App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Neue WUs bei LHC@Home!

- Ersteller TiKu

- Erstellt am

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.247

- Renomée

- 1.832

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Achso, ein Glibber-Problem.

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

Wegen dem SiDock-WU-Mangel habe ich gestern Abend LHC als Fallback aktiviert...

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

Ab morgen schalte ich LHC auf 50%, wenn meine SiDock Mio voll ist, wieder 100% LHC

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

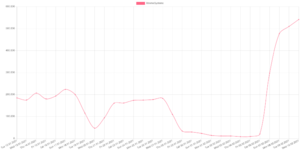

Weil ich gerade bei Auswertungen nach Koschi's Script bin:

(Mischung aus Sixtrack, nativen Atlas und nativen Theory)

V12:

3900x Eco-Mode:

(Mischung aus Sixtrack, nativen Atlas und nativen Theory)

V12:

Code:

Results fetched: 745

Average duration: 25302.4

Average credit: 232.52

Number of reported cores: 128

Per core per day: 790

Per system per day: 1011203900x Eco-Mode:

Code:

Results fetched: 231

Average duration: 15182.0

Average credit: 210.82

Number of reported cores: 24

Per core per day: 1180

Per system per day: 28320Krümel

Grand Admiral Special

- Mitglied seit

- 19.08.2003

- Beiträge

- 5.411

- Renomée

- 530

- Standort

- Schleswig-Holstein

- Aktuelle Projekte

- Rosetta, WCG, Einstein

- Lieblingsprojekt

- POEM *schnüff* R.I.P.

- Meine Systeme

- Ryzen 5 Pro 4650G @ 3,2 GHz @ 0,925 Volt in einem Deskmini X300

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- HP - 14-dk0355ng (R5 3500U 14 Zoll)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 7900x3D

- Mainboard

- Asus TUF B650-M Plus WiFi

- Kühlung

- Noctua NH-U12S

- Speicher

- 2 x 16 GB Corsair Vengeance 5.600

- Grafikprozessor

- AMD RX 6700XT

- Display

- Acer Nitro VG0 27" 1440p / 144 Hz

- SSD

- 1x Crucial P1 1 TB / 1x WB Blue 1 TB (SATA) / 1x Lexar NM790 4TB

- Optisches Laufwerk

- LG BR

- Soundkarte

- Onboardsound

- Gehäuse

- Fractal Design Define R4

- Netzteil

- Be Quiet! Pure Power 11 400 Watt

- Betriebssystem

- Win 10 / Pop!_OS

- Webbrowser

- Opera

- Internetanbindung

-

▼1000

▲50

Weiß jemand was bei LHC los ist?

Alle meine Sixtrack WUs der letzten Tage wandern ins Pending, inzwischen 482.

Alle meine Sixtrack WUs der letzten Tage wandern ins Pending, inzwischen 482.

JagDoc

Grand Admiral Special

- Mitglied seit

- 18.08.2002

- Beiträge

- 3.157

- Renomée

- 546

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- RNA, Pogs, Enigma, Asteroids

- Lieblingsprojekt

- RNA

- Meine Systeme

- i7-3820, i7-3930, ODROID-X2/U2

- BOINC-Statistiken

- Folding@Home-Statistiken

Bei mir sind es auch schon 1441 im Pending.

Laut Serverstatus:

Laut Serverstatus:

| Workunits waiting for validation | 170940 |

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.711

- Renomée

- 705

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Danke, hab das zum Anlass genommen mal wieder ATLAS zu machen, die validieren umgehend.

Die Laufzeiten der ATLAS WUs sind bei mir kräftig gestiegen, die Vergütung aber auch.

Laut meinem Skript:

Das sind WUs mit 4 threads, da passt die Berechnung des Skripts meiner Meinung nach nicht ganz. Eigentlich müsste die Laufzeit und nicht die CPU Zeit verwendet werden. Dummerweise lasse ich das Skript aber den höheren von beiden Werten nehmen, weiß nicht mehr warum, muss ich mal gucken. Über die Laufzeit gemittelt ist der Credit pro Tag dann leicht geringer.

Die Laufzeiten der ATLAS WUs sind bei mir kräftig gestiegen, die Vergütung aber auch.

Laut meinem Skript:

Code:

Application: ATLAS Simulation

CPU: AMD Ryzen 9 3900X 12-Core Processor

OS: Linux Ubuntu Ubuntu 20.04.2 LTS

Results fetched: 13

Average duration (s): 53311.5

Average credit: 973.43

Number of reported cores: 24

Per core per day: 1557

Per system per day: 37368Das sind WUs mit 4 threads, da passt die Berechnung des Skripts meiner Meinung nach nicht ganz. Eigentlich müsste die Laufzeit und nicht die CPU Zeit verwendet werden. Dummerweise lasse ich das Skript aber den höheren von beiden Werten nehmen, weiß nicht mehr warum, muss ich mal gucken. Über die Laufzeit gemittelt ist der Credit pro Tag dann leicht geringer.

Krümel

Grand Admiral Special

- Mitglied seit

- 19.08.2003

- Beiträge

- 5.411

- Renomée

- 530

- Standort

- Schleswig-Holstein

- Aktuelle Projekte

- Rosetta, WCG, Einstein

- Lieblingsprojekt

- POEM *schnüff* R.I.P.

- Meine Systeme

- Ryzen 5 Pro 4650G @ 3,2 GHz @ 0,925 Volt in einem Deskmini X300

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- HP - 14-dk0355ng (R5 3500U 14 Zoll)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 7900x3D

- Mainboard

- Asus TUF B650-M Plus WiFi

- Kühlung

- Noctua NH-U12S

- Speicher

- 2 x 16 GB Corsair Vengeance 5.600

- Grafikprozessor

- AMD RX 6700XT

- Display

- Acer Nitro VG0 27" 1440p / 144 Hz

- SSD

- 1x Crucial P1 1 TB / 1x WB Blue 1 TB (SATA) / 1x Lexar NM790 4TB

- Optisches Laufwerk

- LG BR

- Soundkarte

- Onboardsound

- Gehäuse

- Fractal Design Define R4

- Netzteil

- Be Quiet! Pure Power 11 400 Watt

- Betriebssystem

- Win 10 / Pop!_OS

- Webbrowser

- Opera

- Internetanbindung

-

▼1000

▲50

Von Vorgestern bis Heute sind mir jeweils eine WU pro Tag gutgeschrieben worden...

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.313

- Renomée

- 1.970

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich hatte gestern noch ein paar ATLAS WUs auf meinem Ripper gerechnet und scheinbar können die es so garnicht ab pausiert zu werden.

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

Das hängt eventuell mit dem ständigen Datenverkehr des Rechners mit dem CERN-Server zusammen?

Bei mir mit Singularity und Squid habe ich das bisher nicht festgestellt.

Bei mir mit Singularity und Squid habe ich das bisher nicht festgestellt.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.313

- Renomée

- 1.970

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Keine Ahnung, ich hatte gestern nur die Berechnung der schon laufenden WUs pausiert bis die restlichen WUs runtergeladen wurden. Nachdem ich die pausierten WUs wieder gestartet hatte wurden sie mit einem Berechnungsfehler abgebrochen.

denjo

Grand Admiral Special

- Mitglied seit

- 28.12.2005

- Beiträge

- 3.746

- Renomée

- 116

- Standort

- Kellinghusen

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PDM <--- sowas gabs mal :(

- Lieblingsprojekt

- all

- Meine Systeme

- Ryzen 7 1700, 3.60GHz

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X, 4,1Ghz All Core VID 1.13

- Mainboard

- ASUS ROG Strix B550-E Gaming

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- Gskill F4-3600C16-8GTZNC -> 4*8 GB 3733Mhz (16-19-19-19-35)

- Grafikprozessor

- 5700XT Nitro+

- Display

- LG UltraGear 27GL850-B

- SSD

- Samsung 970 NVMe 1 TB

- HDD

- Western Digital Blue 4TB + 500 Samsung

- Optisches Laufwerk

- gehören der Vergangenheit an.

- Soundkarte

- Onboard

- Gehäuse

- bequite! PURE BASE 500

- Netzteil

- Enermax Revolution87+ 550 W GOLD -> Thx p3d

- Betriebssystem

- Windows X

- Webbrowser

- Chrome, Firefox

- Verschiedenes

- MEHR POWER ^^

- Internetanbindung

- ▼600 ▲50

Das hängt eventuell mit dem ständigen Datenverkehr des Rechners mit dem CERN-Server zusammen?

Bei mir mit Singularity und Squid habe ich das bisher nicht festgestellt.

würde ich auch sagen.

ich könnt die 15 mio. auch mal voll machen ^^

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.596

- Renomée

- 1.310

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Hallo Leute,

ich bin heute von einem LHC-Mod, mit dem ich gerade "privat" gemailt hatte, angeschrieben worden mit folgender Thematik:

Vielleicht wollen wir das mal ausdiskutieren?! Solltet ihr konkrete Fragen bzgl. des obigen Zitats haben, kann ich die auch gerne weiterleiten. Allerdings muss ich gestehen, ich verstehe keinen Ton davon, wovon da geredet wird. Vermutlich betrifft mich das bei Sixtrack aber auch einfach nicht?!

Gruß

Ritschie

ich bin heute von einem LHC-Mod, mit dem ich gerade "privat" gemailt hatte, angeschrieben worden mit folgender Thematik:

Bin heute Nachmittag über den Rechner deines Teamkollegen xxx gestolpert.

128 Cores, 128 GB RAM, sehr schönes System.

Habe aber gesehen, dass das CVMFS nicht fertigkonfiguriert ist.

PM mit entsprechender Bitte ist raus (Proxy-Empfehlung ebenfalls, ist aber mehr Aufwand).

Ähnliches ist mir schon bei einigen Leuten von der P3D-Gruppe aufgefallen.

Ich habe den Verdacht, dass sich sehr viele Leute (nicht nur P3D) einfach keine Gedanken darüber machen, welch hohe Belastung der Netze bei LHC tatsächlich entsteht und dass hohe eigene Bandbreite alleine nicht die Lösung ist.

Mein eigener 100 Mbit/s download ist im Durchschnitt gerade mal zu 2% ausgelastet.

Könntest du als Gruppenmitglied mal freundlich und vorsichtig nachhaken?

CVMFS über Cloudflare ist in 5 min erledigt und praktisch ein Muss.

Squid macht etwas mehr Aufwand (0,5-1 h).

Ohne Squid ist's bei kleineren Clustern kein Beinbruch, bei vielen Worker Nodes sollte man aber der Empfehlung der Entwickler folgen.

Vielleicht wollen wir das mal ausdiskutieren?! Solltet ihr konkrete Fragen bzgl. des obigen Zitats haben, kann ich die auch gerne weiterleiten. Allerdings muss ich gestehen, ich verstehe keinen Ton davon, wovon da geredet wird. Vermutlich betrifft mich das bei Sixtrack aber auch einfach nicht?!

Gruß

Ritschie

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

Das betrifft die nativen Atlas-WU bei Nutzung vom Singularity/CVMS/Squid. Sind ein paar Sachen einzustellen.

Ich hatte da hier in meinem Beiträgen #297 bis #312 etwas geschrieben. Das geht auf diverse Beiträge vom Sompe und Koschi zurück.

Da ich vom LHC-Mod nichts mehr gehört habe, scheint es noch immer gut zu laufen (auch wenn aktuell der 3900x und V12 keinen gemeinsamen Squid-Cache haben).

P.S.

@koschi Das wäre zusammengefasst Singularity/CVMS/Squid etwas für DC-Wiki

Ich hatte da hier in meinem Beiträgen #297 bis #312 etwas geschrieben. Das geht auf diverse Beiträge vom Sompe und Koschi zurück.

Da ich vom LHC-Mod nichts mehr gehört habe, scheint es noch immer gut zu laufen (auch wenn aktuell der 3900x und V12 keinen gemeinsamen Squid-Cache haben).

Code:

#Squid installieren und anpassen:

#Code:

mkdir -p /var/cache/squid

apt install squid

service squid stop

chown -R proxy:proxy /var/cache/squid

squid -z # zwei mal Enter drücken, das ist schnell fertig, gibt aber keine newline zurück

cp -pr /etc/squid/squid.conf /etc/squid/squid.conf.backup

wget -O /etc/squid/squid.conf http://kerbodyne.com/boinc/squid.conf

#In der squid.conf dann anpassen:

### -> acl localnet auf eigenes Heimnetz

### -> dns_nameservers ggf. anpassen, sicher ist sicher

service squid start

#CVMFS anpassen:

#Code:

vi /etc/cvmfs/default.local

#adjust CVMFS_HTTP_PROXY

CVMFS_HTTP_PROXY="http://squid_hostname_or_IP:3128;DIRECT"

#squid_hostname_or_IP auf LAN IP des Squidrechners anpassen

#BOINC anpassen:

#Code:

"Options -> Other Options -> HTTP Proxy"

Address: squid_hostname_or_IP

Port: 3128

#Tipp:

#127.0.0.1 geht nur, wenn CVMFS und Squid auf der gleichen Box laufen.

#Bei CMS läuft CVMFS in der VM. Das ist aus Netzwerksicht ein anderer Rechner.

#Noch ein Tipp:

#Ein simples Squid-Monitoring bekommst du in einer Linux-Konsole mit dem Kommando:

tail -F /var/log/squid/access.log

#Cachegröße checken:

du -smx /var/cache/squid

#Logs verfolgen:

tail -f /var/log/squid/access.log

#Bitte schreib' mal folgende Zeile in die Datei /etc/cvmfs/default.local:

CVMFS_USE_CDN=yes

#Nach dem Abspeichern ein "cvmfs_config reload".

#Bei "cvmfs_config stat" sollte jetzt "...openhtc.io" statt "cvmfs-stratum-one.cern.ch" in der Ausgabe stehen.P.S.

@koschi Das wäre zusammengefasst Singularity/CVMS/Squid etwas für DC-Wiki

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.313

- Renomée

- 1.970

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Da bin ich ehrlich gesagt zu selten damei um mir darüber Gedanken zu machen aber wenn LHC häufiger zum Einsatz kommt hatte ich bei meiner Rechner Flotte schon darüber nachgedacht meinen alten Athlon 5350 als zentrale Verwaltungsstelle und als Proxy einzusetzen. Nach heutigen Stand wären das ja immerhin 3 CPU und 3 GPU Cruncher.

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.596

- Renomée

- 1.310

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Definitiv!P.S.

@koschi Das wäre zusammengefasst Singularity/CVMS/Squid etwas für DC-Wiki

Gruß

Ritschie

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.313

- Renomée

- 1.970

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Würde der kleine Athlon überhaupt genug Power haben um die Proxy Aufgabe dafür zu übernehmen?

LordNord

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 07.09.2005

- Beiträge

- 5.864

- Renomée

- 528

- Standort

- S-H

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3900X

- Mainboard

- ASUS TUF Gaming B550-Plus

- Kühlung

- be quiet! Dark Rock 4

- Speicher

- 2x16GB Crucial DDR4 3200

- Grafikprozessor

- ASUS ROG STRIX Vega 64 GAMING OC

- Display

- AOC Q3279VWFD8

- SSD

- Kingston A2000 1TB + WD Blue SN550 1TB Crucial BX500 2TB + Mega Fastro MS200 2TB Extern

- HDD

- 8TB extern

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 Compact Lite

- Netzteil

- Be quiet! Pure Power 9 600W

- Tastatur

- Corsair K70 MK.2 Low Profile

- Betriebssystem

- Win 10 64Bit

- Webbrowser

- Firefox

- Internetanbindung

-

▼200

▲200

Ich kann über viele Projektbetreiber echt nur lachen.

"Rechnet unsere Aufgaben!" aber

"Nutzt nicht unsere Bandbreite aus!"

"Rechnet unsere Aufgaben!" aber

"Nutzt nicht unsere Bandbreite aus!"

WhiteFire

Vice Admiral Special

- Mitglied seit

- 14.01.2002

- Beiträge

- 963

- Renomée

- 145

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- ASUS Prime X470-Pro

- Kühlung

- WaKü

- Speicher

- Corsair Vengeance PRO, 4x32 GB, DDR4-3600, CL18-22-22-42

- Grafikprozessor

- Gigabyte RX 6800XT

- Gehäuse

- Corsair Obsidian 800D

- Netzteil

- Seasonic Prime Titanium 750W

Squid gibt es ja auch für den Raspi. Ist die Frage wieviel GB da im RAM gelagt werden oder wieviel dann dauernd auf der SD schreibt.

Wie viel Auslastung (RAM/Speicher) hat denn eur Squid?

Naja, bei den kleincrunchern werden die nicht jeden anschreiben. Aber die P3D Cluster zählen da schon zu den VIP (und manche unserer Großcruncher sicherlich auch). Und es ja gut, wenn die Projektbetreiber Interresse zeigen, das hier etwas verbessert wird. Das ist besser, als wenn denen alles egal wäre. Gerade weil eine große Flotte eben kein Normalszenario ist.

Gruß

WhiteFire

Wie viel Auslastung (RAM/Speicher) hat denn eur Squid?

Naja, bei den kleincrunchern werden die nicht jeden anschreiben. Aber die P3D Cluster zählen da schon zu den VIP (und manche unserer Großcruncher sicherlich auch). Und es ja gut, wenn die Projektbetreiber Interresse zeigen, das hier etwas verbessert wird. Das ist besser, als wenn denen alles egal wäre. Gerade weil eine große Flotte eben kein Normalszenario ist.

Gruß

WhiteFire

Landjunge

Admiral Special

- Mitglied seit

- 29.10.2008

- Beiträge

- 1.458

- Renomée

- 605

- Standort

- bei Uelzen, NDS

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- keins

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E3 1230 V2

- Mainboard

- AsRock Z77 Extreme4 - M

- Kühlung

- Noctua NH-L12S

- Speicher

- 16GB 1866er G.Skill

- Grafikprozessor

- Zotac RTX 3070 Twin Edge OC @ AMP Holo Bios (270W TDP)

- Display

- Philips 274E

- SSD

- Crucial BX200 256GB, Crucial MX500 1TB

- Optisches Laufwerk

- defekt ausgebaut

- Soundkarte

- Onboard

- Gehäuse

- Silverstone Cube

- Netzteil

- Coolermaster G550M (teilweise recappt)

- Tastatur

- Microsoft Wired Keyboard 600

- Maus

- Razer Deathadder Essential 2021

- Betriebssystem

- Windows 11 x64 Pro

- Webbrowser

- Firefox Update wird heruntergeladen...

- Internetanbindung

- ▼75 ▲31

Japp, reicht dicke aus. Kannst gleich noch Boinc mitlaufen lassenWürde der kleine Athlon überhaupt genug Power haben um die Proxy Aufgabe dafür zu übernehmen?

. Normal stemmt das auch ein Raspberry Pi mit externer SSD als Proxy Cache.

. Normal stemmt das auch ein Raspberry Pi mit externer SSD als Proxy Cache.erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

@LordNord

In diesem Fall ist es bei den ATLAS auch eher auch für die Cruncher gut, wenn sie mehr als einen "größeren" PC am Netz haben.

Trotz meiner eigentlich guten Leitungen hatte ich Auswirkungen bis hin zum Streaming-TV. Nach einer strukturellen Änderung im Heimnetz und den Einsatz von Singularity/CVMS/Squid ging es dann ganz gut.

In diesem Fall ist es bei den ATLAS auch eher auch für die Cruncher gut, wenn sie mehr als einen "größeren" PC am Netz haben.

Trotz meiner eigentlich guten Leitungen hatte ich Auswirkungen bis hin zum Streaming-TV. Nach einer strukturellen Änderung im Heimnetz und den Einsatz von Singularity/CVMS/Squid ging es dann ganz gut.

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.368

- Renomée

- 9.694

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Trotz meiner eigentlich guten Leitungen hatte ich Auswirkungen bis hin zum Streaming-TV. Nach einer strukturellen Änderung im Heimnetz und den Einsatz von Singularity/CVMS/Squid ging es dann ganz gut.

Bei ein paar Projekten hat man auch subjektiv den Eindruck, dass die das System gerade beim Zugriff auf die Festplatte extrem belasten und dadurch schon die Arbeit am selbigen beeinträchtigen.

Frage ist was nimmt man da am Besten? Ne SSD oder ne SATA-HD mit viel Cache?

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 331

- Antworten

- 0

- Aufrufe

- 251

- Antworten

- 0

- Aufrufe

- 165

- Antworten

- 0

- Aufrufe

- 272

- Antworten

- 1K

- Aufrufe

- 69K