App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Zurück zu Nvidia - Endlich wieder zuhause!

- Ersteller TobiWahnKenobi

- Erstellt am

skelletor

Grand Admiral Special

- Mitglied seit

- 14.06.2002

- Beiträge

- 5.316

- Renomée

- 289

- Standort

- Dresden

- Aktuelle Projekte

- Simap, Spinhenge, Poem, QMC, RNA World

- Lieblingsprojekt

- einheimische Projekte

- Meine Systeme

- AMD Ryzen 7 5800X3D + AMD Radeon RX 6900XT

- BOINC-Statistiken

- Mein Laptop

- Acer Aspire E3 112, Lenovo ThinkPad L570

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- MSI X570-A Pro

- Kühlung

- beQuiet DarkRock TF

- Speicher

- 2x 16GB GSkill 1800MHz CL14 @ 1T

- Grafikprozessor

- AMD Radeon 6900XT

- Display

- Samsung C27HG70 @2560*1440 144Hz; EIZO S2411W @1920x1200 60Hz; 52 Zoll Sony KDL-52HX905 @1920*1080

- SSD

- 1TB WD Black SN850 M2 NVME, 512 GB Samsung 850 Pro

- HDD

- 1x 4TB WesternDigital Red

- Optisches Laufwerk

- Pioneer BluRay Brenner

- Soundkarte

- Realtek HD Audio OnBoard (ALC 1220)

- Gehäuse

- noname

- Netzteil

- Seasonic X650 (80+ Gold)

- Tastatur

- Logitech G815 Tactile (brown)

- Maus

- Swiftpoint Z

- Betriebssystem

- Windows 10 Home 64bit

- Webbrowser

- Firefox

Letztendlich kommt es auf den Einsatzzweck an, aber der Trend ist für mich auch knackig die falsche Richtung. 450W Standard und 600 maximaler TDP sind schon krank.

Wie auch immer: bevor die 7900XT nicht draußen ist... ich hätte wohl noch die 3 Wochen gewartet und dann über einen Kauf nachgedacht, bevor ich den Unsympathen von NVidia vorab das Geld in den Rachen werfe.

Wie auch immer: bevor die 7900XT nicht draußen ist... ich hätte wohl noch die 3 Wochen gewartet und dann über einen Kauf nachgedacht, bevor ich den Unsympathen von NVidia vorab das Geld in den Rachen werfe.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Puh, Tobis Blog seit 2012...Letztendlich kommt es auf den Einsatzzweck an, aber der Trend ist für mich auch knackig die falsche Richtung. 450W Standard und 600 maximaler TDP sind schon krank.

Wie auch immer: bevor die 7900XT nicht draußen ist... ich hätte wohl noch die 3 Wochen gewartet und dann über einen Kauf nachgedacht, bevor ich den Unsympathen von NVidia vorab das Geld in den Rachen werfe.

Daher mal Glühstrumpf für die 10 Jahre Posting hier !

Das hier waren auch schon über 600W @ 230V : https://abload.de/img/night_raid_custom_cfxn5ku9.jpg

Edit: Heute sieht es so aus:

Zuletzt bearbeitet:

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

danke windhund.

ich kann die denkweise zum energieverbrauch gut verstehen. ich denke ja im grunde nicht anders. allerdings ist es dieses mal hardware, die total überzeugt.

die 3090Ti ist gewiss nicht langsam gewesen, aber war in der spitze auch nur 40% schneller als die RTX2080Ti, die vor ihr im slot steckte.

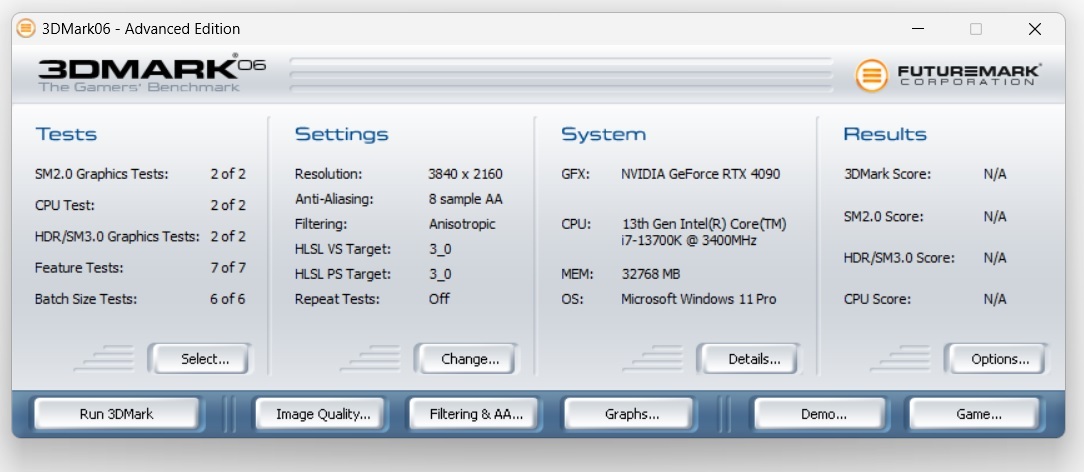

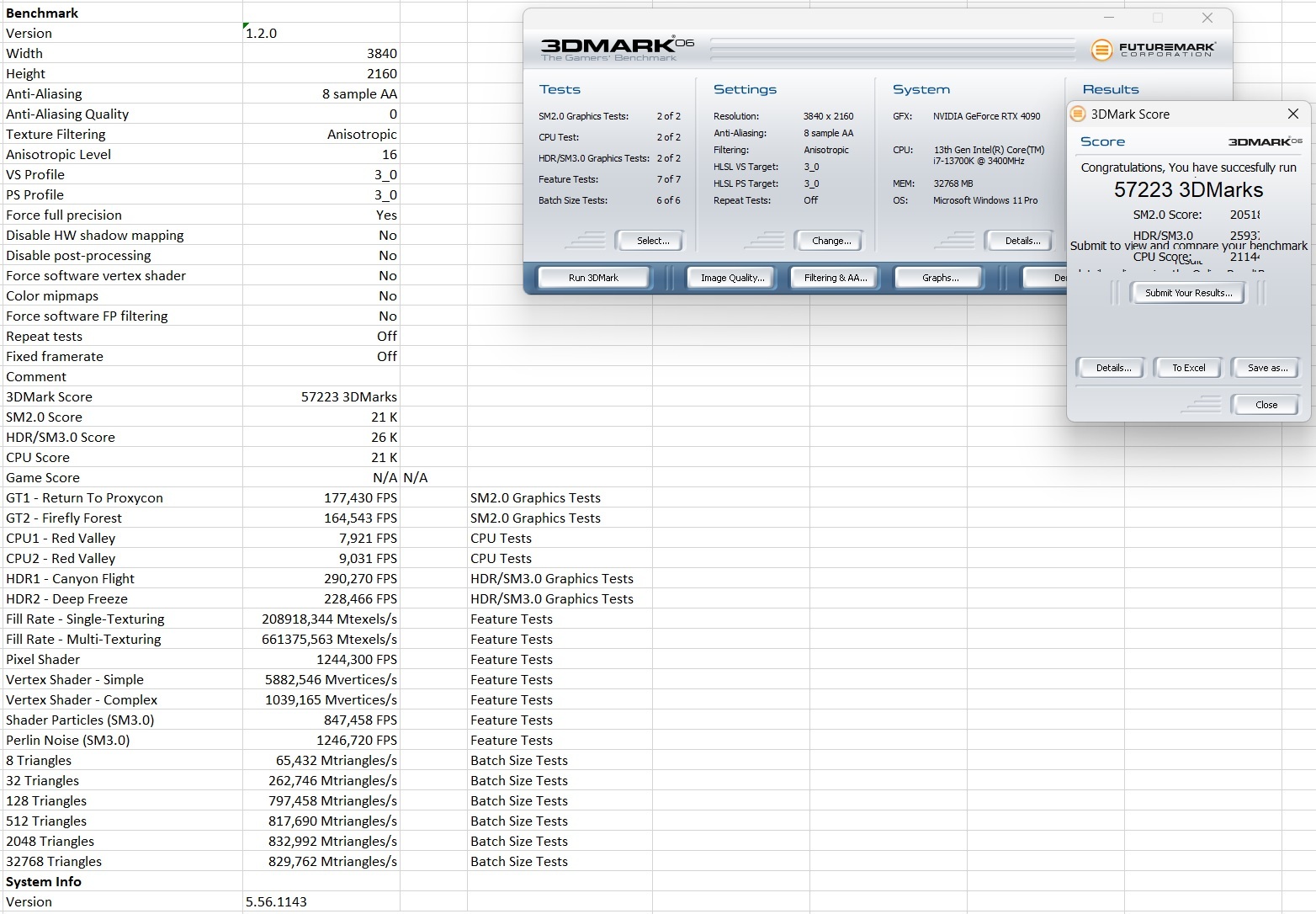

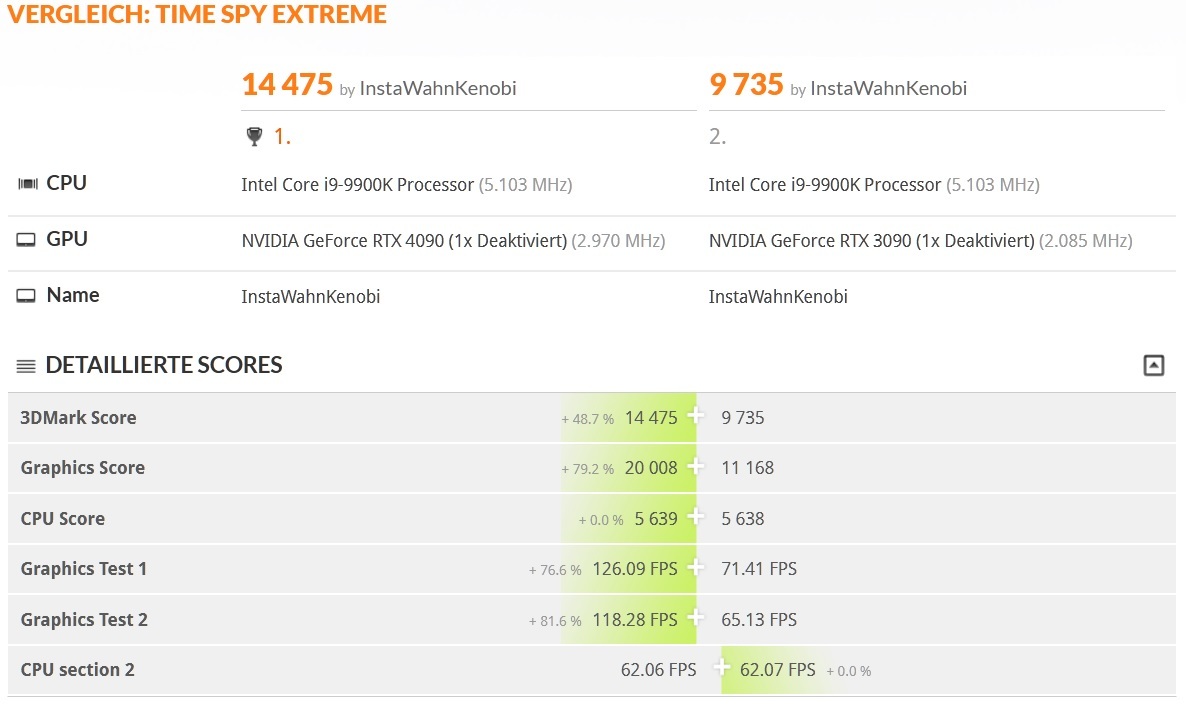

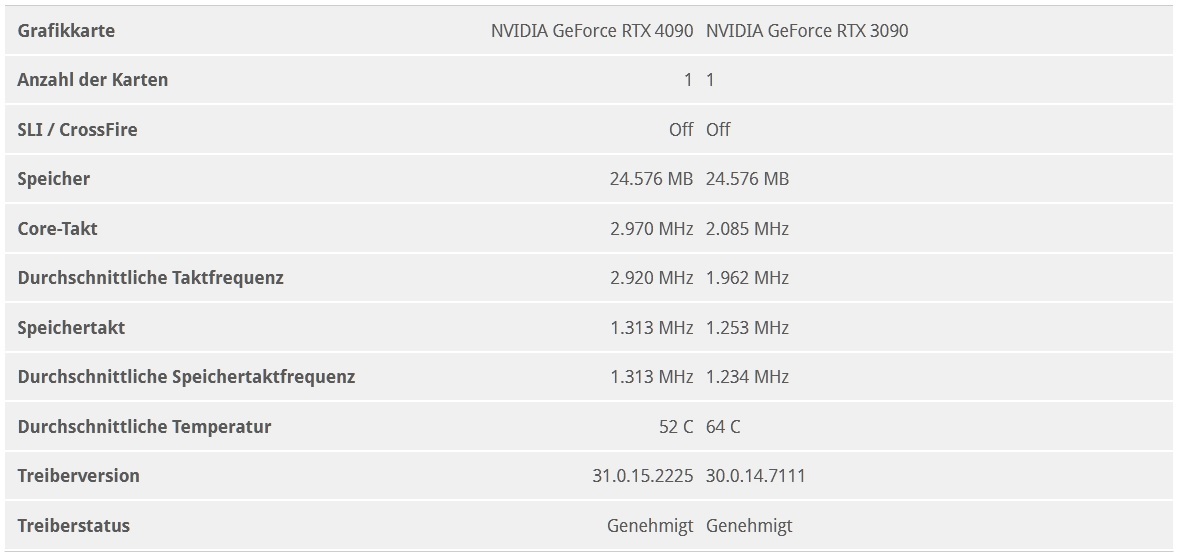

im slot steckte.. gutes stichwort.. da steckte schon so einiges.. mein i9900k ist inzwischen ein opa.. das z370 auf dem er steckt rostet langsam. dass ich darauf überhaupt noch lagfrei spielen kann, liegt nicht zuletzt darin begründet, dass ich immer karten mit zuviel dediziertem speicher kaufe.. *gg* anyway.. plötzlich kommen neue karten auf den markt.. man liest von 600w und kriegt mit blick auf die kosten in heutigen tagen das kotzen - völlig falsche richtung.. wir hatten das thema ja schon.. AAAAAAAABER -> das mistding überzeugt mit 70-80% mehr doppelwumms on top.. auf die 3090.. die in der spitze auch 480W verbraten hat (ROG STRIX OC).. wäre ich zocker würde ich jetzt den witcher mit 200+ fps durch die 4K gegend jagen oder die auflösung auf 8K hochdrehen und hätte immernoch über 60fps. das waren vorhin 1000MHz mehr als ampere drückt.. unter luft.

so und nicht anders muss es sich anfühlen, wenn ich die graka update!

aber das ist für einen ersten eindruck genug weihrauch. warten wir auf die dinge, die mich nerven.. früher oder später.

(..)

mfg

tobi

ich kann die denkweise zum energieverbrauch gut verstehen. ich denke ja im grunde nicht anders. allerdings ist es dieses mal hardware, die total überzeugt.

die 3090Ti ist gewiss nicht langsam gewesen, aber war in der spitze auch nur 40% schneller als die RTX2080Ti, die vor ihr im slot steckte.

im slot steckte.. gutes stichwort.. da steckte schon so einiges.. mein i9900k ist inzwischen ein opa.. das z370 auf dem er steckt rostet langsam. dass ich darauf überhaupt noch lagfrei spielen kann, liegt nicht zuletzt darin begründet, dass ich immer karten mit zuviel dediziertem speicher kaufe.. *gg* anyway.. plötzlich kommen neue karten auf den markt.. man liest von 600w und kriegt mit blick auf die kosten in heutigen tagen das kotzen - völlig falsche richtung.. wir hatten das thema ja schon.. AAAAAAAABER -> das mistding überzeugt mit 70-80% mehr doppelwumms on top.. auf die 3090.. die in der spitze auch 480W verbraten hat (ROG STRIX OC).. wäre ich zocker würde ich jetzt den witcher mit 200+ fps durch die 4K gegend jagen oder die auflösung auf 8K hochdrehen und hätte immernoch über 60fps. das waren vorhin 1000MHz mehr als ampere drückt.. unter luft.

so und nicht anders muss es sich anfühlen, wenn ich die graka update!

aber das ist für einen ersten eindruck genug weihrauch. warten wir auf die dinge, die mich nerven.. früher oder später.

(..)

mfg

tobi

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@TobiWahnKenobi

Cheating meiner Seits: https://www.3dmark.com/spy/30530309

Das waren 720p, oder sowas.

Cheating meiner Seits: https://www.3dmark.com/spy/30530309

Das waren 720p, oder sowas.

Shinsaja

Grand Admiral Special

- Mitglied seit

- 24.03.2009

- Beiträge

- 4.198

- Renomée

- 87

- Standort

- Zwickau

- Mein Laptop

- HP 445 G8 | Ryzen 7 5800U | 32GB Samsung 3200MHz | 1TB Samsung 980 M.2 NVMe | Vega 8

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5800X

- Mainboard

- Gigabyte B550M Aorus Pro

- Kühlung

- Scythe Kotetsu Mark II

- Speicher

- 32GB G.Skill Ripjaws V 3600MHz

- Grafikprozessor

- AMD Radeon RX 6800 16GB

- Display

- Samsung G3 S32AG324NU 32"

- SSD

- Samsung 970 Evo 2TB M.2 NVMe

- Soundkarte

- Realtek ALC1200

- Gehäuse

- Fractal Arc Mini R2

- Netzteil

- be quiet! Pure Power 11 CM 500W 80+ Gold

- Tastatur

- Roccat Horde Aimo

- Maus

- Roccat Kone Aimo

- Betriebssystem

- Windows 11 Pro

- Verschiedenes

- Roccat Elo 7.1 USB

- Internetanbindung

- ▼100 MBit ▲40 MBit

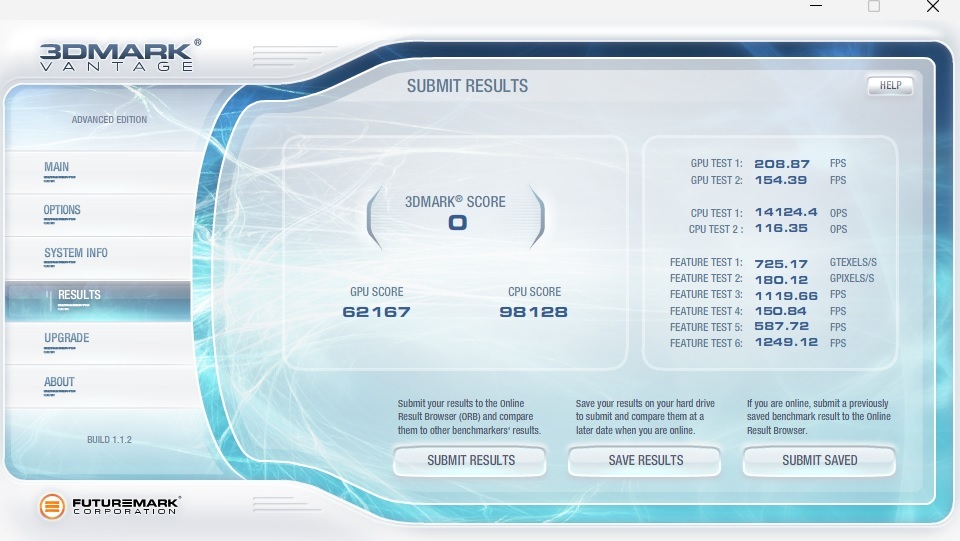

Eigentlich sinds ja nur 885MHz und 48% mehr beim TimeSpy in deinem Screenshot. Da fehlt einiges bis 70-80%

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

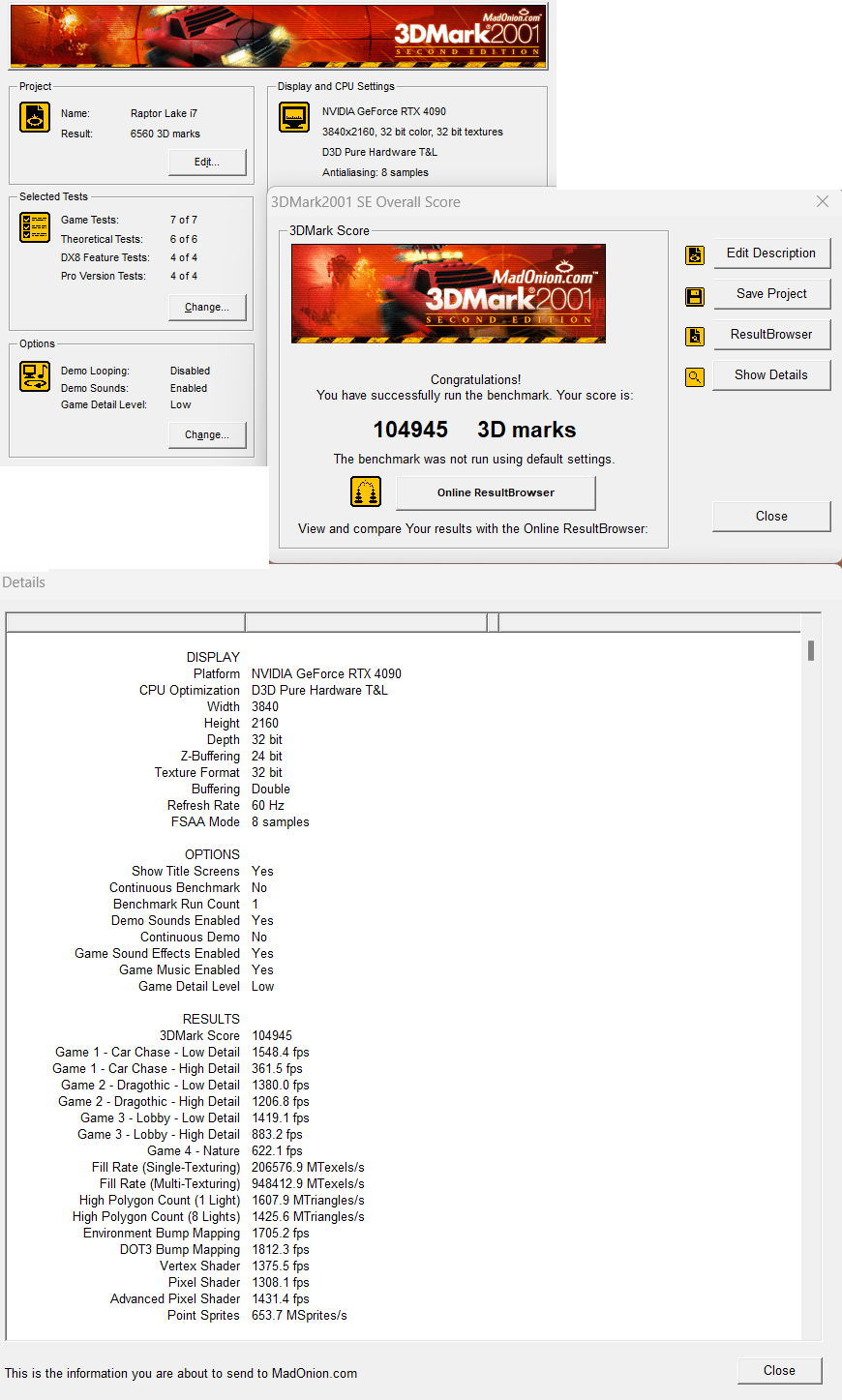

den 3Dmark score darfst du ignorieren. guck auf die grafik-score und auf die fps..Eigentlich sinds ja nur 885MHz und 48% mehr beim TimeSpy in deinem Screenshot. Da fehlt einiges bis 70-80%

1962 vs 2920 sind 1000.

(..)

mfg

tobi

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@TobiWahnKenobi I

Night Ride ?

www.3dmark.com

www.3dmark.com

Night Ride ?

I scored 57 659 in Night Raid

AMD Ryzen 9 3900XT, AMD Radeon RX 6950 XT x 1, 32768 MB, 64-bit Windows 10}

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

@TobiWahnKenobi I

Night Ride ?

I scored 57 659 in Night Raid

AMD Ryzen 9 3900XT, AMD Radeon RX 6950 XT x 1, 32768 MB, 64-bit Windows 10}www.3dmark.com

I scored 66 435 in Night Raid

Intel Core i9-9900K Processor, NVIDIA GeForce RTX 4090 x 1, 32768 MB, 64-bit Windows 11}

GPU last round about 30-40%

(..)

mfg

tobi

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

@stromverbrauch

wenn man die karte mit ihren standardeinstellungen betreibt ist der verbrauch recht moderat und sie boostet out-of-the-box auf 2.7GHz.

ne runde far cry 6 mit 100fps in 4K auflösung und voll aufgerotzt.. unter 300W. dass die gpu nicht richtig ausgelastet wird, spart strom

mit der 3090 brauchte ich mehr saft für weniger bilder.

(..)

mfg

tobi

wenn man die karte mit ihren standardeinstellungen betreibt ist der verbrauch recht moderat und sie boostet out-of-the-box auf 2.7GHz.

ne runde far cry 6 mit 100fps in 4K auflösung und voll aufgerotzt.. unter 300W. dass die gpu nicht richtig ausgelastet wird, spart strom

mit der 3090 brauchte ich mehr saft für weniger bilder.

(..)

mfg

tobi

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.335

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das Problem ist ja auch weniger die Leistung an sich sondernum welchen Preis die Karten darauf kommen.ich kann die denkweise zum energieverbrauch gut verstehen. ich denke ja im grunde nicht anders. allerdings ist es dieses mal hardware, die total überzeugt

EIn schöner Anhaltspunkt ist hier die Messungen mit 300W, 350W und 450W Limit bei Computerbase.

Zwischen 300W und 350W laben immerhin noch 7% Mehrleistung aber zwischen 350W und 450W kommen nur noch 3% bei rum. Ich will garnicht wissen um wieviel es dann bei den 600W Monstern geht aber schon aufgrund dieser Zahlen sieht man recht deutlich das man die 350W Grenze @ default hätte nicht überschreiten sollen denn eine doppelt so viel Mehrverbrauch bei nur halb so großen Leistungszuwachs sprechen hier eine sehr deutliche Sprache.

skelletor

Grand Admiral Special

- Mitglied seit

- 14.06.2002

- Beiträge

- 5.316

- Renomée

- 289

- Standort

- Dresden

- Aktuelle Projekte

- Simap, Spinhenge, Poem, QMC, RNA World

- Lieblingsprojekt

- einheimische Projekte

- Meine Systeme

- AMD Ryzen 7 5800X3D + AMD Radeon RX 6900XT

- BOINC-Statistiken

- Mein Laptop

- Acer Aspire E3 112, Lenovo ThinkPad L570

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- MSI X570-A Pro

- Kühlung

- beQuiet DarkRock TF

- Speicher

- 2x 16GB GSkill 1800MHz CL14 @ 1T

- Grafikprozessor

- AMD Radeon 6900XT

- Display

- Samsung C27HG70 @2560*1440 144Hz; EIZO S2411W @1920x1200 60Hz; 52 Zoll Sony KDL-52HX905 @1920*1080

- SSD

- 1TB WD Black SN850 M2 NVME, 512 GB Samsung 850 Pro

- HDD

- 1x 4TB WesternDigital Red

- Optisches Laufwerk

- Pioneer BluRay Brenner

- Soundkarte

- Realtek HD Audio OnBoard (ALC 1220)

- Gehäuse

- noname

- Netzteil

- Seasonic X650 (80+ Gold)

- Tastatur

- Logitech G815 Tactile (brown)

- Maus

- Swiftpoint Z

- Betriebssystem

- Windows 10 Home 64bit

- Webbrowser

- Firefox

Mal schauen, was die 7900XT bringt - die sollte im Normalbetrieb ja nicht so viel ziehen und ähnlich Leistungsfähig sein.

Wie gesagt hätte ich die paar Tage noch gewartet - dass die dann über 2k Euro kostet wage ich auch zu bezweifeln.

Wie gesagt hätte ich die paar Tage noch gewartet - dass die dann über 2k Euro kostet wage ich auch zu bezweifeln.

bschicht86

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 14.12.2006

- Beiträge

- 4.249

- Renomée

- 228

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- 2950X

- Mainboard

- X399 Taichi

- Kühlung

- Heatkiller IV Pure Chopper

- Speicher

- 64GB 3466 CL16

- Grafikprozessor

- 2x Vega 64 @Heatkiller

- Display

- Asus VG248QE

- SSD

- PM981, SM951, ein paar MX500 (~5,3TB)

- HDD

- -

- Optisches Laufwerk

- 1x BH16NS55 mit UHD-BD-Mod

- Soundkarte

- Audigy X-Fi Titanium Fatal1ty Pro

- Gehäuse

- Chieftec

- Netzteil

- Antec HCP-850 Platinum

- Betriebssystem

- Win7 x64, Win10 x64

- Webbrowser

- Firefox

- Verschiedenes

- LS120 mit umgebastelten USB -> IDE (Format wie die gängigen SATA -> IDE)

Jup, da bremst dann eher die CPU.den 3Dmark score darfst du ignorieren. guck auf die grafik-score und auf die fps..

Ich war davon auch etwas überrascht, aber da sich die Ausführungseinheiten fast verdoppelt haben und der Treiber die gut ausgelastet bekommt, ist sowas gut drin.voll aufgerotzt.. unter 300W. dass die gpu nicht richtig ausgelastet wird, spart strom

mit der 3090 brauchte ich mehr saft für weniger bilder.

Wäre ja mal interessant, wie es bei Taktgleichheit auschaut, ob da nur die Mehrzahl an Ausführungseinheiten "drückt" oder ob es signifikante IPC-Verbesserungen gab.das waren vorhin 1000MHz mehr als ampere drückt.

Das ist das Problem, wenn man bei einem Team "verhaftet" ist. Ich würd sogar wetten, dass Tobi 10k für einen grüne Karte hinblättert, auch wenn er vorher viel gemeckert hat.Wie gesagt hätte ich die paar Tage noch gewartet - dass die dann über 2k Euro kostet wage ich auch zu bezweifeln.

Landjunge

Admiral Special

- Mitglied seit

- 29.10.2008

- Beiträge

- 1.459

- Renomée

- 606

- Standort

- bei Uelzen, NDS

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- keins

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E3 1230 V2

- Mainboard

- AsRock Z77 Extreme4 - M

- Kühlung

- Noctua NH-L12S

- Speicher

- 16GB 1866er G.Skill

- Grafikprozessor

- Zotac RTX 3070 Twin Edge OC @ AMP Holo Bios (270W TDP)

- Display

- Philips 274E

- SSD

- Crucial BX200 256GB, Crucial MX500 1TB

- Optisches Laufwerk

- defekt ausgebaut

- Soundkarte

- Onboard

- Gehäuse

- Silverstone Cube

- Netzteil

- Coolermaster G550M (teilweise recappt)

- Tastatur

- Microsoft Wired Keyboard 600

- Maus

- Razer Deathadder Essential 2021

- Betriebssystem

- Windows 11 x64 Pro

- Webbrowser

- Firefox Update wird heruntergeladen...

- Internetanbindung

- ▼75 ▲31

Jetzt bräuchten wir nur noch paar Boinc Testergebnisse

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.716

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Kann ich mir lebhaft vorstellen: Dann labert sie nur rum, statt zu liefern. Und in jedem Interview zählt sie alle 42 Spiele auf, die sie in den letzten 12 Monaten beschleunigt hat, weil sie glaubt, "der Trick" bestünde darin, immer wieder das Selbe zu sagen?mehr Doppelwumms

Deine Augen können das nicht unterscheiden, deshalb siehst du davon nichts.die auflösung auf 8K hochdrehen

Auch 4K ist doch eine Art "hausgemachtes Problem". Dafür würde ich niemals solche abartigen Summen für eine Grafikkarte ausgeben.

Zuletzt bearbeitet:

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

ich sehe davon ne ganze menge.. mein bildschirm ist ein 55" OLED mit 120Hz und nativer 4K auflösung

(..)

mfg

tobi

(..)

mfg

tobi

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Habe letztens ein 8K Video mit einer 4090 von Red Dead Redemption 2 gesehen, ohne Kantenglättung. Fand ich nicht schön. Immer noch sichtbare Pixel und Kantenflimmern.

4K oder selbst niedrigere Auflösungen mit vernünftiger Kantengättung sieht deutlich schöner aus. Die Auflösung immer weiter hoch zu prügeln ist meiner Meinung nach deshalb komplett sinnlos, viel zu uneffizient. Da schießt man mit Kanonen auf Spatzen.

Bei 4K sind wir bereits bei einer Auflösung angelangt, bei der man mit entsprechender Kantenglättung in Sachen Schärfe keinen Unterschied zur Realität mehr wahrnimmt (siehe im Filmbereich UHD Blu-Ray, wo ist da noch ein Unterschied zur Realität wahrnehmbar?).

Ich bezweifle, dass man zwischen 4K mit Kantenglättung und nativem 8K mit Kantenglättung noch irgendeinen Unterschied wahrnehmen kann.

Die TV-Hersteller wollen uns das natürlch verkaufen mit ihrem tollen 8K-Marketing. Aber auf Seite der Medien wird 4K mit Sicherheit noch SEHR lange der Standard bleiben. Einfach weil noch mehr Auflösung kaum noch Vorteile hat und sehr viele Nachteile. Um Computerspiele noch mehr Richtung Realität zu bekommen, wird Rechenleistung eher für andere Sachen gebraucht, nicht für noch mehr Pixel.

Just my 2 cents

4K oder selbst niedrigere Auflösungen mit vernünftiger Kantengättung sieht deutlich schöner aus. Die Auflösung immer weiter hoch zu prügeln ist meiner Meinung nach deshalb komplett sinnlos, viel zu uneffizient. Da schießt man mit Kanonen auf Spatzen.

Bei 4K sind wir bereits bei einer Auflösung angelangt, bei der man mit entsprechender Kantenglättung in Sachen Schärfe keinen Unterschied zur Realität mehr wahrnimmt (siehe im Filmbereich UHD Blu-Ray, wo ist da noch ein Unterschied zur Realität wahrnehmbar?).

Ich bezweifle, dass man zwischen 4K mit Kantenglättung und nativem 8K mit Kantenglättung noch irgendeinen Unterschied wahrnehmen kann.

Die TV-Hersteller wollen uns das natürlch verkaufen mit ihrem tollen 8K-Marketing. Aber auf Seite der Medien wird 4K mit Sicherheit noch SEHR lange der Standard bleiben. Einfach weil noch mehr Auflösung kaum noch Vorteile hat und sehr viele Nachteile. Um Computerspiele noch mehr Richtung Realität zu bekommen, wird Rechenleistung eher für andere Sachen gebraucht, nicht für noch mehr Pixel.

Just my 2 cents

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

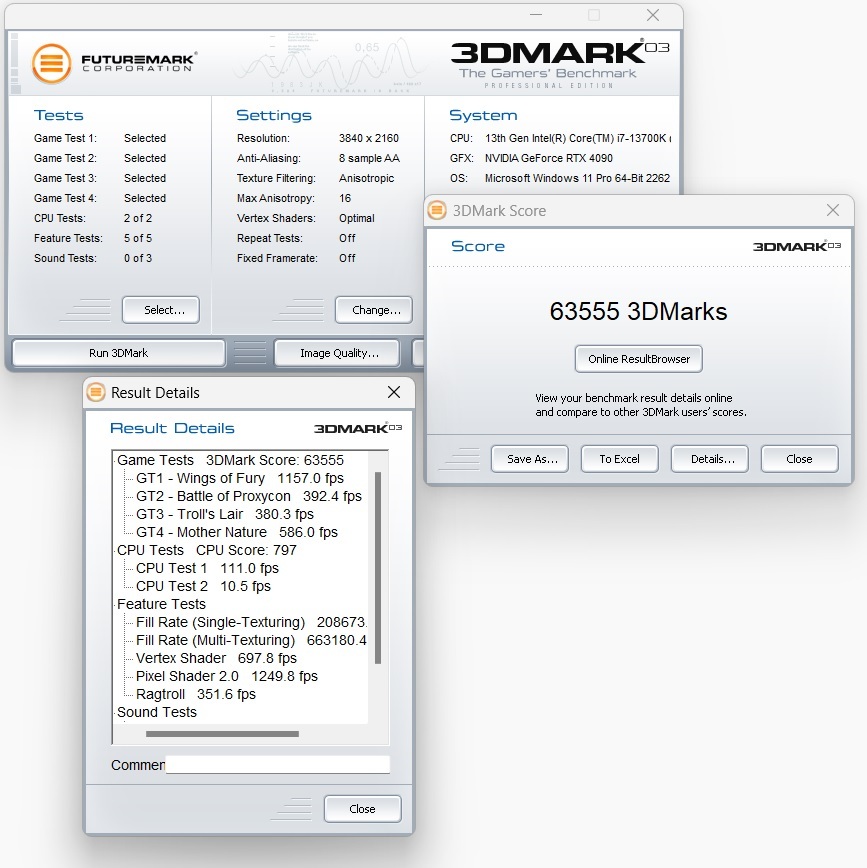

I scored 10 878 in Speed Way

Intel Core i9-9900K Processor, NVIDIA GeForce RTX 4090 x 1, 32768 MB, 64-bit Windows 11}

charmante 3.1GHz im neuesten 3DMark aufguss.

(..)

mfg

tobi

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Soweit kann ich dir folgen, aber:Habe letztens ein 8K Video mit einer 4090 von Red Dead Redemption 2 gesehen, ohne Kantenglättung. Fand ich nicht schön. Immer noch sichtbare Pixel und Kantenflimmern.

4K oder selbst niedrigere Auflösungen mit vernünftiger Kantengättung sieht deutlich schöner aus. Die Auflösung immer weiter hoch zu prügeln ist meiner Meinung nach deshalb komplett sinnlos, viel zu uneffizient. Da schießt man mit Kanonen auf Spatzen.

Bei 4K sind wir bereits bei einer Auflösung angelangt, bei der man mit entsprechender Kantenglättung in Sachen Schärfe keinen Unterschied zur Realität mehr wahrnimmt (siehe im Filmbereich UHD Blu-Ray, wo ist da noch ein Unterschied zur Realität wahrnehmbar?).

Ich bezweifle, dass man zwischen 4K mit Kantenglättung und nativem 8K mit Kantenglättung noch irgendeinen Unterschied wahrnehmen kann.

Die TV-Hersteller wollen uns das natürlch verkaufen mit ihrem tollen 8K-Marketing. Aber auf Seite der Medien wird 4K mit Sicherheit noch SEHR lange der Standard bleiben. Einfach weil noch mehr Auflösung kaum noch Vorteile hat und sehr viele Nachteile. Um Computerspiele noch mehr Richtung Realität zu bekommen, wird Rechenleistung eher für andere Sachen gebraucht, nicht für noch mehr Pixel.

Just my 2 cents

4K ist Natürlich viel Holz, also in der Länge und Breite doppelt so viel wie Full HD (1080p)

Dasselbe gilt auch Analog zu 8K, doppelt so viel wie 4K...

Aber ohne Hz, Farbtiefe und Pixel pro m² ist das alles Schall und Rauch.

Von der Bit Rate des Quell Material mal abgesehen.

AA oder AF braucht man freilich nicht mit 8K !

@TobiWahnKenobi

Mein Neid, sei dir gegönnt.

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

Ähnliche Themen

- Antworten

- 610

- Aufrufe

- 45K

- Antworten

- 2K

- Aufrufe

- 111K

- Antworten

- 680

- Aufrufe

- 87K

- Antworten

- 505

- Aufrufe

- 56K