App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

News Microsoft präsentiert Xbox-One-Prozessor auf der Hot Chips 25 - hUMA Sein oder Nichtsein?

- Ersteller Opteron

- Erstellt am

Opteron

Redaktion

☆☆☆☆☆☆

Wie wir bereits in unserer früheren Meldung erwähnten, fand vor kurzem die Hot-Chips-Konferenz statt. Neben großen Serverdies, wie dem 650 mm² großen Power8-Prozessor mit fast 100 MB L3-Cache von IBM, gab auch Microsoft technische Details seines auf AMDs APU-Technik basierenden SoC der kommenden Xbox One preis. Unsere japanischen Kollegen von PC-Watch Weekly konnten die wichtigsten Detailfolien erhalten. Auf der ersten Folie sieht man die technischen Eckdaten

(…)

» Artikel lesen

(…)

» Artikel lesen

Zuletzt bearbeitet:

mibo

Grand Admiral Special

- Mitglied seit

- 05.01.2003

- Beiträge

- 2.296

- Renomée

- 65

- Standort

- Hannover

- Mein Laptop

- Lenovo T450s

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800X3D

- Mainboard

- ASUS B550M-PLUS

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x16GB DDR4 ECC

- Grafikprozessor

- AMD 6700XT

- Display

- HP X27i

- SSD

- Samsung 860EVO, 960EVO, WD 850X

- Optisches Laufwerk

- DVD-Brenner :-)

- Netzteil

- BQ Dark Power 12 750W

- Betriebssystem

- Suse Tumbleweed / Win10 64Bit

- Webbrowser

- Firefox

Die Vereinfachung mit HSA, die auf den letzten Folien gezeigt wird, bezieht sich darauf, einen Compute-Job abzusetzen.

Das scheint bei Spielen anders zu sein. Da gibt es wohl CPU-Berechnungen, GPU-Berechnungen (der genannte Compute-Job) und Shader für die Grafik.

Tim Sweeney von EPIC Games scheint jedenfalls seine Zweifel zu haben, dass HSA bei Spielen *merklich* etwas bringt. Anscheinend ist das alles noch zu kompliziert zu programmieren, wo ihm selbst AMD Recht gibt.

http://vr-zone.com/articles/epic-games-tim-sweeney-amd-dont-see-eye-eye-huma/53374.html

Das scheint bei Spielen anders zu sein. Da gibt es wohl CPU-Berechnungen, GPU-Berechnungen (der genannte Compute-Job) und Shader für die Grafik.

Tim Sweeney von EPIC Games scheint jedenfalls seine Zweifel zu haben, dass HSA bei Spielen *merklich* etwas bringt. Anscheinend ist das alles noch zu kompliziert zu programmieren, wo ihm selbst AMD Recht gibt.

http://vr-zone.com/articles/epic-games-tim-sweeney-amd-dont-see-eye-eye-huma/53374.html

Dr@

Grand Admiral Special

- Mitglied seit

- 19.05.2009

- Beiträge

- 12.791

- Renomée

- 4.066

- Standort

- Baden-Württemberg

- Aktuelle Projekte

- Collatz Conjecture

- Meine Systeme

- Zacate E-350 APU

- BOINC-Statistiken

- Mein Laptop

- FSC Lifebook S2110, HP Pavilion dm3-1010eg

- Details zu meinem Laptop

- Prozessor

- Turion 64 MT37, Neo X2 L335, E-350

- Mainboard

- E35M1-I DELUXE

- Speicher

- 2x1 GiB DDR-333, 2x2 GiB DDR2-800, 2x2 GiB DDR3-1333

- Grafikprozessor

- RADEON XPRESS 200m, HD 3200, HD 4330, HD 6310

- Display

- 13,3", 13,3" , Dell UltraSharp U2311H

- HDD

- 100 GB, 320 GB, 120 GB +500 GB

- Optisches Laufwerk

- DVD-Brenner

- Betriebssystem

- WinXP SP3, Vista SP2, Win7 SP1 64-bit

- Webbrowser

- Firefox 13

Macht es Sinn direkt nach dem Original-Artikel noch den Abklatsch zu verlinken, der die Sache nochmals negativer darstellt? Edit: Der Post vor mir wurde wieder gelöscht

Tim Sweeney schrieb:Uniform memory access to a cache coherent shared address space is a very welcome improvement to current CPU/GPU model. On the PC platform, the challenge is how to expose it. DirectX? OpenGL? Their pace of adopting new technology is mighty slow for this significant a change. And the bigger source of non-uniformity, the programming model uniformity (C++ on CPU vs OpenCL/CUDA on GPU) remains and is an enormous barrier to the productive movement of code among processing units. Ultimately, I would love to see vector computing hardware addressed in mainstream programming languages such as C++ through loop vectorization and other compiler-automated parallelism transformations, rather than by writing code in separate languages designed for GPU.

QuellePhil Rogers schrieb:Like AMD, it seems Tim Sweeney clearly sees the future that HSA is aiming at: single source, high level language programs that can run both on the CPU and GPU. This is ultimately what will allow Tim, and hundreds of thousands of other software developers, to easily write software that accelerates on HSA platforms. This is exactly why we are developing HSA – unifying the addressing, providing full memory coherency and extending the capability of the GPU parallel processor to fully support C++. We are re-inventing the heterogeneous platform to eliminate all of the barriers that currently prevent a C++ or Java program offloading its parallel content to the GPU.

Tim is correct that in addition to the arrival of the HSA platform, the programming model must evolve to give easy access to GPU acceleration. OpenCL 2.0 and C++ AMP are very good steps in this direction. OpenCL 2.0 brings unified addressing and memory coherency options. C++ AMP is a single source approach that adds just two new keywords, restrict and arrayview, to allow particular methods to be compiled to both CPU and GPU and offloaded opportunistically. The HSA platform will allow both of these programming models to evolve still further towards the pure C++ model that is natural to the programmer.

mibo

Grand Admiral Special

- Mitglied seit

- 05.01.2003

- Beiträge

- 2.296

- Renomée

- 65

- Standort

- Hannover

- Mein Laptop

- Lenovo T450s

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800X3D

- Mainboard

- ASUS B550M-PLUS

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x16GB DDR4 ECC

- Grafikprozessor

- AMD 6700XT

- Display

- HP X27i

- SSD

- Samsung 860EVO, 960EVO, WD 850X

- Optisches Laufwerk

- DVD-Brenner :-)

- Netzteil

- BQ Dark Power 12 750W

- Betriebssystem

- Suse Tumbleweed / Win10 64Bit

- Webbrowser

- Firefox

Ich denke, AMDs Reaktion gibt dem ganzen doch wieder einen positiven drive.

Die neuen Konsolen stehen ja am Anfang ihrer Karriere - da kann sich schon noch einiges entwickeln...

Wahrscheinlich werden die Konsolen sogar ein Zugpferd für die nötigen Software/Compiler/Bibliotheks-Verbesserungen sein.

Die neuen Konsolen stehen ja am Anfang ihrer Karriere - da kann sich schon noch einiges entwickeln...

Wahrscheinlich werden die Konsolen sogar ein Zugpferd für die nötigen Software/Compiler/Bibliotheks-Verbesserungen sein.

Opteron

Redaktion

☆☆☆☆☆☆

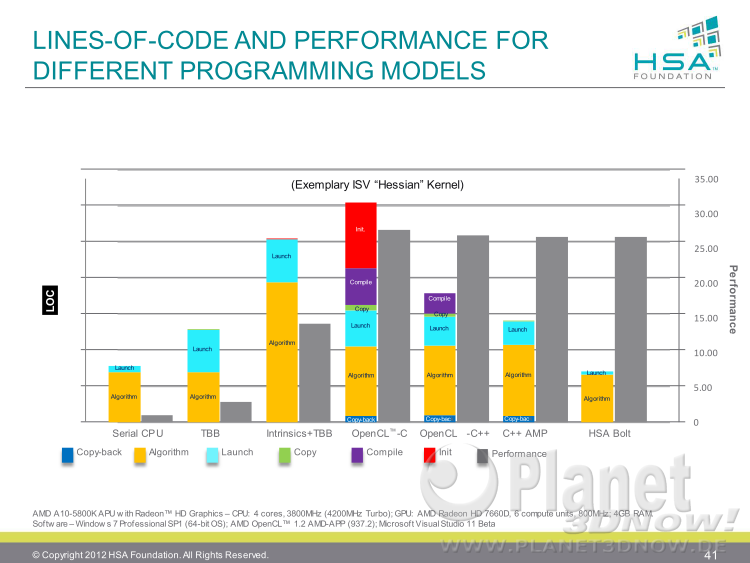

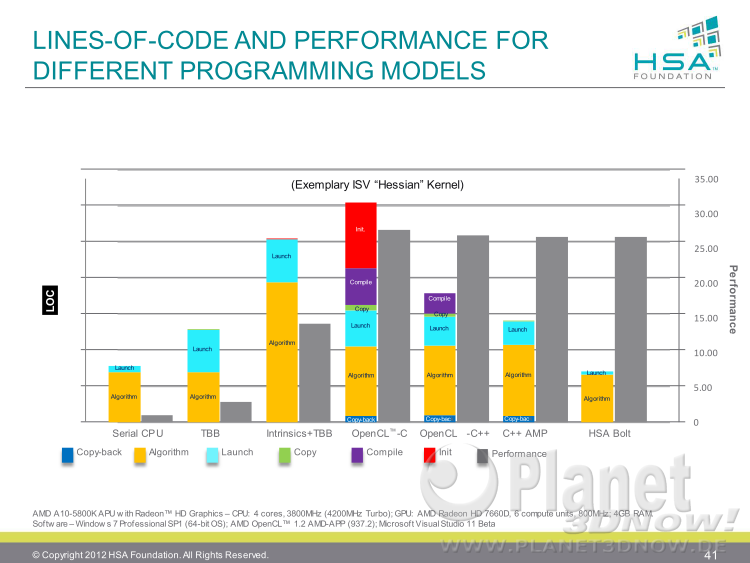

Ich seh da auch keinen Widerspruch in den beiden Positionen. Der Epic-Kollege beschwert sich über den Wildwuchs bei der Programmierung. Mir drängt sich da der Eindruck auf, dass er nur was von hUMA gehört hat, aber nicht zum dazu passenden, umfassenden HSA-Ansatz. Mit HSAIL hat man ja genau das, was er fordert, einen schönen, schlanken Programmieransatz. Da ist die alte Folien hier wichtig:

Scheinbar ist Tim Sweeny auf den Stand vor/bis zum langen Mittelbalken.

Man könnte seine Kritik auch so zusammenfassen: Die (hUMA)Hardware sieht gut aus, aber was ist mit der Software?

Die Frage ist einfach zu beantworten, siehe oben.

Edit:

@mibo:

Ja, wobei Sony für die PS4 ne eigene Shadersprache spezifiziert hat, PSSL:

Mal schauen, wieviel davon zurückfließen kann.

Edit2:

Es stellt sich auch etwas die Frage, wie unabhängig der Tim hier ist, die Demos der neuen Unrealengine gabs bei nvidia:

http://blogs.nvidia.com/blog/2013/07/24/sweeney/

PCGH schreibt:

ach noch ein nettes ZItat von der Epic-Webseite:

und früher haben sie ne Grafikdemo für nvidia programmiert:

Epic, NVIDIA & Tim Sweeney Talk Samaritan & The Future Of Gaming Graphics | N4G.

Insgesamt hab ich mich schon gewundert, ob ein Insider wie Sweeny sich nicht richtig auskennt, aber da könnt er wohl auch einfach aus Loyalität zu nvidia gehandelt und wider besseren Wissen irgendwas Negatives gesagt haben.

Scheinbar ist Tim Sweeny auf den Stand vor/bis zum langen Mittelbalken.

Man könnte seine Kritik auch so zusammenfassen: Die (hUMA)Hardware sieht gut aus, aber was ist mit der Software?

Die Frage ist einfach zu beantworten, siehe oben.

Edit:

@mibo:

Ja, wobei Sony für die PS4 ne eigene Shadersprache spezifiziert hat, PSSL:

http://www.heise.de/ct/artikel/GDC-Was-Entwickler-und-User-bei-der-Playstion-4-erwartet-1831997.htmlSonys neue Playstation Shader Language (PSSL), die für die PS4 entwickelt wurde, soll die Hardware auf der Low-Level-Ebene wesentlich besser ausnutzen. Sie sei mit HLSL vergleichbar und böte viele Funktionen, die über DirectX 11.1 und OpenGL 4.0 hinaus gehen und die Shader-Programmierung vereinfachen. Zudem könnten die GPGPU-Berechnungen simultan zu den Grafikberechnungen ausgeführt werden, was auf PCs derzeit nicht möglich sei.

Mal schauen, wieviel davon zurückfließen kann.

Edit2:

Es stellt sich auch etwas die Frage, wie unabhängig der Tim hier ist, die Demos der neuen Unrealengine gabs bei nvidia:

http://blogs.nvidia.com/blog/2013/07/24/sweeney/

PCGH schreibt:

http://www.pcgameshardware.de/Nvidi...it-Demo-2-Watt-GPU-Video-vorgestellt-1080140/Tim Sweeney findet Project Logan spannend Passend zur Demonstration von Nvidias Project Logan zeigt sich auch Epics Technikguru Tim Sweeney mehr als begeistert. Warum? Epic ist quasi Partner von Nvidia, denn die Demonstrationen laufen unter OpenGL 4.3 auf der Unreal Engine 4 von Epic. Laut Sweeney würde es OpenGL 4.3 ermöglichen, dass die High-End-Grafik unter DirectX 11 für PC und Xbox One/PS4 nun auch für mobile Systeme (Smartphones und Tablets) möglich ist. Dadurch würden ganz neue Möglichkeiten der Crossplattform-Entwicklung entstehen.

ach noch ein nettes ZItat von der Epic-Webseite:

http://epicgames.com/community/2013/07/epic-games-at-siggraph-2013/Thanks to an exciting collaboration with our partners at NVIDIA, we are demonstrating desktop PC game content developed with Unreal Engine 4 on NVIDIA’s next-generation mobile processor, “Logan.”

und früher haben sie ne Grafikdemo für nvidia programmiert:

Epic, NVIDIA & Tim Sweeney Talk Samaritan & The Future Of Gaming Graphics | N4G.

Insgesamt hab ich mich schon gewundert, ob ein Insider wie Sweeny sich nicht richtig auskennt, aber da könnt er wohl auch einfach aus Loyalität zu nvidia gehandelt und wider besseren Wissen irgendwas Negatives gesagt haben.

mibo

Grand Admiral Special

- Mitglied seit

- 05.01.2003

- Beiträge

- 2.296

- Renomée

- 65

- Standort

- Hannover

- Mein Laptop

- Lenovo T450s

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800X3D

- Mainboard

- ASUS B550M-PLUS

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x16GB DDR4 ECC

- Grafikprozessor

- AMD 6700XT

- Display

- HP X27i

- SSD

- Samsung 860EVO, 960EVO, WD 850X

- Optisches Laufwerk

- DVD-Brenner :-)

- Netzteil

- BQ Dark Power 12 750W

- Betriebssystem

- Suse Tumbleweed / Win10 64Bit

- Webbrowser

- Firefox

@Opteron: Man kann Sweeneys Unvoreingenommenheit natürlich anzweifeln.

Aber, was ist dieser "Hessian Kernel" auf Deiner Folie? Vermutlich nur "Compute", ohne Grafik-Shader. Damit aber nicht für die Spieleprogrammierung auf Konsolen relevant (bzw. nur ein Teil der Wahrheit).

Sonys neue Playstation Shader Language (PSSL) ist dann vermutlich auch noch brandneu - hat also auch noch nicht beweisen können, dass es damit wirklich einfacher und schneller zu programmieren geht (für komplette Spiele). Ist jedenfalls ein spannendes, sich entwickelndes Feld.

Aber, was ist dieser "Hessian Kernel" auf Deiner Folie? Vermutlich nur "Compute", ohne Grafik-Shader. Damit aber nicht für die Spieleprogrammierung auf Konsolen relevant (bzw. nur ein Teil der Wahrheit).

Sonys neue Playstation Shader Language (PSSL) ist dann vermutlich auch noch brandneu - hat also auch noch nicht beweisen können, dass es damit wirklich einfacher und schneller zu programmieren geht (für komplette Spiele). Ist jedenfalls ein spannendes, sich entwickelndes Feld.

Opteron

Redaktion

☆☆☆☆☆☆

Naja, das Compute ist aber genau ne Sache, auf die die Spieleentwickler scharf sind, steht auch oben verlinkten heise Artikel zu PSSL:@Opteron: Man kann Sweeneys Unvoreingenommenheit natürlich anzweifeln.

Aber, was ist dieser "Hessian Kernel" auf Deiner Folie? Vermutlich nur "Compute", ohne Grafik-Shader. Damit aber nicht für die Spieleprogrammierung auf Konsolen relevant (bzw. nur ein Teil der Wahrheit).

Zudem könnten die GPGPU-Berechnungen simultan zu den Grafikberechnungen ausgeführt werden, was auf PCs derzeit nicht möglich sei.

Schau Dir mal das Spiel Knack an, da sieht man das relativ gut, die ganzen Einzelteilchen aus der die Spielfigur besteht werden einzeln berechnet (stand mal irgendwo, wenn ich nichts verwechsle ^^)

https://www.youtube.com/watch?v=caPNRZmBH8g

Was genau soll dann der schwarze, relativ dünne Pfeil vom eDRAM Bus zum CPU SI darstellen, neben dem dann steht "any DRAM data can be coherent with CPU caches" (Bild SoC Components). Klingt für mich schon so, als wäre da eine Kohärenz, aber vielleicht verstehe ich den Pfeil falschallerdings ist bei dem 32 MB großen eDRAM Speicher, der auf dem gleichen Stück Silizium untergebracht ist, kein Kohärenzzugriff vermerkt

Opteron

Redaktion

☆☆☆☆☆☆

Was genau soll dann der schwarze, relativ dünne Pfeil vom eDRAM Bus zum CPU SI darstellen, neben dem dann steht "any DRAM data can be coherent with CPU caches" (Bild SoC Components). Klingt für mich schon so, als wäre da eine Kohärenz, aber vielleicht verstehe ich den Pfeil falsch

Das DRAM bezieht sich auf den DRAM-Controller darunter in dem die grünen und blauen Pfeile vom GPU bzw. CPU-Mem-Controller reingehen. Vom Aufbau her identisch zu Trinity.

Der dünne Pfeil ist schon ein ziemliches Kuriosum, irgendwie wird da vermutlich noch ein Zugriff möglich sein, aber ob das kohärent sein wird ist die große Frage. Eher nicht, denn der Pfeil geht nicht zum blauen Kohärenzblock, sondern zu nem Pfeil zwischen jenem und den CPUs. Wenn man die Dicke als bandbreitenindikator nimmt (was nicht stimmen muss), dann wäre das Ding auch recht schmalbandig. Eventuell ist auch eine bestimmte feste Größe, wie jetzt bei den aktuellen UMA-Systemen für die CPU vorgesehen, eben als Austauschfenster, das wäre auch noch möglich. Im Unterschied zu aktuellen APU-Systemen aber halt den Großteil des edRAM-Speichers für die GPu und nur 1MB oder so für die CPU. Je nachdem was man halt braucht. Aber ohne genaue Daten ist das auch schwer zu sagen. Mal schauen, was im Paper steht, wenns mal öffentlich wird.

So oder so, das Argument bleibt, wenn der Chip hUMA könnte, hätten sies ganz sicher gesagt ... die hot chips ist schließlich keine Erstsemester Belustigungsveranstaltung.

ONH

Grand Admiral Special

Naja, das Compute ist aber genau ne Sache, auf die die Spieleentwickler scharf sind, steht auch oben verlinkten heise Artikel zu PSSL:

Das Problem wird wohl sein das PSSL nicht überall vorhanden ist und AMP C++ wohl auch nicht und HSAil hat noch keine Finale Spezifikation. Eine Platformunabhängige Programmierung geht halt noch nicht und mehr sagt er nicht im endeffeht beklagt er sich darüber das die SW Unterstützung fehlt, was wohl das einzige Haar in der suppe ist das er ohne was zu erfinden finden konnte, sonnst wäre sicher was konkreteres genannt worden.

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Erstmal vielen Dank an Opteron für den sauber verfassten Artikel und die interessanten sachlichen Beiträge!

Was könnte denn die Motivation für Microsoft gewesen sein, hier trotz ähnlicher Komponenten und weitestgehend gleichem Pool an Funktionsbausteinen ein eigenes Süppchen zu kochen, das trotz relativ hoher Chip-Größe im Vergleich zur PS4 bereits jetzt weit zurückliegt, was die zu erwartende Performance betrifft? Liegt die Priorität dabei auf einem möglichst effizienten und für den Kunden idealerweise lüfterlosen Betrieb?

Was könnte denn die Motivation für Microsoft gewesen sein, hier trotz ähnlicher Komponenten und weitestgehend gleichem Pool an Funktionsbausteinen ein eigenes Süppchen zu kochen, das trotz relativ hoher Chip-Größe im Vergleich zur PS4 bereits jetzt weit zurückliegt, was die zu erwartende Performance betrifft? Liegt die Priorität dabei auf einem möglichst effizienten und für den Kunden idealerweise lüfterlosen Betrieb?

Opteron

Redaktion

☆☆☆☆☆☆

Das liegt und fällt mit der Speicherentscheidung DDR3 <> GDDR5. DDR3 ist billiger, GDDR5 ist teurer, aber Microsoft musste sparen, da Ihr Kinect-Zeugs ~100 Dollar kostet.Was könnte denn die Motivation für Microsoft gewesen sein, hier trotz ähnlicher Komponenten und weitestgehend gleichem Pool an Funktionsbausteinen ein eigenes Süppchen zu kochen, das trotz relativ hoher Chip-Größe im Vergleich zur PS4 bereits jetzt weit zurückliegt, was die zu erwartende Performance betrifft?

Deshalb muss die Konsole selbst billiger werden. Deshalb haben sie sich für DDR3 entschieden, was selbst mit Quad-Channel keine gute Speicherbandbreite hat, also haben sie noch eDRAM draufgepappt um das etwas auszugleichen, was dann wiederum aber (vermutlich) hUMA und mehr GPU-Shader geopfert hat.

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Microsoft hat ja schon einmal durchblicken lassen, dass "Casual Games" die neuen Goldesel sind. Die meisten dieser "Casual Games" sind jedoch eher einfach gestrickt und graphisch nicht sehr anspruchsvoll. Es sind vielfach Low Budget Projekte. Insofern ist es eigentlich nur konsequent die Konsole darauf auszurichten. Sony sieht wohl weniger Potential in den "Casual Games" und ich hoffe sie behalten damit Recht. Ich würde Sony einen Erfolg der Playstation 4 jedenfalls gönnen und es sieht zur Zeit ganz danach aus als könnte sie größere Marktanteile erobern. Allerdings sollte man nicht vorschnell über die Fähigkeiten der beiden Konsolen urteilen. Das wird frühestens im Jahr 2016 möglich sein. Vieleicht ist die Xbox One doch nicht derart unterlegen wie oft gemutmaßt wird. Man kann nicht einfach die Shaderanzahl, Speicherbandbreite, Taktfrequenzen stur zusammen zählen.

Opteron

Redaktion

☆☆☆☆☆☆

Jein, eigentlich schon, aber für das DDR3 haben sie ja 32MB eDRAM aufs Die holen müssen, was die Fläche wieder vergrößert.Also Kinect im Tradeoff gegen Performance/Fläche?

@Spina: Ja, aber eben aus dem Grund versteh ich die schlechte Zusammenarbeit mit den Indi-Entwicklern auch nicht. Also MS macht da ziemlich viel Mist ... teilweise sind ja zurückgerudert, aber naja, ob das noch was wird ...

Die PS4 ist jetzt relativ simpel zu programmieren, im Vergleich zur PS3 ein Kinderspiel. Da seh ich eigentlich überall die PS4 vorne. Kinect ist nett, aber oversized, für einfache Sachen wird die PS4-Kamera auch noch reichen.

Opteron

Redaktion

☆☆☆☆☆☆

Hier gibts ein Interview mit den Xbox-Entwicklern:

http://www.eurogamer.net/articles/digitalfoundry-the-complete-xbox-one-interview

Da sagen sie, dass sie coherenten Speicher zw. GPU und CPU hätten ...

http://www.eurogamer.net/articles/digitalfoundry-the-complete-xbox-one-interview

Da sagen sie, dass sie coherenten Speicher zw. GPU und CPU hätten ...

Markus Everson

Grand Admiral Special

Wenn Du den Artikel wirklich aufmerksam und Satz für Satz liest und den ganzen Rauch der zahlreichen Nebelkerzen beiseite schiebst - nein, genau das ist es was sie nicht sagen.

Ähnliche Themen

- Antworten

- 11

- Aufrufe

- 3K

G

- Antworten

- 7

- Aufrufe

- 4K

- Antworten

- 135

- Aufrufe

- 22K

- Antworten

- 22

- Aufrufe

- 9K

- Antworten

- 111

- Aufrufe

- 17K