App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

- Foren

- Planet 3DNow! Community

- Planet 3DNow! Distributed Computing

- Team Planet 3DNow!

- Café Planet 3DNow!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Allgemeiner Plauderchat über das Thema DC Part III

- Ersteller joe carnivore

- Erstellt am

- Status

- Für weitere Antworten geschlossen.

olsen_gg

Grand Admiral Special

- Mitglied seit

- 02.03.2012

- Beiträge

- 10.447

- Renomée

- 717

- Standort

- Stralsund

- Aktuelle Projekte

- WCG SCC1, HSTB, wechselnde..

- Lieblingsprojekt

- alle medizinisch / pharmazeutischen Projekte

- Meine Systeme

- Ryzen 9 3900X, 2x Ryzen 7 3700X, ( noch vorhanden: i7-4770S, Lappy i7-3630QM, 13x ARM...)

- BOINC-Statistiken

- Details zu meinem Desktop

- Verschiedenes

- Zuviel Details, das muss nicht veröffentlicht werden.

Solange das 21H1 noch nicht dabei war... Da soll es auch wieder diverse Probs geben.

Maverick-F1

Grand Admiral Special

Das ist ja auch erst seit heute offiziell freigegeben und wird noch nicht für alle Systeme ausgerollt...

Crashtest

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2008

- Beiträge

- 9.275

- Renomée

- 1.413

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Collatz, yoyo, radac

- Lieblingsprojekt

- yoyo

- Meine Systeme

- Ryzen: 2x1600, 5x1700, 1x2700,1x3600, 1x5600X; EPYC 7V12 und Kleinzeuch

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Lenovo IdeaPad 5 14ALC05

- Details zu meinem Desktop

- Prozessor

- Ryzen 7950X / Ryzen 4750G

- Mainboard

- ASRock B650M PGRT / X570D4U

- Kühlung

- be quiet! Dark Rock Pro4 / Pure Rock Slim 2

- Speicher

- 64GB DDR5-5600 G Skill F5-5600J3036D16G / 32 GB DDR4-3200 ECC

- Grafikprozessor

- Raphael IGP / ASpeed AST-2500

- Display

- 27" Samsung LF27T450F

- SSD

- KINGSTON SNVS2000G

- HDD

- - / 8x Seagate IronWolf Pro 20TB

- Optisches Laufwerk

- 1x B.Ray - LG BD-RE BH16NS55

- Soundkarte

- onboard HD?

- Gehäuse

- zu kleines für die GPU

- Netzteil

- be quiet! Pure Power 11 400W / dito

- Tastatur

- CHERRY SECURE BOARD 1.0

- Maus

- Logitech RX250

- Betriebssystem

- Windows 10 19045.4355 / Server 20348.2227

- Webbrowser

- Edge 124.0.2478.51

- Verschiedenes

- U320 SCSI-Controller !!!!

- Internetanbindung

- ▼1000 MBit ▲82 MBit

Das 20KB Update für Windows 10 20H1 und 20H2 auf 21H1 sind ein Witz und nicht das Problem derzeit.

Hab ich seit Dezember 2020 drauf....

Hab ich seit Dezember 2020 drauf....

Maverick-F1

Grand Admiral Special

Das "Update" selber wurde ja schon vorher verteilt und aktualisiert - der "Enabler" ist nur recht klein.

Kann aber schon sein, dass die Pakete, die das eigentliche Upgrade ausmachen noch problembehaftet sind...

Kann aber schon sein, dass die Pakete, die das eigentliche Upgrade ausmachen noch problembehaftet sind...

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.855

- Renomée

- 2.815

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Vom Penta habe ich bei Einstein immer noch 146 im Pending, da scheint es ja grössere "Müllbunker" gegeben zu haben. Das geht da von den ca 300 beim Ende auch nur langsam runter. Bei Primegrid ist nuch 1 WU im Pending.

Das dürfte ja bei anderen im Team noch heftiger sein.

Das dürfte ja bei anderen im Team noch heftiger sein.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Bei Primegrid bekomme ich jeden Tag noch credits.

Bei Einstein hat mein Absturz auf dem Hauptrechner sicher auch etwas mehr Pending erzeugt als erwartet.

Bei Einstein hat mein Absturz auf dem Hauptrechner sicher auch etwas mehr Pending erzeugt als erwartet.

Thyler Durden

Admiral Special

- Mitglied seit

- 27.06.2002

- Beiträge

- 1.606

- Renomée

- 244

- Standort

- Tyrol

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Querbeet

- Lieblingsprojekt

- POEM

- Meine Systeme

- AMD R9-3900x; AMD R7 1700; AMD R5 2400G; ThinkPad 595 & 495; J1900

- BOINC-Statistiken

- Mein Laptop

- Thinkpad E595

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 3900X

- Mainboard

- ASUS ROG STRIX B550-E

- Kühlung

- Wakü mit 420 Mora 3

- Speicher

- Crucial Ballistix schwarz DIMM Kit 64GB, DDR4-3200 @ 3800, CL16-18-18-36

- Grafikprozessor

- AMD ref. RX6900XT

- Display

- EIZO EV3285

- SSD

- 3x 1 TB 1x 0,5 TB

- HDD

- 1x 6 TB

- Optisches Laufwerk

- n.A.

- Soundkarte

- Sound BlasterX AE-5 Plus

- Gehäuse

- In Win 303 weiß

- Netzteil

- be quiet! Straight Power 11 1KW

- Tastatur

- Fnatic Gear Rush G1 Gaming Keyboard, MX brown

- Maus

- Roccat Kain 120 Aimo schwarz

- Betriebssystem

- Win 10 pro

- Schau Dir das System auf sysprofile.de an

Einstein: 110 WU

hier ist Alles durchwachsen, abgebrochen, Zeitüberschreitung, Berechnungsfehler aber nicht mehr als 2x

Prime: 4 WU

alle wurden 2 wurden 4x aufgegeben und 2 nur 3x aufgegeben bzw. Zeitüberschreitung

.......sind die Chicken wings noch am knuspern (möge Ihnen beim Händewaschen die Hemdsärmel runterrutschen!)

hier ist Alles durchwachsen, abgebrochen, Zeitüberschreitung, Berechnungsfehler aber nicht mehr als 2x

Prime: 4 WU

alle wurden 2 wurden 4x aufgegeben und 2 nur 3x aufgegeben bzw. Zeitüberschreitung

.......sind die Chicken wings noch am knuspern (möge Ihnen beim Händewaschen die Hemdsärmel runterrutschen!)

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.855

- Renomée

- 2.815

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

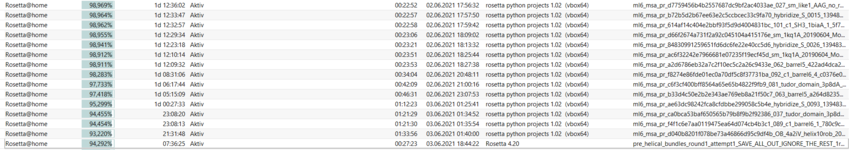

Bei der verblieben WU bei Primegrid ist das schon eine nette History:

| Erklärung | Status | Laufzeit (sek) | CPU Zeit (sek) | Punkte | Anwendung | |||

|---|---|---|---|---|---|---|---|---|

| 1222931626 | 1078143 | 8 May 2021 | 15:26:46 UTC | 15 May 2021 | 16:26:46 UTC | Zeitüberschreitung - keine Antwort | 0.00 | 0.00 | --- | PPS (Sieve) v1.42 (cudaPPSsieve) |

| 1222931627 | 1078021 | 8 May 2021 | 15:26:20 UTC | 10 May 2021 | 19:58:16 UTC | Abbruch durch Benutzer | 0.00 | 0.00 | --- | PPS (Sieve) v1.42 (cudaPPSsieve) |

| 1224034490 | 1077547 | 10 May 2021 | 20:02:15 UTC | 10 May 2021 | 22:46:51 UTC | Abbruch durch Benutzer | 0.00 | 0.00 | --- | PPS (Sieve) v1.42 (cudaPPSsieve) |

| 1224114324 | 934556 | 10 May 2021 | 23:59:41 UTC | 11 May 2021 | 18:27:44 UTC | Fertig, Warte auf Bestätigung | 1,221.36 | 1,218.20 | ausstehend | PPS (Sieve) v1.42 (cudaPPSsieve) |

| 1225649922 | 1041353 | 15 May 2021 | 16:37:36 UTC | 21 May 2021 | 16:44:51 UTC | Abbruch durch Benutzer | 0.00 | 0.00 | --- | PPS (Sieve) v1.42 (openclatiPPSsieve) |

| 1227172866 | 1053976 | 21 May 2021 | 17:18:01 UTC | 28 May 2021 | 18:18:01 UTC | In Bearbeitung |

X_FISH

Grand Admiral Special

- Mitglied seit

- 03.02.2006

- Beiträge

- 4.250

- Renomée

- 1.974

- Aktuelle Projekte

- distributed.net (seit 2000), BOINC (seit 2017)

- BOINC-Statistiken

Meiner rechnet noch immer. Da ich blöderweise Collatz aktiviert habe -> haben die sich vorgemogelt.Vom Penta habe ich bei Einstein immer noch 146 im Pending, da scheint es ja grössere "Müllbunker" gegeben zu haben. Das geht da von den ca 300 beim Ende auch nur langsam runter. Bei Primegrid ist nuch 1 WU im Pending.

Das dürfte ja bei anderen im Team noch heftiger sein.

Grüße, Martin

herby44

Vice Admiral Special

- Mitglied seit

- 14.09.2016

- Beiträge

- 684

- Renomée

- 222

- Standort

- Niedersachsen

- Aktuelle Projekte

- WCG, TN-Grid, Collatz, Asteroids, Seti, Climate Prediction, und andere

- Meine Systeme

- 3 X R7-1700, 1 X R5-3400GE, 1 X i7-7700T, 1 X i7-7700, 2 X 3950XT, 5 X 3900XT; 2 X 5950XT, 2 X 4650G, 1 X 4750G, 1 X 5700G

- BOINC-Statistiken

- Details zu meinem Desktop

Mein pending bei Einstein 574, mindestens 2 Tage habe ich noch nach Penta ende Einstein gerechnet.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.855

- Renomée

- 2.815

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Gerade bei TN-Grid gesehen:

Meine Gammelwu bei Primgrid ist weg noch 63 bei Einstein.

Nutzer des Tages

Sabroe_SMC

Tach auch. Seit Ende 2006 mache ich bei diesem Boinc-Dingens mit. Beruflich hab ich nix mit Computern zu tun, bin da eher handwerklich unterwegs. Seit...

Meine Gammelwu bei Primgrid ist weg noch 63 bei Einstein.

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.659

- Renomée

- 1.061

- Aktuelle Projekte

- MW@H; TN Grid, Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

"Rosettiert" hier eigentlich noch jemand?

Falls ja, habt ihr auch Probleme mit den python vbox- WUs. Der Ripper hat 8 - 10 Stück am Laufen, die inzwischen über 1 Tag laufen. Ich hadere noch mit mir, das abzubrechen...

Falls ja, habt ihr auch Probleme mit den python vbox- WUs. Der Ripper hat 8 - 10 Stück am Laufen, die inzwischen über 1 Tag laufen. Ich hadere noch mit mir, das abzubrechen...

enigmation

Admiral Special

Ich rosettiere auch, bis jetzt fast ohne Fehler. Von diesen python-vbox scheine ich noch keine berechnet zu haben. Wie sieht die Aufgabe dazu aus, kannst einen Link dahin senden?

Landjunge

Admiral Special

- Mitglied seit

- 29.10.2008

- Beiträge

- 1.460

- Renomée

- 607

- Standort

- bei Uelzen, NDS

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- keins

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E3 1230 V2

- Mainboard

- AsRock Z77 Extreme4 - M

- Kühlung

- Noctua NH-L12S

- Speicher

- 16GB 1866er G.Skill

- Grafikprozessor

- Zotac RTX 3070 Twin Edge OC @ AMP Holo Bios (270W TDP)

- Display

- Philips 274E

- SSD

- Crucial BX200 256GB, Crucial MX500 1TB

- Optisches Laufwerk

- defekt ausgebaut

- Soundkarte

- Onboard

- Gehäuse

- Silverstone Cube

- Netzteil

- Coolermaster G550M (teilweise recappt)

- Tastatur

- Microsoft Wired Keyboard 600

- Maus

- Razer Deathadder Essential 2021

- Betriebssystem

- Windows 11 x64 Pro

- Webbrowser

- Firefox Update wird heruntergeladen...

- Internetanbindung

- ▼75 ▲31

Hatte auch noch rosettet, aber bisher keine Fehler gehabt bzw. mitbekommen. Dafür hab ich wohl grad minecraft@home geschrotet. War eh unnütz

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.659

- Renomée

- 1.061

- Aktuelle Projekte

- MW@H; TN Grid, Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

Ich mach auch noch was. Hab das aber eher nicht beobachtet und einfach laufen lassen. Hier ist mal eine fertige.

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.659

- Renomée

- 1.061

- Aktuelle Projekte

- MW@H; TN Grid, Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

Ok, erfolgreich fertige dieser Art habe ich auch, aber nicht mit so radikalen Laufzeiten. Bei mir eher 8000 - 16000 Sek! Daher die Ungeduld über 1d 12 h

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Ich bade noch den Fehler (?) des BoincManagers aus, dass bei Puffer = 0 unendlich viele WUs gezogen werden.

In meiner Erinnerung war 0 noch mit "für jeden Kern eine WU" verknüpft. Aber in der Praxis hat sich der BM so viel gezogen, wie in der deadline zu schaffen wäre.

In meiner Erinnerung war 0 noch mit "für jeden Kern eine WU" verknüpft. Aber in der Praxis hat sich der BM so viel gezogen, wie in der deadline zu schaffen wäre.

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.659

- Renomée

- 1.061

- Aktuelle Projekte

- MW@H; TN Grid, Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

Ich habe heute per app_config die rosetta_python WUs auf 2 - 3 parallel auszuführende beschränkt. Änderung der app_config eingelesen (und sonst nix geändert) und auf einmal wurde der Rechner mit 900 8h WUs überschwemmt. Das reicht für 10 Tage, obwohl die Deadline 3 Tage beträgt und der WU Vorrat im BM auf 0,3 Tage eingestellt ist (in Erwartung eines CPU-Sprints ab morgen). Der eine Rechner, den ich nicht angefasst habe, der hält schön sein WU-Limit.Ich bade noch den Fehler (?) des BoincManagers aus, dass bei Puffer = 0 unendlich viele WUs gezogen werden.

In meiner Erinnerung war 0 noch mit "für jeden Kern eine WU" verknüpft. Aber in der Praxis hat sich der BM so viel gezogen, wie in der deadline zu schaffen wäre.

Soviel kann ich mich gar nicht am Kopf kratzen...

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.358

- Renomée

- 1.977

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

kennt ihr eine Möglichkeit in der app_config verschiedenen GPUs eine unterschiedliche Anzahl an gleichzeitig laufenden WUs festzulegen?

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.900

- Renomée

- 1.435

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Irgendwo im WCG Forum zu Beta oder OpenPandemics hatte dazu jemand ein Beispiel gepostet. Müsste April/Mai gewesen sein.

Ich hatte das für mich zu dem Zeitpunkt schon über 2 Instanzen gelöst. Daher hatte ich es nicht ausprobiert oder gespeichert.

Ich hatte das für mich zu dem Zeitpunkt schon über 2 Instanzen gelöst. Daher hatte ich es nicht ausprobiert oder gespeichert.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.358

- Renomée

- 1.977

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich habe leider nichts gefunden.

Dann muss es erstmal so gehen denn bei meinem kleinen DP Cruncher habe ich das Problem dass der Treiber bei der IGP im Multi WU Betrieb hängen bleibt, zurückgesetzt wird, dabei eine der beiden WUs geschrottet wird und die ander hängen bleibt. Die HD7970 interessiert das wiederum herzlich wenig und knuspert fleissig weiter an den Milkyway WUs.

Da die IGP mit einer WU nicht ausgelastet wird takten die CPU Kerne nicht mehr runter und die WUs auf der HD7970 laufen flotter weil sie mehr CPU Power abbekommen.

Meine Überlegung war deshalb der IGP nur eine WU zuzuordnen und der HD7970 gleich 3 Stück zu verpassen um die Credit Ausbeute zu maximieren.

Im Moment bin ich eher ungewollt bei einer WU auf der IGP weil die zweite beim letzten Treiber Reset wieder hängen geblieben ist. Mit pausieren und wieder laufen lassen wird sie dann idR. normal beendet

Dann muss es erstmal so gehen denn bei meinem kleinen DP Cruncher habe ich das Problem dass der Treiber bei der IGP im Multi WU Betrieb hängen bleibt, zurückgesetzt wird, dabei eine der beiden WUs geschrottet wird und die ander hängen bleibt. Die HD7970 interessiert das wiederum herzlich wenig und knuspert fleissig weiter an den Milkyway WUs.

Da die IGP mit einer WU nicht ausgelastet wird takten die CPU Kerne nicht mehr runter und die WUs auf der HD7970 laufen flotter weil sie mehr CPU Power abbekommen.

Meine Überlegung war deshalb der IGP nur eine WU zuzuordnen und der HD7970 gleich 3 Stück zu verpassen um die Credit Ausbeute zu maximieren.

Im Moment bin ich eher ungewollt bei einer WU auf der IGP weil die zweite beim letzten Treiber Reset wieder hängen geblieben ist. Mit pausieren und wieder laufen lassen wird sie dann idR. normal beendet

Maverick-F1

Grand Admiral Special

Die 7970 verträgt auch 4 WUs parallel - da hab' ich bei mir die größte Ausbeute...

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.358

- Renomée

- 1.977

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Bei mir bekommt jede GPU WU ihren eigenen Kern, erst recht wenn es um die Bulldozer Architektur geht und die APU hat... *Trommelwirbel* ....4 Stück.

- Status

- Für weitere Antworten geschlossen.

Ähnliche Themen

- Antworten

- 2K

- Aufrufe

- 135K

- Antworten

- 3K

- Aufrufe

- 182K

- Antworten

- 396

- Aufrufe

- 34K

- Antworten

- 0

- Aufrufe

- 943