App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

- Foren

- Planet 3DNow! Community

- Planet 3DNow! Distributed Computing

- Team Planet 3DNow!

- Café Planet 3DNow!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Allgemeiner Plauderchat über das Thema DC Part IV

- Ersteller erde-m

- Erstellt am

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Genaustens, Danke!

LordNord

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 07.09.2005

- Beiträge

- 5.865

- Renomée

- 528

- Standort

- S-H

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3900X

- Mainboard

- ASUS TUF Gaming B550-Plus

- Kühlung

- be quiet! Dark Rock 4

- Speicher

- 2x16GB Crucial DDR4 3200

- Grafikprozessor

- ASUS ROG STRIX Vega 64 GAMING OC

- Display

- AOC Q3279VWFD8

- SSD

- Kingston A2000 1TB + WD Blue SN550 1TB Crucial BX500 2TB + Mega Fastro MS200 2TB Extern

- HDD

- 8TB extern

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 Compact Lite

- Netzteil

- Be quiet! Pure Power 9 600W

- Tastatur

- Corsair K70 MK.2 Low Profile

- Betriebssystem

- Win 10 64Bit

- Webbrowser

- Firefox

- Internetanbindung

-

▼200

▲200

Mining und Kryptowährungen: Nvidia entfernt seine Mining-Bremse für GeForce-GPUs

Wie erste Tests bestätigen, hat Nvidia mit dem GeForce 522.25 die Mining-Bremse auf GeForce-Grafikkarten wieder deaktiviert.

Manche Nvidia GPU Besitzer berichten von gestiegener Performence in Games.

Vielleicht kann ja auch Boinc von dem neuen Treiber profitieren?

Möglich, dass es aber auch gar keinen Effekt hat.

Ihr könnt es ja mal ausprobieren.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.337

- Renomée

- 1.974

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich glaube nvidia hatte da im Treiber allgemein was recht deutlich umgebaut was sich nun in der Performance bemerkbar macht.

Computerbase wittmete dem beim Update des 4090er Tests einen kleinen Zusatztest mit der 3090Ti.

www.computerbase.de

www.computerbase.de

Computerbase wittmete dem beim Update des 4090er Tests einen kleinen Zusatztest mit der 3090Ti.

Nvidia GeForce RTX 4090 FE im Test: Brachial schnell: Leistung mit weniger TDP, Overclocking, PCIe 3.0 und neue Treiber (Update)

Nvidia GeForce RTX 4090 im Test: Leistung mit weniger TDP, Overclocking, PCIe 3.0 und neue Treiber (Update)

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Ich vermute einfach mal, dass die Miningbremse Einfluss auf die Gesamtperformance hatte. Nu isse wech und schwupps...

Welches (Unter) Projekt hat denn immer gleichlang dauernde GPU WUs? Dann teste ich gern den neuen Treiber. Einstein hat nix, Numberfields und PG PPS Sieve laufen unterschiedlich lang. Bin im Moment bei Moo! Das scheint zu passen.

Welches (Unter) Projekt hat denn immer gleichlang dauernde GPU WUs? Dann teste ich gern den neuen Treiber. Einstein hat nix, Numberfields und PG PPS Sieve laufen unterschiedlich lang. Bin im Moment bei Moo! Das scheint zu passen.

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.596

- Renomée

- 1.310

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Wie meinenEinstein hat nix

Also meine Radeon ist gut versorgt.

Gruß

Ritschie

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Jetzt hab ich ein Dutzend bekommen. Kann keine Veränderung feststellen.

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

jupp

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

X_FISH

Grand Admiral Special

- Mitglied seit

- 03.02.2006

- Beiträge

- 4.242

- Renomée

- 1.970

- Aktuelle Projekte

- distributed.net (seit 2000), BOINC (seit 2017)

- BOINC-Statistiken

HAH! Wer sucht wird fündig... Da ich bis jetzt keine Sonne gefunden habe -> noch mal auf alten Platten gesucht.

Kann mich jetzt bei GPUGRID anmelden. Das alte, scharfkantige Gehäuse hatte noch eine Platte drin. Passenderweise hieß die Kiste »waitandbleed« mit Namen. Jetzt fehlt nur noch eine nVidia-Karte die etwas performanter ist...

Jetzt fehlt nur noch eine nVidia-Karte die etwas performanter ist...

Grüße, Martin

Kann mich jetzt bei GPUGRID anmelden. Das alte, scharfkantige Gehäuse hatte noch eine Platte drin. Passenderweise hieß die Kiste »waitandbleed« mit Namen.

Jetzt fehlt nur noch eine nVidia-Karte die etwas performanter ist...

Jetzt fehlt nur noch eine nVidia-Karte die etwas performanter ist...

Grüße, Martin

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Diese Python Dinger sind zusätzlich ganz schön CPU lastig. Der 3700X tobt bei 50-70% Auslastung rum.

JagDoc

Grand Admiral Special

- Mitglied seit

- 18.08.2002

- Beiträge

- 3.159

- Renomée

- 549

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- RNA, Pogs, Enigma, Asteroids

- Lieblingsprojekt

- RNA

- Meine Systeme

- i7-3820, i7-3930, ODROID-X2/U2

- BOINC-Statistiken

- Folding@Home-Statistiken

Unter Linux ist die CPU-Last viel weniger.Diese Python Dinger sind zusätzlich ganz schön CPU lastig. Der 3700X tobt bei 50-70% Auslastung rum.

Der 5700G mit RTX3050 hat ca. 25% CPU-Auslastung.

Die ganz langen WUs haben max. 11,5h Laufzeit und 45h CPU-Zeit.

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Jedes neue batch scheint sehr unterschiedlich zu sein. Hatte welche, die auf dem 4800H mit GTX 1650 Ti keine 20 Min brauchten.

Bei den WUs, die an der Stelle der "10" eine 8 oder 9 haben, laufen sehr kurz.

e00004a00025-ABOU_rnd_ppod_expand_demos25_10-0-1-RND7561_0

Auf CPU hatte ich da nicht geachtet. Die 3er, 10er, 11er hauen voll rein

Bei den WUs, die an der Stelle der "10" eine 8 oder 9 haben, laufen sehr kurz.

e00004a00025-ABOU_rnd_ppod_expand_demos25_10-0-1-RND7561_0

Auf CPU hatte ich da nicht geachtet. Die 3er, 10er, 11er hauen voll rein

olsen_gg

Grand Admiral Special

- Mitglied seit

- 02.03.2012

- Beiträge

- 10.443

- Renomée

- 714

- Standort

- Stralsund

- Aktuelle Projekte

- WCG SCC1, HSTB, wechselnde..

- Lieblingsprojekt

- alle medizinisch / pharmazeutischen Projekte

- Meine Systeme

- Ryzen 9 3900X, 2x Ryzen 7 3700X, ( noch vorhanden: i7-4770S, Lappy i7-3630QM, 13x ARM...)

- BOINC-Statistiken

- Details zu meinem Desktop

- Verschiedenes

- Zuviel Details, das muss nicht veröffentlicht werden.

Was tut ihr hier?  GPUGrid?

GPUGrid?

GPUGrid?

GPUGrid?cologne46

Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 1.291

- Renomée

- 223

- Lieblingsprojekt

- medizinische

- Meine Systeme

- A10-5700, 6x Odroid N2

- BOINC-Statistiken

- Mein Laptop

- Dell Vostro 3700

- Details zu meinem Desktop

- Prozessor

- A10-5700

- Mainboard

- Asrock FM2A75 Pro4-M

- Kühlung

- EKL Alpenföhn Groß Clockner mit be quiet! Silent Wings PWM

- Speicher

- 16GB G.Skill 2400

- Grafikprozessor

- HD 7660D

- Display

- 27" IIYAMA XUB2792UHSU

- SSD

- Corsair Neutron XTI 480 GB

- HDD

- Seagate ST6000VN 6 TB

- Optisches Laufwerk

- LG BH16

- Soundkarte

- onboard

- Gehäuse

- Sharkoon Revenge Economy

- Netzteil

- BeQuiet 300W

- Betriebssystem

- Win 7 x64

- Webbrowser

- Firefox

X_FISH

Grand Admiral Special

- Mitglied seit

- 03.02.2006

- Beiträge

- 4.242

- Renomée

- 1.970

- Aktuelle Projekte

- distributed.net (seit 2000), BOINC (seit 2017)

- BOINC-Statistiken

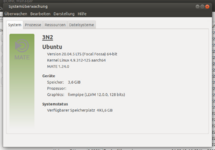

@cologne46

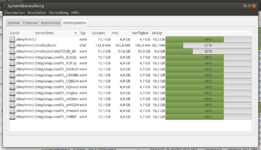

Nein. Die Frage ist wieso es mehrfach gemountet ist.

Was sagt mount an der Konsole?

Grüße, Martin

Nein. Die Frage ist wieso es mehrfach gemountet ist.

Was sagt mount an der Konsole?

Grüße, Martin

cologne46

Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 1.291

- Renomée

- 223

- Lieblingsprojekt

- medizinische

- Meine Systeme

- A10-5700, 6x Odroid N2

- BOINC-Statistiken

- Mein Laptop

- Dell Vostro 3700

- Details zu meinem Desktop

- Prozessor

- A10-5700

- Mainboard

- Asrock FM2A75 Pro4-M

- Kühlung

- EKL Alpenföhn Groß Clockner mit be quiet! Silent Wings PWM

- Speicher

- 16GB G.Skill 2400

- Grafikprozessor

- HD 7660D

- Display

- 27" IIYAMA XUB2792UHSU

- SSD

- Corsair Neutron XTI 480 GB

- HDD

- Seagate ST6000VN 6 TB

- Optisches Laufwerk

- LG BH16

- Soundkarte

- onboard

- Gehäuse

- Sharkoon Revenge Economy

- Netzteil

- BeQuiet 300W

- Betriebssystem

- Win 7 x64

- Webbrowser

- Firefox

Nach einem Neustart sieht das normal aus. Das war früher auch anders meine ich.

Falls das hilft: Hier ist auch Gridcoin auf der microsd installiert und dessen Autostart funktioniert nicht.

odroid@2N2Plus:~$ mount

sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime)

proc on /proc type proc (rw,nosuid,nodev,noexec,relatime)

udev on /dev type devtmpfs (rw,nosuid,noexec,relatime,size=1889068k,nr_inodes=472267,mode=755)

devpts on /dev/pts type devpts (rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000)

tmpfs on /run type tmpfs (rw,nosuid,nodev,noexec,relatime,size=380116k,mode=755)

/dev/mmcblk0p2 on / type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

securityfs on /sys/kernel/security type securityfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /dev/shm type tmpfs (rw,nosuid,nodev)

tmpfs on /run/lock type tmpfs (rw,nosuid,nodev,noexec,relatime,size=5120k)

tmpfs on /sys/fs/cgroup type tmpfs (ro,nosuid,nodev,noexec,mode=755)

cgroup2 on /sys/fs/cgroup/unified type cgroup2 (rw,nosuid,nodev,noexec,relatime)

cgroup on /sys/fs/cgroup/systemd type cgroup (rw,nosuid,nodev,noexec,relatime,xattr,name=systemd)

pstore on /sys/fs/pstore type pstore (rw,nosuid,nodev,noexec,relatime)

bpf on /sys/fs/bpf type bpf (rw,nosuid,nodev,noexec,relatime)

cgroup on /sys/fs/cgroup/pids type cgroup (rw,nosuid,nodev,noexec,relatime,pids)

cgroup on /sys/fs/cgroup/debug type cgroup (rw,nosuid,nodev,noexec,relatime,debug)

cgroup on /sys/fs/cgroup/freezer type cgroup (rw,nosuid,nodev,noexec,relatime,freezer)

cgroup on /sys/fs/cgroup/devices type cgroup (rw,nosuid,nodev,noexec,relatime,devices)

cgroup on /sys/fs/cgroup/memory type cgroup (rw,nosuid,nodev,noexec,relatime,memory)

cgroup on /sys/fs/cgroup/net_cls,net_prio type cgroup (rw,nosuid,nodev,noexec,relatime,net_cls,net_prio)

cgroup on /sys/fs/cgroup/perf_event type cgroup (rw,nosuid,nodev,noexec,relatime,perf_event)

cgroup on /sys/fs/cgroup/blkio type cgroup (rw,nosuid,nodev,noexec,relatime,blkio)

cgroup on /sys/fs/cgroup/cpuset type cgroup (rw,nosuid,nodev,noexec,relatime,cpuset)

cgroup on /sys/fs/cgroup/cpu,cpuacct type cgroup (rw,nosuid,nodev,noexec,relatime,cpu,cpuacct)

cgroup on /sys/fs/cgroup/schedtune type cgroup (rw,nosuid,nodev,noexec,relatime,schedtune)

systemd-1 on /proc/sys/fs/binfmt_misc type autofs (rw,relatime,fd=28,pgrp=1,timeout=0,minproto=5,maxproto=5,direct)

mqueue on /dev/mqueue type mqueue (rw,nosuid,nodev,noexec,relatime)

debugfs on /sys/kernel/debug type debugfs (rw,nosuid,nodev,noexec,relatime)

tracefs on /sys/kernel/tracing type tracefs (rw,nosuid,nodev,noexec,relatime)

configfs on /sys/kernel/config type configfs (rw,nosuid,nodev,noexec,relatime)

/var/lib/snapd/snaps/bare_5.snap on /snap/bare/5 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core18_2563.snap on /snap/core18/2563 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/chromium_2078.snap on /snap/chromium/2078 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core18_2570.snap on /snap/core18/2570 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core20_1614.snap on /snap/core20/1614 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core20_1627.snap on /snap/core20/1627 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-28-1804_147.snap on /snap/gnome-3-28-1804/147 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-28-1804_160.snap on /snap/gnome-3-28-1804/160 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-38-2004_116.snap on /snap/gnome-3-38-2004/116 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-38-2004_122.snap on /snap/gnome-3-38-2004/122 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gtk-common-themes_1534.snap on /snap/gtk-common-themes/1534 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gtk-common-themes_1535.snap on /snap/gtk-common-themes/1535 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/snapd_16782.snap on /snap/snapd/16782 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/snapd_17032.snap on /snap/snapd/17032 type squashfs (ro,nodev,relatime,x-gdu.hide)

/dev/mmcblk0p1 on /media/boot type vfat (rw,relatime,fmask=0077,dmask=0077,codepage=437,iocharset=iso8859-1,shortname=mixed,errors=remount-ro)

fusectl on /sys/fs/fuse/connections type fusectl (rw,nosuid,nodev,noexec,relatime)

tmpfs on /run/user/1000 type tmpfs (rw,nosuid,nodev,relatime,size=380116k,mode=700,uid=1000,gid=1000)

gvfsd-fuse on /run/user/1000/gvfs type fuse.gvfsd-fuse (rw,nosuid,nodev,relatime,user_id=1000,group_id=1000)

/dev/mmcblk1p1 on /media/odroid/32GB_SD type ext4 (rw,nosuid,nodev,relatime,data=ordered,uhelper=udisks2)

tmpfs on /run/snapd/ns type tmpfs (rw,nosuid,nodev,noexec,relatime,size=380116k,mode=755)

/dev/mmcblk0p2 on /tmp/snap.rootfs_Vcwon2 type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_CQBEAW type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_msgisa type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_9i2FJg type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_cJM3Bd type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_YHllbf type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_b0DUUY type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_qMO2HU type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_hQUauE type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_8LI53z type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_o6O0mo type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

sysfs on /sys type sysfs (rw,nosuid,nodev,noexec,relatime)

proc on /proc type proc (rw,nosuid,nodev,noexec,relatime)

udev on /dev type devtmpfs (rw,nosuid,noexec,relatime,size=1889068k,nr_inodes=472267,mode=755)

devpts on /dev/pts type devpts (rw,nosuid,noexec,relatime,gid=5,mode=620,ptmxmode=000)

tmpfs on /run type tmpfs (rw,nosuid,nodev,noexec,relatime,size=380116k,mode=755)

/dev/mmcblk0p2 on / type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

securityfs on /sys/kernel/security type securityfs (rw,nosuid,nodev,noexec,relatime)

tmpfs on /dev/shm type tmpfs (rw,nosuid,nodev)

tmpfs on /run/lock type tmpfs (rw,nosuid,nodev,noexec,relatime,size=5120k)

tmpfs on /sys/fs/cgroup type tmpfs (ro,nosuid,nodev,noexec,mode=755)

cgroup2 on /sys/fs/cgroup/unified type cgroup2 (rw,nosuid,nodev,noexec,relatime)

cgroup on /sys/fs/cgroup/systemd type cgroup (rw,nosuid,nodev,noexec,relatime,xattr,name=systemd)

pstore on /sys/fs/pstore type pstore (rw,nosuid,nodev,noexec,relatime)

bpf on /sys/fs/bpf type bpf (rw,nosuid,nodev,noexec,relatime)

cgroup on /sys/fs/cgroup/pids type cgroup (rw,nosuid,nodev,noexec,relatime,pids)

cgroup on /sys/fs/cgroup/debug type cgroup (rw,nosuid,nodev,noexec,relatime,debug)

cgroup on /sys/fs/cgroup/freezer type cgroup (rw,nosuid,nodev,noexec,relatime,freezer)

cgroup on /sys/fs/cgroup/devices type cgroup (rw,nosuid,nodev,noexec,relatime,devices)

cgroup on /sys/fs/cgroup/memory type cgroup (rw,nosuid,nodev,noexec,relatime,memory)

cgroup on /sys/fs/cgroup/net_cls,net_prio type cgroup (rw,nosuid,nodev,noexec,relatime,net_cls,net_prio)

cgroup on /sys/fs/cgroup/perf_event type cgroup (rw,nosuid,nodev,noexec,relatime,perf_event)

cgroup on /sys/fs/cgroup/blkio type cgroup (rw,nosuid,nodev,noexec,relatime,blkio)

cgroup on /sys/fs/cgroup/cpuset type cgroup (rw,nosuid,nodev,noexec,relatime,cpuset)

cgroup on /sys/fs/cgroup/cpu,cpuacct type cgroup (rw,nosuid,nodev,noexec,relatime,cpu,cpuacct)

cgroup on /sys/fs/cgroup/schedtune type cgroup (rw,nosuid,nodev,noexec,relatime,schedtune)

systemd-1 on /proc/sys/fs/binfmt_misc type autofs (rw,relatime,fd=28,pgrp=1,timeout=0,minproto=5,maxproto=5,direct)

mqueue on /dev/mqueue type mqueue (rw,nosuid,nodev,noexec,relatime)

debugfs on /sys/kernel/debug type debugfs (rw,nosuid,nodev,noexec,relatime)

tracefs on /sys/kernel/tracing type tracefs (rw,nosuid,nodev,noexec,relatime)

configfs on /sys/kernel/config type configfs (rw,nosuid,nodev,noexec,relatime)

/var/lib/snapd/snaps/bare_5.snap on /snap/bare/5 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core18_2563.snap on /snap/core18/2563 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/chromium_2078.snap on /snap/chromium/2078 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core18_2570.snap on /snap/core18/2570 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core20_1614.snap on /snap/core20/1614 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/core20_1627.snap on /snap/core20/1627 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-28-1804_147.snap on /snap/gnome-3-28-1804/147 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-28-1804_160.snap on /snap/gnome-3-28-1804/160 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-38-2004_116.snap on /snap/gnome-3-38-2004/116 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gnome-3-38-2004_122.snap on /snap/gnome-3-38-2004/122 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gtk-common-themes_1534.snap on /snap/gtk-common-themes/1534 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/gtk-common-themes_1535.snap on /snap/gtk-common-themes/1535 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/snapd_16782.snap on /snap/snapd/16782 type squashfs (ro,nodev,relatime,x-gdu.hide)

/var/lib/snapd/snaps/snapd_17032.snap on /snap/snapd/17032 type squashfs (ro,nodev,relatime,x-gdu.hide)

/dev/mmcblk0p1 on /media/boot type vfat (rw,relatime,fmask=0077,dmask=0077,codepage=437,iocharset=iso8859-1,shortname=mixed,errors=remount-ro)

fusectl on /sys/fs/fuse/connections type fusectl (rw,nosuid,nodev,noexec,relatime)

tmpfs on /run/user/1000 type tmpfs (rw,nosuid,nodev,relatime,size=380116k,mode=700,uid=1000,gid=1000)

gvfsd-fuse on /run/user/1000/gvfs type fuse.gvfsd-fuse (rw,nosuid,nodev,relatime,user_id=1000,group_id=1000)

/dev/mmcblk1p1 on /media/odroid/32GB_SD type ext4 (rw,nosuid,nodev,relatime,data=ordered,uhelper=udisks2)

tmpfs on /run/snapd/ns type tmpfs (rw,nosuid,nodev,noexec,relatime,size=380116k,mode=755)

/dev/mmcblk0p2 on /tmp/snap.rootfs_Vcwon2 type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_CQBEAW type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_msgisa type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_9i2FJg type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_cJM3Bd type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_YHllbf type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_b0DUUY type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_qMO2HU type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_hQUauE type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_8LI53z type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

/dev/mmcblk0p2 on /tmp/snap.rootfs_o6O0mo type ext4 (rw,relatime,errors=remount-ro,stripe=32716,data=ordered)

Falls das hilft: Hier ist auch Gridcoin auf der microsd installiert und dessen Autostart funktioniert nicht.

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.659

- Renomée

- 1.061

- Aktuelle Projekte

- MW@H; TN Grid, Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

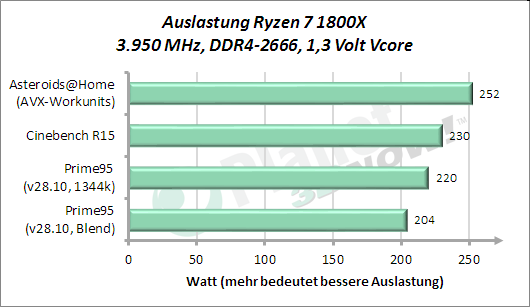

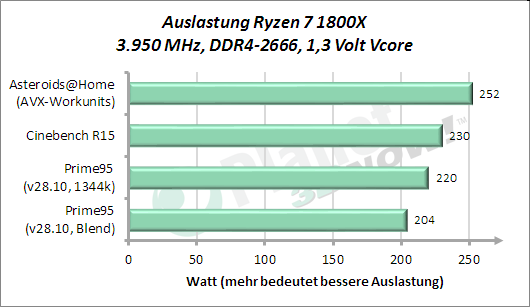

Späte Rückmeldung, aber ich bin gestern erst fündig geworden.Eine Frage in die Runde:

Ich habe "früher" immer Asteroids@Home rechnen lassen, wenn ich die CPU mal so richtig auslasten wollte (AVX). Siehe hier:

Das Projekt scheint aktuell nicht online zu sein.

Welches CPU-Projekt könnte ich alternativ einsetzen, wenn es um eine möglichst hohe Auslastung der CPU geht?

Habe seit langem mal wieder Rosetta@home versucht. Die haben nun wieder einen auskömmlichen Vorrat an Nicht-Python-WUs. Habe meinen 5950X auf allen threads mit Rosetta@Home eingedeckt. Unter ECO schafft er so nur 2,5 GHz allcore. Bei Milkyway nbody und anderen CPU-Projekten kommt er eher auf 3,5 - 3,7 GHz allcore (natürlich auch unter ECO).

Daher scheint bei Rosetta@Home in den Cores ordentlich was abzugehen

cologne46

Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 1.291

- Renomée

- 223

- Lieblingsprojekt

- medizinische

- Meine Systeme

- A10-5700, 6x Odroid N2

- BOINC-Statistiken

- Mein Laptop

- Dell Vostro 3700

- Details zu meinem Desktop

- Prozessor

- A10-5700

- Mainboard

- Asrock FM2A75 Pro4-M

- Kühlung

- EKL Alpenföhn Groß Clockner mit be quiet! Silent Wings PWM

- Speicher

- 16GB G.Skill 2400

- Grafikprozessor

- HD 7660D

- Display

- 27" IIYAMA XUB2792UHSU

- SSD

- Corsair Neutron XTI 480 GB

- HDD

- Seagate ST6000VN 6 TB

- Optisches Laufwerk

- LG BH16

- Soundkarte

- onboard

- Gehäuse

- Sharkoon Revenge Economy

- Netzteil

- BeQuiet 300W

- Betriebssystem

- Win 7 x64

- Webbrowser

- Firefox

Also von Montag bis jetzt habe ich 36,1 GB Speicherplatz hinzugewonnen. Wenn das real so funktionieren würde, wäre das toll.

Ich habe nur die Sorge, dass der irgendwann mal was auf die falsche "Platte" schreibt. Ist ja alles nur temporär (/tmp/snap.rootfs).

Auf einem anderen Odroid sind es mittlerweile schon 493,6 GB.

Ich habe das Thema mal im Odroid Forum aufgmacht, da dies hier ja nun zu offtopic ist.

Ich habe nur die Sorge, dass der irgendwann mal was auf die falsche "Platte" schreibt. Ist ja alles nur temporär (/tmp/snap.rootfs).

Auf einem anderen Odroid sind es mittlerweile schon 493,6 GB.

Ich habe das Thema mal im Odroid Forum aufgmacht, da dies hier ja nun zu offtopic ist.

Zuletzt bearbeitet:

MusicIsMyLife

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.02.2002

- Beiträge

- 15.579

- Renomée

- 2.567

- Standort

- in der Nähe von Cottbus

- Lieblingsprojekt

- Asteroids@Home

- Meine Systeme

- Alltags-PC, Test-PC (wechselnde Hardware)

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Desktopsystem

- Alltags-PC

- Mein Laptop

- HP DV7-2225sg

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X

- Mainboard

- ASRock B650M PG Riptide

- Kühlung

- Watercool Heatkiller IV Pro Copper

- Speicher

- 2x 32 GB G.Skill TridentZ 5 TGB (F5-6000J3040G32X2-TZ5RS)

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- ASUS ROG PG42UQ (3840x2160), Philips BDM4065UC (3840x2160), Samsung C27HG70 (2560x1440)

- SSD

- Micron 9300 Pro 7,68 TB (U.2), Samsung 850 Evo 4 TB (SATA)

- HDD

- keine, SSD only...

- Optisches Laufwerk

- LG CH08LS10 Blu-ray Disc-Player

- Soundkarte

- Creative SoundBlasterX AE-5 Plus

- Gehäuse

- Dimastech BenchTable EasyXL (vorübergehend)

- Netzteil

- Corsair RM850i

- Tastatur

- ASUS ROG Strix Flare

- Maus

- Steelseries Sensei 310

- Betriebssystem

- Windows 10 Professional

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

- Internetanbindung

- ▼250 MBit ▲45 MBit

Späte Rückmeldung, aber ich bin gestern erst fündig geworden.Eine Frage in die Runde:

Ich habe "früher" immer Asteroids@Home rechnen lassen, wenn ich die CPU mal so richtig auslasten wollte (AVX). Siehe hier:

Das Projekt scheint aktuell nicht online zu sein.

Welches CPU-Projekt könnte ich alternativ einsetzen, wenn es um eine möglichst hohe Auslastung der CPU geht?

Habe seit langem mal wieder Rosetta@home versucht. Die haben nun wieder einen auskömmlichen Vorrat an Nicht-Python-WUs. Habe meinen 5950X auf allen threads mit Rosetta@Home eingedeckt. Unter ECO schafft er so nur 2,5 GHz allcore. Bei Milkyway nbody und anderen CPU-Projekten kommt er eher auf 3,5 - 3,7 GHz allcore (natürlich auch unter ECO).

Daher scheint bei Rosetta@Home in den Cores ordentlich was abzugehen

Danke für die Rückmeldung. Die kommt für den konkreten Fall jetzt zwar zu spät, da ich meinen Test schon abgeschlossen habe, ich behalte das trotzdem im Hinterkopf.

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.895

- Renomée

- 1.418

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid, SiDock

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, 2x RTX 4070 Ti, RTX 3080, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti, 3080

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Hat jemand vor, sich (auch) für BOINC eine Intel ARC Karte zu kaufen? Lt. Geizhals haben die ein SP/DP Verhältnis von 1:4. Damit würde die A750 bei DP im gleichen Bereich wie eine Radeon VII landen.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.841

- Renomée

- 2.807

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

So etwas kommt mir nicht in das Haus, habe aber mal gelesen das sie für Mining schlecht ist.

Ethereum-Mining mit Intel Arc: Schlechte Benchmarks werden Spieler freuen (Computerbase)

Ob man da auch auf schlechte Boincperformace schließen kann weiß ich nicht, noch nichts dazu gelesen.

Karten sind aktuell aber eh so gut wie nicht lieferbar.

Ethereum-Mining mit Intel Arc: Schlechte Benchmarks werden Spieler freuen (Computerbase)

Ob man da auch auf schlechte Boincperformace schließen kann weiß ich nicht, noch nichts dazu gelesen.

Karten sind aktuell aber eh so gut wie nicht lieferbar.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.260

- Renomée

- 1.845

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Gabs da nicht auch mal eine paar Nvidia Titans, die ihre brachiale DP-Leistung überhaupt nicht auf die Straße bringen konnten?

Aber intel? Nee, so schlimm geht es mir noch nicht.

Aber intel? Nee, so schlimm geht es mir noch nicht.

Ähnliche Themen

- Antworten

- 53

- Aufrufe

- 3K

- Antworten

- 17

- Aufrufe

- 2K

- Antworten

- 610

- Aufrufe

- 46K

- Antworten

- 1K

- Aufrufe

- 70K

- Gesperrt

- Antworten

- 5K

- Aufrufe

- 283K