App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Artikel AMD A10-7700K und A10-7850K im Test

mmoses

Admiral Special

- Mitglied seit

- 20.10.2006

- Beiträge

- 1.899

- Renomée

- 43

- Standort

- Bembeltown

- Mein Laptop

- Lenovo Thinkpad Edge T450

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen5 - 1600

- Mainboard

- MSI B350 PC MATE

- Kühlung

- Original Bex Kühler

- Speicher

- 2 x ADATA DIMM 8 GB DDR4-2400

- Grafikprozessor

- Asus Radeon R7 250X

- Display

- 27" iiyama ProLite B2783QSU

- SSD

- Samsung SSD 840PRO 256GB

- HDD

- WD WD20EZRZ 2 TB

- Optisches Laufwerk

- BluRayBrenner PIONEER BDR-209DBK SATA

- Soundkarte

- onboard

- Gehäuse

- Enermax Chakra BS 25cm Fan ATX

- Netzteil

- Enermax EPR385AWT Pro82+ 385W ATX23

- Betriebssystem

- 64-Bit Linux Mint 19.2

- Webbrowser

- Frickelfuchs/opera

Das Problem an den APUs ist doch nur das der Käufer nicht in der Lage ist dies richtig ein zu schätzen für seine Bedürfnisse und richtig zu konfigurieren.Wenn ich keine Ahnung davon habe,dann muss ich halt 1000 EU fürn Intel + dicker Graka ausgeben....,die die es können kommen sogar mit einem Athlon 5350 zurecht.

DA hat die "Fachpresse" aber regen Anteil dran... So wie bei Apple grundsätzlich alles immer supergeil ist, wird AMD seit fünf Jahren reflexartig runtergeschrieben! Exemplarisch der Bericht über BilligPCs in der letzten C´t.... Man hätte auch schreiben können, dass erstaunlicherweise selbst der A5150 im Alltag QWXGA souverän beschickt .... Stattdessen kommt nur "für Egoshooter bringt er es nicht" und singlethread ist er viel langsamer als der HaswellPentium... bluppblupp

HALLO?

Nichtmal meine Mama würde glauben, für 250Mücken einen knackigen Spielbolieden zu erstehen!!

Aber nicht völlig in der Materie ist, bekommt ständig nur zu hören "Intel geil, nur etwas teuer" & "AMD 5ch3155e!"......

Es gibt einen Haufen Leute denen würde ich lässig einen A4-7300 reinschrauben, allerdings auf ein ordentliches Brett.... (macht zusammen 100€)

Bei Intel (z.B. G1820T) muss man wieder genau schauen , was die da wieder abgeflext haben, und die Graphik ist unbrauchbar.

Was naturelement helfen würde, wären zwei oder drei grosse Hersteller, die bei AMD nicht gleich "BILLIG ZUSAMMENKLÖPPELN!!!" schreien

Man könnte zum Bleistift den A8 wünnebar als fertigen HTPC aufsetzen - via cTDP auf 35W drosseln, 64GBmSataSSD, 1TB 2,5er magnetisch , TV-Tuner on Board (ggf.fertig eingerichtet), BluRaybrenner das ganze schick verarbeitet uuuund.. in einem geilen Gehäuse

Format : ungefähr aaler VHS-Recorder - Leichtmetall champagnerfarben.. usw usw

Format : ungefähr aaler VHS-Recorder - Leichtmetall champagnerfarben.. usw uswDaaa könnte man auch direkt mal echtes Geld nehmen

Mmoe

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Gut der Singleplayer Mode ist gewöhnungsbedürftig, aber ich fühlte mich zum Ende hin sehr gefordert, auch wenn es einfach aussieht.*g* ja stimmt schon... Moderne Zeiten halt. Es betrifft aber grundsaetzlich auch Erwachsene, denen diese neumodischen Easy-Going Games mit bombastischer Aufmachung aber "inhaltlichem Unterdruck" auch entsprechendes bieten (kommt aber meist bitter rueber, wenn man die auch als Kiddies bezeichnet). Soll ja jeder daddeln, was ihm/ihr Spass macht und nicht ueberfordert.

Schneller als Konsole zu sein, ist allerdings kein Kunststueck - das ist ne recht tiefe Messlatte

Den Multiplayer Mode gibt es ja auch noch und da ist BF4 Meilenweit vorraus im Gegensatzt zu z.B. WOT oder WOW oder alle anderen Ego-shootern.

Die Physikeffekte und die Filter (AA) sind schon für ausgewachsene GPUs aber ohne sie lässt sich eben auch auf einer APU (Kaverie) spielen.

FXAA wurde von einem nvidia Mensch ins leben gerufen, mit AMD Radeon Hardware wirkt dies wie du meinst "unscharf".Wie sieht denn die Implementierung von FXAA bei Tomb Raider aus? Bei anderen Spielen wirkt FXAA häufig so, als hätte jemand Vaseline auf den Monitor geschmiert. Die Kanten sind dadurch zwar geglättet, aber das Spiel wirkt dann insgesamt fast so matschig wie die Texturen in dem Battlefield 4 Video auf Seite 3. Ich mache bisher lieber einen Bogen um FXAA, weil es die Schärfe zu sehr negativ beeinträchtig. So mein subjektiver Eindruck.

AMD GPU user stehen da mehr auf SSAA und da sind selbst zwei GPU Stellenweiße knapp (unter 60FPS minimum)

MfG

FalconFly

Admiral Special

@FalconFly

Wobei man aber auch sagen muss das man im Spielebereicht beim PC Sektor hardwarefressende Features nutzen kann die wiederum bei den Konsolen weg bleiben können. Gerade der aktuelle Tomb Raider Teil kann hierfür ein gutes Beispiel sein. Schaltet man Features wie TressFX und SSAA ab hat man mal ebend ein vielfaches der Framerate und das sollten Features sein die relativ leicht zu verschmerzen sind. Gleiches gilt natürlich auch für andere Geschichten mit der erweiterten Physik (z.B. GPU Physx), also optionale Features die zwar einen deutlichen Unterschied machen können aber nicht Spielerelevant sind.

Stimmt wohl, aber das sind oft "Notfeatures", die man den Konsolen-Ports vereinzelt und gezielt gibt, damit sie nicht ganz so abgespeckt/mager dastehen. Grundsaetzlich unterscheiden sich die PCs einfach zu stark von Konsolen, um das mit ein paar Zusatzfeatures zu kaschieren. Ich sehe halt immer haeufiger echte Konsolen-Games auf dem Schirm und sehe immer haeufiger den schleichenden Rueckschritt (Input, Grafik, Sound, Gameplay-tiefe, Komplexitaet, Schwierigkeitsgrad). Dafuer gibt's dann leider keinen Optionen zum Abschalten *g* Mehr geben diese Games einfach nicht her und sind entsprechend fad.

Ist aber ein generelles Problem der Spielebranche und hat mit APUs nur noch sehr entfernt zu tun (sie profitieren aber in der Tat stark vom Downgrading).

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

So sehr unterscheiden sie sich bei weitem nicht, der größte Unterschied ist in der Bedienung begründet. Dazu noch diese unsinnigen Events der Marke "kloppe auf Taste *x* bis sie abfällt oder Ereignis *y* ausgelöst wird" was sich bei mir nur dummerweise bei Tomb Raider mit der Tastatur Eingabe biss. Bis ich raus hatte das ich die Taste langsamer drücken muss weil sonst nicht mehr richtig zwischen den einzelnen Eingaben unterschieden wurde...dazu noch das Wackel Menü das sich bei der falschen Menülage mit der Mausbedienung beißt und schon ist wieder klar wofür es primär entwickelt wurde.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@sompe

Ganz klar für: So_nie!

Was ich mir bei Tomb Raider noch wünschen würde wäre in Game OGSSAA oder Downsampling, so wie bei BF4 (200% Auflösungsskalierung).

Damit lassen sich auch Titanen vergewaltigen...

Ganz klar für: So_nie!

Was ich mir bei Tomb Raider noch wünschen würde wäre in Game OGSSAA oder Downsampling, so wie bei BF4 (200% Auflösungsskalierung).

Damit lassen sich auch Titanen vergewaltigen...

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Mit ner hohen Auflösung und 4x SSAA sollte man die auch so klein bekommen. 8)

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Du schaust zu Oberflächlich.Betrachtet man sich die Leistungszuwächse bei einem Wechsel von nem Llano auf einen Richland sind die Steigerungen jedoch ein Witz denn für die 12% benötigen die Speichermodule eine bestimmte interne Struktur denn sonst sind es (wie im test ersichtlich) lediglich gute 6%.

Beim Wechsel vom Llano zum Trinity legte lt. Computerbase Tests die Spieleleistung ca. 20-25% zu, beim Wechsel vom Trinity zum Richland nochmal ca. 20%.

Da warte ich dann doch lieber den Nachfolger ab und schaue was er drauf hat. 8)

Llano:

CPU 3GHz

iGPU 600MHz, 400 Shader

Ram DDR3-1866

Wobei die 3GHz CPU Takt recht stark sein können.

Trinity:

CPU 3,8GHz

iGPU 800MHz, 384 Shader

Ram DDR3-1866

Unterschied zum Llano:

20-25%,dabei fehlen dem Llano auch ein paar MHz an Takt auf beiden Seiten.

http://www.tomshardware.de/a10-5800k-a8-5600k-trinity-apu,testberichte-241054-9.html

Richland:

CPU 4,1GHz

iGPU 844MHz, 384 Shader

Ram DDR3-2133

Unterschied zu Trinity:

........Unter anderem durch den höheren RAM-Takt kann der A10-6800K in den von uns getesteten Spielen gegenüber dem Vorgänger A10-5800K um 13 % zulegen. Bei den Anwendungen sind es immerhin 10 %.

Bei gleichem Takt hast kaum noch unterschiede......

http://www.planet3dnow.de/vbulletin/showthread.php?t=413046

Kaveri:

---------A10 7850K---------/--A10 7700K---

CPU 3,7Ghz-----------------/3,4GHz

iGPU 720MHz, 512 Shader /720MHz, 384 Shader

Ram DDR3-2133-----------/Ram DDR3-2133

Unterschied zu Richland:

GPU Performance:

7850K 100%

7700K 90% }18%

6800K 82%

http://www.tweakpc.de/hardware/tests/cpu/amd_a10-7850k_a10-7700k/s09.php

Der 7700K hat wie der Richland 384 Shader,weniger CPU Takt UND weniger iGPU Takt und ist dennoch schneller.

Wie würde es sein wenn der 7850K auch mit 4,1GHz Taktet und auch die iGPU mit 844MHz?!

Ich würde sagen damit sollten min 20% gehen.......

Kurz gesagt:

Llano/Trinity 20-25%

Trinity/Richland nahe zu 0 Runde

Richland/Kaveri um 20% + bei gleichem Takt......

Was ist da jetzt so schlecht dran?

Zuletzt bearbeitet:

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

TressFX erledigt den Rest: http://abload.de/img/tombraider_2014_09_18v6u32.jpgMit ner hohen Auflösung und 4x SSAA sollte man die auch so klein bekommen. 8)

Kommt aber nicht ganz an 2880x1620 DS ran, von der schärfe her.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@Casi030

Ich schaue nicht Oberflächlich sondern vergleiche bei Werkseinstellung.

Das sich Trinity und Richland abseits der Taktfrequenz nichts nehmen ist mir auch klar aber wen juckt ein Verleich bei gleicher Taktfrequenz wenn einer der Vergleichskandidaten dafür übertaktet werden muss? Das kann man mit dem anderen schließlich auch machen.

Deshalb sind solche Vergleiche bei angeglichener Taktfrequenz in meinen Augen zwar schön für die Wissenschaft und den Vergleich der Architekturen aber recht nutzlos für den Vergleich fertiger Produkte. Vielleicht hätte ich da besser die genauen Modellbezeichnungen (A8-3850 vs. A10-5800k vs. A10-6800k vs. A10-7850k) genannt. Die einzelnen Tests kann man sich ja problemlos raussuchen.

@WindHund

Das TressFX aktiv ist versteht sich bei einer passenden Grafikkarte doch von selbst, oder? 8)

Ich schaue nicht Oberflächlich sondern vergleiche bei Werkseinstellung.

Das sich Trinity und Richland abseits der Taktfrequenz nichts nehmen ist mir auch klar aber wen juckt ein Verleich bei gleicher Taktfrequenz wenn einer der Vergleichskandidaten dafür übertaktet werden muss? Das kann man mit dem anderen schließlich auch machen.

Deshalb sind solche Vergleiche bei angeglichener Taktfrequenz in meinen Augen zwar schön für die Wissenschaft und den Vergleich der Architekturen aber recht nutzlos für den Vergleich fertiger Produkte. Vielleicht hätte ich da besser die genauen Modellbezeichnungen (A8-3850 vs. A10-5800k vs. A10-6800k vs. A10-7850k) genannt. Die einzelnen Tests kann man sich ja problemlos raussuchen.

@WindHund

Das TressFX aktiv ist versteht sich bei einer passenden Grafikkarte doch von selbst, oder? 8)

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Was ich dir damit sagen will,das Kaveri ne Deutliche Leistungssteigerung mit sich bring,nur durch die bessere Effizienz fällt es Oberflächlich nur nicht so auf.

6800K vs 7700K

14% weniger Verbrauch und dazu noch 8% mehr iGPU Leistung.

Selbst bei Anwendungen ist er NUR 2 % langsamer bei nem Grundtakt von rund 20% weniger.

http://www.tweakpc.de/hardware/tests/cpu/amd_a10-7850k_a10-7700k/s08.php

Genauer betrachtet sind die Unterschiede doch recht groß,meinst nicht?

6800K vs 7700K

14% weniger Verbrauch und dazu noch 8% mehr iGPU Leistung.

Selbst bei Anwendungen ist er NUR 2 % langsamer bei nem Grundtakt von rund 20% weniger.

http://www.tweakpc.de/hardware/tests/cpu/amd_a10-7850k_a10-7700k/s08.php

Genauer betrachtet sind die Unterschiede doch recht groß,meinst nicht?

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

auf dem Papier ja aber beim genaueren hingucken fällt ebend auch auf das die GPU des A10-7850 30% mehr Rohleistung hat als die des A10-7700, davon aber keine 10% Mehrleistung übrig bleiben da sie in der Speicherbandbreitenfalle hängen bleibt. Da könnten Bandbreitensparmaßnamen wie beim Tonga (R9 285) bereits kleine Wunder bewirken.

Wie gesagt, ich vergleiche keine Architekturen sondern Produkte.

Wie gesagt, ich vergleiche keine Architekturen sondern Produkte.

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Oder liegt es doch nur an den 3GHz CPU Takt in Spielen?!

Ich konnte den CPU Takt bis jetzt noch nicht oben halten ohne die iGPU zu drosseln......

--- Update ---

--- Update ---

Tja Geld regiert die Welt,und Intel hat deutlich zu viel davon,die bestechen ja alles und Jeden um ihre schlechten Produkte besser dar stehen zu lassen und um diese dann deutlich über Wert zu verkaufen.

Ich konnte den CPU Takt bis jetzt noch nicht oben halten ohne die iGPU zu drosseln......

--- Update ---

Ich höre meist nur,was machst den jetzt schon wieder,du sollst da nix dran rumfummeln,ich will einfach nur Spielen......Meine Aussage war "Das eine APU/iGPU (egal von welchem Hersteller) bei vielen nicht die Ansprüche erfüllt ist denke ich offensichtlich." Dann würde der Absatz von Grafikkarten sinken. Das Review zeigt ja auch was schon einen HD7750 mehr leisten kann. Aus meinem Bekanntenkreis und was man im Internet liest haben viele andere Ansprüche als z.B.

--- Update ---

DA hat die "Fachpresse" aber regen Anteil dran... So wie bei Apple grundsätzlich alles immer supergeil ist, wird AMD seit fünf Jahren reflexartig runtergeschrieben! Exemplarisch der Bericht über BilligPCs in der letzten C´t.... Man hätte auch schreiben können, dass erstaunlicherweise selbst der A5150 im Alltag QWXGA souverän beschickt .... Stattdessen kommt nur "für Egoshooter bringt er es nicht" und singlethread ist er viel langsamer als der HaswellPentium... bluppblupp

Tja Geld regiert die Welt,und Intel hat deutlich zu viel davon,die bestechen ja alles und Jeden um ihre schlechten Produkte besser dar stehen zu lassen und um diese dann deutlich über Wert zu verkaufen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Na wnn man schon auf die Standard Vorgaben pfeift (z.B. OC) dann richtig und im Falles des Kaveris müßte dann wohl APM deaktiviert werden damit er auch auf das Power Target pfeift.....zumindest habe ich das bei bisherigen Berichten so rausgelesen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.336

- Renomée

- 1.973

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ist doch auch logisch. Die IGP und der CPU Part müssen sich die TDP teilen.

Kann der CPU Takt nicht gesenkt werden dann muss ebend die IGP ran und ist die IGP nicht aktiv weil eine extra Grafikkarte drin steckt dann hat der CPU Part die gesammte TDP für sich.

Kann der CPU Takt nicht gesenkt werden dann muss ebend die IGP ran und ist die IGP nicht aktiv weil eine extra Grafikkarte drin steckt dann hat der CPU Part die gesammte TDP für sich.

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Passt aber auch nicht.

Schau ins Video und auf den Strommesser.

https://www.youtube.com/watch?v=Ti3gAwSW_i8

ODER auch :

4GHz / 1108 MHz 203Watt , iGPU Auslastung 89%

3GHz / 1108 MHz 180Watt , iGPU Auslastung 93%

Der Einzige Unterschied,die FPS sind begrenzt und somit hab ich diese Änderung in der iGPU Auslastung.

Schau ins Video und auf den Strommesser.

https://www.youtube.com/watch?v=Ti3gAwSW_i8

ODER auch :

4GHz / 1108 MHz 203Watt , iGPU Auslastung 89%

3GHz / 1108 MHz 180Watt , iGPU Auslastung 93%

Der Einzige Unterschied,die FPS sind begrenzt und somit hab ich diese Änderung in der iGPU Auslastung.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ja willst du damit erwarten, dass Lasten der iGPU über 80% der CPU mehr TDP ermöglichen? Oder was meinst du mit passt auch nicht.

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Das die Regelung komisch ist und irgendwie noch mit der iGPU Auslastung zu tun hat abseits der TDP.

--- Update ---

Weil müsste nicht der CPU Takt sinken wenn der Verbrauch hoch geht?!

Tut er aber nicht,er Sinkt wenn die iGPU über 90% Auslastung geht und das bei weniger Verbrauch.

--- Update ---

Weil müsste nicht der CPU Takt sinken wenn der Verbrauch hoch geht?!

Tut er aber nicht,er Sinkt wenn die iGPU über 90% Auslastung geht und das bei weniger Verbrauch.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Welche APU ist da getestet worden? Ich habe das nicht verfolgt im Thread.

--- Update ---

Übrigens kann eine CPU mit verschiedenen Workloads auf 100% Last gebracht werden, und unterschiedliche Hitze entwickeln. Man sieht das gut bei Prime mit dem Unterschied von Small FTT zu Large FTT.

--- Update ---

Übrigens kann eine CPU mit verschiedenen Workloads auf 100% Last gebracht werden, und unterschiedliche Hitze entwickeln. Man sieht das gut bei Prime mit dem Unterschied von Small FTT zu Large FTT.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Na das hätte auch die GPU Temp sein können oder der Topfpflanze

Aber das könnte deine Erklärung sein. Seit Richland hat AMD das dynamische Powermanagement eingeführt, das die beste Kombination aus CPU/GPU für den Workload balanciert.

Schau dir mal die ersten vier Folien an des Trinity Tests auf Seite 2: http://www.planet3dnow.de/cms/351-a...-kern/subpage-richland-modelle-und-plattform/

Aber das könnte deine Erklärung sein. Seit Richland hat AMD das dynamische Powermanagement eingeführt, das die beste Kombination aus CPU/GPU für den Workload balanciert.

Schau dir mal die ersten vier Folien an des Trinity Tests auf Seite 2: http://www.planet3dnow.de/cms/351-a...-kern/subpage-richland-modelle-und-plattform/

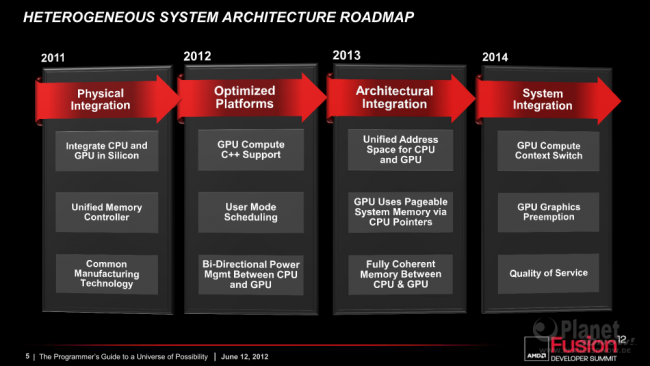

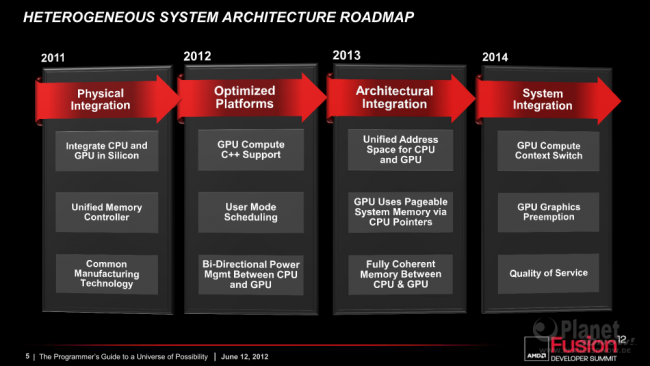

AMD nennt das Hybrid Boost und das ist Hardware integriertes Powerbalancing. Das war auch auf der HSA Roadmap gestanden.AMD nennt das „Temperature Smart Turbo Core”. Dahinter verbergen sich neue bzw. optimierte Algorithmen, mit deren Hilfe das vorhandene TDP-Budget möglichst intelligent auf die einzelnen Funktionsblöcke der APU verteilt wird. Elementarer Bestandteil sollen hierbei die endlich funktionierenden Temperatursensoren sein. Außerdem will AMD jetzt die anliegende Arbeitslast besser verstehen und Flaschenhälse erkennen können, was wiederum in die Verteilung der TDP-Budgets mit einfließen soll.

Zuletzt bearbeitet:

ich habe zum ersten Mal seit dem Duron 1000@1200Mhz wieder einen AMD Prozzi im Einsatz. Gegönnt habe ich mir die Variante A8 7600 für schlanke 80€

Die GPU kommt kaum zum Einsatz, da als Hyper-V Server im Einsatz. Als Board habe ich MSI A78 M-E45 gewählt. Dummerweise musste ich erst noch eine ältere CPU-Version kaufen, da das BIOS mal wieder uralt war.... Dazu 32GB Crucial Ballistix Sport und mit den Standard-Lüftern sogar annehmbar.

Für mich ist das wirklich seit langem mal wieder eine CPU/GPU wo man einfach zuschlagen muss, für einen kleinen Server oder HTPC! Freut mich für AMD

Die GPU kommt kaum zum Einsatz, da als Hyper-V Server im Einsatz. Als Board habe ich MSI A78 M-E45 gewählt. Dummerweise musste ich erst noch eine ältere CPU-Version kaufen, da das BIOS mal wieder uralt war.... Dazu 32GB Crucial Ballistix Sport und mit den Standard-Lüftern sogar annehmbar.

Für mich ist das wirklich seit langem mal wieder eine CPU/GPU wo man einfach zuschlagen muss, für einen kleinen Server oder HTPC! Freut mich für AMD

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Bei AMD zählt wohl einfach alles zu "HSA". In Kürze vermutlich sogar die Pappe der PIB Verpackung.AMD nennt das Hybrid Boost (...). Das war auch auf der HSA Roadmap gestanden.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Das zeigt wieder dass du dich mit HSA nicht beschäftigst. Lies es doch nach. Das stand 3-4 Jahre auf der Roadmap, zudem noch bevor Llano raus kam. Da hast du eine Liste was zu HSA gehört.

Mich würde echt mal interessieren was DU unter HSA verstehst.

Mich würde echt mal interessieren was DU unter HSA verstehst.

Zuletzt bearbeitet:

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Du scheinst vom AMD Marketing ziemlich umgarnt worden zu sein. Scheinbar wirkt es doch bei manchen Lesern.Mich würde echt mal interessieren was DU unter HSA verstehst.

Erklär mir doch zum Beispiel einmal wieso es unbedingt "Common Manufacturing Technology" für HSA braucht?

Ähnliche Themen

- Antworten

- 17

- Aufrufe

- 2K

- Antworten

- 9

- Aufrufe

- 10K

- Antworten

- 15

- Aufrufe

- 7K

- Antworten

- 25

- Aufrufe

- 6K

- Antworten

- 12

- Aufrufe

- 4K