App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

News AMD lässt mit Radeon R9 Fury X die erste Grafikkarte mit HBM vom Stapel

WoIstDerAmiga

Vice Admiral Special

- Mitglied seit

- 07.02.2002

- Beiträge

- 805

- Renomée

- 1

- Standort

- Altena

- Details zu meinem Desktop

- Prozessor

- Core I5 14600K

- Mainboard

- ASRock Z790 Pro RS/D4

- Kühlung

- be quiet! Pure Loop 2 FX 280mm

- Speicher

- Corsair Vengeance RGB pro 3600mhz 32GB

- Grafikprozessor

- Inno3D 4070 TI ichill

- Display

- Philips 27M1N5500ZA

- SSD

- Samsung 980 Pro 1TB

- HDD

- Seagate BarraCuda 4TB 2,5 Seagate BarraCuda 2TB 2,5

- Optisches Laufwerk

- Externer DVD-Benner

- Soundkarte

- Onboard

- Gehäuse

- be quiet! Shadow Base 800 fx black

- Netzteil

- be quiet! Dark Power 13 750 W

- Tastatur

- Cherry

- Maus

- 0815 Lidl Funkmaus

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox

- Internetanbindung

- ▼100 MBit ▲50 MBit

Zum Thema 4 GB Speicher könnten eng werden - hier hat CB interessante Tests und Ergebnisse die eigentlich belegen, dass dies kein Problem darstellen wird. Auch wenn CB mal wieder in ihren Fazits am Ende das Gegenteil von ihren Testzahlen schreibt^^

Computer Bild Base eben.Freut mich aber,das die 4GB Bashkritiker zwischen die Beine getreten wurden.Zwar versuchen sie jetzt die "4GB in der Zukunft zu wenig" Karte auszuspielen,übersehen aber das eine tolle 6 GB-980er da mindestens genauso abstinken würde.

skelletor

Grand Admiral Special

- Mitglied seit

- 14.06.2002

- Beiträge

- 5.316

- Renomée

- 289

- Standort

- Dresden

- Aktuelle Projekte

- Simap, Spinhenge, Poem, QMC, RNA World

- Lieblingsprojekt

- einheimische Projekte

- Meine Systeme

- AMD Ryzen 7 5800X3D + AMD Radeon RX 6900XT

- BOINC-Statistiken

- Mein Laptop

- Acer Aspire E3 112, Lenovo ThinkPad L570

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- MSI X570-A Pro

- Kühlung

- beQuiet DarkRock TF

- Speicher

- 2x 16GB GSkill 1800MHz CL14 @ 1T

- Grafikprozessor

- AMD Radeon 6900XT

- Display

- Samsung C27HG70 @2560*1440 144Hz; EIZO S2411W @1920x1200 60Hz; 52 Zoll Sony KDL-52HX905 @1920*1080

- SSD

- 1TB WD Black SN850 M2 NVME, 512 GB Samsung 850 Pro

- HDD

- 1x 4TB WesternDigital Red

- Optisches Laufwerk

- Pioneer BluRay Brenner

- Soundkarte

- Realtek HD Audio OnBoard (ALC 1220)

- Gehäuse

- noname

- Netzteil

- Seasonic X650 (80+ Gold)

- Tastatur

- Logitech G815 Tactile (brown)

- Maus

- Swiftpoint Z

- Betriebssystem

- Windows 10 Home 64bit

- Webbrowser

- Firefox

Das Geld steht schon bereit, es fehlt nur noch die 8 GB Variante.

Es wird keine 8GB Variante geben.

Da wirst du wie alle anderen auf HBM2 warten müssen. (und 14nm) - vor 2016 wird sich da aber nichts regen.

Im Übrigen scheinst du in den Zaubertrank Kessel gefallen zu sein, bei der überschwenglichen Begeisterung.

Gruß

skell.

Makso

Grand Admiral Special

- Mitglied seit

- 15.02.2006

- Beiträge

- 3.393

- Renomée

- 142

- Standort

- Österreich

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Folding@Home, POEM, Docking

- Lieblingsprojekt

- Folding@Home

- Folding@Home-Statistiken

- Mein Laptop

- Desktopsystem

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1400@3,8GHz

- Mainboard

- Asrock B350 Pro4

- Kühlung

- Scythe Mugan 5

- Speicher

- 2x4GB ADATA

- Grafikprozessor

- RX 550

- Display

- BenQ 21,5

- SSD

- Samsung 960Pro

- HDD

- 1TB WD

- Optisches Laufwerk

- LG schwarz

- Soundkarte

- AC 97

- Gehäuse

- NZXT Beta Evo

- Netzteil

- AXP SimplePower 630W

- Betriebssystem

- Win 10

- Webbrowser

- Chrome

Mal ne blöde Frage. Vielleicht habe ich was verpasst, aber keiner hat Mantel getestet auf der Fury.

Oder kann die Fury Mantel nicht?

Oder kann die Fury Mantel nicht?

Unbekannter Krieger

Grand Admiral Special

- Mitglied seit

- 04.10.2013

- Beiträge

- 4.455

- Renomée

- 66

- Mein Laptop

- HP 15-bq102ng (sackteuer u. ab Werk instabil)

- Details zu meinem Desktop

- Prozessor

- FX-8320E@4,2 GHz & 2,6 GHz Northbridge (jeweils mit UV)

- Mainboard

- Asus M5A99X Evo R2.0 (eher enttäuschend ggü. ASRock E3)

- Kühlung

- Raijintek Nemesis (Lüfter mittig im sowie hinter dem Kühler; erstklassig)

- Speicher

- 4x4 GiB Hynix DDR3-1866 ECC

- Grafikprozessor

- XFX RX 570 8G (P8DFD6)@1180 & 2150 MHz@starkem, fortdauerndem UV | ASRock RX 570 8G@das Gleiche

- Display

- BenQ XL2411T ~ nach 3 RMAs und 6 Monaten wieder brauchbar

- SSD

- Crucial MX100 256 GB (ein Glückskauf) | SanDisk Ultra Plus 256 GB (ein Glückskauf)

- HDD

- WD20EZRZ u. a. (Seagate, Hitachi, WD)

- Optisches Laufwerk

- TSST SH-222AL

- Gehäuse

- Corsair Carbide 300R (ein Fehlkauf)

- Netzteil

- CoolerMaster V450S (ein Glückskauf)

- Betriebssystem

- Win8.x x64, Win7 x64

- Webbrowser

- welche mit minimalem Marktanteil & sinnvollen Konzepten (nicht Chrome-Seuche und Sieche-Fuchs)

- Verschiedenes

- frühere GPUs: , Asus RX 480 O8G@580 O8G, VTX3D 7850 1G

Wer hat das denn so angekündigt? Sicher, dass es AMD war? Oder bist du nur auf die jedes Mal wieder herausgekramte Karte, unerfüllbar hohe Erwartungen vor AMD-Releases zu wecken, [Beginn der Ironie] während bei Nvidias Vorstellungen immer alle Wünsche übertroffen werden - versteht sich doch von selbst - [Ende der Ironie], reingefallen?wolle23 schrieb:Es wurde quasi eine Revolution, eine neue Sphäre angekündigt

hoschi_tux

Grand Admiral Special

- Mitglied seit

- 08.03.2007

- Beiträge

- 4.760

- Renomée

- 286

- Standort

- Ilmenau

- Aktuelle Projekte

- Einstein@Home, Predictor@Home, QMC@Home, Rectilinear Crossing No., Seti@Home, Simap, Spinhenge, POEM

- Lieblingsprojekt

- Seti/Spinhenge

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 5900X

- Mainboard

- ASUS TUF B450m Pro-Gaming

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x 16GB Crucial Ballistix Sport LT DDR4-3200, CL16-18-18

- Grafikprozessor

- AMD Radeon RX 6900XT (Ref)

- Display

- LG W2600HP, 26", 1920x1200

- HDD

- Crucial M550 128GB, Crucial M550 512GB, Crucial MX500 2TB, WD7500BPKT

- Soundkarte

- onboard

- Gehäuse

- Cooler Master Silencio 352M

- Netzteil

- Antec TruePower Classic 550W

- Betriebssystem

- Gentoo 64Bit, Win 7 64Bit

- Webbrowser

- Firefox

Mal ne blöde Frage. Vielleicht habe ich was verpasst, aber keiner hat Mantle getestet auf der Fury.

Oder kann die Fury Mantle nicht?

Mantle kann sie, hat nur keiner getestet. Habe in anderen Foren diesbezüglich gelesen, dass man das nicht gemacht hat, weil die Vergleichbarkeit mit den nVidia Karten nicht gegeben gewesen wäre, bla bla.

Gerade im Hinblick auf DX12 hätte man das sehr gut als extra Aufhänger bringen können. Chance vertan..

mickythebeagle

Gesperrt

- Mitglied seit

- 21.10.2009

- Beiträge

- 1.020

- Renomée

- 21

- Aktuelle Projekte

- Asteroids@home , Malariacontrol.net

- Lieblingsprojekt

- Asteroids, Malaria

- Meine Systeme

- E3-1230V2

- BOINC-Statistiken

- Mein Laptop

- Asus A6ja + Asus A52jc+ 6 Kaveri Books

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E5- 2630

- Mainboard

- ASRock X99 Extreme4

- Kühlung

- Akasa Venom Medusa

- Speicher

- 4x48 DDR4

- Grafikprozessor

- Sapphire Radeon R9 290X Tri-X OC

- Display

- 2x Dell U2412M

- SSD

- 240GB Patriot Pyro SE + 2x Crucial CT960M500SSD1

- HDD

- 4 x 2TB Samsung 204UI + 1x 1TB WD

- Optisches Laufwerk

- 2x LG BD-Brenner

- Soundkarte

- on Board

- Gehäuse

- Coolermaster HAF 932

- Netzteil

- Be quiet! PurePower L8 600 Watt

- Betriebssystem

- Win-7x64

- Webbrowser

- FireFox

- Verschiedenes

- und noch viele viele AMD Rechner. , Und das Wichtigste, die Freundin mein , AMIGA-3000

Mantle kann sie, hat nur keiner getestet. Habe in anderen Foren diesbezüglich gelesen, dass man das nicht gemacht hat, weil die Vergleichbarkeit mit den nVidia Karten nicht gegeben gewesen wäre, bla bla.

Gerade im Hinblick auf DX12 hätte man das sehr gut als extra Aufhänger bringen können. Chance vertan..

Für einen ECHTEN DX12 Test hätten die aber alle Win10 nehmen müssen. Mich würde es Interessieren wie sich die Karte dann schlägt.

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Wäre dies denn praxisgerecht? Aus den von AMD angekündigten "hunderten" Titeln mit Mantle Unterstützung ist bisher noch nichts geworden. Derzeit kann man sie an einer Hand abzählen. Außerdem befindet sich Mantle nun zugunsten von Diret3D12 und Vulkan auf dem Abstellgleis und wurde auf die Entwicklerschiene geschoben. Insofern hat Mantle einfach keine Zukunft (bei Spielen von der Stange) mehr. Man kann sagen, dass AMD seinen Alleingang dem größeren Wohl geopfert und damit dem Markt einen Dienst erwiesen hat. Allerdings leben Teile von dieser API in Vulkan weiter. Vulkan wurde jedoch an entscheidenden Stellen aufgebohrt und bietet mit SPIR-V zum Beispiel obendrein eine Zwischensprache, die zwischen verschiedenen Laufzeitsystemen übersetzen kann. Vulkan ist damit nicht mehr auf HLSL festgenagelt, wie Mantle. Vulkan ist sozusagen ein "SuperOpenMantle".Mal ne blöde Frage. Vielleicht habe ich was verpasst, aber keiner hat Mantel getestet auf der Fury.

Ich frage mich angesichts des Radeon R9 Fury X Launchs, wieso sich kein Reviewer von den HBM Vorzügen durch synthetische Benchmarks überzeugt hat. Es wäre kein Hexenwerk gewesen ein OpenCL Programm zu schreiben, welches mit unterschiedlichen Pattern die deutlich über GDDR5-RAM liegenden IOPS-Werte von HBM ermittelt. So hätte man handfeste Werte über die man debattieren kann, anstatt indirekte Schlüsse ziehen zu müssen.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Vor allem kann es sein, dass dort eben der HBM Speicher seine Stärken wie z.B. das separate runter takten von nicht benötigten Speicherbausteinen noch besser ausspielen kann. Das Speichermanagement ist deutlich segmentierter unter Mantle/DX12.

Merkwürdig, dass AMD im Review Guide nicht wenigstens ein, zwei Spiele zur Vergleichbarkeit gefordert hat.

Weniger merkwürdig ist, dass BF4 aus dem Testparcours bei CB raus geflogen ist rechtzeitig vor dem GTX 980 Ti Launch und ein neues Testsystem eingeführt wurde. Und prompt haben sie ja die Fury auf diesem Standard Mainboard mit Z87 Chipsatz nicht zum laufen gebracht und mussten ein anderes nehmen mit Z97 Chipsatz.

Der Grund warum BF4 raus genommen wurde war die angebliche CPU-Limitierung, anstatt eben mit Mantle im Vergleich den Unterschied zu zeigen geht es nur um Benchmark Balken. Ich frage mich was diese Reviews nützen wenn man immer den kleinsten gemeinsamen Nenner sucht anstatt die Unterschiede und Vor- sowie Nachteile dieser aufzuzeigen. Wäre wohl eigene Denkarbeit notwendig.

Merkwürdig, dass AMD im Review Guide nicht wenigstens ein, zwei Spiele zur Vergleichbarkeit gefordert hat.

Weniger merkwürdig ist, dass BF4 aus dem Testparcours bei CB raus geflogen ist rechtzeitig vor dem GTX 980 Ti Launch und ein neues Testsystem eingeführt wurde. Und prompt haben sie ja die Fury auf diesem Standard Mainboard mit Z87 Chipsatz nicht zum laufen gebracht und mussten ein anderes nehmen mit Z97 Chipsatz.

Der Grund warum BF4 raus genommen wurde war die angebliche CPU-Limitierung, anstatt eben mit Mantle im Vergleich den Unterschied zu zeigen geht es nur um Benchmark Balken. Ich frage mich was diese Reviews nützen wenn man immer den kleinsten gemeinsamen Nenner sucht anstatt die Unterschiede und Vor- sowie Nachteile dieser aufzuzeigen. Wäre wohl eigene Denkarbeit notwendig.

Zuletzt bearbeitet:

samm

Lt. Commander

- Mitglied seit

- 02.09.2009

- Beiträge

- 131

- Renomée

- 1

- Details zu meinem Desktop

- Prozessor

- Threadripper 1950X @Stock

- Mainboard

- Asrock Taichi x399

- Kühlung

- XSPC Raystorm Neo

- Speicher

- 4*8GB G.Skill 3700 CL17 @3200 CL14

- Grafikprozessor

- Sapphire 6900 XT Toxic Air

- Display

- LG G1 55

- SSD

- Samsung 950 Evo 1TB, Samsung 840 Pro 256 GB, Samsung 830 128 GB

- Soundkarte

- SoundblasterX AE-5

- Netzteil

- Seasonic Titanium 750W

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Brave

Zu Mantle-Tests: Laut Aussage von einem Linux-Treiber-Tester im 3DC klingt es so, als würde der "alte" Stand der Frostbyte-Engine, wie er in BF4 verwendet wird, bei Fiji und Tonga ohnehin in einen langsameren Fallback-Modus von Mantle verfallen (Quelle). Ob und welche Vorteile dieser gegenüber DX11 bei langsameren CPUs hätte, müsste man wirklich noch testen.

Ich hoffe auf tiefergehende Reviews, evt sogar schon mit neueren Treibern, in der kommenden Zeit nach den ersten paar Schnellschüssen.

Ich hoffe auf tiefergehende Reviews, evt sogar schon mit neueren Treibern, in der kommenden Zeit nach den ersten paar Schnellschüssen.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

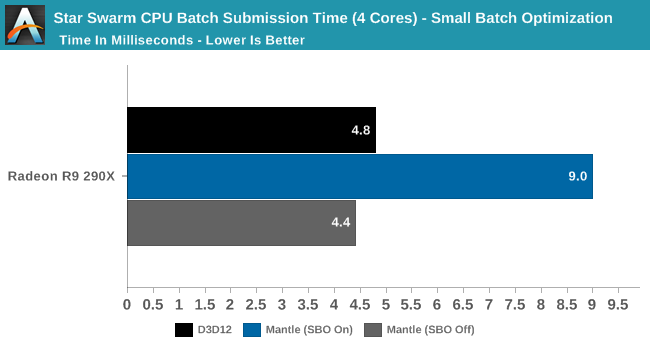

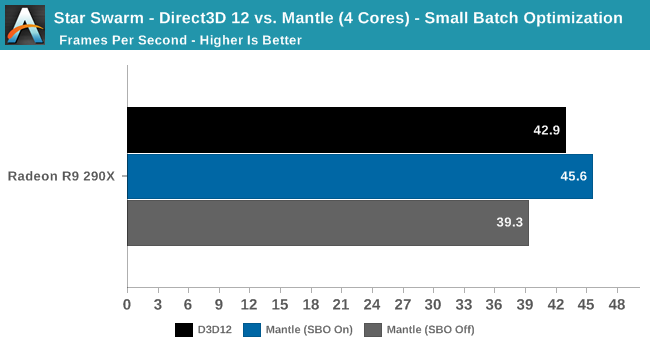

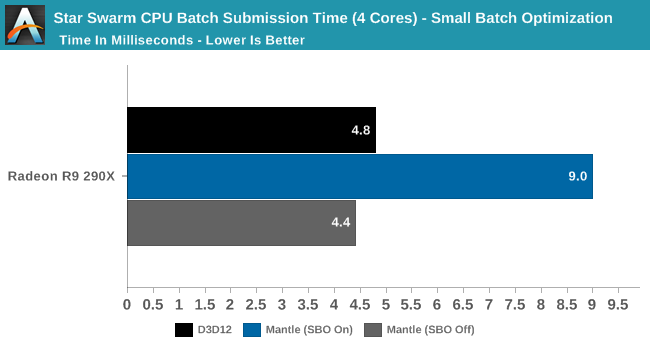

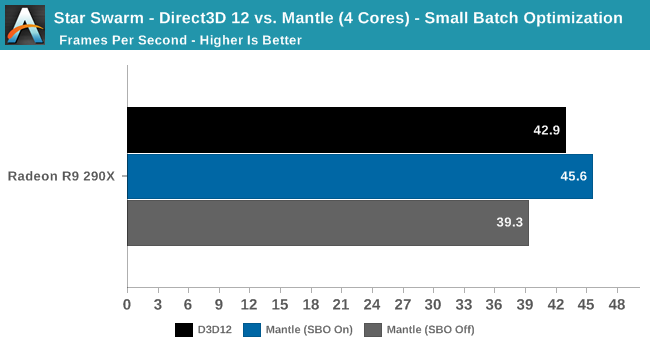

Das wurde hier untersucht von Anand:

http://www.anandtech.com/show/8962/the-directx-12-performance-preview-amd-nvidia-star-swarm/6

ab dem Update lesen, das Oxide Games auf Rückfrage geliefert hat:

http://www.anandtech.com/show/8962/the-directx-12-performance-preview-amd-nvidia-star-swarm/6

ab dem Update lesen, das Oxide Games auf Rückfrage geliefert hat:

Oxide Games has emailed us this evening with a bit more detail about what's going on under the hood, and why Mantle batch submission times are higher. When working with large numbers of very small batches, Star Swarm is capable of throwing enough work at the GPU such that the GPU's command processor becomes the bottleneck. For this reason the Mantle path includes an optimization routine for small batches (OptimizeSmallBatch=1), which trades GPU power for CPU power, doing a second pass on the batches in the CPU to combine some of them before submitting them to the GPU. This bypasses the command processor bottleneck, but it increases the amount of work the CPU needs to do (though note that in AMD's case, it's still several times faster than DX11).

Ich hoffe auf tiefergehende Reviews, evt sogar schon mit neueren Treibern, in der kommenden Zeit nach den ersten paar Schnellschüssen.

Ich genau so... Eine ganz neue Architektur mit neuer Speichertechnik - da muss man doch noch optimieren können...

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Ich hoffe mal sie basteln noch am GPGPU Teil im Treiber, hier gibt es ein kleinen Vorgeschmack: http://www.redgamingtech.com/amd-radeon-fury-x-features-4096-shaders-opencl-performance-leaked/Ich frage mich angesichts des Radeon R9 Fury X Launchs, wieso sich kein Reviewer von den HBM Vorzügen durch synthetische Benchmarks überzeugt hat. Es wäre kein Hexenwerk gewesen ein OpenCL Programm zu schreiben, welches mit unterschiedlichen Pattern die deutlich über GDDR5-RAM liegenden IOPS-Werte von HBM ermittelt. So hätte man handfeste Werte über die man debattieren kann, anstatt indirekte Schlüsse ziehen zu müssen.

Die Werte sind allerdings vor dem Release entstanden.

Mantle Spiele wurden wohl nicht von den Redaktion genutzt, da man sonst nvidia böse aussticht...

Makso

Grand Admiral Special

- Mitglied seit

- 15.02.2006

- Beiträge

- 3.393

- Renomée

- 142

- Standort

- Österreich

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Folding@Home, POEM, Docking

- Lieblingsprojekt

- Folding@Home

- Folding@Home-Statistiken

- Mein Laptop

- Desktopsystem

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1400@3,8GHz

- Mainboard

- Asrock B350 Pro4

- Kühlung

- Scythe Mugan 5

- Speicher

- 2x4GB ADATA

- Grafikprozessor

- RX 550

- Display

- BenQ 21,5

- SSD

- Samsung 960Pro

- HDD

- 1TB WD

- Optisches Laufwerk

- LG schwarz

- Soundkarte

- AC 97

- Gehäuse

- NZXT Beta Evo

- Netzteil

- AXP SimplePower 630W

- Betriebssystem

- Win 10

- Webbrowser

- Chrome

Mantle Spiele wurden wohl nicht von den Redaktion genutzt, da man sonst nvidia böse aussticht...

Wie kommst du drauf

Auch unter DX12 ist eine R9290X schneller als ne GTX 980.

Auch unter DX12 ist eine R9290X schneller als ne GTX 980.nVidia ist halt unter DX11 schneller, jetzt abwarten bis die ersten Spiele in DX12 rauskommen.

Dann schauts anders aus und dann kommen Aussagen MS hat AMD unter die Arme geholfen bezüglich Optimierung.

Es ist egal was AMD macht es wird immer gejammert und niedergemacht.

Wenn man berücksichtig und das sage ich immer wieder Budget für die Forschung gegenüber Intel & NV ist AMD von den Innovationen und Idee Lichtjahre voraus!

Cappuandy

Grand Admiral Special

- Mitglied seit

- 30.01.2013

- Beiträge

- 3.636

- Renomée

- 168

- Standort

- Lübeck

- Mein Desktopsystem

- ROGi

- Mein Laptop

- MacBook Pro

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 7600X

- Mainboard

- Asus ROG X670E-I Gaming WiFi

- Kühlung

- BeQuiet DarkRockPro 4

- Speicher

- Gskill Trident-Z5 RGB Black 32Gb 6000CL30

- Grafikprozessor

- iGP

- Display

- LG 27" UHD60 HDR

- SSD

- 980 Pro & T500

- HDD

- - none -

- Optisches Laufwerk

- - none -

- Soundkarte

- ROG Hive - ALC4050

- Gehäuse

- Fractal Design Torrent Nano

- Netzteil

- BeQuiet SP12 1kW Platinum

- Tastatur

- Razer Cynosa

- Maus

- Razer Mamba

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox | Safari@iPhone

- Internetanbindung

- ▼schneller ▲schnell

Dann schauts anders aus und dann kommen Aussagen MS hat AMD unter die Arme geholfen bezüglich Optimierung.

Es ist egal was AMD macht es wird immer gejammert und niedergemacht.

Wenn man berücksichtig und das sage ich immer wieder Budget für die Forschung gegenüber Intel & NV ist AMD von den Innovationen und Idee Lichtjahre voraus!

cht.

Wenn man berücksichtig und das sage ich immer wieder Budget für die Forschung gegenüber Intel & NV ist AMD von den Innovationen und Idee Lichtjahre voraus!

Wenn man das lesen würde bevor man es abschickt würden die Leute der meinung vll. eher folgen... Wer das liest bricht sich ja die Hirnwindungen...

mariahellwig

Grand Admiral Special

Mantle kann sie, hat nur keiner getestet. Habe in anderen Foren diesbezüglich gelesen, dass man das nicht gemacht hat, weil die Vergleichbarkeit mit den nVidia Karten nicht gegeben gewesen wäre, bla bla.

Gerade im Hinblick auf DX12 hätte man das sehr gut als extra Aufhänger bringen können. Chance vertan..

Das ist unfassbar!!! Was für ein Blödsinn.

Mantle ist definitiv ein Mehrwert. Warum sollte ich es als AMD-Kunde nicht einsetzen? Damit sich nVidia nicht benachteiligt fühlt? Was ist das für ein Blödsinn...

Mantle gehört zu einem Test dazu! Und im Übrigen kommt auch niemand auf die Idee Gamework-Titel aussenvorzulassen. Hat man es nur mit Idioten zu tun?

Dr@

Grand Admiral Special

- Mitglied seit

- 19.05.2009

- Beiträge

- 12.791

- Renomée

- 4.066

- Standort

- Baden-Württemberg

- Aktuelle Projekte

- Collatz Conjecture

- Meine Systeme

- Zacate E-350 APU

- BOINC-Statistiken

- Mein Laptop

- FSC Lifebook S2110, HP Pavilion dm3-1010eg

- Details zu meinem Laptop

- Prozessor

- Turion 64 MT37, Neo X2 L335, E-350

- Mainboard

- E35M1-I DELUXE

- Speicher

- 2x1 GiB DDR-333, 2x2 GiB DDR2-800, 2x2 GiB DDR3-1333

- Grafikprozessor

- RADEON XPRESS 200m, HD 3200, HD 4330, HD 6310

- Display

- 13,3", 13,3" , Dell UltraSharp U2311H

- HDD

- 100 GB, 320 GB, 120 GB +500 GB

- Optisches Laufwerk

- DVD-Brenner

- Betriebssystem

- WinXP SP3, Vista SP2, Win7 SP1 64-bit

- Webbrowser

- Firefox 13

... Aus den von AMD angekündigten "hunderten" Titeln mit Mantle Unterstützung ist bisher noch nichts geworden. Derzeit kann man sie an einer Hand abzählen. ...

Ich nehme mal die Herausforderung an:

Battlefield 4

Battlefield Hardline

Dragon Age: Inquisition

Plants vs Zombies: Garden Warfare

Sid Meier’s Civilization: Beyond Earth

Sniper Elite 3

Thief

Wo ich noch keine offizielle Bestätigung gesehen habe (sind aber auch Frostbite 3 Titel):

Star Wars: Battlefront

Plants vs Zombies: Garden Warfare 2

Ist schon mal mehr als eine Hand voll

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Immerhin bei SemiAccurate haben sie Mantle getestet: http://semiaccurate.com/2015/06/24/overclocking-amds-fury-x/

Civilization BE:

DX11: 46,9 FPS

Mantle: 67,2FPS

Also Grundsätzlich mal 40% mehr FPS drauflegen.

Civilization BE:

DX11: 46,9 FPS

Mantle: 67,2FPS

Also Grundsätzlich mal 40% mehr FPS drauflegen.

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Nur wenn man bei dieser Betrachtung Polydaktylie außer Acht lässt.Ist schon mal mehr als eine Hand voll

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

@Dr@

SW Battlefront und PvZ ist bestätigt. Auch Mirrors Edge nächstes Jahr kommt dazu, sowie Need for Speed Rivals

http://techgage.com/news/amd-shelves-mantle-as-company-transitions-to-a-directx-12-future/

SW Battlefront und PvZ ist bestätigt. Auch Mirrors Edge nächstes Jahr kommt dazu, sowie Need for Speed Rivals

http://techgage.com/news/amd-shelves-mantle-as-company-transitions-to-a-directx-12-future/

Es wird keine 8GB Variante geben.

Da wirst du wie alle anderen auf HBM2 warten müssen. (und 14nm) - vor 2016 wird sich da aber nichts regen.

Im Übrigen scheinst du in den Zaubertrank Kessel gefallen zu sein, bei der überschwenglichen Begeisterung.

Gruß

skell.

Es gibt erste böse Gerüchte, das HBM2 auch noch nicht 2016 kommen wird.... Man scheint in der Entwicklung davon noch nicht so weit zu sein, wie viele in den Namen HBM2 rein interpretieren....

Was mich bis jetzt am meisten verwundert AMD hat die Karte als Heaven für Overclocker gepriesen. Bis jetzt waren nicht mehr als 13% drin...

Aber noch ist Overvolting nicht möglich - dabei gibt es das Board her 400Ampare, die Stromversorgung 2x 8 Pin und die Kühlung - der Radiator soll wohl bis 500 Watt abführen können....

Laut Revs liegt die GPU Temp bisher bei um 50 Grad, aber im Max soll sie 75 Grad abkönnen....

Was mich stutzig macht - 10% mehr Takt resultiert im Schnitt in 5% mehr Leistung in Games [ist das normal? - oder limitiert hier das relativ kleine Front-End?]

--- Update ---

Mal ne blöde Frage. Vielleicht habe ich was verpasst, aber keiner hat Mantel getestet auf der Fury.

Oder kann die Fury Mantel nicht?

Hier hat wenigstens einer beim overclocking auch Mantle getestet - DX Ergebnisse stehen weiter oben.

http://semiaccurate.com/2015/06/24/overclocking-amds-fury-x/

Unbekannter Krieger

Grand Admiral Special

- Mitglied seit

- 04.10.2013

- Beiträge

- 4.455

- Renomée

- 66

- Mein Laptop

- HP 15-bq102ng (sackteuer u. ab Werk instabil)

- Details zu meinem Desktop

- Prozessor

- FX-8320E@4,2 GHz & 2,6 GHz Northbridge (jeweils mit UV)

- Mainboard

- Asus M5A99X Evo R2.0 (eher enttäuschend ggü. ASRock E3)

- Kühlung

- Raijintek Nemesis (Lüfter mittig im sowie hinter dem Kühler; erstklassig)

- Speicher

- 4x4 GiB Hynix DDR3-1866 ECC

- Grafikprozessor

- XFX RX 570 8G (P8DFD6)@1180 & 2150 MHz@starkem, fortdauerndem UV | ASRock RX 570 8G@das Gleiche

- Display

- BenQ XL2411T ~ nach 3 RMAs und 6 Monaten wieder brauchbar

- SSD

- Crucial MX100 256 GB (ein Glückskauf) | SanDisk Ultra Plus 256 GB (ein Glückskauf)

- HDD

- WD20EZRZ u. a. (Seagate, Hitachi, WD)

- Optisches Laufwerk

- TSST SH-222AL

- Gehäuse

- Corsair Carbide 300R (ein Fehlkauf)

- Netzteil

- CoolerMaster V450S (ein Glückskauf)

- Betriebssystem

- Win8.x x64, Win7 x64

- Webbrowser

- welche mit minimalem Marktanteil & sinnvollen Konzepten (nicht Chrome-Seuche und Sieche-Fuchs)

- Verschiedenes

- frühere GPUs: , Asus RX 480 O8G@580 O8G, VTX3D 7850 1G

Wie sieht es mit Die Sims 4 aus, welches hier auch gelistet wird? Und ist The Rise of the Tomb Raider mittlerweile erschienen?

https://de.wikipedia.org/wiki/AMD_Mantle#Unterst.C3.BCtzende_Spiele

b) Die an die Redaktionen verschickten Exemplare sind aus der frühen Fertigung und dementsprechend weniger OC-freudig.

c) Die Furys werden lange am Markt bleiben, sodass mit der Zeit noch einige Anpassungen erfolgen können, darunter Fertigungsverbesserungen und Spannungsfreigabe.

d) eine Kombination aus mehreren der vorstehenden Punkte

https://de.wikipedia.org/wiki/AMD_Mantle#Unterst.C3.BCtzende_Spiele

a) Man meinte Fury, nicht Fury X.Was mich bis jetzt am meisten verwundert AMD hat die Karte als Heaven für Overclocker gepriesen. Bis jetzt waren nicht mehr als 13% drin...

b) Die an die Redaktionen verschickten Exemplare sind aus der frühen Fertigung und dementsprechend weniger OC-freudig.

c) Die Furys werden lange am Markt bleiben, sodass mit der Zeit noch einige Anpassungen erfolgen können, darunter Fertigungsverbesserungen und Spannungsfreigabe.

d) eine Kombination aus mehreren der vorstehenden Punkte

Am meisten limitiert DX11.limitiert hier das relativ kleine Front-End?

Zuletzt bearbeitet:

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

Fury X kann freilich Mantle.Mal ne blöde Frage. Vielleicht habe ich was verpasst, aber keiner hat Mantel getestet auf der Fury. Oder kann die Fury Mantel nicht?

Bullshit zum 1sten.Mantle kann sie, hat nur keiner getestet. Habe in anderen Foren diesbezüglich gelesen, dass man das nicht gemacht hat, weil die Vergleichbarkeit mit den nVidia Karten nicht gegeben gewesen wäre, bla bla.

Bullshit zum 2ten, vor allem weil Mantle im Grafik-Limit eh kaum bis nichts bringt. Höchstens die 1080p-Werte sähen besser aus.Mantle Spiele wurden wohl nicht von den Redaktion genutzt, da man sonst nvidia böse aussticht.

Die meisten Tester hatten die Fury X nur 2T oder weniger Zeit. Mantle-Frostbite-Titel wie BF4 oder DAI kann man nicht "einfach so" benchen, für Mantle muss man per Console fummeln und mit Skripten arbeiten, was unheimlich viel Zeit kostet und nicht direkt mit Fraps vergleichbar ist. Muss man also alle Karten (auch Geforces) per Console testen und dann hockt man alleine für fünf Karten in drei Settings in einem Mantle-Titel mehrere Stunden am PC. Einfacher ist's freilich wenn man integrierte Benches nimmt wie S|A mit Civ BE und Sniper Elite 3 ... aber die haben mit dem eigentlichen Spiel wenig zu tun.

Bullshit zum 3ten. Die derzeit im Handel erhältlichen Fury X (u.a. Alternate und Caseking) gehen genauso schlecht wie die Review Samples.Die an die Redaktionen verschickten Exemplare sind aus der frühen Fertigung und dementsprechend weniger OC-freudig

Nö, Frontend - siehe 4K vs 1080p.Am meisten limitiert DX11.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Wo wir schon beim Thema Bullshit sind....

Ich habe mir inzwischen das eine oder andere Review durchgelesen und muss sagen das da vom Unterhaltungswert her echte Kracher mit dabei sind.

Am besten hat mir bisher die Formulierung gefallen das die Fury bei geringeren Auflösungen stärker einbrechen würde gefallen. Mal ehrlich....ich habe noch nie erlebt das eine Karte die entlastet wird einbrechen würde. Wären die Rollen vertauscht würde es wohl heißen das die AMD Karte bei hohen Auflösungen stärker einbrechen würde, gelle?

Ich habe mir inzwischen das eine oder andere Review durchgelesen und muss sagen das da vom Unterhaltungswert her echte Kracher mit dabei sind.

Am besten hat mir bisher die Formulierung gefallen das die Fury bei geringeren Auflösungen stärker einbrechen würde gefallen. Mal ehrlich....ich habe noch nie erlebt das eine Karte die entlastet wird einbrechen würde. Wären die Rollen vertauscht würde es wohl heißen das die AMD Karte bei hohen Auflösungen stärker einbrechen würde, gelle?

Ähnliche Themen

- Antworten

- 2

- Aufrufe

- 3K

G

- Antworten

- 0

- Aufrufe

- 654

- Antworten

- 31

- Aufrufe

- 8K

- Antworten

- 5

- Aufrufe

- 3K