App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD RDNA2 / Navi-2 und "Bignavi"

- Ersteller BavarianRealist

- Erstellt am

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.716

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Müssen sie nicht, die Abstufungen brauchen sie für mobile GPUs, vielleicht auch für OEM-Desktops. Aber für Privatkunden sehe ich da generell schon kaum einen Markt (Volumen-mäßig, denkt daran, dass Do it yourself eine kleine Nische ist). Und während der Chipkrise ist es nicht drin.aber müssten nicht nutzlos entsorgt werden.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.262

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Wenn mobile GPUs ein Grund sind, dieseGPU auf den Markt zu bringen, verstehe ich die Verwunderung noch viel weniger.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.716

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Naja, dass solche kleinen GPUs in Hardware existieren, und es für (OEM-)Notebooks und OEM-Desktops deutlich mehr Modelle gibt, war ja schon immer so, auch vor der Chipkrise. Sinnvoll sind sie da meist auch nicht. Es gibt ja regelrecht "überflüssige" Kombinationen aus einer schnellen iGPU und einem langsameren(!) Extra-Chip. Aber der Kunde (OEM) will es so und er zahlt dafür, inkl. neuer Modellnummern im Jahrestakt.

Womöglich gibt es bei Endverbrauchern in Asien auch solche "Glaubenssätze" wie im asiatischen Smartphone-Markt: nur ein großes Smartphone ist ein gutes Statussymbol. Ein "vernünftiger PC" braucht eine Grafikkarte? Keine Ahnung, jedenfalls läuft der Markt scheinbar so. Und womöglich buchen die Hersteller auch "Pakete" aus xx großen / mittleren / kleinen CPUs sowie xx großen / kleinen GPUs. Wenn du irgendwo nichts anbieten kannst, dein Konkurrent aber schon, hast du ein Problem. Dann macht es mehr Sinn, die ganze Serie auf deinen Konkurrenten auszulegen. Ist jetzt nur ne Vermutung, aber dass die OEMs in der wirtschafltichen Bedeutung weit, weit vor dem DIY-Markt kommen, wissen wir ja alle.

Ich denke, AMD hätte ohne die Chipkrise auch ein paar 6 nm-Chips über (oder würde weiter Polaris fertigen). Ferner können wir davon ausgehen, dass man in jedem Preissegment vertreten sein möchte, was noch Gewinn abwirft.

Womöglich gibt es bei Endverbrauchern in Asien auch solche "Glaubenssätze" wie im asiatischen Smartphone-Markt: nur ein großes Smartphone ist ein gutes Statussymbol. Ein "vernünftiger PC" braucht eine Grafikkarte? Keine Ahnung, jedenfalls läuft der Markt scheinbar so. Und womöglich buchen die Hersteller auch "Pakete" aus xx großen / mittleren / kleinen CPUs sowie xx großen / kleinen GPUs. Wenn du irgendwo nichts anbieten kannst, dein Konkurrent aber schon, hast du ein Problem. Dann macht es mehr Sinn, die ganze Serie auf deinen Konkurrenten auszulegen. Ist jetzt nur ne Vermutung, aber dass die OEMs in der wirtschafltichen Bedeutung weit, weit vor dem DIY-Markt kommen, wissen wir ja alle.

Ich denke, AMD hätte ohne die Chipkrise auch ein paar 6 nm-Chips über (oder würde weiter Polaris fertigen). Ferner können wir davon ausgehen, dass man in jedem Preissegment vertreten sein möchte, was noch Gewinn abwirft.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.347

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich denke das man wieder die gleiche Strategie wie in der Vergangenheit fahren wird, ein Modell mit einem neuen Chip Design/Fertigungsprozess in einer bestehenden Serie als Pilot Modell für die nächste Kartengeneration starten um vor dem Start auf breiter Front Produktionserfahrungen zu sammeln.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.716

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

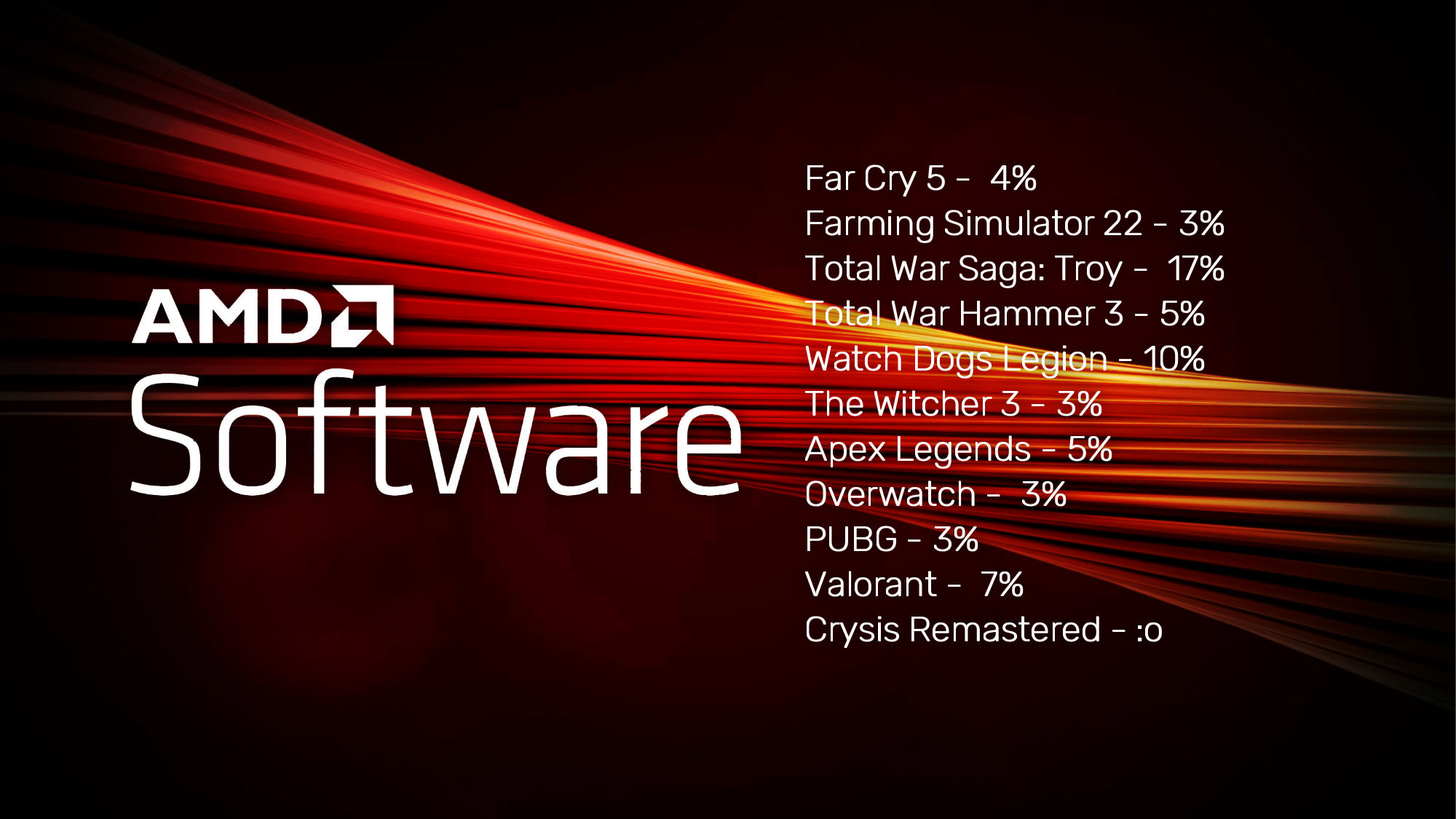

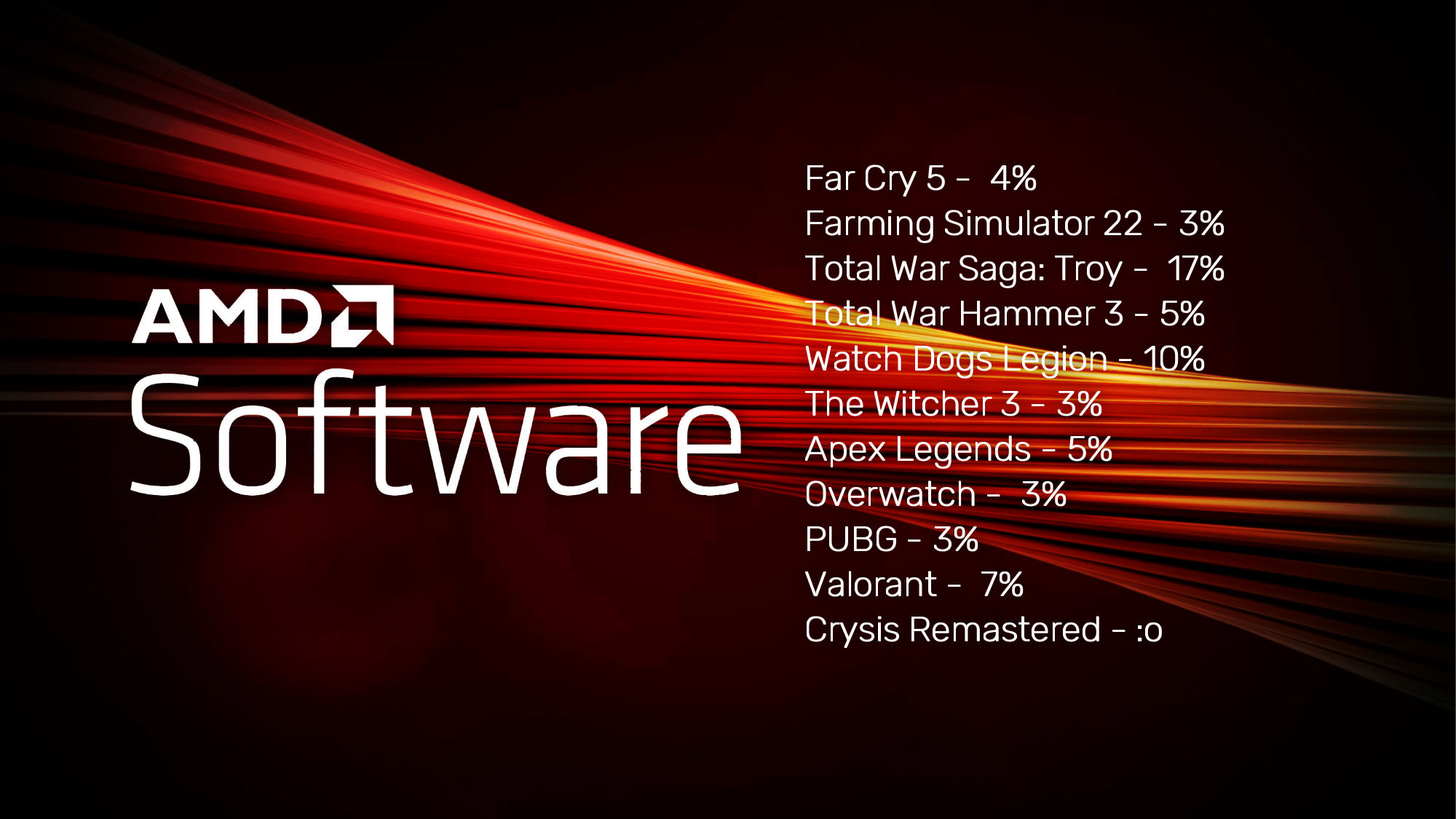

Der Mai-Treiber bringt einen so großen Performance-Sprung für Radeon-Karten (zwischen 3 und 41 %), dass die Tests von DX11-Spielen wiederholt werden müssen.

videocardz.com

videocardz.com

Weitere Werte des Twitterers CapFrameX: Assassin's Creed Odyssey +34 % / God of War +41 %

Hier zeigt sich wie schon in den letzten Jahren, dass AMDs Karten tatsächlich besser reifen als die von Nvidia. Man kann also zum Launch gedanklich noch etwas drauf schlagen, und sollte sich von den oftmals knappen Unterschieden nicht so beeindrucken lassen.

AMD graphics driver preview delivers up to 17% better performance for DirectX11 games - VideoCardz.com

AMD driver for DX11 games Along with Radeon RX 6950/6750/6650XT driver, AMD released a preview of its upcoming May update. This driver will be released later this month, but there is a good reason to check it out already. Radeon Super Resolution 1.1 now with “Sharpen Effect” slider The AMD...

Weitere Werte des Twitterers CapFrameX: Assassin's Creed Odyssey +34 % / God of War +41 %

Hier zeigt sich wie schon in den letzten Jahren, dass AMDs Karten tatsächlich besser reifen als die von Nvidia. Man kann also zum Launch gedanklich noch etwas drauf schlagen, und sollte sich von den oftmals knappen Unterschieden nicht so beeindrucken lassen.

Zuletzt bearbeitet:

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.369

- Renomée

- 9.694

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Weitere Werte des Twitterers CapFrameX: Assassin's Creed Odyssey +34 % / God of War +41 %

Hier zeigt sich wie schon in den letzten Jahren, dass AMDs Karten tatsächlich besser reifen als die von Nvidia. Man kann also zum Launch gedanklich noch etwas drauf schlagen, und sollte sich von den oftmals knappen Unterschieden nicht so beeindrucken lassen.

Und Crysis Remastered bis zu +24%.

Hier zeigt sich wie schon in den letzten Jahren, dass AMDs Karten tatsächlich besser reifen als die von Nvidia. Man kann also zum Launch gedanklich noch etwas drauf schlagen, und sollte sich von den oftmals knappen Unterschieden nicht so beeindrucken lassen.

Klar kann das jeder machen. Zumindest ich brauche solche Hilfskrüken nicht, um mir AMD Hardware schönzureden. Ich kaufe diese, weil ich bisher gute Erfahrung damit gesammet habe und mit deren Eigenheiten gut klar komme. Besser Langzeitsupport ist auch einer Gründe für mich. Ich spiele gerne ältere Spiele und bisher sind diese alle mit normal spielen (maximal kleinen Grafikfehler). Laut einem älteren Artikel von CB ist die Wahrscheinlichkeit das ein Spiel mit einer AMD Karte nicht läuft geringer als mit einer Nvidia Karte. Ich noch von keiner Neuauflage gehört . Aber Nvidia ist ja auch mehr auf die neuste Hardware und Software fixiert. Die bessere Leistungsentwicklung kommt bei mir dann nur noch oben drauf. Ich finde AMD sollte noch ein bishen mehr in diese richtung gehen. ich finde es nicht gut das Navi 33 bei RX 6800 XT Leistung nur 8 GB VRAM bekommen soll. Auch das die neusten Schnittstellen, Videounterstützung, ... lange brauchen bis diese eingeführt werden. Passt für mich nicht zum längeren Nutzungszeitraum.

Das die Tech Presse das macht, glaube ich nicht (Erfahrung). Es wird dann gesagt, dass Nvidia ab beginn die volle Leistung bringt. Schon das Wort reifen deutet eine langsame Entwicklung an. Die Gründe dafür interesieren dort auch niemanden. Auch das Einplanen einer zukünfigen Entwicklung ist schwierig.

Aus der Beschreibung ist mir nicht klar, ob es eine allegemeine Verbesserung gibt (für alle DX11 Spiele) oder die Handbremse nur einige wenigen Spielen gelöst wurden?

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.716

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Das ist keine "Hilfskrücke", und ich rede nichts schön. Es es ist einfach ein Argument, ein weiterer Aspekt, den man beachten sollte.

Es hat ja auch seinen Grund: weil das Team bei AMD kleiner ist, sind die Karten zum Launch noch nicht so ausoptimiert wie bei Nvidia. Aber schlechter werden sie nicht mehr, sondern besser. Das plane ich mit ein, auch wenn es nicht der einzige Kaufgrund sein sollte. Auch ich habe weitere Gründe für AMD-Karten, allen voran Linux. Nvidias neueste "Nummer" (ich meine die Pseudo-Öffnung der Treiber, um Jahre zu spät) ist ja nur Fassade.

Das gilt auch für den ganzen proprietären Kram von Nvidia. Dabei weiß man eigentlich: sobald irgendjemand (z. B. AMD, Intel, ...) eine Open Source-Lösung bringt, die überall läuft, ist Nvidias proprietärer Kack ganz schnell wieder tot, siehe Gsync. Oder nehmen wir FSR. Wenn ich damit alle Karten erreichen kann, weshalb sollte ich noch DLSS einbauen? Bleibt die Frage: Warum wird das vorher so gehypt? Können manche Schreiber nicht so weit denken?

Es hat ja auch seinen Grund: weil das Team bei AMD kleiner ist, sind die Karten zum Launch noch nicht so ausoptimiert wie bei Nvidia. Aber schlechter werden sie nicht mehr, sondern besser. Das plane ich mit ein, auch wenn es nicht der einzige Kaufgrund sein sollte. Auch ich habe weitere Gründe für AMD-Karten, allen voran Linux. Nvidias neueste "Nummer" (ich meine die Pseudo-Öffnung der Treiber, um Jahre zu spät) ist ja nur Fassade.

Ja, leider, und sie tun so, als würde sich das nie mehr ändern.Das die Tech Presse das macht, glaube ich nicht (Erfahrung). Es wird dann gesagt, dass Nvidia ab beginn die volle Leistung bringt.

Die Gründe dafür interesieren dort auch niemanden.

Das gilt auch für den ganzen proprietären Kram von Nvidia. Dabei weiß man eigentlich: sobald irgendjemand (z. B. AMD, Intel, ...) eine Open Source-Lösung bringt, die überall läuft, ist Nvidias proprietärer Kack ganz schnell wieder tot, siehe Gsync. Oder nehmen wir FSR. Wenn ich damit alle Karten erreichen kann, weshalb sollte ich noch DLSS einbauen? Bleibt die Frage: Warum wird das vorher so gehypt? Können manche Schreiber nicht so weit denken?

Man hat wohl durch Beobachtung festgestellt, dass die CPU-Kerne besser ausgelastet werden, also eine allgemeine Verbesserung.Aus der Beschreibung ist mir nicht klar, ob es eine allegemeine Verbesserung gibt (für alle DX11 Spiele) oder die Handbremse nur einige wenigen Spielen gelöst wurden?

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Da hat Nvidia mit Ihrer Marketingabteilung einfach auch immer eine gute Informationspolitik an die Multiplikatoren. Die Infos sind zwar nie ganz vollständig und lassen Schwächen aus, doch viele übernehmen diese unkritisch und publizieren.Das gilt auch für den ganzen proprietären Kram von Nvidia. Dabei weiß man eigentlich: sobald irgendjemand (z. B. AMD, Intel, ...) eine Open Source-Lösung bringt, die überall läuft, ist Nvidias proprietärer Kack ganz schnell wieder tot, siehe Gsync. Oder nehmen wir FSR. Wenn ich damit alle Karten erreichen kann, weshalb sollte ich noch DLSS einbauen? Bleibt die Frage: Warum wird das vorher so gehypt? Können manche Schreiber nicht so weit denken?

Man schaue sich nur mal an, welche Art der Berichterstattung rund um AMDs SAM-Feature ablief. Man konnte den Eindruck bekommen man ging nur vom schlechtesten für den Anwender aus. Das war zum Teil wirklich abstrus und man konnte erkennen, dass kaum eine Redaktion Kenntnisse hat wie die Abläufe und Zuständigkeiten für Rollouts bei Opensource gelagert sind, im Gegensatz zu Nvidias proprietären Features.

Ähnliche Themen

- Antworten

- 728

- Aufrufe

- 50K

- Antworten

- 2K

- Aufrufe

- 132K

- Antworten

- 94

- Aufrufe

- 8K