App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD RDNA2 / Navi-2 und "Bignavi"

- Ersteller BavarianRealist

- Erstellt am

BavarianRealist

Grand Admiral Special

- Mitglied seit

- 06.02.2010

- Beiträge

- 3.358

- Renomée

- 80

Wieso sollte AMD seine RX6800(XT) für 579/649 verkaufen, wenn es wohl auch für 650/800 geht, weil es von Nvidia sowieso nichts gibt? Auch bei der 3070 sieht es anscheinend mehr als sparsam aus und auf digitimes heißt es:

Wie viel Spaß die AIB an Nvidias Ampere haben? Wieso sollen sie dann nicht die AMD-Navi mit ordentlich Gewinn verkaufen, wenn es zudem ohne Probleme möglich sein dürfte?

Wie viel Spaß die AIB an Nvidias Ampere haben? Wieso sollen sie dann nicht die AMD-Navi mit ordentlich Gewinn verkaufen, wenn es zudem ohne Probleme möglich sein dürfte?

E555user

Admiral Special

- Mitglied seit

- 05.10.2015

- Beiträge

- 1.551

- Renomée

- 593

OffTopic:

Natürlich können die mit Kühldesigns für eine RTX3090 auch versuchen eine 6900XT bei 350W Designs für das Prestige stark übertaktet anzubieten. Wann die OEMs überhaupt solche Chips verbauen dürfen bleibt abzuwarten.

Ich wollte mit dem Preis-Leistungs Hinweis nur auf die technische Frage dahinter aufmerksam machen.

OnTopic TechTalk:

Bei Preisen und SKUs der CPUs ist der mögliche Takt im Vordergrund. Der niedrigere Takt bei der 6800 würde von meiner Seite auch dem Binning geschuldet sein. Wenn dann der Preisunterschied so gering zur XT ist will man vielleicht dort die Nachfrage niedrig halten. Aber ich denke vor allem ist es im Basis und Game-Takt ein Sweet-Spot für die Chips. Bei den XT Modellen hat man die Takte im exponetiellen Anstieg des Leistungsbedarfs an der 300W Grenze festgemacht. Sowohl für Boarddesign und Kühlung, als auch als Marketingargument. Bei CPUs entspricht das den X Varianten.

Wie schon in meinem letzten Post geschrieben ist der Preis einer 6900XT vs. 6800XT nur vertretbar wenn die Chipgüte absolute Spitze ist und Seltenheitswert hat. Zumindest scheint bei exakt gleichem PowerBudget trotz der 11% mehr CUs der Chip pro CU wesentlich genügsamer zu sein.

Würden wir grob annehmen die 6800 und 6800XT gebinnt nach funktionierenden CUs hätten die gleiche Chipgüte bei Takt, der Verbrauch für eine CU wäre je GHz linear bei ca. 1,4W. Der Rest des Chips und des Boards dann bei 100W. Bei dem XTX Chip für die 9800XT wären da nur ca. 1,2W je CU je GHz übrig. Da der Verbrauch bei GHz aber nicht linear sondern exponentiell ansteigt ist das eine grobe Vereinfachung. Die Richtng stimmt zumindest.

Es wird sicherlich einzelne GPUs der günstige Modelle geben, die sich bei höherem PowerBudget und besserer Kühlung besser Übertakten lassen, der Cache löst das Speicherproblem und mit dem Takt sollten gute Ergebnisse erreichbar sein. Ich vermute aber starkt, dass es im Binning eben nicht nur um funktionierende CUs auf den grossen Dies geht sondern mindestens genauso sehr um Leckströme und Qualität wie wir es bei CPUs bereits kennen. Das deaktivieren von einzelnen CUs hängt bei 60 aus 80 hauptsächlich von der individuellen Leakage ab, vermute ich.

Natürlich können die mit Kühldesigns für eine RTX3090 auch versuchen eine 6900XT bei 350W Designs für das Prestige stark übertaktet anzubieten. Wann die OEMs überhaupt solche Chips verbauen dürfen bleibt abzuwarten.

Ich wollte mit dem Preis-Leistungs Hinweis nur auf die technische Frage dahinter aufmerksam machen.

OnTopic TechTalk:

Bei Preisen und SKUs der CPUs ist der mögliche Takt im Vordergrund. Der niedrigere Takt bei der 6800 würde von meiner Seite auch dem Binning geschuldet sein. Wenn dann der Preisunterschied so gering zur XT ist will man vielleicht dort die Nachfrage niedrig halten. Aber ich denke vor allem ist es im Basis und Game-Takt ein Sweet-Spot für die Chips. Bei den XT Modellen hat man die Takte im exponetiellen Anstieg des Leistungsbedarfs an der 300W Grenze festgemacht. Sowohl für Boarddesign und Kühlung, als auch als Marketingargument. Bei CPUs entspricht das den X Varianten.

Wie schon in meinem letzten Post geschrieben ist der Preis einer 6900XT vs. 6800XT nur vertretbar wenn die Chipgüte absolute Spitze ist und Seltenheitswert hat. Zumindest scheint bei exakt gleichem PowerBudget trotz der 11% mehr CUs der Chip pro CU wesentlich genügsamer zu sein.

Würden wir grob annehmen die 6800 und 6800XT gebinnt nach funktionierenden CUs hätten die gleiche Chipgüte bei Takt, der Verbrauch für eine CU wäre je GHz linear bei ca. 1,4W. Der Rest des Chips und des Boards dann bei 100W. Bei dem XTX Chip für die 9800XT wären da nur ca. 1,2W je CU je GHz übrig. Da der Verbrauch bei GHz aber nicht linear sondern exponentiell ansteigt ist das eine grobe Vereinfachung. Die Richtng stimmt zumindest.

Es wird sicherlich einzelne GPUs der günstige Modelle geben, die sich bei höherem PowerBudget und besserer Kühlung besser Übertakten lassen, der Cache löst das Speicherproblem und mit dem Takt sollten gute Ergebnisse erreichbar sein. Ich vermute aber starkt, dass es im Binning eben nicht nur um funktionierende CUs auf den grossen Dies geht sondern mindestens genauso sehr um Leckströme und Qualität wie wir es bei CPUs bereits kennen. Das deaktivieren von einzelnen CUs hängt bei 60 aus 80 hauptsächlich von der individuellen Leakage ab, vermute ich.

E555user

Admiral Special

- Mitglied seit

- 05.10.2015

- Beiträge

- 1.551

- Renomée

- 593

Überraschende Einschätzung von Youtuber MLID:

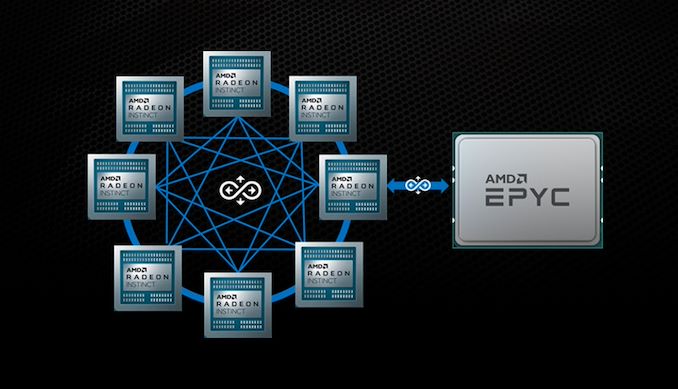

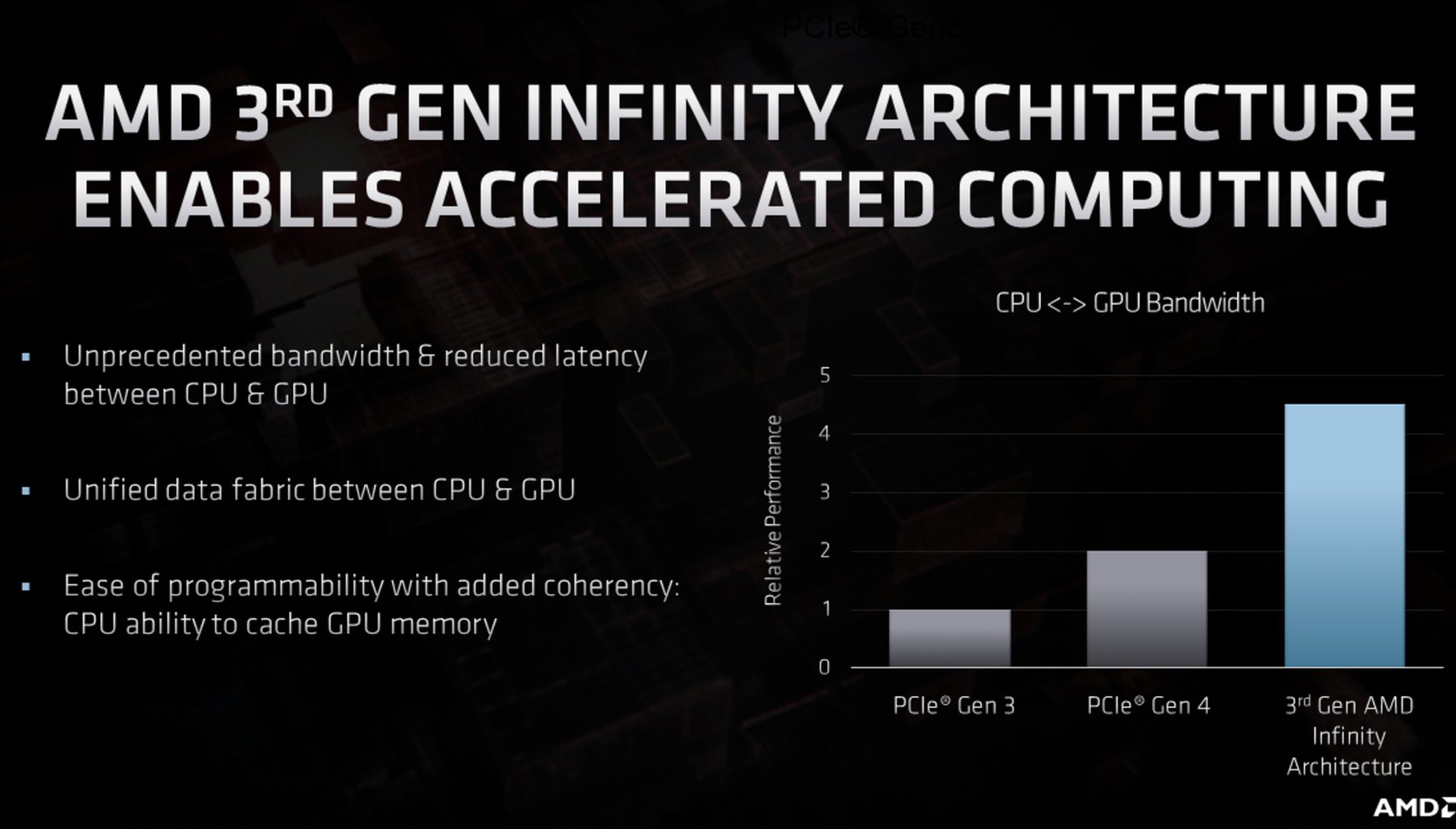

Smart Access Memory - Sharing Information between Caches of GPU and CPU - Sony Co-Developed

Ich dachte solche Konzepte würden unter Infinity Cache laufen, aber SAM als IF basierte Kohärenz auch bei Caches könnte einer Erklärung sein für die Notwendigkeit modernster Varianten bei CPU, Chipset und GPU. Wobei die GPU idR direkt am CPU PCIe angebunden ist.

Smart Access Memory - Sharing Information between Caches of GPU and CPU - Sony Co-Developed

Ich dachte solche Konzepte würden unter Infinity Cache laufen, aber SAM als IF basierte Kohärenz auch bei Caches könnte einer Erklärung sein für die Notwendigkeit modernster Varianten bei CPU, Chipset und GPU. Wobei die GPU idR direkt am CPU PCIe angebunden ist.

bschicht86

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 14.12.2006

- Beiträge

- 4.249

- Renomée

- 228

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- 2950X

- Mainboard

- X399 Taichi

- Kühlung

- Heatkiller IV Pure Chopper

- Speicher

- 64GB 3466 CL16

- Grafikprozessor

- 2x Vega 64 @Heatkiller

- Display

- Asus VG248QE

- SSD

- PM981, SM951, ein paar MX500 (~5,3TB)

- HDD

- -

- Optisches Laufwerk

- 1x BH16NS55 mit UHD-BD-Mod

- Soundkarte

- Audigy X-Fi Titanium Fatal1ty Pro

- Gehäuse

- Chieftec

- Netzteil

- Antec HCP-850 Platinum

- Betriebssystem

- Win7 x64, Win10 x64

- Webbrowser

- Firefox

- Verschiedenes

- LS120 mit umgebastelten USB -> IDE (Format wie die gängigen SATA -> IDE)

Wenn dem so ist, wäre ja mal interessant, ob die Grafikkarten bei Threadripper "5000" mit ihren schier "unendlichen" L3-Cache nochmals etwas mehr zulegen wie gegenüber Ryzen 5000.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ähm, das hatte die PS4 als hUMA schon verbaut und AMD hat das mit HSA definiert. APUs machen das ja schon lange und das ist die angekündigte Erweiterung auf dGPUs über IF (Infitnity Architecture). Stichwort FCL und RMB (Onion+Garlic bei Llano)Überraschende Einschätzung von Youtuber MLID:

Smart Access Memory - Sharing Information between Caches of GPU and CPU - Sony Co-Developed

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.368

- Renomée

- 9.694

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Wenn dem so ist, wäre ja mal interessant, ob die Grafikkarten bei Threadripper "5000" mit ihren schier "unendlichen" L3-Cache nochmals etwas mehr zulegen wie gegenüber Ryzen 5000.

Aber die CPU greift ja nur auf den Cache der GPU zu und nicht umgekehrt.

E555user

Admiral Special

- Mitglied seit

- 05.10.2015

- Beiträge

- 1.551

- Renomée

- 593

Bei 1:09:30 geht ehr auf seine Spekulation mehr ein. Wegen der Die Grössen und was er so gehört hat vermutet er bei Xbox Series X grössere Caches bei CPU und GPU Teil aber nicht kohärent und bei PS5 unified hybrid Cache, aber kleiner.

Tatsächlich war der CPU-Cache in APUs noch nie für den GPU-Part erreichbar. Die HSA Architektur erlaubte das Übergeben von Pointern, der Speicher war aber getrennt verwaltet (tatsächlich würde das aber bei 64bit schon lange Sinn machen). Es mussten aber keine Copies gemacht werden vom Hauptspeicher in den dGPU Speicher. Allerdings ist der Copy-Prozess üblicher Weise in der Game-Software bereits festgelegt. Ein APU-Treiber muss da schon explizit die Pointer Copy ersetzen wo möglich, besser der Game-Code berücksichtigt iGPU. Dann darf der Code aber auch nicht mehr auf den unterschiedlichen Images der Speicherobjekte schreiben wollen. Bei APU ging das bislang nicht auf, mittels Konsole gibt es da schon mehr Möglichkeiten.

Tatsächlich war der CPU-Cache in APUs noch nie für den GPU-Part erreichbar. Die HSA Architektur erlaubte das Übergeben von Pointern, der Speicher war aber getrennt verwaltet (tatsächlich würde das aber bei 64bit schon lange Sinn machen). Es mussten aber keine Copies gemacht werden vom Hauptspeicher in den dGPU Speicher. Allerdings ist der Copy-Prozess üblicher Weise in der Game-Software bereits festgelegt. Ein APU-Treiber muss da schon explizit die Pointer Copy ersetzen wo möglich, besser der Game-Code berücksichtigt iGPU. Dann darf der Code aber auch nicht mehr auf den unterschiedlichen Images der Speicherobjekte schreiben wollen. Bei APU ging das bislang nicht auf, mittels Konsole gibt es da schon mehr Möglichkeiten.

E555user

Admiral Special

- Mitglied seit

- 05.10.2015

- Beiträge

- 1.551

- Renomée

- 593

Ich denke auch AMD könnte wegend der echten SoC Architektur mit direkter Anbidung von GPU via PCIe viel mehr möglich machen, als man bisher bereit war anzubieten. Aber bestimmte Dinge werden nunmal für das Upselling vorbehalten, das war schon bei StoreMI so. Muss man akzeptieren.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.715

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Nehm' wa ma' an, ma wolle a jaaaaaannz groooobe Röchnung der Pörformenz anstelle für die neue Navi-Kaade, die da komme solle.

Wie würdet ihr das machen?

Performance der 6800 / Anzahl CUs der 6800 * Anzahl CUs der 6700?

Oder den Takt noch mit einbeziehen? Immerhin steigt die Performance / CU mit den kleineren Modellen an, obwohl die 6800 weniger Takt hat als die großen Schwestern. Als Ausgangswert würde ich einen Index für die 6900XT / 6800 XT / 6800 verwenden.

Wie würdet ihr das machen?

Performance der 6800 / Anzahl CUs der 6800 * Anzahl CUs der 6700?

Oder den Takt noch mit einbeziehen? Immerhin steigt die Performance / CU mit den kleineren Modellen an, obwohl die 6800 weniger Takt hat als die großen Schwestern. Als Ausgangswert würde ich einen Index für die 6900XT / 6800 XT / 6800 verwenden.

Zuletzt bearbeitet:

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.715

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Nanu, hat euch meine flappsige Formulierung verwirrt, oder stellt Ihr Euch diese Frage nicht?

Mir geht's halt darum, eine grobe Einschätzung zur Performance der kommenden Radeon-Karten zu haben, wo man nur die Anzahl CUs kennt.

Mir geht's halt darum, eine grobe Einschätzung zur Performance der kommenden Radeon-Karten zu haben, wo man nur die Anzahl CUs kennt.

Zuletzt bearbeitet:

Captn-Future

Moderation DC, P3DN Vize-Kommandant

- Mitglied seit

- 16.08.2004

- Beiträge

- 8.430

- Renomée

- 313

- Standort

- VIP Lounge

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- QMC, Simap

- Lieblingsprojekt

- QMC

- Meine Systeme

- X4 940 BE

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E3-1230v2

- Mainboard

- GA-Z77-UD3

- Kühlung

- Thermalright Macho Rev. A

- Speicher

- 16 GB Kingston blue

- Grafikprozessor

- Gigabyte GTX 660

- Display

- HP ZR2440w 1920x1200

- SSD

- Samsung SSD 830 256 GB

- HDD

- WD Blue 1 TB

- Optisches Laufwerk

- LG GSA-H10N

- Gehäuse

- LianLi V1000 Silber

- Netzteil

- Cougar SE400

- Betriebssystem

- Windows 7

- Webbrowser

- FireFox

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.368

- Renomée

- 9.694

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Dazu hat doch Igor was geschrieben. Der Artikel war nicht schlecht. Ob es tatsächlich so kommt?

Lassen wir uns überraschen. Für den Preis und den Verbrauch wird die 6700 eh nichts für mich.

Irgendwas zwischen 150 und 200 Euro. Mindestens 3 Ausgänge und vor allem ein vernünftiger Verbrauch im Idle, sowie im Multi-Monitor-Betrieb.

Bin mal gespannt, ob man sowas von AMD dieses Jahr bekommen wird.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.715

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Erstmal danke für den interessanten Artikel.

Ich meinte es zwar etwas allgemeiner (auch auf die Radeon 6600, 6500 bezogen), aber mit den Werten aus dem Artikel gehe ich jetzt davon aus, dass man die Performance-Klasse durchaus nur anhand der CUs abschätzen kann. Die Performance pro CU steigt bei den kleineren Modellen eher etwas.

Demnach würde die 6700 XT um 4 % über der Radeon 7 liegen, und die 6700 auf dem Niveau der 5700.

Ich meinte es zwar etwas allgemeiner (auch auf die Radeon 6600, 6500 bezogen), aber mit den Werten aus dem Artikel gehe ich jetzt davon aus, dass man die Performance-Klasse durchaus nur anhand der CUs abschätzen kann. Die Performance pro CU steigt bei den kleineren Modellen eher etwas.

Demnach würde die 6700 XT um 4 % über der Radeon 7 liegen, und die 6700 auf dem Niveau der 5700.

Zuletzt bearbeitet:

Berniyh

Grand Admiral Special

- Mitglied seit

- 29.11.2005

- Beiträge

- 5.206

- Renomée

- 218

Ich denke das kannst du vergessen.Dazu hat doch Igor was geschrieben. Der Artikel war nicht schlecht. Ob es tatsächlich so kommt?

Lassen wir uns überraschen. Für den Preis und den Verbrauch wird die 6700 eh nichts für mich.

Irgendwas zwischen 150 und 200 Euro. Mindestens 3 Ausgänge und vor allem ein vernünftiger Verbrauch im Idle, sowie im Multi-Monitor-Betrieb.

Bin mal gespannt, ob man sowas von AMD dieses Jahr bekommen wird.

Wenn man sich mal anschaut, dass derzeit noch nicht mal die 5500 XT für unter 200 € zu bekommen ist und zudem viele Modelle auch nur wenige Anbieter haben:

Grafikkarten PCIe mit AMD Radeon: 10 0005196 - RX 5500 XT Preisvergleich Geizhals Deutschland

Preisvergleich und Bewertungen für Grafikkarten PCIe mit AMD Radeon: 10 0005196 - RX 5500 XT

Für die 8GB Variante legt man schon 250 € auf den Tisch. Und da reden wir von Karten die zu diesem (bzw. glaube ich sogar etwas geringerem) Preis schon bei der Vorstellung vor über einem Jahr als überteuert angesehen wurden …

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.715

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Die Situation vor einem Jahr spielt doch für heute keine Rolle mehr, wenn du dir den Markt anguckst. In der jetzigen (Corona-)Phase ist alles ausverkauft.

Wenn man auf 200 € aus ist, kommt wohl die 6600 oder 6500XT in Frage.

Wenn man auf 200 € aus ist, kommt wohl die 6600 oder 6500XT in Frage.

Captn-Future

Moderation DC, P3DN Vize-Kommandant

- Mitglied seit

- 16.08.2004

- Beiträge

- 8.430

- Renomée

- 313

- Standort

- VIP Lounge

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- QMC, Simap

- Lieblingsprojekt

- QMC

- Meine Systeme

- X4 940 BE

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E3-1230v2

- Mainboard

- GA-Z77-UD3

- Kühlung

- Thermalright Macho Rev. A

- Speicher

- 16 GB Kingston blue

- Grafikprozessor

- Gigabyte GTX 660

- Display

- HP ZR2440w 1920x1200

- SSD

- Samsung SSD 830 256 GB

- HDD

- WD Blue 1 TB

- Optisches Laufwerk

- LG GSA-H10N

- Gehäuse

- LianLi V1000 Silber

- Netzteil

- Cougar SE400

- Betriebssystem

- Windows 7

- Webbrowser

- FireFox

Die derzeitige Marktsituation stellt sich eigentlich wie folgt dar:

Aktuelle (Top)Modelle sind kaum zu bekommen bzw. deutlich über der UVP zu kaufen

Alte Topmodelle sollten eigentlich im Abverkauf günstiger sein, steigen aber sogar noch im Preis wegen der Knappheit der neuen Modelle/Chips

Neue Mittelklassekarten werden noch nicht verkauft, da sie noch gar nicht vorgestellt wurden (AMD) oder schlicht nicht verfügbar sind (nvidia)

Alte Mittelklassekarten gibt es zwar gut zu kaufen, die Preise sind aber deutlich höher als noch Anfang letzten Jahres wegen der allgemeinen Knappheit der Produkte.

Also wie man es dreht und wendet: Entweder abwarten und hoffen, eine Karte kaufen die preiswerter ist oder einen Haufen Geld auf den Tisch legen um das zu kaufen was man braucht zu einem Preis der wirklich weh tut.

Aktuelle (Top)Modelle sind kaum zu bekommen bzw. deutlich über der UVP zu kaufen

Alte Topmodelle sollten eigentlich im Abverkauf günstiger sein, steigen aber sogar noch im Preis wegen der Knappheit der neuen Modelle/Chips

Neue Mittelklassekarten werden noch nicht verkauft, da sie noch gar nicht vorgestellt wurden (AMD) oder schlicht nicht verfügbar sind (nvidia)

Alte Mittelklassekarten gibt es zwar gut zu kaufen, die Preise sind aber deutlich höher als noch Anfang letzten Jahres wegen der allgemeinen Knappheit der Produkte.

Also wie man es dreht und wendet: Entweder abwarten und hoffen, eine Karte kaufen die preiswerter ist oder einen Haufen Geld auf den Tisch legen um das zu kaufen was man braucht zu einem Preis der wirklich weh tut.

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.271

- Renomée

- 450

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2: 2x Samsung 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win10Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

Derzeit kauft wohl nur der welche es entweder muss aus den verschiedensten Gründen oder es sich leisten will/kann auch wenn der Preis sehr überhöht ist.

Gebrauchte Radeon VII für =/>700 EUR in der Bucht spricht Bände

Gebrauchte Radeon VII für =/>700 EUR in der Bucht spricht Bände

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.368

- Renomée

- 9.694

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Derzeit kauft wohl nur der welche es entweder muss aus den verschiedensten Gründen oder es sich leisten will/kann auch wenn der Preis sehr überhöht ist.

Gebrauchte Radeon VII für =/>700 EUR in der Bucht spricht Bände

Selbst die R9 390 marschiert wieder Richtung 130 in der Bucht. Letztes Jahr ging die für unter 100 weg.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.326

- Renomée

- 1.972

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Man merkt eben das sich Mining per GPU langsam wieder rentiert.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Meine RX 5700 Pulse von Sapphire ist ab 640,- € bei geizhals gelistet.

In der Bucht liegen alle 5700 Modelle über meinem EK von 379,- € im Juli 2019....Bei mir kommen auch keine neueren Modelle zum Aufrüsten in Frage bei den Preisen der neuen Generation. Denke die wird mir noch eine ganze Weile gute Dienste leisten

In der Bucht liegen alle 5700 Modelle über meinem EK von 379,- € im Juli 2019....Bei mir kommen auch keine neueren Modelle zum Aufrüsten in Frage bei den Preisen der neuen Generation. Denke die wird mir noch eine ganze Weile gute Dienste leisten

Berniyh

Grand Admiral Special

- Mitglied seit

- 29.11.2005

- Beiträge

- 5.206

- Renomée

- 218

Ja, das ist mir schon klar. Wollte nur darauf hinweisen wie absurd das ist.Die Situation vor einem Jahr spielt doch für heute keine Rolle mehr, wenn du dir den Markt anguckst. In der jetzigen (Corona-)Phase ist alles ausverkauft.

Wenn man auf 200 € aus ist, kommt wohl die 6600 oder 6500XT in Frage.

Ich bräuchte für meinen neuen Desktop PC eigentlich auch eine GPU, aber ich zahle keine 200-250€ für eine 5500 XT und eine Polaris will ich auch nicht mehr haben in 2021.

Zum Glück hab ich noch eine alte 280X rumliegen, die muss dann halt herhalten bis dann irgendwas in Richtung 6500 (XT) zu vernünftigen Preisen verfügbar ist.

(Will auch die Option für AV1 Decoding haben, daher bevorzugt Navi 2x.)

BavarianRealist

Grand Admiral Special

- Mitglied seit

- 06.02.2010

- Beiträge

- 3.358

- Renomée

- 80

Eine 6700 mit 12GB Ram und einem 335sqmm-Die in 7nm wird es unter 500€ kaum geben. Müsste sie billiger sein, wird es sie vermutlich mehr oder minder gar nicht geben, weil es sich einfach nicht lohnt, GDDR6 und 7nm-Wafer sind dafür aktuelle schlichtweg viel zu teuer.

Und wenn eine 6700 kaum über 3060- bzw. 5700-Niveau kommt, könnte sie AMD ganz getrost vergessen. Braucht kein Mensch, AMD auch nicht, weil es aktuell ungleich besser Verwendung der 7nm-Wafer gibt. Entweder die 6700XT wird viel mehr können, oder sie könnte zu einer Luftnummer werden, die AMD aktuell aber kaum weh täte.

Könnte dann Sinn ergeben, dass AMD die 6700-Graka erst mal gar nicht gelauncht hat. Und laut pcgameshardware würden Grakas laut Lisa Su noch im gesamten H1/2021 knapp bleiben. Es könnte dann so enden, dass es Navi22 erst gar nicht mehr in Serie schafft und man für H2/2021 dann ganz was neues präsentiert. Wie schon von mir vermutet: AMD muss die 7nm-Wafer klug verteilen und könnte daher einige der geplanten Produkte canceln: so z.B. Van-Gogh und Navi22....

Und wenn eine 6700 kaum über 3060- bzw. 5700-Niveau kommt, könnte sie AMD ganz getrost vergessen. Braucht kein Mensch, AMD auch nicht, weil es aktuell ungleich besser Verwendung der 7nm-Wafer gibt. Entweder die 6700XT wird viel mehr können, oder sie könnte zu einer Luftnummer werden, die AMD aktuell aber kaum weh täte.

Könnte dann Sinn ergeben, dass AMD die 6700-Graka erst mal gar nicht gelauncht hat. Und laut pcgameshardware würden Grakas laut Lisa Su noch im gesamten H1/2021 knapp bleiben. Es könnte dann so enden, dass es Navi22 erst gar nicht mehr in Serie schafft und man für H2/2021 dann ganz was neues präsentiert. Wie schon von mir vermutet: AMD muss die 7nm-Wafer klug verteilen und könnte daher einige der geplanten Produkte canceln: so z.B. Van-Gogh und Navi22....

Zuletzt bearbeitet:

E555user

Admiral Special

- Mitglied seit

- 05.10.2015

- Beiträge

- 1.551

- Renomée

- 593

Tom von MLID will gehört haben dass die geplante Vorstellung der Radeon 6700 zur CES zurückbehalten wurde und die Präsentation auch deshalb so uninteressant blieb.

Allgemein ist denkbar dass durch höhere Stückzahlen für Konsolen und margenträchtige GPUs die Mittelklasse verschoben wurde. Allerdings ist die Rechnung von möglicher Marge je Wafer bei unterschiedlichen GPUs auch eher kompliziert. Man verliert auch potenzielle Marge im Midrange wegen höheren möglichen Stückzahlen beim Speicher und anderen Komponenten, sofern die entsprechend verfügbar wären.

Allgemein bleibt aber jegliche Aussage von AMD und anderen 7nm Kunden, dass die Fertigung nicht das Problem sei. Das spricht dann eher für Verschiebungen für einige Wochen weil der Bedarf unterschätzt wurde.

Weil das Design fertig ist wird man auch Produkte sehen. Ich denke alles andere verschiebt sich nach hinten solange die Konkurrenz nicht zur Eile zwingt und das Design unverkäuflich wird. Eventuell werden Polaris nochmal bei GloFo nachbestellt um den Einsteigermarkt zu bedienen. Navi sollte wegen der Marge aber nur noch als RDNA2 in Produktion kommen. Radeon 5000 wurde so teuer dass der Bestand bis zum Launch der 6000er genügend wäre, höhere Nachfrage zieht die Preise zusätzlich im Retail nach oben.

Allgemein ist denkbar dass durch höhere Stückzahlen für Konsolen und margenträchtige GPUs die Mittelklasse verschoben wurde. Allerdings ist die Rechnung von möglicher Marge je Wafer bei unterschiedlichen GPUs auch eher kompliziert. Man verliert auch potenzielle Marge im Midrange wegen höheren möglichen Stückzahlen beim Speicher und anderen Komponenten, sofern die entsprechend verfügbar wären.

Allgemein bleibt aber jegliche Aussage von AMD und anderen 7nm Kunden, dass die Fertigung nicht das Problem sei. Das spricht dann eher für Verschiebungen für einige Wochen weil der Bedarf unterschätzt wurde.

Weil das Design fertig ist wird man auch Produkte sehen. Ich denke alles andere verschiebt sich nach hinten solange die Konkurrenz nicht zur Eile zwingt und das Design unverkäuflich wird. Eventuell werden Polaris nochmal bei GloFo nachbestellt um den Einsteigermarkt zu bedienen. Navi sollte wegen der Marge aber nur noch als RDNA2 in Produktion kommen. Radeon 5000 wurde so teuer dass der Bestand bis zum Launch der 6000er genügend wäre, höhere Nachfrage zieht die Preise zusätzlich im Retail nach oben.

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.368

- Renomée

- 9.694

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Tom von MLID will gehört haben dass die geplante Vorstellung der Radeon 6700 zur CES zurückbehalten wurde und die Präsentation auch deshalb so uninteressant blieb.

Allgemein ist denkbar dass durch höhere Stückzahlen für Konsolen und margenträchtige GPUs die Mittelklasse verschoben wurde. Allerdings ist die Rechnung von möglicher Marge je Wafer bei unterschiedlichen GPUs auch eher kompliziert. Man verliert auch potenzielle Marge im Midrange wegen höheren möglichen Stückzahlen beim Speicher und anderen Komponenten, sofern die entsprechend verfügbar wären.

Ich glaube auch, dass AMD gerade sich auf Grund der Rahmenbedingungen nicht hetzen lassen will. Was nützt es AMD denn in nen Volumenmarkt gerade einzusteigen, wenn dann die Händler auf jede Karte auch noch Summe X drauf hauen.

Bei Nvidia gibts ja Gerüchte, dass man die 2000er Karten teilweise wieder auflegen will.

An AMDs Stelle würde ich die Zeit auch nutzen, um bei Samsung die Fertigung zu testen. Die Zusammenarbeit scheint beim neuen Exynos ja bereits sehr eng gewesen zu sein und das sollte man zügig ausbauen, um eine Alternative zu haben. Auch wenn die Foundries gerade wohl eher nicht die limitierenden Faktoren sind (bzw. der Hauptfaktor).

Der Gebrauchtmarkt bei Grafikkarten eskaliert gerade auch weiter, aber kein Wunder, da man fast nichts kaufen kann.

Ähnliche Themen

- Antworten

- 728

- Aufrufe

- 50K

- Antworten

- 2K

- Aufrufe

- 132K

- Antworten

- 91

- Aufrufe

- 8K