App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD RX 6500 XT langsamer als gforce 1030 (beide 3.0 x4) . kann man runtertakten des VRAM der AMD verhindern ?

- Ersteller ballererian

- Erstellt am

- Status

- Für weitere Antworten geschlossen.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Hallo

Ist mir als erstes in far cry 6 trail aufgefallen. hab ne 4 GB RX 6500 XT. Sobald man 3840x2160 auflösung wählt ist es trotz neustart des games extrem langsam mit nur noch 2 fps. obwohl die gforce 1030 nur 2 gb RAM hat ist die mit 6-8 fps viel schneller bei der auflösung. Dachte erst meine Karte wäre kaputt aber es gibt auch im Internet ne liste wie schnell die rx65000 mit 4 gb und PCIe 3 x 4 ist. auch die gforce 1030 hat nur pci3 x 4 was für das RAM nicht bremst.wenn die AMD langsam wird sieht man im AMD logger dass das RAM nur sehr langsam noch läuft. Takt bleibt hoch. Bei half Life 2 mit der am januar 2023 erschienen Vulkan version(mit -gamepadui starten)merkt man wenn neue Wände mit anderen texturen auftauchen etwa 50 ms hänger. Hat die gforce 1030 nicht auch nicht bei 4k.

Vermutlich wenn texturen zu der Karte übertragen werden, taktet das VRAM der AMD runter und braucht dann sehr lange um wieder hochzutakten, daher gibt es die extremen slowdowns wenn das vram knapp ist.

GFX memory benchmark bestätigt noch meine Vermutung. denn beim 1. durchlauf write to GFX card ist die 1030 viel schneller. schafft 2.7 gigabyte. Die AMD nur 1.5 GB. Test mehrfach neue gestartet, bleibt gleich

2.7 GB müsste sie aber auch schaffen, denn dass macht auch das RAM beim 1. durchlauf. Hab ein i5 8600 und ein asus H310 board

Daher die frage. kann man irgendwie das GFX VRAM am runtertakten hindern ?. Bei der 6500 lässt sich im treiber die GPU clock min und max einstellen. beim VRAM geht das aber nicht. ich denke dann wird die karte viel schneller.

Das texturmanagement der AMD scheint auch sehr schlecht zu sein. Wenn ich z.b das doom demo von 2016 mit 1920x1080 laufen lasse ist es schnell. stell ich dann auf 4k Auflösung wird es auch extrem langsam. aber beenden und neustarten von doom läuft dann viel schneller. Man kann also nichteinmal die auflösung ändern ohne dass man starken Geschwindigkeitsverlust bekommt wenn man nicht das Spiel neu startet

Ist mir als erstes in far cry 6 trail aufgefallen. hab ne 4 GB RX 6500 XT. Sobald man 3840x2160 auflösung wählt ist es trotz neustart des games extrem langsam mit nur noch 2 fps. obwohl die gforce 1030 nur 2 gb RAM hat ist die mit 6-8 fps viel schneller bei der auflösung. Dachte erst meine Karte wäre kaputt aber es gibt auch im Internet ne liste wie schnell die rx65000 mit 4 gb und PCIe 3 x 4 ist. auch die gforce 1030 hat nur pci3 x 4 was für das RAM nicht bremst.wenn die AMD langsam wird sieht man im AMD logger dass das RAM nur sehr langsam noch läuft. Takt bleibt hoch. Bei half Life 2 mit der am januar 2023 erschienen Vulkan version(mit -gamepadui starten)merkt man wenn neue Wände mit anderen texturen auftauchen etwa 50 ms hänger. Hat die gforce 1030 nicht auch nicht bei 4k.

Vermutlich wenn texturen zu der Karte übertragen werden, taktet das VRAM der AMD runter und braucht dann sehr lange um wieder hochzutakten, daher gibt es die extremen slowdowns wenn das vram knapp ist.

GFX memory benchmark bestätigt noch meine Vermutung. denn beim 1. durchlauf write to GFX card ist die 1030 viel schneller. schafft 2.7 gigabyte. Die AMD nur 1.5 GB. Test mehrfach neue gestartet, bleibt gleich

2.7 GB müsste sie aber auch schaffen, denn dass macht auch das RAM beim 1. durchlauf. Hab ein i5 8600 und ein asus H310 board

Daher die frage. kann man irgendwie das GFX VRAM am runtertakten hindern ?. Bei der 6500 lässt sich im treiber die GPU clock min und max einstellen. beim VRAM geht das aber nicht. ich denke dann wird die karte viel schneller.

Das texturmanagement der AMD scheint auch sehr schlecht zu sein. Wenn ich z.b das doom demo von 2016 mit 1920x1080 laufen lasse ist es schnell. stell ich dann auf 4k Auflösung wird es auch extrem langsam. aber beenden und neustarten von doom läuft dann viel schneller. Man kann also nichteinmal die auflösung ändern ohne dass man starken Geschwindigkeitsverlust bekommt wenn man nicht das Spiel neu startet

Anhänge

Cappuandy

Grand Admiral Special

- Mitglied seit

- 30.01.2013

- Beiträge

- 3.636

- Renomée

- 168

- Standort

- Lübeck

- Mein Desktopsystem

- ROGi

- Mein Laptop

- MacBook Pro

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 7600X

- Mainboard

- Asus ROG X670E-I Gaming WiFi

- Kühlung

- BeQuiet DarkRockPro 4

- Speicher

- Gskill Trident-Z5 RGB Black 32Gb 6000CL30

- Grafikprozessor

- iGP

- Display

- LG 27" UHD60 HDR

- SSD

- 980 Pro & T500

- HDD

- - none -

- Optisches Laufwerk

- - none -

- Soundkarte

- ROG Hive - ALC4050

- Gehäuse

- Fractal Design Torrent Nano

- Netzteil

- BeQuiet SP12 1kW Platinum

- Tastatur

- Razer Cynosa

- Maus

- Razer Mamba

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox | Safari@iPhone

- Internetanbindung

- ▼schneller ▲schnell

Moin,

um welche Frage gehts genau? VRAM Hochtakten / 4K Gaming ?

und was genau ist dein Problem ?

Nvidia Fan oder das beide Grafikkarten NICHT für 4K geeignet sind?

Welche Grafikkarte ist es denn genau u welche Treiber ?

Verspäteter Aprilscherz

Edit:

Probier mal den CS Source Benchmark in 1920x1080

und Stell in deinem Profil deine System Daten rein.

um welche Frage gehts genau? VRAM Hochtakten / 4K Gaming ?

und was genau ist dein Problem ?

Nvidia Fan oder das beide Grafikkarten NICHT für 4K geeignet sind?

Welche Grafikkarte ist es denn genau u welche Treiber ?

Verspäteter Aprilscherz

Edit:

Probier mal den CS Source Benchmark in 1920x1080

und Stell in deinem Profil deine System Daten rein.

Mente

Grand Admiral Special

- Mitglied seit

- 23.05.2009

- Beiträge

- 3.671

- Renomée

- 135

- Aktuelle Projekte

- constalation astroids yoyo

- Lieblingsprojekt

- yoyo doking

- Meine Systeme

- Ryzen 3950x

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD 5800X3D

- Mainboard

- Asus ROG Crosshair VIII Dark Hero

- Kühlung

- Headkiller IV

- Speicher

- 3800CL14 G.Skill Trident Z silber/rot DIMM Kit 32GB, DDR4-3600, CL15-15-15-35 (F4-3600C15D-16GTZ)

- Grafikprozessor

- AMD Radeon RX 6900 XT Ref. @Alphacool

- Display

- MSI Optix MAG27CQ

- SSD

- SN8502TB,MX5001TB,Vector150 480gb,Vector 180 256gb,Sandisk extreme 240gb,RD400 512gb

- HDD

- n/a

- Optisches Laufwerk

- n/a

- Soundkarte

- Soundblaster X4

- Gehäuse

- Phanteks Enthoo Pro 2 Tempered Glass

- Netzteil

- Seasonic Prime GX-850 850W

- Tastatur

- Logitech G19

- Maus

- Logitech G703

- Betriebssystem

- Win 10 pro

- Webbrowser

- IE 11 Mozilla Opera

- Verschiedenes

- Logitech PRO RENNLENKRAD DD

Hallo,

ich verstehe etwas den Sinn nicht mit solchen Low end karten 4k selbst alte Spiele Spielen zu wollen.

du könntest zum Test ein Video im Hintergrund aufrufen oder 2Monitore mit mehr als 100Hz betreiben.

lg

ich verstehe etwas den Sinn nicht mit solchen Low end karten 4k selbst alte Spiele Spielen zu wollen.

du könntest zum Test ein Video im Hintergrund aufrufen oder 2Monitore mit mehr als 100Hz betreiben.

lg

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Moin,

um welche Frage gehts genau? VRAM Hochtakten / 4K Gaming ?

und was genau ist dein Problem ?

Nvidia Fan oder das beide Grafikkarten NICHT für 4K geeignet sind?

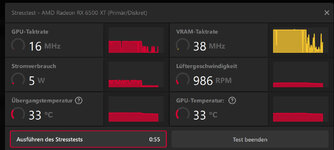

nvidia fan bin ich keiner, ob für 4k geeignet hängt vom spiel und den ansprüchen ab. 4k kein AA 20 fps find ich gut genug. habe IPS monitor da ist das bild besser aber verschwimmt stärker. Finde die schärfe und texturfilter der AMD besser hab ich selbst in youtube videos bemerkt. . Es geht um den grossen leistungsverlust bei der Karte wenn man von 1440p auf 2160p schaltet. daher hoffe ich das man da was machen kann software mässig. es gab schon beim AMD stresstest bei dem 23.2.1 nach etwa 40 sec probleme. bei dem neuesten treiber 23.4.1 geht das. sieh screenshot. so sah das beim vorigen treiber aus. Da es ne verbesserung durch treiber gab sieht nicht so aus als wäre die grake defekt. aber immer noch sporadisch downclock

links kann ich keine posten. Suche im internet Far Cry 6 im Test: Notebook und Desktop Benchmarks

da findest du werte von einer mobile

AMD Radeon RX 5600M, R7 4800H

Dell G5 15 SE wie im test steht 4 GB. da kommen die immerhin auf 16 fps. ich hab nur um die 2 fps während in 1440p

Welche Grafikkarte ist es denn genau u welche Treiber ?

Verspäteter Aprilscherz

Edit:

Probier mal den CS Source Benchmark in 1920x1080

hab kein CS und auf steam hab ich durch suche von benchmark kein CS Benchmark gefunden. den free 3d mark firestrike hab ich gemacht. da ist die rx 6500 über 4 mal schneller als die 1030. nur bei far cry 6 weswegen ich mir neue grako wollte ist langsamer und bei dem gfxmemtest

Anhänge

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Wozu? Die UHD Auflösung wird mit der Karte trotzdem unspielbar bleiben. 2 oder 16 fps - das ist doch nur eine theoretische Frage.Es geht um den grossen leistungsverlust bei der Karte wenn man von 1440p auf 2160p schaltet. daher hoffe ich das man da was machen kann software mässig.

Wenn es nur das eine Spiel betrifft, dann liegt es am Spiel. Entweder warten, bis der Hersteller des Spiels das patcht - oder wie üblich der GPU-Hersteller das für den Spielehersteller erledigt. Bis dahin nimm einfach eine Auflösung, die auch spielbar ist - also konstant mindestens 30fps.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Wozu? Die UHD Auflösung wird mit der Karte trotzdem unspielbar bleiben. 2 oder 6 fps - das ist doch nur eine theoretische Frage.Es geht um den grossen leistungsverlust bei der Karte wenn man von 1440p auf 2160p schaltet. daher hoffe ich das man da was machen kann software mässig.

dass ist doch nur 1 Spiel als worst case Beispiel. die karte soll ja ein paar jahre noch 70% der spiele gut in 4k spielen. Es geht auch um das rucken wenn neue texturen geladen werden sollen z.b bei half life 2. da nutzt grösserer texturspeicher nix braucht nur 1.5 gb. trotzdem wenn man vorwärts läuft immer gerade aus bei einer frisch geladenen szene merkt man wie es als kurz stehenbleibt. selbst wenn eine Karte in dem Spiel 5 fps macht und die andere 2 fps dann ist es doch logisch, dass dadurch mehr Spiele in UHD lauffähig sind. sind doch nicht alle spiele mit gleicher polygonzahl und Texturmasse. Ausserdem ist das Problem, dass beim Screenauflösung umschalten von UHD auf 1080p auch alles langsam ist. Man muss das game erst neu starten oder am besten den PC, scheinbar fragmentiert bei der amd der texturspeicher so stark. Auffallend ist schonmal dass mobil chips mit kleinem texturspeicher und UHD besser klarkommen. Natürlich das Problem kann man vumgehen wenn man sich eine RX mit 8 GB oder mehr RAM kauft, den Hersteller freuts den Anwender weniger, weil das viel teurer ist.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Das dürfte ja heute bereits nicht funktionieren.die karte soll ja ein paar jahre noch 70% der spiele gut in 4k spielen.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Das dürfte ja heute bereits nicht funktionieren.die karte soll ja ein paar jahre noch 70% der spiele gut in 4k spielen.

die grafikkarten hersteller erleben gerade einen massiven rückgang. Zeichen dass vielen die karten noch ausreichen oder sie warten bis es besseres gibt ... vielleicht eine AGPU. früher hatte man viel weniger texturspeicher und da ist die performance nicht gleich um den Faktor 3 eingebrochen nur weil das game 25% mehr VRAM gerne hätte. Da stellt sich vielleicht vielen die Frage. wenn das VRAM nun so extreme auswirkungen hat, dann besser einen PC mit AGPU. da kann man RAM aufrüsten. Ich brauch keine 120 fps . 20 fps reichen mir schon. bluring kann ich auch ausgeschaltet lassen, denn ich hab ja Bluring des IPS Monitors

. far cry hat auto aim. es geht darin nicht so um schnelles ballern. far cry 3 kann ich auch mit gforce 1030 mit über 20 fps in 4k spielen wenn AA aus ist und qualität mittel . kannst ja mal gforce 1030 4k videos suchen. da geht ne menge sogar über 50 fps. aber die meisten lassen noch AA an. bei AA aus wird es dann nochmal 30% schneller.

. far cry hat auto aim. es geht darin nicht so um schnelles ballern. far cry 3 kann ich auch mit gforce 1030 mit über 20 fps in 4k spielen wenn AA aus ist und qualität mittel . kannst ja mal gforce 1030 4k videos suchen. da geht ne menge sogar über 50 fps. aber die meisten lassen noch AA an. bei AA aus wird es dann nochmal 30% schneller.vinacis_vivids

Vice Admiral Special

- Mitglied seit

- 12.01.2004

- Beiträge

- 847

- Renomée

- 86

Wieso erhöhst du nicht Auflösung auf 8K?

4K, da sind beide Karten absolut unterfordert...

4K, da sind beide Karten absolut unterfordert...

enigmation

Admiral Special

Eben, der eine Frame pro Sekunde sieht per Downsampling von 8K auf den 4K-IPS-Monitor auch wesentlich schöner aus und man hat auch einfach mehr Zeit, diesen zu betrachten. Also win-win, oder?

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Die Karte ist leider extrem kastriert, in fast jeder Hinsicht. Früher wäre das eine Karte aus der 50€-Region gewesen - für Leute, denen eine APU zu wenig ist.Da stellt sich vielleicht vielen die Frage. wenn das VRAM nun so extreme auswirkungen hat, dann besser einen PC mit AGPU.

Die Leistung kommt fast nur aus dem extrem ausgereiztem GPU-Takt - weswegen dann auch 100W auf der Uhr stehen und nicht 50W, wie bei der RX6400, die ja den gleichen Chip hat. Selbst zum Aufrüsten für alte Rechner taugt die nicht, weil sie nur so wenige PCIe-Lanes hat. Denn in alten Rechnern ist ja oft nicht mal PCIe4 zu finden, also noch mal langsamere Anbindung. Mit so einer Karte ist 4K einfach absurd.

Zuletzt bearbeitet:

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.598

- Renomée

- 1.339

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Mit so einer Karte ist 4K einfach absurd.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das HL2 bei den Szenenwechseln kurz stehen bleibt ist normal und im Spiel selbst begründet. Da hat die Hardware selbst keinen nennenswerten Einfluss drauf aber wie steht es da um die Performance selbst?Es geht auch um das rucken wenn neue texturen geladen werden sollen z.b bei half life 2. da nutzt grösserer texturspeicher nix braucht nur 1.5 gb. trotzdem wenn man vorwärts läuft immer gerade aus bei einer frisch geladenen szene merkt man wie es als kurz stehenbleibt

Da HL2 selbst keinen Benchmark mitliefert bediene ich mich dafür beim Lost Coast Test und komme mit 4x FSAA und allem anderen auf max in UHD auf ca. 65 FPS......mit der IGP des Ryzen 7 5700G. Da sollte die 6500XT dann doch einen Zacken schneller sein. Da es aber noch ein DX 9 Spiel ist greifen dort auch die Einstellungen zur Anti-Aliasing Methode im Treiber und da muss man bei Performance Problemen dringen nachschauen was dort eingesetllt ist.

Bei "Multi-Sampling" und "Adaptives Multi-Sampling" habe ich dort z.B. die besagten ca. 65 FPS aber mit "Supersampling" sackt das Testergebnis auf 28 FPS ab.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Habe das Problem gefunden. Die Karte ist garnicht zu lahm, sondern es gibt irgendwo auf der Karte einen Temperatur Sensor der nirgends in den Anzeigen angezeigt wird. vermutlich hat das was mit dem RAM zu tun.

konnte die Lüfterdrehzahl fest einstellen auf 1900. von 2 fps max ging es dann hoch auf 32 fps für einge zeit. dann wurde wieder gedrosselt aber nur auf 11 fps. Das ist auch Fehler von AMD. Wenn schon Temperatur sensoren drin sind, dann sollte die software das auch anzeigen. asus schreibt zwar sie würden 144 std testen bei den dual, nur anscheinend merken die das dann auch nicht wenn die runtertaktet im Ram. Da auch andere tests so langsame speed bei 4k erreicht haben scheint das ein generelles Problem mit dem Sensor zu sein. Denn die GPU Temperatur war immer niedrig und der Lüfter drehte nicht sonderlich schnell und war sogar mit 800 umin nicht zu hören. Mein CPU lüfter dreht auch so um die 900 umdrehungen. da war alles sehr leise

3072x1728 ist zwar keine 4k auflösung aber nahe dran. das kommt schon hin was ich von der karte erwarte. nur wie bekommt man eine gute Karte

ich meine nicht das nachladen eines anderen abschnittes wo es dann etwa 4 sec steht. ich muss noch genauer testen. es scheint an der im amd treiber default eonstellung besseres texturformat einstellung zu liegen. half life macht auf gforce 1030 in 4k meistens über 140 fps. die 6500 kommt auf über 200. ich habe aber kein AA an. müsst ich testen was man durch das AA verliert. was wichtig für bessere bildqualität bei half life ist anisotropische texturfilterung. dadurch werden böden und seitewände viel schärfer und die aliasing effekte nehmen so stark ab, dass man meiner Meinung nach gar kein AA braucht. da hab ich 8 fach an bei HL 2

konnte die Lüfterdrehzahl fest einstellen auf 1900. von 2 fps max ging es dann hoch auf 32 fps für einge zeit. dann wurde wieder gedrosselt aber nur auf 11 fps. Das ist auch Fehler von AMD. Wenn schon Temperatur sensoren drin sind, dann sollte die software das auch anzeigen. asus schreibt zwar sie würden 144 std testen bei den dual, nur anscheinend merken die das dann auch nicht wenn die runtertaktet im Ram. Da auch andere tests so langsame speed bei 4k erreicht haben scheint das ein generelles Problem mit dem Sensor zu sein. Denn die GPU Temperatur war immer niedrig und der Lüfter drehte nicht sonderlich schnell und war sogar mit 800 umin nicht zu hören. Mein CPU lüfter dreht auch so um die 900 umdrehungen. da war alles sehr leise

3072x1728 ist zwar keine 4k auflösung aber nahe dran. das kommt schon hin was ich von der karte erwarte. nur wie bekommt man eine gute Karte

Das HL2 bei den Szenenwechseln kurz stehen bleibt ist normal und im Spiel selbst begründet. Da hat die Hardware selbst keinen nennenswerten Einfluss drauf aber wie steht es da um die Performance selbst?Es geht auch um das rucken wenn neue texturen geladen werden sollen z.b bei half life 2. da nutzt grösserer texturspeicher nix braucht nur 1.5 gb. trotzdem wenn man vorwärts läuft immer gerade aus bei einer frisch geladenen szene merkt man wie es als kurz stehenbleibt

ich meine nicht das nachladen eines anderen abschnittes wo es dann etwa 4 sec steht. ich muss noch genauer testen. es scheint an der im amd treiber default eonstellung besseres texturformat einstellung zu liegen. half life macht auf gforce 1030 in 4k meistens über 140 fps. die 6500 kommt auf über 200. ich habe aber kein AA an. müsst ich testen was man durch das AA verliert. was wichtig für bessere bildqualität bei half life ist anisotropische texturfilterung. dadurch werden böden und seitewände viel schärfer und die aliasing effekte nehmen so stark ab, dass man meiner Meinung nach gar kein AA braucht. da hab ich 8 fach an bei HL 2

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Bei deinen beiden Bildern fällt erstmal auf das der VRAM übervoll ist und bereits in den RAM ausgelagert wird, das ist genau das Szenario das der 6500XT wegen des schmalen PCIe Interface so garnicht liegt.

Wenn an sonsten ein Temperatursensor der Grafikkarte die Karte zum Drosseln zwingt ist das Sache des Kartenherstellers und nicht von AMD denn letztere haben die Karte nicht gebaut. Das wäre dann ein klassischer RMA Fall. Solange man aber nicht genau weiß was da drosselt ist aber eher müßig darüber zu spekulieren. Was sagt denn die Sensor Anzeige von Programmen wie hwinfo64 dazu?

Wenn du AA bei HL2 nutzt dann überprüfe bei einer sehr schlechten Performance aber auch noch die Einstellungen im Treiber. Ist da "Supersampling" eingestellt dann wird das vor allem bei 8 fach AA zum absoluten Performance Killer.

Wenn an sonsten ein Temperatursensor der Grafikkarte die Karte zum Drosseln zwingt ist das Sache des Kartenherstellers und nicht von AMD denn letztere haben die Karte nicht gebaut. Das wäre dann ein klassischer RMA Fall. Solange man aber nicht genau weiß was da drosselt ist aber eher müßig darüber zu spekulieren. Was sagt denn die Sensor Anzeige von Programmen wie hwinfo64 dazu?

Wenn du AA bei HL2 nutzt dann überprüfe bei einer sehr schlechten Performance aber auch noch die Einstellungen im Treiber. Ist da "Supersampling" eingestellt dann wird das vor allem bei 8 fach AA zum absoluten Performance Killer.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Bei deinen beiden Bildern fällt erstmal auf das der VRAM übervoll ist und bereits in den RAM ausgelagert wird, das ist genau das Szenario das der 6500XT wegen des schmalen PCIe Interface so garnicht liegt.

gerade dann dürfte die karte nicht drosseln wenn der lüfter langsam läuft denn die daten sind nur x4. Ich habe mal HL mit 2x aa probiert. mit aa die 247 und ohne aa so 285. Die FR gibt es dann auch im Spiel in den meisten Szenen. Erstaunlicherweise geht die temperatur der GPU ziemlich hoch, der lüfter dreht schnell, aber der RAM drosselt nicht. scheinbar wird da irgendwas heiss wenn viel zwischen PC ram und GPU RAM transferiert wird. an meinem board kanns nicht liegen denn die gforce 1030 hat damit keine probleme. Meine 1030 ist sogar passiv gekühlt. ist von asus. da geht auch gputweak 3. ram runtertakten kann die 1030 wenn ich recht erinner garnicht. von Rams zu Kühlkörper ist 1-2 mm luft. der Kühlkörper liegt nur am Chip auf.

schaue dir mal resultate von dem GFX RAM speed benchmarks. da hab ich lesen aus system ram zu schreiben auf GFX card. dass die RX 65000 beim 1 zugriff so lahm ist und lahmer als gforce 1030 liegt sicherlich nicht an dem PCIe3 X4 . gforce 1030 hat ja auch nur PCIe3 x4

GFX Memory Speed Benchmark 1.1.14.16 Win64 © 2015-2020 3delite -

AMD Radeon RX 6500 XT - Free texture memory: 4,00 GB

Allocated system memory: 512,00 MB

Running system RAM read test...

Read from system memory: 512,00 MB 93 ms (5505,38MB/s)

Read from system memory: 512,00 MB 33 ms (15515,2MB/s)

Read from system memory: 512,00 MB 33 ms (15515,2MB/s)

Read from system memory: 512,00 MB 33 ms (15515,2MB/s)

Read from system memory: 512,00 MB 33 ms (15515,2MB/s)

Freed system memory: 512,00 MB

Average system RAM read: 512,00 MB 45 ms (11377,8MB/s)

Peak system RAM read: 512,00 MB 33 ms (15515,2MB/s)

Free texture memory: 3,50 GB

Running GFX RAM write test...

Write to GFX memory: 512,00 MB 218 ms (2348,62MB/s)

Write to GFX memory: 512,00 MB 22 ms (23272,7MB/s)

Write to GFX memory: 512,00 MB 22 ms (23272,7MB/s)

Write to GFX memory: 512,00 MB 22 ms (23272,7MB/s)

Write to GFX memory: 512,00 MB 22 ms (23272,7MB/s)

Free texture memory: 4,00 GB

Average GFX RAM write: 512,00 MB 61 ms (8393,44MB/s)

Peak GFX RAM write: 512,00 MB 22 ms (23272,7MB/s)

mainboard ram schafft nichtmal PCI3 x4 .Ich habe ddr 4 3200 xmp an. andere mögen 20-30% schneller sein. daher was soll das bringen wenn auf die GFX karte noch schneller geschrieben wird als vom RAM gelesen wird.

Anhänge

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Die Karte muss aber zwingend drosseln wenn der Kühler auf dem VRAM oder dem Spannungswandler der Grafikkarte nicht richtig aufliegt denn sonst würde sie durchbrennen. Ich habe auch schon erlebt das die CPU erheblich gedrosselt wurde weil deren Spannungswandler überhitztegerade dann dürfte die karte nicht drosseln wenn der lüfter langsam läuft denn die daten sind nur x4

Würde die Karte allerdings so massiv im Speicherüberlauf hängen bleiben das die GPU unterfordert wird weil sie ewig auf die Daten warten muss dann kann es durchaus sein das eine Karte auch deshalb runtertaktet, einfach weil nicht mehr Rechenleistung genutzt werden kann.

Ohne das Probem einzugrenzen kommt man also kein Stück weiter weil es einfach zu viele Ursachen haben kann.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Die Karte muss aber zwingend drosseln wenn der Kühler auf dem VRAM oder dem Spannungswandler der Grafikkarte nicht richtig aufliegt denn sonst würde sie durchbrennen. Ich habe auch schon erlebt das die CPU erheblich gedrosselt wurde weil deren Spannungswandler überhitztegerade dann dürfte die karte nicht drosseln wenn der lüfter langsam läuft denn die daten sind nur x4

Würde die Karte allerdings so massiv im Speicherüberlauf hängen bleiben das die GPU unterfordert wird weil sie ewig auf die Daten warten muss dann kann es durchaus sein das eine Karte auch deshalb runtertaktet, einfach weil nicht mehr Rechenleistung genutzt werden kann.

das dachte ich auch, bis ich merkte dass durch höhere Lüfterdrehzahl obwohl temperatur sehr niedrig weniger drosselung gibt. Von daher scheidet die Theorie der zu langsamen Übertragung aus. ich werde morgen mal meinen PCIe bus auf gen 2 runterschalten. dann wirds noch langsamer. vielleicht überhitzt dann nichts mehr.

Hab mal gelesen dass DDR 5 rams schon temperatursensoren drin haben. aber wieso sollten die Rams ausgerechnet dann zu heiss werden wenn die daten langsam über den Bus kommen.

Ohne das Probem einzugrenzen kommt man also kein Stück weiter weil es einfach zu viele Ursachen haben kann.

Ich wüsste nicht was es sonst sein könnte. Problem in der AMD PCIe zu VRAM bridge bei hohem datentransfer. evtl stimmt timing was nicht. ich habe aber nichts übertaktet sondern weil wegen bios updates eh alle einstellungen weg sind nur noch die default werte drin.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das Szenario des Speicherüberlaufs kann verdammt tückisch sein denn jedes Spiel reagiert darauf anders.

Dazu hatte ich mal vor einiger Zeitz einen kleinen Vergleichstest mit meiner 6500XT und R9 Nano gemacht.

forum.planet3dnow.de

forum.planet3dnow.de

Dazu hatte ich mal vor einiger Zeitz einen kleinen Vergleichstest mit meiner 6500XT und R9 Nano gemacht.

RX 6500XT vs. R9 Nano

Nachdem meine kleine PowerColor Fighter RX 6500XT diese Woche eingetrudelt war hatte ich mir die Zeit genommen ihr im Vergleich zu meiner alten Sapphire R9 Nano mit Fiji GPU und 4 GB HBM Speicher eine etwas umfangreichere Testreihe zu starten und dabei auch noch ausgerechnet meine meine...

forum.planet3dnow.de

forum.planet3dnow.de

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

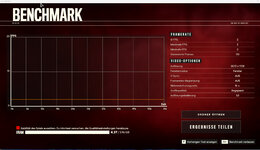

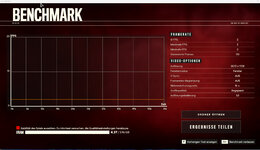

wäre super wenn welche die eine 4 GB Karte von AMD haben mal far cry 6 kostenlose demo den benchmark machen ob bei mehrmaligen aufrufen des tests die ergbenisse ungefähr gleich bleiben bei über 1440p auflösung. für far cry gibt es zwar auch kostenlose HD texturen für 12 GB vram,, aber die kann man scheinbar mit dem Demo nicht runterladen. für den benchmark muss man nicht mit ubi soft connect verbunden sein

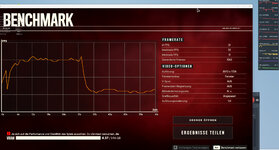

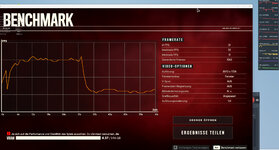

hatte sogar schon dass die fps stark langsamer war obwohl vram usage weniger war beim nochmaligen durchlaufen des benchmarks ohne einstellungen zu ändern. siehe screenshots

Ich glaube ich hatte es noch nicht erwähnt, aber die niedrige fps von 2 bekomme ich auch wenn man im Spiel auf den Boden schaut also nur die Bodentextur sichtbar ist. die gforce 1030 wird in so einem fall viel schneller kommt dann über 15 fps. daher find ich es unglaublich dass das Problem zu geringer Texturspeicher sein soll meiner 6500 .und in dem screenshot ist sogar noch vram frei . nur 3780 MB sind belegt . ein 4 k bild hat mit alphachannel nur 16 megabyte.

Bin mir aber nicht sicher ob es ein Hardware Konstruktionsfehler ist, oder Treiberproblem oder Absicht dass leute teurere version kaufen. und diejenigen die denken sie haben 8 GB karte juckt mich nicht, wenn das ein generelles problem bei AMD ist, dann betrifft es euch wenn ein game auf den Markt kommt das 8 GB karten ausnutzt genauso. oder kauft ihr dann mit freuden eine neue Karte mit 16 GB ?

du hast also auch eine 6500xt. kannst du vielleicht einmal das far cry demo probieren ob es bei dir mit gleichmässiger geschwindigkeit läuft in 4k und nicht einmal mit 2-3 fps und mal mit 30 fps im benchmark oder wenn man auf den Boden schaut.

hatte sogar schon dass die fps stark langsamer war obwohl vram usage weniger war beim nochmaligen durchlaufen des benchmarks ohne einstellungen zu ändern. siehe screenshots

Ich glaube ich hatte es noch nicht erwähnt, aber die niedrige fps von 2 bekomme ich auch wenn man im Spiel auf den Boden schaut also nur die Bodentextur sichtbar ist. die gforce 1030 wird in so einem fall viel schneller kommt dann über 15 fps. daher find ich es unglaublich dass das Problem zu geringer Texturspeicher sein soll meiner 6500 .und in dem screenshot ist sogar noch vram frei . nur 3780 MB sind belegt . ein 4 k bild hat mit alphachannel nur 16 megabyte.

Bin mir aber nicht sicher ob es ein Hardware Konstruktionsfehler ist, oder Treiberproblem oder Absicht dass leute teurere version kaufen. und diejenigen die denken sie haben 8 GB karte juckt mich nicht, wenn das ein generelles problem bei AMD ist, dann betrifft es euch wenn ein game auf den Markt kommt das 8 GB karten ausnutzt genauso. oder kauft ihr dann mit freuden eine neue Karte mit 16 GB ?

Das Szenario des Speicherüberlaufs kann verdammt tückisch sein denn jedes Spiel reagiert darauf anders.

Dazu hatte ich mal vor einiger Zeitz einen kleinen Vergleichstest mit meiner 6500XT und R9 Nano gemacht.

RX 6500XT vs. R9 Nano

Nachdem meine kleine PowerColor Fighter RX 6500XT diese Woche eingetrudelt war hatte ich mir die Zeit genommen ihr im Vergleich zu meiner alten Sapphire R9 Nano mit Fiji GPU und 4 GB HBM Speicher eine etwas umfangreichere Testreihe zu starten und dabei auch noch ausgerechnet meine meine...forum.planet3dnow.de

du hast also auch eine 6500xt. kannst du vielleicht einmal das far cry demo probieren ob es bei dir mit gleichmässiger geschwindigkeit läuft in 4k und nicht einmal mit 2-3 fps und mal mit 30 fps im benchmark oder wenn man auf den Boden schaut.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Für mich leider nicht nutzbar da offenbar nicht abseits des Ubisoft launchers und der Epic Plattform nutzbar.du hast also auch eine 6500xt. kannst du vielleicht einmal das far cry demo probieren ob es bei dir mit gleichmässiger geschwindigkeit läuft in 4k und nicht einmal mit 2-3 fps und mal mit 30 fps im benchmark oder wenn man auf den Boden schaut.

Doppelposting wurde automatisch zusammengeführt:

16 GB VRAM sind für mich wegen der typischen Entwicklung des Speicherbedarfs bei Spielen seit der Radeon VII Grundvoraussetzung für den Kauf denn ich nutze die Karten über Jahre. Zu viel VRAM hat zwar keinen Einfluss auf die Performance aber zu wenig kann vermehrte Nachladeruckler oder gar einen massiven einbruch der Framerate zur Folge haben.oder kauft ihr dann mit freuden eine neue Karte mit 16 GB

Zudem bevorzuge ich max. Texturen Details. Die kosten an und für sich zwar praktisch keine Performance, können aber zum VRAM Überlauf und dieser dann zu den besagten Frameraten Einbrüchen führen weil die GPU auf die in den erheblich langsameren RAM ausgelagerten Daten warten muss.

Doppelposting wurde automatisch zusammengeführt:

Wo ich mich gerade noch an frühere Probleme beim Wechsel von der Geforce zur Radeon erinnere.

Hattest du schon testweise vor der Installation der Radeon den Geforce Treiber vom Rechner sauber entfernt?

Das mußte ich bei meinem damaligen GTX970 vs. R9 290x Test machen damit der Treiber der Radeon wieder sauber arbeiten konnte.

Auch haben Tools wie der Afterburner das Potential den Treiber negativ zu beeinflussen wenn dessen Version nicht zur Treiber Version kompatibel ist. Da gab es schon mehrere Beispiele wo eine solche Inkompatibilität z.B. die Lüftersteuerung der Grafikkarte behinderte.

Wenn sowas bei dir ebenfalls der Fall sein könnte versuche es bitte mal mit einer Beseitigung dieser potentiellen Problem Faktoren und schau ob das Problem dann immernoch besteht.

Zuletzt bearbeitet:

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.264

- Renomée

- 1.851

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Wo soll der Sensor sein und welche Werte zeigt er an?Habe das Problem gefunden. Die Karte ist garnicht zu lahm, sondern es gibt irgendwo auf der Karte einen Temperatur Sensor der nirgends in den Anzeigen angezeigt wird. vermutlich hat das was mit dem RAM zu tun.

konnte die Lüfterdrehzahl fest einstellen auf 1900. von 2 fps max ging es dann hoch auf 32 fps für einge zeit. dann wurde wieder gedrosselt aber nur auf 11 fps. Das ist auch Fehler von AMD. Wenn schon Temperatur sensoren drin sind, dann sollte die software das auch anzeigen. asus schreibt zwar sie würden 144 std testen bei den dual, nur anscheinend merken die das dann auch nicht wenn die runtertaktet im Ram.

Und was kann AMD dafür, wenn Asus solch einen Sensor evtl. einbaut?

Mit hwinfo64 werden normalerweise alle Sensoren auf den Karten ausgelesen, vielleicht findest Du ihn dort.

Warum sollte Asus etwas testen, ohne Testsergebnisse anzuschauen? Das klingt für mich sehr unlogisch.

Der DDR5 wird wohl ohnehin kein Problem sein, Du hast ja keinen.Hab mal gelesen dass DDR 5 rams schon temperatursensoren drin haben. aber wieso sollten die Rams ausgerechnet dann zu heiss werden wenn die daten langsam über den Bus kommen.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Wo soll der Sensor sein und welche Werte zeigt er an?Habe das Problem gefunden. Die Karte ist garnicht zu lahm, sondern es gibt irgendwo auf der Karte einen Temperatur Sensor der nirgends in den Anzeigen angezeigt wird. vermutlich hat das was mit dem RAM zu tun.

konnte die Lüfterdrehzahl fest einstellen auf 1900. von 2 fps max ging es dann hoch auf 32 fps für einge zeit. dann wurde wieder gedrosselt aber nur auf 11 fps. Das ist auch Fehler von AMD. Wenn schon Temperatur sensoren drin sind, dann sollte die software das auch anzeigen. asus schreibt zwar sie würden 144 std testen bei den dual, nur anscheinend merken die das dann auch nicht wenn die runtertaktet im Ram.

Und was kann AMD dafür, wenn Asus solch einen Sensor evtl. einbaut?

wieso sollte asus so einen sensor einbauen. asus kann auch nur das machen was AMD erlaubt . der chipsatz hat dazu register.

Mit hwinfo64 werden normalerweise alle Sensoren auf den Karten ausgelesen, vielleicht findest Du ihn dort.

Warum sollte Asus etwas testen, ohne Testsergebnisse anzuschauen? Das klingt für mich sehr unlogisch.

hwinfo kann nur das auslesen was die hardware hersteller veröffentlichen. RAM temperatur könnte man auch auslesen, aber die hersteller geben die daten wie man das ausliest selten raus bei Rams die in graka verwendet werden wohl eher nicht

Der DDR5 wird wohl ohnehin kein Problem sein, Du hast ja keinen.Hab mal gelesen dass DDR 5 rams schon temperatursensoren drin haben. aber wieso sollten die Rams ausgerechnet dann zu heiss werden wenn die daten langsam über den Bus kommen.

die graka hat doch DDR6. und wenn es in DDR 5 temperatursensoren gibt, wird es das mit DDR 6 logischerweise auch geben auch wenn es keiner erwähnt. das RAM wird dann von sich aus bremsen einfach paar zyklen länger warten. Das würde aber vermutlich die VRAM clock nicht anzeigen, denn vram clock sieht nach einem register aus dass im radeon chipsatz drin ist wo der ramtakt eingestellt wird. ich würde gerne das RAM runtertakten auf 2 GHZ um zu sehen was dann passiert. nur geht das im AMD treiber nicht

immer wenn die karte langsam wird ist zwar der GPU takt voll hoch aber der ram takt ganz niedrig.

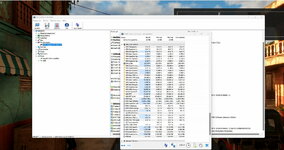

hwinfo zeigt noch ne hotspot temperatur an und viele andere Werte. Die liegt aber nirgends hoch. hier mal der 1. start wo der bench 5* schneller läuft. auflösung ist Fenster 3812x2092

und hier ohne einstellung zu ändern den bench nochmal gestartet dann extrem langsam

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Zieh die spalten mal etwas weiter auf.

GPU-Speicher-Junction müßte die VRAM Temperatur sein und die scheint dort voll im grünen Bereich zu sein. Was man aber nicht sieht ist die Temperatur des Spannungswandlers.

Was allerdings sofort ins Auge sticht ist die GPU-Speicher-Nutzung mit fast 5,7 GB. Bei dir werden bereits fast 2,6 GB in den RAM ausgelagert.

mit den beiden Pfeilen nach außen kannst du die Sensor Anzeige übrigens auch weiter aufblättern um so ev. alle Sensorwerte im Blick zu haben.

GPU-Speicher-Junction müßte die VRAM Temperatur sein und die scheint dort voll im grünen Bereich zu sein. Was man aber nicht sieht ist die Temperatur des Spannungswandlers.

Was allerdings sofort ins Auge sticht ist die GPU-Speicher-Nutzung mit fast 5,7 GB. Bei dir werden bereits fast 2,6 GB in den RAM ausgelagert.

mit den beiden Pfeilen nach außen kannst du die Sensor Anzeige übrigens auch weiter aufblättern um so ev. alle Sensorwerte im Blick zu haben.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Für mich leider nicht nutzbar da offenbar nicht abseits des Ubisoft launchers und der Epic Plattform nutzbar.du hast also auch eine 6500xt. kannst du vielleicht einmal das far cry demo probieren ob es bei dir mit gleichmässiger geschwindigkeit läuft in 4k und nicht einmal mit 2-3 fps und mal mit 30 fps im benchmark oder wenn man auf den Boden schaut.

kennst du einen anderen kostenlosen bench der die grafikkarte mit dem texturmem fordert ?. ohne den ubi soft launcher geht es zwar nicht, aber man muss dort keine telefon nummer oder kreditkarte eingeben um dort kostenlose demos wie das far cry 6 runterzuladen. brauchst lediglich ne e mail adresse zum konto bestätigen. da kannst dir eine kostenlose ohne handy nummeranzugeben bei proton mail holen, wenn du spam von ubi soft fürchtest

- Status

- Für weitere Antworten geschlossen.

Ähnliche Themen

- Gesperrt

- Antworten

- 4

- Aufrufe

- 498

- Antworten

- 0

- Aufrufe

- 624

- Antworten

- 2K

- Aufrufe

- 133K

- Antworten

- 504

- Aufrufe

- 73K