App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Carrizo - volles HSA, UVD6/VCE3.1/ACP2, HDMI 2.0 - und: SOC, aber immernoch DDR3?

- Ersteller nazgul99

- Erstellt am

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

wäre nur schön, könnte ich die hd7870 bei bedarf abschalten, bzw. per ccc festlegen,

welche anwendung durch die integrierte gpu und welche durch die hd 7870 bedient werden soll.

Kann hier jemand im Forum mit einer Kaveri-GPU-Kombination mal schildern, wie sich mit actuellen CCC eine APU-GPU Kombination aktuell ansprechen lässt?

AMD "Enduro" wurde ~ 2012 als Lösung des Problems vermarktet. Ist das mittlerweile praxistauglich?

Oder gibt es da für Carrizo noch Nachholbedarf?

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Oder gibt es da für Carrizo noch Nachholbedarf?

iGPU Werte sind echt RaR, wäre schön wenn jemand Werte hätte!

Kennst du Pacific Rim, den Film? (Sky cinema)

Wenn nein, here is your "Bildungslücke"!

Unbekannter Krieger

Grand Admiral Special

- Mitglied seit

- 04.10.2013

- Beiträge

- 4.455

- Renomée

- 66

- Mein Laptop

- HP 15-bq102ng (sackteuer u. ab Werk instabil)

- Details zu meinem Desktop

- Prozessor

- FX-8320E@4,2 GHz & 2,6 GHz Northbridge (jeweils mit UV)

- Mainboard

- Asus M5A99X Evo R2.0 (eher enttäuschend ggü. ASRock E3)

- Kühlung

- Raijintek Nemesis (Lüfter mittig im sowie hinter dem Kühler; erstklassig)

- Speicher

- 4x4 GiB Hynix DDR3-1866 ECC

- Grafikprozessor

- XFX RX 570 8G (P8DFD6)@1180 & 2150 MHz@starkem, fortdauerndem UV | ASRock RX 570 8G@das Gleiche

- Display

- BenQ XL2411T ~ nach 3 RMAs und 6 Monaten wieder brauchbar

- SSD

- Crucial MX100 256 GB (ein Glückskauf) | SanDisk Ultra Plus 256 GB (ein Glückskauf)

- HDD

- WD20EZRZ u. a. (Seagate, Hitachi, WD)

- Optisches Laufwerk

- TSST SH-222AL

- Gehäuse

- Corsair Carbide 300R (ein Fehlkauf)

- Netzteil

- CoolerMaster V450S (ein Glückskauf)

- Betriebssystem

- Win8.x x64, Win7 x64

- Webbrowser

- welche mit minimalem Marktanteil & sinnvollen Konzepten (nicht Chrome-Seuche und Sieche-Fuchs)

- Verschiedenes

- frühere GPUs: , Asus RX 480 O8G@580 O8G, VTX3D 7850 1G

@FredD

Das letzte, was ich von Enduro hörte, war eine offizielle Meldung hier, dass mit Version 5.5 alles umgekrempelt werden solle.

Das letzte, was ich von Enduro hörte, war eine offizielle Meldung hier, dass mit Version 5.5 alles umgekrempelt werden solle.

Als ich mein Kaveri System neu aufgebaut habe ich ein paar Test gemacht

http://www.planet3dnow.de/vbulletin/showthread.php/415369-Gigabyte-GA-F2A88XN-WIFI

Zumindest von dem Ergebnis unterscheiden sich die 3 Fälle nicht. Ich habe nur eine Radeon HD7770 OC. Ich hoffe mal das das mit größeren Grafikkarten genauso funktioniert. Dann wäre die Auswirkungen auch deutlicher. Leider kann ich das nicht ausprobieren, weil ich keine größer Grafikkarte habe und in ein LL Q11 auch nicht viel größere Grafikkarten reinpasst. Ich finde die Technik interessant, nur man findet nicht viel dazu.

http://www.planet3dnow.de/vbulletin/showthread.php/415369-Gigabyte-GA-F2A88XN-WIFI

An dieser Stelle wollte ich noch schauen, ob bei dem Verwenden einer Grafikkarte die interne Grafik besser abschalten oder eingeschalten sein sollte.

...

Vom Stromverbrauch her ist der Verbrauch mit der internen Grafik seltsamerweise niedriger. Allerdings ist bekannt das Grafkkarten mit Zero Core bei „Dual Graphics“ das Displaysignal durchschleifen können. http://www.golem.de/news/dual-graphi...-104829-2.html

Zumindest von dem Ergebnis unterscheiden sich die 3 Fälle nicht. Ich habe nur eine Radeon HD7770 OC. Ich hoffe mal das das mit größeren Grafikkarten genauso funktioniert. Dann wäre die Auswirkungen auch deutlicher. Leider kann ich das nicht ausprobieren, weil ich keine größer Grafikkarte habe und in ein LL Q11 auch nicht viel größere Grafikkarten reinpasst. Ich finde die Technik interessant, nur man findet nicht viel dazu.

Zuletzt bearbeitet:

nazgul99

Grand Admiral Special

- Mitglied seit

- 01.05.2005

- Beiträge

- 3.592

- Renomée

- 224

- Standort

- Irgendwo in der Nähe

- Mein Laptop

- ThinkPad Edge E145 / 8GB / M500 480GB / Kubuntu /// Asus U38N / 6GB / Matt / Postville / Kubuntu/W8

- Details zu meinem Desktop

- Prozessor

- AMD A10-7800

- Mainboard

- MSI A88XI AC

- Kühlung

- Scythe Shuriken Rev.2

- Speicher

- 2x 8GB DDR3-2133

- Grafikprozessor

- IGP

- Display

- HP LP2465, MVA, 1920x1200, 24"

- SSD

- Samsung 850 EVO 500GB

- HDD

- ST9500325AS 500GB

- Optisches Laufwerk

- ja, so'n USB-Dings

- Soundkarte

- onboard, optisch -> SMSL Q5 PRO -> ELAC EL60

- Gehäuse

- Silverstone ML06B

- Netzteil

- SST-ST30SF

- Betriebssystem

- Kubuntu

- Webbrowser

- Firefox

- Verschiedenes

- Synology DS414slim 3x 1,5 TB RAID5

Dein Golem-Link ist unvollständig. Nicht Text kopieren und einfügen, sondern Rechte Maustaste -> Link kopieren und einfügen bitte

---------- Beitrag hinzugefügt um 11:07 ---------- Vorheriger Beitrag um 11:06 ----------

Ah, Du hast aus dem eignen Review kopiert. Dort hab ich mal den korrekten Link rauskopiert: http://www.golem.de/news/dual-graph...ymbiose-aus-kern-und-karte-1402-104829-2.html

---------- Beitrag hinzugefügt um 11:10 ---------- Vorheriger Beitrag um 11:07 ----------

Ähm, warum wundert es Dich, dass der Verbrauch mit iGPU niedriger ist als mit dedizierter? Ich muss zugeben, dass ich Dein Review jetzt nur sehr sehr grob überflogen hab.

---------- Beitrag hinzugefügt um 11:07 ---------- Vorheriger Beitrag um 11:06 ----------

Ah, Du hast aus dem eignen Review kopiert. Dort hab ich mal den korrekten Link rauskopiert: http://www.golem.de/news/dual-graph...ymbiose-aus-kern-und-karte-1402-104829-2.html

---------- Beitrag hinzugefügt um 11:10 ---------- Vorheriger Beitrag um 11:07 ----------

Ähm, warum wundert es Dich, dass der Verbrauch mit iGPU niedriger ist als mit dedizierter? Ich muss zugeben, dass ich Dein Review jetzt nur sehr sehr grob überflogen hab.

Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

Wo steht denn sowas?

ist die "Ganze" GPU aktiv oder nur ein Bruchteil? Wieviele Transistoren schalten tatsächlich bzw. stehen unter Spannung? - und unter welcher Spannung, mit welchem Fertingungsprozess?

Eine Menge Fragezeichen für so eine einfache aussage...

ist die "Ganze" GPU aktiv oder nur ein Bruchteil? Wieviele Transistoren schalten tatsächlich bzw. stehen unter Spannung? - und unter welcher Spannung, mit welchem Fertingungsprozess?

Eine Menge Fragezeichen für so eine einfache aussage...

das hatte ich mich damals auch gefragt. Falls jemand mehr wissen sollte.

Zumindest war ich froh das das wirklich eine Absenkung des Stromverbrauchs ist. Ich hatte das Gegenteil erwartet und war sehr verwundert. Deswegen hatte ich den Rechner kurz ausgeschalten und dann erneut gemessen. Das Ergebnis blieb. 4 W waren mir zuviel, es es nur für Abweichung beim Messen abzutuen.

Die Beschreibungungen zu Zero Core sind dürftig. Zumindest was man so im Net findet.

Zumindest war ich froh das das wirklich eine Absenkung des Stromverbrauchs ist. Ich hatte das Gegenteil erwartet und war sehr verwundert. Deswegen hatte ich den Rechner kurz ausgeschalten und dann erneut gemessen. Das Ergebnis blieb. 4 W waren mir zuviel, es es nur für Abweichung beim Messen abzutuen.

Die Beschreibungungen zu Zero Core sind dürftig. Zumindest was man so im Net findet.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.224

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Also wenn der Monitor an der dGPU angeschlossen ist und die iGPU aktiviert ist, sind es 4W weniger als mit deaktivierter iGPU? (Dual Graphics aktiv?)das hatte ich mich damals auch gefragt. Falls jemand mehr wissen sollte.

Zumindest war ich froh das das wirklich eine Absenkung des Stromverbrauchs ist. Ich hatte das Gegenteil erwartet und war sehr verwundert. Deswegen hatte ich den Rechner kurz ausgeschalten und dann erneut gemessen. Das Ergebnis blieb. 4 W waren mir zuviel, es es nur für Abweichung beim Messen abzutuen.

Die Beschreibungungen zu Zero Core sind dürftig. Zumindest was man so im Net findet.

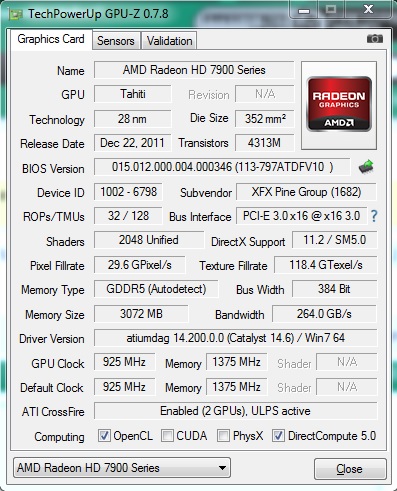

Zu ZCP, bei mir ist der Monitor an der ersten (obersten) dGPU angeschlossen (DVI) mit aktiviertem CrossfireX gibt es dann zwei Zustände:

1. Desktop und Video werden genutzt, die zweite Karte ist im ULPS (GPUz)

2. Monitor geht aus, die erste Karte geht auch in den ULPS Mode, CPU kann weiterhin arbeiten und Aufgaben erledigen im Hintergrund.

(3) Beim spielen sind je nach Profil dann auch beide GPUs an, beim laden schaltet die 2te trotzdem ab und zu ab.

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Als ich mein Kaveri System neu aufgebaut habe ich ein paar Test gemacht

http://www.planet3dnow.de/vbulletin/showthread.php/415369-Gigabyte-GA-F2A88XN-WIFI

Schönes System, und danke für den ausführlichen Bericht!

Wie ausgereift würdest du jetzt "Enduro" aka "Switchable Graphics" sehen? Kann man manuell von iGPU auf die diskrete GPU umschalten, und auch für Programme bzw. Spiele entsprechende Profile anlegen? Wird da reibungsfrei gewechselt, oder meinst du, dass da für Carrizo (respektive die diskreten GCN2.0 GPUs) noch Verbesserungen (die sich nicht rein auf Treiberbasis lösen lassen) nötig sind?

@ WindHund

Ja, Monitor mit einem HDMI Kabel (hat sonst noch VGA) an der dGPU angeschlossen.Ich hatte noch vor das HDMI Kabel mal an die iGPU anzuschließen. Ich hatte hier nur gelesen, dass es dabei zu Leistungseinbußen kommt. Was es nun genau ist kann ich nicht sagen. Ich habe nichts weiteres Eingestellt. (Im Bios war schon Automatisch vorgewählt, welches die iGPU aktiviert lässt). Ich hatte das Ergebnis nicht erwartet und auch nichts dazu vorher gelesen. Die Kombination aus Kaveri und extra Grafikkarte war damals selten. Den Preis der 7700k mit 130 € ist in meinen Augen zu hoch für eine 2 Module CPU. Das kriegt man mit einem FX4300 oder 760k billiger hin. Oder halt mehr Leistung. Ich hatte wegen der Verfügbarkeit und meinem Speicher den 7700k genommen. Ein 7850k ist in meinen Augen besser (kaum teurer, aber höher getaktet und mehr Einheiten).

@ FredD

Danke

Ehrlich gesagt habe ich das mit der Grafikkarte am Anfang ausprobiert um die Leistung und Stromaufnahme der iGPU besser beurteilen zu können. Ich hatte gehofft, durch Zero Core bei Aufnahme noch diese Stromdifferenz einsparen zu können. Der Monitor ist dabei eh aus. Allerdings habe ich keine Information über Zero Core und APU gefunden. Wäre die Differenz zu niedrig hätte ich mir gleich den Aufwand mit einem anderen Monitor gespart.

Extra Eingestellt habe ich nichts. Es wäre schön wenn ein paar Einstellmöglichkeiten gäbe. Im CCC habe ich nichts gefunden, den RadeonPro auch auf die schnelle nichts (wobei das Programm sehr umfangreich ist, leider eingestellt). Das Crossfire Profile habe ich mir nicht angeschaut. Ich sehe das ganze nicht mehr am Anfang Es gibt eine "funktionierende" Basis. Der Effekt ist nicht sehr hoch, allerdings kann er mit größeren oder aktuelleren Grafikkarte auch größer sein (Jeweils 9 W Mehrverbrauch bei einer Asus R7 250 und einer Sapphire Radeon HD 7770). Von Umschalten habe ich nichts gemerkt. Es war über ein Programmstart und Ende. Ich kann mir ein paar Verbesserungen vorstellen. Das fängt schon mit Zero Core, welches mit allen Ausgängen und nicht nur DVI funktioniert, an. Die 9 W können noch etwas bestimmt gedrückt werden ( Zero Core braucht 4 W). Wichtiger ware es, wenn auch mit Videos und normalen Programmen automatisch auf der iGPU laufen würde (manipulierbar). Bei den Hardwareverbesserungen bin ich überfragt. Ich denke mal, dass es bei einem gemeinsamen Speicher das Umschalten sehr schnell funktioniert und nur noch eine Auslastungsabfrage geben muss.

Ich hatte die Grafikkarte nur für die Test eingebaut. Da das nur ein ITX Gehäuse ist, wird der Steckplatz für die DVB-S Karte benötigt. Als HTPC sollte dieser ständig läufen (eigentlich für die Aufnahmen im Ruhemodus befinden) sollte, wollte ich keine extra Grafikkarte. Deswegen habe ich mich nicht so sehr hintergehängt. Zumal das ganze wegen der wenigen Informationen frustrierend ist.

Ja, Monitor mit einem HDMI Kabel (hat sonst noch VGA) an der dGPU angeschlossen.Ich hatte noch vor das HDMI Kabel mal an die iGPU anzuschließen. Ich hatte hier nur gelesen, dass es dabei zu Leistungseinbußen kommt. Was es nun genau ist kann ich nicht sagen. Ich habe nichts weiteres Eingestellt. (Im Bios war schon Automatisch vorgewählt, welches die iGPU aktiviert lässt). Ich hatte das Ergebnis nicht erwartet und auch nichts dazu vorher gelesen. Die Kombination aus Kaveri und extra Grafikkarte war damals selten. Den Preis der 7700k mit 130 € ist in meinen Augen zu hoch für eine 2 Module CPU. Das kriegt man mit einem FX4300 oder 760k billiger hin. Oder halt mehr Leistung. Ich hatte wegen der Verfügbarkeit und meinem Speicher den 7700k genommen. Ein 7850k ist in meinen Augen besser (kaum teurer, aber höher getaktet und mehr Einheiten).

@ FredD

Danke

Ehrlich gesagt habe ich das mit der Grafikkarte am Anfang ausprobiert um die Leistung und Stromaufnahme der iGPU besser beurteilen zu können. Ich hatte gehofft, durch Zero Core bei Aufnahme noch diese Stromdifferenz einsparen zu können. Der Monitor ist dabei eh aus. Allerdings habe ich keine Information über Zero Core und APU gefunden. Wäre die Differenz zu niedrig hätte ich mir gleich den Aufwand mit einem anderen Monitor gespart.

Extra Eingestellt habe ich nichts. Es wäre schön wenn ein paar Einstellmöglichkeiten gäbe. Im CCC habe ich nichts gefunden, den RadeonPro auch auf die schnelle nichts (wobei das Programm sehr umfangreich ist, leider eingestellt). Das Crossfire Profile habe ich mir nicht angeschaut. Ich sehe das ganze nicht mehr am Anfang Es gibt eine "funktionierende" Basis. Der Effekt ist nicht sehr hoch, allerdings kann er mit größeren oder aktuelleren Grafikkarte auch größer sein (Jeweils 9 W Mehrverbrauch bei einer Asus R7 250 und einer Sapphire Radeon HD 7770). Von Umschalten habe ich nichts gemerkt. Es war über ein Programmstart und Ende. Ich kann mir ein paar Verbesserungen vorstellen. Das fängt schon mit Zero Core, welches mit allen Ausgängen und nicht nur DVI funktioniert, an. Die 9 W können noch etwas bestimmt gedrückt werden ( Zero Core braucht 4 W). Wichtiger ware es, wenn auch mit Videos und normalen Programmen automatisch auf der iGPU laufen würde (manipulierbar). Bei den Hardwareverbesserungen bin ich überfragt. Ich denke mal, dass es bei einem gemeinsamen Speicher das Umschalten sehr schnell funktioniert und nur noch eine Auslastungsabfrage geben muss.

Ich hatte die Grafikkarte nur für die Test eingebaut. Da das nur ein ITX Gehäuse ist, wird der Steckplatz für die DVB-S Karte benötigt. Als HTPC sollte dieser ständig läufen (eigentlich für die Aufnahmen im Ruhemodus befinden) sollte, wollte ich keine extra Grafikkarte. Deswegen habe ich mich nicht so sehr hintergehängt. Zumal das ganze wegen der wenigen Informationen frustrierend ist.

Zuletzt bearbeitet:

Alter Sack

Lt. Commander

- Mitglied seit

- 10.03.2013

- Beiträge

- 143

- Renomée

- 0

- Standort

- Dennheritz

- Details zu meinem Desktop

- Prozessor

- A10-6700

- Mainboard

- Asrock FM A88X Extreme6+

- Kühlung

- Scythe Ninja II

- Speicher

- 8 GB DDR 3 1600 MHz

- Grafikprozessor

- APU

- Display

- 20" Samsung 1680x1050

- SSD

- Samssung Evo 840 256 GB

- HDD

- 1x 2 TB

- Optisches Laufwerk

- DVD-Brenner

- Soundkarte

- Onboard

- Netzteil

- Be Quiet 400W, 80+ Gold

- Betriebssystem

- Win7 x 64, SP1

- Webbrowser

- Opera, Firefox

- Verschiedenes

- Mein Allround-PC, den ich bei Bedarf , durch eine HD7870 aufwerte.

http://www.computerbase.de/2014-10/schnellerer-speicher-fuer-grafikkarten-noch-2014/

Zuerst nur 1Gb pro Chip. Könnte die anfänglich geringe Kapazität der Grund sein, dass HBM auf Apus später kommt?

VG

Zuerst nur 1Gb pro Chip. Könnte die anfänglich geringe Kapazität der Grund sein, dass HBM auf Apus später kommt?

VG

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Die HBM für GPU können ja problemlos als 2,5 angebunden werden. Um den GPU Chip herum ist reichlich Platz vorhanden um mehrere DRAM Chips zu verbauen. Bei einer APU ist der Platz begrenzter und vielleicht die 2,5 Anbindung nicht möglich aus Platzmangel, so dass eine 3D Anbindung zwingend ist. Damit wäre es sinnvoll erst die zweite Generation zu verwenden.

Wobei ich hier noch nicht sicher bin ob CB das richtig interpretiert hat.

2Gb Chips werden verwendet - OK

4 Stapel hoch geht es maximum - OK

Warum wird hier auf 1 GB RAM maximal geschlossen? Wer sagt denn, dass pro Stapel nur ein Chip verbaut wird? Auf dieser Folie ist das deutlich so beschrieben, dass je Stapel 4 DRAM Chips verbaut werden, die zusammen 256b-Anbindung haben. Somit ist ein 4xHi DRAM Stack bis 4 GB Ausbau möglich.

Wobei ich hier noch nicht sicher bin ob CB das richtig interpretiert hat.

2Gb Chips werden verwendet - OK

4 Stapel hoch geht es maximum - OK

Warum wird hier auf 1 GB RAM maximal geschlossen? Wer sagt denn, dass pro Stapel nur ein Chip verbaut wird? Auf dieser Folie ist das deutlich so beschrieben, dass je Stapel 4 DRAM Chips verbaut werden, die zusammen 256b-Anbindung haben. Somit ist ein 4xHi DRAM Stack bis 4 GB Ausbau möglich.

Zuletzt bearbeitet:

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

2 Gbit * 4 = 8 Gbit = 1 GByte

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Richtig und das ist erst ein Stack den man noch 4x Hoch stapeln kann. 4 Dies pro Stack steht in der Folie.2 Gbit * 4 = 8 Gbit = 1 GByte

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

das ist erst ein Stack den man noch 4x Hoch stapeln kann

Äh, nein.

Ein Stack besteht aus einem Logik Die und darauf 4 gestapelten RAM Dies a 2 MBit. Ergibt pro Stack 1 GByte. Den kann man nicht mehr Stapeln.

Und mehr ist der obigen Folie nicht zu entnehmen.

Auf einer anderen Folie ist zu sehen, wie AMD 4 solcher Stacks um eine CPU/APU/GPU herumbaut auf einen Chipträger.

Das ergäben dann in der ersten Phase einen Chip mit 4GByte.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

@Complicated

Stack == Stapel. Einen Stapel kann man nicht nochmal stapeln. Wäre ja irgendwie Quatsch. Bzw hätte man dann trotzdem nur einen Stapel, halt einen grösseren. Die Folie ist eigentlich unmissverständlich. 4 Dies pro Stack, 2 Gb pro Die, ergibt insgesamt 1 GB Kapazität pro Stack. Fragt sich nur, wie viele man von den Stacks auf einem Träger unterbringen kann.

Hier werden zumindest 4 Stacks dargestellt. Würde dann insgesamt 4 GB Kapazität bedeuten. Im HBM PDF von SK Hynix werden allerdings auch bis zu 8 Stacks erwähnt.

In der 2nd Gen HBM sollen dann bis zu 8 Dies pro Stack und 8 Gb pro Die möglich sein. Bei 4-8 Stacks wäre das eine Gesamtkapazität von 32-64 GB.

Stack == Stapel. Einen Stapel kann man nicht nochmal stapeln. Wäre ja irgendwie Quatsch. Bzw hätte man dann trotzdem nur einen Stapel, halt einen grösseren. Die Folie ist eigentlich unmissverständlich. 4 Dies pro Stack, 2 Gb pro Die, ergibt insgesamt 1 GB Kapazität pro Stack. Fragt sich nur, wie viele man von den Stacks auf einem Träger unterbringen kann.

Hier werden zumindest 4 Stacks dargestellt. Würde dann insgesamt 4 GB Kapazität bedeuten. Im HBM PDF von SK Hynix werden allerdings auch bis zu 8 Stacks erwähnt.

In der 2nd Gen HBM sollen dann bis zu 8 Dies pro Stack und 8 Gb pro Die möglich sein. Bei 4-8 Stacks wäre das eine Gesamtkapazität von 32-64 GB.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ein Stack kann in der ersten Generation 2-Hi oder 4-Hi betragen (2 RAM Dies oder 4 RAM Dies) die jeweils wieder gestapelt werden:

http://wccftech.com/amd-feature-gen...0-graphics-cards-allegedly-launching-2h-2014/

Allerdings habe ich Restzweifel aufgrund der Quelle. Ich werde mal sehen ob ich noch etwas anderes finde.

Hier ist zumindest der detaillierte Aufbau zu finden und auch die Fertigungsschritte beschrieben: http://www.microarch.org/micro46/files/keynote1.pdf

http://wccftech.com/amd-feature-gen...0-graphics-cards-allegedly-launching-2h-2014/

Allerdings habe ich Restzweifel aufgrund der Quelle. Ich werde mal sehen ob ich noch etwas anderes finde.

Hier ist zumindest der detaillierte Aufbau zu finden und auch die Fertigungsschritte beschrieben: http://www.microarch.org/micro46/files/keynote1.pdf

Anhänge

Zuletzt bearbeitet:

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Das 2-Hi oder 4-Hi bezieht sich auf die Anzahl der Dies, nicht auf die Anzahl irgendwelcher Stacks. 2+1 bedeutet 2x DRAM Die + 1x Base Logic Die. 4+1 ebenso mit entsprechend zwei weiteren DRAM Dies. Stapel können nicht gestapelt werden. Man kann sie nur nebeneinander auf dem Träger unterbringen.

Hier übrigens der Vollständigkeit halber mal die Originalquelle für die Hot Chips Slides von Hynix, wie sie im 3DC gefunden wurden, bevor sie dort von Videocardz und dort von CB geklaut wurde

http://www.setphaserstostun.org/hc26/HC26-11-day1-epub/HC26.11-3-Technology-epub/HC26.11.310-HBM-Bandwidth-Kim-Hynix-Hot%20Chips%20HBM%202014%20v7.pdf

Und nein, die DRAM-Dies sind nicht bereits gestapelte Einheiten. Wie schon mehrfach richtig erwähnt, besteht ein 4-Hi-Stack aus einem Logik-Die auf den vier DRAM-Dies (mit jeweils nur einer SI-Lage) gestapelt werden. Die erste Generation wird dann wohl wie auf Seite 12 zu sehen implementiert werden.

http://www.setphaserstostun.org/hc26/HC26-11-day1-epub/HC26.11-3-Technology-epub/HC26.11.310-HBM-Bandwidth-Kim-Hynix-Hot%20Chips%20HBM%202014%20v7.pdf

Und nein, die DRAM-Dies sind nicht bereits gestapelte Einheiten. Wie schon mehrfach richtig erwähnt, besteht ein 4-Hi-Stack aus einem Logik-Die auf den vier DRAM-Dies (mit jeweils nur einer SI-Lage) gestapelt werden. Die erste Generation wird dann wohl wie auf Seite 12 zu sehen implementiert werden.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.716

- Renomée

- 431

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Computerbase berichtet (via Digitimes) über einen Carrizo-Start im Dezember für low power und im März für die Kaveri-Nachfolger: http://www.computerbase.de/2014-10/amds-excavator-kerne-mit-carrizo-im-dezember/

hot

Admiral Special

- Mitglied seit

- 21.09.2002

- Beiträge

- 1.187

- Renomée

- 15

- Details zu meinem Desktop

- Prozessor

- AMD Phenom 9500

- Mainboard

- Asrock AOD790GX/128

- Kühlung

- Scythe Mugen

- Speicher

- 2x Kingston DDR2 1066 CL7 1,9V

- Grafikprozessor

- Leadtek Geforce 260 Extreme+

- Display

- Samsung 2432BW

- HDD

- Samsung HD403LJ, Samung SP1614C

- Optisches Laufwerk

- LG HL55B

- Soundkarte

- Realtek ALC890

- Gehäuse

- Zirco AX

- Netzteil

- Coba Nitrox 600W Rev.2

- Betriebssystem

- Vista x64 HP

- Webbrowser

- Firefox

Da wird wohl der Glücklose Beema ersetzt, wie es aussieht. Mullins wird ja dann durch Nolan später ersetzt.

nazgul99

Grand Admiral Special

- Mitglied seit

- 01.05.2005

- Beiträge

- 3.592

- Renomée

- 224

- Standort

- Irgendwo in der Nähe

- Mein Laptop

- ThinkPad Edge E145 / 8GB / M500 480GB / Kubuntu /// Asus U38N / 6GB / Matt / Postville / Kubuntu/W8

- Details zu meinem Desktop

- Prozessor

- AMD A10-7800

- Mainboard

- MSI A88XI AC

- Kühlung

- Scythe Shuriken Rev.2

- Speicher

- 2x 8GB DDR3-2133

- Grafikprozessor

- IGP

- Display

- HP LP2465, MVA, 1920x1200, 24"

- SSD

- Samsung 850 EVO 500GB

- HDD

- ST9500325AS 500GB

- Optisches Laufwerk

- ja, so'n USB-Dings

- Soundkarte

- onboard, optisch -> SMSL Q5 PRO -> ELAC EL60

- Gehäuse

- Silverstone ML06B

- Netzteil

- SST-ST30SF

- Betriebssystem

- Kubuntu

- Webbrowser

- Firefox

- Verschiedenes

- Synology DS414slim 3x 1,5 TB RAID5

Beema: 124 Einträge

Kaveri: 47 Einträge

Glücklos sieht anders aus. Zudem ist Beema viel günstiger zu fertigen (winziges Die, billiger Prozess) und steht performance-seitig Kaveri bei den praktischen Benchmarks kaum nach. Und das bei 15 vs 19 Watt TDP und ohne zusätzlichen FCH, der die TDP und Kosten Kaveris nochmals erhöht.

Ich denke, Digitimes schreibt da schlicht Stuss.

--- Update ---

Mullins hingegen ist bisher definitv glücklos, ich kenne nur das eine HP-Notebook mit der Beemas Tablet-Variante an Bord. Tablets: Kein einziges. Verständlich ist das allerdings nicht - IMHO. Mag an den glücklosen Vorgänger-Modellen liegen, wo die Hersteller sich nie trauten, mehr als den billigsten Temash in Tablets einzubauen, weshalb sie den schwachbrüstigen Billig-Schund nicht loswurden.

Kaveri: 47 Einträge

Glücklos sieht anders aus. Zudem ist Beema viel günstiger zu fertigen (winziges Die, billiger Prozess) und steht performance-seitig Kaveri bei den praktischen Benchmarks kaum nach. Und das bei 15 vs 19 Watt TDP und ohne zusätzlichen FCH, der die TDP und Kosten Kaveris nochmals erhöht.

Ich denke, Digitimes schreibt da schlicht Stuss.

--- Update ---

Mullins hingegen ist bisher definitv glücklos, ich kenne nur das eine HP-Notebook mit der Beemas Tablet-Variante an Bord. Tablets: Kein einziges. Verständlich ist das allerdings nicht - IMHO. Mag an den glücklosen Vorgänger-Modellen liegen, wo die Hersteller sich nie trauten, mehr als den billigsten Temash in Tablets einzubauen, weshalb sie den schwachbrüstigen Billig-Schund nicht loswurden.

Zuletzt bearbeitet:

Wie viele DRAM-Stapel könnte man denn an den brachliegenden zweiten Speicherkontroller im Kaveri-Die anschließen? So wie ich das verstehe, kommt die Bandbreite über einen Zugriff über wesentlich mehr Datenleitungen als bei DDR3. Dafür bräuchte man dann auch einen neuen RAM-Controller. Oder man krempelt einen aus einer Radeon um und "baut HSA ein".[...]Fragt sich nur, wie viele man von den Stacks auf einem Träger unterbringen kann.

Ähnliche Themen

- Antworten

- 22

- Aufrufe

- 9K

- Antworten

- 0

- Aufrufe

- 62K

- Antworten

- 0

- Aufrufe

- 52K