App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Artikel Gleicher Preis bei AMD und Intel - wer bietet mehr fürs Geld?

- Ersteller heikosch

- Erstellt am

Jetzt sind wir schon bei 1200p (nicht mehr nur FullHD), und bei der Beschränkung auf Spiele, die in 2012 erschienen sind...lustig...wenn wir noch etwas warten, dann wird daraus vielleicht noch 4k und Spiele, die 2014 erscheinen werden...Nenne mir nur 3 Spiele aus 2012 die in 1200p ohne Augen Krebs in spielbaren Framebereichen liegen.

.

EDIT :

.

Rede Dir eben weiter alles schön.

Dir ist schon klar, dass nicht jedes Spiel, welches 2012 erschienen ist, zwangsweise höhere Hardwareanforderungen als Spiele aus 2011 oder 2010 hat

Und eigentlich ging es um diese Aussage von dev art:

Die wolltest du mit dem Gegenbeispiel von BF3 widerlegen, welches eben bei FullHD nicht ganz flüssig läuft. Aber es wurde ja auch nie behauptet, dass alle Spiele in FullHD flüssig laufen, das wolltest du nur immer hinzu dichten...Und man [kann] sehr wohl Spiele native in 1920x1200 z.b. sehr fluessig spielen. Es gibt naemlich auch solche, die mit solcher Hardware klarkommen, auch aktuell angebotene Spiele.

Und bezüglich deinem Zitat:

1. Absatz zitiert rein die von dir genannten Benches, da kann ich mir nichts schön reden...

2. Absatz sind nun mal Fakten, die man überall nachlesen kann

3. Absatz ist in den üblichen Foren zu finden.

Da frage ich mich echt, wer sich hier was schön redet...

Zusätzlich sollte man noch erwähnen, dass die schnelle IGP von Trinity durchaus aktuell schon sinnvoll genutzt werden kann. Z.B. von Winzip, der aktuell OpenCL Support bietet, was die Packzeit beim A10 mal eben in etwa halbiert. Glücklicherweise hat P3DNow nur auf die steinzeitlichen Packer von 7zip und WinRar gesetzt, sonst hätte die Intel CPU in dem Test bei den Benches schlechter abgeschnitten.

@Deracus:

Im HTPC Bereich kann man sicher darüber streiten, was besser ist, da ist Intel sicherlich auch ein sehr rundes Paket. Allerdings sollte Trinity mit -0,2V schon deutlich weniger als 65W verbrauchen, die Spannung geht ja exponentiell in die Verlustleistung ein. Eine 65W APU landet dann bei ca. 45W, bei -0,3V sind's dann etwa 38W TDP (rein wegen der Spannung, am Takt wurde da nichts geändert), was auch recht ordentlich ist, wenn auch vielleicht nicht ganz auf i3 Niveau (aber da ist der Abstand dann schon so gering, dass ein sparsames Board, sparsamer Ram und Co. mehr ausmachen, als die CPU). Mit dem Intel geht's allerdings wohl etwas einfacher als mit Trinity. Ich wollte auch nur andeuten, dass Trinity durchaus auch merklich sparsamer sein kann, als AMD das aktuell zeigt.

Nachtrag:

@Twodee:

Die 7750 braucht laut HT4U etwas mehr als 23W bei BluRay. Je nach Einstellung ist der Vorteil von Intel dahin, natürlich mit mehr Leistung, aber auch mit fast 80% Aufpreis (aktuell gibt's die 7750 GDDR5 ab 78€, die DDR3 Variante verliert ja so viel an Leistung gegenüber der GDDR5, dass die nicht sinnvoll ist). Sicher ist das Intel System dann das rundere Paket, aber halt auch deutlich teurer und damit nicht wirklich zum AMD vergleichbar.

Zuletzt bearbeitet:

Das geht mit dem I3 aber auch. Man nimmt einfach einen günstigen 35Watt I3 (3220T) und untervoltet ihn. Da braucht es schon einen E450 um verbrauchstechnisch mithalten zu können.@Deracus:

Im HTPC Bereich kann man sicher darüber streiten, was besser ist, da ist Intel sicherlich auch ein sehr rundes Paket. Allerdings sollte Trinity mit -0,2V schon deutlich weniger als 65W verbrauchen, die Spannung geht ja exponentiell in die Verlustleistung ein. Eine 65W APU landet dann bei ca. 45W, bei -0,3V sind's dann etwa 38W TDP (rein wegen der Spannung, am Takt wurde da nichts geändert), was auch recht ordentlich ist, wenn auch vielleicht nicht ganz auf i3 Niveau (aber da ist der Abstand dann schon so gering, dass ein sparsames Board, sparsamer Ram und Co. mehr ausmachen, als die CPU). Mit dem Intel geht's allerdings wohl etwas einfacher als mit Trinity. Ich wollte auch nur andeuten, dass Trinity durchaus auch merklich sparsamer sein kann, als AMD das aktuell zeigt.

@Twodee:

Die 7750 braucht laut HT4U etwas mehr als 23W bei BluRay. Je nach Einstellung ist der Vorteil von Intel dahin, natürlich mit mehr Leistung, aber auch mit fast 80% Aufpreis (aktuell gibt's die 7750 GDDR5 ab 78€, die DDR3 Variante verliert ja so viel an Leistung gegenüber der GDDR5, dass die nicht sinnvoll ist). Sicher ist das Intel System dann das rundere Paket, aber halt auch deutlich teurer und damit nicht wirklich zum AMD vergleichbar.

Nur braucht man für die Reibungslose BluRay-Wiedergabe mit nem i3 3225 keine dGPU wie die 7750. Daher ist der Vergleich eigentlich von vorn herein unsinnig.

Eine solche Rechnung macht eigentlich nur Sinn, wenn man sich dabei auf die erreichbare Spieleleistung bezieht...

@Deracus:

[...]

Ich wollte auch nur andeuten, dass Trinity durchaus auch merklich sparsamer sein kann, als AMD das aktuell zeigt.

Gut, bei deinem Schlusspunkt gehe ich mit.

Ich wollte ja auch nicht sagen, dass AMD im HTPC Bereich absolut untauglich wäre...sondern lediglich, wie du schon meintest, man bei Intel mit weniger Aufwand schneller ein runderes Paket hinbekommt.

Es ist ja auch nicht gesagt, dass jeder Trinity bei-0,2 oder -0,3V noch läuft. Das der Intel mehr als 0,1V Spannungsabsenkung vertragen würde steht zudem ja auch im Raum.

Faktisch war es bei mir halt so, dass ich im Vorfeld meiner Entscheidungen nur auf das schauen konnte, was bisher so im Netz zu finden war. Und da gab es bezüglich der Sparsamkeit der APUs eben nicht viel belastbares Material.

Ein User Namens "keibertz" z.B. hat da auf forumdeluxx.de und xbmcnerds ne Kiste mit nem A6-5400k gebaut und seine Werte lagen bei 3D-BluRays halt beispielsweise immernoch bei besagten 52Watt oder sowas in der Art...

Das - und die zu dem Zeitpunkt sehr wackelige Verfügbarkeit von guten ITX-Boards für FM2 - brachten mich halt zum i3 3225.

Spielperformance war für meinen Zweck nicht so wichtig (da eh nur hier und da mal nen Adventure, nen alter Klassiker oder was browserbasiertes gespielt wird), saubere Multimedia-Performance hingegen schon. Und die gabs beim i3 ohne viel gefrickel...

Zusammengefasst wollte ich eigentlich auch nur sagen, dass ich es schade finde, dass AMD so sehr versucht die GPU-Leistung hochzuhalten anstatt mal eine APU zu bringen, die sich irgendwo mehr in Richtung Stromsparen orientiert und die GPU-Leistung wirklich mehr im Bezug auf Video-De- und Encodierung legt. Vielleicht was in Richtung Stock-45W-TDP...

WindHund schrieb:Richtig, wer einen HTPC mit Multimedia Inhalten nutzen will kommt um eine dGPU nicht herum mit dem I3.

Dann ist nicht nur der Verbrauch höher beim Unterhalt, nein man hat auch noch mehr Verbrauch bei der Herstellung verursacht.

Soviel mehr Verbrauch, das es in 10 Jahren Laufzeit keine Einsparungen mit dem Intel System möglich sind.

Wer sagt denn, dass man für Multimedia-Inhalte beim i3 ne dGPU braucht? Wozu sollte man die brauchen?

Die iGPU kann h264 und Co in Hardware, unterstützt BluRay3D, Digital Audio über HDMI und Flash-Hardware-Beschleunigung.

Ich wüsste nicht seit wann Spiele standardmäßig Multimedia-Inhalte wären...und dann stehen eben @Stock-VCore 65Watt gegen ca. 45W beim Intel...inkl. guter Möglichkeiten zur Spannungsabsenkungen und dadurch weitere Verbrauchsreduktion.

Es geht beim HTPC auch selten um die Möglichkeit der Kosteneinsparung durch Stromsparen, sondern viel mehr darum, dass ab ner gewissen Baugröße einfach nur x Watt sinnvoll (=leise) abgeführt werden können...

@sompe:

In was für eine RIchtung Leute immer gleich denken. Auch ich kenne die Wunderwelt der Werbeblocker....

Prinzipiell meinte ich mit anspruchsvolleren Websites Dinge wie Browser-Games (Die Siedler Online und Co.) sowie HTML5-basierte Spielereien, die doch gern mal hier und da etwas extra Performance brauchen und z.T: eben nicht immer absolut sauber und effizient gebaut wurden.

Anspruchsvolle Websites müssen nicht immer gleich Full-Screen-Flash-Ads bedeuten...es gibt heutzutage durchaus auch die Möglichkeit mit "sinnvollen" Sachen die CPU ordentlich zu beanspruchen...und da tut es ein E350 oder Atom eben nicht mehr wirklich...

Zuletzt bearbeitet:

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

Sag mal gehts noch? Die 1200p kommen nicht von mir! Wie wäre es mal mit lesen der posts!

Das aber scheint für manchen zuviel verlangt.

Das aber scheint für manchen zuviel verlangt.

Jetzt sind wir schon bei 1200p (nicht mehr nur FullHD), und bei der Beschränkung auf Spiele, die in 2012 erschienen sind...lustig...wenn wir noch etwas warten, dann wird daraus vielleicht noch 4k und Spiele, die 2014 erscheinen werden...

Dir ist schon klar, dass nicht jedes Spiel, welches 2012 erschienen ist, zwangsweise höhere Hardwareanforderungen als Spiele aus 2011 oder 2010 hat

Und eigentlich ging es um diese Aussage von dev art:

Die wolltest du mit dem Gegenbeispiel von BF3 widerlegen, welches eben bei FullHD nicht ganz flüssig läuft. Aber es wurde ja auch nie behauptet, dass alle Spiele in FullHD flüssig laufen, das wolltest du nur immer hinzu dichten...

Und bezüglich deinem Zitat:

1. Absatz zitiert rein die von dir genannten Benches, da kann ich mir nichts schön reden...

2. Absatz sind nun mal Fakten, die man überall nachlesen kann

3. Absatz ist in den üblichen Foren zu finden.

Da frage ich mich echt, wer sich hier was schön redet...

Zusätzlich sollte man noch erwähnen, dass die schnelle IGP von Trinity durchaus aktuell schon sinnvoll genutzt werden kann. Z.B. von Winzip, der aktuell OpenCL Support bietet, was die Packzeit beim A10 mal eben in etwa halbiert. Glücklicherweise hat P3DNow nur auf die steinzeitlichen Packer von 7zip und WinRar gesetzt, sonst hätte die Intel CPU in dem Test bei den Benches schlechter abgeschnitten.

@Deracus:

Im HTPC Bereich kann man sicher darüber streiten, was besser ist, da ist Intel sicherlich auch ein sehr rundes Paket. Allerdings sollte Trinity mit -0,2V schon deutlich weniger als 65W verbrauchen, die Spannung geht ja exponentiell in die Verlustleistung ein. Eine 65W APU landet dann bei ca. 45W, bei -0,3V sind's dann etwa 38W TDP (rein wegen der Spannung, am Takt wurde da nichts geändert), was auch recht ordentlich ist, wenn auch vielleicht nicht ganz auf i3 Niveau (aber da ist der Abstand dann schon so gering, dass ein sparsames Board, sparsamer Ram und Co. mehr ausmachen, als die CPU). Mit dem Intel geht's allerdings wohl etwas einfacher als mit Trinity. Ich wollte auch nur andeuten, dass Trinity durchaus auch merklich sparsamer sein kann, als AMD das aktuell zeigt.

Nachtrag:

@Twodee:

Die 7750 braucht laut HT4U etwas mehr als 23W bei BluRay. Je nach Einstellung ist der Vorteil von Intel dahin, natürlich mit mehr Leistung, aber auch mit fast 80% Aufpreis (aktuell gibt's die 7750 GDDR5 ab 78€, die DDR3 Variante verliert ja so viel an Leistung gegenüber der GDDR5, dass die nicht sinnvoll ist). Sicher ist das Intel System dann das rundere Paket, aber halt auch deutlich teurer und damit nicht wirklich zum AMD vergleichbar.

Der Verbrauch der HD7750 allein ist irrelevant, entscheidend ist der Gesamtsystemverbrauch.J

@Twodee:

Die 7750 braucht laut HT4U etwas mehr als 23W bei BluRay. Je nach Einstellung ist der Vorteil von Intel dahin, natürlich mit mehr Leistung, aber auch mit fast 80% Aufpreis (aktuell gibt's die 7750 GDDR5 ab 78€, die DDR3 Variante verliert ja so viel an Leistung gegenüber der GDDR5, dass die nicht sinnvoll ist). Sicher ist das Intel System dann das rundere Paket, aber halt auch deutlich teurer und damit nicht wirklich zum AMD vergleichbar.

Und dieser ist laut dem P3D Test hier geringer als ein A10 allein bei BluRay.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Dann würden aber auch unter 10W reichen: http://www.extremetech.com/computin...xplorer-an-overpriced-raspberry-pi-competitorDas geht mit dem I3 aber auch. Man nimmt einfach einen günstigen 35Watt I3 (3220T) und untervoltet ihn. Da braucht es schon einen E450 um verbrauchstechnisch mithalten zu können.

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

Da geht ja aber kein Blueray mehr

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.348

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Auch ich kenne mit meinem E-350 Schleppi das Wunder des Werbeblockers, auch wenn ich es nur bei nerfiger und behinderner Werbung einsetze, mir also die Filter selbst erstelle und erweitere.@sompe:

In was für eine RIchtung Leute immer gleich denken. Auch ich kenne die Wunderwelt der Werbeblocker....

Prinzipiell meinte ich mit anspruchsvolleren Websites Dinge wie Browser-Games (Die Siedler Online und Co.) sowie HTML5-basierte Spielereien, die doch gern mal hier und da etwas extra Performance brauchen und z.T: eben nicht immer absolut sauber und effizient gebaut wurden.

Anspruchsvolle Websites müssen nicht immer gleich Full-Screen-Flash-Ads bedeuten...es gibt heutzutage durchaus auch die Möglichkeit mit "sinnvollen" Sachen die CPU ordentlich zu beanspruchen...und da tut es ein E350 oder Atom eben nicht mehr wirklich...

Und nein...ich nutze nicht nur 1-3 Tabs/Fenster.

.

EDIT :

.

Korrekt und der Verbrauch der Grafikkarte kommt beim Systemverbrauch nochmal zum Verbrauch der anderen Komponenten hinzu. Fraßen das Trinity und das i3 System in idle zuvor ca. gleich viel kommt der idle Verbrauch der Grafikkarte noch dazu und schon frißt hier das i3 System mehr. Womöglich überholt der i3 dann selbst bei der Video Wiedergabe den Trinity ohne wirklich mehr zu leisten. Dazu fehlen aber entsprechende Tests und angesichts des Preisunterschiedes der Systeme wäre der Vergleich auch relativ sinnfrei.Der Verbrauch der HD7750 allein ist irrelevant, entscheidend ist der Gesamtsystemverbrauch.

Und dieser ist laut dem P3D Test hier geringer als ein A10 allein bei BluRay.

Bleibt also praktisch nur noch die Zocker Fraktion übrig.

Zuletzt bearbeitet:

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

ZCP sollte das widerlegen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.348

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Schaltest du jedes mal den Monitor aus sobald sich der Rechner im idle Takt befindet?

Bei dem Test hier verbraucht der I3 Idle aber 5 Watt weniger als der A10. Eine Referenz HD7750 verbraucht @Idle laut HT4u 6,5 Watt. Abzüglich der iGPU des I3 sollte das Gespann I3+dGPU genauso viel verbrauchen wie der A10.Korrekt und der Verbrauch der Grafikkarte kommt beim Systemverbrauch nochmal zum Verbrauch der anderen Komponenten hinzu. Fraßen das Trinity und das i3 System in idle zuvor ca. gleich viel kommt der idle Verbrauch der Grafikkarte noch dazu und schon frißt hier das i3 System mehr.

Hast du dir hier den Teil mit den Verbrauchsmessung angesehen?Womöglich überholt der i3 dann selbst bei der Video Wiedergabe den Trinity ohne wirklich mehr zu leisten. Dazu fehlen aber entsprechende Tests

Der I3+HD7750 verbraucht @Bluray bis zu 8 Watt weniger als ein A10 allein.

Wie ich schon sagte, was mehr Leistet (CPU+dGPU), bei gleichem Verbrauch, darf auch gerne etwas mehr Kosten.und angesichts des Preisunterschiedes der Systeme wäre der Vergleich auch relativ sinnfrei.

Zuletzt bearbeitet:

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

Hier wird um 2 Euro pro Jahr an Mehrkosten für Energie gesprochen. Mit einem Pentium G2020 und einer HD7750 komme ich auf wesentlich spielbarere frames bei gleicher Investition und weniger Frustpotential im Gegensatz zum A10. Jetzt erklare mir bitte nochmal den Sinn des A10. Ich bin z.b. froh das ich den los bin. Warum nicht gegen den Pentium antreten lassen im Test? Weil der Vergleich dann noch sinnfreier wäre?!

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.348

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@Twodee

Das ist das Problem beim Systemverbrauch. Er hängt auch von anderen Faktoren wie der Wahl des Mainboards ab.

Des weiteren habe ich es dem Test nicht angesehen denn dieser Punkt fehlt hier im Test und das hatte ich auch bereits angemeckert.

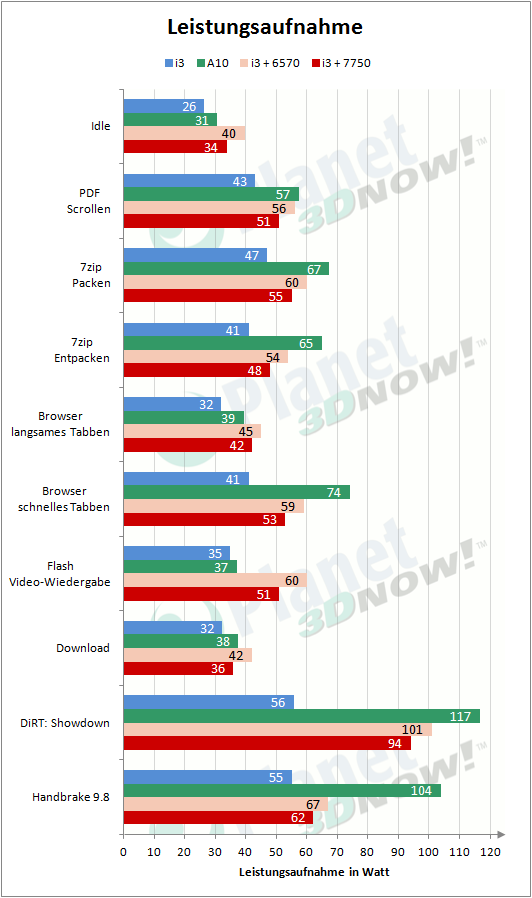

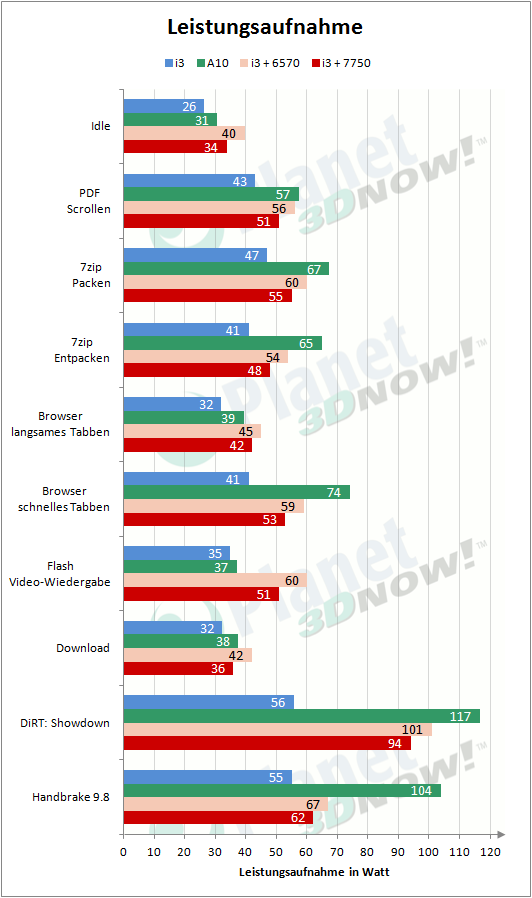

Allerdings kann man das Problem zumindest bei der Blu-Ray Wiedergabe auch hier im Test bereits sehen. Da zog das Trinity System alleine 50-60W, das i3 System zusammen mit der HD 6570 hingegen 67-69W. Das Trinity System war also in dieser Teildisziplin zwischen 9 und 17W effizienter. Leider fehlt dieses Modell im ht4u Test...

Das ist das Problem beim Systemverbrauch. Er hängt auch von anderen Faktoren wie der Wahl des Mainboards ab.

Des weiteren habe ich es dem Test nicht angesehen denn dieser Punkt fehlt hier im Test und das hatte ich auch bereits angemeckert.

Allerdings kann man das Problem zumindest bei der Blu-Ray Wiedergabe auch hier im Test bereits sehen. Da zog das Trinity System alleine 50-60W, das i3 System zusammen mit der HD 6570 hingegen 67-69W. Das Trinity System war also in dieser Teildisziplin zwischen 9 und 17W effizienter. Leider fehlt dieses Modell im ht4u Test...

@sompe

Ich beziehe mich jedesmal auf die HD7750, steht doch überall deutlich oder?

A10 (ohne Werkseinstellung) 50 bis 60Watt =>55Watt

I3+HD7750: 57-58Watt =>57,5Watt

Unterschied ~2,5Watt weniger

oder:

A10 (mit Werkseinstellung) 57 bis 66Watt =>61,5Watt

I3+HD7750: 57-58Watt =>57,5Watt

Unterschied ~4Watt mehr

Ich beziehe mich jedesmal auf die HD7750, steht doch überall deutlich oder?

A10 (ohne Werkseinstellung) 50 bis 60Watt =>55Watt

I3+HD7750: 57-58Watt =>57,5Watt

Unterschied ~2,5Watt weniger

oder:

A10 (mit Werkseinstellung) 57 bis 66Watt =>61,5Watt

I3+HD7750: 57-58Watt =>57,5Watt

Unterschied ~4Watt mehr

Von wem denn bitte sonstSag mal gehts noch? Die 1200p kommen nicht von mir! Wie wäre es mal mit lesen der posts!

Das aber scheint für manchen zuviel verlangt.

Alle anderen schreiben immer nur von FullHD, was eben 1080p ist. Nur du hast 1200p erwähnt (siehe mein Zitat). Und da dir die Argumente ausgehen, musst du natürlich gleich wieder pampig werden...

@Twodee:

Deine Rechnung geht aber nur auf, wenn beide Systeme jeweils im Durchschnitt auch exakt in der Mitte zwischen min und max liegen. Das muss nicht zwingend so sein (Ausreißer), aber wahrscheinlich ist das Intel System dann minimal sparsamer, zumindest in der Config. Anderes Board und es kann schon wieder ganz anders aussehen...vom AMD Board aus dem Test ist ja schon bekannt, dass es nicht so sparsam sein soll. Wenn man für die Intel CPU hingegen zufällig ein Sparsames erwischt haben sollte, dann relativiert das die Verbrauchswerte schon wieder. Bei Anandtech war z.B. der A10 im Idle so sparsam wie ein i3-3220T. Unter Last ist der AMD natürlich klar schlechter, das war ja auch mit der Fertigung zu erwarten. Aber so mancher kann sich da eben eine zusätzliche Grafikkarte sparen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.348

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@Twodee

Jetzt ist der Groschen gefallen welchen Test du meintest.

Ich hatte bei meinem Schleppi nicht weit genug runter gescrollt, weshalb die 7750 Werte verdeckt waren.

Letztendlich ändert dies aber nichts daran dass das i3 System mit der 7750 (nochmal zusätzlich ca. 78€) in diesem Test bei der Blu-Ray Wiedergabe nicht all so viel ändert und die Wahl des Mainboards bei so geringen Unterschieden im Idle Verbrauch einen Einfluss darauf hat welches System weniger Strom frißt (bei Computerbase fisst das A10 System beipielsweise in idle 1W weniger als die i3 Variante)

Im Vergleich zu den Werten aus diesem Test haben wir bereits eine Differenz von 6W die vermutlich aufs Konto der Mainboardwahl geht. Dies wird um so deutlicher je mehr tests man mit einander vergleicht. Besipielsweise fressen in diesem Computerbase Test alle IB Modelle in idle gleich viel. Im Trinity Test bei Hartware ist der i5 hingegen mit 7W mehr dabei. Über verschiedene Tests hinweg haben wir also bereits eine Differenz von 12W die nicht zuletzt auf die Kappe der Mainboardauswahl gehen werden.

Jetzt ist der Groschen gefallen welchen Test du meintest.

Ich hatte bei meinem Schleppi nicht weit genug runter gescrollt, weshalb die 7750 Werte verdeckt waren.

Letztendlich ändert dies aber nichts daran dass das i3 System mit der 7750 (nochmal zusätzlich ca. 78€) in diesem Test bei der Blu-Ray Wiedergabe nicht all so viel ändert und die Wahl des Mainboards bei so geringen Unterschieden im Idle Verbrauch einen Einfluss darauf hat welches System weniger Strom frißt (bei Computerbase fisst das A10 System beipielsweise in idle 1W weniger als die i3 Variante)

Im Vergleich zu den Werten aus diesem Test haben wir bereits eine Differenz von 6W die vermutlich aufs Konto der Mainboardwahl geht. Dies wird um so deutlicher je mehr tests man mit einander vergleicht. Besipielsweise fressen in diesem Computerbase Test alle IB Modelle in idle gleich viel. Im Trinity Test bei Hartware ist der i5 hingegen mit 7W mehr dabei. Über verschiedene Tests hinweg haben wir also bereits eine Differenz von 12W die nicht zuletzt auf die Kappe der Mainboardauswahl gehen werden.

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

Bitte schön...

Lesen, dann schreiben! Aber wie schon erwähnt, das ist manchen schon zuviel bzw sind sie damit schon überfordert. Hat nichts mit pampig werden zu tun und Argumente gehen mir bestimmt nicht aus...

@sompe:

G2020 + HD7750 = 124€

Von wem denn bitte sonst

Alle anderen schreiben immer nur von FullHD, was eben 1080p ist. Nur du hast 1200p erwähnt (siehe mein Zitat). Und da dir die Argumente ausgehen, musst du natürlich gleich wieder pampig werden...

Lesen, dann schreiben! Aber wie schon erwähnt, das ist manchen schon zuviel bzw sind sie damit schon überfordert. Hat nichts mit pampig werden zu tun und Argumente gehen mir bestimmt nicht aus...

Einen A10 kennst Du jedenfalls nicht. ich hab schon mehrere davon zusammengebaut. Und man sehr wohl Spiele native in 1920x1200 z.b. sehr fluessig spielen.

@sompe:

G2020 + HD7750 = 124€

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.348

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@Sagi T 754

Das bringt uns ohne Test jetzt genau wieviel?

Der G2020 besitzt etwas mehr als 10% weniger Taktfrequenz und kein HTT.

Im Singlethread Bereich dürfte er damit gute 10% langsamer als der i3 sein und baut diesen im Multithread Bereich noch weiter aus. Da der i7-3770 beim Cinebench ca. 30% langsamer als der i5-3570K sein soll kann man hier also getrost von 40/45% weniger Rechenleistung ausgehen. Bedenkt man dann noch das es bereits Spiele gibt die recht gut über 4 Kerne/Threads hinweg skalieren können....

Das bringt uns ohne Test jetzt genau wieviel?

Der G2020 besitzt etwas mehr als 10% weniger Taktfrequenz und kein HTT.

Im Singlethread Bereich dürfte er damit gute 10% langsamer als der i3 sein und baut diesen im Multithread Bereich noch weiter aus. Da der i7-3770 beim Cinebench ca. 30% langsamer als der i5-3570K sein soll kann man hier also getrost von 40/45% weniger Rechenleistung ausgehen. Bedenkt man dann noch das es bereits Spiele gibt die recht gut über 4 Kerne/Threads hinweg skalieren können....

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

Geht nur um den Vergleich zum A10

Würde das sogar spasseshalber mal so bestellen und testen.

Würde das sogar spasseshalber mal so bestellen und testen.

PC-Erfahrung hat die GT 610 so eingestuft. Nach CB ist`s eher eine GT 430 bzw. GT 620. Wer besser ist oder nicht, zeigt Dir gleich das Licht.Soll das ein Witz sein

Die GT610 ist eine umgelabelte GT520. Vielleicht mit 3 von denen kommst du auf das Niveau des A10...der liegt im von Sagi T 754 zitierten BF3 Bench von Anandtech auf dem Niveau einer GT440, die aktuell auch als GT630 verkauft wird...Die gibt's ab 46€, braucht aber auch bis 65W. Damit bist du also bei selbem Verbrauch auf vergleichbarer Leistung wie ein A10. Nur eben 46€ teurer...ja, Intel ist da klar besser...

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.348

- Renomée

- 1.975

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Vom Multithreading her ist der A10 ca. mit dem i3 vergleichbar, da wäre der G2020 also ca. 40% langsamer.Geht nur um den Vergleich zum A10

Würde das sogar spasseshalber mal so bestellen und testen.

Singlethreaded könnte er ca. 15-20% schneller sein.

Es kommt also wie immer auf die Anzahl der genutzten Kerne an.

Spieleseitig könnte sich die Spanne von "ca. doppelt so schnell" (max. 2 Threads, GPU lastig) bis "fast halb so schnell" (CPU Limit bei 4 Threads) erstrecken.

@Twodee

Jetzt ist der Groschen gefallen welchen Test du meintest.

Ich hatte bei meinem Schleppi nicht weit genug runter gescrollt, weshalb die 7750 Werte verdeckt waren.

Letztendlich ändert dies aber nichts daran dass das i3 System mit der 7750 (nochmal zusätzlich ca. 78€) in diesem Test bei der Blu-Ray Wiedergabe nicht all so viel ändert und die Wahl des Mainboards bei so geringen Unterschieden im Idle Verbrauch einen Einfluss darauf hat welches System weniger Strom frißt (bei Computerbase fisst das A10 System beipielsweise in idle 1W weniger als die i3 Variante)

Im Vergleich zu den Werten aus diesem Test haben wir bereits eine Differenz von 6W die vermutlich aufs Konto der Mainboardwahl geht. Dies wird um so deutlicher je mehr tests man mit einander vergleicht. Besipielsweise fressen in diesem Computerbase Test alle IB Modelle in idle gleich viel. Im Trinity Test bei Hartware ist der i5 hingegen mit 7W mehr dabei. Über verschiedene Tests hinweg haben wir also bereits eine Differenz von 12W die nicht zuletzt auf die Kappe der Mainboardauswahl gehen werden.

Richtig. Es hängt auch vieles vom Board ab.

Was ich nur zeigen wollte, ist das man auch den I3+dGPU auf ähnlichem Verbrauch trimmen könnte, wenn es denn nötig wäre.

Preislich ist die Sache natürlich teuer, aber das ist man ja bei Intel gewohnt. (+/- 100€ spielen für mich pers. keine Rolle)

Würde ich mir ein System kaufen, wäre es definitiv ein A10-System, allein deshalb weil man auf eine dGPU verzichten kann und dadurch kleinere und leisere Systeme möglich sind, ohne das man auf 3D-Leistung verzichten muss.

Wie z.B. mit dem Gehäuse hier: http://www.amazon.de/gp/product/B004LUJ31C/ref=oh_details_o03_s00_i00

echtes "mini ITX", derzeit läuft da ein A8 3870K, ein I3+dGPU würde da nicht reinpassen.

Nenne mir nur 3 Spiele aus 2012 die in 1200p ohne Augen Krebs in spielbaren Framebereichen liegen.

Dann nimm am besten gleich die ersten 3 von denen hier

http://www.computerbild.de/artikel/cbs-Tipps-PC-Top-50-Download-Spiele-des-Monats-5248873.html#2

Sagi T

Grand Admiral Special

- Mitglied seit

- 22.02.2005

- Beiträge

- 7.544

- Renomée

- 156

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Pentathlon 2012

- Lieblingsprojekt

- SIMAP, SETI, COLLATZ

- Meine Systeme

- i7-2600k, E-350, E-450, Core2Duo T6670

- BOINC-Statistiken

- Mein Laptop

- Lenovo X200 T

- Details zu meinem Desktop

- Prozessor

- Intel Core i7-8700k @ 5.0Ghz

- Mainboard

- AsRock Z390 Phantom Gaming SLi

- Kühlung

- Scythe Mine2 @ Arctic P12+P14

- Speicher

- 16GB Crucial Ballistix DDR4-3200

- Grafikprozessor

- EVGA RTX2060 @ 2100/7800

- Display

- LG UM65 21:9

- HDD

- Samsung 860 EVO 500GB | Samsung SD840 256GB | Crucial MX500 | Hitachi 1TB

- Soundkarte

- Soundblaster THX

- Gehäuse

- ThermalTake H200 weiß

- Netzteil

- Corsair HX850 80+ Gold

- Tastatur

- Logitech illuminated Keyboard

- Maus

- G500

- Betriebssystem

- Windows 7 64bit | Win10 Pro 64bit

- Webbrowser

- Chrome

- Schau Dir das System auf sysprofile.de an

Ahahahhahaaaaaa, soll ich jetzt lachen oder weinen?

Mahjong, BF1942, Lemmings, Solitär und Trackmania?

OMG![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Mahjong, BF1942, Lemmings, Solitär und Trackmania?

OMG

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

[/quote]Nenne mir nur 3 Spiele aus 2012 die in 1200p ohne Augen Krebs in spielbaren Framebereichen liegen.

Dann nimm am besten gleich die ersten 3 von denen hier

http://www.computerbild.de/artikel/cbs-Tipps-PC-Top-50-Download-Spiele-des-Monats-5248873.html#2

heikosch

Grand Admiral Special

Die Messungen mit den Grafikkarten und ohne HTT waren mal für den Artikel angedacht. Beim A10 ergibt sich ja nur das Problem, dass sich die iGPU scheinbar nicht komplett abschaltet. Außerdem sollte der Artikel die beiden Produkte direkt vergleichen und weniger die etlichen Kombinationen, die möglich sind. Darunter leidet dann auch die Übersichtlichkeit.

Trotzdem kann ich euch gerne die Verbrauchswerte noch einmal geben.

Bei Handbrake scheint die Beschleunigung über die GPU nicht mehr zu funktionieren, wenn die Intel-CPU zum Einsatz kommt.

Trotzdem kann ich euch gerne die Verbrauchswerte noch einmal geben.

Bei Handbrake scheint die Beschleunigung über die GPU nicht mehr zu funktionieren, wenn die Intel-CPU zum Einsatz kommt.

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 482

- Antworten

- 0

- Aufrufe

- 659

- Antworten

- 0

- Aufrufe

- 968

- Antworten

- 0

- Aufrufe

- 799