App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

nVidia Geforce RTX 4060/4070/4080/4090 (Ti/Super) (Ada/PCIe 4.0): Tests/Meinungen im Netz. Links in Post 1

- Ersteller eratte

- Erstellt am

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.371

- Renomée

- 9.696

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Wie ist das eigentlich rechtlich? Ich meine auf dem Karton jeder Karte pappen diverse Siegel. Wenn der Adapter wirklich so gefährlich sein sollte, müsste man die Karten doch aus dem Verkehr nehmen, oder nicht?

Versucht mal ein Handy ohne CE-Zeichen zu importieren, aber Kabel, die im Extremfall einen Brand verursachen sind ok?

Gute Frage.

Die CE-Kennzeichnung bietet – abgesehen von wenigen Ausnahmefällen – keine Gewähr dafür, dass die Konformität auch von offizieller Seite geprüft wurde und stellt auch kein Qualitätssiegel dar. Der Hersteller ist für die Konformität vielmehr selbst verantwortlich und haftet in vollem Umfang für etwaige Fehler. Z.B. kann eine fehlerhafte CE-Kennzeichnung eine wettbewerbsrechtliche Abmahnung oder ein strafrechtliches Verfahren zur Folge haben. Auch stellen sich Fragen der Produkthaftung.

Abmahnen dürfen aber wahrscheinlich wie üblich nur Mitbewerber. Inwieweit hier irgendeine offizielle Stelle bei Kenntnis aktiv werden kann, keine Ahnung.

Es wird wohl eh darauf hinauslaufen, dass Nvidia die Adapter tauschen wird, ob sie wirklich gezwungen sind den Verkauf einzustellen, wieder keine Ahnung.

bei allem respekt für seine arbeit.

aber herrschaften, was für ein aufgeblasener klugscheißer. wenn er bereits mehrere stecker zur hand hat, hätte er igors ansatz aufgreifen können, die dinger mit einem ct zu durchleuchten. und sorry für den rant ... aber dann noch seine stiefellecker-community ... ja, youtube ist nicht gut für den charakter.![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

aber herrschaften, was für ein aufgeblasener klugscheißer. wenn er bereits mehrere stecker zur hand hat, hätte er igors ansatz aufgreifen können, die dinger mit einem ct zu durchleuchten. und sorry für den rant ... aber dann noch seine stiefellecker-community ... ja, youtube ist nicht gut für den charakter.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.854

- Renomée

- 2.814

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Bald sollten alle üblichen "Verdächtigen" die Kuh durch das Dorf getrieben haben, aber es geht auch mehrfach.

Simple Ursache? NVIDIA GeForce RTX 4090, der verschmorte 12VHPWR Anschluss und das Einstecken | Blind Test (igor'sLAB)

Ich frage mich immer wieder was sich die Reviewer von ihren "Grimassenstartbildschirm" versprechen? Mehr Cklicks? Mich schreckt das eher ab.

Bei GN nervt mich auch langsam das umfangreiche anbiedern ihre "Merchadiseartikel".

Am liebsten schaue ich da noch HU, das meist recht nüchtern und nicht so reißerisch.

Simple Ursache? NVIDIA GeForce RTX 4090, der verschmorte 12VHPWR Anschluss und das Einstecken | Blind Test (igor'sLAB)

Ich frage mich immer wieder was sich die Reviewer von ihren "Grimassenstartbildschirm" versprechen? Mehr Cklicks? Mich schreckt das eher ab.

Bei GN nervt mich auch langsam das umfangreiche anbiedern ihre "Merchadiseartikel".

Am liebsten schaue ich da noch HU, das meist recht nüchtern und nicht so reißerisch.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das liegt wohl auch daran das es nicht nur peinlich ist einen Adapter mit so vielen Mängeln einer Karte dieser Preisklasse beizulegen.

Er ist für gängige Gehäuse bei der Höhe der Karten zu hoch um die Biegeradien einhalten zu können, die Kabel sind zu kurz um das Gewicht der 8 Pin Steckverbindungen sicher abfangen zu können und übt aber wegen der Länge eine entsprechende Hebelwirkung auf die 12 Pin Steckverbindung aus. Das Problem der schlechten Anschlussqualität kommt da erst noch oben drauf. Das trifft dann einfach auf nvidias teils selbstherrliche Selbstdarstellung.

Er ist für gängige Gehäuse bei der Höhe der Karten zu hoch um die Biegeradien einhalten zu können, die Kabel sind zu kurz um das Gewicht der 8 Pin Steckverbindungen sicher abfangen zu können und übt aber wegen der Länge eine entsprechende Hebelwirkung auf die 12 Pin Steckverbindung aus. Das Problem der schlechten Anschlussqualität kommt da erst noch oben drauf. Das trifft dann einfach auf nvidias teils selbstherrliche Selbstdarstellung.

auf den pfaden von ltt. die zicken sich mittlerweile auch regelmäßig an, vor allem gn in richtung ltt, seit ltt sei lab-project angekündigt hat. wie gesagt, youtube scheint nicht gut für den charakter.Bei GN nervt mich auch langsam das umfangreiche anbiedern ihre "Merchadiseartikel".

ltt ist aber um faktor x noch schlimmer als gn. gn bringt ja wenigstens noch interessante und fachlich fundierte sachen, aber bei ltt gibt es ja fast nur noch gescripteten müll. und die häufigkeit von linus-dicke-hose-videos a'la ich hab produkt x für summe x (also für viel geld) gekauft, nimmt gefühlt immer mehr zu inkl. stetig steigender nervigkeit. und seit einiger zeit gibt es wirklich nur noch click-bait-headlines.

da hat sich meine meinung mittlerweile geändert. deshalb stimme ich zu, dass hu von den ganzen hardware-kanälen am wenigsten überkandidelt ist. oder sowas wie kitguru u.a.Am liebsten schaue ich da noch HU, das meist recht nüchtern und nicht so reißerisch.

die verbreitung entsprechender netzteile wird schritt für schritt zunehmen, dann wird man ohne adapter auskommen. die spannende frage ist dann, inwiefern der stecker abseits der adapter etwas taugt. also die langfristige haltbarkeit der nativen stecker. ich hab die befürchtung, dass das ganze konstrukt nichts taugt.Das liegt wohl auch daran das es nicht nur peinlich ist einen Adapter mit so vielen Mängeln einer Karte dieser Preisklasse beizulegen.

Er ist für gängige Gehäuse bei der Höhe der Karten zu hoch um die Biegeradien einhalten zu können, die Kabel sind zu kurz um das Gewicht der 8 Pin Steckverbindungen sicher abfangen zu können und übt aber wegen der Länge eine entsprechende Hebelwirkung auf die 12 Pin Steckverbindung aus. Das Problem der schlechten Anschlussqualität kommt da erst noch oben drauf. Das trifft dann einfach auf nvidias teils selbstherrliche Selbstdarstellung.

Cleric

Admiral Special

- Mitglied seit

- 08.01.2003

- Beiträge

- 1.087

- Renomée

- 110

Ein Schnäppchen.

www.computerbase.de

www.computerbase.de

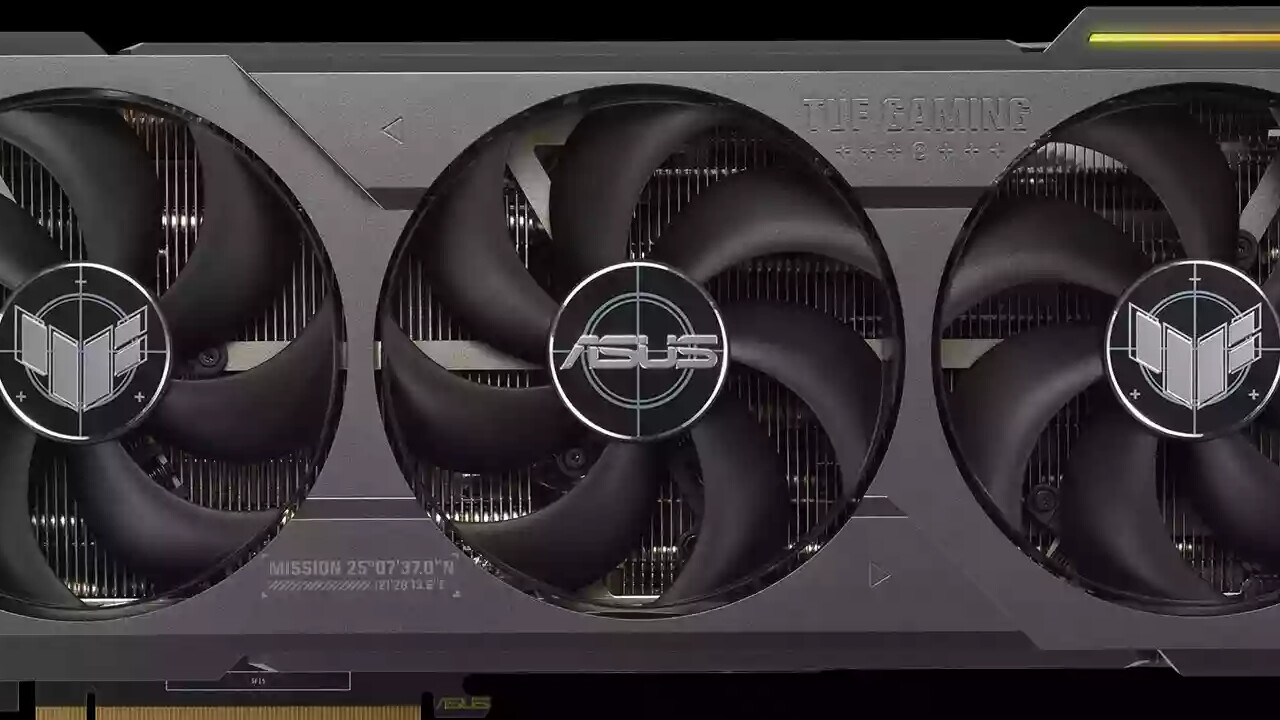

GeForce RTX 4080: Erste Custom-Designs sind für 1.619 bis 1.969 Euro im Handel

Die ersten Custom-Designs der GeForce RTX 4080 sind zu Preisen von 1.619 bis 1.969 Euro bereits im Handel angekommen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Und bis dahin dürfen die Gehäuse nicht mehr egschlossen werden damit der Adapter nicht potentiell die Karte abfackelt oder ist es die sekundäre Aufgabe des Adapters als Seitenwandsperre herzuhalten damit die Karten genug Frischluft bekommen?die verbreitung entsprechender netzteile wird schritt für schritt zunehmen, dann wird man ohne adapter auskommen. die spannende frage ist dann, inwiefern der stecker abseits der adapter etwas taugt. also die langfristige haltbarkeit der nativen stecker. ich hab die befürchtung, dass das ganze konstrukt nichts taugt.

So oder so, das Ding ist ne Fehlkonstruktion und das mit Ansage.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Die können sehr viel für die Bauform des Adapters den sie beilegen obwohl er für reguläre Systeme mit der besagten Karte unbrauchbar ist.

Mit einer abgewinkelten Variante hätte man das Problem von Anfang an umgehen können.

Mit einer abgewinkelten Variante hätte man das Problem von Anfang an umgehen können.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.854

- Renomée

- 2.814

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

RTX 4090 & 53 Games: Ryzen 7 5800X vs Ryzen 7 5800X3D Review (TechPowerUp)

MSI GeForce RTX 4090 SUPRIM LIQUID X im Test – Mit Wasser bleibt kein Auge trocken (igor'sLAB)

VIDIA RTX 4090 PCIe 3.0 vs. 4.0 x16 & '5.0' Scaling Benchmarks (Gamers Nexus)

Für mich ist das wirklich enttäuschend das es bei der aktuell schnellsten und teuersten Grafikkarte für Endanwender weder PCIe 5.0 noch Display Port 2.x gibt.

PS.: zu LTT sparen ich mir lieber jeden Kommentar will nicht unhöflich werden

MSI GeForce RTX 4090 SUPRIM LIQUID X im Test – Mit Wasser bleibt kein Auge trocken (igor'sLAB)

VIDIA RTX 4090 PCIe 3.0 vs. 4.0 x16 & '5.0' Scaling Benchmarks (Gamers Nexus)

Für mich ist das wirklich enttäuschend das es bei der aktuell schnellsten und teuersten Grafikkarte für Endanwender weder PCIe 5.0 noch Display Port 2.x gibt.

PS.: zu LTT sparen ich mir lieber jeden Kommentar will nicht unhöflich werden

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

WTF

www.computerbase.de

www.computerbase.de

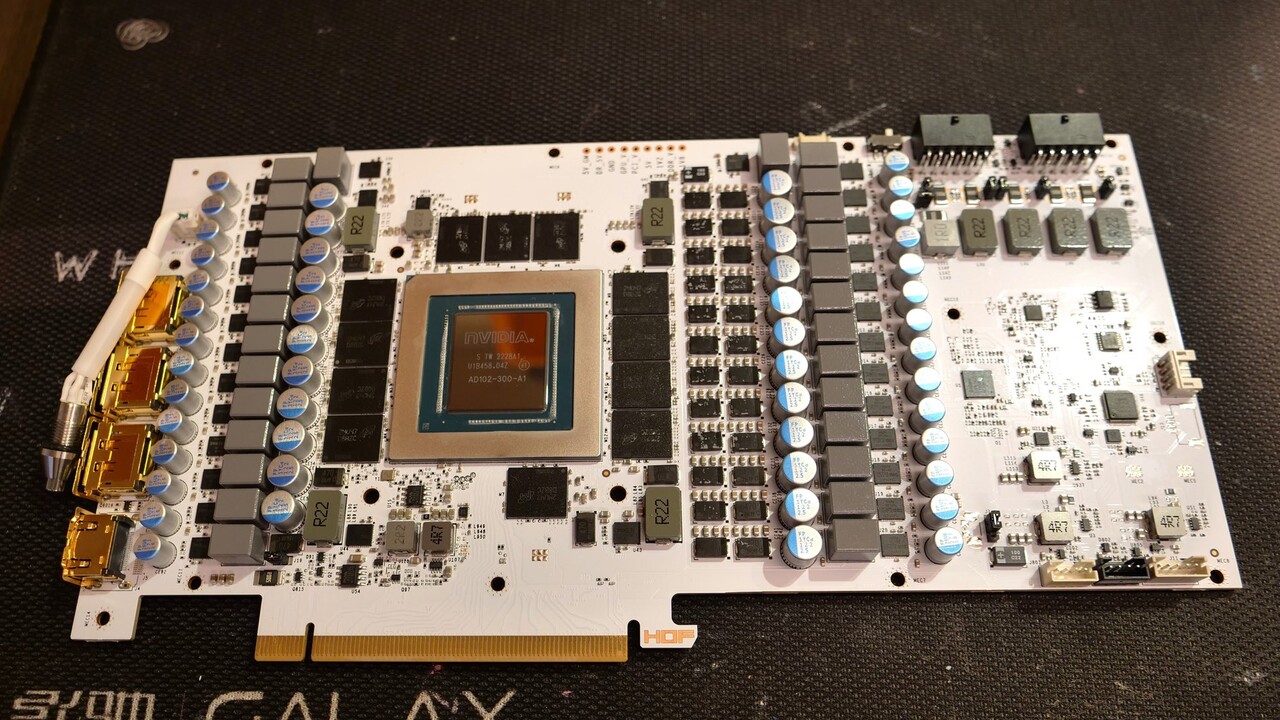

RTX 4090 HOF: Galax verbaut zwei 12VHPWR-Stecker für bis zu 1.275 Watt

Als bisher erste RTX 4090 bietet die Galax HOF zwei 12VHPWR-Stecker, sodass die theoretische Leistungsaufnahme auf über 1 Kilowatt steigt.

Nichtsdestoweniger sieht Galax wohl die Notwendigkeit, für extremes Overclocking zwei 12VHPWR-Stecker zu verbauen, wodurch die theoretisch maximal mögliche Leistungsaufnahme mitsamt der 75 Watt über den PCIe-Steckplatz auf absurde 1.275 Watt steigt.

cologne46

Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 1.291

- Renomée

- 223

- Lieblingsprojekt

- medizinische

- Meine Systeme

- A10-5700, 6x Odroid N2

- BOINC-Statistiken

- Mein Laptop

- Dell Vostro 3700

- Details zu meinem Desktop

- Prozessor

- A10-5700

- Mainboard

- Asrock FM2A75 Pro4-M

- Kühlung

- EKL Alpenföhn Groß Clockner mit be quiet! Silent Wings PWM

- Speicher

- 16GB G.Skill 2400

- Grafikprozessor

- HD 7660D

- Display

- 27" IIYAMA XUB2792UHSU

- SSD

- Corsair Neutron XTI 480 GB

- HDD

- Seagate ST6000VN 6 TB

- Optisches Laufwerk

- LG BH16

- Soundkarte

- onboard

- Gehäuse

- Sharkoon Revenge Economy

- Netzteil

- BeQuiet 300W

- Betriebssystem

- Win 7 x64

- Webbrowser

- Firefox

Nette Entwicklung. Lässt für die Zukunft großes erwarten.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.854

- Renomée

- 2.814

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

E555user

Admiral Special

- Mitglied seit

- 05.10.2015

- Beiträge

- 1.551

- Renomée

- 593

5800X vs. 5800X3D vs. 13900k mit einer RTX 4090

Techpowerup hat in den Grafiken des 13900K vs 5800X3D (mittleres Bild) vergessen Teile der Titel anzupassen.

Gegenüber dem gleichen Modell ohne V-Cache wird der minimale Taktvorteil vollständig kompensiert und der V-Cache kann teils deutliche Unterschiede auch in 4k ausmachen. Bei AoE4, Anno1800 und Hitman ist der höhere Takt des Intel dann ausschlaggebend. Zum optischen Vergleich von mir die entsprechenden Titel für FHD zusammengestellt.

Der Intel mit 30% mehr Takt gewinnt in LoRes besonders in Simulationen hinzu, aber auch bei bestimmten EgoShooter rd. 15%, vermutlich wenn mehr Gegner-KI oder Simulation dabei ist. Bei Ace Combat, CiV und F1-22 sieht man, dass bei steigenden Auflösungen sich die Last auf der CPU auch mal stark ändern kann, von Taktvorteil zum Cache- bzw. RAM-Latenz Vorteil.

Das erste Bild zeigt eindrücklich wo viel L3 Cache mit wenig Latenz hilft. Man sollte nicht vergessen, dass auch der 13900k deutlich im L2 zugelegt hat gegenüber dem einfachen Zen3.

Techpowerup hat in den Grafiken des 13900K vs 5800X3D (mittleres Bild) vergessen Teile der Titel anzupassen.

Gegenüber dem gleichen Modell ohne V-Cache wird der minimale Taktvorteil vollständig kompensiert und der V-Cache kann teils deutliche Unterschiede auch in 4k ausmachen. Bei AoE4, Anno1800 und Hitman ist der höhere Takt des Intel dann ausschlaggebend. Zum optischen Vergleich von mir die entsprechenden Titel für FHD zusammengestellt.

Der Intel mit 30% mehr Takt gewinnt in LoRes besonders in Simulationen hinzu, aber auch bei bestimmten EgoShooter rd. 15%, vermutlich wenn mehr Gegner-KI oder Simulation dabei ist. Bei Ace Combat, CiV und F1-22 sieht man, dass bei steigenden Auflösungen sich die Last auf der CPU auch mal stark ändern kann, von Taktvorteil zum Cache- bzw. RAM-Latenz Vorteil.

Das erste Bild zeigt eindrücklich wo viel L3 Cache mit wenig Latenz hilft. Man sollte nicht vergessen, dass auch der 13900k deutlich im L2 zugelegt hat gegenüber dem einfachen Zen3.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Die dezeitigen 364,-€ lassen auch bei mir die Finger langsam jucken, als Replacement für meinen 3700X - so war das am Ende der AM4-Periode auch geplant - schön wenn man Hochpreisphasen aussitzen kann. Auf 16 Core oder schnelleren 8-Core Upgrade. Das einzige was mich derzeit abhält ist, dass ich überhaupt kein Performance-Defizit mit meinem Setup/Usecase habe. Womöglich investiere ich doch eher in ein neues QNAP-NAS und 2,5 Gbit Switch und warte noch bis H2/2023

Maverick-F1

Grand Admiral Special

Im Mindstar aktuell nur 349 € - ohne Deine Entscheidung irgendwie beeinflussen zu wollen!Die dezeitigen 364,-€ lassen auch bei mir die Finger langsam jucken, als Replacement für meinen 3700X - so war das am Ende der AM4-Periode auch geplant - schön wenn man Hochpreisphasen aussitzen kann. Auf 16 Core oder schnelleren 8-Core Upgrade. Das einzige was mich derzeit abhält ist, dass ich überhaupt kein Performance-Defizit mit meinem Setup/Usecase habe. Womöglich investiere ich doch eher in ein neues QNAP-NAS und 2,5 Gbit Switch und warte noch bis H2/2023

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Mein Preis war Mindfactory

Das geht aber schnell jetzt.

Das geht aber schnell jetzt.

Peet007

Admiral Special

- Mitglied seit

- 30.09.2006

- Beiträge

- 1.884

- Renomée

- 39

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 8700G

- Mainboard

- MSI Mortar B650

- Kühlung

- Wasser

- Speicher

- 32 GB

- Grafikprozessor

- IGP

- Display

- Philips

- Soundkarte

- onBoard

- Netzteil

- 850 Watt

- Betriebssystem

- Manjaro / Ubuntu

- Webbrowser

- Epiphany

Das ganze klimmpimps um die Spannungsversorgung versteh ich eh nicht wirklich. Rein von der Technischen Seite reicht eine 6 polige Leitung locker für 1200 Watt. Bei einer 2,5 mm² Zuleitung Länge 1 Meter. Werte mit Wechselstrom da dürfte noch nichts abfackeln.

Das meiste wird bei der Buchse und Platine vermurkst.

Bei guten Netzteilen braucht man sich da keinen Kopf über Lötstellen und Anschlüsse zu machen. Die sind vom Fach.

- Spannungsfall: 4,46 % bzw. 0,54 V

- nutzbare Spannung: 11,46 V

- Verlustleistung: 53,57 W

Das meiste wird bei der Buchse und Platine vermurkst.

Bei guten Netzteilen braucht man sich da keinen Kopf über Lötstellen und Anschlüsse zu machen. Die sind vom Fach.

Zuletzt bearbeitet:

too hot

www.pcgameshardware.de

www.pcgameshardware.de

Geforce RTX 4090: Auch 16-Pin-Stromadapter von nativem ATX 3.0 Netzteil schmilzt

Selbst bei Netzteilen mit nativem ATX 3.0, die spezifisch für den 12VHPWR-Anschluss ausgelegt sind, geraten mit der Geforce RTX 4090 in Brandgefahr.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich verstehe gerade nicht was das Netzteil für einen Unterschied machen soll wenn die Karte nicht direkt sondern weiterhin per Adapter angeschlossen wird.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.854

- Renomée

- 2.814

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Da wird sich nVidia aber freuen:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.355

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Endlich mal einer der den Stromanschluss da platziert hat damit man das Gehäuse bei den Meisten auch schließen könnte.

Schade für die Geforce Kundschaft das es diese Karte nicht geben wird.

Schade für die Geforce Kundschaft das es diese Karte nicht geben wird.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.854

- Renomée

- 2.814

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Corsair’s PSU Expert Jonny Guru Weighs in on Nvidia Connector-Gate (tom's Hardware)

Ja der dumme Anwender ist schuld.

Ja der dumme Anwender ist schuld.

hoschi_tux

Grand Admiral Special

- Mitglied seit

- 08.03.2007

- Beiträge

- 4.760

- Renomée

- 286

- Standort

- Ilmenau

- Aktuelle Projekte

- Einstein@Home, Predictor@Home, QMC@Home, Rectilinear Crossing No., Seti@Home, Simap, Spinhenge, POEM

- Lieblingsprojekt

- Seti/Spinhenge

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 5900X

- Mainboard

- ASUS TUF B450m Pro-Gaming

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x 16GB Crucial Ballistix Sport LT DDR4-3200, CL16-18-18

- Grafikprozessor

- AMD Radeon RX 6900XT (Ref)

- Display

- LG W2600HP, 26", 1920x1200

- HDD

- Crucial M550 128GB, Crucial M550 512GB, Crucial MX500 2TB, WD7500BPKT

- Soundkarte

- onboard

- Gehäuse

- Cooler Master Silencio 352M

- Netzteil

- Antec TruePower Classic 550W

- Betriebssystem

- Gentoo 64Bit, Win 7 64Bit

- Webbrowser

- Firefox

Klarer Fall von "you're holding bending inserting it wrong"..

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.854

- Renomée

- 2.814

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Ähnliche Themen

- Antworten

- 1K

- Aufrufe

- 70K

- Antworten

- 226

- Aufrufe

- 24K

- Antworten

- 2K

- Aufrufe

- 112K

- Antworten

- 51

- Aufrufe

- 7K

- Antworten

- 53

- Aufrufe

- 5K