App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

NVIDIA - Pascal

- Ersteller Morkhero

- Erstellt am

Die Zuwächse für NV beim neuen 3D Mark kommen mutmaßlich davon, dass hier Concurrency mit Context Switches genutzt wird, nicht das was bisher Asynchronous Compute eigentlich ist. Futuremark bestreitet das, aber man darf gespannt sein, ob das Dementi dann Substanz hat. Die Analyse von mahigan liest sich jedenfalls sehr glaubwürdig.

Es bleibt also wohl dabei: NV hat gute OpenGL- und DX11-Treiber, dafür profitiert AMD stärker von den NextGen-APIs, wenn sie denn ordentlich implementiert werden. (Was seltsamerweise bei Gameworks-/TWIMTBP-Titeln problematischer zu sein scheint, als bei anderen....=

Es bleibt also wohl dabei: NV hat gute OpenGL- und DX11-Treiber, dafür profitiert AMD stärker von den NextGen-APIs, wenn sie denn ordentlich implementiert werden. (Was seltsamerweise bei Gameworks-/TWIMTBP-Titeln problematischer zu sein scheint, als bei anderen....=

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

@gruffi

weis nicht ob das so unverständlich ist, aber ich erwarte in einem thread mit der überschrift nvidia pascal, genau da drüber etwas zu erfahren. komme mir hier vor wie in einem kindergarten.

bin weder für die eine firma noch für die andere, aber ich habe nunmal interesse an pascal. meine kiste ist uralt und es soll halt das nächste mal eine karte von nvidia werden. das ist meine eigene entscheidung. nur deswegen verteufele ich noch lange nicht amd.

wahrscheinlich hätte ich das in beitrag 338 mit der 1 nicht kleiner sondern größer darstellen sollen. am besten wir machen noch einen amd vs nvidia thread auf und dann können sich alle pausenlos die köpfe einschlagen. oder die moderation fügt rubriken ein die in hersteller unterteilen.

weis nicht ob das so unverständlich ist, aber ich erwarte in einem thread mit der überschrift nvidia pascal, genau da drüber etwas zu erfahren. komme mir hier vor wie in einem kindergarten.

bin weder für die eine firma noch für die andere, aber ich habe nunmal interesse an pascal. meine kiste ist uralt und es soll halt das nächste mal eine karte von nvidia werden. das ist meine eigene entscheidung. nur deswegen verteufele ich noch lange nicht amd.

wahrscheinlich hätte ich das in beitrag 338 mit der 1 nicht kleiner sondern größer darstellen sollen. am besten wir machen noch einen amd vs nvidia thread auf und dann können sich alle pausenlos die köpfe einschlagen. oder die moderation fügt rubriken ein die in hersteller unterteilen.

eine Diskussion ist so lange zielführend, wie beide Seiten bereit sind, die Argumente der anderen Partei anzuhören und gegebenenfalls gelten zu lassen. Ist das nicht der Fall, wird aus der Diskussion ein wiederkäuen von immer gleichen Strukturen ohne Zweck (abgesehen von der Befriedigung des Egos).

Also lasst bitte die öffentlichen Diskussionen zu " wer findet was gut und wer findet was schlecht", wenn es nichts mit Pascal zu tun hat und Substanz hat.

Also lasst bitte die öffentlichen Diskussionen zu " wer findet was gut und wer findet was schlecht", wenn es nichts mit Pascal zu tun hat und Substanz hat.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Ja dann erzähl das bitte den Leuten, die zu Roy Taylor abdriften, ihn als Witzfigur bezeichnen, permanent über die Leistungsaufnahme bei AMD herziehen und dergleichen. Erzähl das nicht mir. Ich halte mich normalerweise auch ans Threadthema, sofern eben Kleingeister wie MickFoley nicht immer wieder rumstänkern würden. Irgendwann wird's dann auch mir zu viel.weis nicht ob das so unverständlich ist, aber ich erwarte in einem thread mit der überschrift nvidia pascal, genau da drüber etwas zu erfahren. komme mir hier vor wie in einem kindergarten.

Stefan Payne

Grand Admiral Special

Doch, tut man.Das Gedisse wird langsam lächerlich. Mit Schrott, Betrug, Vaporware, Abzocke etc. erobert man sich kein 80 % Marktanteil.

http://www.3dcenter.org/news/die-grafikchip-und-grafikkarten-marktanteile-im-vierten-quartal-2015

Denn schau mal in die Vergangenheit, was sich da so durchgesetzt hat, was gekauft wurde...

Jetzt könnte man VHS gegenüber den anderen Formaten anführen, so als Beispiel...

Und es zählt eben nicht immer die technische Qualität sondern der Glauben der Leute an die Produkte. Und das ist hier ja leider vorhanden...

Dazu eben auch solche unlauteren Dinge wie PhysX und Gameworks...

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

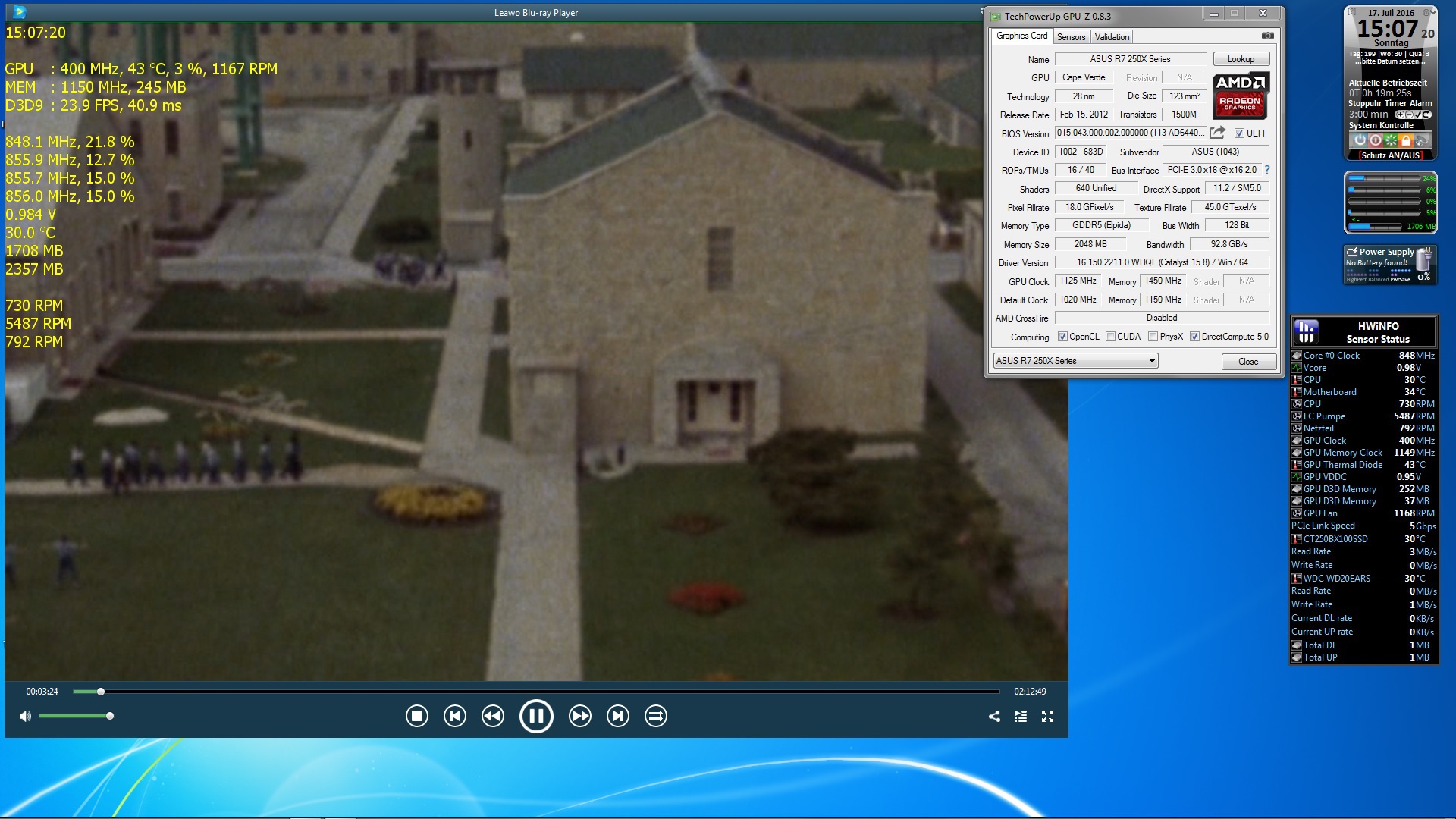

Warum man einen derart hohen Strombedarf beim einfachen Abspielen eine Blu-Ray so hohe Powerstates fahren muss? Ich weiß es nicht.

Ich auch nicht,bis jetzt ging der VRAM immer auf max Takt hoch wo die GPU doch Unten bleibt.

Es ist ein Ram Problem,NUR warum bleibt der nicht unten oder Taktet nur geringfügig hoch?

Der Ram wie ja auch bei der RX 480 ist seit Jahren das große Problem das er einen hohen Verbrauch hat,immer wieder auf Max Taktet......Stellt man diesen manuell runter,geht auch der Verbrauch Deutlich runter.

Ich mein in meiner HD7950 ist der Ram in Stufen hinterlegt,Taktet aber bei Verwendung immer mit Max Takt.......

So langsam vermute ich ein Software/Programm Problem.......das AMD hier mal wieder nicht richtig Unterstützt wird.

Locuza

Commodore Special

- Mitglied seit

- 03.03.2011

- Beiträge

- 351

- Renomée

- 3

Fast überall überlegen schließt wohl Conservative Rasterization, ROVs, einen Hybrid Intermediate/Tiled-Renderer, Volume Tiled Resources, einen Perf/Watt Vorsprung von ~50% mit ein und einigen weiteren Dingen, wie Tessellation, die Delta-Color-Compression oder die Perf/mm².Aufholen heisst aber noch lange nicht vorne sein.AMD ist Nvidia im Moment architektonisch fast überall überlegen. Das wird sich auch erst mal nicht so schnell ändern. Das kuriose ist ja, selbst bei Nvidias einstigen Stärken, wie Computing, ist AMD mittlerweile überlegen. Vorne ist Nvidia eigentlich nur bei Sachen, die keiner wirklich braucht, wie Übertessellierung. Und wenn Volta kommt, dann hat AMD auch schon wieder Neues am Start. Sollte man auch nicht vergessen.

Es gibt so vieles was man vergleichen könnte.

Bei Compute ist AMD seit GCN vorne, dass ist schon 4 Jahre her.

Ein Feld wo aber Nvidia sehr stark mit Maxwell aufgeholt hat und mit Pascal etwas verbessert, nachdem Kepler sehr schwach unter Compute war.

AMD muss zusehen, dass sie ihre Nachfolgeprodukte schneller auf den Markt bringen und die Architektur auch zügiger und mit größeren Schritten verbessern.

Nvidia hat mächtig aufgeholt in vielen Bereichen, in anderen überholt, ihr R&D ist verdammt groß und ich bin wenig optimistisch gestimmt das mit Vega/Navi AMD Nvidia wieder auf Augenhöhe begegnen kann.

Ich hoffe ja das Vega positiv überrascht, aber Hoffnungen bei AMD sind meistens zerplatzte Träume.

Da würde ich nicht zustimmen.Die Zuwächse für NV beim neuen 3D Mark kommen mutmaßlich davon, dass hier Concurrency mit Context Switches genutzt wird, nicht das was bisher Asynchronous Compute eigentlich ist. Futuremark bestreitet das, aber man darf gespannt sein, ob das Dementi dann Substanz hat. Die Analyse von mahigan liest sich jedenfalls sehr glaubwürdig.

[...]

Der Entwickler hat keine direkte Kontrolle darüber, wie die Anwendung sein Multiengine-Konstrukt konsumiert, die Hardware führt es vielleicht parallel aus oder auch nicht.

Die Kontrolle erfolgt höchstens indirekt, indem der Entwickler seine Compute- und Grafik-Pipeline immer hin und her springen lässt und einen Context-Switch je nach Hardware triggert.

Einen Context-Switch will man dabei aber natürlich in den meisten Fällen vermeiden, dass ergibt keinen Sinn wieso Pascal dadurch gewinnen sollte, im Gegensatz zu Maxwell verliert er dadurch aber wesentlich weniger Performance.

Was man bei der ganzen Geschichte erreichen will sind natürlich verkürzte Idle-Zeiten, indem unterschiedliche Anwendungsbereiche gemixt werden, die unterschiedliche Flaschenhälse aufweisen, so kann die Hardware mit zusätzlichen Compute-Queues flexibler mögliche Idle-Units auslasten.

Die Time-Spy Demo hat das gut hinbekommen, die Zuwächse bei CB bewegen sich bei 9-17% für die Radeons, dass ist von den bisherigen PC-Spielen, wo man es testen kann oder es Entwickleraussagen gibt, die Spitze der Ergebnisse.

3D Mark gibt in ihrer Dokumentation auch an, welche Aufgabenbereiche sie überlappen:

Lighting is evaluated using a tiled method in multiple separate passes.

Before the main illumination passes, asynchronous compute shaders are used to cull lights, evaluate illumination from prebaked environment reflections, computescreen-space ambient occlusion, and calculate unshadowed surface illumination.

These tasks are started right after G-buffer rendering has finished and are executed alongside shadow rendering. All frustum lights, omni-lights and reflection capture probes are culled to small tiles (16x16 pixels) and written to an intermediate buffer.

http://s3.amazonaws.com/download-aws.futuremark.com/3DMark_Technical_Guide.pdfParticles

Particles are simulated on the GPU using asynchronous compute queue.

Simulation work is submitted to the asynchronous queue while G-buffer and shadow map rendering commands are submitted to the main command queue.

Bezüglich Async Compute haben so viele Entwickler schon das Beispiel genannt, zusätzliche Compute-Queues neben dem Shadow-Map-Rendering laufen zu lassen, da hier die ROPs limitieren und die ALUs wenig ausgelastet werden.

Mente

Grand Admiral Special

- Mitglied seit

- 23.05.2009

- Beiträge

- 3.671

- Renomée

- 135

- Aktuelle Projekte

- constalation astroids yoyo

- Lieblingsprojekt

- yoyo doking

- Meine Systeme

- Ryzen 3950x

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD 5800X3D

- Mainboard

- Asus ROG Crosshair VIII Dark Hero

- Kühlung

- Headkiller IV

- Speicher

- 3800CL14 G.Skill Trident Z silber/rot DIMM Kit 32GB, DDR4-3600, CL15-15-15-35 (F4-3600C15D-16GTZ)

- Grafikprozessor

- AMD Radeon RX 6900 XT Ref. @Alphacool

- Display

- MSI Optix MAG27CQ

- SSD

- SN8502TB,MX5001TB,Vector150 480gb,Vector 180 256gb,Sandisk extreme 240gb,RD400 512gb

- HDD

- n/a

- Optisches Laufwerk

- n/a

- Soundkarte

- Soundblaster X4

- Gehäuse

- Phanteks Enthoo Pro 2 Tempered Glass

- Netzteil

- Seasonic Prime GX-850 850W

- Tastatur

- Logitech G19

- Maus

- Logitech G703

- Betriebssystem

- Win 10 pro

- Webbrowser

- IE 11 Mozilla Opera

- Verschiedenes

- Logitech PRO RENNLENKRAD DD

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Nein. Ich habe ja nicht gesagt, dass AMD da überall überlegen wäre. Genauso wenig wie Nvidia. Mal davon abgesehen macht es keinen Sinn, sich an einzelnen Features wie ROV aufzuhängen. Ich sehe es im Grossen und Ganzen. Und so war auch meine Aussage gemeint. Im Moment spricht vermeintlich nur Perf/Watt unter Spielen für Nvidia. Aber auch das bleibt erst mal abzuwarten bis die kleineren Polaris und Vega kommen, die mehr auf Effizienz getrimmt sind. Ansonsten sehe ich nichts was für Nvidia spricht. Perf/Watt unter Computing spricht für AMD. Unterstützung neuer Speichertechnologien spricht für AMD, siehe HBM. Bessere Unterstützung von neuen APIs spricht für AMD. Daran ändert auch ROV zB nichts. BQ spricht für AMD wie man anhand diverser In-Game Videovergleiche immer wieder sehen kann. Ob Nvidia absichtlich weniger Details rendert, um künstlich die FPS zu erhöhen, oder die Hardware einfach nicht mehr hergibt, sei mal dahingestellt. Der Softwaresupport spricht für AMD. Sachen wie TressFX sind nicht nur offen, sondern auch effizient implementiert. Das kann man von GameWorks zB nicht sagen. Wenn man sich insgesamt den Funktionsumfang bei AMD anschaut, von Eyefinity über TrueAudio bis hin zu VR, ich sehe da ein besseres Gesamtpaket als bei Nvidia. Was ich aber nicht sehe ist ein Nachweis, dass Nvdia besser bei DCC wäre. Oder willst du nur wieder irgendwelche nichtssagenden Balkendiagramme bringen, die maximal zeigen, dass Nvidia verhältnismässig schlecht bei Schwarzkompression ist?Fast überall überlegen schließt wohl Conservative Rasterization, ROVs, einen Hybrid Intermediate/Tiled-Renderer, Volume Tiled Resources, einen Perf/Watt Vorsprung von ~50% mit ein und einigen weiteren Dingen, wie Tessellation, die Delta-Color-Compression oder die Perf/mm².

Es gibt so vieles was man vergleichen könnte.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif) Ähnliches gilt für Tessellation. Was soll denn da für sie sprechen? Nvidia kann lediglich besser übertessellieren. Geschenkt, weil's niemand wirklich braucht.

Ähnliches gilt für Tessellation. Was soll denn da für sie sprechen? Nvidia kann lediglich besser übertessellieren. Geschenkt, weil's niemand wirklich braucht.Aufgrund der Vergleiche, die ich mir bisher angeschaut habe, scheint Pascal bei Computing teilweise sogar langsamer als Maxwell zu sein bzw im Vergleich zu Spielen weniger zuzulegen. Im Luxmark Test hier ist die GTX 1080 Simple/Complex zB 20/45% schneller als eine GTX 980, obwohl es bei Spielen im Schnitt etwa 60% sind. Also ich sehe da noch lange nicht, wo Pascal etwas bei Computing verbessert haben soll.Bei Compute ist AMD seit GCN vorne, dass ist schon 4 Jahre her.

Ein Feld wo aber Nvidia sehr stark mit Maxwell aufgeholt hat und mit Pascal etwas verbessert, nachdem Kepler sehr schwach unter Compute war.

Wieso? Damit sie Nvidia architektonisch noch weiter davonziehen? Im Moment ist erst mal Nvidia wieder unter Zugzwang. Polaris verkauft sich anscheinend prächtig. Das zählt vor allem für AMD, Absätze und Marktanteile bei dGPUs wieder zu steigern. Mit Glofo hat man auch genügend Kapazitäten. Die hat Nvidia bei TSMC nicht. Und keine Sorge, AMD wird schon zusehen, Nachfolgeprodukte beizeiten auf den Markt zu bringen. Womöglich kommt Vega früher als es Nvidia lieb ist.AMD muss zusehen, dass sie ihre Nachfolgeprodukte schneller auf den Markt bringen und die Architektur auch zügiger und mit größeren Schritten verbessern.

In welchen Bereichen haben sie denn seit GCN überholt? Ich sehe da ehrlich gesagt nichts. Ich sehe nur, dass sie sich in den letzten Jahren voll auf DX11 Gaming konzentriert haben. Dafür sind sie in allen anderen Bereichen stagniert oder weiter zurückgefallen, wie bei Konsolen, DX12/Vulkan oder Computing.Nvidia hat mächtig aufgeholt in vielen Bereichen, in anderen überholt

So gross nun auch wiederum nicht. Und wenn sie Unmengen davon in den Sand setzen, wie mit Tegra oder Shield, dann schmilzt das effektive R&D Budget deutlichst. Ausserdem denke ich, dass AMD trotz im Moment weniger R&D Budget einiges an signifikanten Vorteilen hat. Wie zB CPU Know-How, welches auch in die GPU-Entwicklung einfliesst.ihr R&D ist verdammt groß

Auf Augenhöhe? Warum sollte sich AMD zurückentwickeln? Ergibt doch gar keinen Sinn. Ich tippe eher darauf, dass man mit Vega und Navi architektonisch weiter vorangehen wird.und ich bin wenig optimistisch gestimmt das mit Vega/Navi AMD Nvidia wieder auf Augenhöhe begegnen kann.

Das ist aber nur deine Meinung. Zerplatzte Träume sehe ich bei Nvidia nicht weniger. Nvidias Produkte und Produktpolitik enttäuschen mich seit nunmehr fast 7 Jahren. Seitdem habe ich keine für mich annehmbare Karte mehr in deren Portfolio gefunden. Das trifft in den etwa zwei letzten Jahren zwar auch auf AMD zu. Allerdings gab es davor attraktive Karten und mit Polaris/Vega sehe ich neue.Ich hoffe ja das Vega positiv überrascht, aber Hoffnungen bei AMD sind meistens zerplatzte Träume.

Stefan Payne

Grand Admiral Special

Not really...Bei Compute ist AMD seit GCN vorne, dass ist schon 4 Jahre her.

Ein Feld wo aber Nvidia sehr stark mit Maxwell aufgeholt hat und mit Pascal etwas verbessert, nachdem Kepler sehr schwach unter Compute war.

Für diverse Chryptowährungen nutzt man immer noch ausschließlich AMD GPUs und keine nVidia.

So sagte mir heute jemand, dass bei Ethereon die RX480 sogar flotter denn die 1080 sein soll.

Und dass nVidia so weit vorn zu sein scheint, liegt schlicht an den Treiberoptimierungen, die man, wenn man böse wäre (was hier keiner momentan ist), auch als Cheats bezeichnen könnte. Das ganze fällt dann auch sehr stark ab, im Vergliech zu 'den anderen', so dass man besser NICHT nVidia kauft...

Mächtig aufgeholt in vielen Bereichen?!Nvidia hat mächtig aufgeholt in vielen Bereichen, in anderen überholt, ihr R&D ist verdammt groß und ich bin wenig optimistisch gestimmt das mit Vega/Navi AMD Nvidia wieder auf Augenhöhe begegnen kann.

Ähm, nee. Man gammelt immer noch mit der immer wieder aufgehübschten G80 Architektur rum. GCN hingegen ist neu und frisch.

Auch vergisst du, dass das R&D bei nVidia zwar größer zu sein scheint, sie aber es auch für den ganzen Müll, den sie so verbreiten, verwenden. Darunter Gameworks, CUDA, der G-Sync Mist. Und wahrscheinlich sind auch die 'Überzeugungen' diverser Publisher im R&D Budget drin...

Ich verstehe nicht, warum du hier so stark Vorteile, die die AMD Hardware so hat, unter den Tisch zu kehren versuchst. Und so sehr versuchst, die nVidia Hardware als besser/überlegener hinzustellen, was einfach nicht so ganz korrekt ist.

Insbesondere in Performancesteigernden Dingen wie Asynchrounous Compute sind sie ziemlich weit hinten, hier hat AMD echt was geschaffen, was für nVidia ein Sargnagel bzw eine zweite Geforce FX Serie werden kann.

Und das Ansehen von denen bröckelt dank der einen Karte, mit denen sie die Leute nach Strich und Faden verarscht haben, eh...

Wenn, dann solltest du dir Sorgen um nVidia machen!

Denn wenn DIE sich nicht ändern, ist haben DIE bald ein Problem!

Die Konsolen sind 100% in Hand von AMD, das wird so langsam Früchte Tragen, insbesondere was Optimierungen auf die Hardware betrifft. Dazu kommt, dass nVidia sich wie 'ne Axt im Walde gegenüber Developern/Publishern verhalten hat...

Da haben dann einige Leute einfach keinen Bock mehr, intensiv mit denen zusammen zu arbeiten...

DAS darfst du auch nicht vergessen. Auch wie sehr der Witcher 3 Chef Entwickler, im Rahmen seiner Möglichkeiten, sich über Gameworks und co geäuert hat...

Die Aussage, dass das eine 'Business Entscheidung' wäre, deutet ja wohl klar hin, dass er die Idee einfach nur grottig findet, es aber nicht sagen darf, findest du nicht auch?!

und auch was man so mit Gameworks gemacht hat, ist ziemlich übel.

Da haben viele Entwickler die Meinung vertreten, dass das einfach völliger Bullshit ist, was sie da machen, da das einfach ein furchtbar ineffizienter Weg ist, der halt schlechter auf AMD läuft...

nVidia sollte erst mal von seinem hohen Ross runter kommen und sich weniger aus dem Fenster lehnen, wenn sie auch in 10 Jahren noch existieren wollen...

Denn alle Anstrengungen, die sie in anderen Bereichen unternommen haben, sind gescheitert. Da hat man schlicht viel Geld verbrannt...

Tegra ist einer davon (und komme mir bitte nicht mit dem Automotive Bullshit...)

Und auch Gameworks ist glücklicherweise ziemlich gescheitert, DX12, Vulkan und co sei dank...

nVidia hat sich einfach auf ihren Lohrbeeren ausgeruht und ist gerade von allen Seiten unter Beschuss! Im HPC Markt werden sie von Intel angegriffen, im GPU Markt von AMD. Wenn AMD es gelingt, einige Marktanteile zurück zu erobern, hat nVidia ein ernsthaftes Problem. Denn mehr als GPUs haben die echt nicht.

Und AMD hat immer noch die CPUs, die deutlich wichtiger sind als GPUs...

RICHTHOFEN

Admiral Special

- Mitglied seit

- 07.12.2001

- Beiträge

- 1.086

- Renomée

- 8

[3DC]Payne;5106040 schrieb:Not really...

Für diverse Chryptowährungen nutzt man immer noch ausschließlich AMD GPUs und keine nVidia.

So sagte mir heute jemand, dass bei Ethereon die RX480 sogar flotter denn die 1080 sein soll.

Und dass nVidia so weit vorn zu sein scheint, liegt schlicht an den Treiberoptimierungen, die man, wenn man böse wäre (was hier keiner momentan ist), auch als Cheats bezeichnen könnte. Das ganze fällt dann auch sehr stark ab, im Vergliech zu 'den anderen', so dass man besser NICHT nVidia kauft...

Mächtig aufgeholt in vielen Bereichen?!

Ähm, nee. Man gammelt immer noch mit der immer wieder aufgehübschten G80 Architektur rum. GCN hingegen ist neu und frisch.

Auch vergisst du, dass das R&D bei nVidia zwar größer zu sein scheint, sie aber es auch für den ganzen Müll, den sie so verbreiten, verwenden. Darunter Gameworks, CUDA, der G-Sync Mist. Und wahrscheinlich sind auch die 'Überzeugungen' diverser Publisher im R&D Budget drin...

Ich verstehe nicht, warum du hier so stark Vorteile, die die AMD Hardware so hat, unter den Tisch zu kehren versuchst. Und so sehr versuchst, die nVidia Hardware als besser/überlegener hinzustellen, was einfach nicht so ganz korrekt ist.

Insbesondere in Performancesteigernden Dingen wie Asynchrounous Compute sind sie ziemlich weit hinten, hier hat AMD echt was geschaffen, was für nVidia ein Sargnagel bzw eine zweite Geforce FX Serie werden kann.

Und das Ansehen von denen bröckelt dank der einen Karte, mit denen sie die Leute nach Strich und Faden verarscht haben, eh...

Wenn, dann solltest du dir Sorgen um nVidia machen!

Denn wenn DIE sich nicht ändern, ist haben DIE bald ein Problem!

Die Konsolen sind 100% in Hand von AMD, das wird so langsam Früchte Tragen, insbesondere was Optimierungen auf die Hardware betrifft. Dazu kommt, dass nVidia sich wie 'ne Axt im Walde gegenüber Developern/Publishern verhalten hat...

Da haben dann einige Leute einfach keinen Bock mehr, intensiv mit denen zusammen zu arbeiten...

DAS darfst du auch nicht vergessen. Auch wie sehr der Witcher 3 Chef Entwickler, im Rahmen seiner Möglichkeiten, sich über Gameworks und co geäuert hat...

Die Aussage, dass das eine 'Business Entscheidung' wäre, deutet ja wohl klar hin, dass er die Idee einfach nur grottig findet, es aber nicht sagen darf, findest du nicht auch?!

und auch was man so mit Gameworks gemacht hat, ist ziemlich übel.

Da haben viele Entwickler die Meinung vertreten, dass das einfach völliger Bullshit ist, was sie da machen, da das einfach ein furchtbar ineffizienter Weg ist, der halt schlechter auf AMD läuft...

nVidia sollte erst mal von seinem hohen Ross runter kommen und sich weniger aus dem Fenster lehnen, wenn sie auch in 10 Jahren noch existieren wollen...

Denn alle Anstrengungen, die sie in anderen Bereichen unternommen haben, sind gescheitert. Da hat man schlicht viel Geld verbrannt...

Tegra ist einer davon (und komme mir bitte nicht mit dem Automotive Bullshit...)

Und auch Gameworks ist glücklicherweise ziemlich gescheitert, DX12, Vulkan und co sei dank...

nVidia hat sich einfach auf ihren Lohrbeeren ausgeruht und ist gerade von allen Seiten unter Beschuss! Im HPC Markt werden sie von Intel angegriffen, im GPU Markt von AMD. Wenn AMD es gelingt, einige Marktanteile zurück zu erobern, hat nVidia ein ernsthaftes Problem. Denn mehr als GPUs haben die echt nicht.

Und AMD hat immer noch die CPUs, die deutlich wichtiger sind als GPUs...

AMD verbrennt mit den CPUs mindestens genausoviel Geld wie Nvidia bei dem ein oder anderen Bereich. Eher sogar mehr. Also das würde mich nicht beruhigen

Dresdenboy

Redaktion

☆☆☆☆☆☆

Moving goalposts.Es geht doch nicht um 30 Watt, sondern beispielsweise um 100 bis 150 Watt, schaut man sich AMD´s r9 390x gegen Nvidias GTX 980 an, oder eben die r9290 gegen GTX970.

Um dich mal hier zu unterstützen, da ja frische GTX 1060-Werte eintrudeln:Zudem geht es auch um Kühlung und Lautstärke und um den Punkt dass ein niedrigerer Strombedarf hier offenbar kein Vorteil sein darf. ( Wieso eigentlich? )

Um mal ein Rechenbeispiel anzuführen. 125 Watt bei geringen 2 Stunden Spielelast pro Tag ergeben bei 28cent pro Kilowattstunde mal eben knapp 26 Euro im Jahr.

Einfach unnötig mal eben 50 Euro mehr auszugeben wenn man eine Karte 2 Jahre betreibt. Da sinkt die Preisleistung des Gerätes/derKarte doch schonmal deutlich.

http://www.guru3d.com/articles_pages/geforce_gtx_1060_review,8.html

Dort im Review braucht mit dem dort angenommenen kWh-Preis (hier ja eher schon fast 0,30€/kWh) nur 32€ an Strom pro Jahr für die gesamte Grafikkarte (5d/Woche, 4h/d). Was fehlt, ist natürlich der erhöhte Verbrauch des Restsystems.

Aber wenn nur die GPU ausgetauscht wird u. z.B. 30W mehr braucht, käme man selbst mit 0,30€/kWh auf 9,36€ mehr pro Jahr.

Captn-Future

Moderation DC, P3DN Vize-Kommandant

- Mitglied seit

- 16.08.2004

- Beiträge

- 8.430

- Renomée

- 313

- Standort

- VIP Lounge

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- QMC, Simap

- Lieblingsprojekt

- QMC

- Meine Systeme

- X4 940 BE

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Intel Xeon E3-1230v2

- Mainboard

- GA-Z77-UD3

- Kühlung

- Thermalright Macho Rev. A

- Speicher

- 16 GB Kingston blue

- Grafikprozessor

- Gigabyte GTX 660

- Display

- HP ZR2440w 1920x1200

- SSD

- Samsung SSD 830 256 GB

- HDD

- WD Blue 1 TB

- Optisches Laufwerk

- LG GSA-H10N

- Gehäuse

- LianLi V1000 Silber

- Netzteil

- Cougar SE400

- Betriebssystem

- Windows 7

- Webbrowser

- FireFox

Persönlich finde ich 30 Watt bei 300 Watt Gesamtsystem nicht so tragisch. Interessant wird es wenn wir über 120 zu 150 Watt reden. Aber auf was beziehen sich die 30 Watt denn überhaupt? Netzseite, Grafikkarte allein. Auch die Wandlung aus dem Netz hat ja einen Wirkungsgrad. Viel mehr als 80-85% wird es da nicht. Auch die Spannungswandler auf dem Board die aus 5/12 Volt 3,3V machen haben Verluste. (Kann natürlich sein, dass der Hauptteil aus der 12V Schiene kommt die eh nur durchgeleitet wird. Aber dann werden aus 30W auf der Garfikkarte schnell 38-40W am Netzteil. (Ist im Verhältnis zum Restsystem immer noch wenig). Bei mir daheim unterm Dach merke ich im Sommer aber jedes Watt dank guter Wärmedämmung und der Aufheizung durch die Sonne.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Was wurde im Vorfeld über die GTX 1060 nochmal gehyped? "Much faster than an RX 480", mit über 15% Vorsprung? Und was sehen wir jetzt nach dem Launch? Gerade mal gut %5 Vorsprung. Was in einem Jahr vermutlich 5% Rückstand bedeutet, so wie Nvidia seine einstigen Sprösslinge mit Treibersupport versorgt. Soviel zum Thema zerplatzte Träume, die einige ja gerne nur AMD andichten wollen. ![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

Bin eher geschockt, dass im Computerbase Test bei ANNO 2205 die MSI GeForce GTX 1060 Gaming mit 221W Gesamtsystem mehr schluckt als die RX 480 (215 W Gesamtsystem)

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

@Casi030

Schon klar. Ich hab ja jetzt auch nur die Referenzmodelle verglichen. Unter DX12/Vulkan zieht die RX 480 eh schon davon und spielt ihre Stärken aus. Irgendwie hab ich das Gefühl, dass selbst die RX 470 unter DX12/Vulkan schneller als die GTX 1060 wird, bei ähnlicher Leistungsaufnahme und ein Drittel geringerem Preis. Ist aber nur ein Gefühl.

@amdfanuwe

Auch deshalb halte ich nix davon, ständig mit der Leistungsaufnahme der Referenzkarten irgendwelcher Reviews zu argumentieren. So wie MickFoley das getan hat und Gegenargumenten resistent zu sein scheint. Jedes Spiel kann sich unterschiedlich verhalten. Reviews können da nur einen sehr kleinen und spezifischen Einblick geben. und Partnerkarten sind eben noch mal was anderes, sowohl im positiven als auch negativen Sinn. Man sollte auch nicht vergessen, Anno 2205 ist so ziemlich mit das extremste Szenario pro Nvidia. Da ist in den CB Tests selbst die MSI GeForce GTX 970 Gaming schneller als eine Fury X. Ich vermute mal stark, die Radeons werden dort einfach nicht gut ausgelastet und lassen einiges an Performance liegen. Was natürlich auch die Leistungsaufnahme drückt. Von nix kommt halt nix.

Schon klar. Ich hab ja jetzt auch nur die Referenzmodelle verglichen. Unter DX12/Vulkan zieht die RX 480 eh schon davon und spielt ihre Stärken aus. Irgendwie hab ich das Gefühl, dass selbst die RX 470 unter DX12/Vulkan schneller als die GTX 1060 wird, bei ähnlicher Leistungsaufnahme und ein Drittel geringerem Preis. Ist aber nur ein Gefühl.

@amdfanuwe

Auch deshalb halte ich nix davon, ständig mit der Leistungsaufnahme der Referenzkarten irgendwelcher Reviews zu argumentieren. So wie MickFoley das getan hat und Gegenargumenten resistent zu sein scheint. Jedes Spiel kann sich unterschiedlich verhalten. Reviews können da nur einen sehr kleinen und spezifischen Einblick geben. und Partnerkarten sind eben noch mal was anderes, sowohl im positiven als auch negativen Sinn. Man sollte auch nicht vergessen, Anno 2205 ist so ziemlich mit das extremste Szenario pro Nvidia. Da ist in den CB Tests selbst die MSI GeForce GTX 970 Gaming schneller als eine Fury X. Ich vermute mal stark, die Radeons werden dort einfach nicht gut ausgelastet und lassen einiges an Performance liegen. Was natürlich auch die Leistungsaufnahme drückt. Von nix kommt halt nix.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.356

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das kann sich auch ganz schnell mit den neuen APIs mehr als umkehren, siehe Vulkan, DX12 Tests im PCGH Sondertest.Was wurde im Vorfeld über die GTX 1060 nochmal gehyped? "Much faster than an RX 480", mit über 15% Vorsprung? Und was sehen wir jetzt nach dem Launch? Gerade mal gut %5 Vorsprung. Was in einem Jahr vermutlich 5% Rückstand bedeutet, so wie Nvidia seine einstigen Sprösslinge mit Treibersupport versorgt. Soviel zum Thema zerplatzte Träume, die einige ja gerne nur AMD andichten wollen.![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

http://www.pcgameshardware.de/Nvidi...te-264678/Tests/GTX-1060-Review-1201931/2/#a2

Kuroiban

Admiral Special

- Mitglied seit

- 31.05.2008

- Beiträge

- 1.625

- Renomée

- 23

- Mein Laptop

- Asus Nexus 7 2013

- Details zu meinem Desktop

- Prozessor

- AMD Phenom II X6 1090T

- Mainboard

- ZOTAC 890GX-ITX WiFi

- Kühlung

- Corsiar H80+ 2x120mm Nanoxia FX-1250

- Speicher

- 2x 4GB A-Data PC-6400

- Grafikprozessor

- XFX AMD Radeon HD6850 1GB DDR5

- Display

- 21" Iiyama ProLite B2206WS

- SSD

- Curcial M500 250GB

- HDD

- WesternDigital CavierBlack 640GB

- Soundkarte

- M-Audio Fast Track Pro

- Gehäuse

- Bitfenix Prodigy + 140mm Nanoxia FX-1000

- Netzteil

- Antech TruePower New 550W

- Betriebssystem

- Windows 8.1

- Webbrowser

- Chrome

Low Level API Analyse von Golem.de : http://www.golem.de/news/geforce-gt...ingen-direct3d-12-und-vulkan-1607-122214.html

Zugewinne der 1060 sind eher Marginal, teilweise verliert man sogar an Leistung. Entweder muss da nV noch etwas an den Treibern lösen, gerade bei Vulkan, oder es ist doch die Architektur die durch Low Level Zugriff nichts mehr dazu gewinnt da man bereits unter DX11 alles raus hohlen konnte.

Zugewinne der 1060 sind eher Marginal, teilweise verliert man sogar an Leistung. Entweder muss da nV noch etwas an den Treibern lösen, gerade bei Vulkan, oder es ist doch die Architektur die durch Low Level Zugriff nichts mehr dazu gewinnt da man bereits unter DX11 alles raus hohlen konnte.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.356

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Der Effekt ist in den meisten Fällen recht einfach zu erklären.

Nvidia hatte es bislang schlicht besser gepackt die Multicore CPU Schwächen der bisherigen APIs zu kaschieren und konnte deshalb die Leistung der Grafikkarte besser entfalten.

Dieses Manko fällt bei den neuen APIs weitestgehend weg und schon können auch die Radeons deutlich mehr Leistung entfalten und legen deshalb unverhältnismäßig stark zu.

Der einzige andere Grund warum die Karten an Leistung zulegen würde wäre Async Compute, was den Geforce Modellen allerdings recht wenig schmeckt.

Nvidia hatte es bislang schlicht besser gepackt die Multicore CPU Schwächen der bisherigen APIs zu kaschieren und konnte deshalb die Leistung der Grafikkarte besser entfalten.

Dieses Manko fällt bei den neuen APIs weitestgehend weg und schon können auch die Radeons deutlich mehr Leistung entfalten und legen deshalb unverhältnismäßig stark zu.

Der einzige andere Grund warum die Karten an Leistung zulegen würde wäre Async Compute, was den Geforce Modellen allerdings recht wenig schmeckt.

Zuletzt bearbeitet:

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Was ich soweit an "Pascal" interessant finde, sind die hohen ermöglichten Takte bei niedriger Verlustleistung. Hier scheint das "16nm" Verfahren von TSCM gegenüber dem "14nm" LP node von Samsung/GF doch vorteilhafter zu sein.

Im Vergleich zwischen GTX1060 und RX 480 fällt auf, dass die Energieaufnahme in einem ähnlichen Bereich liegt (entgegen aller Marketing- bzw. Unkenrufe), sobald man die mit zu hoher Spannung verkaufte RX 480 in den höheren Power States um ~100mV untertaktet. Noch ein paar Watt für die je Vergleichsmodell 1-2 GB zusätzlichen VRAM einbezogen, und die ursprünglich ~30 Watt Differenz im Stromverbrauch (worauf gerne herumgeritten wird) sind mehr oder weniger im gleichen Bereich.

Zurück zu den Takten: Wenn ein bestimmtes Performance-Niveau das Ziel ist, lässt sich ausgehend von höheren Taktraten die Die-Fläche kleiner auslegen.

Faktisch sieht das nun im Vergleich der Kontrahenten so aus:

Polaris 10: 232mm² | GP106: 200mm²

bzw.:

Unabhängig vom Marketing-Gedöns sehe ich die Karten technisch in einem sehr ähnlichen Performance-Bereich bei Spielen - dass Gameworx/twimtbp nochmals einen ~20% Unterschied herausdrücken, war eigentlich klar, und es bleibt zu hoffen übrig, dass solche Dinge mit DX12 und Vulkan langfristig an Bedeutung (in Reviews/Balkenlänge/Marktanteil) verlieren (wobei es auch da Möglichkeiten geben wird, unter die Gürtellinie zu schlagen).

Abhängig vom Marketing-Gedöns sehe ich die Art und Weise der Käufer-Manipulation schon in den Überschriften der Test-Reviews (siehe 3DC)

"Degen statt Keule" (PCGH), "Effizienzknaller" (GameStar), wobei "Knapper Konter" (Golem) noch am wenigsten wie eine Vorgabe aus der Werbebroschüre klingt. Das muss nicht sein, und ich bin jeden Leid, der sich von solchen Überschriften und den sprachlichen Verbiegungen und Suggestionen im Text beeinflussen lässt.

Im Vergleich zwischen GTX1060 und RX 480 fällt auf, dass die Energieaufnahme in einem ähnlichen Bereich liegt (entgegen aller Marketing- bzw. Unkenrufe), sobald man die mit zu hoher Spannung verkaufte RX 480 in den höheren Power States um ~100mV untertaktet. Noch ein paar Watt für die je Vergleichsmodell 1-2 GB zusätzlichen VRAM einbezogen, und die ursprünglich ~30 Watt Differenz im Stromverbrauch (worauf gerne herumgeritten wird) sind mehr oder weniger im gleichen Bereich.

Zurück zu den Takten: Wenn ein bestimmtes Performance-Niveau das Ziel ist, lässt sich ausgehend von höheren Taktraten die Die-Fläche kleiner auslegen.

Faktisch sieht das nun im Vergleich der Kontrahenten so aus:

Polaris 10: 232mm² | GP106: 200mm²

bzw.:

Kommentar von https://www.reddit.com/r/nvidia/comments/4tntvx/nvidias_die_size_advantage_rx_480_vs_gtx_1060/, wo die Situation aus wirtschaftlicher Sicht gegenübergestellt wird. Anm. dazu: Auch wenn mir der Tonfall nicht besonders gefällt, bestätigt der Inhalt doch so meine altgepflegte Sichtweise: im Lager AMD die verspielten Techniker, im Lager nVidia die knallharten Business- und Marketing-Strategen.Polaris 10: 102 dies per 200mm wafer (14.33mm x 16.19mm each). GP106: 119 dies per 200mm wafer (11.67mm x 17.13mm each)

Unabhängig vom Marketing-Gedöns sehe ich die Karten technisch in einem sehr ähnlichen Performance-Bereich bei Spielen - dass Gameworx/twimtbp nochmals einen ~20% Unterschied herausdrücken, war eigentlich klar, und es bleibt zu hoffen übrig, dass solche Dinge mit DX12 und Vulkan langfristig an Bedeutung (in Reviews/Balkenlänge/Marktanteil) verlieren (wobei es auch da Möglichkeiten geben wird, unter die Gürtellinie zu schlagen).

Abhängig vom Marketing-Gedöns sehe ich die Art und Weise der Käufer-Manipulation schon in den Überschriften der Test-Reviews (siehe 3DC)

"Degen statt Keule" (PCGH), "Effizienzknaller" (GameStar), wobei "Knapper Konter" (Golem) noch am wenigsten wie eine Vorgabe aus der Werbebroschüre klingt. Das muss nicht sein, und ich bin jeden Leid, der sich von solchen Überschriften und den sprachlichen Verbiegungen und Suggestionen im Text beeinflussen lässt.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.356

- Renomée

- 1.976

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das mit der höheren Taktfrequenz ist doch nichts neues.

Bei den letzten beiden Generationen war es doch schon das gleiche Spiel. Die Radeons takteten von Hause aus auf nur ca. 1000 MHz, die Geforce Modelle takteten beim gleichen Prozess deutlich höher, der Turbo taktet über den angegebenen max. Takt hinaus und dennoch zogen sie weniger Strom.

Ich sehe hier keinen Vorteil für den TSMC Prozess sondern lediglich einen Vorteil für die Architektur.

Bei den letzten beiden Generationen war es doch schon das gleiche Spiel. Die Radeons takteten von Hause aus auf nur ca. 1000 MHz, die Geforce Modelle takteten beim gleichen Prozess deutlich höher, der Turbo taktet über den angegebenen max. Takt hinaus und dennoch zogen sie weniger Strom.

Ich sehe hier keinen Vorteil für den TSMC Prozess sondern lediglich einen Vorteil für die Architektur.

Was ich soweit an "Pascal" interessant finde, sind die hohen ermöglichten Takte bei niedriger Verlustleistung. Hier scheint das "16nm" Verfahren von TSCM gegenüber dem "14nm" LP node von Samsung/GF doch vorteilhafter zu sein.

Ich weiß gerade nicht wo ich es gelesen habe, aber die Argumentation war gut. Der Vergleich hinkt, denn dann hätte man ja die AMD Karten früher als Sie auch bei TSCM im selben Verfahren produziert wurden genau so hoch takten müssen können, wie die NV-Karten.

Dem war aber nicht so - mal davon ab das es deutlichere Unterschiede beim "Verbrauch" auch damals gab. Die Architektur scheint hier dann doch eine gewisses Feld zu sein, die Ihre Auswirkungen hat was Takt/"Verbrauch" angeht.

Siehe auch Sompe - wahrscheinlich war er es der in einem anderen Thread das Argument brachte.

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Bei früheren Karten auf dem gleichen TSCM Prozess hatte AMD die deutlich höhere Packdichte, was - all else equal - niedrigere Takte bedingt.

Da sich aktuell sowohl Prozess als auch Architektur geändert haben, dürfte das Urteil nicht so eindeutig ausfallen.

Typisch für LP nodes ist die stärker abflachende Takt-/Leistungskurve (siehe auch Carrizo). Die Kurve flacht im Vergleich zu Performance nodes derart stark ab, dass ab einem gewissen Punkt jede Taktsteigerung durch eine überproportionale Steigerung der Leistungsaufnahme erkauft werden muss.

Der Snapdragon 820 wird u.a. im Samsung 14nm LPP Verfahren gefertigt, wo hohe Takte nicht unbedingt die größte Rolle spielen dürften.

Alles in allem kann man sich streiten über dieses Argument, daher auch meine vorsichtige Formulierung: ein Sachverhalt "scheint" bedeutet keine Tatsachenbehauptung! Die mit den neuen nodes erreichten Taktfrequenzen für GPUs (tw. Übertaktungen auf 2GHz luftgekühlt) lassen den Unterschied zwischen den GPU-Serien beider Hersteller zumindest interessant erscheinen. Ob und inwiefern der Sachverhalt vorteilhaft ist, ist dann eine andere Frage.

Da sich aktuell sowohl Prozess als auch Architektur geändert haben, dürfte das Urteil nicht so eindeutig ausfallen.

Typisch für LP nodes ist die stärker abflachende Takt-/Leistungskurve (siehe auch Carrizo). Die Kurve flacht im Vergleich zu Performance nodes derart stark ab, dass ab einem gewissen Punkt jede Taktsteigerung durch eine überproportionale Steigerung der Leistungsaufnahme erkauft werden muss.

Der Snapdragon 820 wird u.a. im Samsung 14nm LPP Verfahren gefertigt, wo hohe Takte nicht unbedingt die größte Rolle spielen dürften.

Alles in allem kann man sich streiten über dieses Argument, daher auch meine vorsichtige Formulierung: ein Sachverhalt "scheint" bedeutet keine Tatsachenbehauptung! Die mit den neuen nodes erreichten Taktfrequenzen für GPUs (tw. Übertaktungen auf 2GHz luftgekühlt) lassen den Unterschied zwischen den GPU-Serien beider Hersteller zumindest interessant erscheinen. Ob und inwiefern der Sachverhalt vorteilhaft ist, ist dann eine andere Frage.

Zuletzt bearbeitet:

Halte ich für wahrscheinlich, wenn man sich mal ansieht, mit wie wenigen Shadern/TMUs/ROPs Nvidia die Leistung auf den Bildschirm bringt, da schlummern keine Reserven mehr. Durch die wenigen Einheiten auf dem Chip sinkt auch der Stromverbrauch, das ist alles komplett optimiert....oder es ist doch die Architektur die durch Low Level Zugriff nichts mehr dazu gewinnt da man bereits unter DX11 alles raus hohlen konnte.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 610

- Aufrufe

- 46K

- Antworten

- 1K

- Aufrufe

- 70K

- Antworten

- 0

- Aufrufe

- 564

- Antworten

- 2K

- Aufrufe

- 112K