App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

R1000 Spekulationsthread

- Ersteller p4z1f1st

- Erstellt am

Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

Ja. Eine wichtige Fähigkeit, die ich bis heute vermisse. Insbesondere bei den HD69xx zollt der Speicher einen nicht unerheblichen Anteil am Verbrauch im Idle, Multimonitor bzw. bei DVD- und BluRay-Wiedergabe. Ich hoffe, dass dies mit den kommenden GPUs elegant gelöst wird.

Das meine ich. Selbst wenn das bloße runtertakten des Speichers seit der 8er-Generation funktionieren sollte, gab es da nicht noch Fälle wo die Eyefinitys im IDLE trotzdem deutlich mehr (zuviel?) Strom gezogen haben, weil zwar der chip nicht unbedingt viel zu tun hatte, aber seine Infrastruktur (displayport-Ansteuerung etc.) trotzdem auf Hochtouren laufen musste?

Gerade hier ist noch optimierungspotenzial. Das mag zwar wenig prio haben, da es ein Highend-Problem ist, wo die Idle-Power sowieso eine untergeordnete Rolle spielt, dennoch zeigt es dass da oftmals noch halbgare Verfahren im Einsatz sind.

Wenn es die Graka schaffen sollte nur eine Handvoll Transistoren am laufen zu halten und den Rest zu powergaten, den Speicher fast gänzlich vom Strom zu nehmen und auch die restliche Infrastruktur soweit runter zu fahren wie es geht, sollten zumindest 10W drin sein IMHO. das wäre zumindest mal eine Hausnummer mit der man ansatzweise leben könnte. Sosnt haben wir nämlich das Kuriosum, dass die große Graka, obwohl nichts zu tun, mehr strom verbrutzelt als ein Zacate unter vollast. Und das entbehrt nicht irgendwie einer gewissen Lächerlichkeit...

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Teillast, wie der Name schon sagt, entspricht einem Teil der Vollast. Das können 10% sein. Das können aber auch 90% sein. Und ob du es glaubst oder nicht, 90% Teillast unterscheidet sich auch messbar sehr stark von Idle.Die Teillast, wie du es nennst, unterscheidet sich aber nicht messbar von dem was du als idle bezeichnest.

Darum geht es aber nicht. Es geht, wie Ge0rgy ja schon richtigerweise fragte, um die Definition. Und Idle ist per Definition etwas anderes als Teillast. Das war der Punkt. Genau genommen gibt es eigentlich gar kein vollständiges Idle auf normalen Systemen. Bei einer CPU muss immer noch mindestens ein Kern laufen, um OS Prozesse zu verarbeiten. Auch wenn die dadurch erzeugte Last sehr gering ist. Eine GPU wiederum muss noch das ganze Desktop Gedöns anzeigen. Dennoch, das ist trotzdem nochmal was anderes als die von dir aufgezählten Fälle. Vollständiges Idle von CPU und GPU ist eigentlich nur mit Standby möglich.

Darum geht es aber nicht. Es geht, wie Ge0rgy ja schon richtigerweise fragte, um die Definition. Und Idle ist per Definition etwas anderes als Teillast. Das war der Punkt. Genau genommen gibt es eigentlich gar kein vollständiges Idle auf normalen Systemen. Bei einer CPU muss immer noch mindestens ein Kern laufen, um OS Prozesse zu verarbeiten. Auch wenn die dadurch erzeugte Last sehr gering ist. Eine GPU wiederum muss noch das ganze Desktop Gedöns anzeigen. Dennoch, das ist trotzdem nochmal was anderes als die von dir aufgezählten Fälle. Vollständiges Idle von CPU und GPU ist eigentlich nur mit Standby möglich.Lynxeye

Admiral Special

- Mitglied seit

- 26.10.2007

- Beiträge

- 1.107

- Renomée

- 60

- Standort

- Sachsen

- Mein Laptop

- Lifebook T1010

- Details zu meinem Desktop

- Prozessor

- AMD FX 8150

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- Zalman Reserator 1 Plus

- Speicher

- 4x8GB DDR3-1600 G.Skill Ripjaws

- Grafikprozessor

- ASUS ENGTX 260

- Display

- 19" AOC LM928 (1280x1024), V7 21" (1680x1050)

- HDD

- Crucial M4 128GB, 500GB WD Caviar 24/7 Edition

- Optisches Laufwerk

- DVD Multibrenner LG GSA-4167B

- Soundkarte

- Creative Audigy 2 ZS

- Gehäuse

- Amacrox Spidertower

- Netzteil

- Enermax Liberty 500W

- Betriebssystem

- Fedora 17

- Webbrowser

- Firefox

- Verschiedenes

- komplett Silent durch passive Wasserkühlug

Ja. Eine wichtige Fähigkeit, die ich bis heute vermisse. Insbesondere bei den HD69xx zollt der Speicher einen nicht unerheblichen Anteil am Verbrauch im Idle, Multimonitor bzw. bei DVD- und BluRay-Wiedergabe. Ich hoffe, dass dies mit den kommenden GPUs elegant gelöst wird.

Gerade bei der Blu-Ray Wiedergabe wird es keine großen Veränderungen geben, denn das Dekodieren von H.264 benötigt gewaltige Speicherbandbreiten (es muss der Bitstrom gelesen werden + aus bis zu 16 Referenzframes gelesen werden und der endgültige Frame geschrieben werden und das 30 mal pro Sekunde), weshalb der Speicher immer hoch getaktet werden muss, mit Idletaktraten ist da kein Blumentopf zu gewinnen.

Lepus

Fleet Captain Special

- Mitglied seit

- 14.08.2009

- Beiträge

- 289

- Renomée

- 1

- Standort

- München

- Mein Laptop

- Alienware M17x R4

- Details zu meinem Laptop

- Prozessor

- Intel Core i7-3820M Single Thread @ max 4,1GHz

- Speicher

- 2x4GB Mushkin 1600MHz (ULV)

- Grafikprozessor

- Dell AMD HD 7970M

- Display

- 17,3" FHD

- HDD

- Crucial m4 256Gb mSata

- Optisches Laufwerk

- HL-DT-ST DVDRW/BR-ROM

- Soundkarte

- Creative Sound Blaster Recon 3Di / HM77

- Gehäuse

- Alienware M17x R4

- Netzteil

- Dell 240W

- Betriebssystem

- Windows 8

- Webbrowser

- Opera

Gerade bei der Blu-Ray Wiedergabe wird es keine großen Veränderungen geben, denn das Dekodieren von H.264 benötigt gewaltige Speicherbandbreiten (es muss der Bitstrom gelesen werden + aus bis zu 16 Referenzframes gelesen werden und der endgültige Frame geschrieben werden und das 30 mal pro Sekunde), weshalb der Speicher immer hoch getaktet werden muss, mit Idletaktraten ist da kein Blumentopf zu gewinnen.

Nur brauch man dafür keine mehrere hundert Mhz.

Mein Notebook mit RV840 verbraucht im Teillastbereich ca 6-7W obwohl der Speicher schon unter 100Mhz hat und der Core auf 30Mhz läuft.

Das Problem, dass ATI hat, ist immernoch, dass bei vielen Lastwechsel er zwischen den einzelnen Bioseinträgen hin und herjumpt und man dadurch graue Streifen am oberen Bildschirmrand flackern sieht. Ich kann damit leben und nehm die Stunde längere Laufzeit in kauf.

Nur wenn ATI immer so verfahren würde, würden sicherlich viele aufschreien.

HD-Streams kann ich auch bei nur 500Mhz Speicher ansehen. 200Mhz ist zu niedrig und dazwischen stürzt er immer ab.

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

Gerade da könnte und wird es hoffentlich große Veränderungen geben: AMD hat da im Vergleich zu NV noch Potenzial, bei de Blu-ray-Wiedergabe benötigen Radeons wie HD 6970 in Relation zum Leerlauf-Verbrauch weitaus mehr Strom als etwa eine GTX 580 [laut HT4U 22 zu 71 gegen 31 zu nur 38 Watt]. Vermutlich wird AMD das mit Tahiti/GCN auch angegangen sein.Gerade bei der Blu-Ray Wiedergabe wird es keine großen Veränderungen geben [...]

Markus Everson

Grand Admiral Special

Wenn du Texte tippt oder Videos renderst, ist die Grafikkarte im idle

Du möchtest damit sagen das SI nicht unter allen Umständen jederzeit im Idle auf 3W Boardpower kommt? Ob Dir da wohl jemand widerspricht? Und obs wohl jemanden interessiert?

Spannend ist hier doch ob der Wert überhaupt erreicht wird - zum Beispiel wenn ich einen längeren Task starte der CPU- oder I/O-intensiv ist aber keine Aufmerksamkeit erfordert. Ich persönlich halte 3W für die gesamte Karte für nicht erreichbar - egal ob mit oder ohne Monitor.

.

EDIT :

.

Eine GPU wiederum muss noch das ganze Desktop Gedöns anzeigen.

Welcher Desktop? man bash

.

EDIT :

.

idR wird "idle" als auf dem Desktop ohne laufende Programme bezeichnet.

Du bist weiblichen Geschlechts?

Nightshift

Grand Admiral Special

- Mitglied seit

- 19.08.2002

- Beiträge

- 4.447

- Renomée

- 81

- Standort

- Tief im Weeeeeesss-teheheheeen ;-)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- SIMAP, Docking, POEM

- Lieblingsprojekt

- SIMAP

- Meine Systeme

- Ci7-3770K@3,8 GHz, C2Q 9550@3,4 GHz, AthlonII 620 X4 (+ 2x Ci3-2100, 2x C2D 8400, 9x A4-3420, E-450)

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 3700X @stock

- Mainboard

- Gigabyte X570 Aorus Elite

- Kühlung

- Noctua NH-D15 chromax.black

- Speicher

- 2x 16 GB Corsair Vengeance LPX (schwarz) PC4-25600U (DDR4-3200) CL16-18-18-36 @stock

- Grafikprozessor

- Powercolor RX 5700 Red Dragon @stock

- Display

- Eizo FlexScan EV2750

- SSD

- Corsair MP600 1TB M.2 NVMe | Kingston A2000 NVMe PCIe SSD 1TB | Samsung 850 EVO 500 GB

- Optisches Laufwerk

- LG BH16NS55| NEC AD-7203S

- Soundkarte

- onboard :-P der Hardwaregott habe meine Creative Audgiy 2ZS selig

- Gehäuse

- Nanoxia Deep Silence 5, schallgedämmt

- Netzteil

- be quiet! Straight Power E11 650W

- Tastatur

- Razer Ornata Chroma

- Maus

- Logitech Lift for Business

- Betriebssystem

- Win 10 Pro 64bit

- Webbrowser

- Firefox

- Verschiedenes

- rockstable & silent

- Schau Dir das System auf sysprofile.de an

Mein Gott ist doch für den Sachverhalt vollkommen Wurst wie die exakte Definition von idle, Niedriglast, Teillast etc. ist... der Vergleich mit kleinen Grafikkarten älterer Serien hinkt, die haben doch viel weniger Recheneinheiten, ergo ist auch weniger Grundversorgung notwendig.

3W Boardpower halte ich nicht für realistisch... GPU, Speicher, Lüfter und dann die Wandler - ich kann es mir echt nicht vorstellen... es sei denn es würden im Niedriglastbereich große Teile des Chips komplett von der Spannungsversorgung getrennt werden, samt einiger Speicherbausteine, der Lüfter komplett abgeschaltet - und selbst dann sind da immer noch die Wandler.

Aber selbst 10 oder Watt wären für so eine Grafikkarte der Knaller, 15 immer noch eine immense und beachtliche Verbesserung.

3W Boardpower halte ich nicht für realistisch... GPU, Speicher, Lüfter und dann die Wandler - ich kann es mir echt nicht vorstellen... es sei denn es würden im Niedriglastbereich große Teile des Chips komplett von der Spannungsversorgung getrennt werden, samt einiger Speicherbausteine, der Lüfter komplett abgeschaltet - und selbst dann sind da immer noch die Wandler.

Aber selbst 10 oder Watt wären für so eine Grafikkarte der Knaller, 15 immer noch eine immense und beachtliche Verbesserung.

deadohiosky

Gesperrt

- Mitglied seit

- 13.07.2011

- Beiträge

- 1.624

- Renomée

- 26

Gesehen schon, besonders interessant ist es aber nicht, außer vllt der Tesselation Folie. Viel Gequatsche, OBR und seine "Folien-Folie" ohne Quellen-Angabe und die Vorverlegung auf den 22. Dez..

Wie immer journalistische Feinarbeit.![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Der Typ holt sich übrigens gerade sprichwörtlich einen runter, dass die ganze Welt seine Leaks wie das "Wort Gottes" verbreitet (sollte die Übersetzung hinkommen).

Äußerst sympathisches Kerlchen. Da verweise ich gerne mal auf 3dcenter die sich großspurig dafür ausgesprochen haben, OBR keine Projektionsfläche mehr zu bieten, http://www.3dcenter.org/blog/leonid...r-presse-bezueglich-disqualifizierter-quellen, es aber dennoch wieder tun, sich aber durch Verweis auf eben diese, ich nenn es mal Kolumne, moralisch und ethisch von der Masse versuchen abzusetzen.

Dass nenne ich mal konsequent und die eigene Integrität wahren.![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Wie immer journalistische Feinarbeit.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Der Typ holt sich übrigens gerade sprichwörtlich einen runter, dass die ganze Welt seine Leaks wie das "Wort Gottes" verbreitet (sollte die Übersetzung hinkommen).

Äußerst sympathisches Kerlchen. Da verweise ich gerne mal auf 3dcenter die sich großspurig dafür ausgesprochen haben, OBR keine Projektionsfläche mehr zu bieten, http://www.3dcenter.org/blog/leonid...r-presse-bezueglich-disqualifizierter-quellen, es aber dennoch wieder tun, sich aber durch Verweis auf eben diese, ich nenn es mal Kolumne, moralisch und ethisch von der Masse versuchen abzusetzen.

Dass nenne ich mal konsequent und die eigene Integrität wahren.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Zuletzt bearbeitet:

Neo

Moderator

☆☆☆☆☆☆

- Mitglied seit

- 21.02.2001

- Beiträge

- 7.177

- Renomée

- 139

- Standort

- ABI

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 1800X

- Mainboard

- MSI B550-A PRO

- Kühlung

- einer mit Lüfter :p

- Speicher

- 2x 8GB Crucial DDR4-2400

- Grafikprozessor

- Sapphire R9 270X

- Display

- 2x Acer 22" 16:19

- SSD

- SanDisk SDSSDP128G

- HDD

- 320GB (Samsung)

- Optisches Laufwerk

- LG-irgendwas

- Soundkarte

- Realtek ALC887 (OnBoard)

- Netzteil

- SeaSonic B12 BC-550

- Betriebssystem

- Windows 10

- Webbrowser

- EDGE

So Leute,

ich schreibe es extra dick und fett damit es auch der letzte von Euch versteht:

Diskutiert bitte sachlich über das Thema des Threads! Wenn wir hier weiter Kommentare lesen die persönlich andere User angreifen, hagelt es ab sofort Sperren!

Wir sind es echt leid hier, und in anderen Threads jeden Tag aufräumen zu müssen nur weil einige (natürlich fast immer die selben) sich nicht benehmen können.

Also bitte: Nehmt Euch zusammen und diskutiert sachlich und in einem angemessenen Ton über das eigentliche Thema!

VG

Neo

ich schreibe es extra dick und fett damit es auch der letzte von Euch versteht:

Diskutiert bitte sachlich über das Thema des Threads! Wenn wir hier weiter Kommentare lesen die persönlich andere User angreifen, hagelt es ab sofort Sperren!

Wir sind es echt leid hier, und in anderen Threads jeden Tag aufräumen zu müssen nur weil einige (natürlich fast immer die selben) sich nicht benehmen können.

Also bitte: Nehmt Euch zusammen und diskutiert sachlich und in einem angemessenen Ton über das eigentliche Thema!

VG

Neo

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

"Programme" sind auf OS Ebene Prozesse, die wiederum aus einem oder mehreren Threads bestehen. Du wirst keinen Rechner finden, auf dem kein Prozess läuft. Ausser der Rechner ist ausgeschaltet. Als Idle wird idR der Zustand bezeichnet, wenn kein Prozess Last erzeugt. Auch wenn das, wie ich bereits sagte, technisch nicht ganz richtig ist. Jeder Prozess erzeugt Last, da jeder Thread seine Zeit vom Scheduler bekommt. Wenn es nichts zu tun gibt, verwirft er eben die ihm zur Verfügung stehende Zeit. Wie auch immer, die von dir aufgezählten Fälle, Texte mit einer Office Lösung zu schreiben oder Videos zu rendern, erzeugen mehr Last, mal mehr und mal weniger. Daher ist das auch kein Idle. Weder per Definition, noch wie Idle üblicherweise gemessen wird.Da kann ich meinen Rechner auch gleich ausmachen ... idR wird "idle" als auf dem Desktop ohne laufende Programme bezeichnet.

mibo

Grand Admiral Special

- Mitglied seit

- 05.01.2003

- Beiträge

- 2.296

- Renomée

- 65

- Standort

- Hannover

- Mein Laptop

- Lenovo T450s

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800X3D

- Mainboard

- ASUS B550M-PLUS

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x16GB DDR4 ECC

- Grafikprozessor

- AMD 6700XT

- Display

- HP X27i

- SSD

- Samsung 860EVO, 960EVO, WD 850X

- Optisches Laufwerk

- DVD-Brenner :-)

- Netzteil

- BQ Dark Power 12 750W

- Betriebssystem

- Suse Tumbleweed / Win10 64Bit

- Webbrowser

- Firefox

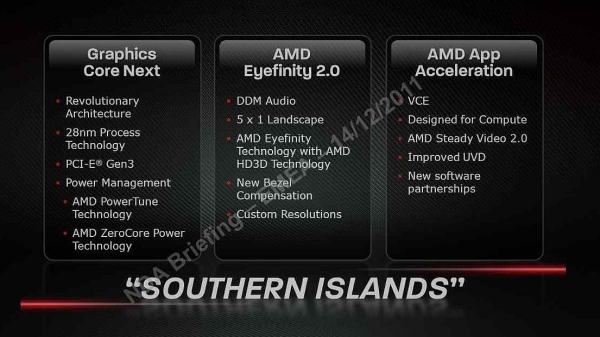

Alle 28nm GPUs 77xx - 79xx sind GCN. Alle kleineren GPUs sind umbenannte, alte 40nm Chips - sagt Semiaccurate

http://semiaccurate.com/2011/12/16/low-end-radeon-hd-7000-series-rebrands/

http://semiaccurate.com/2011/12/16/low-end-radeon-hd-7000-series-rebrands/

Locuza

Commodore Special

- Mitglied seit

- 03.03.2011

- Beiträge

- 351

- Renomée

- 3

Das ist eigentlich schon seit Monaten klar?

Gipsel hat sich schon lange die Treiber angeschaut und 3 ASICs für die GCN-Architektur rausbekommen. Es war somit klar, dass Tahiti, Cape Verde und Pitcairn auf GCN basieren und der Rest darunter auf VLIW 5 und VLIW 4 ( Trinity ) aufbauen wird.

Gipsel hat sich schon lange die Treiber angeschaut und 3 ASICs für die GCN-Architektur rausbekommen. Es war somit klar, dass Tahiti, Cape Verde und Pitcairn auf GCN basieren und der Rest darunter auf VLIW 5 und VLIW 4 ( Trinity ) aufbauen wird.

mibo

Grand Admiral Special

- Mitglied seit

- 05.01.2003

- Beiträge

- 2.296

- Renomée

- 65

- Standort

- Hannover

- Mein Laptop

- Lenovo T450s

- Details zu meinem Desktop

- Prozessor

- Ryzen 5800X3D

- Mainboard

- ASUS B550M-PLUS

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x16GB DDR4 ECC

- Grafikprozessor

- AMD 6700XT

- Display

- HP X27i

- SSD

- Samsung 860EVO, 960EVO, WD 850X

- Optisches Laufwerk

- DVD-Brenner :-)

- Netzteil

- BQ Dark Power 12 750W

- Betriebssystem

- Suse Tumbleweed / Win10 64Bit

- Webbrowser

- Firefox

Theoretisch - ja.

Aber überall gab es trotzdem Leute, die behaupteten, dass nur die HighEnd 79xx GCN haben würde.

Aber überall gab es trotzdem Leute, die behaupteten, dass nur die HighEnd 79xx GCN haben würde.

Duplex

Admiral Special

Gute Nachrichten bei ATI

7970 Launch am Donnerstag wäre Super

Derweil bringt AMD dem Grafikkarten-Enthusiasten ein kleines Weihnachtsgeschenk, indem der Launch der Radeon HD 7970 auf den 22. Dezember vorgezogen wurde

http://www.3dcenter.org/Zusammen mit den 40 Prozent mehr Texturpower, einem 50 Prozent breiterem Speicherinterface und den Effizienzverbesserungen der GCN-Architektur kann das angepeilte Performance-Ziel von 50 Prozent mehr als bei der GeForce GTX 580 durchaus erreichbar sein.

7970 Launch am Donnerstag wäre Super

G

Gast27042015

Guest

Freitag in den händen halten wär mir lieber

hoffen wir das es zumindest nen paar verfügbare gibt

Lepus

Fleet Captain Special

- Mitglied seit

- 14.08.2009

- Beiträge

- 289

- Renomée

- 1

- Standort

- München

- Mein Laptop

- Alienware M17x R4

- Details zu meinem Laptop

- Prozessor

- Intel Core i7-3820M Single Thread @ max 4,1GHz

- Speicher

- 2x4GB Mushkin 1600MHz (ULV)

- Grafikprozessor

- Dell AMD HD 7970M

- Display

- 17,3" FHD

- HDD

- Crucial m4 256Gb mSata

- Optisches Laufwerk

- HL-DT-ST DVDRW/BR-ROM

- Soundkarte

- Creative Sound Blaster Recon 3Di / HM77

- Gehäuse

- Alienware M17x R4

- Netzteil

- Dell 240W

- Betriebssystem

- Windows 8

- Webbrowser

- Opera

Naja aber nicht vor Neujahr bis die Verfügbarkeit hoch geht

deadohiosky

Gesperrt

- Mitglied seit

- 13.07.2011

- Beiträge

- 1.624

- Renomée

- 26

http://www.donanimhaber.com/ekran-k...PU-enerji-verimliliginde-acik-ara-ondeyiz.htm

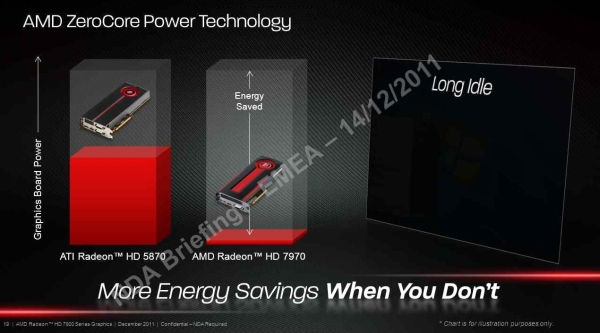

Damit dürfte sich auch klären, was man unter idle bzw. long idle versteht.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

http://www.donanimhaber.com/ekran-k...0-serisi-icin-alti-cizilen-ana-ozellikler.htm

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

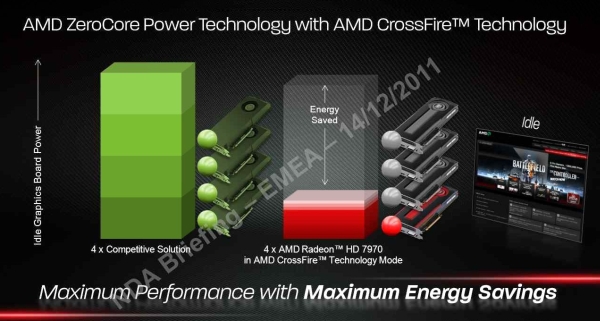

Wie ich es sagte: Unter 3W nur, wenn der Schirm aus ist, bei "klassischem" Leerlauf auf dem Desktop im Bereich wie bisher, also irgendwas um die 20W [sieht man daran, dass eine Radeon im CF noch so viel zieht wie eine "Competitive Solution"]. Schicke Sache, wenn man mal 10 min weg ist - dann kann der Schirm ja ruhig ausgehen.

deadohiosky

Gesperrt

- Mitglied seit

- 13.07.2011

- Beiträge

- 1.624

- Renomée

- 26

Und wie ich und andere sagten, es gibt keinen "klassischen" idle.

Es ist offensichtlich Definitionsfrage, was "du" unter idle verstehst und was "andere" unter idle verstehen.

Es ist offensichtlich Definitionsfrage, was "du" unter idle verstehst und was "andere" unter idle verstehen.

Onkel_Dithmeyer

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.04.2008

- Beiträge

- 12.943

- Renomée

- 4.014

- Standort

- Zlavti

- Aktuelle Projekte

- Universe@home

- Lieblingsprojekt

- Universe@home

- Meine Systeme

- cd0726792825f6f563c8fc4afd8a10b9

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X @4000 MHz//1,15V

- Mainboard

- MSI X370 XPOWER GAMING TITANIUM

- Kühlung

- Custom Wasserkühlung vom So. G34

- Speicher

- 4x8 GB @ 3000 MHz

- Grafikprozessor

- Radeon R9 Nano

- Display

- HP ZR30W & HP LP3065

- SSD

- 2 TB ADATA

- Optisches Laufwerk

- LG

- Soundkarte

- Im Headset

- Gehäuse

- Xigmatek

- Netzteil

- BeQuiet Dark Pro 9

- Tastatur

- GSkill KM570

- Maus

- GSkill MX780

- Betriebssystem

- Ubuntu 20.04

- Webbrowser

- Firefox Version 94715469

- Internetanbindung

- ▼100 Mbit ▲5 Mbit

Gab es nicht mal eine Entwicklung für Monitore zum Energiesparen? Fällt mir in dem Zusammenhang ein. Da wurde nur ein Bild von der Grafikkarte erzeugt, wenn sich der Bildinhalt ändert und der Monitor stellt solange das alte Bild dar, bis ein neues kommt. Ich finde die Bezeichnung davon nicht mehr. Ist zwar OT, drängt sich mir dabei aber auf, jemand eine Idee?

rasmus

Admiral Special

- Mitglied seit

- 07.07.2008

- Beiträge

- 1.191

- Renomée

- 47

- Mein Laptop

- Notebook, was ist das?

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 3600

- Mainboard

- MSI B450M PRO-VDH MAX

- Kühlung

- Luft

- Speicher

- 32 GB Gskill Ripjaws

- Grafikprozessor

- Nvidia 3070 ti FE

- Display

- Asus PB278Q 27" 2560*1440

- SSD

- Ja

- HDD

- auch

- Optisches Laufwerk

- ja

- Soundkarte

- onboard

- Gehäuse

- irgendwas mit glas

- Netzteil

- thermaltake toughpower pf1 750W

- Maus

- Rat 9

- Betriebssystem

- Win 7 64bit, Win 10 64 bit

- Webbrowser

- Firefox

- Verschiedenes

- http://valid.canardpc.com/show_oc.php?id=628058

[sieht man daran, dass eine Radeon im CF noch so viel zieht wie eine "Competitive Solution"]. Schicke Sache, wenn man mal 10 min weg ist - dann kann der Schirm ja ruhig ausgehen.

Das (für mich) entscheidende ist in dem Fall, daß mein Crossfire im idle nur für eine Graka Strom zieht (ziehen soll) und nicht für 2 (wie bisher und auch bisher bei NV). Und das ist relativ neu. Bisher war das nämlich nicht wirklich tauglich. Mal sehen, ob es jetzt gut funktioniert.

Ähnliche Themen

- Antworten

- 17

- Aufrufe

- 2K

- Antworten

- 11

- Aufrufe

- 530

- Antworten

- 5

- Aufrufe

- 736