App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Rise of the Tomb Raider

- Ersteller Majohandro

- Erstellt am

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

ok nochmal danke

hab das auch gleich mal bei the witcher 3 ausprobiert.... dort schafft es wenigstens die 60 fps auch in 4k. interessant finde ich nur weil ja jetzt alle so feuer und flamme für die neuen amd cpu's sind ^^, das die cpu auslastung dort beim witcher geradezu lächerlich gering ist wenn man das so mit 4k verwendet. aber ok ich versteh das eh nicht so richtig. für mein verständnis muss halt eine cpu am limit sein, damit eine andere schneller sein kann wenn da mehr luft ist. aber ist wohl mit den ganzen optimierungen und was weis ich heute alles anders.

ok das ist mit vsync, aber wenn eine 2080ti immer wieder auf 100 % springt wenn das auf 60 fps limitiert ist, wie soll eine schnellere cpu dann unterstützend wirken können wenn man jetzt mal angenommen vsync deaktiviert ?

äh oder the witcher 3 ist halt ne ausnahme.

hab das auch gleich mal bei the witcher 3 ausprobiert.... dort schafft es wenigstens die 60 fps auch in 4k. interessant finde ich nur weil ja jetzt alle so feuer und flamme für die neuen amd cpu's sind ^^, das die cpu auslastung dort beim witcher geradezu lächerlich gering ist wenn man das so mit 4k verwendet. aber ok ich versteh das eh nicht so richtig. für mein verständnis muss halt eine cpu am limit sein, damit eine andere schneller sein kann wenn da mehr luft ist. aber ist wohl mit den ganzen optimierungen und was weis ich heute alles anders.

ok das ist mit vsync, aber wenn eine 2080ti immer wieder auf 100 % springt wenn das auf 60 fps limitiert ist, wie soll eine schnellere cpu dann unterstützend wirken können wenn man jetzt mal angenommen vsync deaktiviert ?

äh oder the witcher 3 ist halt ne ausnahme.

Zuletzt bearbeitet:

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Naja, bei den meisten Spielen wird die Grafikkarte limitieren, das ist richtig. Um die meisten Spiele mit 60fps wiederzugeben, werden in der Tat selbst deutlich schwächere CPUs ausreichen. Man sieht es ja bei den ganzen Spiele-Benchmarks, wo CPUs gegeneinander getestet werden. Da bringt dann die eine CPU mal 140 statt 120fps, aber unter realen Bedingungen wird sowieso die Grafikkarte limitieren und dann ist das eh irrelevant.

Aber es gibt tatsächlich auch Spiele, wo ggf. die CPU limitieren kann (Simulationen, die sehr viel Berechnungen der CPU erfordern). Außer man prügelt die Grafik so hoch, dass wieder die GPU limitiert. Und natürlich wird dann eine CPU auch nicht unbedingt dauerhaft limitieren, sondern mal bei einigen Stellen des Spielt, wo es dann kurz einbricht oder eben auch nicht.

Im Idealfall hat man genug CPU und GPU-Power in Reserve für besonders fordernde Stellen. Gerade The Witcher hat ein paar ganz fiese Stellen im Spiel, die schlecht optimiert sind und jede Hatfware in die Knie zwingen können (erinnere mich noch an die Diskussionen damals mit TobiWahnKenobi, wo ich eine Stelle im Spiel genannt habe, die selbst seine Titan unter 60fps gebracht hat ). Aber kann mit einer 2080Ti heute natürlich anders aussehen

). Aber kann mit einer 2080Ti heute natürlich anders aussehen  Ist ja auch ein ziemlich altes Spiel.

Ist ja auch ein ziemlich altes Spiel.

Aber es gibt tatsächlich auch Spiele, wo ggf. die CPU limitieren kann (Simulationen, die sehr viel Berechnungen der CPU erfordern). Außer man prügelt die Grafik so hoch, dass wieder die GPU limitiert. Und natürlich wird dann eine CPU auch nicht unbedingt dauerhaft limitieren, sondern mal bei einigen Stellen des Spielt, wo es dann kurz einbricht oder eben auch nicht.

Im Idealfall hat man genug CPU und GPU-Power in Reserve für besonders fordernde Stellen. Gerade The Witcher hat ein paar ganz fiese Stellen im Spiel, die schlecht optimiert sind und jede Hatfware in die Knie zwingen können (erinnere mich noch an die Diskussionen damals mit TobiWahnKenobi, wo ich eine Stelle im Spiel genannt habe, die selbst seine Titan unter 60fps gebracht hat

). Aber kann mit einer 2080Ti heute natürlich anders aussehen

). Aber kann mit einer 2080Ti heute natürlich anders aussehen  Ist ja auch ein ziemlich altes Spiel.

Ist ja auch ein ziemlich altes Spiel.

Zuletzt bearbeitet:

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

ich muss zugeben das ich gerade verärgert bin .... hab gerade mal diesen treiber ein update verpasst... ok ich hab das gforce experience ding das machen lassen. vorher war auch einiges an bestimmten sachen gar nicht drauf. dachte ja kann nur besser werden. aber jetzt ist es deutlich langsamer und zwar so das es auffällt.

ist das zufall oder hängt das irgendwie damit zusammen das nvidia die "alten" karten langsamer macht ?

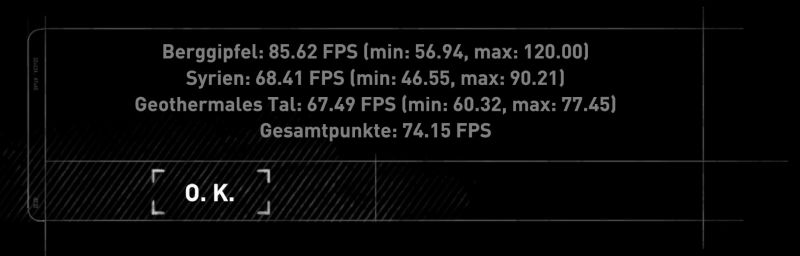

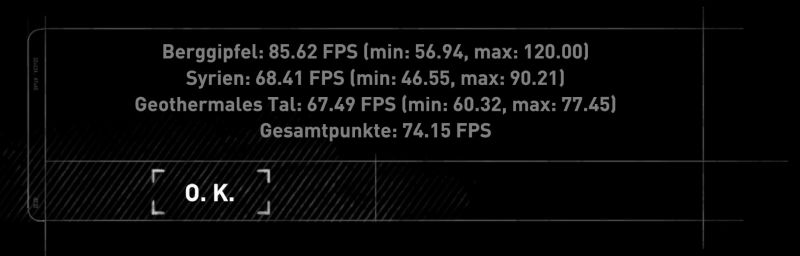

vor dem update :

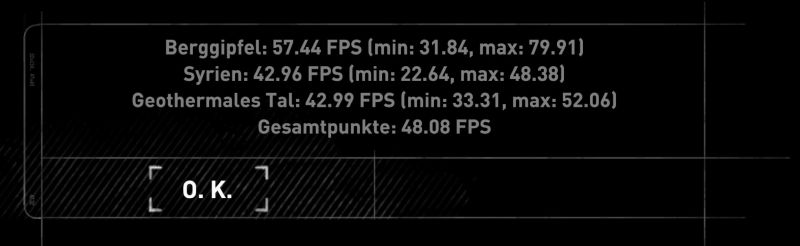

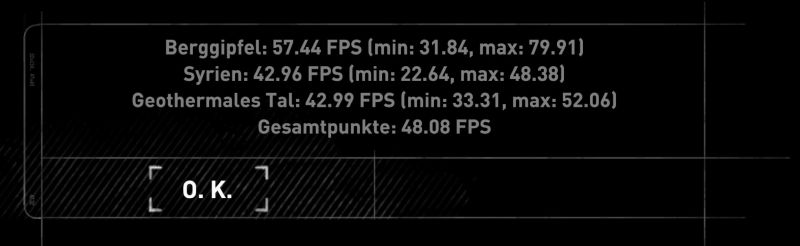

und danach :

ich hätte die finger von dem quatsch lassen sollen und es so wie immer machen, nämlich gar nichts upzudaten.

das ist natürlich in 4k...

--- Update ---

ok war mein fehler .... oder das experience ding hat ne einstellung geändert denn ich hab dort nichts gemacht. es war auf einmal auf SSAA 2x eingestellt.

ist das zufall oder hängt das irgendwie damit zusammen das nvidia die "alten" karten langsamer macht ?

vor dem update :

und danach :

ich hätte die finger von dem quatsch lassen sollen und es so wie immer machen, nämlich gar nichts upzudaten.

das ist natürlich in 4k...

--- Update ---

ok war mein fehler .... oder das experience ding hat ne einstellung geändert denn ich hab dort nichts gemacht. es war auf einmal auf SSAA 2x eingestellt.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.358

- Renomée

- 1.977

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

War das experience Dingens nicht auch zum "optimieren" von Spiele Einstellungen da?

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Ja, schrieb ich ja. Das setzt selbständig (wenn man möchte) Spiele-Settings. Oft aber nicht so, wie ich sie möchte, bzw. nicht die für mich optimalen Settings, deswegen fand ich das ziemlich überflüssig.War das experience Dingens nicht auch zum "optimieren" von Spiele Einstellungen da?

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

naja falls es wirklich das SSAA 2x eingestellt hat ist es natürlich quark ^^ aber egal, man kann ja wieder umstellen.

hat denn irgendwer auch so nen full hd - 4k dsr test mit allen optionen auf maximum (ok filmkörnung hab ich aus weil ich das genauso mies finde wie hohe iso beim fotografieren ^^) ?

FXAA hab ich noch nie ausprobiert, finde das SMAA allerdings schon gut.

nutzt ihr dx12 ?

ich hätte gerne mal nen vergleich. aber die meisten werden wohl rise of the tomb raider gar nicht mehr auf dem rechner haben weil zu alt... nur noch shadow.

hat denn irgendwer auch so nen full hd - 4k dsr test mit allen optionen auf maximum (ok filmkörnung hab ich aus weil ich das genauso mies finde wie hohe iso beim fotografieren ^^) ?

FXAA hab ich noch nie ausprobiert, finde das SMAA allerdings schon gut.

nutzt ihr dx12 ?

ich hätte gerne mal nen vergleich. aber die meisten werden wohl rise of the tomb raider gar nicht mehr auf dem rechner haben weil zu alt... nur noch shadow.

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Ich habe leider keinen Test darüber gefunden, wieviel Leistung DSR wirklich frisst. Es wird immer nur erwähnt, dass DSR ordentlich Performance frisst, aber da beziehen sie sich nur darauf, dass höhere Auflösungen berechnet werden, was ja logisch ist. Wieviel aber die Umrechnung selbst an Leistung kostet, dazu konnte ich nichts finden.

Ich denke aber, dass das nicht viel sein kann. Das Umrechnen von Auflösungen ist bei Konsolen ja Standard (zwar in die andere Richtung, aber das dürfte vom Rechenaufwand vergleichbar sein) und da sieht man auch keine Einbrüche, wenn man die Funktion nutzt. Auch handelsübliche AV-Receiver haben das Umrechnen von Auflösungen eingebaut und die haben auch keine leistungsfähigen Grafikchips.

Ich vermute, dass das höchstens ein paar Prozent kosten kann. Bei einer 2080Ti vernachlässigbar.

Also vergleiche nicht so viel rum, stell es einfach auf 1620p oder 2160p DSR mit entsprechenden Settings ein, sodass es flüssig läuft, und genieße das Spiel

UHD ist einfach eine abartige Auflösung, da kann selbst eine 2080Ti bei Ultra Settings unter die 60fps gehen, das ist normal. Siehe hier der Benchmark der RTX2080Ti von Computerbase, da hat die Karte bei Rise of the Tomb Raider in UHD auch nur 55fps im Schnitt, ist also völlig normal. Einfach ein bisschen die Settings reduzieren oder auf 1620p stellen und glücklich sein. https://www.pcgameshardware.de/Geforce-RTX-2080-Ti-Grafikkarte-267862/Tests/Review-1265133/3/

Ich denke aber, dass das nicht viel sein kann. Das Umrechnen von Auflösungen ist bei Konsolen ja Standard (zwar in die andere Richtung, aber das dürfte vom Rechenaufwand vergleichbar sein) und da sieht man auch keine Einbrüche, wenn man die Funktion nutzt. Auch handelsübliche AV-Receiver haben das Umrechnen von Auflösungen eingebaut und die haben auch keine leistungsfähigen Grafikchips.

Ich vermute, dass das höchstens ein paar Prozent kosten kann. Bei einer 2080Ti vernachlässigbar.

Also vergleiche nicht so viel rum, stell es einfach auf 1620p oder 2160p DSR mit entsprechenden Settings ein, sodass es flüssig läuft, und genieße das Spiel

UHD ist einfach eine abartige Auflösung, da kann selbst eine 2080Ti bei Ultra Settings unter die 60fps gehen, das ist normal. Siehe hier der Benchmark der RTX2080Ti von Computerbase, da hat die Karte bei Rise of the Tomb Raider in UHD auch nur 55fps im Schnitt, ist also völlig normal. Einfach ein bisschen die Settings reduzieren oder auf 1620p stellen und glücklich sein. https://www.pcgameshardware.de/Geforce-RTX-2080-Ti-Grafikkarte-267862/Tests/Review-1265133/3/

Zuletzt bearbeitet:

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

interessiert mich halt ^^

und letztlich gehts auch darum doch mal nen anderen tft zu kaufen. sprich eben 4k ^^ dann hat man ja keine möglichkeit mehr was anderes zu nutzen. oder halt doch einen mit niedriger auflösung und dann eben mit besagtem dsr auf 4k.

nur es gibt so viele tft's und da ich mich eh nie bei irgendwas so richtig entscheiden kann ist diese 4k vs anderes nochmal so ne zusätzliche sache. jedes mal wenn ich irgendwie dort rumsuche schau ich mir dies und jenes an aber irgendwie ist immer was.

ich finde ja das full hd eigentlich gar nicht so schlecht und wenn man dann mit dsr sozusagen das optisch so gut aufhübschen kann, dann hat man auf alles gesehn ja eigentlich nur vorteile. sprich man sieht alles besser auf dem desktop, also man muss nix irgendwie scalieren und braucht auch nicht zu interpolieren.

dieses ganze gsync freesync zeugs ist dann auch noch so ne sache.

und letztlich gehts auch darum doch mal nen anderen tft zu kaufen. sprich eben 4k ^^ dann hat man ja keine möglichkeit mehr was anderes zu nutzen. oder halt doch einen mit niedriger auflösung und dann eben mit besagtem dsr auf 4k.

nur es gibt so viele tft's und da ich mich eh nie bei irgendwas so richtig entscheiden kann ist diese 4k vs anderes nochmal so ne zusätzliche sache. jedes mal wenn ich irgendwie dort rumsuche schau ich mir dies und jenes an aber irgendwie ist immer was.

ich finde ja das full hd eigentlich gar nicht so schlecht und wenn man dann mit dsr sozusagen das optisch so gut aufhübschen kann, dann hat man auf alles gesehn ja eigentlich nur vorteile. sprich man sieht alles besser auf dem desktop, also man muss nix irgendwie scalieren und braucht auch nicht zu interpolieren.

dieses ganze gsync freesync zeugs ist dann auch noch so ne sache.

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

4K ist in vielen Spielen richtig geil,aber auch NUR in Spielen weil den Rest muss ich schon wieder so Vergrößern das es am Ende wie Full HD ist.Max gehen noch QHD 2560 × 1440 und das auf nem 65Zoll TV.

--- Update ---

Ach ich kann gar nicht mit reden hab nur Tomb Raider von 2013....

--- Update ---

Ach ich kann gar nicht mit reden hab nur Tomb Raider von 2013....

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

wegen diesem tomb raider von 2013 hab ich mir das rise of the tomb raider gekauft ... fand das alte halt wirklich sehr gut. und rise gibts gerade im angebot für 7 euro irgendwas.

ich wusste zuerst gar nicht das es schon wieder ein weiteres, also shadow gibt ^^. das kostet glaub noch 16 euro+ ....und ich hab eh zuviel zu spielen da muss ich das nicht ausgeben dafür.

ich hatte übrigens nach dem rumprobieren mit diesem dsr zeugs auch den desktop auf 4 k gestellt ^^. ist durch die weichzeichnung etwas komisch und es hat automatisch auf 200 % gestellt. aber wie das dann alles auf einem echten 4k monitor aussieht kann ich mir trotzdem schlecht vorstellen.

und ja das mit dem 4 k und zu klein lese ich meistens. naja echt schwer ^^

man braucht wohl mehrere monitore für jede eventualität ^^ es ist halt so das z.b the witcher schon gut aussieht, aber auf dem 22 zoll monitor hier in gewisser weise doch recht "klein" wirkt, also man möchte ein wenig mehr "eintauchen". ansonsten sind die 22 zoll für mich eigentlich ausreichend, gerade bei mp hat man alles mit einmal im blick. ok das ist ja letztlich eine sache des abstands.

ich werd mich da wohl nie entscheiden können ^^.

ich wusste zuerst gar nicht das es schon wieder ein weiteres, also shadow gibt ^^. das kostet glaub noch 16 euro+ ....und ich hab eh zuviel zu spielen da muss ich das nicht ausgeben dafür.

ich hatte übrigens nach dem rumprobieren mit diesem dsr zeugs auch den desktop auf 4 k gestellt ^^. ist durch die weichzeichnung etwas komisch und es hat automatisch auf 200 % gestellt. aber wie das dann alles auf einem echten 4k monitor aussieht kann ich mir trotzdem schlecht vorstellen.

und ja das mit dem 4 k und zu klein lese ich meistens. naja echt schwer ^^

man braucht wohl mehrere monitore für jede eventualität ^^ es ist halt so das z.b the witcher schon gut aussieht, aber auf dem 22 zoll monitor hier in gewisser weise doch recht "klein" wirkt, also man möchte ein wenig mehr "eintauchen". ansonsten sind die 22 zoll für mich eigentlich ausreichend, gerade bei mp hat man alles mit einmal im blick. ok das ist ja letztlich eine sache des abstands.

ich werd mich da wohl nie entscheiden können ^^.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

naja kommt halt draufan ^^ ...ich hab gerne witcher 1 und 2 gespielt ..... und da ich gleichzeitig die figur mit wollte hab ich halt witcher 3 in der collectors gekauft selbst wenn ich es erst jetzt jahre später spiele ^^. oder darksiders 3 ..da gefielen mir auch die vorgänger und ich hab eben den monsterpreis der apokalypse version bezahlt...hier auch eher wegen der figuren.

ich sammle nunmal figuren, auch wenn das bei mir aus platzgründen nachgelassen hat. ok eine hab ich noch bestellt erst kürzlich und gleich bezahlt, was die wenigsten machen bei den ewig langen wartezeiten. da die nicht gerade günstig war muss ich wieder ein wenig haushalten ^^.

die alten tomb raider teile waren nichts für mich... das von 2013 hab ich sozusagen "verschlungen" nur hätte ich rise of .... eh nicht spielen können und habs daher sein gelassen es zu kaufen. aber jetzt für die 7+ ist es wirklich ok.

ich sammle nunmal figuren, auch wenn das bei mir aus platzgründen nachgelassen hat. ok eine hab ich noch bestellt erst kürzlich und gleich bezahlt, was die wenigsten machen bei den ewig langen wartezeiten. da die nicht gerade günstig war muss ich wieder ein wenig haushalten ^^.

die alten tomb raider teile waren nichts für mich... das von 2013 hab ich sozusagen "verschlungen" nur hätte ich rise of .... eh nicht spielen können und habs daher sein gelassen es zu kaufen. aber jetzt für die 7+ ist es wirklich ok.

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Einen 4K Monitor würde ich persönlich mir nicht holen, sondern 1440p/ 1620p. Niedrigere Auflösungen vom Bildschirm interpolieren lassen sieht einfach schlechter aus als Downsampling, und dann bist du an UHD-Auflösung gebunden.

Eine 2080Ti schafft doch jetzt schon in vielen Spielen (mit Ultra Settings) keine 60fps konstant, wie soll das dann erst in zukünftigen Spielen sein? Man ist dann immer gezwungen, die neueste absurd teure Graka zu kaufen, um den UHD Bildschirm auch adäquat befeuern zu können. Würde ich nicht machen.

Wobei ich ehrlicherweise nicht weiß, wie gut moderne UHD-Bildschirme interpolieren können. Vielleicht ist es ja inzwischen erträglich.

Eine 2080Ti schafft doch jetzt schon in vielen Spielen (mit Ultra Settings) keine 60fps konstant, wie soll das dann erst in zukünftigen Spielen sein? Man ist dann immer gezwungen, die neueste absurd teure Graka zu kaufen, um den UHD Bildschirm auch adäquat befeuern zu können. Würde ich nicht machen.

Wobei ich ehrlicherweise nicht weiß, wie gut moderne UHD-Bildschirme interpolieren können. Vielleicht ist es ja inzwischen erträglich.

Ich habe mir zum Arbeiten einen 4K UHD Monitor gekauft und darauf zu spielen ist trotz 2080ti noch eine Herausforderung. Man muss schon auch an den Einstellungen schrauben, damit man die 60 fps erreicht, alles auf "Hoch" ist aber meisten schon drin, den Unterschied zu Ultra sehe ich im Spiel sowieso nicht. Und wenn ich Screenshots machen will, kann ich es ja auch hochschrauben. Geforce Experience nutze ich um Clips aufzunehmen und mit Ansel zu knipsen, an die Einstellungen lasse ich das nicht ran.

Ich muss das gleich mal testen, aber ich glaube, mit Rise of the Tomb Raider wird die 2080ti auch in 4K UHD ganz gut fertig.

Here we go:

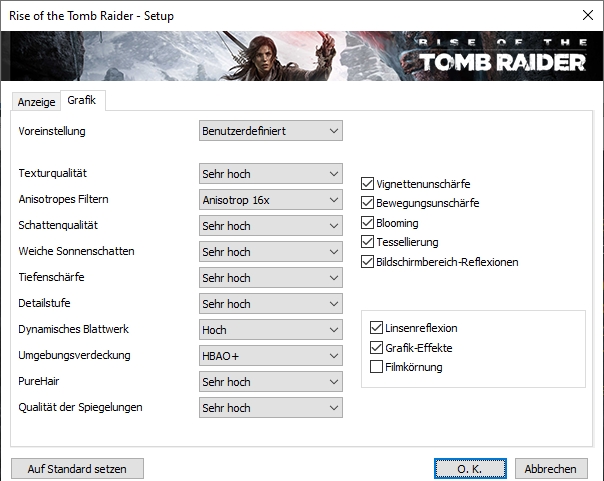

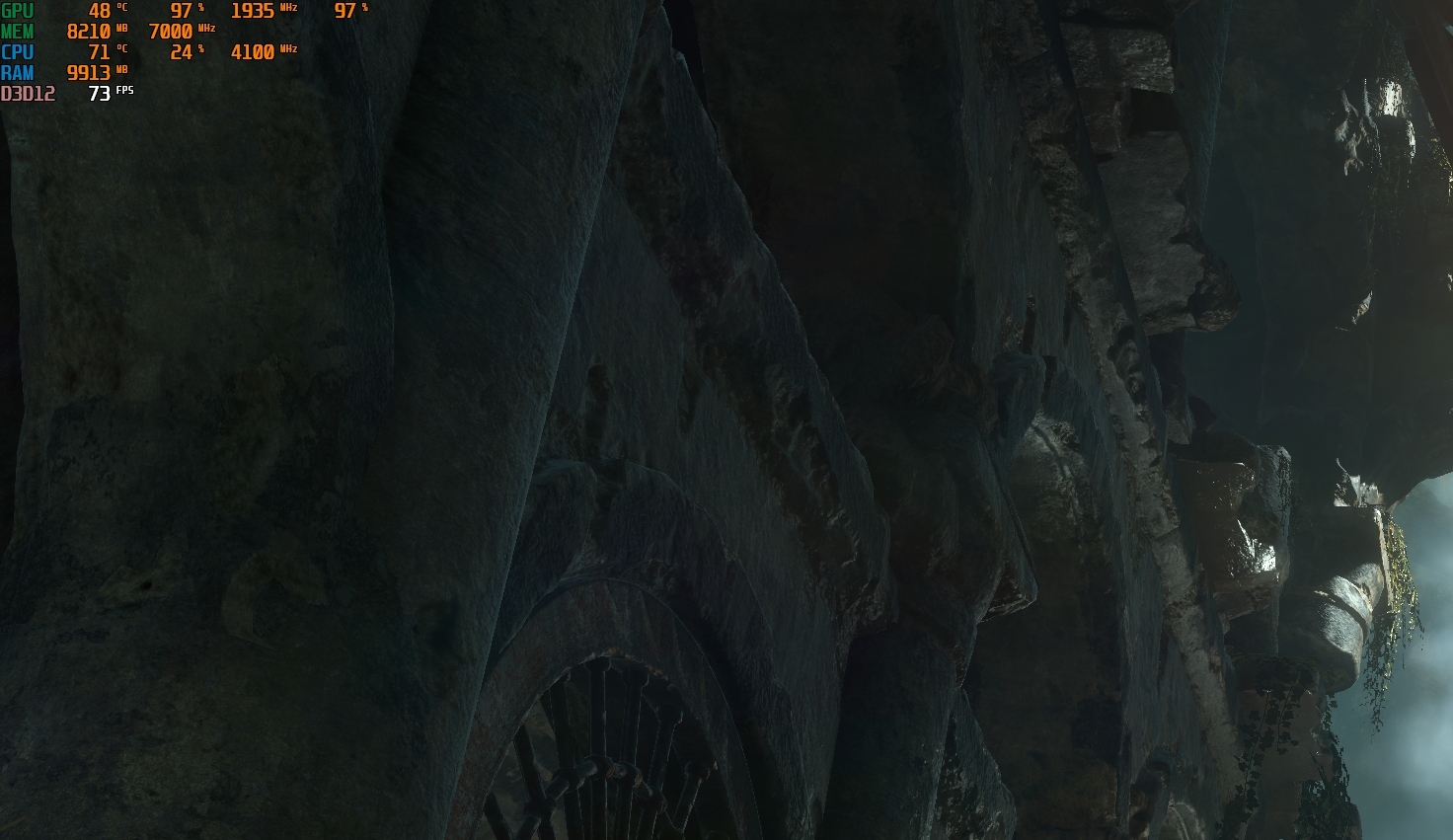

4k Auflösung, Settings "Sehr hoch", kein AA. Und mein R5 2600 limitiert in manchen Szenen ganz gewaltig.

Ich muss das gleich mal testen, aber ich glaube, mit Rise of the Tomb Raider wird die 2080ti auch in 4K UHD ganz gut fertig.

Here we go:

4k Auflösung, Settings "Sehr hoch", kein AA. Und mein R5 2600 limitiert in manchen Szenen ganz gewaltig.

Zuletzt bearbeitet:

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

@thunderbird

ja das mit dem interpolieren soll wohl eben nicht so gut sein, zumindest bei den test's wo ich rumgelesen hatte. ich dachte halt nur 4k ist die zukunft ^^. aber wahrscheinlich ist es für kleinere bilddiagonalen eh nicht so besonders.

das machts mir mit der entscheidung trotzdem nicht einfacher ^^.

@ fliwatut

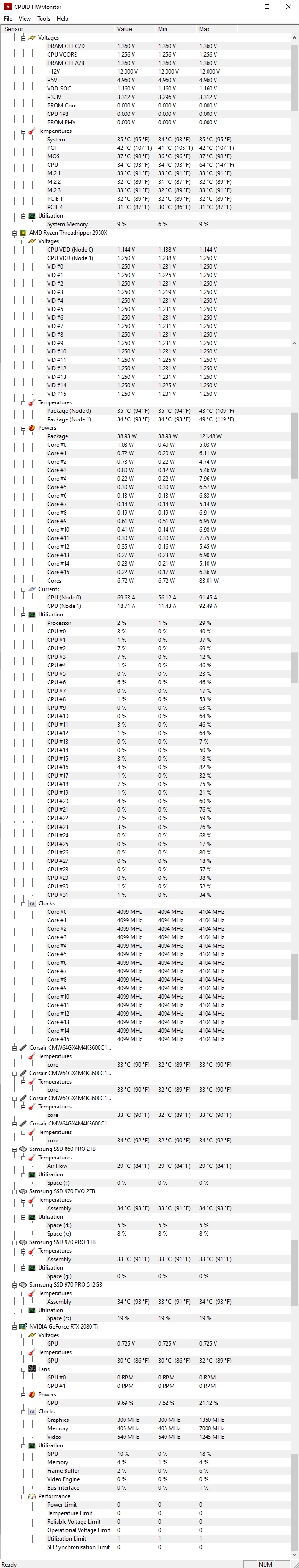

danke für den test. interessant das bei dir die cpu limitiert. bei mir scheint es eher so zu sein, das die cpu vor sich hin dümpelt und dafür die 2080ti immer fast am limit ist.

eigentlich wollte ich die andere kiste nicht anmachen ^^, habs aber mal gemacht und ein paar bildschirmfoto geschossen. da ich gerade am alten rechner schreibe und ich das nich rüberziehen will, kommt dann gleich nochmal ein kommentar

--- Update ---

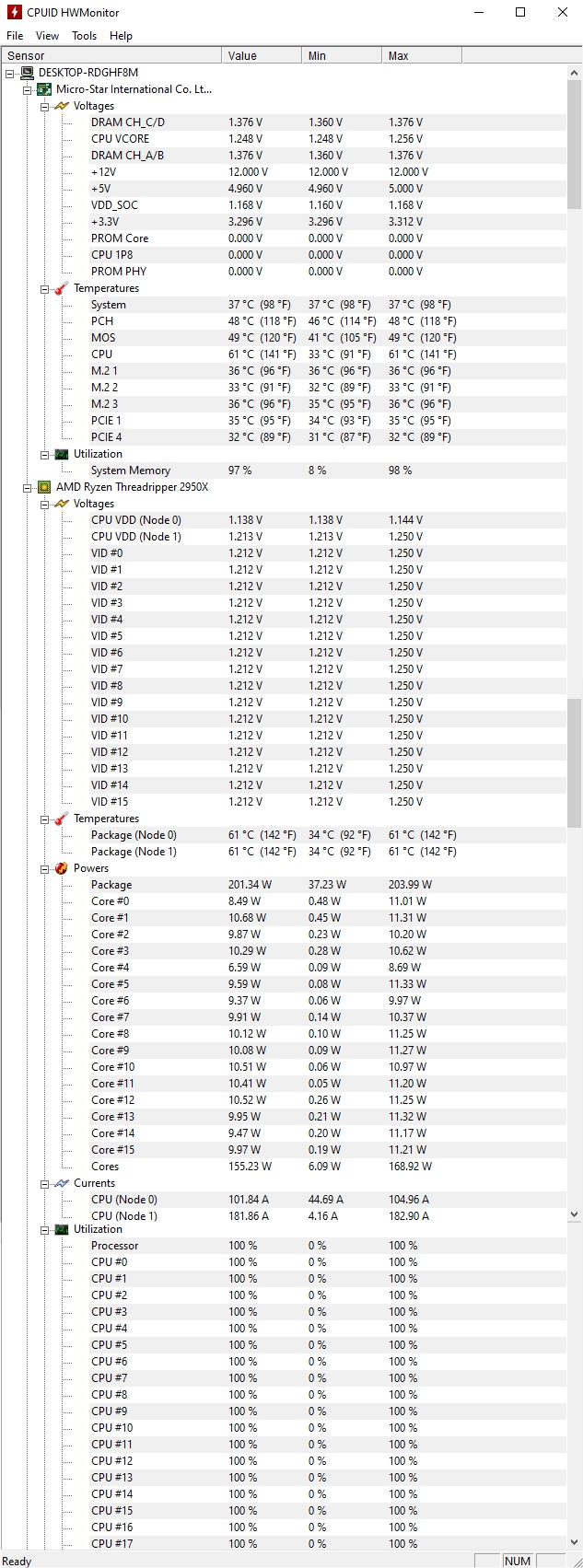

so jetzt mal kurz die screenshots...

also ich habs nun ebenso gemacht um das vergleichbar zu haben und SMAA ausgeschaltet wobei der unterschied im benchmark echt zu vernachlässigen ist.

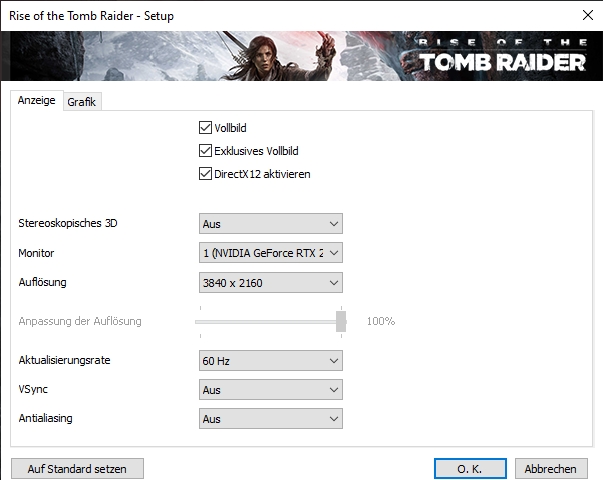

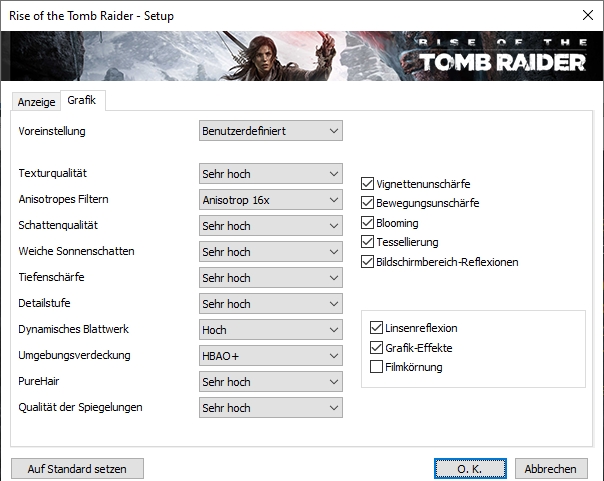

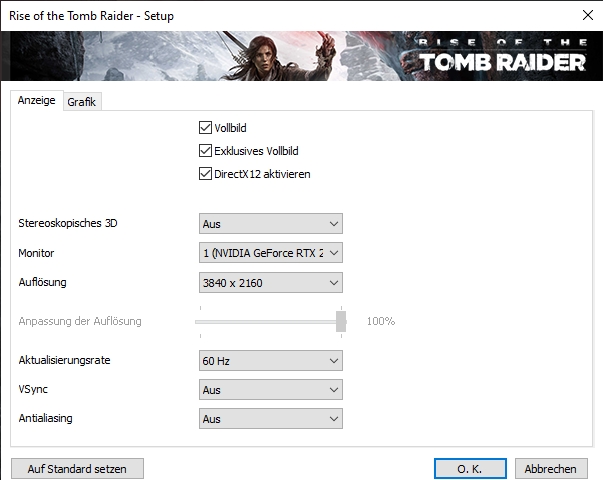

einstellungen (alles auf maximum ....wenn man bei der voreinstellung sehr hoch einstellt ist noch nicht alles auf max..... filmkörnung aus) :

so da die screenshots in 4k ja schweinegroß sind ^^ hab ich das nur ausgeschnitten damit man noch erkennt in welcher szene es ist. da die bilder nun eher hässlich sind nur im spoiler:

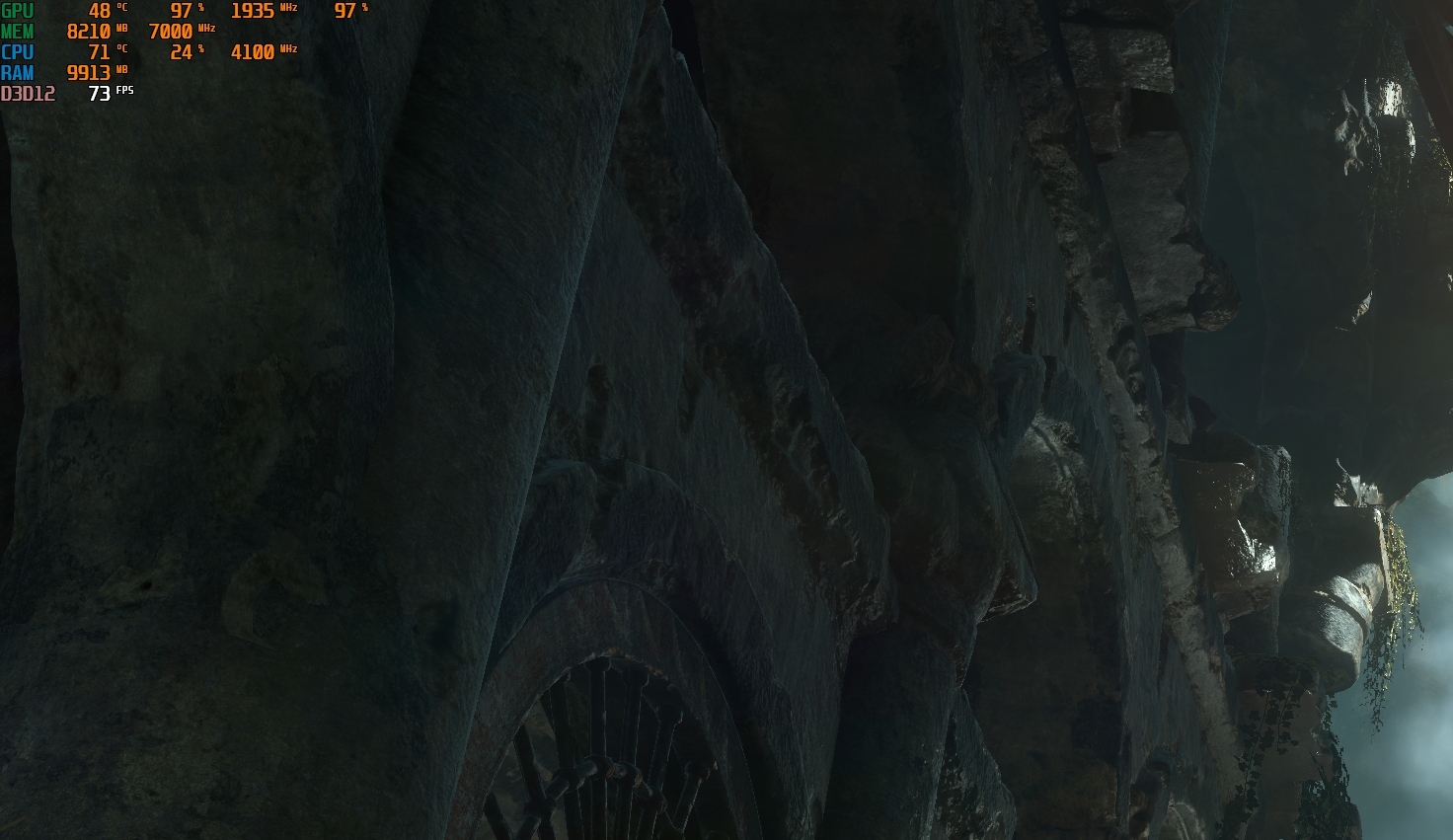

erste szene:

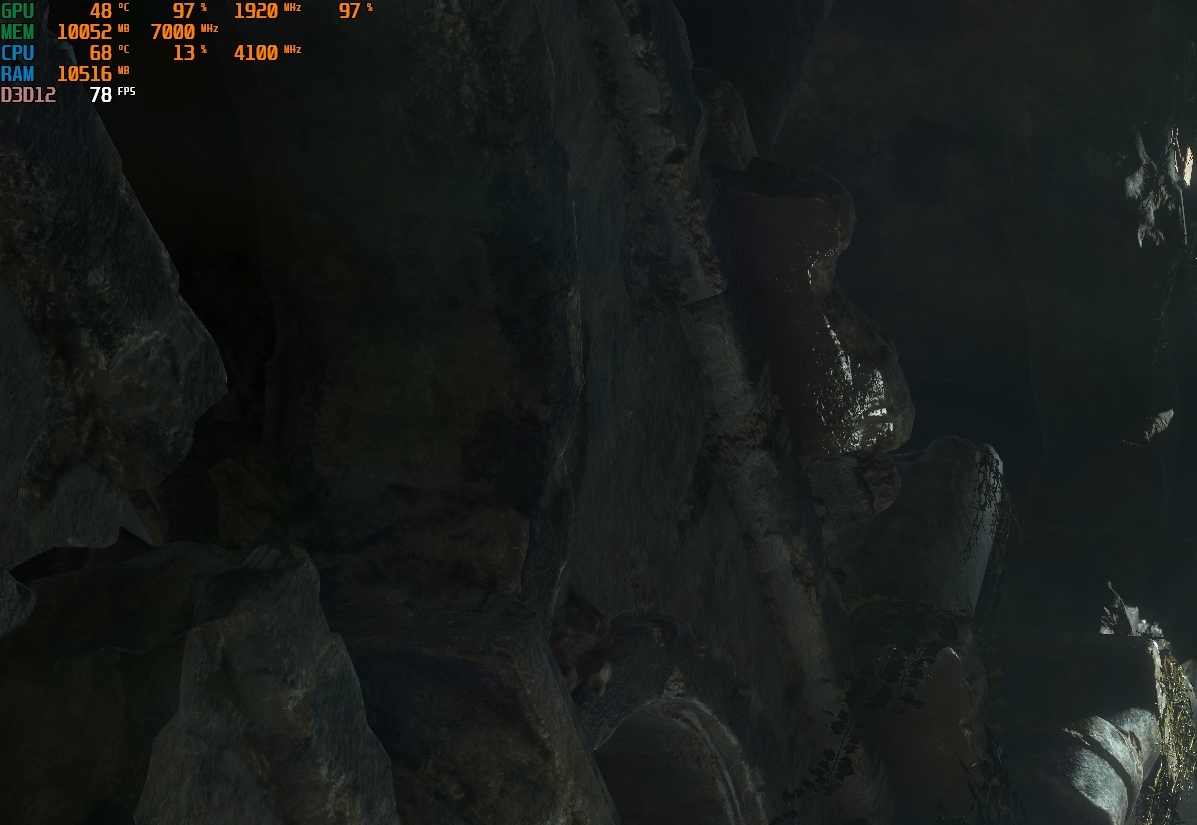

zweite szene:

dritte szene:

bei den werten sollte klar sein was was ist... die hinterste prozentangabe bei gpu dürfte power sein, die geht manchmal über 100%

ich hab auch mal den strom gemessen. bei der zweiten szene waren es mal kurz 550 watt, sonst ist alles im 500er bereich oder knapp darunter. wenn man bedenkt das die cpu hier praktisch kaum was macht ist klar das es nicht höher geht.

nebenfrage zum msi afterburner.... kann man das irgendwie so einstellen das genau für die einzelnen sachen da steht was sie bedeuten ?

die ramauslastung der grafikkarte ist auch ganz schön groß mit über 10 gb also wenn man bedenkt das sie nur 11 gb hat. achso und wieso sieht man nicht die max und die niedrigsten fps auch wenn ich es eingestellt habe ?

also wenn man bedenkt das sie nur 11 gb hat. achso und wieso sieht man nicht die max und die niedrigsten fps auch wenn ich es eingestellt habe ?

so dann..... kann man von den werten her irgendwie erkennen ob ich was falsch eingestellt habe ? wieso ist die cpu auslastung bei mir so dermaßen gering und bei fliwatut bremst die cpu ?

edit: könnten ausserdem die höheren fps bei fliwatut daher kommen weil es dort nativ und nicht dsr ist ? oder ist der threadripper einfach ungeeignet ^^

ja das mit dem interpolieren soll wohl eben nicht so gut sein, zumindest bei den test's wo ich rumgelesen hatte. ich dachte halt nur 4k ist die zukunft ^^. aber wahrscheinlich ist es für kleinere bilddiagonalen eh nicht so besonders.

das machts mir mit der entscheidung trotzdem nicht einfacher ^^.

@ fliwatut

danke für den test. interessant das bei dir die cpu limitiert. bei mir scheint es eher so zu sein, das die cpu vor sich hin dümpelt und dafür die 2080ti immer fast am limit ist.

eigentlich wollte ich die andere kiste nicht anmachen ^^, habs aber mal gemacht und ein paar bildschirmfoto geschossen. da ich gerade am alten rechner schreibe und ich das nich rüberziehen will, kommt dann gleich nochmal ein kommentar

--- Update ---

so jetzt mal kurz die screenshots...

also ich habs nun ebenso gemacht um das vergleichbar zu haben und SMAA ausgeschaltet wobei der unterschied im benchmark echt zu vernachlässigen ist.

einstellungen (alles auf maximum ....wenn man bei der voreinstellung sehr hoch einstellt ist noch nicht alles auf max..... filmkörnung aus) :

so da die screenshots in 4k ja schweinegroß sind ^^ hab ich das nur ausgeschnitten damit man noch erkennt in welcher szene es ist. da die bilder nun eher hässlich sind nur im spoiler:

erste szene:

zweite szene:

dritte szene:

bei den werten sollte klar sein was was ist... die hinterste prozentangabe bei gpu dürfte power sein, die geht manchmal über 100%

ich hab auch mal den strom gemessen. bei der zweiten szene waren es mal kurz 550 watt, sonst ist alles im 500er bereich oder knapp darunter. wenn man bedenkt das die cpu hier praktisch kaum was macht ist klar das es nicht höher geht.

nebenfrage zum msi afterburner.... kann man das irgendwie so einstellen das genau für die einzelnen sachen da steht was sie bedeuten ?

die ramauslastung der grafikkarte ist auch ganz schön groß mit über 10 gb

also wenn man bedenkt das sie nur 11 gb hat. achso und wieso sieht man nicht die max und die niedrigsten fps auch wenn ich es eingestellt habe ?

also wenn man bedenkt das sie nur 11 gb hat. achso und wieso sieht man nicht die max und die niedrigsten fps auch wenn ich es eingestellt habe ?so dann..... kann man von den werten her irgendwie erkennen ob ich was falsch eingestellt habe ? wieso ist die cpu auslastung bei mir so dermaßen gering und bei fliwatut bremst die cpu ?

edit: könnten ausserdem die höheren fps bei fliwatut daher kommen weil es dort nativ und nicht dsr ist ? oder ist der threadripper einfach ungeeignet ^^

Zuletzt bearbeitet:

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Woher weiß Fliwatut denn, dass seine CPU limitiert? Und vor allem wo? Kann da an dem Screenshot nichts erkennen.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

hmm äh keine ahnung ^^ wird er schon noch sagen. vielleicht auch mal mit einem test mithilfe vom afterburner.

ich glaube auch nicht das ein deaktivieren der kerne beim threadripper helfen würde. die laufen ja letztlich jetzt alle mit 4100 mhz und mehr würde ich wohl auch nicht machen wollen bei weniger kernen . zumindest kann ich mir nicht vorstellen das bei der geringen auslastung eine erhöhung etwas bringt.

. zumindest kann ich mir nicht vorstellen das bei der geringen auslastung eine erhöhung etwas bringt.

die cpu temperatur gibt mir aber doch zu denken..... wenn ich wüsste ob das wirklich stimmt. es geht teils auf über 70 grad. (bei hw monitor sieht das anders aus)

ich glaube auch nicht das ein deaktivieren der kerne beim threadripper helfen würde. die laufen ja letztlich jetzt alle mit 4100 mhz und mehr würde ich wohl auch nicht machen wollen bei weniger kernen

. zumindest kann ich mir nicht vorstellen das bei der geringen auslastung eine erhöhung etwas bringt.

. zumindest kann ich mir nicht vorstellen das bei der geringen auslastung eine erhöhung etwas bringt.die cpu temperatur gibt mir aber doch zu denken..... wenn ich wüsste ob das wirklich stimmt. es geht teils auf über 70 grad. (bei hw monitor sieht das anders aus)

Zuletzt bearbeitet:

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Mein 3700X geht ständig kurzfristig auf 70-80°C beim Zocken (mit sehr starken Schwankungen hoch und runter), trotz AiO Wakü und guter Wärmeleitpaste. Ohne eine fette Wasserkühlung sind niedrigere Temperaturen wohl einfach nicht drin bei so vielen Kernen. Völlig normal.

Wobei meine Temperaturen sich seit dem letzten BIOS Update um 10°C erhöht haben, also da geht mit künftigen Updates vielleicht noch was.

Wobei meine Temperaturen sich seit dem letzten BIOS Update um 10°C erhöht haben, also da geht mit künftigen Updates vielleicht noch was.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

hmm du meinst also die angabe beim afterburner stimmt definitiv ? angenommen ich spiele und wechsle dann zurück und schau mir das beim hd monitor an... sollte das echt so schnell von 70 grad auf irgendwas um die 40 zurückgehen ?

die cpu auslastung liegt ja wie man hoffentlich auf den screenshots erkennen kann gerade mal bei 7-28 %. drosselt die cpu ?

die cpu auslastung liegt ja wie man hoffentlich auf den screenshots erkennen kann gerade mal bei 7-28 %. drosselt die cpu ?

Casi030

Grand Admiral Special

- Mitglied seit

- 03.10.2012

- Beiträge

- 8.942

- Renomée

- 153

Wie hoch ist denn die Temperatur direkt nach nem Kaltstart und natürlich Idle auf dem Desktop?!

Dafür muss HWInfo64 natürlich recht schnell Starten.....

Wie ist die Zimmertemperatur?

Welche Temperatur ändert sich schnell wenn Prime an gemacht wird um rund 20-30°C?

Erst wenn man sich im Klaren ist mit welcher CPU Temperatur man Arbeiten kann,erst dann kann man sagen ob es zu hoch ist oder nicht.

Dafür muss HWInfo64 natürlich recht schnell Starten.....

Wie ist die Zimmertemperatur?

Welche Temperatur ändert sich schnell wenn Prime an gemacht wird um rund 20-30°C?

Erst wenn man sich im Klaren ist mit welcher CPU Temperatur man Arbeiten kann,erst dann kann man sagen ob es zu hoch ist oder nicht.

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- Ryzen 5900X

- Mainboard

- MSI X570-A Pro

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 4x8GB Corsair DDR4-3200 CL16

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Meine CPU-Auslastung beim Zocken vom neuen Wolfenstein ist auch relativ niedrig, bekomme als Max.-Wert 50% angezeigt, die maximal erreichte Temperatur trotzdem 80°C.

Ja, die Temperatur schwankt bei mir auch extrem schnell. In der einen Sekunde 70°C und dann 1-2 Sekunden später, wenn die Last weg ist, nur noch 50°C. Die Temperatur wird irgendwo innen gemessen, wo sie extrem schnell schwankt.

Ja, die Temperatur schwankt bei mir auch extrem schnell. In der einen Sekunde 70°C und dann 1-2 Sekunden später, wenn die Last weg ist, nur noch 50°C. Die Temperatur wird irgendwo innen gemessen, wo sie extrem schnell schwankt.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

@ casi

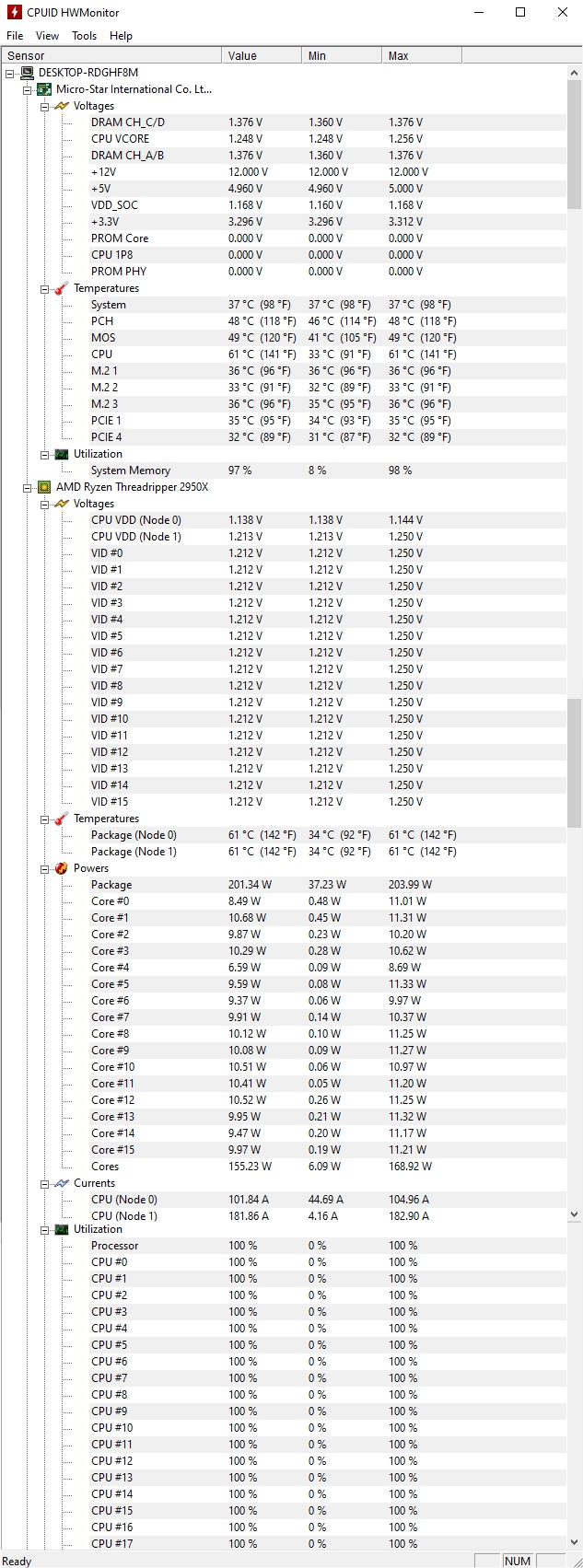

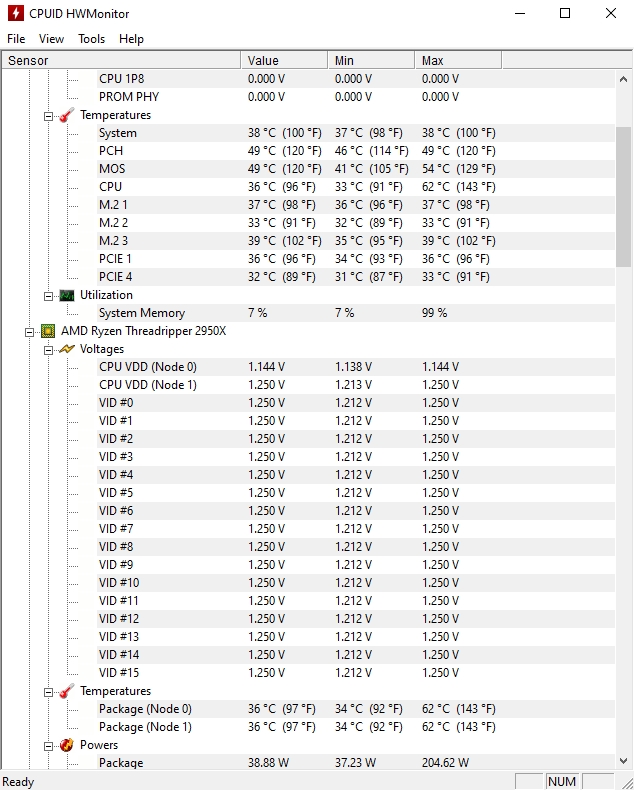

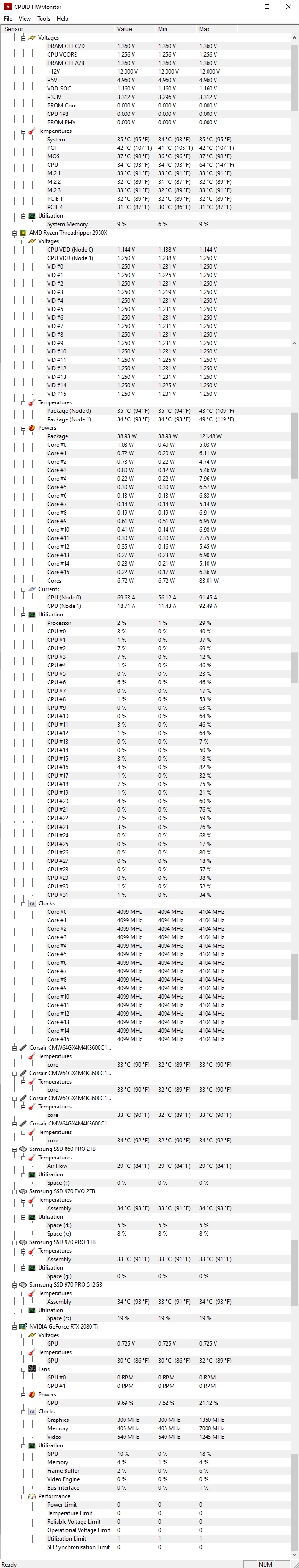

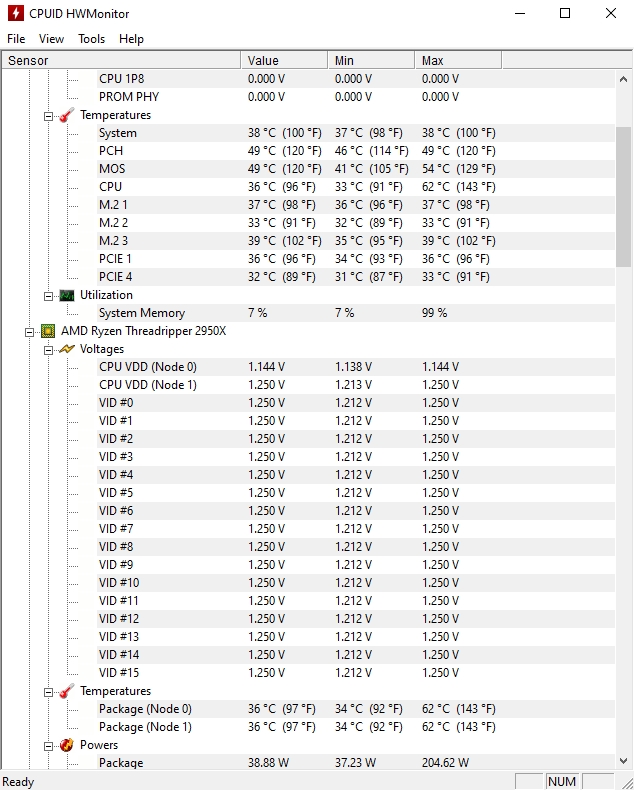

also direkt kaltstart kann ich jetzt natürlich nicht testen. ich hatte es allerdings während ich essen war ne weile aus.

hab daher mal spassehalber ein paar screenshots gemacht und es zusammengefügt . (daher können die werte innerhalb ein wenig abweichen)

. (daher können die werte innerhalb ein wenig abweichen)

da mich die andere kiste wahnsinnig macht und ich dort nicht klar komme, das zeug auf nen stick und auf den einzigen wahren rechner kopiert .

.

ok hier also direkt jetzt nach dem "warmen" kaltstart ^^ (vorsicht scrollerei)

mit prime hab ich keine erfahrung und es nur mal runtergeladen und ein wenig laufen lassen. so sieht es dann aus...:

und hier noch ein einzelbild eine kurze weile nach dem beenden von prime:

ob die grafikkarte alleine ausreicht das dort auf einmal beim afterburner über 70 grad kommen halte ich für ausgeschlossen. es sind ja nunmal 2 kreisläufe ...kann also nicht am wasser liegen und es müsste ja dann auch wenn man beim hw monitor clear macht am ende ein maximaler wert erscheinen der mit dem übereinstimmt und dort gabs noch nie 70 grad oder mehr.

raumtemperatur weis ich nicht. der raum ist noch relativ angenehm , kälter als in dem ich gerade sitze ^^.....bei dem einen thermometer ist gerade die batterie runter ....und so ein 9 v block hab ich nich da....wenn man schonmal was braucht.

also direkt kaltstart kann ich jetzt natürlich nicht testen. ich hatte es allerdings während ich essen war ne weile aus.

hab daher mal spassehalber ein paar screenshots gemacht und es zusammengefügt

. (daher können die werte innerhalb ein wenig abweichen)

. (daher können die werte innerhalb ein wenig abweichen)da mich die andere kiste wahnsinnig macht und ich dort nicht klar komme, das zeug auf nen stick und auf den einzigen wahren rechner kopiert

.

.ok hier also direkt jetzt nach dem "warmen" kaltstart ^^ (vorsicht scrollerei)

mit prime hab ich keine erfahrung und es nur mal runtergeladen und ein wenig laufen lassen. so sieht es dann aus...:

und hier noch ein einzelbild eine kurze weile nach dem beenden von prime:

ob die grafikkarte alleine ausreicht das dort auf einmal beim afterburner über 70 grad kommen halte ich für ausgeschlossen. es sind ja nunmal 2 kreisläufe ...kann also nicht am wasser liegen und es müsste ja dann auch wenn man beim hw monitor clear macht am ende ein maximaler wert erscheinen der mit dem übereinstimmt und dort gabs noch nie 70 grad oder mehr.

raumtemperatur weis ich nicht. der raum ist noch relativ angenehm , kälter als in dem ich gerade sitze ^^.....bei dem einen thermometer ist gerade die batterie runter ....und so ein 9 v block hab ich nich da....wenn man schonmal was braucht.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

nein definitiv nicht ^^ ...die temperatur für die gpu ist ja zu sehen auf den screenshots oben ....die dümpelt immer so bei 48-49 grad rum und das beanstande ich auch nicht , weil es der afterburner und hw monitor exakt gleich anzeigt. wäre ja auch ein witz bei dem großen kühlkreislauf 70 grad zumal der auch noch die luft von vorne direkt bekommt.

aber ich werde dein programm noch testen ...ich habs blos falsch gelesen sorry

aber ich werde dein programm noch testen ...ich habs blos falsch gelesen sorry

Ähnliche Themen

- Umfrage

- Antworten

- 30

- Aufrufe

- 2K

- Antworten

- 0

- Aufrufe

- 649

- Antworten

- 0

- Aufrufe

- 624