App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

- Status

- Für weitere Antworten geschlossen.

@ TNT Wenn er gekauft wird wie blöde

Richtig - und das wird er vielleicht - wenn der Preis/Leistung stimmt. Es wird mitnichten ein schlechter Prozessor (ja, ja er wird vermutlich fuer 110% aller anstehenden Aufgaben und das sogar fuer 120% aller Anwender reichen).

Es scheint nur so zu sein, dass AMD hier viel Transistoren in BDv1 und Aufwand verballert hat und irgendwie in den letzten Monaten die (meine) Erwartungen an BD immer weiter zu recht gestutzt wurden.

Aber die Hoffnung, dass AMD mit BDv1 Anschluss an Intel finden koennte - ist erst ein mal dahin. Ein Intel 2700k wird vermutlich reichen um AMDs neues Prachtpferd in die Schranken zu weisen - und zwar in allen Bereichen.

Gewonnen und verdient wird aber nicht mit den Prachtpferden, sondern mit den Galoppern, die die vielen Karren zum Markt ziehen fuer den Normalbuerger.

Hier wird es sich zeigen, ob der Verbrauch und das Angebot(sprich auch das Yield) stimmt.

Das wird sich aber erst nach dem Launch zeigen...

Zuletzt bearbeitet:

nonworkingrich

Captain Special

- Mitglied seit

- 28.04.2006

- Beiträge

- 234

- Renomée

- 4

Hmmm... ich erinnere mich noch an eine Aussage eines Google-Mitarbeiters auf einer Intel-Veranstaltung (wo der P4 beworben werden sollte ^^), dass sie eigentlich keine P4s wollen, sondern viel lieber stromsparende Celerons

Insofern wäre eine Entwicklungsvorgabe für den Bulldozer à la "Bobcat mit mehr Taktpotenzial + Skalierbarkeit der Kernzahl" für den Serverbereich sehr verständlich. Allerdings sollte man es dann auch den Desktop-Endkunden gegenüber entsprechend kommunizieren und den Erwartungen auf ein "next big thing" offen entgegentreten (anstatt sie sogar noch zu schüren). Sonst wird es ein Desaster.

Aber vielleicht kommt ja doch alles ganz anders und das Wunder-BIOS am Vorlaunchtag treibt die Performance noch in ungeahnte Höhen. Wer weiß

Insofern wäre eine Entwicklungsvorgabe für den Bulldozer à la "Bobcat mit mehr Taktpotenzial + Skalierbarkeit der Kernzahl" für den Serverbereich sehr verständlich. Allerdings sollte man es dann auch den Desktop-Endkunden gegenüber entsprechend kommunizieren und den Erwartungen auf ein "next big thing" offen entgegentreten (anstatt sie sogar noch zu schüren). Sonst wird es ein Desaster.

Aber vielleicht kommt ja doch alles ganz anders und das Wunder-BIOS am Vorlaunchtag treibt die Performance noch in ungeahnte Höhen. Wer weiß

Nein, der Ingenieure. Hotchips 22:

http://www.hotchips.org/conference-archives/hot-chips-22

AMD "Bulldozer" Core - a new approach to multithreaded compute performance for maximum efficiency and throughput

Authors: Mike Butler

Folie mit "80%"-Erwähnung:

http://www.anandtech.com/Gallery/Album/754#6

Danke fuer die Links. Das war aber auch eher eine rhetorische Frage - das mit der reinen Marketing Folie ist da nicht passend gewesen. Es ist aber so, dass diese Zahl von '80%' auf theoretischen Berechnungen beruht - die man bei AMD durchgefuehrt hat, in dem man ein BD 'Module' mit einem Kern simuliert hat.

Also, ist es recht vage und nicht nachpruefbar - was aber sicher nicht heissen muss, dass es nicht stimmt. Dennoch ist die pauschale Aussage etwas zu einfach und darf sicherlich nicht auf alle Faelle angewendet werden - mal geht es nach oben, mal nach unten.

Aber da man sich fuer das Modulekonzept mit zwei INT Cores entschieden hat, ist eh Perlen vor die S...geworfen.

.

EDIT :

.

...

Aber vielleicht kommt ja doch alles ganz anders und das Wunder-BIOS am Vorlaunchtag treibt die Performance noch in ungeahnte Höhen. Wer weiß

Ich lehne mich mal aus dem Fenster - wenn der Launch wirklch am 12. Oktober stattfindet, wird es nun kein Wunderbios mehr gehen - im Sinne, dass die Gesamtperformance noch mal um mehr als 1-2% angehoben wird.

Oder launcht AMD eine Beta Version von BDv1? Wohl kaum...oder etwa doch?

Opteron

Redaktion

☆☆☆☆☆☆

Sieht für mich danach aus.Oder launcht AMD eine Beta Version von BDv1? Wohl kaum...oder etwa doch?

Allein die Tatsache, dass Asus neben dem offiziellen Release BIOS gleichzeitig schon ein neueres Beta BIOS bei Hand hat zeigt, dass da noch was zu tun ist.

Irgendwie ein Schnellschuss, wahrscheinlich braucht AMD das Geld.

Ich frag mich nur echt, wie die ernsthaft glauben konnten, ne B0 Revision im Q2 zu launchen, was waren da für Träumer am planen? Hatte JF AMD mal darauf angesprochen, da meinte er, dass beim E0 das erste Silizium ja auch ganz toll gewesen wäre. Daraufhin hab ich erwidert, dass das nur ein kleiner Patch von nem alten, bewährten Core im bewährten 45nm Prozess gewesen sei, und BD da ein ganz anderes Kaliber sei, Antwort ... tja Null ...

Langsam glaube ich sogar die Unkenrufe von vor ein paar Wochen beim Sysmark Ausstieg.

Wird bei mir wohl eher ein 960T als ein FX4 oder FX6 werden.

Ich auch nicht ^^Die Frage ist doch, was man von BD erwartet - erwarten kann oder erwarten soll. Dass er das aktuelle Topmodell von AMD 1100T in allen Belangen an die Wand spielt? Dass er Intels Top Desktopmodelle Feuer unter dem Hintern macht? Dass er deutlich guenstiger Leistung anbieten als AMD oder Intel jetzt? Dass er die Leistungsspitze erobert? Dass die 'IPC' pro Core zu legt? Dass das jetzige finale Produkt aus Not geboren wurde - da man endlich etwas vorzuweisen hat und um die 'alten' K10.5 zu ersetzen?

Dass es eine 1. 'Rohfassung' der BD Architektur ist?

Wann wird BDv1 zum Erfolg fuer AMD?

Ehrlich gesagt - ich weiss es nicht.

Bei den aktuellen Spielen mit max. 4 Threads holt man sich auf alle Fälle ne blutige Nase und bei multithreaded Cinebench &Co ist man nur nahe beim 2600K dran und/oder SandyE macht das.

Bleibt warten auf Rev.C, bis dahin kann mans mit Rev. E0 sicher ganz gut aushalten ^^

Zuletzt bearbeitet:

Duplex

Admiral Special

@Opteron

Core2 wurde auch im B0 Stepping gelauncht und war einwandfrei

Bzgl. Bulldozer B0 > B1 & B2 können das auch nur Taktupdates gewesen sein weil die IPC nicht den erwartungen entsprach, es muss nicht umbedingt das Design betreffen.

Core2 wurde auch im B0 Stepping gelauncht und war einwandfrei

Bzgl. Bulldozer B0 > B1 & B2 können das auch nur Taktupdates gewesen sein weil die IPC nicht den erwartungen entsprach, es muss nicht umbedingt das Design betreffen.

Opteron

Redaktion

☆☆☆☆☆☆

Nö das war B2. B0 hatte da noch einige Problemchen:@Opteron

Core2 wurde auch im B0 Stepping gelauncht und war einwandfrei

http://www.techarp.com/showarticle.aspx?artno=407&pgno=1Why You Should AVOID Intel Core 2 Engineering Samples Rev. 4.1

The B0 Stepping

The majority of these ES-related problems involve the B0 stepping.

Und verglichen mit BD war das halt auch nur ein weiterentwickelter Pentium3, d.h. hatte ne ausgereifte Basis.

Bei BD dagegen scheints jetzt noch an Grundlegendem wie dem Snoop-Mechanismus oder den Caches allgemein zu hapern, ist halt schon blöd, wenn da nicht klar ist, wo in welchem Cache gültige Daten stehen können. Wenn da andauernd un den ganzen L1 Caches geschnüffelt werden muss, Prost Mahlzeit.

Selbst wenn: Pech, wenn man ne nagelneue Architektur in nem neuen Prozess launchen will. Das hat letztens Nvidia bei Fermi probiert ... Resultat? Intel hat nicht umsonst tick-tock.Bzgl. Bulldozer B0 > B1 & B2 können das auch nur Taktupdates gewesen sein weil die IPC nicht den erwartungen entsprach, es muss nicht umbedingt das Design betreffen.

Fermi 2.0 ist aber immerhin ganz ok, hoffen wir dass es mit Rev.C ählich ausschaut. Für die aktuelle BD Generation schauts dagegen eher noch schlechter als Fermi aus.

Zuletzt bearbeitet:

Duplex

Admiral Special

Die Integer Leistung vom Core2 mit B0 war Super & der rest war zu dem Zeitpunkt auch i.o.Nö das war B2. B0 hatte da noch einige Problemchen:

http://www.techarp.com/showarticle.aspx?artno=407&pgno=1

Mehr hat damals keiner gegenüber K8 & P4 erwartet

.

EDIT :

.

Wenns nach dieser billigen Folie von Donanimhaber geht kommt Vishera erst ab Q3/2012, wer weiß was bis dahin alles noch passiert...Eine neue Maske mit besseren Kernen kann man bestimmt erwarten.Fermi 2.0 ist aber immerhin ganz ok, hoffen wir dass es mit Rev.C ählich ausschaut. Für die aktuelle BD Generation schauts dagegen eher noch schlechter als Fermi aus.

Gab es von HP nicht noch eine Folie mit 28nm BD?

Opteron

Redaktion

☆☆☆☆☆☆

Ach Du siehst das nur aus Leistungssicht. Auch gut, aber wie besagt, war ein einfacherer Schritt als jetzt mir BD. Bei neuen Sachen muss man immer mit mehr Aufwand rechnen.Die Integer Leistung vom Core2 mit B0 war Super & der rest war zu dem Zeitpunkt auch i.o.

Mehr hat damals keiner gegenüber K8 & P4 erwartet

Könntest aus der Sicht ja auch sagen, dass Phenom B2 ganz ok war

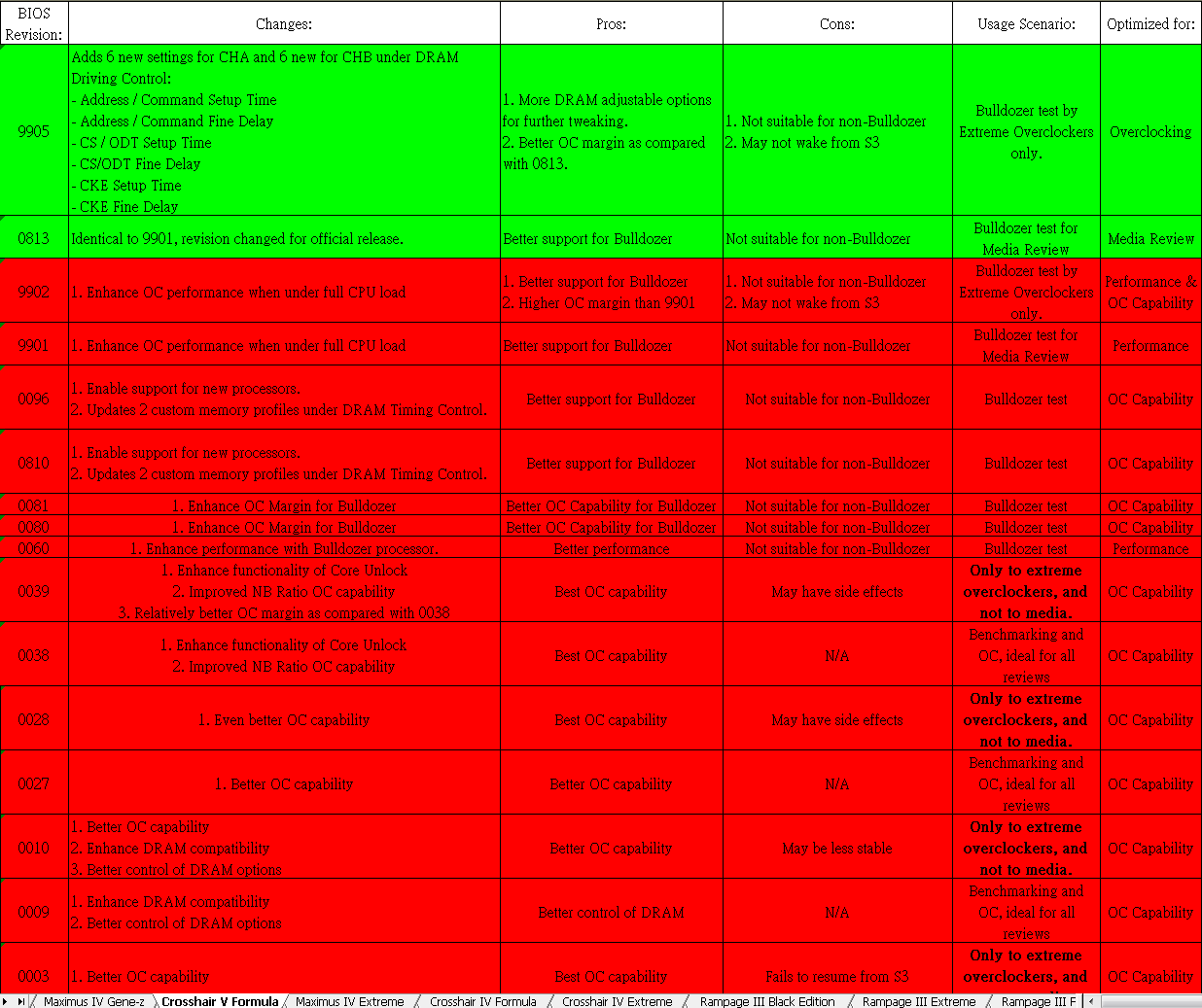

Ansonsten, hier hat noch jemand was zum Asus BIOS gepostet:

http://www.xtremesystems.org/forums...nnaly-tested&p=4968493&viewfull=1#post4968493

Da steht auch noch was zu "Core Unlock", allerdings ist da nicht klar, ob sie auch BD meinen, oder sich auf die alten Phenoms beziehen.

Edit:

Die neue Maske mit den besseren Kernen ist mMn Vishera. Für Vishera brauchen sie auf alle Fälle ne neue Maske, und die Chipproduktion, bis hinten an der Fab was rauskommt dauert ~ halbes Jahr. Um auf genügend Stückzahl zu kommen warten man dann noch ein paar Monate mit Start.Wenns nach dieser billigen Folie von Donanimhaber geht kommt Vishera erst ab Q3/2012, wer weiß was bis dahin alles noch passiert...Eine neue Maske mit besseren Kernen kann man bestimmt erwarten.

Da sehe ich keinen Platz für ne extra Zambezi Maske dazwischen, da es mMn kein "dazwischen" gibt.

Zuletzt bearbeitet:

Crashtest

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2008

- Beiträge

- 9.283

- Renomée

- 1.414

- Standort

- Leipzig

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Collatz, yoyo, radac

- Lieblingsprojekt

- yoyo

- Meine Systeme

- Ryzen: 2x1600, 5x1700, 1x2700,1x3600, 1x5600X; EPYC 7V12 und Kleinzeuch

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Lenovo IdeaPad 5 14ALC05

- Details zu meinem Desktop

- Prozessor

- Ryzen 7950X / Ryzen 4750G

- Mainboard

- ASRock B650M PGRT / X570D4U

- Kühlung

- be quiet! Dark Rock Pro4 / Pure Rock Slim 2

- Speicher

- 64GB DDR5-5600 G Skill F5-5600J3036D16G / 32 GB DDR4-3200 ECC

- Grafikprozessor

- Raphael IGP / ASpeed AST-2500

- Display

- 27" Samsung LF27T450F

- SSD

- KINGSTON SNVS2000G

- HDD

- - / 8x Seagate IronWolf Pro 20TB

- Optisches Laufwerk

- 1x B.Ray - LG BD-RE BH16NS55

- Soundkarte

- onboard HD?

- Gehäuse

- zu kleines für die GPU

- Netzteil

- be quiet! Pure Power 11 400W / dito

- Tastatur

- CHERRY SECURE BOARD 1.0

- Maus

- Logitech RX250

- Betriebssystem

- Windows 10 19045.4355 / Server 20348.2402

- Webbrowser

- Edge 124.0.2478.51

- Verschiedenes

- U320 SCSI-Controller !!!!

- Internetanbindung

- ▼1000 MBit ▲82 MBit

Naja bleibt es ggf bei der Ausage seit Hammer:

keine (große Server & Highenddesktop) CPU von AMD vor Rev. C

SH-B0 & SH-B3 hatten auch einige große "Macken" zB SSE2.

Bei Deerhound gabs ja auch das Bx Problem - selbst ein DR-B3 haben einige übersprungen und auch Ridgeback C2 gewartet ...

Ma sehen was OR-B2 so bringt bei Wald und Wiesensoftware - einige hochoptimierte Programme kicken Intel tief in den Ar... wenn SSE5 ähm XOP richtig verwendet wird

Dass Bulldozer so schlecht nicht sein kann zeigt doch Cray - sonst würden die keine verbauen sondern weiterhin MangyCs

keine (große Server & Highenddesktop) CPU von AMD vor Rev. C

SH-B0 & SH-B3 hatten auch einige große "Macken" zB SSE2.

Bei Deerhound gabs ja auch das Bx Problem - selbst ein DR-B3 haben einige übersprungen und auch Ridgeback C2 gewartet ...

Ma sehen was OR-B2 so bringt bei Wald und Wiesensoftware - einige hochoptimierte Programme kicken Intel tief in den Ar... wenn SSE5 ähm XOP richtig verwendet wird

Dass Bulldozer so schlecht nicht sein kann zeigt doch Cray - sonst würden die keine verbauen sondern weiterhin MangyCs

mariahellwig

Grand Admiral Special

Ich will ja nicht klugscheißen, aber ich habe schon vor Wochen gesagt das BD AMD's Fermi wird. Die ganze Argumentation wegen des Vorziehens von Llano seitens AMD war höchst unglaubwürdig. Und spätestens als die Preise bekannt wurden, war mir klar, das wird nix.

Ich stelle mir die Frage, ob die nächste Generation das leisten wird, was BD mal versprochen hat. Wenn dem so ist, wird man mit einem blauen Auge davon kommen. Wenn nicht, hat man ein echtes Problem.

Wichtiger als BD finde ich sowieso die neue Archtitektur GCN. Auf die 10% x86 Leistung kann ich getrost pfeifen. Wichtiger ist es den Fusion Ansatz nach vorn zu bringen und mit Trinity eine bessere Verfügbarkeit zu erreichen.

Und das ich den Ehrgeiz von AMD neue Archtitekturen und neue Strukturbreiten auf einmal zu bringen bewunderswert finde, hatte ich auch schon erwähnt. Nur, so etwas kann eben auch in die Hose gehen.

Ich stelle mir die Frage, ob die nächste Generation das leisten wird, was BD mal versprochen hat. Wenn dem so ist, wird man mit einem blauen Auge davon kommen. Wenn nicht, hat man ein echtes Problem.

Wichtiger als BD finde ich sowieso die neue Archtitektur GCN. Auf die 10% x86 Leistung kann ich getrost pfeifen. Wichtiger ist es den Fusion Ansatz nach vorn zu bringen und mit Trinity eine bessere Verfügbarkeit zu erreichen.

Und das ich den Ehrgeiz von AMD neue Archtitekturen und neue Strukturbreiten auf einmal zu bringen bewunderswert finde, hatte ich auch schon erwähnt. Nur, so etwas kann eben auch in die Hose gehen.

Zuletzt bearbeitet:

Duplex

Admiral Special

@Opteron

Wie unterscheidest du Zambezi, Piledriver & Vishera?

Rev. Bx = Zambezi

Rev. Cx = Piledriver (5-10% mehr IPC?)

Was für Kerne könnte dann Vishera haben?

@Ulukay

Korrekt, Fermi hat mehr Strom verbraucht, war aber schneller als der RV870

Wie unterscheidest du Zambezi, Piledriver & Vishera?

Rev. Bx = Zambezi

Rev. Cx = Piledriver (5-10% mehr IPC?)

Was für Kerne könnte dann Vishera haben?

@Ulukay

Korrekt, Fermi hat mehr Strom verbraucht, war aber schneller als der RV870

nonworkingrich

Captain Special

- Mitglied seit

- 28.04.2006

- Beiträge

- 234

- Renomée

- 4

Alles sehr mysteriös iwie. Man (bzw. ich persönlich ^^) erwartet seit dem K7 von jeder neuen AMD-Architektur einen Paukenschlag. Und jetzt scheint es eher ein Schlag ins Wasser zu werden. Da fragt man sich doch zwei Dinge: 1.) Was haben die die ganzen Jahre getan und 2.) wofür verbraten die soviele Transistoren und Die-Fläche?

Bei den Ergebnissen bekommt man ja den Eindruck, die Mannschaft um Glenn Henry hätte das Design während eines Kegelausflugs aus dem Boden stampfen können - morgens um zwei, wenn schon alle besoffen sind.

Hat AMD mit den Überläufern von Intel die falschen Leute eingekauft? Hätte man sich besser Centaur gegriffen? Standen von den Ex-Intelianern vielleicht einige auch nach ihrem Wechsel zu AMD noch auf Intels Gehaltsliste?

Das Leistungsniveau des Bulldozer ergibt einfach keinen Sinn. K8 war sehr gut zu seiner Zeit, BD scheint dagegen einfach der Mühe nicht wert. Ich erwarte überhaupt nicht, dass sie die High-End-Abteilung Intels dominieren, das ist mir ehrlich gesagt komplett egal, aber ich erwarte, dass eine neue Generation einen deutlichen Vorsprung gegenüber der eigenen aktuellen einfährt. Insbesonderes, wenn man sich vor Augen hält, wie alt die aktuelle ist. Ich versteh's einfach nit.

Bei den Ergebnissen bekommt man ja den Eindruck, die Mannschaft um Glenn Henry hätte das Design während eines Kegelausflugs aus dem Boden stampfen können - morgens um zwei, wenn schon alle besoffen sind.

Hat AMD mit den Überläufern von Intel die falschen Leute eingekauft? Hätte man sich besser Centaur gegriffen? Standen von den Ex-Intelianern vielleicht einige auch nach ihrem Wechsel zu AMD noch auf Intels Gehaltsliste?

Das Leistungsniveau des Bulldozer ergibt einfach keinen Sinn. K8 war sehr gut zu seiner Zeit, BD scheint dagegen einfach der Mühe nicht wert. Ich erwarte überhaupt nicht, dass sie die High-End-Abteilung Intels dominieren, das ist mir ehrlich gesagt komplett egal, aber ich erwarte, dass eine neue Generation einen deutlichen Vorsprung gegenüber der eigenen aktuellen einfährt. Insbesonderes, wenn man sich vor Augen hält, wie alt die aktuelle ist. Ich versteh's einfach nit.

Opteron

Redaktion

☆☆☆☆☆☆

Na Piledriver@Opteron

Wie unterscheidest du Zambezi, Piledriver & Vishera?

Rev. Bx = Zambezi

Rev. Cx = Piledriver (5-10% mehr IPC?)

Was für Kerne könnte dann Vishera haben?

MMn:

Orochi Rev.C (Herstellungscodname) = Vishera (Marketingchipname) = Orochi mit Piledriver, anstatt Bulldozer Kernen.

Weitere Diskussionen besser im BD2 Thread

Jo deswegen schrieb ich, es sieht schlechter aus@Ulukay

Korrekt, Fermi hat mehr Strom verbraucht, war aber schneller als der RV870

@mariahellwig:

Stimmt, Gratulation ^^

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.394

- Renomée

- 1.986

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Fermi hatte fuer die erbrachte Leistung zu viel Strom verballert.BD ist beim besten willen nicht AMDs Fermi.

Fermi war zwar laut und heiss, dafuer aber sauschnell!

Mag sein das er schneller als ein Cypress Chip ist aber was bringt es ihm wenn die GTX480 mit einem Fermi ca. so viel Strom wie das Cypress Doppelgespann in Form der HD5970 verballert hat aber letztendlich deutlich langsamer war?

Ulukay

Fleet Captain Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 295

- Renomée

- 0

Fermi hatte fuer die erbrachte Leistung zu viel Strom verballert.

Mag sein das er schneller als ein Cypress Chip ist aber was bringt es ihm wenn die GTX480 mit einem Fermi ca. so viel Strom wie das Cypress Doppelgespann in Form der HD5970 verballert hat aber letztendlich deutlich langsamer war?

aepfel und birnen

sli/crossfire ist fuer bencher intressant, gamer die KEINEN inputlag und KEINE mikroruckler wollen, wollen die schnellste singlegpu karte.

wie du schon sagtest, Fermi war die schnellste karte. der bulldozer ist ARSCHLAHM und verbraucht VIEL MEHR. also KEIN vergleich zu Fermi.

so - jetzt laber weiter warum der BD doch so toll ist.

das ist naemlich das thema, und nicht ob DU dualgpu geruckel besser findest oder nicht.

Zuletzt bearbeitet:

Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

Der nächste der eien Moderne CPU-Architektur, die in der Lage ist abermilliarden von rechenoperationen pro sekunde auszuführen als "Arschlahm" oder sonst irgendwie diffamierend bezeichnet, wird geschrumpft und darf im nächsten Universitäts-rechencluster die ganzen berechungen von Hand auf paoier ausführen... die Zeit wird gestoppt, und wenn er langsamer ist als die CPU gibts Stromschläge.

BD ist nicht das schnellste Stück silizium das man kaufen kann...aber Lahm ist nun wirklich was anderes!

BD ist nicht das schnellste Stück silizium das man kaufen kann...aber Lahm ist nun wirklich was anderes!

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Also wenn du ein Exemplar hast, dann wirst du es nachweisen können. 1 Thread vs 2 Threads pro CU (Turbo aus). Natürlich muss man dann schon verschiedene Workloads testen, um einen aussagekräftigen Mittelwert zu bekommen. Die von Dresdenboy verlinkte Folie mit den 80% ist übrigens ein anderer Sachverhalt. Da geht's darum, wie das CMT Design als gesamtes gegenüber CMP skaliert, nicht darum, wie CMT von ein auf zwei Threads skaliert.Mal eine andere Frage - hat man eigentlich diese 80% Zahl nachgewiesen? Kann man es nachweisen?

Schlechter? Wie soll das möglich sein?Fermi 2.0 ist aber immerhin ganz ok, hoffen wir dass es mit Rev.C ählich ausschaut. Für die aktuelle BD Generation schauts dagegen eher noch schlechter als Fermi aus.

So schlecht wird es schon nicht werden. So schlecht kann es gar nicht werden. Bei Fermi hatte man weder die Fertigung, noch den Stromhunger im Griff. Das kann man von Bulldozer nicht behaupten.

So schlecht wird es schon nicht werden. So schlecht kann es gar nicht werden. Bei Fermi hatte man weder die Fertigung, noch den Stromhunger im Griff. Das kann man von Bulldozer nicht behaupten.Ja, gegenüber der Konkurrenz 10-15% mehr in Spielen und öfters deutlich hinterher bei GPGPU ist "sauschnell". Dafür hat man auch nur >60% mehr Energie gebraucht.BD ist beim besten willen nicht AMDs Fermi.

Fermi war zwar laut und heiss, dafuer aber sauschnell!

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

So so, Leistungsniveau eines i5-2500 / i7-2600 und mit ISA Erweiterungen auch darüber wäre also "ARSCHLAHM"?der bulldozer ist ARSCHLAHM und verbraucht VIEL MEHR. also KEIN vergleich zu Fermi.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif) Und wo gibt es aussagekräftige Zahlen zum "Verbrauch"? Ich kenne nur die vom Unaussprechbaren und bis auf ein paar wenige Watt zeigen die keine grossen Unterschiede zum i7-2600 unter Volllast. Und wenn man nur ansatzweise die Stromspartechniken wie bei Bobcat und Llano im Griff hat, dann sollte Bulldozer erst recht unter Teillast sparsam sein.

Und wo gibt es aussagekräftige Zahlen zum "Verbrauch"? Ich kenne nur die vom Unaussprechbaren und bis auf ein paar wenige Watt zeigen die keine grossen Unterschiede zum i7-2600 unter Volllast. Und wenn man nur ansatzweise die Stromspartechniken wie bei Bobcat und Llano im Griff hat, dann sollte Bulldozer erst recht unter Teillast sparsam sein.

Zuletzt bearbeitet:

Man sollte schon etwas am Boden bleiben.wie du schon sagtest, Fermi war die schnellste karte. der bulldozer ist ARSCHLAHM und verbraucht VIEL MEHR. also KEIN vergleich zu Fermi.

Nur weil er jetzt nicht Sandy-Bridge-Killer wird, ist er jetzt noch lange nicht lahm & schlecht.

Man hatte zwar bei BD1 mehr IPC erspekuliert, aber dafür nachher kaum IPC-Steigerungen.

So wie es jetzt aussieht, hat er weniger IPC als gedacht, aber dafür sieht es jetzt nachher nach "größereren" IPC-Steigerungen aus.

Dazu sieht es Übertaktungs-Potential recht gut aus, sodass sie auch im Notfalls über den Takt gehen kann.

Stimmt, mit Fermi kann man nicht vergleichen.

Der Vorgänger von Fermi war effizienter, was man von K10 vs. Westmere nicht sagen kann.

Markus Everson

Grand Admiral Special

BD ist beim besten willen nicht AMDs Fermi.

Fermi war zwar laut und heiss, dafuer aber sauschnell!

Bring BD auf die TDP von Fermi und er rennt wie Luzi, das scheint ja schon fast fest zu stehen.

Opteron

Redaktion

☆☆☆☆☆☆

In 3 Tagen weißt DusSchlechter? Wie soll das möglich sein?http://www.abload.de/image.php?img=img003300028f9.png

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

Mit solchen Aussagen sollte man sehr vorsichtig sein. Es wird sich sehr schnell zeigen, ob GloFo genügend Exemplare liefern kann. Laut Lab 501 hat AMD sieben Modelle in der Pipe, wird aber erst mal nur drei launchen - das spricht erneut für eine schlechte Ausbeute, so wie bei den Llanos. Kein gutes Zeichen ... leider. Der Stromverbrauch ist laut Donanim Haber höher als bei einem 1100T.Bei Fermi hatte man weder die Fertigung, noch den Stromhunger im Griff. Das kann man von Bulldozer nicht behaupten.

Somit sieht es danach aus, als ob man weder die Fertigung noch den Stromhunger im Griff hat.

EDIT

http://www.donanimhaber.com/islemci...ekirdekli-FX8150-islemcisi-video-inceleme.htm

Zuletzt bearbeitet:

So kurz vor dem Launch!? Wo sind denn die aktuellen positiven Nachrichten/Geruechte zu BDv1?

Dass man nun auch hoehere 'IPC' Steigerung hofft in den naechsten Inkarnationen von BD, weil sie beim BDv1 scheinbar ausbleiben, hat schon beinahe so was von einem Versuch sich Hoffnung zu machen...

Ebenso ist diese Hoffnung auf ein 'Wunderbios'....jetzt - Stunden vor dem Launch und den laufenden Test in den Redaktionen...etc. irgendwie ziemlich vage.

Ich bin mal gespannt, ob man bald sieht - wenn es wirklich so um BD bestellt ist, wie z.Z. angenommen - wo es denn im BDv1 hakt und was besser werden muss und wie man es am besten behebt.

Wo steckt das Potential der neuen Architektur - irgendwo muss es ja sein - ....also nicht theoretisch oder auf Folien...sondern in der Praxis...?

<boese>

Man koennte meine, dass Piledriver sein Debuet scheinbar im Trinity zu erst feiern muss, da man bei AMD gesehen hat, dass ein Trinity im CPU Teil mit BDv1 Cores schlechter abschneiden wuerde als Llano mit K10.6 Cores (+6% IPC K10.5 Core) ...und dieser Schmach will man sich nicht ausliefern.</boese>

Dass man nun auch hoehere 'IPC' Steigerung hofft in den naechsten Inkarnationen von BD, weil sie beim BDv1 scheinbar ausbleiben, hat schon beinahe so was von einem Versuch sich Hoffnung zu machen...

Ebenso ist diese Hoffnung auf ein 'Wunderbios'....jetzt - Stunden vor dem Launch und den laufenden Test in den Redaktionen...etc. irgendwie ziemlich vage.

Ich bin mal gespannt, ob man bald sieht - wenn es wirklich so um BD bestellt ist, wie z.Z. angenommen - wo es denn im BDv1 hakt und was besser werden muss und wie man es am besten behebt.

Wo steckt das Potential der neuen Architektur - irgendwo muss es ja sein - ....also nicht theoretisch oder auf Folien...sondern in der Praxis...?

<boese>

Man koennte meine, dass Piledriver sein Debuet scheinbar im Trinity zu erst feiern muss, da man bei AMD gesehen hat, dass ein Trinity im CPU Teil mit BDv1 Cores schlechter abschneiden wuerde als Llano mit K10.6 Cores (+6% IPC K10.5 Core) ...und dieser Schmach will man sich nicht ausliefern.</boese>

Zuletzt bearbeitet:

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Die Caches erscheinen weiterhin verkrüppelt, z.B.

http://forums.anandtech.com/showthread.php?t=2197131&page=2

L3 mit einem Kopier-/Schreibdurchsatz gleichauf mit RAM?

http://forums.anandtech.com/showthread.php?t=2197131&page=2

L3 mit einem Kopier-/Schreibdurchsatz gleichauf mit RAM?

Schaffe89

Gesperrt

- Mitglied seit

- 13.06.2011

- Beiträge

- 101

- Renomée

- 0

Mehr Stromverbrauch als ein 1100T? Das sieht ja wirklich überhaupt nicht gut aus.

Wenn man sich die bisherigen Leaks vor Augen führt, wird es noch zu einer schlechteren Situation führen als es damals bei Fermi war.

Hoher Verbrauch, miese IPC und Preise <150 Euro. Fermi konnte damals mit der Performance und Gimmiks überzeugen.

Der Vergleich ist doch witzlos.

AMD scheint so dringend neue Prozessoren veröffentlichen zu wollen, dass ihnen selbst schwerwiegende L3 Read Bugs egal sind.

gruffi schrieb:So schlecht kann es gar nicht werden.

Wenn man sich die bisherigen Leaks vor Augen führt, wird es noch zu einer schlechteren Situation führen als es damals bei Fermi war.

Hoher Verbrauch, miese IPC und Preise <150 Euro. Fermi konnte damals mit der Performance und Gimmiks überzeugen.

Der Vergleich ist doch witzlos.

AMD scheint so dringend neue Prozessoren veröffentlichen zu wollen, dass ihnen selbst schwerwiegende L3 Read Bugs egal sind.

Zuletzt bearbeitet:

- Status

- Für weitere Antworten geschlossen.

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 146K

- Antworten

- 0

- Aufrufe

- 234K