App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

CELL offiziell vorgestellt: ready for 4 GHz !?

- Ersteller rkinet

- Erstellt am

rkinet

Grand Admiral Special

Original geschrieben von mtb][sledgehammer

Natürlich sieht pipin den Cell nicht pessimistisch, aber realistisch.

Und deshalb schreibt er auh nichts von einer Cell-Revolution, sondern lediglich Fakten.

a) pipin verlinkt zumindest mal auf einen Detail-Artikel.

Auch behauptet er nicht, daß IBM & Sony lügen bzgl. Performance oder internem Takt.

b) 'Cell'-Revolution ist relativ.

Gemäß 'Moorschem Gesetz' hätten wir von 2003 (P4-3 GHz) auf 2006 eh 4-fach Steigerung bei Performance und Transitorzahl anzusetzen. Das IBM und AMD die letzen Jahre hier bremsten, hat spezielle Gründe. Nur IBM hat eine Design für 2006ff vorgestellt - sowas ist unter dem Aspekt der aktuellen PC-Technik eine 'Revolution', gemäß 'Moorschem Gesetz' aber innerhalb des erwartbaren.

Bem. Vielleicht schreibt Ihr noch ne Protest-email an Intel wg. diesem 'Moorschen Gesetz', dort ist es ja entstanden und wird auch off. von Intel für weiter gültig betrachtet.

Original geschrieben von rkinet

pipin hat auf 'Real World Technologies' - dort wird der Cell sehr detailiert vorgestellt und man kann bei den technischen Daten nicht auf die Idee kommen, daß IBM/Sony die Welt damit betrügen wollen.

Nachdem auch der (wohl) 3-fach PowerPC / gem. 1MB-L2 zur XBox2 bald ansteht (wohl 100 mm2 in SOI-90nm - abgeschätzt aus http://www.realworldtech.com/includes/images/articles/cell-1.gif) haben wir ja bald einen zweiten Vergleichswert zur PC-Welt.

Gemäß http://www.realworldtech.com/page.cfm?ArticleID=RWT021005084318 könnte der PowerPC-Kern gegenüber dem Power5 in der Performance abfallen - vielleicht.

Nur, 4 GHz sind auch bei Kompromissen im Design noch über dem heutigen HighEnd bei x86-CPUs besonders bei Berücksichtigung der sehr schnellen Speicheranbindung und dem Onchip-DRAM Kontroller.

Fazit: Der 'Cell' ist schnell - wie schnell, werden wir bald genauer wissen.

Ich glaube nicht, dass Pinpin den Artikel bis ins letzte Detail studiert hat und auch an dich Phantasten gedacht hat.

Der letzte Absatz zeigt mal wieder deutlich, dass du keine Ahnung hast wovon du eigentlich sprichst! Du kennst den Aufbau vom Cell nichtmal ansatzweise, argumentierst aber mit irgendwelchen theoretischen Eckdaten.

Gehts noch?

Wie lange gedenkst du noch solche Märchen in die Welt zu setzen?

Wann wirst du uns endlich erlösen?

E:

Gemäß 'Moorschem Gesetz' hätten wir von 2003 auf 2006 eh 4-fach Steigerung bei Performance und [...]

Eigentlich ist es ja allgemein bekannt, dass das Moorsche Gesetz nix über Performance oder Transistorenzahlen, sondern einzig und allein über Strukturgrößen aussagt. Nur du scheinst es nicht zu wissen...

rkinet

Grand Admiral Special

Die PS3 soll 31.März vorgestellt werden und es auf der E3 spielbare Konsolen geben (http://www.computerbase.de/news/con.../2005/februar/playstation_3-praesentation_e3/)Original geschrieben von i_hasser

Wie lange gedenkst du noch solche Märchen in die Welt zu setzen?

Dann kann ja jeder selbst abschätzen, ob da ne 'Cell'-Gurke drin arbeiten kann

Anschließend bin ich als 'Märchenonkel' überflüssig -

und Anti-'Cell' Postings dürften im 'Partykeller' landen (http://www.planet3dnow.de/vbulletin/forumdisplay.php3?s=&forumid=17)

Merkst du eigentlich, dass du nicht die geringste Ahnung von der Materie hast? Merkst du das überhaupt noch?

Es ist ja völlig normal, dass man mal keine Ahnung hat - aber dann halt dich doch einfach mal ein bisschen zurück!

Keine Ahnung zu haben beudetet normalerweise, dass man zu einer Sache keine Aussagen machen kann. Das machst du hier aber die ganze Zeit, ohne auch nur ein Fünkchen Ahnung vom Cell.

Es ist ja völlig normal, dass man mal keine Ahnung hat - aber dann halt dich doch einfach mal ein bisschen zurück!

Keine Ahnung zu haben beudetet normalerweise, dass man zu einer Sache keine Aussagen machen kann. Das machst du hier aber die ganze Zeit, ohne auch nur ein Fünkchen Ahnung vom Cell.

rkinet

Grand Admiral Special

http://www.intel.com/cd/corporate/pressroom/emea/deu/102109.htmOriginal geschrieben von i_hasser

Eigentlich ist es ja allgemein bekannt, dass das Moorsche Gesetz nix über Performance oder Transistorenzahlen, sondern einzig und allein über Strukturgrößen aussagt. Nur du scheinst es nicht zu wissen...

http://www.golem.de/0210/22062.html

Zwei von vielen Statement von Intel zum Moorschen Gesetz.

Ok Intel ist eine Lügenhaufen, Moor ein Intel-Mitarbeiter und die Erde eine Scheibe.

Nur, 'i_hasser', Deine Postings haben längst den Boden der technischen Realität verlassen und zeigen nur noch den 'Hass' auf alles, was nicht ins gewohnte Weltbild paßt.

Und Deinen Vorwürfe weiten sich auf immer mehr Personen aus ...

erste Anzeichen von Selbsterkenntnis ?Original geschrieben von i_hasser

Es ist ja völlig normal, dass man mal keine Ahnung hat

Nochmal zur Technik 'Cell':

Der Link von pipin - http://www.planet3dnow.de/vbulletin/showthread.php3?s=&threadid=205187

und der zu http://www.planet3dnow.de/vbulletin/showthread.php3?s=&threadid=205187 (bei mir auch in http://www.planet3dnow.de/vbulletin/showthread.php3?s=&threadid=204449

sind tiefgehend, aber von den selbsternannten 'Cell-Profi' bisher noch nicht im Ansatz gewürdigt worden. Es wird Zeit sich wieder der Cell-Technik zuzuwenden - dazu ist die auch zu gut um nur schmutzige Wäsche zu waschen.

Zuletzt bearbeitet:

Darauf hab ich gewartet  .

.

Ich dachte schon du willst mir garnimmer Ahnungslosigkeit unterstellen, scheint ja normalerweise dein letztes 'Argument' zu sein.

Das Moorsche Gesetzt richtet sich tatsächlich nur nach Strukturgröße und in jeder wirklich anständigen Literatur zu dem Thema kannst du das auch nachlesen - lesen bildet eben. Das wurde schon damals falsch interpretiert, und so hat sich der Mythos der sich alle 18 Monate verdoppelnden Performance gebildet.

Ich darf dich aber drauf hinweisen, dass du in diesem Thread hier bisher nicht ein einziges mal auch nur irgendwie mit technischen Sachen argumentiert hast. Es fragt sich also, wer hier keine Ahnung hat.

Im Gegenteil, du hast hier sogar einige anregende Phantasien gebracht - teilweise wirklich Amüsant, aber eben fernab jeder Realität.

Ich frag mich nur, wann das endlich bis in deine Großhirnwindungen durchsickern wird.

Wäre übrigens nett wenn du so weiterschreiben könntest, dann hol ich mir noch eine Tüte Chips und der Abend ist gerettet . Vielleicht solltest du mal beim Zirkus anfangen?

. Vielleicht solltest du mal beim Zirkus anfangen?

EDIT:

Na ich hab mir doch mal die Mühe gemacht:

http://www.webopedia.com/TERM/M/Moores_Law.html

http://c2.com/cgi/wiki?MooresLaw

.

.Ich dachte schon du willst mir garnimmer Ahnungslosigkeit unterstellen, scheint ja normalerweise dein letztes 'Argument' zu sein.

Das Moorsche Gesetzt richtet sich tatsächlich nur nach Strukturgröße und in jeder wirklich anständigen Literatur zu dem Thema kannst du das auch nachlesen - lesen bildet eben. Das wurde schon damals falsch interpretiert, und so hat sich der Mythos der sich alle 18 Monate verdoppelnden Performance gebildet.

Ich darf dich aber drauf hinweisen, dass du in diesem Thread hier bisher nicht ein einziges mal auch nur irgendwie mit technischen Sachen argumentiert hast. Es fragt sich also, wer hier keine Ahnung hat.

Im Gegenteil, du hast hier sogar einige anregende Phantasien gebracht - teilweise wirklich Amüsant, aber eben fernab jeder Realität.

Ich frag mich nur, wann das endlich bis in deine Großhirnwindungen durchsickern wird.

Wäre übrigens nett wenn du so weiterschreiben könntest, dann hol ich mir noch eine Tüte Chips und der Abend ist gerettet

. Vielleicht solltest du mal beim Zirkus anfangen?

. Vielleicht solltest du mal beim Zirkus anfangen?EDIT:

Na ich hab mir doch mal die Mühe gemacht:

http://www.webopedia.com/TERM/M/Moores_Law.html

The observation made in 1965 by Gordon Moore, co-founder of Intel, that the number of transistors per square inch on integrated circuits...

http://c2.com/cgi/wiki?MooresLaw

Formulated by GordonMoore of IntelCorporation, it says (roughly) that chip density doubles every eighteen months.

PuckPoltergeist

Grand Admiral Special

Original geschrieben von i_hasser

Das Moorsche Gesetzt richtet sich tatsächlich nur nach Strukturgröße und in jeder wirklich anständigen Literatur zu dem Thema kannst du das auch nachlesen - lesen bildet eben. Das wurde schon damals falsch interpretiert, und so hat sich der Mythos der sich alle 18 Monate verdoppelnden Performance gebildet.

...

http://www.webopedia.com/TERM/M/Moores_Law.html

http://c2.com/cgi/wiki?MooresLaw

Damit hast du dich hier selber widerlegt. Die Aussage von Moore bezog sich auf die Anzahl der integrierten Schaltkreise, nicht die Strukturgröße. Die Aussage über Performance ist tatsächlich später da rein gedichtet worden.

Original geschrieben von PuckPoltergeist

Damit hast du dich hier selber widerlegt. Die Aussage von Moore bezog sich auf die Anzahl der integrierten Schaltkreise, nicht die Strukturgröße. Die Aussage über Performance ist tatsächlich später da rein gedichtet worden.

Die Anzahl der Transistoren pro Fläche gibt die Strukturgröße...

SnakePlisken

Vice Admiral Special

i-hasser

jetzt schau Dir mal seine ersten beiden Postings in diesem Thread an, und dann:

Das ist erst der 2. Thread zu diesem Thema nach dem der erste ziemlich schnell verschwand.

Da wunderst Du Dich, über das Niveau?

Übrigens, was hast Du gegen Zirkus?

Und:

macht doch mal ne Pause, ist zwar kein Allheilmittel, aber in diesem Fall vielleicht von Vorteil.

Grüße

jetzt schau Dir mal seine ersten beiden Postings in diesem Thread an, und dann:

Kannst du (rkinet) nicht einfach mal irgendwas klar und deutlich darlegen als auf irgendwelche Marketingsachen oder sonstige Riesentexte zu linken.

Nach deinem Schreibaufwand um das Thema müsstest du ja Experte sein...

Das ist erst der 2. Thread zu diesem Thema nach dem der erste ziemlich schnell verschwand.

Da wunderst Du Dich, über das Niveau?

Übrigens, was hast Du gegen Zirkus?

Und:

macht doch mal ne Pause, ist zwar kein Allheilmittel, aber in diesem Fall vielleicht von Vorteil.

Grüße

PuckPoltergeist

Grand Admiral Special

Original geschrieben von i_hasser

Die Anzahl der Transistoren pro Fläche gibt die Strukturgröße...

Es ging bei Moore aber um die Anzahl der Transistoren pro Schaltkreis, nicht pro Fläche. Dass die Fläche da mit rein spielt, weil man das Zeuchs nicht kilometerweit auseinander ziehen kann ist klar. Das hat Moore aber so nicht gesagt/geschrieben.

rkinet

Grand Admiral Special

Was soll die Welt mit einer Z80-CPU auf 1mm2 DIE-Fläche ?Original geschrieben von i_hasser

Das Moorsche Gesetzt richtet sich tatsächlich nur nach Strukturgröße und in jeder wirklich anständigen Literatur zu dem Thema kannst du das auch nachlesen - lesen bildet eben. Das wurde schon damals falsch interpretiert, und so hat sich der Mythos der sich alle 18 Monate verdoppelnden Performance gebildet.

Hat man mehr Silicium-Abfall beim zersägen, als nutzbare Chips

Moor ist nicht dumm.

Ursprünglich nur für Transitorabmessungen definiert, aber von Moor (später) auch für Anzahl der Transistoren und indirekt (bessere HF-Eigenschaften der kleineren Transitoren) auch für die Taktrate geeignet.

s. auch http://www.lte.e-technik.uni-erlang...lesungsfolien_TI_III_Kapitel_3_Handzettel.pdf

Page 11 & 12

So jetzt haben wir also den Kampf:

'i_hasser' gegen rkinet, Moor, Intel, IBM, Sony, Microsoft (XBox2)

Natürlich sind WIR viel, viel dümmer als i_hasser ...

Nein, rkinet vs. P3D & den Rest der Welt...

Such dir doch einfach mal eine andere Beschäftigung (zB. eine Frau), dann bist du vielleicht auch hier etwas ausgeglichener.

@Puck

Beiden Quellen nach zu urteilen schon (die eine spricht ja sogar von density), ich wette ich find auch noch mehr.

Such dir doch einfach mal eine andere Beschäftigung (zB. eine Frau), dann bist du vielleicht auch hier etwas ausgeglichener.

@Puck

Beiden Quellen nach zu urteilen schon (die eine spricht ja sogar von density), ich wette ich find auch noch mehr.

PuckPoltergeist

Grand Admiral Special

Original geschrieben von i_hasser

Beiden Quellen nach zu urteilen schon (die eine spricht ja sogar von density), ich wette ich find auch noch mehr.

Finde ich nicht, aber hier findest du das ursprüngliche paper von ihm. ("Cramming More Components Onto Integrated Circuits")

Zuletzt bearbeitet:

PuckPoltergeist

Grand Admiral Special

Original geschrieben von rkinet

So jetzt haben wir also den Kampf:

'i_hasser' gegen rkinet, Moor, Intel, IBM, Sony, Microsoft (XBox2)

Natürlich sind WIR viel, viel dümmer als i_hasser ...

Es ist schon bemerkenswert, wie du für andere sprichst. Du bist nicht mal in der Lage zu bemerken, dass du der einzige bist, der auf einem Standpunkt steht, und das bei so ziemlich jedem Thema aufs neue. Es ist vollkommen egal, deine "Ausführungen" widerlegt, du beharrst auf deiner Meinung, und sprichst allen anderen jegliches Sachverständnis ab, sei es Henry_Wince, Dresdenboy, i_hasser oder ich. Dabei offenbarst du auch jedesmal auf bemerkenswerte Art und Weise dein Unwissen zum Thema, in dem du nicht einmal technische Hintergründe bringst, oder wenigstens darauf eingehst, wenn es andere dir schon vorlegen. Ich frage mich ernsthaft, wie man so im realen Leben weiter kommt, wenn man alles besser weiß, und dabei nur Blödsinn verzapft.

Schweift zwar etwas vom Thema ab (aber wenigstens hat es noch einen gewissen Argumentationsgehalt):

http://www.ti.cs.uni-frankfurt.de/lehre/ss04_wissenschaftliche_dokumentation/book/node15.html

Können wir ja gerne in einem neuen Thread diskutieren . Aus heutiger Sicht find ich die Betrachtung der Transistorzahl ziemlich abwegig, den A64 gibts mit 106M und 69M Transistoren. Ja welchen nehmen wir denn nun? Den mit den meißten? Ja aber wieso nehmen wir dann nicht den Itanicum mit > 1000M Transistoren?

. Aus heutiger Sicht find ich die Betrachtung der Transistorzahl ziemlich abwegig, den A64 gibts mit 106M und 69M Transistoren. Ja welchen nehmen wir denn nun? Den mit den meißten? Ja aber wieso nehmen wir dann nicht den Itanicum mit > 1000M Transistoren?

Oder nehmen wir nur den CPU Kern? Dann hat Moore's Law aber schon die letzten 5 Jahre nicht mehr "gegolten".

http://www.ti.cs.uni-frankfurt.de/lehre/ss04_wissenschaftliche_dokumentation/book/node15.html

Wenn heute der Name Moore's Law fällt, dann hat das nicht mehr mit Komplexität und Kosten von IC-Komponenten zu tun, sondern hat sich größtenteils weiterentwickelt zu verschiedenen Aussagen über sich verdoppelnde Prozessorleistung, wobei manche von Moore erwähnte Aspekte untergingen während andere ``zugedichtet`` wurden. Im Jahre 1975 vollzog sich die erste Wandlung, als Moore selbst auf einer Konferenz des Institute of Electrical and Electronics Engineers (IEEE) seine Beobachtung revidierte und ihre Bedeutung änderte.

1. Verdopplung der Verarbeitungsgeschwindigkeit auf einem Elektronik-Chip alle 18 Monate

2. Verdopplung der Rechenleistung alle 18 Monate

3. Halbierung des Preises für Rechenleistung alle 18 Monate

Obwohl jeder Ansatz für sich durchaus gültig sein kann, haben doch alle drei nicht mehr wirklich viel mit Moore's Originalfassung und sogar der ersten Interpretation zu tun.

Können wir ja gerne in einem neuen Thread diskutieren

. Aus heutiger Sicht find ich die Betrachtung der Transistorzahl ziemlich abwegig, den A64 gibts mit 106M und 69M Transistoren. Ja welchen nehmen wir denn nun? Den mit den meißten? Ja aber wieso nehmen wir dann nicht den Itanicum mit > 1000M Transistoren?

. Aus heutiger Sicht find ich die Betrachtung der Transistorzahl ziemlich abwegig, den A64 gibts mit 106M und 69M Transistoren. Ja welchen nehmen wir denn nun? Den mit den meißten? Ja aber wieso nehmen wir dann nicht den Itanicum mit > 1000M Transistoren? Oder nehmen wir nur den CPU Kern? Dann hat Moore's Law aber schon die letzten 5 Jahre nicht mehr "gegolten".

rkinet

Grand Admiral Special

@PuckPoltergeist

@i_hasser

noch immer nichts technisches als 'contra' zum Cell.

Darum ging es mir aber im Beitrag aber auschließlich.

Und da kommt jetzt seit 'Ewigkeiten' nicht mehr außer diffusen Unterstellungen zur gefühlen Performanceschwäche des Cell.

Nur, dazu fehlen jede technische Fakten ...

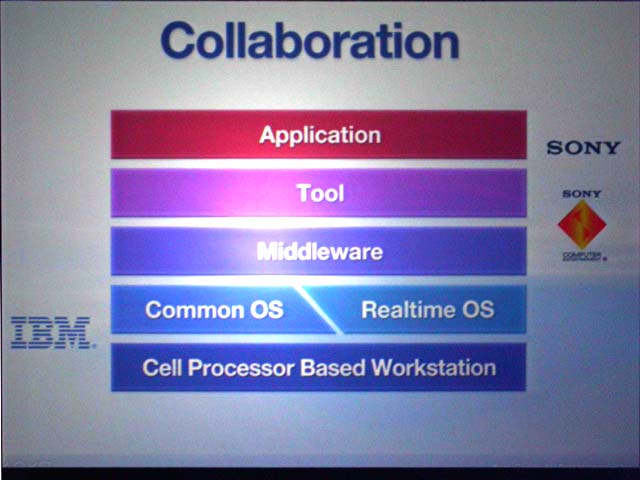

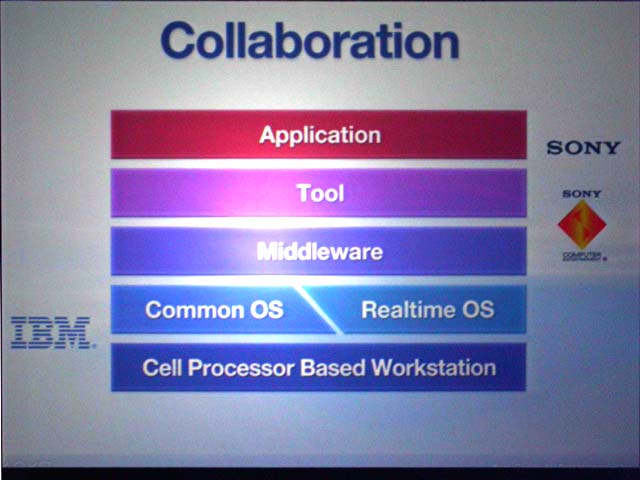

nun, 'uralt' = von 2001, aber doch der Vermerk 'Realtime OS', was den SPEs und der Virtualisierung sehr entgegenkommt, oder ?

@i_hasser

noch immer nichts technisches als 'contra' zum Cell.

Darum ging es mir aber im Beitrag aber auschließlich.

Und da kommt jetzt seit 'Ewigkeiten' nicht mehr außer diffusen Unterstellungen zur gefühlen Performanceschwäche des Cell.

Nur, dazu fehlen jede technische Fakten ...

nun, 'uralt' = von 2001, aber doch der Vermerk 'Realtime OS', was den SPEs und der Virtualisierung sehr entgegenkommt, oder ?

Zuletzt bearbeitet:

PuckPoltergeist

Grand Admiral Special

Original geschrieben von rkinet

noch immer nichts technisches als 'contra' zum Cell.

Darum ging es mir aber im Beitrag aber auschließlich.

Und da kommt jetzt seit 'Ewigkeiten' nicht mehr außer diffusen Unterstellungen zur gefühlen Performanceschwäche des Cell.

Nur, dazu fehlen jede technsiceh Fakten ...

Wieso sollen wir uns die Arbeit machen, dir irgendwelche technischen Zusammenhänge zu erklären, wenn du sie eh ignorierst, weil du sie offenbar nicht mal verstehst? Das haben bis jetzt einige versucht, und du bist nie drauf eingegangen. Alles was von dir kommt, ist irgendwelches Marketing-Blahblah, was man permanent um die Ohren geschmissen bekommt, oder irgendwelche Schlussfolgerungen daraus von dir, die nicht mal ansatzweise einen logischen Zusammenhang erkennen lassen. Alles, was gegen dein eingebildetes Wissen geht, wird von dir kategorisch abgelehnt. Statt dessen ziehst du dich darauf zurück, deine Gegenüber zu beleidigen. Ich erinner jetzt nur mal an:

* die 64bit-Diskussion(en) (mit und ohne x86_64)

* PCIe

* AMDs Marktstellung

* oder zuletzt Virtualisierung und Echtzeitsysteme

Da wurde mehr als genug erklärt und Beispiel gebracht. Du hast nichts davon anerkannt, sondern nur rumpolemisiert. Auch in diesem Thread gab es mehr als genug Ansätze, wo technisch über den Cell diskutiert wurde. Keinen davon hast du aufgenommen. Wieso sollte sich also jemand die Mühe machen, und das Thema weiter mit dir erörtern?

Hättest du das von HenryWince verlinkte PPT gelesen wüsstest du so einige technische Contras.

Ich hab auch schon geschrieben, dass die SPUs vollkommen separat arbeiten und eher wie ein 8fach System agieren anstatt als einzelnes System.

Zudem gibt es feste Zeitintervale für neue Apulets, was gerade Abhängigkeiten sehr schwer macht und last but not least ist Cell völlig anders handhabbar als eine normale CPU!

Lies es dir mal durch, mach dich ein bisschen über VPUs schlau. Die einzelnen SPUs haben auch keinen so vollwertigen Assembler wie x86, noch etwas das die Sache schwierig macht. Bei Abhängigkeiten von einem Wert liegen für ein gesamtes Zeitintervall 7 von 8 SPUs brach und die 8. rechnet mit ihren SIMD Einheiten auch nur mit einem einzigen Wert (1/4 Leistung bei 4xSIMD).

Im ungünstigsten Fall (DP) bleiben so von theoretischen 256 GFLOPS noch maximal 8 GFLOPS übrig. Dann haben die Speicherzugriffe eine Größe von 1024 Bit - hervorragend für Streaming, aber bei allem was irgendwie etwas verteilter zugeht absolute Bandbreitenverschwendung.

Und dabei geht das Dokument auch nicht in alle Details ein, der Assemblerdialekt für die SPUs ist zB. auch nicht wirklich detailliert abgehandelt (eigentlich fast garnicht).

Selbst wenn so eine SPU theoretisch einen vollwertiges Assembler könnte wären die Ausführungszeiten bei Branches etc. viel viel höher als bei einem x86er, weil so eine SPU nunmal einfach nur einen Bruchteil der Technik eines vollwertigen x86ers oder meinentwegen einer Power CPU enthält.

Wie ich gesagt habe, der Efficeon hat auch eine gigantische Rechenleistung, nur wie bei den SPUs bleibt auch bei dem in der Praxis nicht so viel davon übrig ('gerade genug' um mit den anderen x86ern mitzuhalten).

Von der absoluten reinen Rohrechenleistung ist so ein Efficeon viel schneller als jeder andere x86er.

Such den Thread mal nach 'dynamisch' und 'statisch' ab, da hab ich schon ein Haufen zu geschrieben.

Ich hab auch schon geschrieben, dass die SPUs vollkommen separat arbeiten und eher wie ein 8fach System agieren anstatt als einzelnes System.

Zudem gibt es feste Zeitintervale für neue Apulets, was gerade Abhängigkeiten sehr schwer macht und last but not least ist Cell völlig anders handhabbar als eine normale CPU!

Lies es dir mal durch, mach dich ein bisschen über VPUs schlau. Die einzelnen SPUs haben auch keinen so vollwertigen Assembler wie x86, noch etwas das die Sache schwierig macht. Bei Abhängigkeiten von einem Wert liegen für ein gesamtes Zeitintervall 7 von 8 SPUs brach und die 8. rechnet mit ihren SIMD Einheiten auch nur mit einem einzigen Wert (1/4 Leistung bei 4xSIMD).

Im ungünstigsten Fall (DP) bleiben so von theoretischen 256 GFLOPS noch maximal 8 GFLOPS übrig. Dann haben die Speicherzugriffe eine Größe von 1024 Bit - hervorragend für Streaming, aber bei allem was irgendwie etwas verteilter zugeht absolute Bandbreitenverschwendung.

Und dabei geht das Dokument auch nicht in alle Details ein, der Assemblerdialekt für die SPUs ist zB. auch nicht wirklich detailliert abgehandelt (eigentlich fast garnicht).

Selbst wenn so eine SPU theoretisch einen vollwertiges Assembler könnte wären die Ausführungszeiten bei Branches etc. viel viel höher als bei einem x86er, weil so eine SPU nunmal einfach nur einen Bruchteil der Technik eines vollwertigen x86ers oder meinentwegen einer Power CPU enthält.

Wie ich gesagt habe, der Efficeon hat auch eine gigantische Rechenleistung, nur wie bei den SPUs bleibt auch bei dem in der Praxis nicht so viel davon übrig ('gerade genug' um mit den anderen x86ern mitzuhalten).

Von der absoluten reinen Rohrechenleistung ist so ein Efficeon viel schneller als jeder andere x86er.

Such den Thread mal nach 'dynamisch' und 'statisch' ab, da hab ich schon ein Haufen zu geschrieben.

PuckPoltergeist

Grand Admiral Special

In der aktuellen c't steht jetzt auch ein wenig über den Cell. Erstmal liefen wohl nur die SPEs mit 4,6GHz, was an sich keine sonderlich tolle Leistung mehr ist. Das ist mit anderen Spezialprozessoren auch schon geschafft worfen. Dazu muss sich dann auch zeigen, ob die Chips auch im regulären Einsatz mit dieser Taktrate laufen. Laborobjekte sind eine Sache, wirklich kaufbare Chips eine ganz andere.

Dann ist der Power-Prozessor, welcher das ganze koordiniert wirklich arg beschnitten worden. Zum einen ist der nicht dualcore, der arbeitet "lediglich" mit SMT. Zum anderen fehlt im die OoO-Funktionalität, sprich hier hängt sehr viel vom Programmierer ab.

Wie sehr der Cell also zum "Überflieger" wird, muss sich erst noch zeigen. Ich für meinen Teil habe da recht starke Bedenken. In gewissen Bereichen wird er sicherlich neue Maßstäbe setzen, zum x86-Killer taugt er wohl kaum.

Dann ist der Power-Prozessor, welcher das ganze koordiniert wirklich arg beschnitten worden. Zum einen ist der nicht dualcore, der arbeitet "lediglich" mit SMT. Zum anderen fehlt im die OoO-Funktionalität, sprich hier hängt sehr viel vom Programmierer ab.

Wie sehr der Cell also zum "Überflieger" wird, muss sich erst noch zeigen. Ich für meinen Teil habe da recht starke Bedenken. In gewissen Bereichen wird er sicherlich neue Maßstäbe setzen, zum x86-Killer taugt er wohl kaum.

Starcraftfreak

Vice Admiral Special

- Mitglied seit

- 02.04.2004

- Beiträge

- 851

- Renomée

- 7

Schön langsam kristallisiert sich das heraus, was von Anfang an irgendwie in der Luft lag. Der Cell ist nicht so toll und lediglich zu Marketingzwecken als Super-CPU (z.B. die ominösen 256GFlops) hochgepusht worden. Dabei müsste es einem schon beim geplanten Einsatzziel, Spielkonsolen und Consumerelektronik, dämmern, dass der nicht allzu teuer sein darf, ansonsten kann kein wirtschaftlicher Erfolg erzielt werden.Original geschrieben von PuckPoltergeist

In der aktuellen c't steht jetzt auch ein wenig über den Cell. Erstmal liefen wohl nur die SPEs mit 4,6GHz, was an sich keine sonderlich tolle Leistung mehr ist. Das ist mit anderen Spezialprozessoren auch schon geschafft worfen. Dazu muss sich dann auch zeigen, ob die Chips auch im regulären Einsatz mit dieser Taktrate laufen. Laborobjekte sind eine Sache, wirklich kaufbare Chips eine ganz andere.

Wie sehr der Cell also zum "Überflieger" wird, muss sich erst noch zeigen. Ich für meinen Teil habe da recht starke Bedenken. In gewissen Bereichen wird er sicherlich neue Maßstäbe setzen, zum x86-Killer taugt er wohl kaum.

Diese SPEs sind vereinfacht gesehen nicht wesentlich anders als z.B. SIMD Einheiten. Und gibt es nicht gewisse Einheiten z.B. beim P4, welche mit dem doppelten Kerntakt getaktet werden?

i_hasser hat schon mehrmals erklärt, warum ein Cell nie ein x86 Killer sein kann. Ich denke, dass er diesen Anspruch gar nicht stellt.

PuckPoltergeist

Grand Admiral Special

Original geschrieben von Starcraftfreak

z.B. die ominösen 256GFlops

Die sind rein theoretisch, sprich wenn wirklich 10 Threads simultan arbeiten (8 auf je einer SPE + 2 auf dem Power-Kern). Dass das in der Praxis nicht machbar ist, dürfte auch klar sein. Schon die heutigen x86-CPUs sind nicht in der Lage, all ihre Funktionseinheiten auszulasten.

Diese SPEs sind vereinfacht gesehen nicht wesentlich anders als z.B. SIMD Einheiten.

Naja, das ist etwas zu einfach gesehen. Die sind doch eher Vektor-Prozessoren.

Und gibt es nicht gewisse Einheiten z.B. beim P4, welche mit dem doppelten Kerntakt getaktet werden?

Ja, die ALU ist double-pumped, sprich die kann pro Takt zwei Befehle abarbeiten.

Was halt neu ist, ist die recht starke physische Nähe der einzelnen Spezialchips, zusammen mit der Verknüpfung untereinander.

Was bis jetzt aber noch gar nicht beleutet wurde, ist der Power-Kern. Der soll ja wohl für die Koordination und die Verteilung der Aufgaben zuständig sein. Kommt der nicht hinterher, helfen auch SPEs mit 10GHz nicht weiter. So wie ich das bis jetzt verstanden habe, ist der doch sehr stark kastriert worden. Im Endeffekt wird das wohl wieder eine ziemliche Aufgabe für die Programmierer, das Ding zu füttern. Ein Fehler im Code, und die ganze Kiste lahmt (in-order-Struktur).

@rkinet @intel_hasser @puckpoltergeist

könnt ihr eure beiträge nicht sehen einfach als beiträge aus verschiedener position heraus? immer müßt ihr euch gegenseitig vorwerfen

a) keine ahnung zu haben

b) nicht auf argumente einzugehen

c) euch nicht überzeugen zu lassen

ich muß sagen, ich kann ja a), a) & c) sehr gut verstehen. , aber richtig voran bringt einen das nicht

, aber richtig voran bringt einen das nicht

okay, zum thema:

habe ich zwar mindestens schon fünf-mal hier geschrieben in den letzten jahren, aber dennoch:

seit zwanzig jahren hört man immer wieder von irgendwelchen super-duper-wunder-prozessoren. glaube ich mittlerweile nicht mehr dran, bevor ich es sehe (=benches). ist doch ganz simpel: mensch setzt energie ein, um ihm unangenehme, unmögliche arbeit zu erledigen. diese arbeit ergibt ein ergebnis, für welches eben entsprechend viel energie aufgewendet werden muß. wenn es nun heißt, ein wunderteil würde viel mehr ergebnisse liefern bei gleichemm energieaufwand, dann ist entweder eine technische revolution notwendig oder eine totale spezialisierung. was ist technisch revolutionär an cell? ? ? neues herstellungsverfahren? weniger leckströme? (=technisch physikalisch) habe ich noch nicht von gehört. ist die architektur anders (schnelleres ram, schnelleres ram, mehr register)? na, dann kann man es wohl schwer mit x86 vergleichen, wenn jedes popelprogramm neu compliert werden müßte...

ich glaube einfach nicht daran, daß eine neue prozessor-architektur einfach mal so neue leistungs-regionen erschließt für vorhandene software. die bestehenden techniken und architekturen arbeiten schlicht und einfach schon immer am anschlag des derzeit möglichen. d.h.: wenn man eine x86-cpu "gerecht" mit anderen architekturen vergleicht, dann würden ziemlich gleiche ergebnisse hinsichtlich (rechenleistung/pro eingesetzem watt) heraus kommen. (erstmalige ausnahme: prescott - daß ergebnis eines falschen weges, einer falschen einschätzung seitens intel) d.h. für den cell-prozessor: auch er wird nicht den energie-erhaltungssatz umstoßen. wenn er mehr leistet auf manchen gebieten als eine x86- oder ein power-cpu, dann nur auf kosten anderer fähigkeiten (also wegen spezialisierung). insofern ist der streit hier ziemlich überflüssig...die benches werden es beweisen...

könnt ihr eure beiträge nicht sehen einfach als beiträge aus verschiedener position heraus? immer müßt ihr euch gegenseitig vorwerfen

a) keine ahnung zu haben

b) nicht auf argumente einzugehen

c) euch nicht überzeugen zu lassen

ich muß sagen, ich kann ja a), a) & c) sehr gut verstehen.

, aber richtig voran bringt einen das nicht

, aber richtig voran bringt einen das nicht

okay, zum thema:

habe ich zwar mindestens schon fünf-mal hier geschrieben in den letzten jahren, aber dennoch:

seit zwanzig jahren hört man immer wieder von irgendwelchen super-duper-wunder-prozessoren. glaube ich mittlerweile nicht mehr dran, bevor ich es sehe (=benches). ist doch ganz simpel: mensch setzt energie ein, um ihm unangenehme, unmögliche arbeit zu erledigen. diese arbeit ergibt ein ergebnis, für welches eben entsprechend viel energie aufgewendet werden muß. wenn es nun heißt, ein wunderteil würde viel mehr ergebnisse liefern bei gleichemm energieaufwand, dann ist entweder eine technische revolution notwendig oder eine totale spezialisierung. was ist technisch revolutionär an cell? ? ? neues herstellungsverfahren? weniger leckströme? (=technisch physikalisch) habe ich noch nicht von gehört. ist die architektur anders (schnelleres ram, schnelleres ram, mehr register)? na, dann kann man es wohl schwer mit x86 vergleichen, wenn jedes popelprogramm neu compliert werden müßte...

ich glaube einfach nicht daran, daß eine neue prozessor-architektur einfach mal so neue leistungs-regionen erschließt für vorhandene software. die bestehenden techniken und architekturen arbeiten schlicht und einfach schon immer am anschlag des derzeit möglichen. d.h.: wenn man eine x86-cpu "gerecht" mit anderen architekturen vergleicht, dann würden ziemlich gleiche ergebnisse hinsichtlich (rechenleistung/pro eingesetzem watt) heraus kommen. (erstmalige ausnahme: prescott - daß ergebnis eines falschen weges, einer falschen einschätzung seitens intel) d.h. für den cell-prozessor: auch er wird nicht den energie-erhaltungssatz umstoßen. wenn er mehr leistet auf manchen gebieten als eine x86- oder ein power-cpu, dann nur auf kosten anderer fähigkeiten (also wegen spezialisierung). insofern ist der streit hier ziemlich überflüssig...die benches werden es beweisen...

rkinet

Grand Admiral Special

Original geschrieben von Treverer

seit zwanzig jahren hört man immer wieder von irgendwelchen super-duper-wunder-prozessoren.

wenn es nun heißt, ein wunderteil würde viel mehr ergebnisse liefern bei gleichemm energieaufwand, dann ist entweder eine technische revolution notwendig oder eine totale spezialisierung.

was ist technisch revolutionär an cell? ? ?

neues herstellungsverfahren?

weniger leckströme? (=technisch physikalisch) habe ich noch nicht von gehört. ist die architektur anders (schnelleres ram, schnelleres ram, mehr register)?

ich glaube einfach nicht daran, daß eine neue prozessor-architektur einfach mal so neue leistungs-regionen erschließt für vorhandene software.

Moorsches - Gesetz:

Unsere heutigen CPUs haben vielfach den Stand 2003/4. Ursache ist das Erlahmen bei Intel und eine ähnlich zurückhaltende Politik bei AMD (typ: 2,4 GHz 3400+ und 3800+).

IBM orientiert sich beim Cell am Technikstand 2006/7, dies ergibt automatisch einen deutschlichen Vorsprung.

Der Cell und die kommnende 3-fach PowerPC-CPU beim der XBox2 kombinieren deutlich höheren CPU-Takt (3,5++ GHz) mit Multi-Core.

Cell per PowerPC-Core zzgl. 8 St. SPE in RISC-Design; Die XBox2 CPU mit 3-fach PowerPC Core auf dem DIE. Beide mit RAM und Chip-Chip Kommunikationperformance in neunen Diemsionen.

Die Designs sind aber für die Consolen und Home-Entertainement optimiert.

Ob ein Apple Mac genauso Schub dadurch erhalten würde, müssen Benchmarks zeigen.

Zur Technik:

s. http://www.planet3dnow.de/vbulletin/showthread.php3?s=&postid=2087160#post2087160

Eine einzige SPE läßt sich bei SOI-90nm, 'DSL' und 2 GHz (echt) mit einem Watt betreiben.

Bei 4 GHz mit 6-9 Watt. Dies sind nun einmal elektrische Vorgaben, die auf eine wesentlich verbesserte Fertigung schließen läßt. Und Leckströme kennt SOI eh kaum.

Zur Software:

Der Cell muss ja nicht die x86-64 CPUs ersetzen. Aber er dürfte Druck machen, was ja schon die Multi-Core Roadmaps von Intel und AMD aufzeigen. Hinter den x86-64 Kulissen dürfte auch längst die SSE in der Diskussion stehen. Auch sind die 6-8 Gbyte/s DRAM im Vergleich zu den neuen Konsolen mit 25 GByte/s sicherlich nicht von Dauer.

So kann x86-64 auch in Zukunft uns erhalten bleiben.

Allerdings versucht ja IBM Linux zu stärken, was bzgl. Hardwareunterbau dann unkritischer wird.

Zuletzt bearbeitet:

Wer hat den denn wieder hier reingelassen?

Ich zweifele so langsam ob es noch Sinn macht das zu wiederholen, aber mir fällt ehrlich gesagt nix besseres ein:

Der Cell hat ein vollkommen anderes Programmiermodell, damit kann man Desktop und Server-Anwendungen nicht sinnvoll realisieren. Klar geht es trotzdem, aber nur mit einem enormen Performance-Verlust.

Sinn macht die Sache nur bei Programmen die sich in dem Programmiermodell von Cell auch gut realisieren lassen - die gibts, aber nicht auf Desktops.

Und abgesehen davon dürften die 4 Cells in der PS3 mehr Strom verpulvern als die aktuellen 90nm A64 (ich erinnere da an die ~40W Messung). Und in ein oder zwei Jahren gibts sicher auch wieder neue CPUs von AMD und Intel.

Willst du einen echten Stromsparer, dann greif zu Transmeta. Dummerweise will den anscheinend nur keiner, obwohl die < 1W für MP3 und DVD ja ziemlich beeindruckend sind. Abgesehen davon kannst du auch zu einem Dothan oder Turion greifen.

Im Desktop Einsatz sind diese CPUs allesammt stromsparender als ein Cell. Denn im Gegensatz zum Cell lassen sich da Desktop-typische Anwendungen auch ohne 3fache Handstände und Performanceverluste ohne Ende realisieren.

Ich zweifele so langsam ob es noch Sinn macht das zu wiederholen, aber mir fällt ehrlich gesagt nix besseres ein:

Der Cell hat ein vollkommen anderes Programmiermodell, damit kann man Desktop und Server-Anwendungen nicht sinnvoll realisieren. Klar geht es trotzdem, aber nur mit einem enormen Performance-Verlust.

Sinn macht die Sache nur bei Programmen die sich in dem Programmiermodell von Cell auch gut realisieren lassen - die gibts, aber nicht auf Desktops.

Und abgesehen davon dürften die 4 Cells in der PS3 mehr Strom verpulvern als die aktuellen 90nm A64 (ich erinnere da an die ~40W Messung). Und in ein oder zwei Jahren gibts sicher auch wieder neue CPUs von AMD und Intel.

Willst du einen echten Stromsparer, dann greif zu Transmeta. Dummerweise will den anscheinend nur keiner, obwohl die < 1W für MP3 und DVD ja ziemlich beeindruckend sind. Abgesehen davon kannst du auch zu einem Dothan oder Turion greifen.

Im Desktop Einsatz sind diese CPUs allesammt stromsparender als ein Cell. Denn im Gegensatz zum Cell lassen sich da Desktop-typische Anwendungen auch ohne 3fache Handstände und Performanceverluste ohne Ende realisieren.

PuckPoltergeist

Grand Admiral Special

Original geschrieben von rkinet

jede Menge Gelaber, was nichts mit dem Thema zu tun hat

[ ] du weißt, was das Power-Design ist

[ ] du weißt, was Vektor-Prozessoren sind

[ ] du weißt, was RISC ist

[ ] du weißt, was Parallelprogrammierung ist

[ ] du weißt, OoO/in-order ist

[ ] du weißt, was Virtualisierung ist

[x] du hast ein paar Marketing-Papers gelesen, und hältst dich jetzt für einen ganz tollen Hecht, der Ahnung hat (und zwar mehr als alle anderen)

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 626

- Antworten

- 0

- Aufrufe

- 903

- Antworten

- 0

- Aufrufe

- 834