App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD kleckert nicht, sondern klotzt :o

- Ersteller S.I.

- Erstellt am

- Mitglied seit

- 18.11.2008

- Beiträge

- 11.406

- Renomée

- 724

- Standort

- 8685x <><

- Aktuelle Projekte

- Spinhenge; Orbit; Milkyway

- Lieblingsprojekt

- Orbit@home; Milkyway@home

- Meine Systeme

- Tuban, 3,8~ Ghz x6 /Turbo 4,095GHz 2x Radeon HD 5850@5870 CFx. // Rechner 2: 5900x B02 //3= 9850 /4 = Rasp

- BOINC-Statistiken

- Mein Desktopsystem

- 5900xt (bis 5,3Ghz Boost); 3900x (bis 4,66 Boots); Thuban 1090x(bis 4 GHz Turbo)

- Mein Laptop

- P-

- Details zu meinem Desktop

- Prozessor

- siehe oben. alles Lukü mit max Anzahl ausgesuchter sehr starker Lüfter. (Rechner 3 = R 9 3900x

- Mainboard

- Asus MSI b 550 Tomahawk/; M4A79Deluxe für Thuban / MSI b 550 Tomahawk für R 9

- Kühlung

- ausgesklügelte Luftkühlung mit starkem Airflow

- Speicher

- vollbelegung

- Grafikprozessor

- Midrange oc 12GB /& 8 GB / & 3GB

- Display

- 2x 22" |(Benq; LG) und 1x 23,6" Samsung TFTs Eyefinity +2x21" für die anderen Rechner

- SSD

- 3x

- HDD

- (Tower voll!)

- Optisches Laufwerk

- Asus SATA-DVD RW

- Soundkarte

- o.b.

- Gehäuse

- ANTEC Twelfehundred Bequiet u.a.

- Netzteil

- vorhanden überall

- Tastatur

- ja gibt es jes

- Maus

- ja

- Betriebssystem

- Win 7 V 64 / und alternative

- Webbrowser

- Opera &/ IEE64/ &Safari und alternative

- Verschiedenes

- Thuban: |V-CoreCPU =1,23- 1,47V Turbo//norm. VID= 1,45V System läuft mit 4 Upgrades seit 2008 stabil!

6 Kerne Istanbul, 12 Kerne, ja, wurde auch schon spekuliert...

nun mit bis zu 16 Kernen.....

http://www.hardwareluxx.de/index.ph...n/11914-amd-kleckert-nicht-sondern-klotz.html

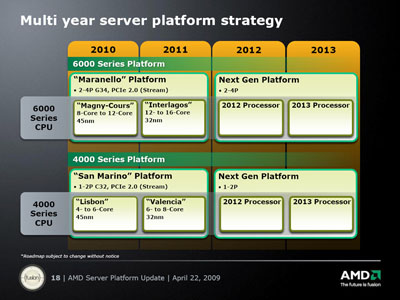

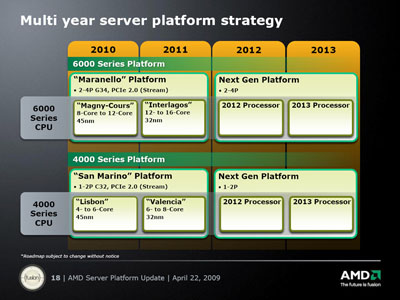

Im Rahmen der Feierlichkeiten zum sechsjährigen Geburtstag des Opterons kleckerte AMD nicht, sondern klotzte. Nicht nur gab man bekannt, dass der Istanbul seinem Zeitplan voraus sei, sondern zeigte auch erstmals ein lauffähiges Sample des 12-Kern-Prozessors namens Magny-Cours. Letztgenannter soll nach aktuellem Stand im ersten Quartal 2010 auf den Markt kommen. Möglich wird diese quasi exponentielle Zunahme der Kerne durch eine Technik namens Die-Bonding, wobei zwei Istanbul-Kerne auf ein Substrat gebannt werden.

Damit nicht genug, warf AMD zudem noch einen Blick auf die nähere Zukunft und erklärte, dass man 2011 sowohl den Umstieg auf den 32-nm-Prozess sowie die Bulldozer-Architektur wagen wolle. An technischen Neuerungen soll der Architekturwechsel nicht nur eine Art „Hyperthreading“, sondern auch neue SSE-Befehle namens Advanced Vector Extensions bringen. Paten für diese Entwicklung sind zum einen die Maranello-Plattform als auch der Interlagos-Prozessor, der mit 12 bis 16 Kernen ins Rennen gehen soll.

http://www.hardwareluxx.de/images/stories/newsbilder/dwenzel/magnycours_sample2.jpg

AMD scheint also keineswegs zu schlafen oder sich zurückzulehnen, wie es scheint und mancher schon befürchtet hatte

nun mit bis zu 16 Kernen.....

http://www.hardwareluxx.de/index.ph...n/11914-amd-kleckert-nicht-sondern-klotz.html

Im Rahmen der Feierlichkeiten zum sechsjährigen Geburtstag des Opterons kleckerte AMD nicht, sondern klotzte. Nicht nur gab man bekannt, dass der Istanbul seinem Zeitplan voraus sei, sondern zeigte auch erstmals ein lauffähiges Sample des 12-Kern-Prozessors namens Magny-Cours. Letztgenannter soll nach aktuellem Stand im ersten Quartal 2010 auf den Markt kommen. Möglich wird diese quasi exponentielle Zunahme der Kerne durch eine Technik namens Die-Bonding, wobei zwei Istanbul-Kerne auf ein Substrat gebannt werden.

Damit nicht genug, warf AMD zudem noch einen Blick auf die nähere Zukunft und erklärte, dass man 2011 sowohl den Umstieg auf den 32-nm-Prozess sowie die Bulldozer-Architektur wagen wolle. An technischen Neuerungen soll der Architekturwechsel nicht nur eine Art „Hyperthreading“, sondern auch neue SSE-Befehle namens Advanced Vector Extensions bringen. Paten für diese Entwicklung sind zum einen die Maranello-Plattform als auch der Interlagos-Prozessor, der mit 12 bis 16 Kernen ins Rennen gehen soll.

http://www.hardwareluxx.de/images/stories/newsbilder/dwenzel/magnycours_sample2.jpg

AMD scheint also keineswegs zu schlafen oder sich zurückzulehnen, wie es scheint und mancher schon befürchtet hatte

LinuS

Vice Admiral Special

Das gehört in Spekulatius. Bis Bulldozer dauert es noch eine ganze Weile.

Bei dem Magny Cours dachte ich bisher, das die einfach ein Istanbul * 2 wäre. Das scheint mir jedoch falsch zu sein, wenn ich die Roadmap anschaue. Demnach wäre das eher ein "Lisbon". Die Frage die sich dann stellt ist, was sich von Istanbul zu Lisbon verändert hat?

btw. auch vom K10 gab es recht früh funktionstüchtige Samples die angeblich sogar ohne größere Probleme bis 3GHz taktbar waren...

Bei dem Magny Cours dachte ich bisher, das die einfach ein Istanbul * 2 wäre. Das scheint mir jedoch falsch zu sein, wenn ich die Roadmap anschaue. Demnach wäre das eher ein "Lisbon". Die Frage die sich dann stellt ist, was sich von Istanbul zu Lisbon verändert hat?

btw. auch vom K10 gab es recht früh funktionstüchtige Samples die angeblich sogar ohne größere Probleme bis 3GHz taktbar waren...

- Mitglied seit

- 18.11.2008

- Beiträge

- 11.406

- Renomée

- 724

- Standort

- 8685x <><

- Aktuelle Projekte

- Spinhenge; Orbit; Milkyway

- Lieblingsprojekt

- Orbit@home; Milkyway@home

- Meine Systeme

- Tuban, 3,8~ Ghz x6 /Turbo 4,095GHz 2x Radeon HD 5850@5870 CFx. // Rechner 2: 5900x B02 //3= 9850 /4 = Rasp

- BOINC-Statistiken

- Mein Desktopsystem

- 5900xt (bis 5,3Ghz Boost); 3900x (bis 4,66 Boots); Thuban 1090x(bis 4 GHz Turbo)

- Mein Laptop

- P-

- Details zu meinem Desktop

- Prozessor

- siehe oben. alles Lukü mit max Anzahl ausgesuchter sehr starker Lüfter. (Rechner 3 = R 9 3900x

- Mainboard

- Asus MSI b 550 Tomahawk/; M4A79Deluxe für Thuban / MSI b 550 Tomahawk für R 9

- Kühlung

- ausgesklügelte Luftkühlung mit starkem Airflow

- Speicher

- vollbelegung

- Grafikprozessor

- Midrange oc 12GB /& 8 GB / & 3GB

- Display

- 2x 22" |(Benq; LG) und 1x 23,6" Samsung TFTs Eyefinity +2x21" für die anderen Rechner

- SSD

- 3x

- HDD

- (Tower voll!)

- Optisches Laufwerk

- Asus SATA-DVD RW

- Soundkarte

- o.b.

- Gehäuse

- ANTEC Twelfehundred Bequiet u.a.

- Netzteil

- vorhanden überall

- Tastatur

- ja gibt es jes

- Maus

- ja

- Betriebssystem

- Win 7 V 64 / und alternative

- Webbrowser

- Opera &/ IEE64/ &Safari und alternative

- Verschiedenes

- Thuban: |V-CoreCPU =1,23- 1,47V Turbo//norm. VID= 1,45V System läuft mit 4 Upgrades seit 2008 stabil!

also wie es aussieht sind das Verlautbarungen von AMD, samt neuer Roadmap incl. Bild, das dies ausweist -

Möchte dir nur ungern wiedersprechen, aber das ist mehr als Spekulation damit.

gerne kannst du dir noch den Artikel von Heise.de dazu ansehen:

http://www.heise.de/newsticker/AMD-demonstriert-12-Kern-Prozessormodul--/meldung/136604

da gibt es übrigens noch einen Screen mit 48 Kernen (!!!)

schönen Abend noch

Möchte dir nur ungern wiedersprechen, aber das ist mehr als Spekulation damit.

gerne kannst du dir noch den Artikel von Heise.de dazu ansehen:

http://www.heise.de/newsticker/AMD-demonstriert-12-Kern-Prozessormodul--/meldung/136604

da gibt es übrigens noch einen Screen mit 48 Kernen (!!!)

schönen Abend noch

LinuS

Vice Admiral Special

Wenn ich mir den Artikel von heise durchlese, dann hört sich das alles andere als nach Ausführungen von AMD bezüglich näheren Bulldozer an. Sie schreiben "soweit man weiß", aber was weiß man von einer unveröffentlichten CPU schon groß, deren "Geburt" noch über 1 Jahr auf sich warten lassen wird mit Bestimmtheit?  hwluxx hat hier lediglich die Meldung von heise verwurstet (wobei heise in letzter Zeit zu meinem Argwohn auch ganz gerne Gerüchte streuen). Das ist dann wie stille Post. Einer sagt etwas und am Ende kommt was anderes heraus... Das ist das Dumme an Zweit-,Dritt- usw. Lektüre.

hwluxx hat hier lediglich die Meldung von heise verwurstet (wobei heise in letzter Zeit zu meinem Argwohn auch ganz gerne Gerüchte streuen). Das ist dann wie stille Post. Einer sagt etwas und am Ende kommt was anderes heraus... Das ist das Dumme an Zweit-,Dritt- usw. Lektüre.

hwluxx hat hier lediglich die Meldung von heise verwurstet (wobei heise in letzter Zeit zu meinem Argwohn auch ganz gerne Gerüchte streuen). Das ist dann wie stille Post. Einer sagt etwas und am Ende kommt was anderes heraus... Das ist das Dumme an Zweit-,Dritt- usw. Lektüre.

hwluxx hat hier lediglich die Meldung von heise verwurstet (wobei heise in letzter Zeit zu meinem Argwohn auch ganz gerne Gerüchte streuen). Das ist dann wie stille Post. Einer sagt etwas und am Ende kommt was anderes heraus... Das ist das Dumme an Zweit-,Dritt- usw. Lektüre.Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

ne, das dumme an le(c)ktüre ist, dass die Türen heutzutage einfach nicht mehr lecker sind...

positiv denken!

Immerhin, wenn es morgen Gummistiefel regnet, fällt Intel vielleicht in einen tiefen Dornröschenschlaf (wo kriegt man nur ne böse Fee her, wenn man mal eine braucht!? )

Und verpennt die Neuentwicklungen und Bulldozer walzt die intelchips des jahres dann platt!

Allerdings ist Core-O-Manie auch nicht der Weisheit letzter schluß.

Zusammengeklebte Istanbuls... okay... aber dadurch wird die IPC und TDP noch nicht unbedingt besser...!?

positiv denken!

Immerhin, wenn es morgen Gummistiefel regnet, fällt Intel vielleicht in einen tiefen Dornröschenschlaf (wo kriegt man nur ne böse Fee her, wenn man mal eine braucht!? )

Und verpennt die Neuentwicklungen und Bulldozer walzt die intelchips des jahres dann platt!

Allerdings ist Core-O-Manie auch nicht der Weisheit letzter schluß.

Zusammengeklebte Istanbuls... okay... aber dadurch wird die IPC und TDP noch nicht unbedingt besser...!?

Oi!Olli

Grand Admiral Special

- Mitglied seit

- 24.12.2006

- Beiträge

- 16.418

- Renomée

- 785

- Mein Laptop

- HP Elitebook 8760W

- Details zu meinem Desktop

- Prozessor

- Ryzen R7 5800X3D

- Mainboard

- Asus B 550 Strix F Wifi

- Kühlung

- Noctua NH-U12A

- Speicher

- 2x 32 GB Kingston FURY DIMM DDR4 3600

- Grafikprozessor

- XFX Speedster MERC 310 Radeon RX 7900 XT Black Edition

- Display

- Acer Predator XB253QGP

- SSD

- Samsung 980 Pro 2 TB, Samsung 970 Evo Plus 2 TB

- HDD

- Samsung TB, 2x2 TB 1x3 TB 1x8 TB

- Optisches Laufwerk

- GH-22NS50

- Soundkarte

- Soundblaster Recon 3d

- Gehäuse

- Raijintek Zofos Evo Silent

- Netzteil

- BeQuiet Straight Power 750 Platinum

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Opera 101 (der Browser aktualisiert sich natürlich immer)

- Verschiedenes

- X-Box One Gamepad, MS Sidewinder Joystick

ne, das dumme an le(c)ktüre ist, dass die Türen heutzutage einfach nicht mehr lecker sind...

positiv denken!

Immerhin, wenn es morgen Gummistiefel regnet, fällt Intel vielleicht in einen tiefen Dornröschenschlaf (wo kriegt man nur ne böse Fee her, wenn man mal eine braucht!? )

Und verpennt die Neuentwicklungen und Bulldozer walzt die intelchips des jahres dann platt!

Allerdings ist Core-O-Manie auch nicht der Weisheit letzter schluß.

Zusammengeklebte Istanbuls... okay... aber dadurch wird die IPC und TDP noch nicht unbedingt besser...!?

SOllte Intel in einen Dornröschenschlaf fallen dann kannst dich freuen. Dann wird AMD nämlich bestimmt schnell mit ihrer Version vom P4 aufwarten.

Terrabyte77

Grand Admiral Special

- Mitglied seit

- 13.02.2008

- Beiträge

- 2.149

- Renomée

- 27

- Standort

- bei BONN

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5800X

- Mainboard

- Asus ROG Strix B350-F Gaming

- Kühlung

- SCYTHE Mugen 5 ARGB Plus

- Speicher

- Corsair Vengeance RGB 16GB (2 x 8GB) DDR4 3466MHz C16 XMP 2.0 Enthusiast RGB LED

- Grafikprozessor

- SAPPHIRE Radeon RX - 6900 XT Nitro+ OC SE

- Display

- MSI OPTIX MPG27CQ VA WQHD 1ms & iiyama ProLite XB2783HSU-B3 AMVA+ LED

- SSD

- C: Samsung MZ-75E500B/EU 850 EVO, E: Samsung 970 EVO plus 2 TB PCIe NVMe M.2 (2280)

- HDD

- Seasonic Fire Hybrid 1TB

- Optisches Laufwerk

- ASUS BW-16D1HT, Asus DRW-24D5MT, LiteOn IHOS104

- Gehäuse

- SILVERSTONE Fortress FT01-B W

- Netzteil

- Seasonic X-660

- Tastatur

- Logitech G 815

- Maus

- Logitech MX 518

- Betriebssystem

- Windows 10 Home Premium 64

- Webbrowser

- Google Chrome

- Verschiedenes

- Logitech G923 Trueforce, Logitech Flight Pro System, WD EX2 Ultra 16TB RAID 0, Panasonic TX-65 HZW 1004

Schlafen wird da niemand, so lange wie Intel mal geschlafen hatte, sowas wird nicht wieder passieren.

Paralell zu den vielen Core-CPUs wird es auch langsam mal Zeit das es Anwendungen gibt die das auch brauchen.

Wer sollte sonst nen Octa-Core brauchen ausser ein paar Film und Grafiker?

Ok ich hab damals ( 2001 ) auch gesagt als ich vom Athlon XP 1800 auf den 3200+ umgestiegen bin der reicht 10 Jahre .

.

Es gibt ja aktuell im privaten Desktop-Bereich nichts was einen i7 965 rechtfertigt ausser Enthusiasmus.

Und bis die Spiele mal soweit sind.........

Paralell zu den vielen Core-CPUs wird es auch langsam mal Zeit das es Anwendungen gibt die das auch brauchen.

Wer sollte sonst nen Octa-Core brauchen ausser ein paar Film und Grafiker?

Ok ich hab damals ( 2001 ) auch gesagt als ich vom Athlon XP 1800 auf den 3200+ umgestiegen bin der reicht 10 Jahre

.

.Es gibt ja aktuell im privaten Desktop-Bereich nichts was einen i7 965 rechtfertigt ausser Enthusiasmus.

Und bis die Spiele mal soweit sind.........

dekaisi

Grand Admiral Special

- Mitglied seit

- 06.11.2006

- Beiträge

- 3.929

- Renomée

- 25

- Standort

- B

- Mein Laptop

- Lenovo Y50-70,32GB Ram, Samsung 830Pro 256GB, Panel Upgrade,...

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3950X

- Mainboard

- ROG Strix X570-E

- Kühlung

- Corsair H115i Platinium

- Speicher

- 4x G.Skill F4-3600C15-8GTZ (B-Die)

- Grafikprozessor

- MSI Trio X 3090

- Display

- Predator X27, Asus MQ270Q

- SSD

- sehr viele :D

- HDD

- viele viele und extra Platz :D

- Optisches Laufwerk

- LG Bluray BH10LS30

- Soundkarte

- Soundblaster X7, Steinberg UR-22C

- Gehäuse

- Corsair Vengeance v70 +Dämmung

- Netzteil

- Enermax Platimax D.F. 600W

- Tastatur

- Corsair RGB Platinum K95

- Maus

- Asus ROG Pugio

- Betriebssystem

- Win10 Prof Workstation

Wer sollte sonst nen Octa-Core brauchen ausser ein paar Film und Grafiker?

Ok ich hab damals ( 2001 ) auch gesagt als ich vom Athlon XP 1800 auf den 3200+ umgestiegen bin der reicht 10 Jahre.

Und bis die Spiele mal soweit sind.........

Zocker, Medizinrechner, Großrechner,... .

Der Bedarf besteht.

Mir hat der XP nicht lange gereicht. Die zahlreichen Ausfälle waren zudem eine starke Belastung im Service Bereich.

Derzeitige Spiele benutzen die Cores ohne Probleme. Man sollte sich eben, wenn, auch das passende Betriebssystem drauf machen. Wer mit XP noch versucht irgendwas zu reißen ist eh schon zu scheitern verurteilt.

Bsp. Left4Dead, Masseffect, COD4/5, Fear, Farcry ... benutzen alle ohne Probleme mehrere Kerne.

Left4Dead auch sehr effektiv, klar Half-life Engine.

Terrabyte77

Grand Admiral Special

- Mitglied seit

- 13.02.2008

- Beiträge

- 2.149

- Renomée

- 27

- Standort

- bei BONN

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5800X

- Mainboard

- Asus ROG Strix B350-F Gaming

- Kühlung

- SCYTHE Mugen 5 ARGB Plus

- Speicher

- Corsair Vengeance RGB 16GB (2 x 8GB) DDR4 3466MHz C16 XMP 2.0 Enthusiast RGB LED

- Grafikprozessor

- SAPPHIRE Radeon RX - 6900 XT Nitro+ OC SE

- Display

- MSI OPTIX MPG27CQ VA WQHD 1ms & iiyama ProLite XB2783HSU-B3 AMVA+ LED

- SSD

- C: Samsung MZ-75E500B/EU 850 EVO, E: Samsung 970 EVO plus 2 TB PCIe NVMe M.2 (2280)

- HDD

- Seasonic Fire Hybrid 1TB

- Optisches Laufwerk

- ASUS BW-16D1HT, Asus DRW-24D5MT, LiteOn IHOS104

- Gehäuse

- SILVERSTONE Fortress FT01-B W

- Netzteil

- Seasonic X-660

- Tastatur

- Logitech G 815

- Maus

- Logitech MX 518

- Betriebssystem

- Windows 10 Home Premium 64

- Webbrowser

- Google Chrome

- Verschiedenes

- Logitech G923 Trueforce, Logitech Flight Pro System, WD EX2 Ultra 16TB RAID 0, Panasonic TX-65 HZW 1004

Zocker, Medizinrechner, Großrechner,... .

Der Bedarf besteht.

Mir hat der XP nicht lange gereicht. Die zahlreichen Ausfälle waren zudem eine starke Belastung im Service Bereich.

Derzeitige Spiele benutzen die Cores ohne Probleme. Man sollte sich eben, wenn, auch das passende Betriebssystem drauf machen. Wer mit XP noch versucht irgendwas zu reißen ist eh schon zu scheitern verurteilt.

Bsp. Left4Dead, Masseffect, COD4/5, Fear, Farcry ... benutzen alle ohne Probleme mehrere Kerne.

Left4Dead auch sehr effektiv, klar Half-life Engine.

Hi,

nun ich zocke all diese Spiele ausser COD, dazu noch Dead Space, aber auf nem X2 5000+ BE @3200 Mhz.

Beisher hab ich nen 4 Kerner nicht vermisst, aber selbst wenn, so bedeutet das nicht das diese Spiele und zukünftige die 6-8-24 Kerne voll auslasten können.

Bis heute hat noch kein Spiel die maximal kaufbare Performance ausgeretzt.

Warum sollten diese Spiele die noch kommen in wenigen Monaten einen Quantensprung machen und Octacore CPUS als Systemanforderungen haben?

Ich denke da wird viel mit Zahlen geworben die kein Mensch braucht, noch lange nicht!

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Allerdings ist Core-O-Manie auch nicht der Weisheit letzter schluß.

Zusammengeklebte Istanbuls... okay... aber dadurch wird die IPC und TDP noch nicht unbedingt besser...!?

Hallo? Es geht hier um SERVER bzw WORKSTATION CPUs. Da ist jeder Kern zu gebrauchen. IPC zählt dort auch schon lange nicht mehr. Und selbst wenn die TDP lediglich linear skaliert, man kann damit trotzdem effizienter arbeiten. Letztendlich sind nämlich die gesamten Systeme ausschlaggebend. ZB zwei Systeme mit jeweils einem 4-Kern Prozessoren brauchen insgesamt mehr Leistung als ein System mit einem 8-Kern Prozessor.Wer sollte sonst nen Octa-Core brauchen ausser ein paar Film und Grafiker?

@topic

Ist das ein Schreibfehler, lediglich AMDs Bezeichnung für SSE5 oder bringen sie mit Bulldozer tatsächlich schon AVX?An technischen Neuerungen soll der Architekturwechsel nicht nur eine Art „Hyperthreading“, sondern auch neue SSE-Befehle namens Advanced Vector Extensions bringen.

Wan_Mateng

Admiral Special

@topic

Ist das ein Schreibfehler, lediglich AMDs Bezeichnung für SSE5 oder bringen sie mit Bulldozer tatsächlich schon AVX?

heise schrieb:Außerdem soll Bulldozer Intels neue Advanced Vector Extension unterstützen (SSE mit 256 Bit Breite), wobei man sich noch mit Intel über das nächste Patentaustauschabkommen einigen muss

Sandy Bridge soll ja auch 2011 rauskommen mit dieser Erweiterung.Also gut möglich das AMD sich schon mit Intel geeinigt hat. Wäre natürlich klasse. Denke 2011 wird ein interessantes Jahr.

mfg

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Fände ich auch gut, wenn man sich wieder auf einen gemeinsamen Nenner einigen würde. Dieser ganze SSE4a/SSE4.1/SSE4.2 Hick Hack hilft nun wirklich keinem weiter. Eine 256 Bit FP Pipeline ist natürlich auch lecker. DP Gaming kann kommen.

Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

öhm... hängt das DP-Gaming denn von 256Bit Vektor-extensions ab?

Da muss doch die Graka die hauptarbeit machen, und die wird auch nicht breiter / schneller wenn der Prozessor nun AVX kann...

Abgesehen davon ist die Situation mit SSE heute immerhin schon merklich beser als zu pentium2/3 - Zeiten, als AMD nur 3DNow und intel nur SSE konnten, da gabs gar keinen gemeinsamen nenner...

Daher ist im Moment SSE2/3 als gemeinsame Basis gar nicht mal soooo schlecht...

Da muss doch die Graka die hauptarbeit machen, und die wird auch nicht breiter / schneller wenn der Prozessor nun AVX kann...

Abgesehen davon ist die Situation mit SSE heute immerhin schon merklich beser als zu pentium2/3 - Zeiten, als AMD nur 3DNow und intel nur SSE konnten, da gabs gar keinen gemeinsamen nenner...

Daher ist im Moment SSE2/3 als gemeinsame Basis gar nicht mal soooo schlecht...

FalconFly

Admiral Special

Das aktuelle Produktportofolio (Opteron) hat einen guten Sprung nach vorne, sowie in die richtige Richtung getan.

Bleibt nur zu hoffen, dass die neuen Opterons bez. deren tatsaechliche Verfuegbarkeit den gleichen Sprung nach vorne machen.

Bislang sah es fuer viele an sich interessante Modelle (bes. viele HE-Versionen) ja verdammt mager aus

Bleibt nur zu hoffen, dass die neuen Opterons bez. deren tatsaechliche Verfuegbarkeit den gleichen Sprung nach vorne machen.

Bislang sah es fuer viele an sich interessante Modelle (bes. viele HE-Versionen) ja verdammt mager aus

dekaisi

Grand Admiral Special

- Mitglied seit

- 06.11.2006

- Beiträge

- 3.929

- Renomée

- 25

- Standort

- B

- Mein Laptop

- Lenovo Y50-70,32GB Ram, Samsung 830Pro 256GB, Panel Upgrade,...

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3950X

- Mainboard

- ROG Strix X570-E

- Kühlung

- Corsair H115i Platinium

- Speicher

- 4x G.Skill F4-3600C15-8GTZ (B-Die)

- Grafikprozessor

- MSI Trio X 3090

- Display

- Predator X27, Asus MQ270Q

- SSD

- sehr viele :D

- HDD

- viele viele und extra Platz :D

- Optisches Laufwerk

- LG Bluray BH10LS30

- Soundkarte

- Soundblaster X7, Steinberg UR-22C

- Gehäuse

- Corsair Vengeance v70 +Dämmung

- Netzteil

- Enermax Platimax D.F. 600W

- Tastatur

- Corsair RGB Platinum K95

- Maus

- Asus ROG Pugio

- Betriebssystem

- Win10 Prof Workstation

Bislang sah es fuer viele an sich interessante Modelle (bes. viele HE-Versionen) ja verdammt mager aus

na weil die ordentlich verkauft werden, da bleibt nix über.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Direkt natürlich nicht. Man kann zur Not ja immer noch x87 nutzen.öhm... hängt das DP-Gaming denn von 256Bit Vektor-extensions ab?

Spiele arbeiten idR bezüglich räumlichen Ausdehnungen aber mit 3- bzw 4-fach Vektoren. Und da reicht ein SSE Register nun mal nur für SP (32 Bit) aus. Man müsste für DP also immer mit zwei Registern bzw Instruktionen arbeiten. Mit AVX wäre wiederum nur ein Register notwendig. Damit aber nicht genug. Man könnte hier letztendlich auch 2 SP Vektoren in einem Register unterbringen.

Spiele arbeiten idR bezüglich räumlichen Ausdehnungen aber mit 3- bzw 4-fach Vektoren. Und da reicht ein SSE Register nun mal nur für SP (32 Bit) aus. Man müsste für DP also immer mit zwei Registern bzw Instruktionen arbeiten. Mit AVX wäre wiederum nur ein Register notwendig. Damit aber nicht genug. Man könnte hier letztendlich auch 2 SP Vektoren in einem Register unterbringen.Für die Transformationen ist immer noch der Prozessor zuständig, speziell was Modell, Kamera und Welt betrifft. Die Grafikkarte kommt erst dann zum Tragen, wenn es um die 2D Projektion geht, also die Pixel berechnet werden müssen.Da muss doch die Graka die hauptarbeit machen, und die wird auch nicht breiter / schneller wenn der Prozessor nun AVX kann...

Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

Interessant... ich war immer der Meinung dass Transform & Lighting (abgekürzt T&L) schon seit DX7 in HW (graka) beherrscht wird... aber ich hab ehrlich gesagt auch nicht den großen Durchblick im Gaming/Rendering, da ich seit jahren kaum noch zum zocken komme.

Trotzdem interessekt.

Dennoch könnte man AFAIK ja trotzdem schon jetzt DP-Gaming machen, bräuchte halt immer 2 SSE-Register auf einmal.

grüßle

michse

Trotzdem interessekt.

Dennoch könnte man AFAIK ja trotzdem schon jetzt DP-Gaming machen, bräuchte halt immer 2 SSE-Register auf einmal.

grüßle

michse

und damit hast du absolut recht. die cpu muss das schon lange nich mehr durchkauen.Interessant... ich war immer der Meinung dass Transform & Lighting (abgekürzt T&L) schon seit DX7 in HW (graka) beherrscht wird... aber ich hab ehrlich gesagt auch nicht den großen Durchblick im Gaming/Rendering, da ich seit jahren kaum noch zum zocken komme.

Trotzdem interessekt.

Dennoch könnte man AFAIK ja trotzdem schon jetzt DP-Gaming machen, bräuchte halt immer 2 SSE-Register auf einmal.

grüßle

michse

Undergroundking

Gesperrt

- Mitglied seit

- 23.05.2007

- Beiträge

- 2.366

- Renomée

- 72

und eingene chipsätze für server sind auch in der mache.

http://www.pcgameshardware.de/aid,6...it-eigenen-Server-Chipsaetzen/Mainboard/News/

http://www.pcgameshardware.de/aid,6...it-eigenen-Server-Chipsaetzen/Mainboard/News/

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Ja. Aber davon habe ich auch nicht gesprochen. Das kommt, wie ich schon sagte, erst bei der 2D Projektion zum tragen, wenn Vertices bzw Pixel berechnet werden müssen.ich war immer der Meinung dass Transform & Lighting (abgekürzt T&L) schon seit DX7 in HW (graka) beherrscht wird...

Ein Modell zu drehen, zu verschieben, die Kamera auszurichten, etc erfolgt immer noch über Vektor- bzw Matrix Transformationen, welche die CPU übernimmt.

Zuletzt bearbeitet:

Ge0rgy

Grand Admiral Special

- Mitglied seit

- 14.07.2006

- Beiträge

- 4.322

- Renomée

- 82

- Mein Laptop

- Lenovo Thinkpad X60s

- Details zu meinem Desktop

- Prozessor

- Phenom II 955 BE

- Mainboard

- DFI LanParty DK 790FXB-M3H5

- Kühlung

- Noctua NH-U12P

- Speicher

- 4GB OCZ Platinum DDR1600 7-7-7 @ 1333 6-6-6

- Grafikprozessor

- Radeon 4850 1GB

- HDD

- Western Digital Caviar Black 1TB

- Netzteil

- Enermax Modu 525W

- Betriebssystem

- Linux, Vista x64

- Webbrowser

- Firefox 3.5

Oh...okay, wusst ich nicht...

Ich dachte matrix-Rechnungen können GPUs viel besser als CPUs

Ich dachte matrix-Rechnungen können GPUs viel besser als CPUs

Nope. Die 3D-Transformation kann wirklich seit DX7 auf der GPU gemacht werden (inzwischen von den Shader-Einheiten).Ja. Aber davon habe ich auch nicht gesprochen. Das kommt, wie ich schon sagte, erst bei der 2D Projektion zum tragen, wenn Vertices bzw Pixel berechnet werden müssen.

Ein Modell zu drehen, zu verschieben, die Kamera auszurichten, etc erfolgt immer noch über Vektor- bzw Matrix Transformationen, welche die CPU übernimmt.

Und was Vertex-Daten in doppelter Genauigkeit jetzt groß für Vorteile bringen sollen, muß mir auch erst mal jemand erklären. Riesige Außenareale etwas einfacher zu erstellen?

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Nochmal, es ging nicht um Vertices. Bitte kein Halbwissen verbreiten. Wer nicht schon mal eine OpenGL oder DirectX Graphics Anwendung programmiert hat, bitte die Füsse still halten.Nope. Die 3D-Transformation kann wirklich seit DX7 auf der GPU gemacht werden (inzwischen von den Shader-Einheiten).

Für die Transformationen ist immer noch der Prozessor zuständig, speziell was Modell, Kamera und Welt betrifft. Die Grafikkarte kommt erst dann zum Tragen, wenn es um die 2D Projektion geht, also die Pixel berechnet werden müssen.

Aha, also die 3D-Modelle bestehen etwa nicht aus Vertices? Das wäre ja mal wirklich was Neues (zumindest wenn es keine Voxel-Engine istNochmal, es ging nicht um Vertices. Bitte kein Halbwissen verbreiten. Wer nicht schon mal eine OpenGL oder DirectX Graphics Anwendung programmiert hat, bitte die Füsse still halten.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif) ).

).Und soll ich jetzt hier wirklich das Direct3D-Manual zitieren um Dir zu zeigen, daß die Transformation von Modell-Koordinaten zu Welt-Koordinaten (verschieben, drehen, skalieren) und die Kameratransformation auch über DirectX-Aufrufe ausgeführt werden? Und wenn DirectX das nicht an die GPU weiter reicht, dann vielleicht nur, weil man irgendein Uralt-Teil hat, was das nicht kann.

Ich kann Dir sogar sagen, daß der in DirectX11 geforderte (und teilweise schon heute auf ATIs vorhandene) Hardware-Tesselator sogar noch vor der Modell -> Welt-Koordinaten Trafo ansetzt. Der arbeitet also mit Vertex-Koordinaten im Modell-Raum.

So, und jetzt belehre mich eines Besseren. Versuche doch mal zu erklären, wie Displacement-Mapping in Hardware funktioniert, wenn doch die CPU die Welt- und Kamera-Trafo macht (die erst später in der Grafikpipeline kommen)

Zuletzt bearbeitet:

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Ja, mach das bitte. Dann wirst du nämlich merken, dass diese Aufrufe der D3DX High Level Bibliothek entspringen, welche letztendlich auf der CPU landen. Das hat mit der GPU noch gar nichts zu tun. Wobei sich das natürlich mit DX11 aufgrund der Compute Shader ändern könnte.Und soll ich jetzt hier wirklich das Direct3D-Manual zitieren um Dir zu zeigen, daß die Transformation von Modell-Koordinaten zu Welt-Koordinaten (verschieben, drehen, skalieren) und die Kameratransformation auch über DirectX-Aufrufe ausgeführt werden?

Was bitteschön hat Displace Mapping oder überhaupt ein Mapping mit dem Thema zu tun? Nochmal, es ging um Welt, Modell und Kamera Transformationen. Mapping hingegen setzt direkt auf dem Polygon an, liegt also eine Ebene darunter.Versuche doch mal zu erklären, wie Displacement-Mapping in Hardware funktioniert, wenn doch die CPU die Welt- und Kamera-Trafo macht (die erst später in der Grafikpipeline kommen)

Vielleicht kommst du ja mit dem Begriff nicht klar. Damit ist Translation, Rotation und Skalierung.gemeint. Es geht hier nicht um die Manipulation von einzelnen Vertices.

Du solltest ausserdem unterscheiden, in welcher Reihenfolge die Pipeline arbeitet und wie sie gefüttert wird.

Ich sehe schon, hier ist wieder jede Menge Halbwissen vorhanden. Und dann noch mit einem solch aggressiven und besserwisserischen Tonfall.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 52K

- Antworten

- 27

- Aufrufe

- 8K

- Antworten

- 0

- Aufrufe

- 37K