App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Intel Nehalem

- Ersteller Desti

- Erstellt am

mocad_tom

Admiral Special

- Mitglied seit

- 17.06.2004

- Beiträge

- 1.234

- Renomée

- 52

@desti

>Dann hat der Penryn also auch keinen Shared Cache, sondern 2*3 MiB, sieht schließlich genauso aus.

Tomaten auf den Augen. Beim Penryn-Die sieht man ziemlich exakt den Shared-Port, durch den auf den Cache zugegriffen wird.

Hab mir jetzt das große Bild nochmal angesehen.

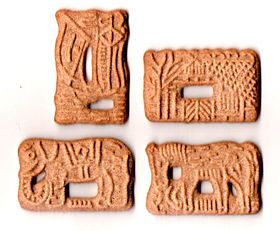

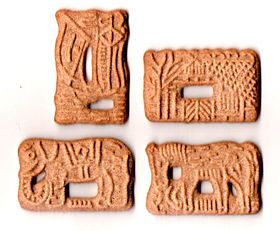

Es schaut fast nach 4x2MB dedicated Cache aus - siehe grüne Balken im Anhang.

Roter Balken entspricht Crossbar + SRQ

Grüße,

Tom

>Dann hat der Penryn also auch keinen Shared Cache, sondern 2*3 MiB, sieht schließlich genauso aus.

Tomaten auf den Augen. Beim Penryn-Die sieht man ziemlich exakt den Shared-Port, durch den auf den Cache zugegriffen wird.

Hab mir jetzt das große Bild nochmal angesehen.

Es schaut fast nach 4x2MB dedicated Cache aus - siehe grüne Balken im Anhang.

Roter Balken entspricht Crossbar + SRQ

Grüße,

Tom

Zuletzt bearbeitet:

Opteron

Redaktion

☆☆☆☆☆☆

Tom .. geh schlafenHab mir jetzt das große Bild nochmal angesehen.

Es schaut fast nach 4x2MB dedicated Cache aus - siehe grüne Balken im Anhang.

Roter Balken entspricht Crossbar + SRQ

Ansonsten beherzige meinen Rat, den ich schon Sompe gegeben hab:

und grüble mal, was "Bank" alles bedeuten kann ^^Das wird schon passen, schau Dir mal Suns T2 an ... sind halt nur 2(oder mehr) Bänke.

ciao

Alex

OBrian

Moderation MBDB, ,

- Mitglied seit

- 16.10.2000

- Beiträge

- 17.032

- Renomée

- 267

- Standort

- NRW

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 940 BE, C2-Stepping (undervolted)

- Mainboard

- Gigabyte GA-MA69G-S3H (BIOS F7)

- Kühlung

- Noctua NH-U12F

- Speicher

- 4 GB DDR2-800 ADATA/OCZ

- Grafikprozessor

- Radeon HD 5850

- Display

- NEC MultiSync 24WMGX³

- SSD

- Samsung 840 Evo 256 GB

- HDD

- WD Caviar Green 2 TB (WD20EARX)

- Optisches Laufwerk

- Samsung SH-S183L

- Soundkarte

- Creative X-Fi EM mit YouP-PAX-Treibern, Headset: Sennheiser PC350

- Gehäuse

- Coolermaster Stacker, 120mm-Lüfter ersetzt durch Scythe S-Flex, zusätzliche Staubfilter

- Netzteil

- BeQuiet 500W PCGH-Edition

- Betriebssystem

- Windows 7 x64

- Webbrowser

- Firefox

- Verschiedenes

- Tastatur: Zowie Celeritas Caseking-Mod (weiße Tasten)

Hab noch ein passendes Bild gefunden:

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

So ein kleines vermatschtes Bild ist doch völlig unbrauchbar, daraus kann man doch gar nichts erkennen. Wenn es größer und sauberer wäre, könnte man evtl. über Veränderungen am Core spekulieren, aber so?

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

So ein kleines vermatschtes Bild ist doch völlig unbrauchbar, daraus kann man doch gar nichts erkennen. Wenn es größer und sauberer wäre, könnte man evtl. über Veränderungen am Core spekulieren, aber so?

mocad_tom

Admiral Special

- Mitglied seit

- 17.06.2004

- Beiträge

- 1.234

- Renomée

- 52

Hier gibt es einen ziemlich exakten Die-Plot:

http://www.intel.com/pressroom/kits/events/idffall_2007/BriefingSmith45nm.pdf

Im Anhang, als Grundlage für weitere Diskussionen.

War echt schon ein bisschen spät, @desti war nicht so gemeint, sorry.

Hier also nun meine Erklärung warum ich mir eig. keinen Shared-Cache vorstellen kann.

Die haben die L1-Caches nach oben gedreht und zur Mitte hin orientiert, was für einen shared 4-Port-L2 sprechen würde, aber dann hätten sie irrsinnige Signalwege, wer baut denn sowas?

Geht mal im Geiste den Signalweg vom L1-Cache des linken äusseren Kern, zum L2-Cache-Port(in der Mitte) und dann zu einer der rechten unteren Cache-Zellen durch, man muss einmal "Z-ähnlich" über den sowieso schon sehr grossen Die, was wird das wohl an Latenzen kosten?

Grüße,

Tom

http://www.intel.com/pressroom/kits/events/idffall_2007/BriefingSmith45nm.pdf

Im Anhang, als Grundlage für weitere Diskussionen.

War echt schon ein bisschen spät, @desti war nicht so gemeint, sorry.

Hier also nun meine Erklärung warum ich mir eig. keinen Shared-Cache vorstellen kann.

Die haben die L1-Caches nach oben gedreht und zur Mitte hin orientiert, was für einen shared 4-Port-L2 sprechen würde, aber dann hätten sie irrsinnige Signalwege, wer baut denn sowas?

Geht mal im Geiste den Signalweg vom L1-Cache des linken äusseren Kern, zum L2-Cache-Port(in der Mitte) und dann zu einer der rechten unteren Cache-Zellen durch, man muss einmal "Z-ähnlich" über den sowieso schon sehr grossen Die, was wird das wohl an Latenzen kosten?

Grüße,

Tom

Zuletzt bearbeitet:

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

Hier noch eine Newsmeldung dazu:

http://www.computerbase.de/news/hardware/prozessoren/intel/2007/september/idf_intel_nehalem_aktion/

http://www.computerbase.de/news/hardware/prozessoren/intel/2007/september/idf_intel_nehalem_aktion/

mocad_tom

Admiral Special

- Mitglied seit

- 17.06.2004

- Beiträge

- 1.234

- Renomée

- 52

@opteron

>Das wird schon passen, schau Dir mal Suns T2 an ... sind halt nur 2(oder mehr) Bänke.

Äpfel <-> Birnen

Bei dem T2 sind die Cache-Latenzen zweitrangig - durch die vielen logischen Threads kann man L2-Zugriffs-Wartezyklen verstecken. Intel wird Nehalem hoffentlich nicht auf Durchsatz hin optimiert haben - sonst können sie der Single-Thread-Integer-Performance-Krone gleich wieder adieu sagen.

Grüße,

Tom

>Das wird schon passen, schau Dir mal Suns T2 an ... sind halt nur 2(oder mehr) Bänke.

Äpfel <-> Birnen

Bei dem T2 sind die Cache-Latenzen zweitrangig - durch die vielen logischen Threads kann man L2-Zugriffs-Wartezyklen verstecken. Intel wird Nehalem hoffentlich nicht auf Durchsatz hin optimiert haben - sonst können sie der Single-Thread-Integer-Performance-Krone gleich wieder adieu sagen.

Grüße,

Tom

Opteron

Redaktion

☆☆☆☆☆☆

Tja .. irgendwohin muss der L2 hin (againDie haben die L1-Caches nach oben gedreht und zur Mitte hin orientiert, was für einen shared 4-Port-L2 sprechen würde, aber dann hätten sie irrsinnige Signalwege, wer baut denn sowas?

Geht mal im Geiste den Signalweg vom L1-Cache des linken äusseren Kern, zum L2-Cache-Port(in der Mitte) und dann zu einer der rechten unteren Cache-Zellen durch, man muss einmal "Z-ähnlich" über den sowieso schon sehr grossen Die, was wird das wohl an Latenzen kosten?

Ansonsten sind Deine 4 "grünen" Blöcke wohl die L2 Write-Back Buffer der 4 Cache Bänke. Ich kann mich nur abermals wiederholen, schau Dir Sun T2 Design an ..

Damits einfacher ist, diesmal sogar mit Link

http://www.realworldtech.com/page.cfm?ArticleID=RWT090406012516&p=4

Edit: Oh da war noch ein Äpfel-Birnen Beitrag ...

Du glaubst also allen Ernstens Intel baut auf Ihren ersten native QuadKern 4 *einzelne* Caches ... damit bist Du dann aber schon aus der Obstabteilung raus, das wäre ne lahme Möhre, um im Bild zu bleiben

Zum Thema "Throughput": Du hast schon mitbekommen, dass Intel wieder SMT (Hyperthreading) einbaut, oder ?

Edit2:

Die 16fach core Systeme waren 2P, vielleicht gabs deswegen das Mißverständnis:

http://www.theinquirer.net/default.aspx?article=42440

ciao

Alex

Zuletzt bearbeitet:

p4z1f1st

Grand Admiral Special

- Mitglied seit

- 28.04.2003

- Beiträge

- 9.722

- Renomée

- 81

- Details zu meinem Desktop

- Prozessor

- AMD FX-6300

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- HEATKILLER® CPU Rev3.0 LC + HEATKILLER® GPU-X² 69x0 LT

- Speicher

- 2x 4096 MB G.Skill RipJawsX DDR3-1600 CL7

- Grafikprozessor

- AMD Radeon RX 480 8GB

- Display

- Dell U2312HM

- HDD

- Crucial m4 SSD 256GB

- Optisches Laufwerk

- Sony Optiarc AD-7260S

- Soundkarte

- Creative Labs SB Audigy 2 ZS

- Gehäuse

- Chieftec Scorpio TA-10B-D (BxHxT: 205x660x470mm)

- Netzteil

- Seasonic X-Series X-660

- Betriebssystem

- Microsoft Windows 10 Professional 64bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- Watercool HTF2 Dual + 2x Papst 4412 F/2GL

Habe meine "Leistung-um-jeden-Preis-Kiddie"-Zeit zwar schon hinter mir (hat mit dem Studium urplötzlich an Priorität verloren  ) aber wenn ich einen Taskmanager mit 16 Lastfenster sehe, geht mir jetzt sogar noch einer ab

) aber wenn ich einen Taskmanager mit 16 Lastfenster sehe, geht mir jetzt sogar noch einer ab

Hat zwar absolut 0 Sinn für jeglichen Normal-Consumer, aber es sieht beeindruckend aus

) aber wenn ich einen Taskmanager mit 16 Lastfenster sehe, geht mir jetzt sogar noch einer ab

) aber wenn ich einen Taskmanager mit 16 Lastfenster sehe, geht mir jetzt sogar noch einer ab

Hat zwar absolut 0 Sinn für jeglichen Normal-Consumer, aber es sieht beeindruckend aus

Hier gibt es einen ziemlich exakten Die-Plot:

http://www.intel.com/pressroom/kits/events/idffall_2007/BriefingSmith45nm.pdf

Im Anhang, als Grundlage für weitere Diskussionen.

War echt schon ein bisschen spät, @desti war nicht so gemeint, sorry.

Hier also nun meine Erklärung warum ich mir eig. keinen Shared-Cache vorstellen kann.

Die haben die L1-Caches nach oben gedreht und zur Mitte hin orientiert, was für einen shared 4-Port-L2 sprechen würde, aber dann hätten sie irrsinnige Signalwege, wer baut denn sowas?

Geht mal im Geiste den Signalweg vom L1-Cache des linken äusseren Kern, zum L2-Cache-Port(in der Mitte) und dann zu einer der rechten unteren Cache-Zellen durch, man muss einmal "Z-ähnlich" über den sowieso schon sehr grossen Die, was wird das wohl an Latenzen kosten?

Grüße,

Tom

Intel zeichnet dort den Speicher nur mit 2 Verbindungen, schreibt aber nichts dazu, vielleicht steht es noch nicht ganz fest ob 2 oder 3, ist ja auch eine Kostenfrage bei den Mainboards.

Dieser Kommentar würde aber auch eher zu 3 Channels passen:

http://www.news.com/8301-10784_3-9780925-7.html?part=rss&subj=news&tag=2547-1001_3-0-5

"When we go to Nehalem next year, we will see the memory latency and bandwidth improve dramatically," Gelsinger said. Memory bandwidth will be three times that of today's best systems, he said.

Die 4 Sockel Version bekommt klar 3 CSI Links.

Fragt sich was Intel mit "Dynamically Managed Threads/Cores/Caches meint.

Hier gibt es einen ziemlich exakten Die-Plot:

http://www.intel.com/pressroom/kits/events/idffall_2007/BriefingSmith45nm.pdf

Im Anhang, als Grundlage für weitere Diskussionen.

War echt schon ein bisschen spät, @desti war nicht so gemeint, sorry.

Hier also nun meine Erklärung warum ich mir eig. keinen Shared-Cache vorstellen kann.

Die haben die L1-Caches nach oben gedreht und zur Mitte hin orientiert, was für einen shared 4-Port-L2 sprechen würde, aber dann hätten sie irrsinnige Signalwege, wer baut denn sowas?

Geht mal im Geiste den Signalweg vom L1-Cache des linken äusseren Kern, zum L2-Cache-Port(in der Mitte) und dann zu einer der rechten unteren Cache-Zellen durch, man muss einmal "Z-ähnlich" über den sowieso schon sehr grossen Die, was wird das wohl an Latenzen kosten?

Grüße,

Tom

Noch ein paar Überlegungen dazu:

a) der Nehalem kommt vom Oregon Design Team, also die, die den Rest ihres Lebens Netburst gemacht haben, ich glaube kaum, dass davon nicht auch was hängen geblieben ist.

b) Das Layout muss für 2, 4 und 8 Cores onDie geeignet sein. Würde man jetzt die Cores z.B. um 90° drehen und mit den L1 Caches nach innen zeigen lassen, könnte man zwar für den Dual Core auch einfach die oberen beiden abschneiden, hätte dann aber unten immer noch die selbe Cachemenge und eine ziemlich längliches Die, nicht gut für die Fertigung, schneidet man hier links und rechts einen Core samt Cache ab, bekommt man ein wieder nur ein leicht unterschiedliche Kantenlänge raus und da man gleich noch unnötige Cachefläche entsorgt hat, spart man noch mehr Platz, schließlich ist Dual Core 2009 nur noch Low-End und muss sich daher günstig produzieren lassen.

Der 8 Core könnte nun unten gespiegelt werden, also der Cache in der Mitte und die Cores drum herum.

p4z1f1st

Grand Admiral Special

- Mitglied seit

- 28.04.2003

- Beiträge

- 9.722

- Renomée

- 81

- Details zu meinem Desktop

- Prozessor

- AMD FX-6300

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- HEATKILLER® CPU Rev3.0 LC + HEATKILLER® GPU-X² 69x0 LT

- Speicher

- 2x 4096 MB G.Skill RipJawsX DDR3-1600 CL7

- Grafikprozessor

- AMD Radeon RX 480 8GB

- Display

- Dell U2312HM

- HDD

- Crucial m4 SSD 256GB

- Optisches Laufwerk

- Sony Optiarc AD-7260S

- Soundkarte

- Creative Labs SB Audigy 2 ZS

- Gehäuse

- Chieftec Scorpio TA-10B-D (BxHxT: 205x660x470mm)

- Netzteil

- Seasonic X-Series X-660

- Betriebssystem

- Microsoft Windows 10 Professional 64bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- Watercool HTF2 Dual + 2x Papst 4412 F/2GL

Noch ein paar Überlegungen dazu:

a) der Nehalem kommt vom Oregon Design Team, also die, die den Rest ihres Lebens Netburst gemacht haben, ich glaube kaum, dass davon nicht auch was hängen geblieben ist.

b) Das Layout muss für 2, 4 und 8 Cores onDie geeignet sein. Würde man jetzt die Cores z.B. um 90° drehen und mit den L1 Caches nach innen zeigen lassen, könnte man zwar für den Dual Core auch einfach die oberen beiden abschneiden, hätte dann aber unten immer noch die selbe Cachemenge und eine ziemlich längliches Die, nicht gut für die Fertigung, schneidet man hier links und rechts einen Core samt Cache ab, bekommt man ein wieder nur ein leicht unterschiedliche Kantenlänge raus und da man gleich noch unnötige Cachefläche entsorgt hat, spart man noch mehr Platz, schließlich ist Dual Core 2009 nur noch Low-End und muss sich daher günstig produzieren lassen.

Der 8 Core könnte nun unten gespiegelt werden, also der Cache in der Mitte und die Cores drum herum.

Mir stellt sich gerade die Frage (da ich deine "unten gespielt"-Beschreibung anfangs missverstanden habe), ob es eigentlich möglich wäre, 2 QuadCores "übereinander" zu bauen...sprich, 2 "dicke" Schichten die je einen QC darstellen übereinander. Wäre das anbindungstechnisch überhaupt realisierbar?

mocad_tom

Admiral Special

- Mitglied seit

- 17.06.2004

- Beiträge

- 1.234

- Renomée

- 52

@opteron

http://www.anandtech.com/IT/showdoc.aspx?i=2727&p=5

Der Niagara 1 hat bei 1GHz ein L2-Latenz von 22 Zyklen

Schaut man sich hier die Grafiken an, dann sieht man wie weit der L3-Cache hinterher hinkt:

http://www.techreport.com/articles.x/13176/3

Vom Opteron zum Barcelona wurde der L2-Zugriff langsamer, von 12 auf 16 Zyklen

Der L3-Cache-Zugriff liegt irgendwo bei 40 Zyklen.

Der Conroe benötigt 14 Zyklen, ein großer Teil der Performance des Conroe rührt daher, dass er sehr sehr schnell auf 4MB L2-Cache zugreifen kann - bricht dieser Vorteil weg bricht so einiges weg.

Und natürlich ist mir klar das Nehalem SMT hat, allerdings kann ich mir nicht vorstellen das man Single-Thread-Performance zurückstellt um dafür Durchsatz zu steigern.

Grüße,

Tom

http://www.anandtech.com/IT/showdoc.aspx?i=2727&p=5

Der Niagara 1 hat bei 1GHz ein L2-Latenz von 22 Zyklen

Schaut man sich hier die Grafiken an, dann sieht man wie weit der L3-Cache hinterher hinkt:

http://www.techreport.com/articles.x/13176/3

Vom Opteron zum Barcelona wurde der L2-Zugriff langsamer, von 12 auf 16 Zyklen

Der L3-Cache-Zugriff liegt irgendwo bei 40 Zyklen.

Der Conroe benötigt 14 Zyklen, ein großer Teil der Performance des Conroe rührt daher, dass er sehr sehr schnell auf 4MB L2-Cache zugreifen kann - bricht dieser Vorteil weg bricht so einiges weg.

Und natürlich ist mir klar das Nehalem SMT hat, allerdings kann ich mir nicht vorstellen das man Single-Thread-Performance zurückstellt um dafür Durchsatz zu steigern.

Grüße,

Tom

mtb][sledgehammer

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 4.375

- Renomée

- 30

- Mein Laptop

- HP Compaq nx6125

- Details zu meinem Desktop

- Prozessor

- Athlon XP 2500+

- Mainboard

- Asrock K7S8XE

- Kühlung

- AC / selfmade Wakü

- Speicher

- 1 GB PC3200 Team Memory

- Grafikprozessor

- ATI Radeon 9500

- Display

- 20,1'' Samsung SyncMaster 205BW 1680x1050

- HDD

- Samsung SV0802N

- Optisches Laufwerk

- Toshiba DVD-ROM SD-M1612

- Soundkarte

- Creative SB Live! Player 1024

- Gehäuse

- Chenbro Net Server Tower

- Netzteil

- Coba 400 Watt (silent)

- Betriebssystem

- Windows XP, Ubuntu Linux

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- knc TV Station , Terratec Cinergy 1200 DVB-C

Ich glaube das ist eher ungünstig. In Die Querschnitten sieht man immer sehr schön, dass die Strukturbreite von unten nach oben zunimmt (fertigungsbedingt ?). Da müsste man was grundlegend dran ändern. Außerdem dürfte sich ein thermisches Problem ergeben wenn man Hotspots übereinander klebt.Mir stellt sich gerade die Frage (da ich deine "unten gespielt"-Beschreibung anfangs missverstanden habe), ob es eigentlich möglich wäre, 2 QuadCores "übereinander" zu bauen...sprich, 2 "dicke" Schichten die je einen QC darstellen übereinander. Wäre das anbindungstechnisch überhaupt realisierbar?

Zum Nahelem: ich könnte mir vorstellen, dass es zwei mal 4 MB sind, die aber allen Kernen zur Verfügung stehen. Ähnlich wie beim POWER 5 (?), der hatte 3x 512 KB L2 Cache. Das sollte ähnliche Vorteile bringen wie bei AMD die AUfteilung des Speichercontrollers von 1x128 Bit zu 2x64 Bit.

Opteron

Redaktion

☆☆☆☆☆☆

@opteron

http://www.anandtech.com/IT/showdoc.aspx?i=2727&p=5

Der Niagara 1 hat bei 1GHz ein L2-Latenz von 22 Zyklen

Schaut man sich hier die Grafiken an, dann sieht man wie weit der L3-Cache hinterher hinkt:

http://www.techreport.com/articles.x/13176/3

Vom Opteron zum Barcelona wurde der L2-Zugriff langsamer, von 12 auf 16 Zyklen

Der L3-Cache-Zugriff liegt irgendwo bei 40 Zyklen.

Der Conroe benötigt 14 Zyklen, ein großer Teil der Performance des Conroe rührt daher, dass er sehr sehr schnell auf 4MB L2-Cache zugreifen kann - bricht dieser Vorteil weg bricht so einiges weg.

Und natürlich ist mir klar das Nehalem SMT hat, allerdings kann ich mir nicht vorstellen das man Single-Thread-Performance zurückstellt um dafür Durchsatz zu steigern.

Grüße,

Tom

- Niagara 1 ist in 90nm hergestellt .. schon mal überlegt, wie sich ein Strukturshrink auf 45nm auf die Latenzen auswirken würde ?

- Opterons L3 ist langsam ja, aber das kann sich AMD leisten, da sie ja extra L2 haben, der fällt bei Intel weg, also wären sie auf alle Fälle schneller als AMDs L3

- Conroe hat den Cache auch "geteilt", eine Häfte ist unter einem Core, die andre unter dem andren Core .. ist es deswegen 2x2 MB .. Nein ..

- Durch das SMT haben sie auf alle Fälle eine Grund mehr nicht brachial auf Single-thread zu optimieren. Prozessordesign ist immer ein Trade-Off Spiel mit ~100 Unbekannten, stellt man an einem Rad was ein was Vorteile mit sich bringt, handelt man sich im Umkehrschluss Nachteile woanders ein. SMT verschiebt das Ganze eindeutig in Richtung Durchsatz, wenn auch nicht in dem Maße wie Suns T2

Abgesehen davon ist 2009 die single thread performance sicherlich nicht mehr so interessant.

- Zuguterletzt hat Intel schon immer den shared L2 Cache Ansatz verfolgt, würde mich sehr wundern wenn sie auf einmal davon abweichen würden. So oder so kann mans dadurch zwar nicht 100% ausschließen, aber da verlasse ich mich auch gerne auf Hiroshige Goto, der war bisher immer richtig gelegen, und er spricht von einem *shared* Cache. Ich bleib deswegen dabei, das sind 8 MB unified Cache, aufgeteilt in 4 Bänke á 2 MB, die grünen Rechtecke sind Write-Back Buffer wie bei Sun.

Edit: Noch ein Bild (Erkennen tut man zwar nichts, aber man sieht den Chip und hat nen Größenvergleich):

Quelle:

http://pc.watch.impress.co.jp/docs/2007/0919/idf01.htm

ciao

Alex

P.S: Die Skull Trail boards sind auch verrückt, 4 FBD Steckplätze insgesamt, d.h. 1 Steckplatz *pro* channel ^^

Zuletzt bearbeitet:

G

gast_003

Guest

Wenn ich es richtig in Erinnerung habe und beim K10 ein Kern auch auf den L2 Cache eines anderen Kernes zugreifen kann, dann hat demzufolge der K10 auch 2MB shared L2 Cache?

Ragas

Grand Admiral Special

- Mitglied seit

- 24.05.2005

- Beiträge

- 4.470

- Renomée

- 85

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 3800+ @2520MHz; 1,4V; 53°C

- Mainboard

- Asus A8N-E

- Kühlung

- Thermaltake Sonic Tower (doppelt belüftet)

- Speicher

- 4x Infineon DDR400 512MB @207MHz

- Grafikprozessor

- Nvidia GeForce FX 7800GT

- Display

- 1.: 24", Samsung SyncMaster 2443BW, 1920x1200 TFT 2.: 19", Schneider, 1280x1024 CRT

- HDD

- Seagate Sata1 200GB 7200rpm, 2x250GB Seagate SATA2 im Raid0

- Optisches Laufwerk

- DVDBrenner LG GSA 4167

- Soundkarte

- Creative X-Fi Extreme Music

- Gehäuse

- Thermaltake Soprano Silber

- Netzteil

- Be-quiet! Darkpower 470W

- Betriebssystem

- Windows XP; Linux Mandriva 2007.1 (Kernel: 2.6.22.2 Ragas-Edition :D )

- Webbrowser

- Firefox

- Verschiedenes

- -Lüftersteuerung: Aerogate3

ne die können schneller daten untereinander austauschen, da ein direkter linkt zwischen ihnen besteht, trotzdem kann ein Kern nicht in den Chace des anderen schreiben.Wenn ich es richtig in Erinnerung habe und beim K10 ein Kern auch auf den L2 Cache eines anderen Kernes zugreifen kann, dann hat demzufolge der K10 auch 2MB shared L2 Cache?

chrisihamm

Lieutnant

Der L3 Cache des Barcelonas hat keine 40ns sondrn liegt im Bereich von ca 20ns.

mfg

mfg

rkinet

Grand Admiral Special

und: http://www.anandtech.com/cpuchipsets/intel/showdoc.aspx?i=3101&p=2Hier noch eine Newsmeldung dazu:

http://www.computerbase.de/news/hardware/prozessoren/intel/2007/september/idf_intel_nehalem_aktion/

Der Nehalem startet mit 2 Cores und 4 Threads und kann mit int. GPU versehen werden.

Dies könnte dann dieser 4 Thread-Core werden mit int. Memory-Controller, der dann ca. 125-150mm2 große DIEs ergäbe (Penryn 107 mm2 (Page 10 http://www.intel.com/pressroom/kits/events/idffall_2007/BriefingSmith45nm.pdf ) / 2-Core Nehalem ca. 100mm2).

Intel spricht von 'a significant improvement in entry-level graphics performance' ( http://www.anandtech.com/cpuchipsets/intel/showdoc.aspx?i=3101&p=5 ) was vielleicht statt +$5 je Chipsatz heute $20-$30 für Intel bedeuten könnte. So etwas wird Intel sicherlich anpeilen, denn die Nutzung rel. teurer und noch nicht abgeschriebener Technik (heute werden die int. GPUs bei Intel noch in 90nm hergestellt) muß auch mehr Geld einbringen.

'Entry-level' ist sicherlich auch die Zielgruppe bei Fusion und mehr Geld erhält AMD dafür auch bestimmt nicht.

Opteron

Redaktion

☆☆☆☆☆☆

Hmmm also davor muss AMD keine Angst haben ... SSE5 soll die AES Leistung verfünffachen ( und die Leistung dabei sollte im Moment beim Intel/AMD Vergleich gleich sein), und für die Finanzleute hat AMD Torrenza:Neue Befehle gibts auch.

http://www.thetradenews.com/operations-technology/market-data/749

Ich find ehrlich gesagt dämlich, dass Intel sowas Spezielles in den Chip einbaut. Was will der Otto Normal Anwender mit den schöden Finanzfunkionen. Sollte da in Zukunft kein positiver Nebeneffekt bekannt werden, schlag ich Intel schon mal für die goldene "Befehlssatzerweiterungs"- Zitrone vor. Is ja alles ganz gut und nett, aber man kanns auch übertreiben. Das kommt mir eher so vor als würden die bei Intel nach *irgendwas* suchen und wenns auch nur nen 1 Promill Nutzen hat, dann wird es eingebaut. Da reicht das "C" von CISC (steht für Complex) bald nicht mehr aus ..

Wenigstens vergibt Intel für den Witz keine extra Nummer, z.B. SSE6

ciao

Alex

Zuletzt bearbeitet:

larsbo

Grand Admiral Special

- Mitglied seit

- 20.06.2003

- Beiträge

- 5.864

- Renomée

- 62

- Details zu meinem Desktop

- Prozessor

- Ryzen 5 3400G

- Mainboard

- Gigabyte B450I Aorus pro Wifi

- Kühlung

- Noctua NH-L9a

- Speicher

- 32 GB, 2x ADATA 16GB single rank PC4-3200 1,2V (Samsung 16Gbit 2666-Chips)

- Grafikprozessor

- APU

- SSD

- Samsung 970Pro 1TB NVMe PCIe3

- Optisches Laufwerk

- Pioneer BD-RE slim-line

- Soundkarte

- on-board

- Gehäuse

- SilverStone ML08-H

- Netzteil

- Corsair SF450 (80PlusGold)

- Betriebssystem

- Win10pro 64

Schon was bekannt geworden zu internen Optimierungen? Insbesondere bessere 64bit-Leistung wäre wichtig für Intel. Also MicroOp-Fusion auch in 64bit z.B.

Ragas

Grand Admiral Special

- Mitglied seit

- 24.05.2005

- Beiträge

- 4.470

- Renomée

- 85

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 3800+ @2520MHz; 1,4V; 53°C

- Mainboard

- Asus A8N-E

- Kühlung

- Thermaltake Sonic Tower (doppelt belüftet)

- Speicher

- 4x Infineon DDR400 512MB @207MHz

- Grafikprozessor

- Nvidia GeForce FX 7800GT

- Display

- 1.: 24", Samsung SyncMaster 2443BW, 1920x1200 TFT 2.: 19", Schneider, 1280x1024 CRT

- HDD

- Seagate Sata1 200GB 7200rpm, 2x250GB Seagate SATA2 im Raid0

- Optisches Laufwerk

- DVDBrenner LG GSA 4167

- Soundkarte

- Creative X-Fi Extreme Music

- Gehäuse

- Thermaltake Soprano Silber

- Netzteil

- Be-quiet! Darkpower 470W

- Betriebssystem

- Windows XP; Linux Mandriva 2007.1 (Kernel: 2.6.22.2 Ragas-Edition :D )

- Webbrowser

- Firefox

- Verschiedenes

- -Lüftersteuerung: Aerogate3

"Befehlssatzerweiterungs"- Zitrone vor. Is ja alles ganz gut und nett, aber man kanns auch übertreiben. Das kommt mir eher so vor als würden die bei Intel nach *irgendwas* suchen und wenns auch nur nen 1 Promill Nutzen hat, dann wird es eingebaut. Da reicht das "C" von CISC (steht für Complex) bald nicht mehr aus ..

Ich bin für OCISC O für "overloaded".

mocad_tom

Admiral Special

- Mitglied seit

- 17.06.2004

- Beiträge

- 1.234

- Renomée

- 52

@crisihamm

40 Taktzyklen sind bei 2GHz 20ns

@opteron

>Niagara 1 ist in 90nm hergestellt .. schon mal überlegt, wie sich ein Strukturshrink

>auf 45nm auf die Latenzen auswirken würde

Warum wirkt sich ein shrink nicht, oder nur selten auf die Latenz aus? Weil man den Takt anheben will. Der 130nm Opteron hatte 13 Takte Latenz, der 90nm 12 Takte und der 65nm wieder 13.

Bei 2GHz dauert ein Takt 0.5ns. Nimmt man an, Elektronen reisen mit annähernder Lichtgeschwindigkeit, dann reist ein Elekton während eines Takts maximal 1,4m.

Hier etwas, das noch einigermassen verständlich geschrieben ist. Der ganze Stoff ist schon harter Tobak, dafür das man sich nur hobbymässig damit beschäftigt:

http://www.anandtech.com/showdoc.aspx?i=2379&p=10

Und hier noch härter:

http://www.realworldtech.com/page.cfm?ArticleID=RWT072405191325&p=6

Ich gebe zu, ich habe diese Zusammenhänge selbst nicht alle verstanden, aber soviel weiß ich: Will man einen Multi-Port-L2-Cache quer über einen Riesen-Die hinweg ansprechen, so kostet dies Latenzen.

Latenzen heisst, es sind zuviele Schaltvorgänge während eines Taktzyklus notwendig, also teilt man es in mehrere Stufen auf, das sogenannte Pipelining, was für die Ausführungseinheiten gilt, gilt genauso auch für Cache.

Diese FO4-Einheit hört man selten, wenn sie aber auftaucht, dann wirds komplex.

Grüße, Tom

40 Taktzyklen sind bei 2GHz 20ns

@opteron

>Niagara 1 ist in 90nm hergestellt .. schon mal überlegt, wie sich ein Strukturshrink

>auf 45nm auf die Latenzen auswirken würde

Warum wirkt sich ein shrink nicht, oder nur selten auf die Latenz aus? Weil man den Takt anheben will. Der 130nm Opteron hatte 13 Takte Latenz, der 90nm 12 Takte und der 65nm wieder 13.

Bei 2GHz dauert ein Takt 0.5ns. Nimmt man an, Elektronen reisen mit annähernder Lichtgeschwindigkeit, dann reist ein Elekton während eines Takts maximal 1,4m.

Hier etwas, das noch einigermassen verständlich geschrieben ist. Der ganze Stoff ist schon harter Tobak, dafür das man sich nur hobbymässig damit beschäftigt:

http://www.anandtech.com/showdoc.aspx?i=2379&p=10

Und hier noch härter:

http://www.realworldtech.com/page.cfm?ArticleID=RWT072405191325&p=6

Ich gebe zu, ich habe diese Zusammenhänge selbst nicht alle verstanden, aber soviel weiß ich: Will man einen Multi-Port-L2-Cache quer über einen Riesen-Die hinweg ansprechen, so kostet dies Latenzen.

Latenzen heisst, es sind zuviele Schaltvorgänge während eines Taktzyklus notwendig, also teilt man es in mehrere Stufen auf, das sogenannte Pipelining, was für die Ausführungseinheiten gilt, gilt genauso auch für Cache.

Diese FO4-Einheit hört man selten, wenn sie aber auftaucht, dann wirds komplex.

Grüße, Tom

Zuletzt bearbeitet:

Opteron

Redaktion

☆☆☆☆☆☆

Da reden wir aneinander vorbei, ich wollte auf die effektiven Nanosekunden raus. Die 22 Takte sind bei 3 Ghz halt n bisschen weniger Sekunden als bei 1,4 und bei steigender CacheGröße steigt auch automatisch die Zugriffszeit (war ja z.B. bei AMD die Begründung, dass der L2 langsamer in 65nm langsamer wurde), d.h. Pi*Daumen könnten 22 Takte für nen 8 MB L2 nicht mal schlecht sein.@opteron

>Niagara 1 ist in 90nm hergestellt .. schon mal überlegt, wie sich ein Strukturshrink

>auf 45nm auf die Latenzen auswirken würde

Warum wirkt sich ein shrink nicht, oder nur selten auf die Latenz aus? Weil man den Takt anheben will. Der 130nm Opteron hatte 13 Takte Latenz, der 90nm 12 Takte und der 65nm wieder 13.

Naja ist halt nur ne "praktische" Zeiteinheit ... was Du bei dem Cell Beispiel aber siehst (und Sun treibt das beim T2 ja auf die Spitze), es gibt unterschiedliche Taktregionen, und die Caches liegen bei IBM in der "Fast-Area".Hier etwas, das noch einigermassen verständlich geschrieben ist. Der ganze Stoff ist schon harter Tobak, dafür das man sich nur hobbymässig damit beschäftigt:

http://www.anandtech.com/showdoc.aspx?i=2379&p=10

Und hier noch härter:

http://www.realworldtech.com/page.cfm?ArticleID=RWT072405191325&p=6

Ich gebe zu, ich habe diese Zusammenhänge selbst nicht alle verstanden, aber soviel weiß ich: Will man einen Multi-Port-L2-Cache quer über einen Riesen-Die hinweg ansprechen, so kostet dies Latenzen.

Latenzen heisst, es sind zuviele Schaltvorgänge während eines Taktzyklus notwendig, also teilt man es in mehrere Stufen auf, das sogenannte Pipelining, was für die Ausführungseinheiten gilt, gilt genauso auch für Cache.

Diese FO4-Einheit hört man selten, wenn sie aber auftaucht, dann wirds komplex.

So oder so ... wir wissen nur, dass wir nix wissen, und 1 Intel Ingenieur ist sicherlich schlauer als die ganze P3D Leserschaft. Ich vertrau mal auf deren Expertise, die wissen schon was sie machen.

Mein Überzeugung ist nachwievor, dass das ein shared L2 ist, Du bist andrer Meinung, tja .. warten wir ein Jahr, weiterdiskutieren hat nicht mehr viel Sinn

ciao

Alex

G

gast_003

Guest

ich sage nachwievor das ich vermute das es ich dabei um 2 shared caches handelt, welche höchstens noch über die crossbar miteinander verbunden sind.

Warscheinlich steckt da sogar zusätzlich noch eine Priorisierung drin (ein Kern hab beim naheliegensten Teil des Cache Speichers die höchste Priorität bei den zugriffen), damit sich die Kerne nicht dauernd in die quere kommen. 8)

Warscheinlich steckt da sogar zusätzlich noch eine Priorisierung drin (ein Kern hab beim naheliegensten Teil des Cache Speichers die höchste Priorität bei den zugriffen), damit sich die Kerne nicht dauernd in die quere kommen. 8)

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 1K

- Antworten

- 78

- Aufrufe

- 14K

- Antworten

- 2

- Aufrufe

- 3K

- Antworten

- 0

- Aufrufe

- 1K

- Antworten

- 0

- Aufrufe

- 1K