App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Bulldozer - AMD Fam 15h - allgemeiner Infothread

- Ersteller Opteron

- Erstellt am

Zwen

Grand Admiral Special

- Mitglied seit

- 06.01.2002

- Beiträge

- 7.122

- Renomée

- 24

- Details zu meinem Desktop

- Prozessor

- eine elektronische Schaltung, die Befehle ausführt

- Mainboard

- die zentrale Platine eines Computers

- Kühlung

- damit wird thermische Energie entzogen

- Speicher

- speichert auszuführenden Programme oder Programmteile

- Grafikprozessor

- wandelt Daten um, dass der Monitor sie als Bild wiedergeben kann

- Display

- Ausgabegerät zur Darstellung von visueller Information

- HDD

- Speichermedium, gewährleistet nichtflüchtige Speicherung

- Optisches Laufwerk

- ermöglicht den Zugriff auf optische Datenträger

- Soundkarte

- verarbeitet analoge und digitale Audiosignale

- Gehäuse

- eine feste Hülle die den Inhalt schützend umgibt

- Netzteil

- Baugruppe zur Energieversorgung

- Betriebssystem

- Sammlung von Computerprogrammen

- Webbrowser

- Software zur Darstellung von Webseiten

- Verschiedenes

- was nicht in das Kategorienschema passt

Wieso ist das eine komische Sache? TDP ist nicht gleich Stromverbrauch (Umwandlung), TDP = thermische Verlustleistung.Stromverbrauch ist auch so eine komische Sache ...

Bei CPUs ist eine TDP von >100 Watt störend,

bei GPUs stört sich niemand an einer TDP von 250 Watt und mehr.

Dabei befinden sich CPUs in der Regel im Idle Modus wo sie nur einen Bruchteil der TDP verbrauchen.

Und aktuell 125W TDP (FX 4M) sind sehr wohl relevant, wenn die CPU oft unter hohen workloads steht.

Bei der GPU stören hohe TDPs ebenso, wie bei der CPU und eine doch recht schnelle HD 7850 hat weniger als-wie 125W TDP.

Zuletzt bearbeitet:

boxleitnerb

Vice Admiral Special

- Mitglied seit

- 27.01.2008

- Beiträge

- 517

- Renomée

- 5

Die GPUs leisten aber auch entsprechend was. Hier wird die Leistung alle 2 Jahre verdoppelt, das muss irgendwoher kommen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.406

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Unter anderem von einer fast stetig steigenden TDP?

Bei den CPUs ist sie eher stagnierend bis fallend.

Bei den CPUs ist sie eher stagnierend bis fallend.

boxleitnerb

Vice Admiral Special

- Mitglied seit

- 27.01.2008

- Beiträge

- 517

- Renomée

- 5

Bei gleicher TDP wären immer noch 60-70% drin, mehr als bei den CPUs. Die TDP wird jetzt mMn auch erstmal konstant bleiben bei den GPUs.

Zwen

Grand Admiral Special

- Mitglied seit

- 06.01.2002

- Beiträge

- 7.122

- Renomée

- 24

- Details zu meinem Desktop

- Prozessor

- eine elektronische Schaltung, die Befehle ausführt

- Mainboard

- die zentrale Platine eines Computers

- Kühlung

- damit wird thermische Energie entzogen

- Speicher

- speichert auszuführenden Programme oder Programmteile

- Grafikprozessor

- wandelt Daten um, dass der Monitor sie als Bild wiedergeben kann

- Display

- Ausgabegerät zur Darstellung von visueller Information

- HDD

- Speichermedium, gewährleistet nichtflüchtige Speicherung

- Optisches Laufwerk

- ermöglicht den Zugriff auf optische Datenträger

- Soundkarte

- verarbeitet analoge und digitale Audiosignale

- Gehäuse

- eine feste Hülle die den Inhalt schützend umgibt

- Netzteil

- Baugruppe zur Energieversorgung

- Betriebssystem

- Sammlung von Computerprogrammen

- Webbrowser

- Software zur Darstellung von Webseiten

- Verschiedenes

- was nicht in das Kategorienschema passt

Nur ist die TDP bei AMD-Grafikkarten eben nicht steigend, sondern fallend, bei steigender Leistung und weniger Energiebedarf.

Und auch aus diesem Grund kommen jene Grafikkarten so gut bei der Kundschaft an, weil... logisch?

Und auch aus diesem Grund kommen jene Grafikkarten so gut bei der Kundschaft an, weil... logisch?

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.406

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das wurde bei den Doppelkarten auch vermutet aber oh Wunder....als die single GPU Karten in den Bereich oberhalb der 225W Grenze vordrangen durften die Doppelwopper auch mehr als 300W fressen.

Der begrenzende Faktor durfte eher die Lautstärke des Kühlers sein allerdings gibt es bei den Custom Designs auch schon 3 Slot Kühler.....

Der begrenzende Faktor durfte eher die Lautstärke des Kühlers sein allerdings gibt es bei den Custom Designs auch schon 3 Slot Kühler.....

LoRDxRaVeN

Grand Admiral Special

- Mitglied seit

- 20.01.2009

- Beiträge

- 4.169

- Renomée

- 64

- Standort

- Oberösterreich - Studium in Wien

- Mein Laptop

- Lenovo Thinkpad Edge 11

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 955 C3

- Mainboard

- Gigabyte GA-MA790X-DS4

- Kühlung

- Xigmatek Thor's Hammer + Enermax Twister Lüfter

- Speicher

- 4 x 1GB DDR2-800 Samsung

- Grafikprozessor

- Sapphire HD4870 512MB mit Referenzkühler

- Display

- 22'' Samung SyncMaster 2233BW 1680x1050

- HDD

- Hitachi Deskstar 250GB, Western Digital Caviar Green EADS 1TB

- Optisches Laufwerk

- Plextor PX-130A, Plextor Px-716SA

- Soundkarte

- onboard

- Gehäuse

- Aspire

- Netzteil

- Enermax PRO82+ II 425W ATX 2.3

- Betriebssystem

- Windows 7 Professional Studentenversion

- Webbrowser

- Firefox siebenunddreißigsttausend

- Schau Dir das System auf sysprofile.de an

Kannst du das bitte etwas genauer ausführen.TDP ist nicht gleich Stromverbrauch (Umwandlung), TDP = thermische Verlustleistung.

LG

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

Auch nicht richtig. Mal schaun, ob ich es etwas besser hinbekomme.TDP ist nicht gleich Stromverbrauch (Umwandlung), TDP = thermische Verlustleistung.

TDP = Termal Design Power

War bei AMD die theoretisch maximal auftretende Wärmeenergie, also der Verbrauch bei dem alle Einheiten des Prozessors ihren maximalen Verbrauch haben. Praktisch war die auftretende Wärmemenge selbst bei Vollast geringer. Und diese abzuführende Wärme ist gleichzusetzen mit der verbrauchten elektrischen Leistung, da diese letztendlich in Wärme umgewandelt wird.

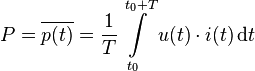

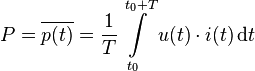

P = U * I grob gesagt. http://de.wikipedia.org/wiki/Elektrische_Leistung

Da Intel jedoch TDP anders definierte, nämlich als Verbrauch bei Vollast des Prozessors, konnte Intel bei gleichem praktischem Verbrauch eine geringere TDP für ihre Prozessoren angeben.

Daher führte AMD mit den Opterons die ACP ( Average CPU Power ) ein, die den Verbrauch der CPU bei einem bestimmten Bench angibt und damit dem realem maximalem Verbrauch der CPU nahe kommt.

http://www.amd.com/us/Documents/43761C_ACP_WP_EE.pdf

Also ACP < TDP Intel < TDP AMD.

In dem PDF ist ein schöner Vergleich mit einem Tachometer eines Autos angegeben.

Würde Intel und AMD Autos bauen die beide 100km/h schnell wären, hätte der Intel Wagen einen Tacho, der maximal 120 auf dem Zifferblatt hat, und AMD hätte maximal 160 auf dem Tacho angegeben.

Der ACP Tacheo hätte maximal 100km/h drauf und manchmal geht die Nadel auch kurz drüber hinaus.

Zudem gibt es dann noch die TDP Klassen.

Typisch für Desktop sind 45W, 65W, 95W, 100W, 125W, 150W

Jeder Prozessor verhält sich etwas anders und Verbraucht mehr oder weniger. Um das ganze etwas zu vereinfachen, werden die Prozessoren in diese Klassen unterteilt. Bei einem Prozessor mit 95W TDP Angabe kann der Prozessor irgendwas zwischen 65W TDP und 95W TDP haben. Real kann also ein 95W TDP Prozessor durchaus mit 60W Verbrauch unter Volllast auskommen.

Ich weiß nicht, ob die Hersteller ihre Definitionen die letzten Jahre geändert haben und daher aktuell diese Darstellung so nicht mehr gültig ist.

LoRDxRaVeN

Grand Admiral Special

- Mitglied seit

- 20.01.2009

- Beiträge

- 4.169

- Renomée

- 64

- Standort

- Oberösterreich - Studium in Wien

- Mein Laptop

- Lenovo Thinkpad Edge 11

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 955 C3

- Mainboard

- Gigabyte GA-MA790X-DS4

- Kühlung

- Xigmatek Thor's Hammer + Enermax Twister Lüfter

- Speicher

- 4 x 1GB DDR2-800 Samsung

- Grafikprozessor

- Sapphire HD4870 512MB mit Referenzkühler

- Display

- 22'' Samung SyncMaster 2233BW 1680x1050

- HDD

- Hitachi Deskstar 250GB, Western Digital Caviar Green EADS 1TB

- Optisches Laufwerk

- Plextor PX-130A, Plextor Px-716SA

- Soundkarte

- onboard

- Gehäuse

- Aspire

- Netzteil

- Enermax PRO82+ II 425W ATX 2.3

- Betriebssystem

- Windows 7 Professional Studentenversion

- Webbrowser

- Firefox siebenunddreißigsttausend

- Schau Dir das System auf sysprofile.de an

Diese Geschichte gibt es auch schon ewig. Aber ich habe auch (in den letzten Jahren) nie einen Test gesehen, wo ein Intel Prozessor - trotz "Powerviren" seine TDP überschritten hätte, oder AMD immer deutlich unter ihrer TDP geblieben wäre (bei Topmodelle) (auch bei Powerviren schalten ja nicht alle Transistoren).

Also mag das vll. mal so gewesen sein, aber seit Bulldozer bzw. (All-Core-)Turbo-Core mit "Messung der tatsächlichen Leistungsaufnahme" gilt dies mMn nicht mehr.

TDP Intel < TDP AMD.

Also mag das vll. mal so gewesen sein, aber seit Bulldozer bzw. (All-Core-)Turbo-Core mit "Messung der tatsächlichen Leistungsaufnahme" gilt dies mMn nicht mehr.

Zwen

Grand Admiral Special

- Mitglied seit

- 06.01.2002

- Beiträge

- 7.122

- Renomée

- 24

- Details zu meinem Desktop

- Prozessor

- eine elektronische Schaltung, die Befehle ausführt

- Mainboard

- die zentrale Platine eines Computers

- Kühlung

- damit wird thermische Energie entzogen

- Speicher

- speichert auszuführenden Programme oder Programmteile

- Grafikprozessor

- wandelt Daten um, dass der Monitor sie als Bild wiedergeben kann

- Display

- Ausgabegerät zur Darstellung von visueller Information

- HDD

- Speichermedium, gewährleistet nichtflüchtige Speicherung

- Optisches Laufwerk

- ermöglicht den Zugriff auf optische Datenträger

- Soundkarte

- verarbeitet analoge und digitale Audiosignale

- Gehäuse

- eine feste Hülle die den Inhalt schützend umgibt

- Netzteil

- Baugruppe zur Energieversorgung

- Betriebssystem

- Sammlung von Computerprogrammen

- Webbrowser

- Software zur Darstellung von Webseiten

- Verschiedenes

- was nicht in das Kategorienschema passt

@amdfanuwe

Was? Ich verstehe deinen Beitrag nicht, TDP ist nicht gleichzusetzen mit dem maximal anfallenden Energiebedarf!

"refers to the maximum amount of power the cooling system in a computer is required to dissipate" (P=CV²f)

Was? Ich verstehe deinen Beitrag nicht, TDP ist nicht gleichzusetzen mit dem maximal anfallenden Energiebedarf!

"refers to the maximum amount of power the cooling system in a computer is required to dissipate" (P=CV²f)

LoRDxRaVeN

Grand Admiral Special

- Mitglied seit

- 20.01.2009

- Beiträge

- 4.169

- Renomée

- 64

- Standort

- Oberösterreich - Studium in Wien

- Mein Laptop

- Lenovo Thinkpad Edge 11

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 955 C3

- Mainboard

- Gigabyte GA-MA790X-DS4

- Kühlung

- Xigmatek Thor's Hammer + Enermax Twister Lüfter

- Speicher

- 4 x 1GB DDR2-800 Samsung

- Grafikprozessor

- Sapphire HD4870 512MB mit Referenzkühler

- Display

- 22'' Samung SyncMaster 2233BW 1680x1050

- HDD

- Hitachi Deskstar 250GB, Western Digital Caviar Green EADS 1TB

- Optisches Laufwerk

- Plextor PX-130A, Plextor Px-716SA

- Soundkarte

- onboard

- Gehäuse

- Aspire

- Netzteil

- Enermax PRO82+ II 425W ATX 2.3

- Betriebssystem

- Windows 7 Professional Studentenversion

- Webbrowser

- Firefox siebenunddreißigsttausend

- Schau Dir das System auf sysprofile.de an

@Zwen

Wie ich schon gesagt habe: Dann erklär' doch mal, was du denkst, wie es ist...

Wie ich schon gesagt habe: Dann erklär' doch mal, was du denkst, wie es ist...

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

Jup, TDP, Termal Design Power, ist die Leistung, für die das Kühlsystem ausgelegt sein muß.

Früher war damit sichergestellt, dass ein Prozessor unter theoretisch maximaler Leistung nicht mehr Verbraucht. Wie Opteron anmerkt, nutzt AMD jetzt die Trägheit der Wärmeleitung aus und gestattet einen kurzfristigen höheren Verbrauch.

P = CV²f = UI = I²R = U²/R = ...

gilt alles nur für Spezialfälle.

Wenn wirs genauer wollen:

AMD definiert jetzt die TDP anscheinend über einen definierten Zeitraum wodurch ein kurzfristig höherer Verbrauch nicht zum überschreiten der TDP führen sollte. Meine auch gelesen zu haben, dass Intel auch kurzfristige Peaks hat. War mir dieser Sachen aber nicht sicher, weshalb ich es nicht erwähnte.

Wie bei der Microwelle: 5 sekunden 900W/h, 5 sekunden aus ergibt ein Wärmeäquivalent von 450W/h über 10 Sekunden.

P = CV²f = UI = I²R = U²/R = ...

gilt alles nur für Spezialfälle.

Wenn wirs genauer wollen:

AMD definiert jetzt die TDP anscheinend über einen definierten Zeitraum wodurch ein kurzfristig höherer Verbrauch nicht zum überschreiten der TDP führen sollte. Meine auch gelesen zu haben, dass Intel auch kurzfristige Peaks hat. War mir dieser Sachen aber nicht sicher, weshalb ich es nicht erwähnte.

Wie bei der Microwelle: 5 sekunden 900W/h, 5 sekunden aus ergibt ein Wärmeäquivalent von 450W/h über 10 Sekunden.

Dresdenboy

Redaktion

☆☆☆☆☆☆

Falls die Regelung interessiert, sucht doch mal in der Google-Bildersuche nach

.tomshardware "power consumption" graph

Dr@

Grand Admiral Special

- Mitglied seit

- 19.05.2009

- Beiträge

- 12.791

- Renomée

- 4.066

- Standort

- Baden-Württemberg

- Aktuelle Projekte

- Collatz Conjecture

- Meine Systeme

- Zacate E-350 APU

- BOINC-Statistiken

- Mein Laptop

- FSC Lifebook S2110, HP Pavilion dm3-1010eg

- Details zu meinem Laptop

- Prozessor

- Turion 64 MT37, Neo X2 L335, E-350

- Mainboard

- E35M1-I DELUXE

- Speicher

- 2x1 GiB DDR-333, 2x2 GiB DDR2-800, 2x2 GiB DDR3-1333

- Grafikprozessor

- RADEON XPRESS 200m, HD 3200, HD 4330, HD 6310

- Display

- 13,3", 13,3" , Dell UltraSharp U2311H

- HDD

- 100 GB, 320 GB, 120 GB +500 GB

- Optisches Laufwerk

- DVD-Brenner

- Betriebssystem

- WinXP SP3, Vista SP2, Win7 SP1 64-bit

- Webbrowser

- Firefox 13

von einer kurzfristigen Überschreitung der TDP kann im HPC-Modus (wenn er denn funktioniert, wie er soll) ja wohl nicht gesprochen werden. Da wird der P-state festgeklemmt egal wie viel die Kiste zieht. Erst wenn das Teil zu heiß wird, kommt es zu einer Drosselung.

Die Opterons mit einer "TDP" von 140 Watt können dann gut und gern 165 Watt reale Leistungsaufnahme haben.

Die Opterons mit einer "TDP" von 140 Watt können dann gut und gern 165 Watt reale Leistungsaufnahme haben.

Markus Everson

Grand Admiral Special

Kann mir mal jemand verraten wie und von wem der HPC-Modus definiert ist?

Dr@

Grand Admiral Special

- Mitglied seit

- 19.05.2009

- Beiträge

- 12.791

- Renomée

- 4.066

- Standort

- Baden-Württemberg

- Aktuelle Projekte

- Collatz Conjecture

- Meine Systeme

- Zacate E-350 APU

- BOINC-Statistiken

- Mein Laptop

- FSC Lifebook S2110, HP Pavilion dm3-1010eg

- Details zu meinem Laptop

- Prozessor

- Turion 64 MT37, Neo X2 L335, E-350

- Mainboard

- E35M1-I DELUXE

- Speicher

- 2x1 GiB DDR-333, 2x2 GiB DDR2-800, 2x2 GiB DDR3-1333

- Grafikprozessor

- RADEON XPRESS 200m, HD 3200, HD 4330, HD 6310

- Display

- 13,3", 13,3" , Dell UltraSharp U2311H

- HDD

- 100 GB, 320 GB, 120 GB +500 GB

- Optisches Laufwerk

- DVD-Brenner

- Betriebssystem

- WinXP SP3, Vista SP2, Win7 SP1 64-bit

- Webbrowser

- Firefox 13

Es gibt von AMD keine offiziell einsehbare Dokumentation dazu. Hier im Thread wurde ober schon die Präsentation von einer HPC-Konferenz (von Opteron) verlinkt, wo ein Angestellter von AMD darauf eingegangen ist.Kann mir mal jemand verraten wie und von wem der HPC-Modus definiert ist?

Meine Anfrage dazu bei AMD läuft schon eine ganze Weile. Genauere Infos gab es bisher nicht.

http://www.youtube.com/watch?v=myIUMnRtPnM

http://www.hpcadvisorycouncil.com/events/2012/European-Workshop/Presentations/12_AMD.pdf

insbesonder Folie 19

boxleitnerb

Vice Admiral Special

- Mitglied seit

- 27.01.2008

- Beiträge

- 517

- Renomée

- 5

Nur ist die TDP bei AMD-Grafikkarten eben nicht steigend, sondern fallend, bei steigender Leistung und weniger Energiebedarf.

Und auch aus diesem Grund kommen jene Grafikkarten so gut bei der Kundschaft an, weil... logisch?

Fallend? 5870, 6970, 7970 GE...der Verbrauch hat sich da in etwa verdoppelt, der Vorteil zu Fermi-Zeiten ist komplett dahin.

Was ich eigentlich meinte, unabhängig von Nvidia oder AMD:

Was Perf/W angeht, legen Grafikkarten seit Jahren mehr zu als CPUs. Nimm ein bestimmtes TDP-Budget und schau mal an, was in den letzten 10 Jahren die CPUs und die GPUs damit angestellt haben. Ist auch logisch, denn Grafikkarten sind eben immer noch spezialisierte Beschleuniger im Gegensatz zu CPUs.

ONE_FOR_ALL

Lieutnant

- Mitglied seit

- 22.11.2009

- Beiträge

- 62

- Renomée

- 0

Bei jedem Spiel das du aufgezählt hast Friert sich mein 8350 in den Tod .Aber ich ich bin voll wie ein Eimer und deswegen brennt das alte Fieber was mich glauben macht ,ich bin 18 Jahre alt.Und doof wie Stulle .Fallend? 5870, 6970, 7970 GE...der Verbrauch hat sich da in etwa verdoppelt, der Vorteil zu Fermi-Zeiten ist komplett dahin.

Was ich eigentlich meinte, unabhängig von Nvidia oder AMD:

Was Perf/W angeht, legen Grafikkarten seit Jahren mehr zu als CPUs. Nimm ein bestimmtes TDP-Budget und schau mal an, was in den letzten 10 Jahren die CPUs und die GPUs damit angestellt haben. Ist auch logisch, denn Grafikkarten sind eben immer noch spezialisierte Beschleuniger im Gegensatz zu CPUs.

boxleitnerb

Vice Admiral Special

- Mitglied seit

- 27.01.2008

- Beiträge

- 517

- Renomée

- 5

Und jetzt lesen wir nochmal meinen Post gaaaanz gründlich

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Hallo Dr,Es gibt von AMD keine offiziell einsehbare Dokumentation dazu. Hier im Thread wurde ober schon die Präsentation von einer HPC-Konferenz (von Opteron) verlinkt, wo ein Angestellter von AMD darauf eingegangen ist.

Meine Anfrage dazu bei AMD läuft schon eine ganze Weile. Genauere Infos gab es bisher nicht.

http://www.youtube.com/watch?v=myIUMnRtPnM

http://www.hpcadvisorycouncil.com/events/2012/European-Workshop/Presentations/12_AMD.pdf

insbesonder Folie 19

auf der Developer Seite liegt was im Archive:

http://developer.amd.com/resources/archive/hpc-zone/

@Dresdenboy

Welchen "Power consumption graph" meinst du, den mit 2s Intervall?

Dr@

Grand Admiral Special

- Mitglied seit

- 19.05.2009

- Beiträge

- 12.791

- Renomée

- 4.066

- Standort

- Baden-Württemberg

- Aktuelle Projekte

- Collatz Conjecture

- Meine Systeme

- Zacate E-350 APU

- BOINC-Statistiken

- Mein Laptop

- FSC Lifebook S2110, HP Pavilion dm3-1010eg

- Details zu meinem Laptop

- Prozessor

- Turion 64 MT37, Neo X2 L335, E-350

- Mainboard

- E35M1-I DELUXE

- Speicher

- 2x1 GiB DDR-333, 2x2 GiB DDR2-800, 2x2 GiB DDR3-1333

- Grafikprozessor

- RADEON XPRESS 200m, HD 3200, HD 4330, HD 6310

- Display

- 13,3", 13,3" , Dell UltraSharp U2311H

- HDD

- 100 GB, 320 GB, 120 GB +500 GB

- Optisches Laufwerk

- DVD-Brenner

- Betriebssystem

- WinXP SP3, Vista SP2, Win7 SP1 64-bit

- Webbrowser

- Firefox 13

Auf was genau beziehst Du Dich?

Dresdenboy

Redaktion

☆☆☆☆☆☆

Ich fand z.B. diesen hier interessant (mit zusätzlichem Stichwort "trinity", vorher ging es um mehrere CPUs):@Dresdenboy

Welchen "Power consumption graph" meinst du, den mit 2s Intervall?

Die Trinities laufen bis zu einem Peak im Verbrauch hoch und ab da nur noch abwärts. Möglicherweise war entspr. der Konditionen noch ein P-State nutzbar, welcher danach gesperrt wurde (Hysterese).

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Auf die Frage von Markus, wie und wer den HPC Modus definiert hat.Auf was genau beziehst Du Dich?

Das müssen dann wohl die Entwickler von AMD geweßen sein.

Da es inzwischen im Archive gelandet ist, wird es wohl kein gutes Zeichen sein?

Umso merkwürdiger ist es, dass du keine Antwort auf deine Anfage bei AMD bekommst.

@Dresdenboy

Stimmt, woran kann das liegen? (ResonantClockMesh, varibaler CPU-GPU Turbo, dithering)

Ein interessanter Artikel, auch wenn er schon etwas älter ist: http://www.xbitlabs.com/articles/cases/display/system-wattage.html

Bobo_Oberon

Grand Admiral Special

- Mitglied seit

- 18.01.2007

- Beiträge

- 5.045

- Renomée

- 190

Danke!Hallo Dr,

auf der Developer Seite liegt was im Archive:

http://developer.amd.com/resources/archive/hpc-zone/ ...

Auch bei mir hinterlässt das einen bitteren Geschmack, dass AMD High-Performance Tools für die CPUs da hin geschoben hat.

Wird da der Opteron und die Desktop-FXèn als (halb)totes Gaul noch ausgeritten bis es gar nicht mehr geht?

MFG Bobo(2012)

Ähnliche Themen

- Antworten

- 1

- Aufrufe

- 298

- Antworten

- 1

- Aufrufe

- 239

- Antworten

- 1

- Aufrufe

- 503

- Antworten

- 0

- Aufrufe

- 877