App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Mein Einstieg in 10GbE LAN mit SFP+

- Ersteller Hammerhead Shark

- Erstellt am

Hammerhead Shark

Commodore Special

★ Themenstarter ★

- Mitglied seit

- 22.04.2008

- Beiträge

- 450

- Renomée

- 488

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3900X

- Mainboard

- ASUS Prime X570-PRO

- Kühlung

- be quiet Dark Rock Pro 4

- Speicher

- 2x16GB G.Skill Trident Neo 3600 MHz CL16

- Grafikprozessor

- Power Color RX 9070XT Hellhound

- SSD

- Lexar NM790 4TB; XPG SX8200 PRO 1TB

- Optisches Laufwerk

- LG GGW-H20L

- Gehäuse

- Thermaltake Xaser VI

- Netzteil

- Be Quiet Dark Power 13 - 850W

- Betriebssystem

- openSUSE Tumbleweed; Windows 10 Pro

- Webbrowser

- Firefox

Inspiriert von erattes Erfahrungsbericht über seinen Einstieg in das 2,5 GbE LAN teile ich hier meine Erfahrungen mit 10GbE, und warum ich mich für SFP+ entschieden habe.

Nachdem ich meinen neuen Heimserver endlich Fertiggestellt hatte, sollte auch das alte 1G Netzwerk aufgerüstet werden, damit der neue Speicherplatz auch effektiv ausgenutzt werden kann. Trotz des hohen Einstiegpreises reizte es mich, zumindest Hauptrechner und Server über eine 10Gb Leitung zu verbinden.

Nach etwas Recherche und der Suche nach der passenden Hardware habe ich mich für SFP+ für die Realisierung der 10G Verbindung entschieden.

Der Anschaffungspreis für Netzwerkkarten und Switches gegenüber RJ45 ist bei 10G auf ähnlichem Niveau, häufig sogar etwas günstiger.

Der große Vorteil von SFP ist der sehr geringe Stromverbrauch bei Verwendung von passiven DAC (Direct Attached Copper) Kabeln.

Während RJ45 bei 10G bis zu 3 Watt pro Port ziehen kann (also bis zu 6 Watt pro Verbindung ), sollen es bei passiven DAC Kabeln nur um die 0,2 W sein.

), sollen es bei passiven DAC Kabeln nur um die 0,2 W sein.

Zudem erlaubt SFP+ verschiedene Transceiver zu nutzen, z.B. für optische Kabel. Wobei die Kosten pro Transceiver ja nach Art nicht zu unterschätzen sind und schonmal an die 60€ oder mehr betragen können.

Auch SFP+ zu RJ45 ist möglich, wobei dann allerdings wieder der hohe Stromverbrauch ins Spiel kommt.

DAC Kabel kosten mit 12 bis 16 € für 2m (Länge immer inklusive Transceiver) ungefähr das doppelte von CAT8 Kabeln gleicher Länge, aber bei den Kosten der restlichen Hardware fallen sie auch nicht groß ins Gewicht.

Auch sind sie nicht so robust wie RJ45 Kabel.

Switch:

Beim Switch habe ich mich für den QNAP QSW-2100 entschieden.

Mit 2x 10G SFP+ und 4x 2.5G Ethernet Ports liefert er eine gute und zukunftssichere Anschlussvielfalt, sowie die von mir momentan benötigten 6 Ports.

Zudem gehört er zu den günstigsten Switches mit SFP+ und 2.5G Ports.

Test:

Alternativen wären:

MikroTik Cloud Smart Switch CSS610

ZyXEL XGS1010

Netzwerkkarte:

Als Netzwerkkarten habe ich die Inter-Tech Argus ST-7211 genommen.

Mit ca 55 € ist sie deutlich günstiger als andere 10G PCIe Karten.

Die Karte hat eine PCIe2 x8 Anschluss, wird aber in den beiden Rechnern jeweils in den unteren x4 Slots betrieben.

PCIe2 x4 sind aber immer noch ca 2GB/s an Roh-Bandbreite, was vollkommen ausreichen sollte (außer eventuell für Vollduplex mit max Geschwindigkeit).

Kabel:

2x SFP+ passive DAC Kabel (je 2m)

Geschwindigkeits Test (PC <-> Server):

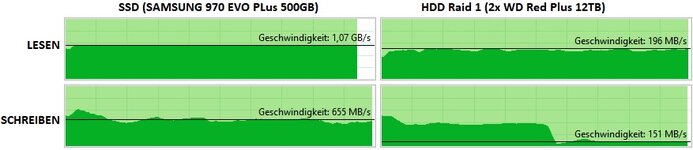

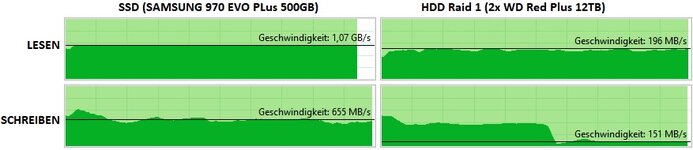

Lesen: Wenn ich auf Daten die auf der SSD liegen zugreife, schaffe ich konstante 1,07 GB/s. Beim Raid 1 sind es 180 bis 210 MB/s.

Schreiben: Beim schreiben über das Netzwerk auf die SSD sind es zwischen 600 und 750 MB/s. Beim Schreiben auf das Festplatten Raid sind über einen gewissen Zeitraum über 600 MB/s möglich, bevor er sich bei ca 150 MB/s einpendelt. Vermutlich kommt hier der Schreibcache der Festplatten zum Tragen. Für caching im RAM zu langsam und ich habe auch noch keinen SSD Cache eingerichtet.

getestet wurde mit einer ca. 20GB großen mkv Datei.

Ich werde die Tage eventuell mal noch ein paar Benchmark Tools laufen lassen und die Ergebnisse dann hier präsentieren.

Fürs Erste bin ich jedenfalls sehr zufrieden mit der Leistung

Nachdem ich meinen neuen Heimserver endlich Fertiggestellt hatte, sollte auch das alte 1G Netzwerk aufgerüstet werden, damit der neue Speicherplatz auch effektiv ausgenutzt werden kann. Trotz des hohen Einstiegpreises reizte es mich, zumindest Hauptrechner und Server über eine 10Gb Leitung zu verbinden.

Nach etwas Recherche und der Suche nach der passenden Hardware habe ich mich für SFP+ für die Realisierung der 10G Verbindung entschieden.

Der Anschaffungspreis für Netzwerkkarten und Switches gegenüber RJ45 ist bei 10G auf ähnlichem Niveau, häufig sogar etwas günstiger.

Der große Vorteil von SFP ist der sehr geringe Stromverbrauch bei Verwendung von passiven DAC (Direct Attached Copper) Kabeln.

Während RJ45 bei 10G bis zu 3 Watt pro Port ziehen kann (also bis zu 6 Watt pro Verbindung

Zudem erlaubt SFP+ verschiedene Transceiver zu nutzen, z.B. für optische Kabel. Wobei die Kosten pro Transceiver ja nach Art nicht zu unterschätzen sind und schonmal an die 60€ oder mehr betragen können.

Auch SFP+ zu RJ45 ist möglich, wobei dann allerdings wieder der hohe Stromverbrauch ins Spiel kommt.

DAC Kabel kosten mit 12 bis 16 € für 2m (Länge immer inklusive Transceiver) ungefähr das doppelte von CAT8 Kabeln gleicher Länge, aber bei den Kosten der restlichen Hardware fallen sie auch nicht groß ins Gewicht.

Auch sind sie nicht so robust wie RJ45 Kabel.

Switch:

Beim Switch habe ich mich für den QNAP QSW-2100 entschieden.

Mit 2x 10G SFP+ und 4x 2.5G Ethernet Ports liefert er eine gute und zukunftssichere Anschlussvielfalt, sowie die von mir momentan benötigten 6 Ports.

Zudem gehört er zu den günstigsten Switches mit SFP+ und 2.5G Ports.

Test:

Alternativen wären:

MikroTik Cloud Smart Switch CSS610

- 2 SFP+ 10G

- 8 RJ45 1G

- managed !

ZyXEL XGS1010

- 2 SFP+ 10g

- 2 RJ45 2.5G

- 8 RJ45 1G

- Test:

- Managed Variante: XGS1250

Netzwerkkarte:

Als Netzwerkkarten habe ich die Inter-Tech Argus ST-7211 genommen.

Mit ca 55 € ist sie deutlich günstiger als andere 10G PCIe Karten.

Die Karte hat eine PCIe2 x8 Anschluss, wird aber in den beiden Rechnern jeweils in den unteren x4 Slots betrieben.

PCIe2 x4 sind aber immer noch ca 2GB/s an Roh-Bandbreite, was vollkommen ausreichen sollte (außer eventuell für Vollduplex mit max Geschwindigkeit).

Kabel:

2x SFP+ passive DAC Kabel (je 2m)

Geschwindigkeits Test (PC <-> Server):

Lesen: Wenn ich auf Daten die auf der SSD liegen zugreife, schaffe ich konstante 1,07 GB/s. Beim Raid 1 sind es 180 bis 210 MB/s.

Schreiben: Beim schreiben über das Netzwerk auf die SSD sind es zwischen 600 und 750 MB/s. Beim Schreiben auf das Festplatten Raid sind über einen gewissen Zeitraum über 600 MB/s möglich, bevor er sich bei ca 150 MB/s einpendelt. Vermutlich kommt hier der Schreibcache der Festplatten zum Tragen. Für caching im RAM zu langsam und ich habe auch noch keinen SSD Cache eingerichtet.

getestet wurde mit einer ca. 20GB großen mkv Datei.

Ich werde die Tage eventuell mal noch ein paar Benchmark Tools laufen lassen und die Ergebnisse dann hier präsentieren.

Fürs Erste bin ich jedenfalls sehr zufrieden mit der Leistung

Zuletzt bearbeitet:

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 24.369

- Renomée

- 3.742

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- HP EliteBook 865 G9 / ASUS ZenBook 14X OLED UM5401RA-L7024W

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 9950X3D

- Mainboard

- ASUS ROG Crosshair X870E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 9100 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server: ASUS Falchion

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server: Rival 300

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. ASUS Delta S Wirelesss Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Ich wärme den Thread noch mal auf da ich einen ähnlichen Schritt gemacht habe aber ich hatte diesen Thread übersehen und meine Erfahrungen in meinem Server Tagebuch gepostet.

Der Basteltrieb war stark und als Idee hatte ich die Netzbandbreite zu meinen Server zu erhöhen.

Ausgangspunkt war 2,5 GB Lan auf Basis von 2 Switchen:

Switch 1:

geizhals.de

geizhals.de

Switch 2:

geizhals.de

geizhals.de

Switche mit Port 8 vom Zyxel und Port 1 vom QNAP mit 2,5 GB Bandbreite verbunden, Bandbreite zum Server 2,5 GB Onboard Realtek auf Port 2 vom Zyxel.

Endstand (die Zwischenschritte verursacht durch die Fehlereingrenzung spare ich mir hier)

Netzwerkkarte im Server:

geizhals.de

geizhals.de

Switch 1:

geizhals.de

geizhals.de

Switch 2:

geizhals.de

geizhals.de

Server hängt mit der LAN Karte und einem 10m 10Gtek AOC Kabel am SFP+ Port 9 mit 10g (Porteinstellung am Zyxel auf SFP+)

Switche sind verbunden mit SFP+ Port 10 vom Zyxel (Porteinstellung am Zyxel auf DAC10G) mit 3m 10GTek DAC Kabel zu TRENDnet SFP+ Port 9

Ohne die Einstellung auf DAC10G für den Port 10 am Zyxel gab es keinen Link.

Damit Bandbreite zum Server 10G und und ebenso 10G zwischen den Switchen. Einen anderen Rechner mit 10G habe ich also nicht, die meisten haben schon 2,5 GB auf dem Mainboard.

Hauptzielmedium ist die NM790 NVMe SSD im Server, auf der SATA SSD liegen nur Mediendateien.

Gleichzeitiges Schreiben und Lesen mit NASTester von 2 Rechner zeigt das sie da auch beide ihre mögliche 2,5 Bandbreite

ausreizen können. Auch mit iperf3 zu gleichen Zeit.

Das heist ich kann hier nun mit ca 3 Rechnern gleichzeitig Backups, Images, VMs starten, Daten kopieren etc ohne da sie sich da in das Gehege kommen.

Probleme die dabei aufgetreten sind und zu erst nicht gelöst werden konnten weil nichts zum gegentesten vorhanden waren:

Digitus 10m DAC Kabel funktioniert nicht - mit keinem Switch. Das war aber erst klar nach dem ich andere Kabel und einen anderen Switch zum testen hatte.

Dazu hatte ich mir ein 10Gtek 0,5m DAC Kabel und das 10m 10GTek AOC Kabel gekauft und den folgenden Switch:

geizhals.de

geizhals.de

Chinaware für 68 € damals - der funktioniert wen es wen intressiert einwandfrei so wie der Zyxel jetzt auch. Liegt nun als Ersatz in der Schublade.

Kritisieren kann man das die LINK Leds der SFP+ Ports unglücklich unten sind und damit nicht sichtbar im Desktopbetrieb weil von den SFP+ Kabel verdeckt und das keine Füßchen zum aufkleben mit dabei sind. Er bietet noch einen Schalter für VLAN oder Link Aggreation. Aktuell liegt er bei 79.99 €.

Der Basteltrieb wollte aber gerne erstmalig einen managedbaren Switch weswegen es noch der Zyxel geworden ist.

Da muss ich mich noch mit den vielen Möglichkeiten beschäftigen.

Inbetriebnahme war problemlos:

- Switch an das LAN

- hat sich IP vom DHCP gezogen

- IP ermittelt und per Browser drauf

- Adminpasswort und SMNTP geändert

- feste IP gesetzt

- neuste Firmware aufgespielt (man kann zwischen 2 Firmware switchen)

- Nebula Cloud nicht eingerichtet und deaktiviert sonst blinkt immer eine LED (die Nebula Cloud von Zyxel will ich nicht nutzen)

- Switche getauscht und alles angeschlossen

- SFP+ Port 10 von SFP+ auf DAC10G gestellt da sonst kein LINK zwischen den Switchen

- Zeit angepasst.

Dann mal alle Clients angemacht und geschaut ob es wie erwartet passt. Zu mehr Spielereien war keine Zeit bisher.

Zweites Problem war mit der LAN Karte im Server, ich hatte das vorher auf einem baugleichen Mainboard in einem Testrechner ausprobiert - mit Installation der neuste Firmeware und Treiber direkt von Marvell - OS ist Window 11. Alles ok.

Im Server dann wurde Karte gefunden Treiberinstallation aber nicht erfolgreich und Karte auf Fehler. Wie sich rausstellte ist das Problem das der aktuelle Marvelltreiber mit Windows Server 2019 nicht funktioniert. Der Uralte von der ASUS HP schon und auch ein Neuerer von Stations Driver auch.

Unter dem Strich bin ist damit sehr zufrieden, irgendwann wird es dann weiter gehen mit 10G da Realtek nun mit dem RTL8127 einen 10 Gbe Kontroller am Start hat und dann es vermehrt nach aktuell 5 Gbe auf zukünftigen Mainboards 10 Gbe gibt und nicht auf den Highendplatinen und auch der Markt für LAN Karten dürfet dann aufgemischt werden.

Erste Switche mit nur 10 Gbe und mit RJ45 und SFP+ sind ja auch da und werden dann interessant.

Der Basteltrieb war stark und als Idee hatte ich die Netzbandbreite zu meinen Server zu erhöhen.

Ausgangspunkt war 2,5 GB Lan auf Basis von 2 Switchen:

Switch 1:

Zyxel MG-108 Desktop 2.5G Switch ab € 121,76 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Zyxel MG-108 Desktop 2.5G Switch ✔ Bewertungen ✔ Produktinfo ⇒ Funktion: Switch • Typ: Standalone • Netzwerkanschlüsse: 8x RJ-45 • Geschwindigkeiten: 8x RJ-45 (100/1000… ✔ Switches ✔ Testberichte ✔ Günstig kaufen

Switch 2:

QNAP QSW-1100 Desktop 2.5G Switch, 5x RJ-45 ab € 82,90 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für QNAP QSW-1100 Desktop 2.5G Switch, 5x RJ-45 ✔ Bewertungen ✔ Produktinfo ⇒ Funktion: Switch • Typ: Standalone • Netzwerkanschlüsse: 5x RJ-45 • Geschwindigkeiten: 5x RJ-45 (100/1000… ✔ Switches ✔ Testberichte ✔ Günstig kaufen

Switche mit Port 8 vom Zyxel und Port 1 vom QNAP mit 2,5 GB Bandbreite verbunden, Bandbreite zum Server 2,5 GB Onboard Realtek auf Port 2 vom Zyxel.

Endstand (die Zwischenschritte verursacht durch die Fehlereingrenzung spare ich mir hier)

Netzwerkkarte im Server:

ASUS XG-C100F LAN-Adapter ab € 88,98 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für ASUS XG-C100F LAN-Adapter ✔ Bewertungen ✔ Produktinfo ⇒ Typ: LAN-Adapter • Bauform: 1x PCIe-Karte (wechselbare Blende: full height und low profile Blende im Lief… ✔ Adapter & Hubs ✔ Testberichte ✔ Günstig kaufen

Switch 1:

Zyxel XMG1915-10E Desktop 2.5G Smart Switch ab € 214,19 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Zyxel XMG1915-10E Desktop 2.5G Smart Switch ✔ Produktinfo ⇒ Funktion: Switch • Typ: Standalone • Netzwerkanschlüsse: 8x RJ-45, 2x SFP+ • Geschwindigkeiten: 8x RJ-45 … ✔ Switches ✔ Testberichte ✔ Günstig kaufen

Switch 2:

TRENDnet TEG-S Desktop 2.5G Switch, 8x RJ-45, 1x SFP+ ab € 88,22 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für TRENDnet TEG-S Desktop 2.5G Switch, 8x RJ-45, 1x SFP+ ✔ Produktinfo ⇒ Funktion: Switch • Typ: Standalone • Netzwerkanschlüsse: 8x RJ-45, 1x SFP+ • Geschwindigkeiten: 8x RJ-45 … ✔ Switches ✔ Testberichte ✔ Günstig kaufen

Server hängt mit der LAN Karte und einem 10m 10Gtek AOC Kabel am SFP+ Port 9 mit 10g (Porteinstellung am Zyxel auf SFP+)

Switche sind verbunden mit SFP+ Port 10 vom Zyxel (Porteinstellung am Zyxel auf DAC10G) mit 3m 10GTek DAC Kabel zu TRENDnet SFP+ Port 9

Ohne die Einstellung auf DAC10G für den Port 10 am Zyxel gab es keinen Link.

Damit Bandbreite zum Server 10G und und ebenso 10G zwischen den Switchen. Einen anderen Rechner mit 10G habe ich also nicht, die meisten haben schon 2,5 GB auf dem Mainboard.

Hauptzielmedium ist die NM790 NVMe SSD im Server, auf der SATA SSD liegen nur Mediendateien.

Gleichzeitiges Schreiben und Lesen mit NASTester von 2 Rechner zeigt das sie da auch beide ihre mögliche 2,5 Bandbreite

ausreizen können. Auch mit iperf3 zu gleichen Zeit.

Das heist ich kann hier nun mit ca 3 Rechnern gleichzeitig Backups, Images, VMs starten, Daten kopieren etc ohne da sie sich da in das Gehege kommen.

Probleme die dabei aufgetreten sind und zu erst nicht gelöst werden konnten weil nichts zum gegentesten vorhanden waren:

Digitus 10m DAC Kabel funktioniert nicht - mit keinem Switch. Das war aber erst klar nach dem ich andere Kabel und einen anderen Switch zum testen hatte.

Dazu hatte ich mir ein 10Gtek 0,5m DAC Kabel und das 10m 10GTek AOC Kabel gekauft und den folgenden Switch:

Tenda TEM2000 Desktop 2.5G Switch, 8x RJ-45, 2x SFP+ ab € 79,99 (2025) | Preisvergleich Geizhals Deutschland

✔ Preisvergleich für Tenda TEM2000 Desktop 2.5G Switch, 8x RJ-45, 2x SFP+ ✔ Produktinfo ⇒ Funktion: Switch • Typ: Standalone, Wandmontage • Netzwerkanschlüsse: 8x RJ-45, 2x SFP+ • Geschwindigkeit… ✔ Switches ✔ Testberichte ✔ Günstig kaufen

Chinaware für 68 € damals - der funktioniert wen es wen intressiert einwandfrei so wie der Zyxel jetzt auch. Liegt nun als Ersatz in der Schublade.

Kritisieren kann man das die LINK Leds der SFP+ Ports unglücklich unten sind und damit nicht sichtbar im Desktopbetrieb weil von den SFP+ Kabel verdeckt und das keine Füßchen zum aufkleben mit dabei sind. Er bietet noch einen Schalter für VLAN oder Link Aggreation. Aktuell liegt er bei 79.99 €.

Der Basteltrieb wollte aber gerne erstmalig einen managedbaren Switch weswegen es noch der Zyxel geworden ist.

Da muss ich mich noch mit den vielen Möglichkeiten beschäftigen.

Inbetriebnahme war problemlos:

- Switch an das LAN

- hat sich IP vom DHCP gezogen

- IP ermittelt und per Browser drauf

- Adminpasswort und SMNTP geändert

- feste IP gesetzt

- neuste Firmware aufgespielt (man kann zwischen 2 Firmware switchen)

- Nebula Cloud nicht eingerichtet und deaktiviert sonst blinkt immer eine LED (die Nebula Cloud von Zyxel will ich nicht nutzen)

- Switche getauscht und alles angeschlossen

- SFP+ Port 10 von SFP+ auf DAC10G gestellt da sonst kein LINK zwischen den Switchen

- Zeit angepasst.

Dann mal alle Clients angemacht und geschaut ob es wie erwartet passt. Zu mehr Spielereien war keine Zeit bisher.

Zweites Problem war mit der LAN Karte im Server, ich hatte das vorher auf einem baugleichen Mainboard in einem Testrechner ausprobiert - mit Installation der neuste Firmeware und Treiber direkt von Marvell - OS ist Window 11. Alles ok.

Im Server dann wurde Karte gefunden Treiberinstallation aber nicht erfolgreich und Karte auf Fehler. Wie sich rausstellte ist das Problem das der aktuelle Marvelltreiber mit Windows Server 2019 nicht funktioniert. Der Uralte von der ASUS HP schon und auch ein Neuerer von Stations Driver auch.

Unter dem Strich bin ist damit sehr zufrieden, irgendwann wird es dann weiter gehen mit 10G da Realtek nun mit dem RTL8127 einen 10 Gbe Kontroller am Start hat und dann es vermehrt nach aktuell 5 Gbe auf zukünftigen Mainboards 10 Gbe gibt und nicht auf den Highendplatinen und auch der Markt für LAN Karten dürfet dann aufgemischt werden.

Erste Switche mit nur 10 Gbe und mit RJ45 und SFP+ sind ja auch da und werden dann interessant.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 6

- Aufrufe

- 212

- Antworten

- 4

- Aufrufe

- 820

- Antworten

- 38

- Aufrufe

- 6K

- Antworten

- 12

- Aufrufe

- 3K