App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

R1000 Spekulationsthread

- Ersteller p4z1f1st

- Erstellt am

OBrian

Moderation MBDB, ,

- Mitglied seit

- 16.10.2000

- Beiträge

- 17.032

- Renomée

- 267

- Standort

- NRW

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 940 BE, C2-Stepping (undervolted)

- Mainboard

- Gigabyte GA-MA69G-S3H (BIOS F7)

- Kühlung

- Noctua NH-U12F

- Speicher

- 4 GB DDR2-800 ADATA/OCZ

- Grafikprozessor

- Radeon HD 5850

- Display

- NEC MultiSync 24WMGX³

- SSD

- Samsung 840 Evo 256 GB

- HDD

- WD Caviar Green 2 TB (WD20EARX)

- Optisches Laufwerk

- Samsung SH-S183L

- Soundkarte

- Creative X-Fi EM mit YouP-PAX-Treibern, Headset: Sennheiser PC350

- Gehäuse

- Coolermaster Stacker, 120mm-Lüfter ersetzt durch Scythe S-Flex, zusätzliche Staubfilter

- Netzteil

- BeQuiet 500W PCGH-Edition

- Betriebssystem

- Windows 7 x64

- Webbrowser

- Firefox

- Verschiedenes

- Tastatur: Zowie Celeritas Caseking-Mod (weiße Tasten)

Tja, das ist nun mal kein Wunschkonzert, da kann man noch so viele Roadmaps malen, aber Chiptechnologie ist absolutes technologisches Neuland. Wenn ich eine Textilfabrik aufbaue, dann weiß man was rauskommt, weil da nichts neues dabei ist, man kann bestenfalls hier und da was an Abläufen optimieren, ansonsten ist das ziemlich planbar. Aber bei Chips weiß man erst, ob was überhaupt funktioniert, wenn es tatsächlich funktioniert. Was diese Fabriken heute neu einführen, gab es noch nie, und was sie in einem halben Jahr machen, sollte theoretisch klappen, aber wurde auch noch nie gemacht. Ich will gar nicht wissen, wie oft die Ingenieure da stehen und sich wundern, was alles so geht; das meiste, was die probieren, geht aber nicht.

Also sind das alles keine Verspätungen und Probleme, sondern einfach der normale, unvorhersehbare Lauf des Fortschritts. Es gibt keine Garantie für alle zwei Jahre eine neue Node, es gibt immer nur den Versuch, zur nächsten zu kommen, bevor der Firma das Geld ausgeht, dann muß man weitersehen.

Also sind das alles keine Verspätungen und Probleme, sondern einfach der normale, unvorhersehbare Lauf des Fortschritts. Es gibt keine Garantie für alle zwei Jahre eine neue Node, es gibt immer nur den Versuch, zur nächsten zu kommen, bevor der Firma das Geld ausgeht, dann muß man weitersehen.

Das ist der entscheidende Punkt wo ich Intels größte Stärke sehe. Die gigantischen Ausgaben für F&E mal sehen wie sich GF in dieser Hinsicht entwickeln wird immo überzeugen sich mich nicht wirklich....bevor der Firma das Geld ausgeht, dann muß man weitersehen.

Aber der Konkurrent fertigt auch schon in kleineren Strukturen und das mit den selben Belichtungs-Tools.OBrian schrieb:Also sind das alles keine Verspätungen und Probleme, sondern einfach der normale, unvorhersehbare Lauf des Fortschritts.

p4z1f1st

Grand Admiral Special

- Mitglied seit

- 28.04.2003

- Beiträge

- 9.722

- Renomée

- 81

- Details zu meinem Desktop

- Prozessor

- AMD FX-6300

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- HEATKILLER® CPU Rev3.0 LC + HEATKILLER® GPU-X² 69x0 LT

- Speicher

- 2x 4096 MB G.Skill RipJawsX DDR3-1600 CL7

- Grafikprozessor

- AMD Radeon RX 480 8GB

- Display

- Dell U2312HM

- HDD

- Crucial m4 SSD 256GB

- Optisches Laufwerk

- Sony Optiarc AD-7260S

- Soundkarte

- Creative Labs SB Audigy 2 ZS

- Gehäuse

- Chieftec Scorpio TA-10B-D (BxHxT: 205x660x470mm)

- Netzteil

- Seasonic X-Series X-660

- Betriebssystem

- Microsoft Windows 10 Professional 64bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- Watercool HTF2 Dual + 2x Papst 4412 F/2GL

[Klugscheiß-Modus]Aber der Konkurrent fertigt auch schon in kleineren Strukturen und das mit den selben Belichtungs-Tools.

Wenn, dann mit den GLEICHEN Belichtungs-Tools... sicher nicht mit den SELBEN...

[/Klugscheiß-Modus]

Opteron

Redaktion

☆☆☆☆☆☆

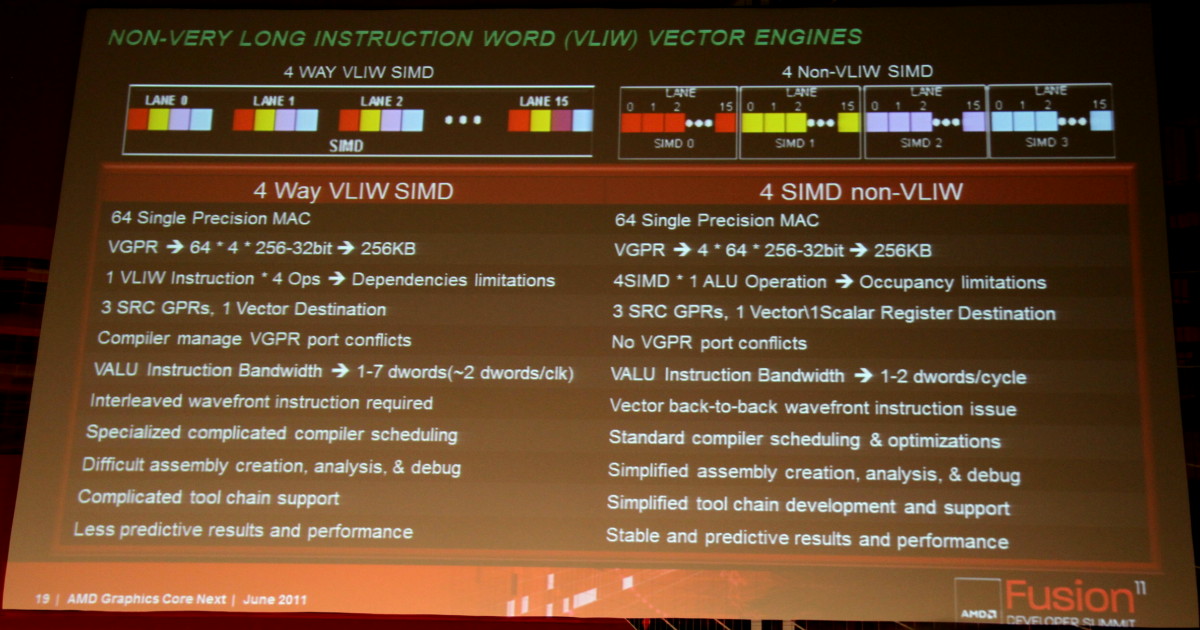

VLIW ist Geschichte:

http://www.planet3dnow.de/vbulletin/showthread.php?t=395675

http://www.planet3dnow.de/vbulletin/showthread.php?t=395675

Zuletzt bearbeitet:

rasmus

Admiral Special

- Mitglied seit

- 07.07.2008

- Beiträge

- 1.191

- Renomée

- 47

- Mein Laptop

- Notebook, was ist das?

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 3600

- Mainboard

- MSI B450M PRO-VDH MAX

- Kühlung

- Luft

- Speicher

- 32 GB Gskill Ripjaws

- Grafikprozessor

- Nvidia 3070 ti FE

- Display

- Asus PB278Q 27" 2560*1440

- SSD

- Ja

- HDD

- auch

- Optisches Laufwerk

- ja

- Soundkarte

- onboard

- Gehäuse

- irgendwas mit glas

- Netzteil

- thermaltake toughpower pf1 750W

- Maus

- Rat 9

- Betriebssystem

- Win 7 64bit, Win 10 64 bit

- Webbrowser

- Firefox

- Verschiedenes

- http://valid.canardpc.com/show_oc.php?id=628058

Das ist ja mal etwas grandios Neues. Das käme dann für die 8000er? Das konnte ich so schnell nicht eruieren.

Opteron

Redaktion

☆☆☆☆☆☆

Das ist ja mal etwas grandios Neues. Das käme dann für die 8000er? Das konnte ich so schnell nicht eruieren.

Habs gerade noch editiert, das sind sogar schon die 7000er, denn Bergmann hat zuvor gemeint, dass die neuen GPU bereits Ende des Jahres erscheinen.

Eventuell machen sie es so wie bei der 6000er Serie. Zuerst einen Mittelklasse VLIW4 Chip als 28nm "Rohrfrei" als 78xx und dann ein dicker "R1000" Chip als HD79xx hinterher.

Zuletzt bearbeitet:

Lynxeye

Admiral Special

- Mitglied seit

- 26.10.2007

- Beiträge

- 1.107

- Renomée

- 60

- Standort

- Sachsen

- Mein Laptop

- Lifebook T1010

- Details zu meinem Desktop

- Prozessor

- AMD FX 8150

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- Zalman Reserator 1 Plus

- Speicher

- 4x8GB DDR3-1600 G.Skill Ripjaws

- Grafikprozessor

- ASUS ENGTX 260

- Display

- 19" AOC LM928 (1280x1024), V7 21" (1680x1050)

- HDD

- Crucial M4 128GB, 500GB WD Caviar 24/7 Edition

- Optisches Laufwerk

- DVD Multibrenner LG GSA-4167B

- Soundkarte

- Creative Audigy 2 ZS

- Gehäuse

- Amacrox Spidertower

- Netzteil

- Enermax Liberty 500W

- Betriebssystem

- Fedora 17

- Webbrowser

- Firefox

- Verschiedenes

- komplett Silent durch passive Wasserkühlug

WOW. Der Bummer des heutigen Tages. Ich hätte nicht damit gerechnet, dass AMD diesen Schritt wagt.

Mit dem alten VLIW Design konnte AMD gegenüber NVidia immer bei der Rohleistung glänzen, jetzt begibt man sich in die selbe Arena wie NV. Vielleicht ist es ja doch einfacher und lohnender immer mehr Hardware auf einen Chip zu packen, als sich ständig Gedanken darüber machen zu müssen, wie man den Compiler immer weiter verbessert. Besonders im Hinblick auf OpenCL wären da bestimmt noch einige harte Nüsse zu knacken gewesen, bevor aus der Rohleistung auch in jedem Fall ordentliche Rechenleistung wird.

Tja, damit wird VLIW wohl für immer ein Ausrutscher in der Geschichte bleiben. AMD ist scheinbar mit der vom R600 geerbten Architektur genauso an der Umsetzung eines funktionieren Compilers für VLIW gescheitert wie Intel damals beim Itanium.

Mit dem alten VLIW Design konnte AMD gegenüber NVidia immer bei der Rohleistung glänzen, jetzt begibt man sich in die selbe Arena wie NV. Vielleicht ist es ja doch einfacher und lohnender immer mehr Hardware auf einen Chip zu packen, als sich ständig Gedanken darüber machen zu müssen, wie man den Compiler immer weiter verbessert. Besonders im Hinblick auf OpenCL wären da bestimmt noch einige harte Nüsse zu knacken gewesen, bevor aus der Rohleistung auch in jedem Fall ordentliche Rechenleistung wird.

Tja, damit wird VLIW wohl für immer ein Ausrutscher in der Geschichte bleiben. AMD ist scheinbar mit der vom R600 geerbten Architektur genauso an der Umsetzung eines funktionieren Compilers für VLIW gescheitert wie Intel damals beim Itanium.

Opteron

Redaktion

☆☆☆☆☆☆

In der Zwischenzeit bis jetzt, fand ich es ganz gut.Tja, damit wird VLIW wohl für immer ein Ausrutscher in der Geschichte bleiben. AMD ist scheinbar mit der vom R600 geerbten Architektur genauso an der Umsetzung eines funktionieren Compilers für VLIW gescheitert wie Intel damals beim Itanium.

Aber jetzt ist wohl der Punkt gekommen, in dem der Compiler zu komplex geworden wäre. Es werden ja immer mehr Shader verbaut, das Problem wurde damit womöglich immer schlimmer.

OBrian

Moderation MBDB, ,

- Mitglied seit

- 16.10.2000

- Beiträge

- 17.032

- Renomée

- 267

- Standort

- NRW

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 940 BE, C2-Stepping (undervolted)

- Mainboard

- Gigabyte GA-MA69G-S3H (BIOS F7)

- Kühlung

- Noctua NH-U12F

- Speicher

- 4 GB DDR2-800 ADATA/OCZ

- Grafikprozessor

- Radeon HD 5850

- Display

- NEC MultiSync 24WMGX³

- SSD

- Samsung 840 Evo 256 GB

- HDD

- WD Caviar Green 2 TB (WD20EARX)

- Optisches Laufwerk

- Samsung SH-S183L

- Soundkarte

- Creative X-Fi EM mit YouP-PAX-Treibern, Headset: Sennheiser PC350

- Gehäuse

- Coolermaster Stacker, 120mm-Lüfter ersetzt durch Scythe S-Flex, zusätzliche Staubfilter

- Netzteil

- BeQuiet 500W PCGH-Edition

- Betriebssystem

- Windows 7 x64

- Webbrowser

- Firefox

- Verschiedenes

- Tastatur: Zowie Celeritas Caseking-Mod (weiße Tasten)

Wahrscheinlich ließ sich die VLIW-Architektur auch nicht so wirklich im Fusion-Konzept verwursten. Das lebt schließlich davon, daß der Programmierer einfach beliebigen Code schreibt und nicht wissen muß, in welchem Teil der APU der ausgeführt wird, gut laufen soll er aber. Ist wohl alles einfacher, wenn die GPU im Aufbau näher an eine CPU heranrückt.

Irgendwie hört sich das so an, als ob das die erste echte AMD-GPU wäre bzw erste AMD-GPU, wo AMDs-CPU-Architektur-Know-How dann von Grund auf bzw. Anfang an bzw. Konzeptional einfließt.

Eines ist mir auch noch eingefallen.

Erste R600-Chips gabs schon im Herbst 2006.

Also, müssten die R600-Entwickler schon Mitte 2006 mit der R600-Architektur fertig sein.

Ob dieses Team dann ein dem obengenannten neuen Architektur begannen? (5 Jahre?) Oder jenes, was mit R770 dann so Anfang 2008 fertig war. (3,5 Jahre?)

Irgendiwe hört es sich so an, als ob AMD diese SIMD viel leichter in eine FPU unter einer FPU-Sheduler neben FMAC anhängen kann als VILW, was dann quais Fusion in Vollendung wäre.

Eines ist mir auch noch eingefallen.

Erste R600-Chips gabs schon im Herbst 2006.

Also, müssten die R600-Entwickler schon Mitte 2006 mit der R600-Architektur fertig sein.

Ob dieses Team dann ein dem obengenannten neuen Architektur begannen? (5 Jahre?) Oder jenes, was mit R770 dann so Anfang 2008 fertig war. (3,5 Jahre?)

Irgendiwe hört es sich so an, als ob AMD diese SIMD viel leichter in eine FPU unter einer FPU-Sheduler neben FMAC anhängen kann als VILW, was dann quais Fusion in Vollendung wäre.

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Tja, damit wird VLIW wohl für immer ein Ausrutscher in der Geschichte bleiben. AMD ist scheinbar mit der vom R600 geerbten Architektur genauso an der Umsetzung eines funktionieren Compilers für VLIW gescheitert wie Intel damals beim Itanium.

Fragt sich dann aber, wozu die aufwändige Weiterentwicklung zu VLIW-4, wenn diese lediglich ein kurzes Zwischenstadium darstellen sollte. War Cayman ein Ausrutscher, ein groß gewordenes Experiment? Oder sind die non-VLIW Pläne eher lang- als mittelfristig einzuordnen, Stichwort "heterogeneous computing"?

Opteron

Redaktion

☆☆☆☆☆☆

Fragt sich dann aber, wozu die aufwändige Weiterentwicklung zu VLIW-4, wenn diese lediglich ein kurzes Zwischenstadium darstellen sollte. War Cayman ein Ausrutscher, ein groß gewordenes Experiment? Oder sind die non-VLIW Pläne eher lang- als mittelfristig einzuordnen, Stichwort "heterogeneous computing"?

Siehe News Meldungsfolie:

Da zählen sie links die Nachteile von VLIW auf:

Komplex, kompliziert, schwierig zu handhaben... klingt nicht besonders gut.

VLIW4 ging schon in die Richtung Vereinfachung, aber hats am Ende dann wohl doch nicht gepackt.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Nicht ganz. Der theoretische Durchsatz pro Compute Unit (vorher SIMD Engine) ist ja der gleiche, 128 FLOPs (32-bit). Nur der Aufbau ist nun anders gestrickt. Das ganze ähnelt mehr Larrabee (512-bit SIMD Pipeline), nur ohne den Hinkefuss x86 und hervorgegangen aus einer richtigen GPU-Architektur anstatt aus P54C Kernen.Mit dem alten VLIW Design konnte AMD gegenüber NVidia immer bei der Rohleistung glänzen, jetzt begibt man sich in die selbe Arena wie NV.

Ich denke, dass es vielmehr eine wichtige Vorstufe für die Non-VLIW Architektur war.Fragt sich dann aber, wozu die aufwändige Weiterentwicklung zu VLIW-4, wenn diese lediglich ein kurzes Zwischenstadium darstellen sollte.

Es sollte klar sein, dass die neue Architektur flexibler agieren kann und einiges vereinfacht. Die Frage, die ich mir stelle, welche Nachteile bringt der Verzicht von VLIW. Weniger FLOPS pro mm²?

Opteron

Redaktion

☆☆☆☆☆☆

Gute Frage, wenn man annimmt, dass die VLIW Effizienz wg des noch komplexeren Compilers noch weiter gesunken wäre, dann nichtmal das.Weniger FLOPS pro mm²?

Lynxeye

Admiral Special

- Mitglied seit

- 26.10.2007

- Beiträge

- 1.107

- Renomée

- 60

- Standort

- Sachsen

- Mein Laptop

- Lifebook T1010

- Details zu meinem Desktop

- Prozessor

- AMD FX 8150

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- Zalman Reserator 1 Plus

- Speicher

- 4x8GB DDR3-1600 G.Skill Ripjaws

- Grafikprozessor

- ASUS ENGTX 260

- Display

- 19" AOC LM928 (1280x1024), V7 21" (1680x1050)

- HDD

- Crucial M4 128GB, 500GB WD Caviar 24/7 Edition

- Optisches Laufwerk

- DVD Multibrenner LG GSA-4167B

- Soundkarte

- Creative Audigy 2 ZS

- Gehäuse

- Amacrox Spidertower

- Netzteil

- Enermax Liberty 500W

- Betriebssystem

- Fedora 17

- Webbrowser

- Firefox

- Verschiedenes

- komplett Silent durch passive Wasserkühlug

Nicht ganz. Der theoretische Durchsatz pro Compute Unit (vorher SIMD Engine) ist ja der gleiche, 128 FLOPs (32-bit). Nur der Aufbau ist nun anders gestrickt. Das ganze ähnelt mehr Larrabee (512-bit SIMD Pipeline), nur ohne den Hinkefuss x86 und hervorgegangen aus einer richtigen GPU-Architektur anstatt aus P54C Kernen.

Auf die Compute Unit gesehen ist das vollkommen richtig, nur wenn ich skalare Einheiten habe, werden diese automatisch komplexer als VLIW Einheiten mit dem selben Durchsatz. In Endeffekt bedeutet dies, das ich weniger dieser Einheiten auf dem Chip unterbringe. Also genau das was NVidia macht: weniger Einheiten mit entsprechend weniger Rohleistung, dafür aber einfach ansteuerbar und deshalb bei den meisten Realworld Anwendungen am Ende schneller.

Es sollte klar sein, dass die neue Architektur flexibler agieren kann und einiges vereinfacht. Die Frage, die ich mir stelle, welche Nachteile bringt der Verzicht von VLIW. Weniger FLOPS pro mm²?

Meiner Meinung nach weniger Roh-FLOPS pro mm². Was hinten für den Anwender raus kommt ist eine andere Frage.

rasmus

Admiral Special

- Mitglied seit

- 07.07.2008

- Beiträge

- 1.191

- Renomée

- 47

- Mein Laptop

- Notebook, was ist das?

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 3600

- Mainboard

- MSI B450M PRO-VDH MAX

- Kühlung

- Luft

- Speicher

- 32 GB Gskill Ripjaws

- Grafikprozessor

- Nvidia 3070 ti FE

- Display

- Asus PB278Q 27" 2560*1440

- SSD

- Ja

- HDD

- auch

- Optisches Laufwerk

- ja

- Soundkarte

- onboard

- Gehäuse

- irgendwas mit glas

- Netzteil

- thermaltake toughpower pf1 750W

- Maus

- Rat 9

- Betriebssystem

- Win 7 64bit, Win 10 64 bit

- Webbrowser

- Firefox

- Verschiedenes

- http://valid.canardpc.com/show_oc.php?id=628058

Also VLIW5 war ja nach seinem Reifeprozeß durchaus sehr erfolgreich. Gescheiterte Umsetzung sieht doch eher anders aus. Nur weil AMD seine CPU Architektur seit Beginn aufgewärmt hat, heißt das ja nicht zwangsläufig, daß man das bei der GPU auch so machen muss. VLIW5/4 war sehr erfolgreich zuletzt, jetzt kann frei nach Law of the Woodscrews dann der AMD Thermi folgen. Ich gehe aber davon aus, daß AMD-F/Thermi seine nukleare Power weniger in der Hitzeabstrahlung als in der GPU Power konzentriert, denn im Gegensatz zur CPU Abteilung waren sie bei den GPUs in letzter Zeit ja eher auf die Füße gefallen als auf den Kopf.

Edit: @7000er schon... das wäre ja der Kracher! Ich hatte angenommen, 6900 gehen mit ein paar Polituren in die 28nm Prod. - Dafür waren sie doch mal gedacht.

Edit: @7000er schon... das wäre ja der Kracher! Ich hatte angenommen, 6900 gehen mit ein paar Polituren in die 28nm Prod. - Dafür waren sie doch mal gedacht.

Zuletzt bearbeitet:

Lepus

Fleet Captain Special

- Mitglied seit

- 14.08.2009

- Beiträge

- 289

- Renomée

- 1

- Standort

- München

- Mein Laptop

- Alienware M17x R4

- Details zu meinem Laptop

- Prozessor

- Intel Core i7-3820M Single Thread @ max 4,1GHz

- Speicher

- 2x4GB Mushkin 1600MHz (ULV)

- Grafikprozessor

- Dell AMD HD 7970M

- Display

- 17,3" FHD

- HDD

- Crucial m4 256Gb mSata

- Optisches Laufwerk

- HL-DT-ST DVDRW/BR-ROM

- Soundkarte

- Creative Sound Blaster Recon 3Di / HM77

- Gehäuse

- Alienware M17x R4

- Netzteil

- Dell 240W

- Betriebssystem

- Windows 8

- Webbrowser

- Opera

Hm, mit dem weniger Flops pro mm² kann ich mich nur anfreunden, wenn wir uns auf die gleiche Strukturbreite einigen. Nun steht aber ein Wechsel zu 28nm an, was wohl auch dieser Baustelle entgegenwirkt. Lassen mer uns mal überraschen. Vllt habens ja gschafft, statt runtertakten einfach nur so viele SIMDs zu aktivieren, wie man brauch, um die momentane Leistung im Idle bereitzustellen. Macht bei mir weniger Leckströme oder bin ich da aufm Irrweg? Beim Llano habens doch auch so ähnlich

Zuletzt bearbeitet:

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Mag sein. Da steht aber explizit, dass es Vektor-ALUs sind, 16 wide SIMD. Eben das, was Intel auch mit Larrabee vorhatte. Das schaut mir nicht nach den skalaren CUDA Kernen von nVidia aus.Auf die Compute Unit gesehen ist das vollkommen richtig, nur wenn ich skalare Einheiten habe, werden diese automatisch komplexer als VLIW Einheiten mit dem selben Durchsatz.

Lynxeye

Admiral Special

- Mitglied seit

- 26.10.2007

- Beiträge

- 1.107

- Renomée

- 60

- Standort

- Sachsen

- Mein Laptop

- Lifebook T1010

- Details zu meinem Desktop

- Prozessor

- AMD FX 8150

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- Zalman Reserator 1 Plus

- Speicher

- 4x8GB DDR3-1600 G.Skill Ripjaws

- Grafikprozessor

- ASUS ENGTX 260

- Display

- 19" AOC LM928 (1280x1024), V7 21" (1680x1050)

- HDD

- Crucial M4 128GB, 500GB WD Caviar 24/7 Edition

- Optisches Laufwerk

- DVD Multibrenner LG GSA-4167B

- Soundkarte

- Creative Audigy 2 ZS

- Gehäuse

- Amacrox Spidertower

- Netzteil

- Enermax Liberty 500W

- Betriebssystem

- Fedora 17

- Webbrowser

- Firefox

- Verschiedenes

- komplett Silent durch passive Wasserkühlug

Mag sein. Da steht aber explizit, dass es Vektor-ALUs sind, 16 wide SIMD. Eben das, was Intel auch mit Larrabee vorhatte. Das schaut mir nicht nach den skalaren CUDA Kernen von nVidia aus.

Und wieder hast du Recht. Allerdings stellt sich mir dann wirklich die Frage, was sich AMD dabei gedacht. Das wäre eine Rolle rückwärts in die Shadertechnologie der GeForce7 / Radeon X1800, wobei natürlich das Umland der Shader, wie der Scheduler seit dieser Zeit viel dazu gelernt haben.

Naja, ich glaube darüber muss ich erst mal schlafen, bevor ich mir ein klares Bild machen kann, was dies genau für die Programmierbarkeit bedeutet. AMD legt damit eindeutig den Fokus auf Vektormaschinen, also weg von immer freierer Programmierbarkeit der Shaderkerne, hin zu den starren Durchsatzmonstern, welche die Idee von der Verwendung der GPU für allgemeine Berechnungen erst aufkeimen ließen.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Interessant ist auch, dass es neben den 4 Vektor ALUs einer Compute Unit auch eine skalare Integer Unit gibt. Für was die gut ist?

Lynxeye

Admiral Special

- Mitglied seit

- 26.10.2007

- Beiträge

- 1.107

- Renomée

- 60

- Standort

- Sachsen

- Mein Laptop

- Lifebook T1010

- Details zu meinem Desktop

- Prozessor

- AMD FX 8150

- Mainboard

- Gigabyte GA-970A-UD3

- Kühlung

- Zalman Reserator 1 Plus

- Speicher

- 4x8GB DDR3-1600 G.Skill Ripjaws

- Grafikprozessor

- ASUS ENGTX 260

- Display

- 19" AOC LM928 (1280x1024), V7 21" (1680x1050)

- HDD

- Crucial M4 128GB, 500GB WD Caviar 24/7 Edition

- Optisches Laufwerk

- DVD Multibrenner LG GSA-4167B

- Soundkarte

- Creative Audigy 2 ZS

- Gehäuse

- Amacrox Spidertower

- Netzteil

- Enermax Liberty 500W

- Betriebssystem

- Fedora 17

- Webbrowser

- Firefox

- Verschiedenes

- komplett Silent durch passive Wasserkühlug

Wahrscheinlich eine Special-Function-Unit, in welche man alle Befehle reinsteckt, die man zwar braucht, welche aber nicht häufig vorkommen (wie etwa RCP, RSQ). Damit hat man bei diesen Befehlen zwar nur noch 1/4 des Durchsatzes, meist brauch man die Ergebnisse dieser SF aber sowieso nur skalar.

An der Stelle wäre schön zu wissen, ob gleichzeitig ein Skalar- und Vektorbefehl ausgeführt werden kann. Nach dem Blockbildchen zu urteilen, wäre dies möglich und würde die Architektur doch wieder mehr von anderen bisher gekannten abheben.

Für mich ist damit zum ersten mal seit Langem eine GPU Architektur wieder wirklich interessant, nachdem uns Jahrelang der selbe Einheitsbrei von wieder aufgegossenen VLIW- oder Skalarrechenwerken präsentiert wurde.

An der Stelle wäre schön zu wissen, ob gleichzeitig ein Skalar- und Vektorbefehl ausgeführt werden kann. Nach dem Blockbildchen zu urteilen, wäre dies möglich und würde die Architektur doch wieder mehr von anderen bisher gekannten abheben.

Für mich ist damit zum ersten mal seit Langem eine GPU Architektur wieder wirklich interessant, nachdem uns Jahrelang der selbe Einheitsbrei von wieder aufgegossenen VLIW- oder Skalarrechenwerken präsentiert wurde.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ich denke dass dies auch für die Kompatibilität von Software von belang ist, welche für APUs entwickelt werden soll. Könnte mir vorstellen dass dies auch der Grund ist für den Wechsel weg von VLIW - das ganze schneller in die Programmierstuben zu transportieren und weniger kompliziert zu machen. Wer weiss wie die GPU mit Nvidia optimierten Spielen umgehtInteressant ist auch, dass es neben den 4 Vektor ALUs einer Compute Unit auch eine skalare Integer Unit gibt. Für was die gut ist?

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Integer? Sollte diese SFU dann nicht auch Gleitkomma sein?Wahrscheinlich eine Special-Function-Unit, in welche man alle Befehle reinsteckt, die man zwar braucht, welche aber nicht häufig vorkommen (wie etwa RCP, RSQ).

Jup, das war echt ein Hammer. Damit hätte ich nicht gerechnet. Schon gar nicht bei Southern Islands.Für mich ist damit zum ersten mal seit Langem eine GPU Architektur wieder wirklich interessant, nachdem uns Jahrelang der selbe Einheitsbrei von wieder aufgegossenen VLIW- oder Skalarrechenwerken präsentiert wurde.

Zuletzt bearbeitet:

Ähnliche Themen

- Antworten

- 17

- Aufrufe

- 2K

- Antworten

- 11

- Aufrufe

- 586

- Antworten

- 13

- Aufrufe

- 925