App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

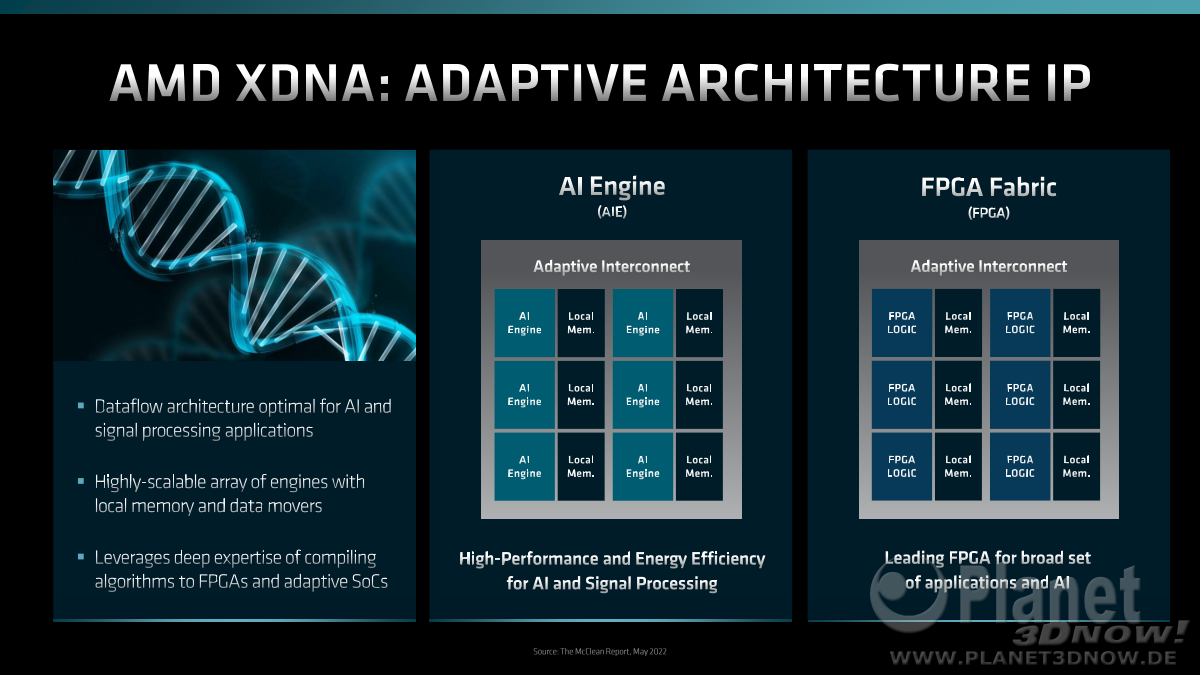

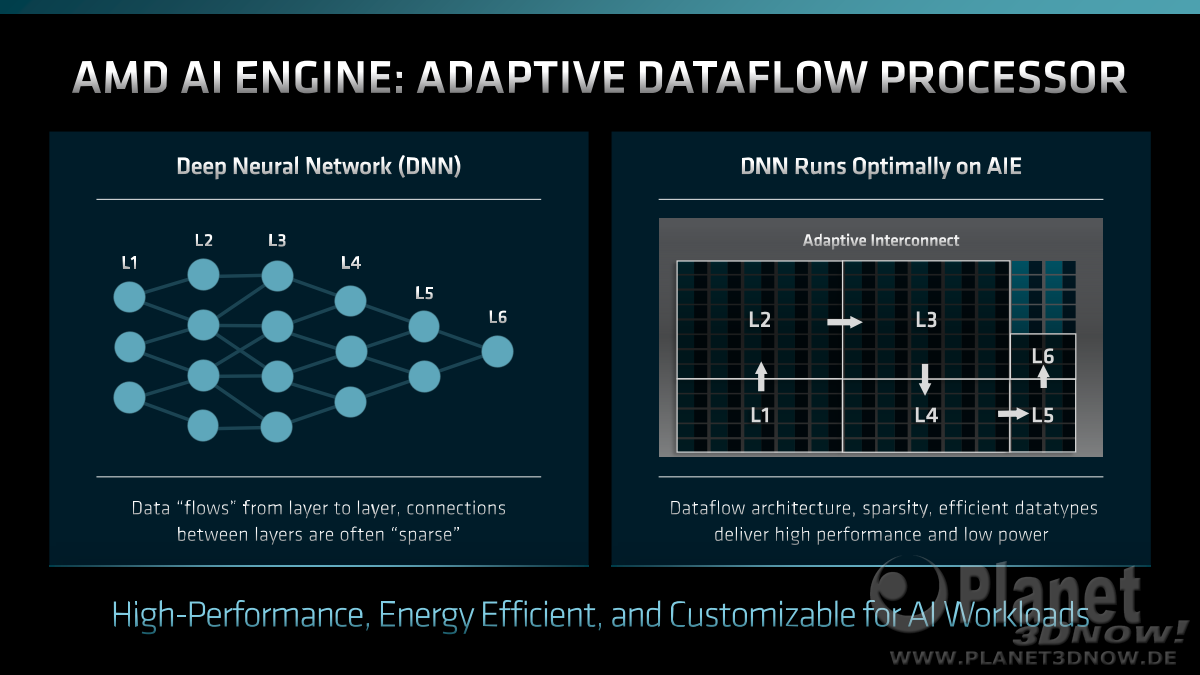

Mit der CES Keynote hat AMD erstmals XDNA als neue Architektur für AI bzw. KI für X86 Prozessoren angekündigt.

Der entsprechende Teil aus der Pressemitteilung zur CES.

Das universelle X steht also künftig für künstliche Intelligenz wie das C in CDNA für Compute und das R in RDNA für Radeon.

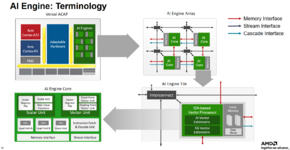

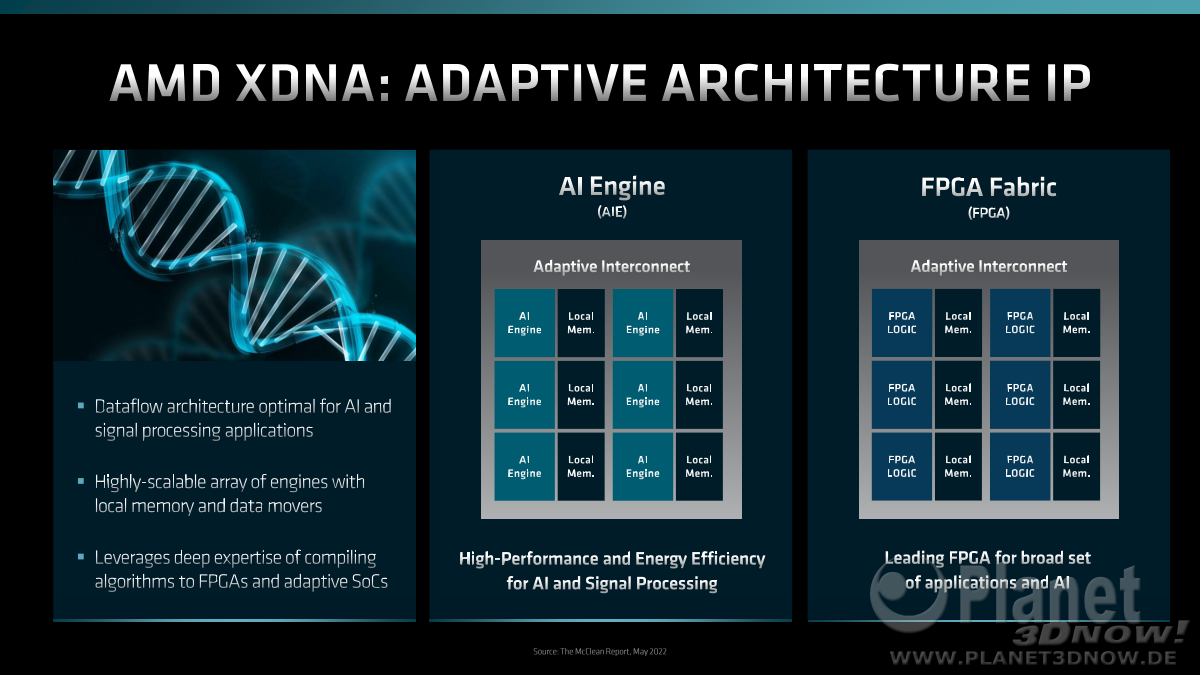

Bereits zum Financial Analyst Day wurde der Terminus XDNA in der Präsentation von Viktor Peng (S.14ff) der Öffentlichkeit präsentiert, allerdings noch vor allem im Kontext mit den Xilinx-Produkten. Das X in XDNA steht deshalb auch für Xilinx.

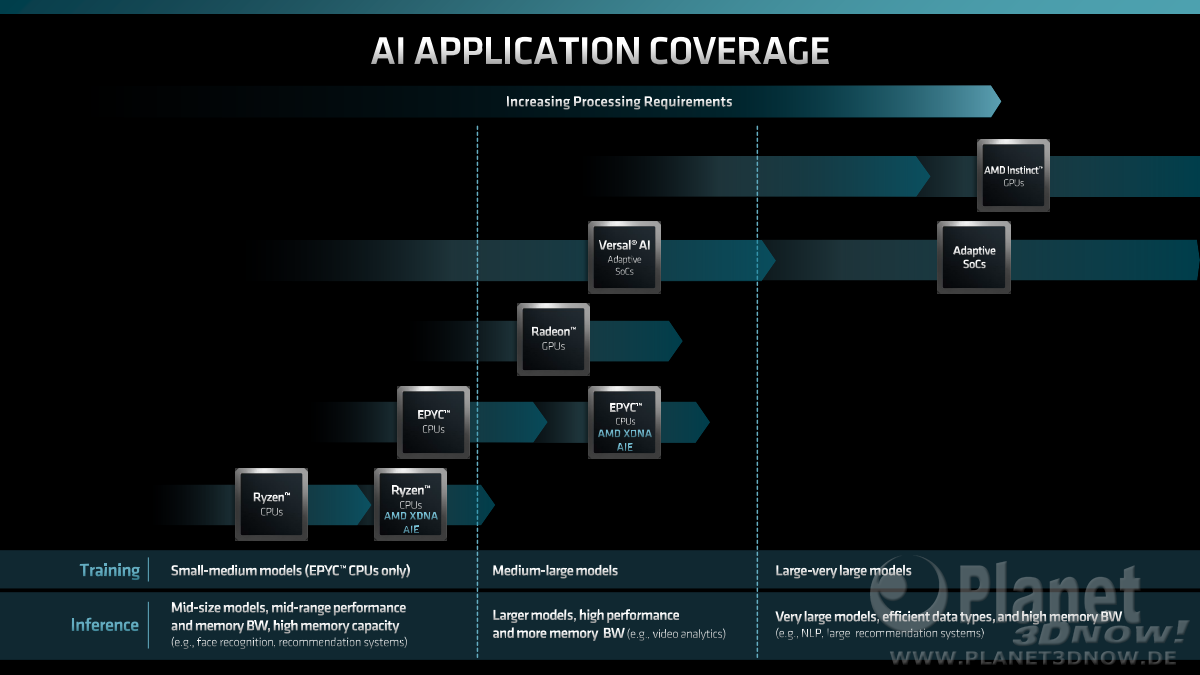

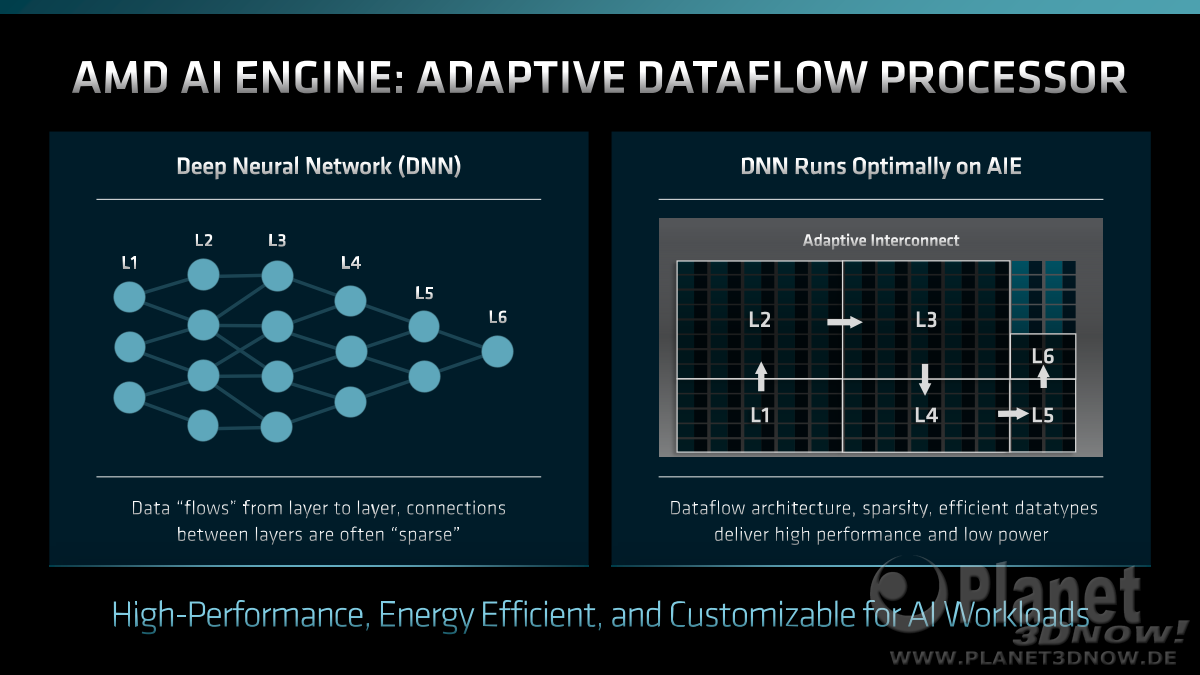

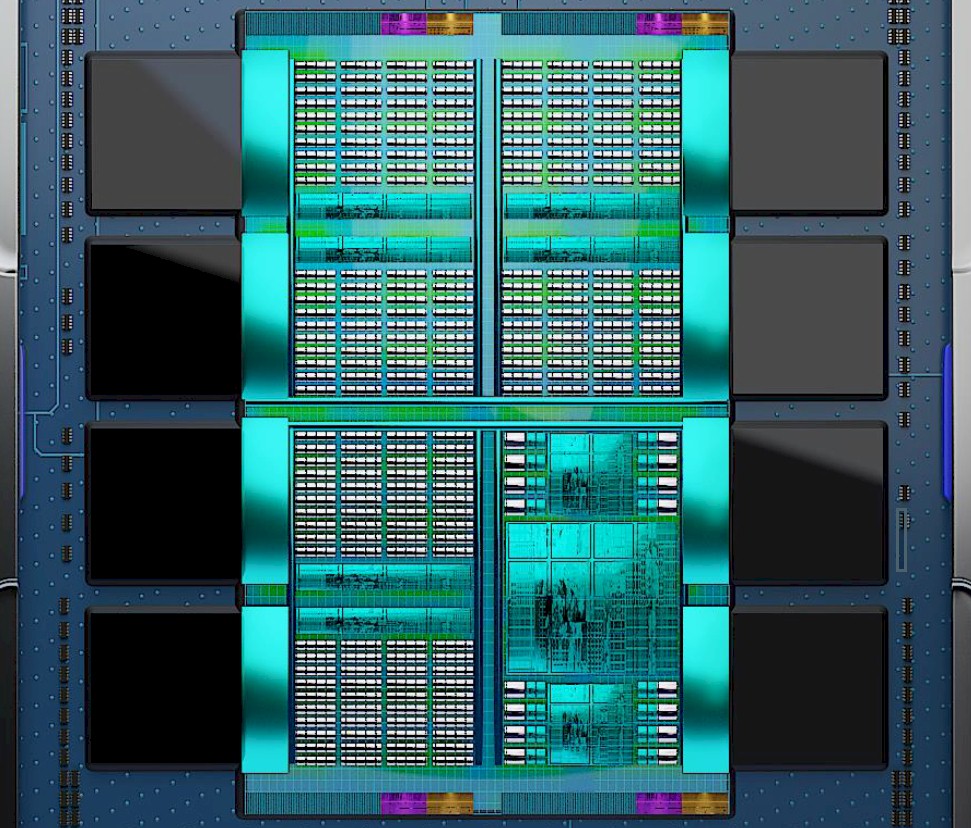

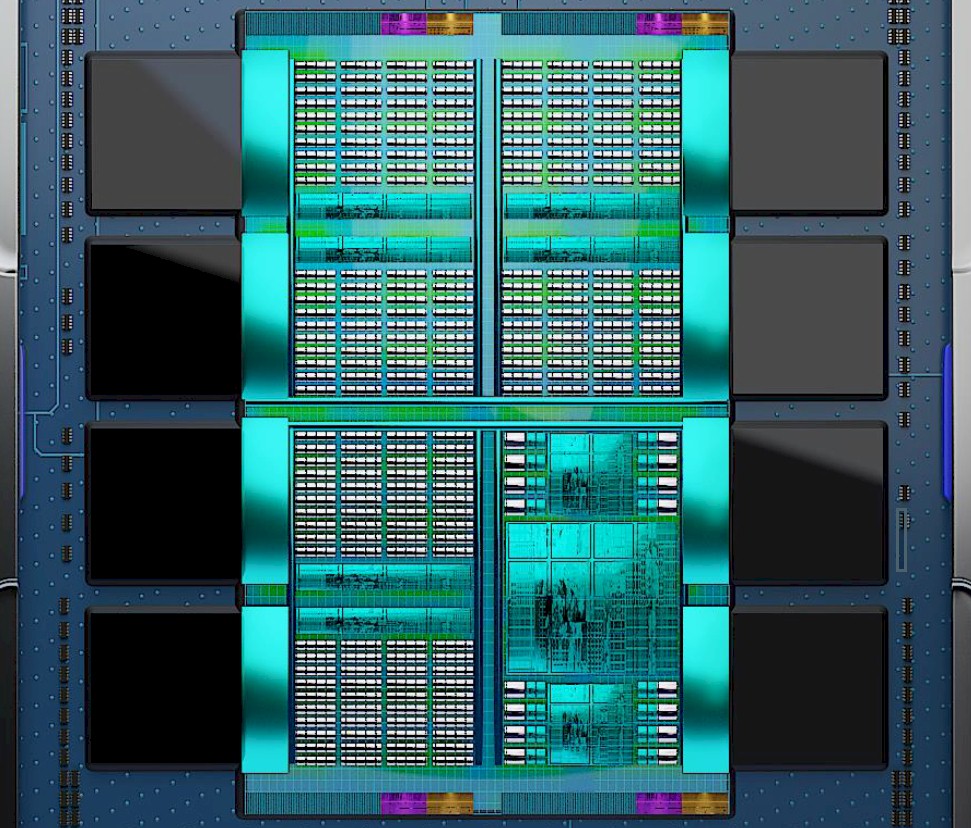

Gemäss einem Artikel von STH handelt es sich um die gleiche Architektur, die in den aktuellen FPGA-Beschleunigern der Versal-Serie genutzt wird. Diese FPGAs werden bei AMD als ACAP (Adaptive Compute Acceleration Platform) bezeichnet. ACAP bezieht dabei neben den AI-Beschleunigern auch die damit integrierten Scalaren Einheiten (z.B. ARM) und programmierbare Netzwerkkomponenten mit ein.

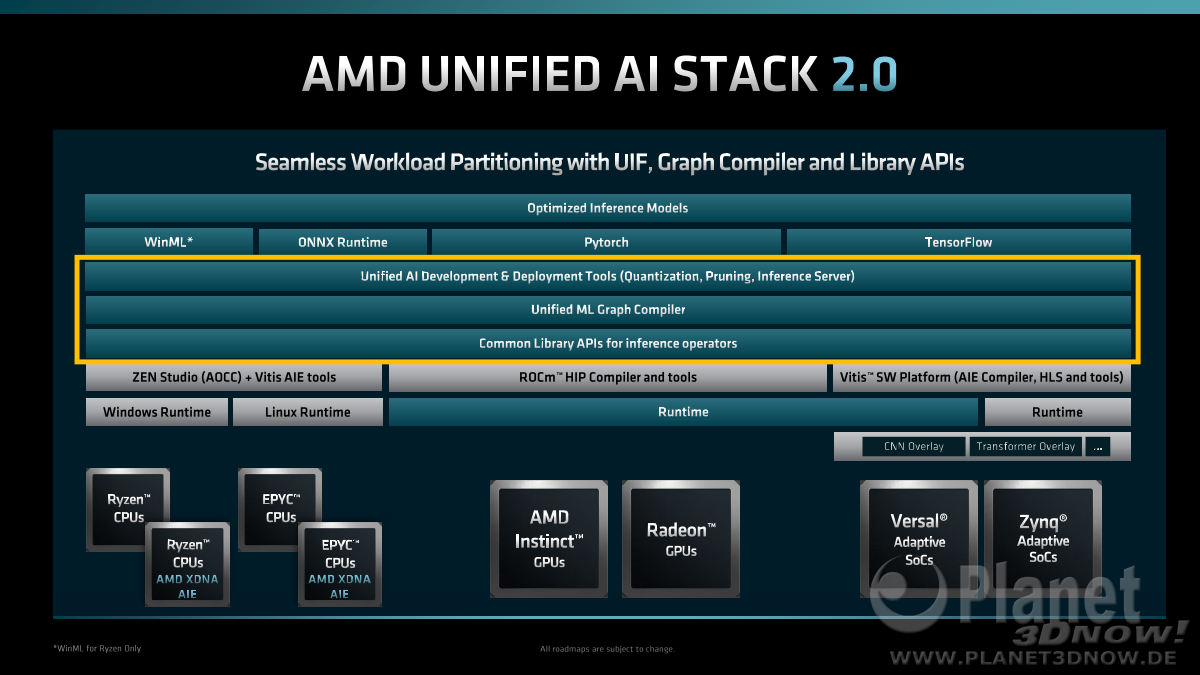

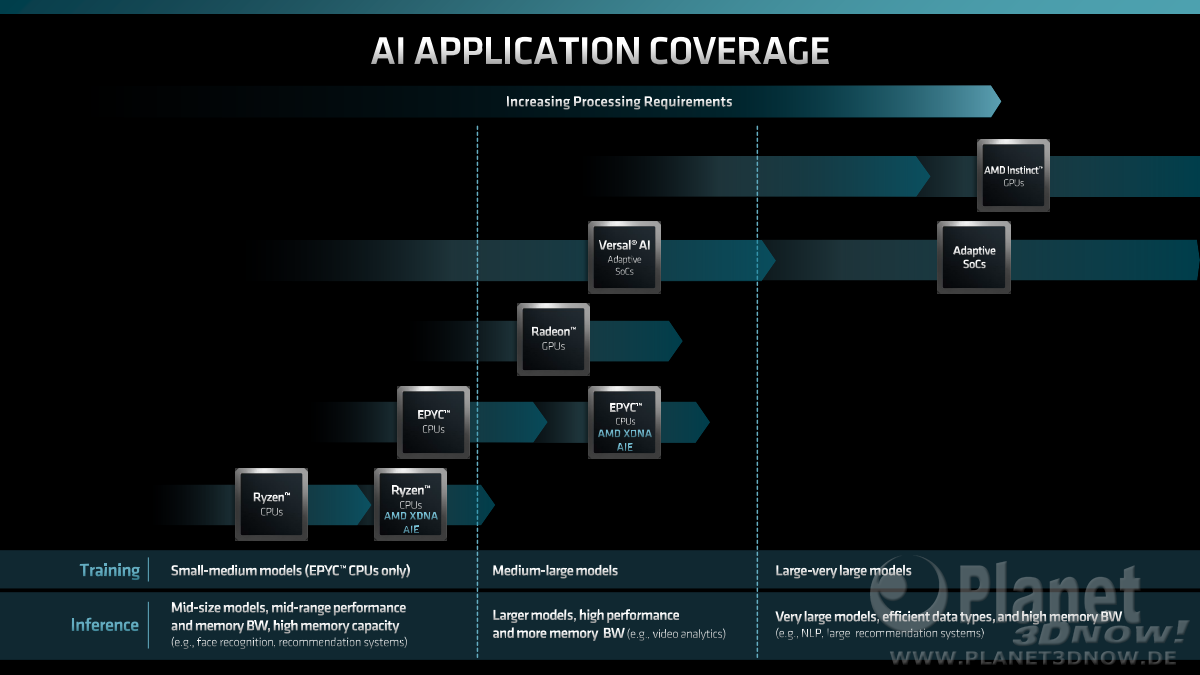

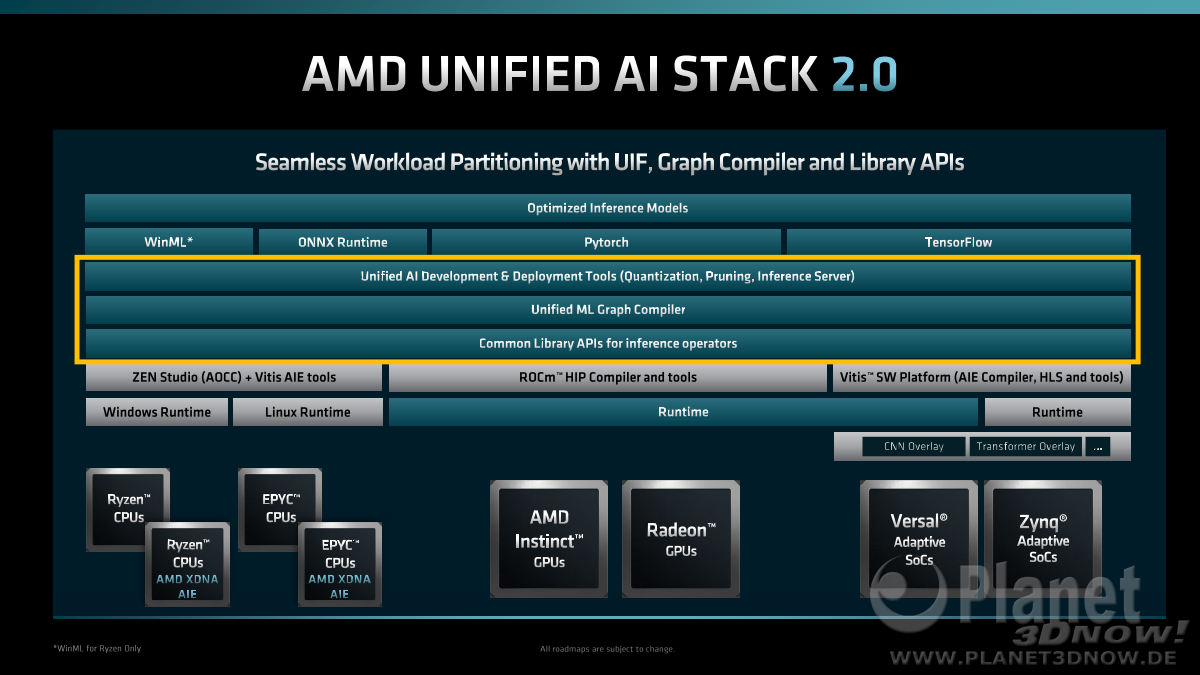

In den Fussnoten der AMD-Präsentation war darauf hingewiesen, dass Microsoft ML ausschliesslich für die Ryzen-CPUs verwendet werden soll. Die Vermutung ist, dass sich das auf den Treiber-Support vor allem auch ohne XDNA bezieht. Abseits dem Client-Computing möchte AMD also andere APIs bevorzugt unterstützen, die Entwickler sollen sich dem von Xilinx geprägten Softwarestack zuwenden.

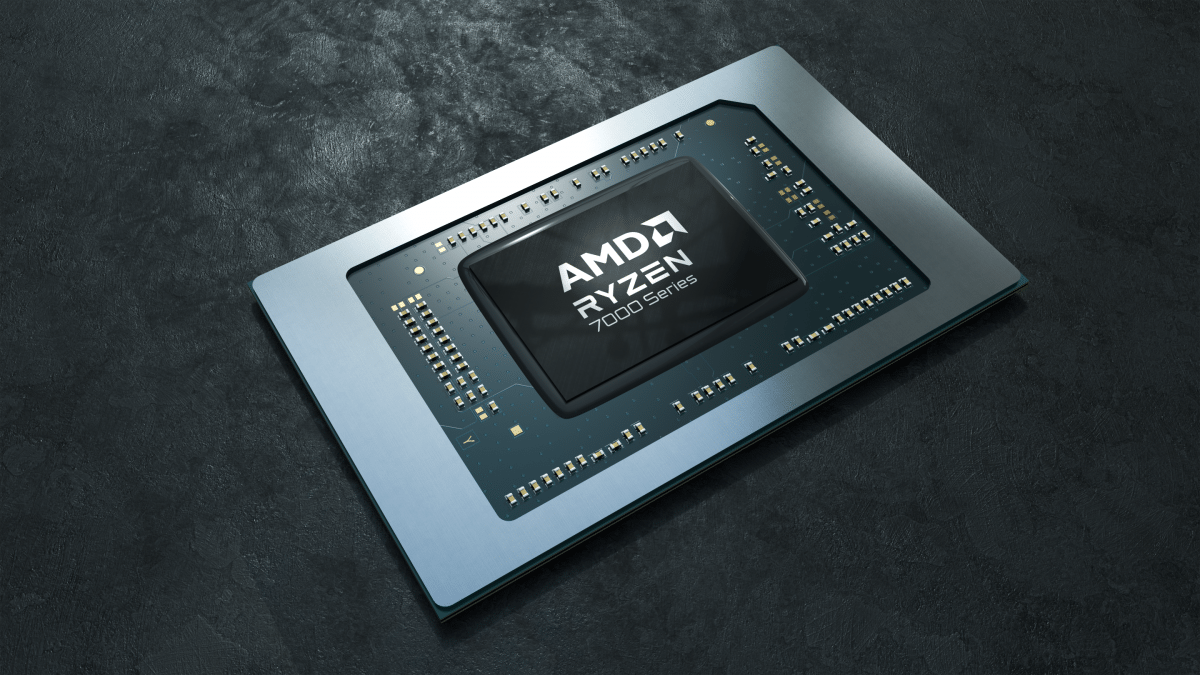

AMD zeigt mit dem Launch der ersten Phoenix Laptops im März 2023, dass sie nach der Übernahme von Xilinx und den Ankündigungen letzten Jahre rasch integrierte Produkte in den Markt bringen können. THG berichtet dazu über Aussagen von AMD, dass man bereits Pläne für XDNA2 und XDNA3 Ausbaustufen hat.

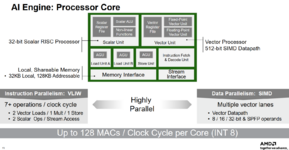

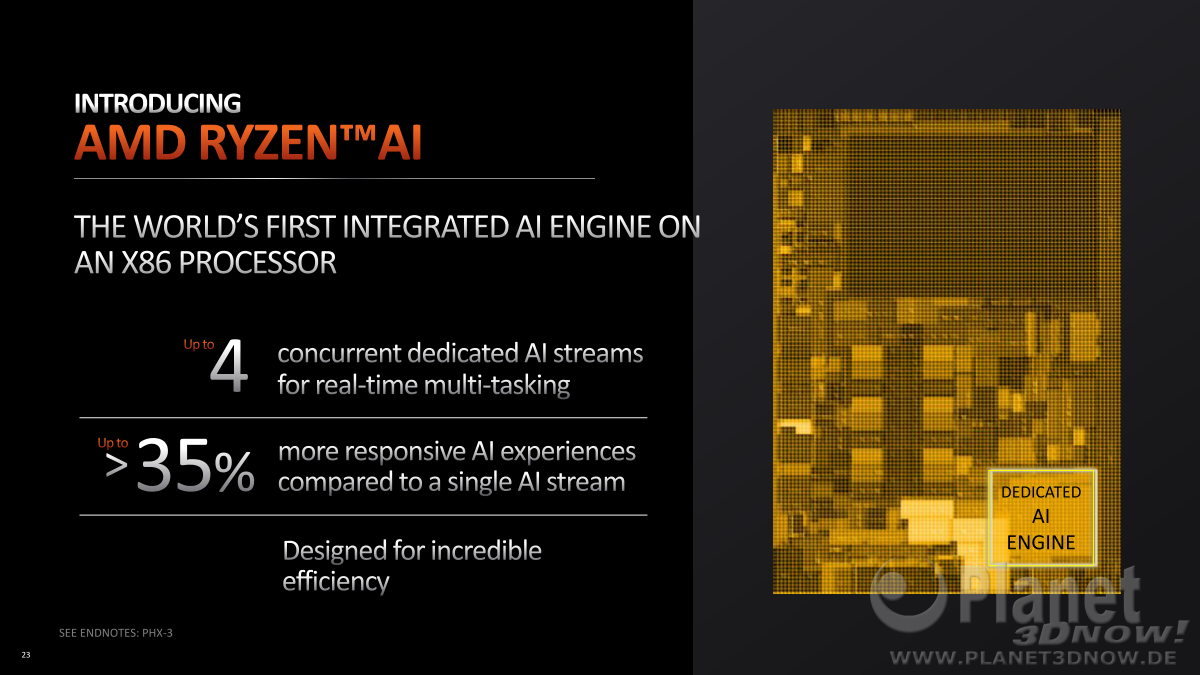

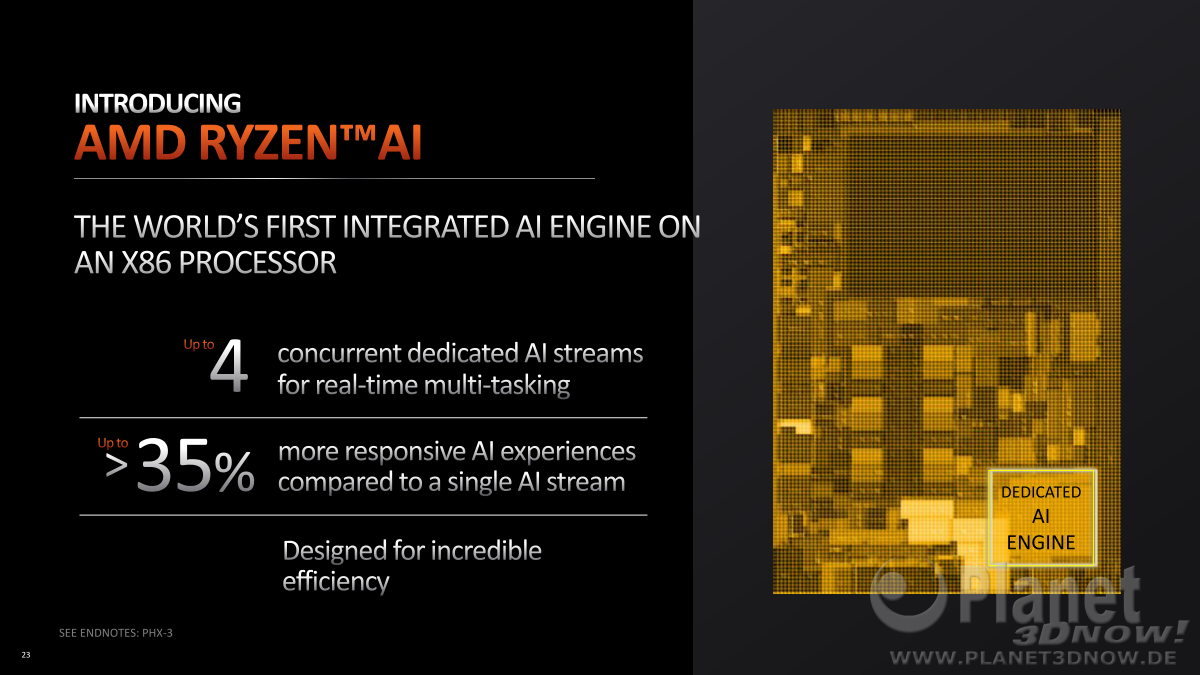

Für die erste Implementierung in den Ryzen 7040 APUs als Ryzen AI spricht AMD von 4 unabhängigen AI-Streams mit einer Leistung von 12 Billionen AI-Ops pro Sekunde (engl.: trillion).

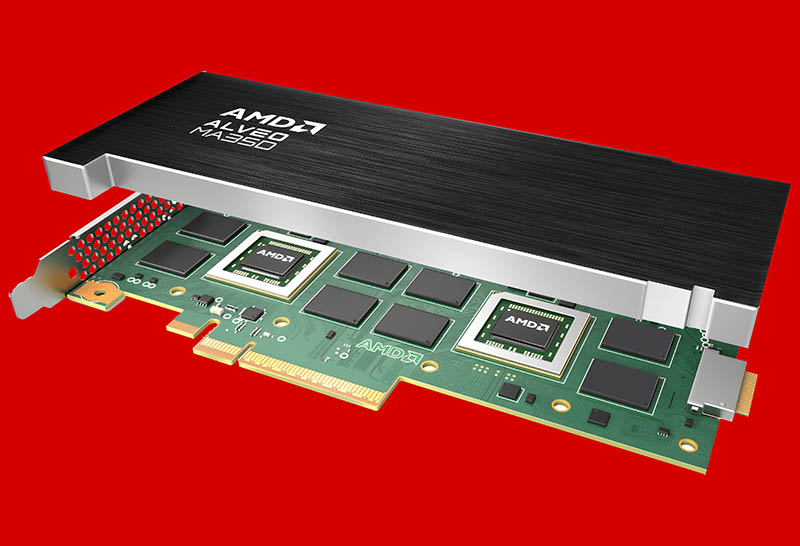

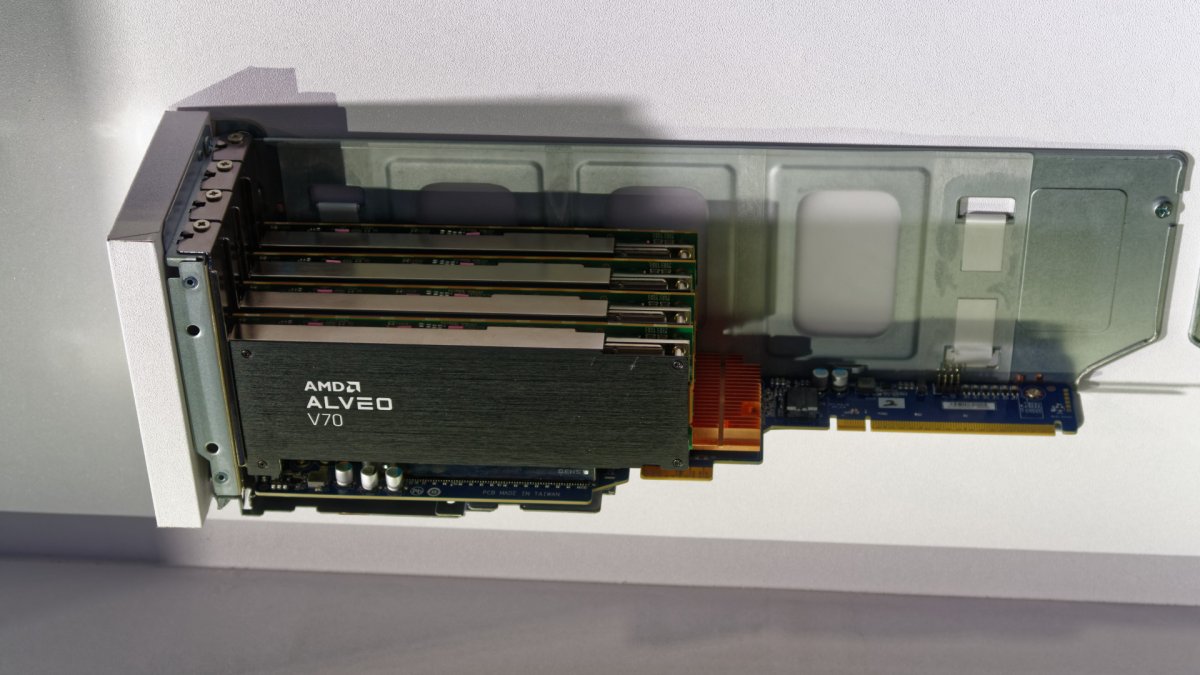

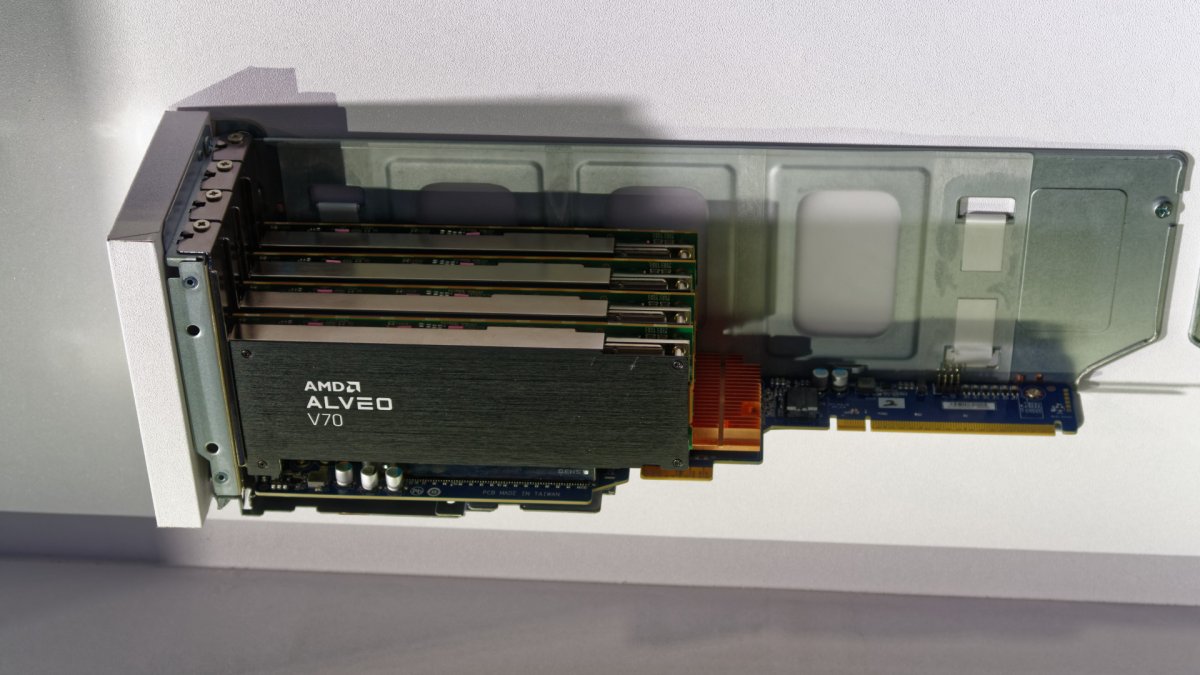

Auf der Produktseite zur Beschleunigerkarte Alveo V70 spezifiziert AMD diese als XDNA Versal AI Core basierend. Die Alveo V70 war Teil der CES-Präsentation und ist fürs Frühjahr 2023 angekündigt:

Die Ryzen AI leisten nach Angaben von AMD nur 3% dieser Alveo, bzw. ist diese mit 400 TOPS vs 12 TOPS um Faktor 33 leistungsfähiger.

Die Ryzen AI leisten nach Angaben von AMD nur 3% dieser Alveo, bzw. ist diese mit 400 TOPS vs 12 TOPS um Faktor 33 leistungsfähiger.

Der entsprechende Teil aus der Pressemitteilung zur CES.

AMD Brings the Power of AI to Mobile Processors

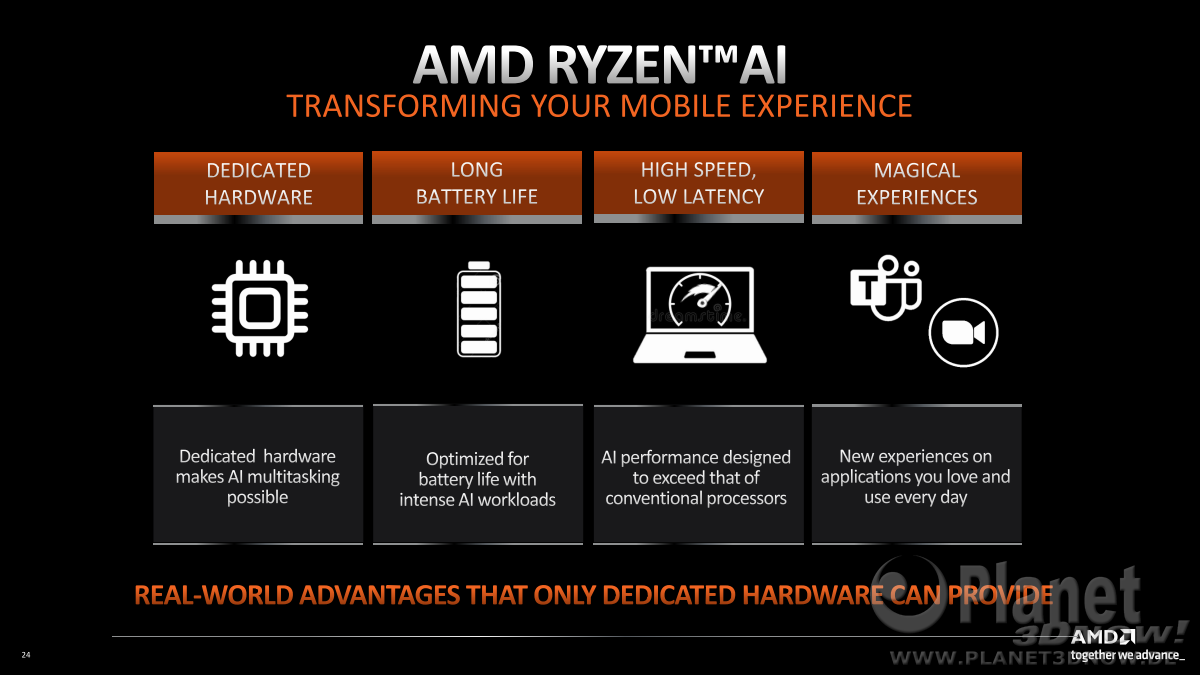

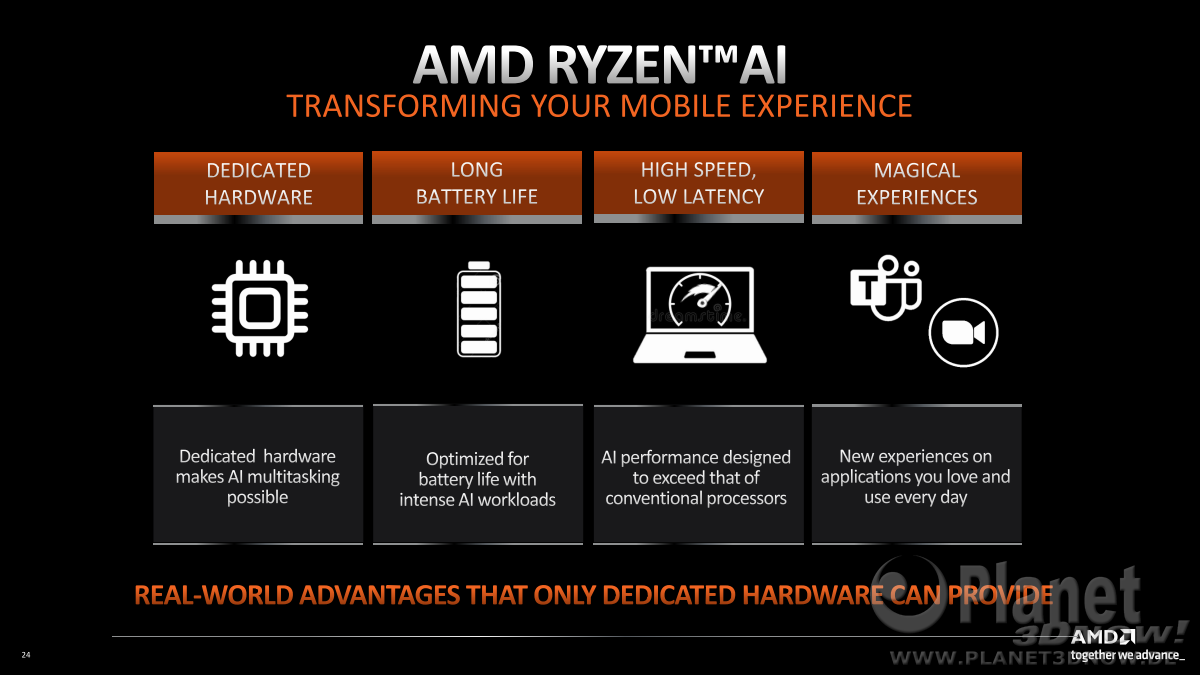

As part of the new Ryzen 7040 Series Mobile processors, AMD unveiled Ryzen™ AI, the first dedicated artificial intelligence hardware in an x86 processor, available on select models, bringing AMD XDNA™ adaptive AI architecture to laptop computing delivering more performance for real-time AI experiences. Ryzen processors with Ryzen AI outperform the Apple M2 CPU by up to 20% while being up to 50% more energy efficient 8. This performance and efficiency ultimately add up to richer, real-time user experiences in video collaboration, content creation, productivity, gaming, and protection.

“Microsoft and AMD have a long history of incredible partnership and impact,” said Panos Panay, EVP, and chief product officer, Microsoft. “The AMD Ryzen 7040 Series paired with the latest Windows 11 updates is the next step on our journey together. Leveraging AMD silicon along with our AI investments in Windows will unlock groundbreaking experiences for our customers.”

8. Engineering projections are not a guarantee of final performance. Performance projection by AMD engineering staff based on expected performance. Specific projections are based on pre-silicon analysis and are subject to change when final products are released in market. PHX-13.

Das universelle X steht also künftig für künstliche Intelligenz wie das C in CDNA für Compute und das R in RDNA für Radeon.

Bereits zum Financial Analyst Day wurde der Terminus XDNA in der Präsentation von Viktor Peng (S.14ff) der Öffentlichkeit präsentiert, allerdings noch vor allem im Kontext mit den Xilinx-Produkten. Das X in XDNA steht deshalb auch für Xilinx.

Gemäss einem Artikel von STH handelt es sich um die gleiche Architektur, die in den aktuellen FPGA-Beschleunigern der Versal-Serie genutzt wird. Diese FPGAs werden bei AMD als ACAP (Adaptive Compute Acceleration Platform) bezeichnet. ACAP bezieht dabei neben den AI-Beschleunigern auch die damit integrierten Scalaren Einheiten (z.B. ARM) und programmierbare Netzwerkkomponenten mit ein.

In den Fussnoten der AMD-Präsentation war darauf hingewiesen, dass Microsoft ML ausschliesslich für die Ryzen-CPUs verwendet werden soll. Die Vermutung ist, dass sich das auf den Treiber-Support vor allem auch ohne XDNA bezieht. Abseits dem Client-Computing möchte AMD also andere APIs bevorzugt unterstützen, die Entwickler sollen sich dem von Xilinx geprägten Softwarestack zuwenden.

AMD zeigt mit dem Launch der ersten Phoenix Laptops im März 2023, dass sie nach der Übernahme von Xilinx und den Ankündigungen letzten Jahre rasch integrierte Produkte in den Markt bringen können. THG berichtet dazu über Aussagen von AMD, dass man bereits Pläne für XDNA2 und XDNA3 Ausbaustufen hat.

Für die erste Implementierung in den Ryzen 7040 APUs als Ryzen AI spricht AMD von 4 unabhängigen AI-Streams mit einer Leistung von 12 Billionen AI-Ops pro Sekunde (engl.: trillion).

Auf der Produktseite zur Beschleunigerkarte Alveo V70 spezifiziert AMD diese als XDNA Versal AI Core basierend. Die Alveo V70 war Teil der CES-Präsentation und ist fürs Frühjahr 2023 angekündigt:

Zuletzt bearbeitet:

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.486

- Renomée

- 9.834

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

community.amd.com/t5/business/building-the-future-of-laptop-mobility/ba-p/572254/

Zukünftige Prozessoren sollen demnach mehr AI-Streams bekommen.

Dann sind wir mal gespannt, was vor allem MS daraus macht.

As far as new and emerging technologies, artificial intelligence holds tremendous long-term potential. AMD will offer hardware AI acceleration on select 7040 series processors in 2023 and expects to expand the total number of processors with onboard AI hardware over time. This hardware AI integration represents an important long-term transition for the entire computing industry. Just as the graphics card was invented to speed up the unique demands of graphics engine processing, so has the Ryzen AI engine been introduced for the specialized demands on AI processing.

Zukünftige Prozessoren sollen demnach mehr AI-Streams bekommen.

Dann sind wir mal gespannt, was vor allem MS daraus macht.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Kürzlich habe ich die CES Präsentation von AMD gemeinsam mit einem Freund angeschaut. Der konnte nicht gut Englisch und ich habe den MS Translator auf einem Smartphone genutzt (Galaxy S10+). Das hat recht gut funktioniert in Echtzeit und ich bin sicher da wird einiges an Verbesserungen möglich mit zusätzliche AI-Streams auf Notebooks/Desktops. Wenn Untertitel/Übersetzungen lokal generiert werden können und damit Plattform/Format-Unabhängig werden, ist das ein großer Vorteil.

Probleme gabs übrigens mit dem spanischen Dialekt des HP CEOs.

Probleme gabs übrigens mit dem spanischen Dialekt des HP CEOs.

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

(Ich habe im ersten Post noch die zusätzlichen 4 Bilder der Präsentationen zu RyzenAI und Alveo ergänzt, nachdem ich die in Pinpins Slide Decks gefunden hatte.)

Bei Microsoft war mir das Gerede während der Keynote noch viel zu schwammig. Dass ich in Bildbearbeitung zur Korrektur unterstützt werde oder es bessere Deinterlacer, Skalierer und bessere Rausch- und Wackel-Reduktion geben wird ist ein erwartbarer Anwendungsfall.

Übersetzungen wohl auch, obwohl ich das eher in der Cloud sehe wegen den vielen Sprachen mit steten Entwicklungen und Dialekten.

Ton- und Bildkorrektur bei Videotelefonie bleibt mir aber momentan als einziger breitenwirksamer Anwendungsfall für Client-Compute übrig.

Zur AMD-Folie zu Gaming, Security und Adaptive UI sehe ich da noch kein Anwendungsfall. Womöglich möchte Microsoft künftig

Bei Microsoft war mir das Gerede während der Keynote noch viel zu schwammig. Dass ich in Bildbearbeitung zur Korrektur unterstützt werde oder es bessere Deinterlacer, Skalierer und bessere Rausch- und Wackel-Reduktion geben wird ist ein erwartbarer Anwendungsfall.

Übersetzungen wohl auch, obwohl ich das eher in der Cloud sehe wegen den vielen Sprachen mit steten Entwicklungen und Dialekten.

Ton- und Bildkorrektur bei Videotelefonie bleibt mir aber momentan als einziger breitenwirksamer Anwendungsfall für Client-Compute übrig.

Zur AMD-Folie zu Gaming, Security und Adaptive UI sehe ich da noch kein Anwendungsfall. Womöglich möchte Microsoft künftig

- das Kontext-Menü per AI für den Nutzer individualisieren?

- die vergessenen Passwörter per AI wiederherstellen?

- einen trainierbaren Cheat-Bot für Maus & Keyboard fürs Grinding anbieten?

Zuletzt bearbeitet:

w0mbat

Commodore Special

- Mitglied seit

- 19.05.2006

- Beiträge

- 416

- Renomée

- 18

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5800X3D

- Mainboard

- MSI MAG B550M Mortar Max WIFI

- Kühlung

- NZXT Kraken X63

- Speicher

- G.SKILL F4-3600C18D-64GVK

- Grafikprozessor

- Sapphire Nitro+ RX 9070 XT

- Display

- Alienware AW3423DWF

- SSD

- 2TB WD_BLACK SN850X + 2TB Samsung 970 EVO Plus

- Soundkarte

- Realtek ALC1220

- Gehäuse

- Lian Li O11 Dynamic Mini

- Netzteil

- Cougar SF750 ATX3.1

- Tastatur

- CM QuickFire Rapid-i

- Maus

- Logitech G Pro X Superlight 2

- Betriebssystem

- Windows 11 Pro x64

- Webbrowser

- Firefox

Gegner-KI in single player Spielen, die auf der AIE läuft?

Hintergrund bei Videotelefonie tauschen, KI-Stimmoptimierung, Video-Upscaling.

Hintergrund bei Videotelefonie tauschen, KI-Stimmoptimierung, Video-Upscaling.

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

AMD Alveo MA35D Custom Anti-GPU Silicon for AV1-era Video Transcoding

The AMD Alveo MA35D uses custom silicon for AV1-era video transcoding instead of GPUs and CPUs to lower costs per stream

The Alveo MA35D supports AV1, VP9, h265, and h264 and up to 8K resolution. Something that is different with the ASIC is that the VQ QoE Engine and VQ look-ahead features can, at low latency, make determinations of quality/ compression impacts and optimize streams in almost realtime.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Die Folie von dir oben zeigt den Alveo 70 als XDNA. Der Alveo MA35D hat die selben AI Engines verbaut. Daher denke ich es ist Teil des XDNA Portfolios.

Edit: Tatsächlich wird nirgends XDNA bei den AI Funktionen erwähnt in den Produkt-Papers... hmm.

Edit: Tatsächlich wird nirgends XDNA bei den AI Funktionen erwähnt in den Produkt-Papers... hmm.

Zuletzt bearbeitet:

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

V70, das V steht für Versal, das sind flexiblere Alveo Karten für Entwickler. Ansonsten gibt es noch jede Menge andere AI-Core Series im Versal-Portfolio.

Die anderen Alveo Addin-Karten sind für ganz spezifische Anwendungsfälle ausgelegt und haben teilweise spezielle Chipdesignes, so wie beim MA35D. Welches AI-Design so ein SoC hat lässt Xilinx offen, aber weil die V70 explizit als XDNA beworben wurde gehe ich davon aus, dass es momentan das erste und einzige Alveo Modell ist.

Die anderen Alveo Addin-Karten sind für ganz spezifische Anwendungsfälle ausgelegt und haben teilweise spezielle Chipdesignes, so wie beim MA35D. Welches AI-Design so ein SoC hat lässt Xilinx offen, aber weil die V70 explizit als XDNA beworben wurde gehe ich davon aus, dass es momentan das erste und einzige Alveo Modell ist.

Ob es SoC/FPGA/ASIC einzeln gibt, die bereits XDNA mitbringen ist auf die Schnelle nicht zu erkennen, ich denke mal eher nein, sonst wäre es vermutlich beworben.The Alveo™ V70 accelerator card is the first AMD Alveo production card leveraging AMD XDNA™ architecture with AI Engines.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Diese neue strategische Ausrichtung ist sicherlich eine Initialzündung und IMHO gut besetzt:

www.nextplatform.com

www.nextplatform.com

AMD Says AI Is The Number One Priority Right Now

When it comes to an economy, you get what we collectively expect. And given all of the talk and weird things that have happened in the early part of 2023,

www.nextplatform.com

www.nextplatform.com

Su also said that all of the AI teams across AMD’s various divisions and groups are have been combined into one single organization, which will be managed by Victor Peng, the former chief executive officer of FPGA maker Xilinx and the general manager of AMD’s Embedded group. The new AI group, which may be one of those virtual, cross-group things, will drive AMD’s end-to-end AI hardware strategy as well as its AI software ecosystem, including optimized libraries, models and frameworks spanning all of the companies compute engines.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Olive Optimized DirectML Stable Diffusion 1.5

AMD Developer Blog: https://community.amd.com/t5/gaming...deon/ba-p/609959/jump-to/first-unread-message

Eine erste Einordnung: https://www.slashcam.de/news/single/AMDs-neue-Adrenalin-Treiber-23-5-1-verdoppeln-Rech-17956.html

Kontext dazu unter welchen Namen das vermarktet wird:

MS Olive: https://devblogs.microsoft.com/directx/optimize-directml-performance-with-olive/

Save the date:

13.06.2023: AMD to Showcase Next-Generation Data Center and AI Technology

ir.amd.com

30.06.2023: Webinar bei AMD, vorgetragen von Verfasser des Blogeintrags oben:

ir.amd.com

30.06.2023: Webinar bei AMD, vorgetragen von Verfasser des Blogeintrags oben:

AMD Developer Blog: https://community.amd.com/t5/gaming...deon/ba-p/609959/jump-to/first-unread-message

Damit wäre AMDs 7900XT und 7900XTX in diesen Benchmarks vom Januar schneller als die RTX 4090 (ohne die Optimierungen).The latest AMD Radeon™ RX 7000 Series graphics cards feature new unified AMD RDNA ™ 3 compute units with AI accelerators that have been optimized for AI workloads. The latest generation of GPUs also come with large amounts of GDDR6 memory, with up to 24GB, allowing users and developers to work with larger AI models locally.

Eine erste Einordnung: https://www.slashcam.de/news/single/AMDs-neue-Adrenalin-Treiber-23-5-1-verdoppeln-Rech-17956.html

Im Vorfeld des Phoenix Launch sicherlich eine interessante OS-/Software-Entwicklung, da auch 7040 APUs unterstützt werden.Doch bislang ist nicht einmal die eigentliche Performance das Problem, sondern überhaupt die Unterstützung beliebter Software-Pakete. Während fast jedes KI-Modell auf Nvidias CUDA fußt, scheint AMDs Alternative (ROCm) seit Jahren den Anschluss zu suchen.

Doch all dies könnte sich nun auch schnell ändern. Nicht nur, dass AMD die Zahl der ROCm-Entwickler in den letzten zwei Jahren vervielfacht hat, auch auf dem zugehörigenGitHub-Repository ist seit einigen Monaten reges Treiben zu vermelden.

Und am 13. Juni will AMD zur eigenen KI-Strategie Großes verkünden. Wir persönlich erwarten hier erste direkte Benchmarks mit Vergleichen zu Nvidia - die natürlich trotzdem "cherry picked" sein werden. Trotzdem: Alleine für ein gesundes Marktgleichgewicht ist ein zweiter Player neben Nvidia sicherlich wünschenswert.

Kontext dazu unter welchen Namen das vermarktet wird:

MS Olive: https://devblogs.microsoft.com/directx/optimize-directml-performance-with-olive/

ONNX Live: https://cloudblogs.microsoft.com/op...ing-models-with-onnx-and-hugging-face-spaces/Are you ready to revolutionize the way you optimize your AI models? Say hello to Olive (ONNX Live), the advanced model optimization tool that integrates seamlessly with DirectML for hardware acceleration across the breadth of the Windows ecosystem.

ONNX Runtime is a cross-platform inference and training machine-learning accelerator. It makes live Gradio demos with ONNX Model Zoo model on Hugging Face possible.

ONNX Runtime inference can enable faster customer experiences and lower costs, supporting models from deep learning frameworks such as PyTorch and TensorFlow/Keras as well as classical machine learning libraries such as scikit-learn, LightGBM, XGBoost, etc. ONNX Runtime is compatible with different hardware, drivers, and operating systems, and provides optimal performance by leveraging hardware accelerators where applicable alongside graph optimizations and transforms.

The Hugging Face Spaces we created use ONNX Runtime with its Python APIs running on the server. ONNX Runtime also has Java, C, C++, C#, and JavaScript APIs and runs on mobile devices and even inside the browser.

Save the date:

13.06.2023: AMD to Showcase Next-Generation Data Center and AI Technology

AMD to Showcase Next-Generation Data Center and AI Technology at June 13 Livestream Event

Browse AMD’s company-wide and financial press releases.

AMD Ryzen™ AI: What It Is and How It’s Elevating Your Digital Workflow

AMD Ryzen™ AI: What It Is and How It’s Elevating Your Digital Workflow

webinars.amd.com

What We’ll Cover:

- AMD Ryzen™ AI Hardware

- AMD Ryzen™ AI Use-Cases

- AMD Ryzen™ 7040 Series Processors

Zuletzt bearbeitet:

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

Naja. Also Olive für RDNA3 ist eben gerade nicht XDNA, das tendiert eigentlich off-topic.

Aber es bringt die Frage in den Fokus - Warum in aller Welt werden bei AMD die AI Beschleuniger nicht für AI Beschleunigung durch Software supportet?

Hier meine News dazu.

Überspitzt könnte man vermuten, die Softwareunterstützung für AI von AMD wird in Zukunft erstmal katastrophal bleiben, denn das DirectML Marketing-Beispiel zu StableDiffusion haben ...

Es ist schon verwunderlich, warum man für XDNA statt bei den APU-Dokumentationen etwas bei Xilinx Versal rauskramen muss. Das Pamphlet von Cahrlie Demerjian ist da leider ganz treffend.

Zuletzt - Mitte Mai - hat man zu XDNA auch nur Hinweise aus Interviews bei PCWorld oder TomsHardware mit David McAfee von AMD gefunden. Momentan sieht es demnach so aus, dass AMD vor allem auf Microsoft wartet, dass die ihre künftigen OS mit AI Aufgaben anreichern, die in übrigen Applikationen wie Videoconferencing, Bildbearbeitung, Emailbearbeitung und Metadatengenerierung helfen sollen. Die Strategie scheint momentan zu sein das nur bei APUs auszubauen, da für Many-Core Desktops genug generische Cores und Energie vorhanden sein wird. XDNA in extremis wird dann nur in der Cloud als Xilinx Beschleuniger verbaut.

Das erinnert stark an alte Zeiten von AMD, in denen man nur Technologie auf den Markt geschmissen hat und sich später wunderte warum die Entwickler sich doch nur wieder der Literatur, dem Beispielcode und den APIs und ISA der Konkurrenz zuwenden.

Aber es bringt die Frage in den Fokus - Warum in aller Welt werden bei AMD die AI Beschleuniger nicht für AI Beschleunigung durch Software supportet?

Hier meine News dazu.

Überspitzt könnte man vermuten, die Softwareunterstützung für AI von AMD wird in Zukunft erstmal katastrophal bleiben, denn das DirectML Marketing-Beispiel zu StableDiffusion haben ...

- entweder ein paar studentische Praktikanten zusammengeflickt weil sonst niemand Zeit für soetwas hat,

- oder die haben zu viele Vollzeitentwickler gebraucht, dass mit viel Aufwand gerade nur ein einziger GPU-Chip supportet werden kann.

Es ist schon verwunderlich, warum man für XDNA statt bei den APU-Dokumentationen etwas bei Xilinx Versal rauskramen muss. Das Pamphlet von Cahrlie Demerjian ist da leider ganz treffend.

Zuletzt - Mitte Mai - hat man zu XDNA auch nur Hinweise aus Interviews bei PCWorld oder TomsHardware mit David McAfee von AMD gefunden. Momentan sieht es demnach so aus, dass AMD vor allem auf Microsoft wartet, dass die ihre künftigen OS mit AI Aufgaben anreichern, die in übrigen Applikationen wie Videoconferencing, Bildbearbeitung, Emailbearbeitung und Metadatengenerierung helfen sollen. Die Strategie scheint momentan zu sein das nur bei APUs auszubauen, da für Many-Core Desktops genug generische Cores und Energie vorhanden sein wird. XDNA in extremis wird dann nur in der Cloud als Xilinx Beschleuniger verbaut.

Das erinnert stark an alte Zeiten von AMD, in denen man nur Technologie auf den Markt geschmissen hat und sich später wunderte warum die Entwickler sich doch nur wieder der Literatur, dem Beispielcode und den APIs und ISA der Konkurrenz zuwenden.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ich sehe das nicht als Offtopic, sondern so wie das auch heise interpretiert:

www.heise.de

www.heise.de

Damit sollten die Zweifel ob APUs die AI-Cores nutzen, für die 7040-Serie nun ausgeräumt sein.

Die APUs sind gelistet, noch kein Linux Support. Opensource und Code Beispiele zur Nutzung.

Auch Phoronix berichtet von starken Aktivitäten:

KI-Beschleuniger für Server mit XDNA-Technik des AMD Ryzen 7040U

Gigabyte packt 16 KI-Inferencing-Beschleuniger vom Typ AMD Alveo V70 mit XDNA-Technik in einen Rackserver. Die Karten sollen Video- und Sprachdaten analysieren.

Danke nochmal für den Link zu deiner User News, die ist mir tatsächlich entgangenXDNA-Technik auch im Mobilprozessor Ryzen 7040U

Während die meisten Smartphone-Chips bereits KI-Inferencing-Beschleuniger wie Apples Neural Engine (ANE) enthalten, kommen solche Einheiten bei x86-Prozessoren von AMD und Intel erst auf den Markt. Allerdings beherrschen die AVX-Einheiten moderner x86-CPUs KI-Befehle wie VNNI und die GPU-Shader integrierter Grafikprozessoren lassen sich ebenfalls fürs Inferencing einspannen.

Doch erst mit Intel Meteor Lake und AMD Ryzen 7040U alias Phoenix kommen x86-Mobilprozessoren mit dedizierten KI-Einheiten, die Intel VPU nennt und AMD "Ryzen AI" beziehungsweise XDNA. Das "X" bezieht sich auch auf die zugekaufte FPGA-Sparte Xilinx, die die "Versal AI Cores" seit einigen Jahren entwickelt.

Microsoft arbeitet an der Integration von Machine-Learning-Beschleunigern ins Betriebssystem Windows und stellte dazu vor 5 Jahren die API Windows ML (WinML) mit ONNX vor. In Windows 11 sind beispielsweise die Windows Studio Effects zur Echtzeitverarbeitung von Webcam-Bildern enthalten, die WinML/DirectML nutzen.

Damit sollten die Zweifel ob APUs die AI-Cores nutzen, für die 7040-Serie nun ausgeräumt sein.

Dem kann ich nicht zustimmen - Charlie ist da mit seiner OEM-Theorie völlig auf dem Holzweg. Die Implementierung ist über OS+Treiber, da gibst du an keinen OEM Infos raus. Und AMD gibt keine Infos raus an Charlie? Hier sind seit 5 Monaten Samples zu finden. Und mit diesem Satz, hat er sich völlig disqualifiziert zu dem Thema:Es ist schon verwunderlich, warum man für XDNA statt bei den APU-Dokumentationen etwas bei Xilinx Versal rauskramen muss. Das Pamphlet von Cahrlie Demerjian ist da leider ganz treffend.

Das KI-Thema wird von Journalisten überhaupt nicht durchdrungen, da alle ChatGPT oder Raytracing im Sinn haben.To make matters worse, nearly all the AI related processing tasks depend on having lots of trained information. Do you think your laptop has a better model than, oh say, Facebook or Google? AI hardware is great for acquisition devices but borderline useless on laptops.

Die APUs sind gelistet, noch kein Linux Support. Opensource und Code Beispiele zur Nutzung.

Auch Phoronix berichtet von starken Aktivitäten:

Zuletzt bearbeitet:

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

Ok. Es gibt auf AMD.com ein Blog der auf ein Github Repository mit einem Demo für XDNA verweist.

community.amd.com

community.amd.com

Von Januar bis Juni ist das nach wie vor reichlich wenig. Man verlässt sich auf Microsoft mit ONNX und Olive, hat je ein Beispiel für XDNA via Vitis AI ohne Olive bzw. eines für Navi31 mit Olive das Treiberoptimierungen nötig macht.

Wünschen würde man sich doch, dass die in wenigen Tagen alle Beispiele für XDNA aufbereiten, dokumentieren und optimieren, für APUs gar mit Hybrid-Aware Optimierungen via Olive.

Bisher ist die Message man kann XDNA via ONNX von Microsoft nutzen, es ist aber nicht Olive optimiert und gleicher Code läuft via Olive ohne Treiberanpassungen von AMD auf GPU CUs erst mal nicht oder nicht optimal.

Für die potentiellen Kunden im Marketing für Laptops würde man sich mehr als irgend ein Demo auf Github wünschen, z. B. Studio Effects von Win11.

Ich fürchte das wird viel zu lange dauern, bis dort allgemein Softwareentwickler auf den Zug aufspringen und von Anfang an eigene Software dafür testen und debuggen oder gar optimieren.

AMD Accelerates AI Adoption on Windows 11 With New Developer Tools for Ryzen AI

AI is one of the most transformative technologies to debut in the past 40 years, but taking full advantage of its capabilities requires more than just the latest processor or graphics card. Previous major shifts in computing, like the adoption of 64-bit software and the introduction of...

Von Januar bis Juni ist das nach wie vor reichlich wenig. Man verlässt sich auf Microsoft mit ONNX und Olive, hat je ein Beispiel für XDNA via Vitis AI ohne Olive bzw. eines für Navi31 mit Olive das Treiberoptimierungen nötig macht.

Quantization of Ryzen AI models can be accomplished with either the Vitis AI Quantizer, or Olive. For AMD Adapable SoCs, the user must leverage the Vitis AI Quantizer.

Wünschen würde man sich doch, dass die in wenigen Tagen alle Beispiele für XDNA aufbereiten, dokumentieren und optimieren, für APUs gar mit Hybrid-Aware Optimierungen via Olive.

Bisher ist die Message man kann XDNA via ONNX von Microsoft nutzen, es ist aber nicht Olive optimiert und gleicher Code läuft via Olive ohne Treiberanpassungen von AMD auf GPU CUs erst mal nicht oder nicht optimal.

Für die potentiellen Kunden im Marketing für Laptops würde man sich mehr als irgend ein Demo auf Github wünschen, z. B. Studio Effects von Win11.

Die Marketing-Folie mit der längeren Batterielaufzeit für Videokonferenzen mit AI-optimiertem Bild und dadurch Bandbreitenbedarf habe ich noch nicht entdeckt... gibts vermutlich auch noch lange nicht, von einem Marketing-Video dazu ganz zu schweigen.As one example, AMD Ryzen AI is now supported in Windows Studio Effects. These effects include Eye Contact (an effect to compensate for eyes looking at the screen instead of the camera), Automatic framing (an effect to automatically zoom and crop the image as you move around), and advanced background effects, including background blur. Each is designed to improve a different aspect of video calls – which, for many, have become an important part of their jobs and daily lives. Windows Studio effects is enabled by machine learning algorithms and will require a NPU (neural processing unit) like Ryzen AI.

Ich fürchte das wird viel zu lange dauern, bis dort allgemein Softwareentwickler auf den Zug aufspringen und von Anfang an eigene Software dafür testen und debuggen oder gar optimieren.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Da die Ankündigung für den 13.06. vorgesehen ist, weiss ich nicht so recht was du da erwartest an Marketing vor dem Kick-Off.

Dass die Zahl der Entwickler rapide gestiegen ist, wird in mehreren meiner Links geschrieben. Durch den Microsoft Copilot unter Windows 11 wird das ganz schnell gehen in den nächsten Monaten. IMHO ist das ein koordinierter Launch der AI-Strategie von Microsoft mit AMD, Intel, Nvidia und Qualcomm.

Hardware, Software und Implementation fallen wie zufällig auf den selben Zeitrahmen?

news.microsoft.com

news.microsoft.com

Dass die Zahl der Entwickler rapide gestiegen ist, wird in mehreren meiner Links geschrieben. Durch den Microsoft Copilot unter Windows 11 wird das ganz schnell gehen in den nächsten Monaten. IMHO ist das ein koordinierter Launch der AI-Strategie von Microsoft mit AMD, Intel, Nvidia und Qualcomm.

Hardware, Software und Implementation fallen wie zufällig auf den selben Zeitrahmen?

Neue Möglichkeiten für KI-Developer mit Windows Copilot in Windows 11 und im Microsoft Store | News Center Microsoft

Im Rahmen der Microsoft Build 2023 stellen wir neue Tools und KI-gestützte Lösungen wie Windows Copilot für Developer und Endnutzer*innen vor

Windows goes AI: Im Rahmen der Microsoft Build 2023 stellen wir neue Tools und KI-gestützte Lösungen für Developer und Endnutzer*innen vor. Dazu gehören Windows Copilot in Windows 11 und die starke Einbindung von Bing-Chat-Plugins. Zudem bieten wir mit Lösungen wie Hybrid Loop und Dev Home weitere Möglichkeiten, um die Arbeit für Developer zu erleichtern. Für den Microsoft Store kündigen wir neue Tools und KI-Funktionen an.

Künstliche Intelligenz (KI) ist die entscheidende Technologie unserer Zeit und Entwickler*innen sind bei dem Wandel, der mit ihr einhergeht, ganz vorne mit dabei. Mit den richtigen Tools können wir Entwickler*innen und unsere gemeinsame Kundschaft dabei unterstützen, die Zukunft mitzugestalten. Heute stellen wir die nächsten Schritte vor, die wir auf unserer Reise mit Windows 11 unternehmen, um diesem neuen Zeitalter der KI zu begegnen:

- Mit Windows Copilot ist Windows 11 die erste PC-Plattform, die eine zentralisierte KI-Hilfe anbietet. Das unterstützt Menschen dabei, Ideen einfach umzusetzen, zusammenzuarbeiten und komplexe Projekte zu erledigen.

- Die Erweiterung von Bing-Chat-Plugins auf Windows ermöglicht es Developern, ihre Apps in Windows Copilot zu integrieren, um ihren Kund*innen einen besseren Service zu bieten und das Engagement bei nativen Windows-Anwendungen zu erhöhen.

- Hybrid Loop unterstützt die KI-Entwicklung plattformübergreifend und zwar von Azure bis zum Client mit neuer Chip-Unterstützung von AMD, Intel, Nvidia und Qualcomm.

- Die neue Plattform Dev Home hilft Developern, unter Windows produktiver zu werden und ihre Projekte zu organisieren.

- Neue KI-Funktionen und Erfahrungen im Microsoft Store unter Windows bieten Developern mehr Möglichkeiten, mit ihren Kund*innen zu interagieren.

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.486

- Renomée

- 9.834

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Man verlässt sich auf Microsoft mit ONNX und Olive

McNamara hat ja bereits gesagt, dass bei AMD jetzt daran sehr viele Xilinx-Entwickler mitarbeiten. Man strebt hier ja auch einen Unified AI Stack an, wird aber wohl Q4 werden, wenn auch MI300 kommt. ROCm soll mit 5.6 ja auch Windows unterstützen.

Mir drängt sich leider trotzdem der Eindruck auf, dass AMD locker ein paar 1.000 Entwickler mehr bräuchte.

Die Treiberentwicklung gerade bei den GPUs ist auch sehr hakelig. FSR 3.0 soll so zum Beispiel frühestens im August kommen.

hoschi_tux

Grand Admiral Special

- Mitglied seit

- 08.03.2007

- Beiträge

- 4.824

- Renomée

- 331

- Standort

- Ilmenau

- Aktuelle Projekte

- Einstein@Home, Predictor@Home, QMC@Home, Rectilinear Crossing No., Seti@Home, Simap, Spinhenge, POEM

- Lieblingsprojekt

- Seti/Spinhenge

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 5900X

- Mainboard

- ASUS TUF B450m Pro-Gaming

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x 16GB Crucial Ballistix Sport LT DDR4-3200, CL16-18-18

- Grafikprozessor

- AMD Radeon RX 6900XT (Ref)

- Display

- LG W2600HP, 26", 1920x1200

- HDD

- Crucial M550 128GB, Crucial M550 512GB, Crucial MX500 2TB, WD7500BPKT

- Soundkarte

- onboard

- Gehäuse

- Cooler Master Silencio 352M

- Netzteil

- Antec TruePower Classic 550W

- Betriebssystem

- Gentoo 64Bit, Win 7 64Bit

- Webbrowser

- Firefox

DLSS3 ist ja auch nicht der Bringer, von daher sollen sie sich Zeit lassen.

Fähige Entwickler wachsen leider nicht auf Bäumen und ich kann mir vorstellen, Nvidia zahlt ebenfalls gut.. Zumal an der Uni sicher auch überwiegend Cuda genutzt wird..

Fähige Entwickler wachsen leider nicht auf Bäumen und ich kann mir vorstellen, Nvidia zahlt ebenfalls gut.. Zumal an der Uni sicher auch überwiegend Cuda genutzt wird..

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

Bitte nicht alles durcheinanderwerfen.

ROCm ist für die GPU Architekturen

Vitis AI ist für AI Beschleuniger Architekturen (von Xilinx)

Hier im Thread soll es um XDNA gehen.

TensorFlow, Pytorch, ONNX etc. sind Frameworks für die Programmierung, die in beiden SW-Plattformen von AMD(Xilinx) unterstützt werden.

Die Fragen hier sollten sich um den Marktstart und weitere Entwicklung von XDNA, Grundlagen und Einsatz drehen.

Und es gibt dabei bisher keinerlei Hinweise darauf, dass Vitis und ROCm zu einer art "AMDone API Plattform" in Analogie zu Koduris OneAPI bei Intel verschmolzen werden.

Momentan gibt es nichteinmal eine offizielle XDNA Dokumentation in Bezug auf die Ausprägung als RyzenAI während auch schon mit Verzögerung die Laptops bereits im Markt sind. Dass man bei Interesse an XDNA auf den Xilinx Developer Hub gehen muss wird nirgends erklärt, mangels Nennung der V70, XDNA oder RyzenAI in den Dokumentationen und Tutorials bleibt dort ebenso erstmal unklar wie denn nun RyzenAI genutzt werden sollte.

Es bleibt dabei - das ist bislang viel zu wenig, da ist null und nix aus der Produktentwicklung in die Dokumentation für Entwickler oder ins Marketing gegangen. Sind wir mal gespannt was diesen Monat, dieses Jahr noch kommt...

ROCm ist für die GPU Architekturen

Vitis AI ist für AI Beschleuniger Architekturen (von Xilinx)

Hier im Thread soll es um XDNA gehen.

TensorFlow, Pytorch, ONNX etc. sind Frameworks für die Programmierung, die in beiden SW-Plattformen von AMD(Xilinx) unterstützt werden.

Die Fragen hier sollten sich um den Marktstart und weitere Entwicklung von XDNA, Grundlagen und Einsatz drehen.

Und es gibt dabei bisher keinerlei Hinweise darauf, dass Vitis und ROCm zu einer art "AMDone API Plattform" in Analogie zu Koduris OneAPI bei Intel verschmolzen werden.

Momentan gibt es nichteinmal eine offizielle XDNA Dokumentation in Bezug auf die Ausprägung als RyzenAI während auch schon mit Verzögerung die Laptops bereits im Markt sind. Dass man bei Interesse an XDNA auf den Xilinx Developer Hub gehen muss wird nirgends erklärt, mangels Nennung der V70, XDNA oder RyzenAI in den Dokumentationen und Tutorials bleibt dort ebenso erstmal unklar wie denn nun RyzenAI genutzt werden sollte.

Es bleibt dabei - das ist bislang viel zu wenig, da ist null und nix aus der Produktentwicklung in die Dokumentation für Entwickler oder ins Marketing gegangen. Sind wir mal gespannt was diesen Monat, dieses Jahr noch kommt...

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.486

- Renomée

- 9.834

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Bitte nicht alles durcheinanderwerfen.

ROCm ist für die GPU Architekturen

Vitis AI ist für AI Beschleuniger Architekturen (von Xilinx)

Hier im Thread soll es um XDNA gehen.

TensorFlow, Pytorch, ONNX etc. sind Frameworks für die Programmierung, die in beiden SW-Plattformen von AMD(Xilinx) unterstützt werden.

Die Fragen hier sollten sich um den Marktstart und weitere Entwicklung von XDNA, Grundlagen und Einsatz drehen.

Und es gibt dabei bisher keinerlei Hinweise darauf, dass Vitis und ROCm zu einer art "AMDone API Plattform" in Analogie zu Koduris OneAPI bei Intel verschmolzen werden.

Es war ein kleiner Hint.

Übrigens hat AMD für den Unified AI Stack ja auch eine Version 1.0 vorgesehen.

Wir werden nächste Woche etwas schlauer sein.

E555user

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 05.10.2015

- Beiträge

- 2.173

- Renomée

- 938

Ende des Jahres ist eigentlich ein Jahr zu spät.

www.heise.de

www.heise.de

Ryzen 7040: Integrierte KI-Einheit anfangs mit limitierter Unterstützung

AMDs 2023er-Ryzen sind die ersten x86-Prozessoren mit integrierter KI-Einheit, doch diese krankt noch an Softwareunterstützung.

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.486

- Renomée

- 9.834

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Ende des Jahres ist eigentlich ein Jahr zu spät.

Immerhin suchen sie ja:

Career Opportunities | AMD Careers

AMD offers the opportunity to learn and build careers. Search for Opportunities to Apply Now.

knapp die Hälfte der Stellenausschreibungen bezieht sich auf Software.

Für den Adrenalin fällt noch eine Stelle ab.

Career Opportunities | AMD Careers

AMD offers the opportunity to learn and build careers. Search for Opportunities to Apply Now.

Gozu

Vice Admiral Special

- Mitglied seit

- 19.02.2017

- Beiträge

- 855

- Renomée

- 169

- Mein Laptop

- Asus ROG Zephyrus G14 2022 (GA402RJ-L8116W) / HP 15s-eq1158ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900

- Mainboard

- AsRock B550 Phantom Gaming Velocita

- Kühlung

- Coolermaster MASTERLIQUID 120

- Speicher

- 2x 16GB HyperX KHX3733C19D4/16GX 3733-19

- Grafikprozessor

- AsRock RX 6800 Phantom Gaming D 16G

- Display

- 27 " iiyama G-Master GB2760QSU WQHD

- HDD

- 2x WDC WD10EADS-11P8B1

- Optisches Laufwerk

- TSSTcorp CDDVDW SH-2

- Gehäuse

- CoolerMaster HAF XB

- Netzteil

- Enermax EDT1250EWT

- Maus

- Rocat Kova

- Betriebssystem

- Windows 10 Professional x64, Manjaro

- Webbrowser

- Iron

- Internetanbindung

- ▼1000 MBit ▲50 MBit

Erster Vergleich AMD vs NVDIA:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 5.050

- Renomée

- 496

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Samsung, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Dass die Anime-Augen mit dem doppelten Stromverbrauch besser aussehen sollen, kann aber nicht sein Ernst sein. Völlig verfälscht und auf den ersten Blick als Fake sichtbar. Für mich ist da Nvidia durchgefallen mit der Optik. Das subtile ist ja genau was man möchte, mit realistischen Augen - dann auch noch bei halbem Verbrauch. Damit ist Nvidias Technik eigentlich tot, da nur mit dedizierter GPU und doppeltem Stromverbrauch. Für unterwegs ohne Stromkabel nicht tauglich für Videokonferenzen.

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.134

- Renomée

- 993

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 5700X3D (100-100001503)

- Mainboard

- ASUS ProArt B550-Creator

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB (11324-01-20G)

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- Western Digital SN850X (WDS400T2XHE)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64) Xfce

- Verschiedenes

- ASUS TPM-SPI (Nuvoton NPCT750A)

Aus männlicher Sicht stimme ich dir zu, aber die Hälfte der Weltbevölkerung sieht es erfahrungsgemäß anders.Das subtile ist ja genau was man möchte, mit realistischen Augen - dann auch noch bei halbem Verbrauch.

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 443

- Antworten

- 44

- Aufrufe

- 2K

- Antworten

- 0

- Aufrufe

- 3K