App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

NVIDIA - Kepler

- Ersteller Desti

- Erstellt am

Neo

Moderator

☆☆☆☆☆☆

- Mitglied seit

- 21.02.2001

- Beiträge

- 7.177

- Renomée

- 141

- Standort

- ABI

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 1800X

- Mainboard

- MSI B550-A PRO

- Kühlung

- einer mit Lüfter :p

- Speicher

- 2x 8GB Crucial DDR4-2400

- Grafikprozessor

- Sapphire R9 270X

- Display

- 2x Acer 22" 16:19

- SSD

- SanDisk SDSSDP128G

- HDD

- 320GB (Samsung)

- Optisches Laufwerk

- LG-irgendwas

- Soundkarte

- Realtek ALC887 (OnBoard)

- Netzteil

- SeaSonic B12 BC-550

- Betriebssystem

- Windows 10

- Webbrowser

- EDGE

Also bei so etwas kann man nun noch den Kopf schütteln.

[...]

Mit dem Kopfschütteln solltest du mal zu Arzt gehen...[...]

Leute, es geht doch auch ohne sich gegenseitig zu beleidigen, oder? Danke

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.410

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Sicherlich kann die Titan die GTX690 ersetzen, spätestens mit halbiertem Speicher und einer Kühlung die den Dauer Turbo auf hohem Niveau zuläßt, die Preisfrage ist nur ob sie es auch wird.

Die GPU hat einfach das Potential in der Herstellung teurer zu kommen als 2 kleine.

Die GPU hat einfach das Potential in der Herstellung teurer zu kommen als 2 kleine.

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.015

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

Sicherlich kann die Titan die GTX690 ersetzen, spätestens mit halbiertem Speicher und einer Kühlung die den Dauer Turbo auf hohem Niveau zuläßt, die Preisfrage ist nur ob sie es auch wird.

Die GPU hat einfach das Potential in der Herstellung teurer zu kommen als 2 kleine.

so kompliziert war das gar nicht gedacht. ich quote mich mal passend dazu aus dem 3DC-thread.

ich war schon immer so eingestellt, dass mir spielgefühl "vor" frames geht. nur manchmal braucht man einfach mehr bums; allerdings ist das anwendungsgebiet bei MGPU zu beschränkt. das deckt im 24/7 -einsatz nur teilbereiche zufriedenstellend ab.

btw,

ich habe das zweifelhafte glück, dass hier von beamern bis TFTs und fernsehern alles auf FHD ausgerichtet ist. bissl 3DV dazu und natürlich schnelle schaltzeiten plus steinzeit-eingabegeräte -> immersion! und das auch mit der derzeit schnellsten single-GPU-karte.

in den ersten testläufen heute nacht habe ich bewusst gespielt und OSDs ausgelassen - das spielgefühl ist gut.

und wenn ein C3 nicht mit 8xMSAA + SSAA oder sonstwelchem brimborium läuft, dann ist das halt so. eine hohe einstellung mit AFR-stottern bei fixer FHD-auslösung ist für mein dafürhalten eher ein immersionskiller, als ne gemäßigte einstellung, die auf beiden lösungen läuft. und selbst wenn SGPU in jener dann nur mit 50fps rumkrebst, während MGPU noch 70fps schafft, so fühlen sich letztere nicht zwingend besser an. und das ist nunmal die krux.

edit:

beispiel bf3 letzte nacht:

2013-03-03 05:50:29 - bf3 (Karkand, 4xMSAA, ultra but FXAA low, Titan)

Frames: 6051 - Time: 55817ms - Avg: 108.408 - Min: 75 - Max: 141

so fühlen sich 75 minframes an? GEILO!!!!

aber moment.. *gtx690* rauskramt..

vergleichbares hatte ich doch vorher auch.. im januar schon..

2013-01-17 00:34:17 - bf3 (Karkand, 4xMSAA, ultra but FXAA low, GTX690)

Frames: 7603 - Time: 68157ms - Avg: 111.551 - Min: 79 - Max: 198

trotzdem, sowas von unterschiedlich im "gefühl" - 1:0 für titan. auf meiner strichliste...

(..)

mfg

tobi

(..)

mfg

tobi

Zuletzt bearbeitet:

G

Gast31082015

Guest

Wie schön das Gefühle nicht messbar sind, allenfalls blendbar

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.015

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

Wie schön das Gefühle nicht messbar sind, allenfalls blendbar

doch, vor dem AFR-kontext sind sie es (messbar) - nur erfordert es (das messen) einigen aufwand.

PC-perspective haben sich die arbeit gemacht - mit leicht vernichtendem ergebnis für crossfire.

http://www.forum-3dcenter.org/vbulletin/showthread.php?p=9665219#post9665219

und selbst printmedien sind allmählich bei ihren tests dazu übergegangen, subjektives stottern zu bewerten. PCGH

hat z.b. drei stufen.. von slight über moderate zu heavy -stuttering.

(..)

mfg

tobi

Zuletzt bearbeitet:

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.888

- Renomée

- 2.823

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Viel Spaß mit der Karte. Und ich bin mir sicher das man den hat wenn man die Spiele dafür zockt.

G

Gast31082015

Guest

Gefühle sind niemals messbar  Was messbar ist sind die Latenzen zwischen den einzelnen Frames bzw deren Abstände. Wie das aber jeder einzelne empfindet lässt sich nicht darlegen.

Was messbar ist sind die Latenzen zwischen den einzelnen Frames bzw deren Abstände. Wie das aber jeder einzelne empfindet lässt sich nicht darlegen.

Die Abstände sollte allerdings hier und da schon dargestellt werden.

Was messbar ist sind die Latenzen zwischen den einzelnen Frames bzw deren Abstände. Wie das aber jeder einzelne empfindet lässt sich nicht darlegen.

Was messbar ist sind die Latenzen zwischen den einzelnen Frames bzw deren Abstände. Wie das aber jeder einzelne empfindet lässt sich nicht darlegen.Die Abstände sollte allerdings hier und da schon dargestellt werden.

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.015

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

problem an der "messung" ist, dass auch frames gezählt werden, die nicht gezählt werden dürften, weil sie nicht sichbar sind.

warum habe ich wohl ins 3DC verlinkt -> weil es eben nicht trivial ist einen nachweis für ein schwaches spielgefühl zu erbringen. fraps starten und meinetwegen die frametimes auszuwerten täuscht über das eigentlich störende hinweg.

(..)

mfg

tobi

warum habe ich wohl ins 3DC verlinkt -> weil es eben nicht trivial ist einen nachweis für ein schwaches spielgefühl zu erbringen. fraps starten und meinetwegen die frametimes auszuwerten täuscht über das eigentlich störende hinweg.

(..)

mfg

tobi

Ich dachte, es wäre inzwischen auch beim Mädchen vom Land angekommen, dass man SingleGPU-Setups nicht mit MultiGPU-Setups vergleichen sollte....auch wenn Nvidia inzwischen viel verbessert hat was SLI angeht. (Crossfire ist sowieso nur eine Prothese...)

Dieser MultiGPU-Irrsinn verdankt sich ja auch nur der Benchmarkgeilheit, oder? Also ich glaube nach wie vor nicht, dass man zwischen 60 und 120 Bilder pro sekunde unterscheiden kann, wenn die Min Frames nicht unter 35 sinken, aber gut, sei´s drum. Möglicherweise bin ich auch bloß neidisch, dass ich nicht die Zeit habe, solche Benchmarks durchzuführen.

Ich will hier aber noch einwerfen, dass ich nicht sehe, wieso ein defizitäres Unternehmen wie AMD sich auf derartige Spielereien konzentrieren sollte. Für Nvidia ist Titan halt quasi ein Zuckerl, weil das Produkt im Profi-Segment wichtig ist. AMD ist da noch himmelweit hinterher und hat da insofern wohl auch keinen großen Markt, mit dem man sowas finanzieren könnte. Man wird sich da wohl auch eher auf Fusion/HSA konzentrieren, nicht auf reine HPC-GPUs.

Es ist also schön, wenn der Kunde sowas gerne hätte. Wenn das für das Unternehmen nichts bringt, dann kann sich nur ein Multimillionär sowas "wünschen" wenn er genug Geld dafür auf den Tisch legt. Ansonsten ist es sicherlich besser, sich auf die Bereich zu konzentrieren, wo man zumindest die Chance hat, Geld zu verdienen. Insofern ist es schön, dass diejenigen, die gerne nicht aufs GEld schauen, sich jetzt eine Titan kaufen und dann Benchmarks durchführen können.

Dieser MultiGPU-Irrsinn verdankt sich ja auch nur der Benchmarkgeilheit, oder? Also ich glaube nach wie vor nicht, dass man zwischen 60 und 120 Bilder pro sekunde unterscheiden kann, wenn die Min Frames nicht unter 35 sinken, aber gut, sei´s drum. Möglicherweise bin ich auch bloß neidisch, dass ich nicht die Zeit habe, solche Benchmarks durchzuführen.

Ich will hier aber noch einwerfen, dass ich nicht sehe, wieso ein defizitäres Unternehmen wie AMD sich auf derartige Spielereien konzentrieren sollte. Für Nvidia ist Titan halt quasi ein Zuckerl, weil das Produkt im Profi-Segment wichtig ist. AMD ist da noch himmelweit hinterher und hat da insofern wohl auch keinen großen Markt, mit dem man sowas finanzieren könnte. Man wird sich da wohl auch eher auf Fusion/HSA konzentrieren, nicht auf reine HPC-GPUs.

Es ist also schön, wenn der Kunde sowas gerne hätte. Wenn das für das Unternehmen nichts bringt, dann kann sich nur ein Multimillionär sowas "wünschen" wenn er genug Geld dafür auf den Tisch legt. Ansonsten ist es sicherlich besser, sich auf die Bereich zu konzentrieren, wo man zumindest die Chance hat, Geld zu verdienen. Insofern ist es schön, dass diejenigen, die gerne nicht aufs GEld schauen, sich jetzt eine Titan kaufen und dann Benchmarks durchführen können.

Zuletzt bearbeitet:

G

Gast31082015

Guest

Sobald Gefühle und Empfindungen ins Spiel kommen ist man so oder so außen vor. Das empfindet jeder User für sich und mitunter um Welten anders. Das gleiche Thema gibt es auch beim Sound

Neo

Moderator

☆☆☆☆☆☆

- Mitglied seit

- 21.02.2001

- Beiträge

- 7.177

- Renomée

- 141

- Standort

- ABI

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 1800X

- Mainboard

- MSI B550-A PRO

- Kühlung

- einer mit Lüfter :p

- Speicher

- 2x 8GB Crucial DDR4-2400

- Grafikprozessor

- Sapphire R9 270X

- Display

- 2x Acer 22" 16:19

- SSD

- SanDisk SDSSDP128G

- HDD

- 320GB (Samsung)

- Optisches Laufwerk

- LG-irgendwas

- Soundkarte

- Realtek ALC887 (OnBoard)

- Netzteil

- SeaSonic B12 BC-550

- Betriebssystem

- Windows 10

- Webbrowser

- EDGE

So, ich habe hier jetzt ein paar der AMD vs. NVIDIA Posts gelöscht. Leute, bleibt bitte beim Thema, und das lautet:

NVIDIA - Kepler

und nicht "Aber AMD hat trotzdem schnellere Karten"

NVIDIA - Kepler

und nicht "Aber AMD hat trotzdem schnellere Karten"

Duplex

Admiral Special

Nichts für ungut aber AMD hatte innerhalb ihrer Produktpalette einen größeren Leistungssprung vollzogen als nvida mit dem GK104.

Tahiti XT war zum Launch 40% schneller als der Vorgänger & GK104 war zum Launch 30% schneller als der Vorgänger, Tahiti XT ist 25% größer als GK104 & hat 50% mehr Bandbreite durch das größere SI, noch Fragen?

Nvidia hätte in 350mm² Fläche locker 10 SMX Cluster einbauen können, dann hätte man 1920 Shader, mit einem 384 Bit SI wäre die Karte ca. 10% schneller als eine 7970 Ghz.

In diesem Bereich haben Sie aber kaum was zu sagen, der Marktanteil ist zu gering, Nvidia hat über 80% Marktanteil in diesem Segment.Amd hat den größten sprung bei gpgpu vollzogen und das ist für die strategie wichtig.

Das war früher so, aber seit GK104 nicht mehr.Tja offensichtlich kriegt AMD mehr funktionierende Chips aus einem Wafer raus als Nvidia. Was traditionell eigentlich immer der Fall war, wenn man Insidern glauben darf.

Die Radeon verursacht deutlich mehr Produkionskosten als die Geforce, witzig finde ich das die GTX680 dann noch 100 Euro mehr kostet. Nvidia verdient mit GK104 richtig viel Geld. Außerdem ist jetzt 28nm HP nicht teurer als 40nm HP.

GK104

294 mm² DIE

256 Bit SI

2GB GDDR5

Tahiti

365mm² DIE

384 Bit SI

3GB GDDR5

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Hast du eine Quelle für diese Behauptung? Yield der Kepler GPUs? Und verursacht nun der Marketingbegriff "Radeon" Mehrkosten oder welcher spezielle Chips sollte das sein? Ach was solls, genug Ironie.Das war früher so, aber seit GK104 nicht mehr.

Die Radeon verursacht deutlich mehr Produkionskosten als die Geforce, witzig finde ich das die GTX680 dann noch 100 Euro mehr kostet.

Dass du Unsinn schreibst geht ja alleine schon dadurch hervor, dass unter "Radeon" mehrere Generationen und Dutzende von verschiedenen Chips firmieren.

.

EDIT :

.

Siehst du und schon sind die Tahitis günstiger zu produzieren - ich geh jetzt mal solange von den von mir in rot hinzugefügten Werten aus, bis du mir das Gegenteil beweist

GK104

294 mm² DIE

256 Bit SI

2GB GDDR5

15 funktionierende Chips pro Wafer

Tahiti

365mm² DIE

384 Bit SI

3GB GDDR5

25 funktionierende Chips pro Wafer

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.888

- Renomée

- 2.823

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Hat der Modpost euch nicht gereicht oder warum macht ihr damit weiter?

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Da wir hier über Kepler Yields und Kosten in deren Herstellung sprechen, finde ich deinen Vergleich mit der vorhergehenden Benchmark Diskussion unpassend.

Neo

Moderator

☆☆☆☆☆☆

- Mitglied seit

- 21.02.2001

- Beiträge

- 7.177

- Renomée

- 141

- Standort

- ABI

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 1800X

- Mainboard

- MSI B550-A PRO

- Kühlung

- einer mit Lüfter :p

- Speicher

- 2x 8GB Crucial DDR4-2400

- Grafikprozessor

- Sapphire R9 270X

- Display

- 2x Acer 22" 16:19

- SSD

- SanDisk SDSSDP128G

- HDD

- 320GB (Samsung)

- Optisches Laufwerk

- LG-irgendwas

- Soundkarte

- Realtek ALC887 (OnBoard)

- Netzteil

- SeaSonic B12 BC-550

- Betriebssystem

- Windows 10

- Webbrowser

- EDGE

Über Yields und Kosten kann man reden, solange das nicht in ein gestreite darüber endet, wer denn nun "besser" ist

Achja, und der Ton macht die Musik....

Achja, und der Ton macht die Musik....

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.888

- Renomée

- 2.823

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Da es keiner weiß ist es müßig sich da mit Spekulationen hoch zu schaukeln, und die vermutete Ausbeute von AMD ist auch im entsprechenden Thread besser aufgehoben.

Tatsache ist dagegen das nv im letzten Quartal sehr gut verdient hat.

Tatsache ist dagegen das nv im letzten Quartal sehr gut verdient hat.

War das nicht so, dass größere Chips häufiger von Defekten betroffen sein könnten als kleinere Chips?Siehst du und schon sind die Tahitis günstiger zu produzieren - ich geh jetzt mal solange von den von mir in rot hinzugefügten Werten aus, bis du mir das Gegenteil beweist

NOFX

Grand Admiral Special

- Mitglied seit

- 02.09.2002

- Beiträge

- 4.532

- Renomée

- 287

- Standort

- Brühl

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Spinhenge

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600 @Stock

- Mainboard

- ASUS B350M-A

- Kühlung

- Boxed-Kühler

- Speicher

- 2x 8 G.Skill RipJaws 4 rot DDR4-2800 DIMM

- Grafikprozessor

- PowerColor Radeon RX 480 Red Dragon 8GB

- Display

- LG 34UM-68 (FreeSync)

- SSD

- PowerColor Radeon RX 480 Red Dragon 8GB

- HDD

- 1x 1,5TB Seagate S-ATA

- Optisches Laufwerk

- DVD-Brenner

- Soundkarte

- onBoard

- Gehäuse

- Thermaltake Versa H15

- Netzteil

- Cougar SX 460

- Betriebssystem

- Windows 10 Pro x64

- Webbrowser

- Google Chrome

Kommt darauf an, wieviel an Redundanzen vorgesehen und verbaut sind, um Fehler zu kompensieren.War das nicht so, dass größere Chips häufiger von Defekten betroffen sein könnten als kleinere Chips?

Kann durchaus sein, dass Tahiti mehr enthält, weil AMD den für eine noch nicht besonders ausgereifte 28nm-Fertigung ausgelegt hat. Ist der Prozess dann schlechter als erwartet und man hat nicht so viel eingeplant, kann auch ein kleinerer Chip (z.B. GK104) ein schlechteres Yield haben.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Vor allem wenn man schon 8 Monate länger Produkte in der Fertigungsgröße ausliefert, spricht es dafür, dass man die spezifischen Probleme der Kombinatrion Architektur<->Fertigung früher gelöst hat und länger Optimierungen implementieren konnte.

Richtig ist dass ein größerer Chip bei gleicher Fehlerzahl pro Wafer einen größeren Auschuß bedeutet. Halbiert man die Fehlerzahl wegen gut angepasster Architektur, dann kann man auch mit größerem Chip mehr Ausbeute erreichen.

Was Nvidia mit Kepler definitv angegangen ist und verbessert hat, ist die Größe des Chips. Das bedeutet nicht dass Sie die Fertigungscharakteristiken besser gelöst haben, wofür die monatelange Verspätung in 28nm ja deutlich spricht. Aber ein erster Schritt ist ja getan mit dem GK104 - mit dem GK110 kommt allerdings wieder das alte Nvidia durch.

Richtig ist dass ein größerer Chip bei gleicher Fehlerzahl pro Wafer einen größeren Auschuß bedeutet. Halbiert man die Fehlerzahl wegen gut angepasster Architektur, dann kann man auch mit größerem Chip mehr Ausbeute erreichen.

Was Nvidia mit Kepler definitv angegangen ist und verbessert hat, ist die Größe des Chips. Das bedeutet nicht dass Sie die Fertigungscharakteristiken besser gelöst haben, wofür die monatelange Verspätung in 28nm ja deutlich spricht. Aber ein erster Schritt ist ja getan mit dem GK104 - mit dem GK110 kommt allerdings wieder das alte Nvidia durch.

mariahellwig

Grand Admiral Special

Wenn das so weiter geht wird nVidia bald Schwierigkeiten haben seine Aufpreise zu rechtfertigen.

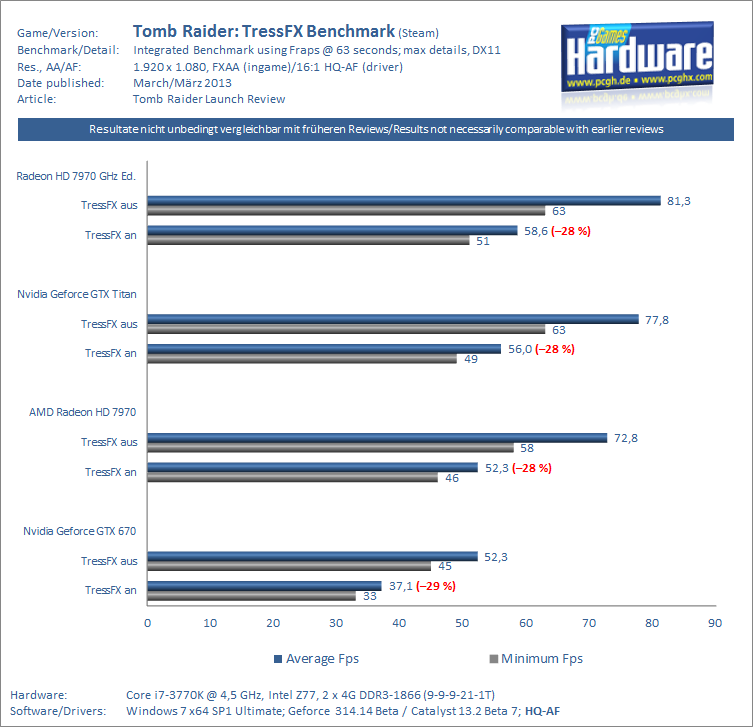

Tomb Raider zeigt schonungslos die GPGPU-Schwächen der GTX680.

http://www.pcgameshardware.de/AMD-R...mb-Raider-PC-Grafikkarten-Benchmarks-1058878/

Nicht die Performance begeistert nicht gerade, auch die Treiberfehler sind nicht gerade Premium.

Tomb Raider zeigt schonungslos die GPGPU-Schwächen der GTX680.

http://www.pcgameshardware.de/AMD-R...mb-Raider-PC-Grafikkarten-Benchmarks-1058878/

Nicht die Performance begeistert nicht gerade, auch die Treiberfehler sind nicht gerade Premium.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Naja Tomb Raider hat wohl jetzt kaum einen anderen Stellenwert als gutes Marketing für AMD. Warten wir mal 4 Wochen ab wie es dann aussieht, wenn Nvidia Gelegenheit hatte Treiber nachzubessern.

mariahellwig

Grand Admiral Special

680GTX GPGPU Schwächen in TR?

Irgendwie gibt das der verlinkte Artikel nicht her.

Nein?

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 410

- Antworten

- 1

- Aufrufe

- 452

)

)