App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

nVidia Geforce RTX 4060/4070/4080/4090 (Ti/Super) (Ada/PCIe 4.0): Tests/Meinungen im Netz. Links in Post 1

- Ersteller eratte

- Erstellt am

Gozu

Vice Admiral Special

- Mitglied seit

- 19.02.2017

- Beiträge

- 521

- Renomée

- 70

- Mein Laptop

- Asus ROG Zephyrus G14 2022 (GA402RJ-L8116W) / HP 15s-eq1158ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900

- Mainboard

- AsRock B550 Phantom Gaming Velocita

- Kühlung

- Coolermaster MASTERLIQUID 120

- Speicher

- 2x 16GB HyperX KHX3733C19D4/16GX 3733-19

- Grafikprozessor

- AsRock RX 6800 Phantom Gaming D 16G

- Display

- 27 " iiyama G-Master GB2760QSU WQHD

- HDD

- 2x WDC WD10EADS-11P8B1

- Optisches Laufwerk

- TSSTcorp CDDVDW SH-2

- Gehäuse

- CoolerMaster HAF XB

- Netzteil

- Enermax EDT1250EWT

- Maus

- Rocat Kova

- Betriebssystem

- Windows 10 Professional x64, Manjaro

- Webbrowser

- Iron

- Internetanbindung

- ▼1000 MBit ▲50 MBit

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

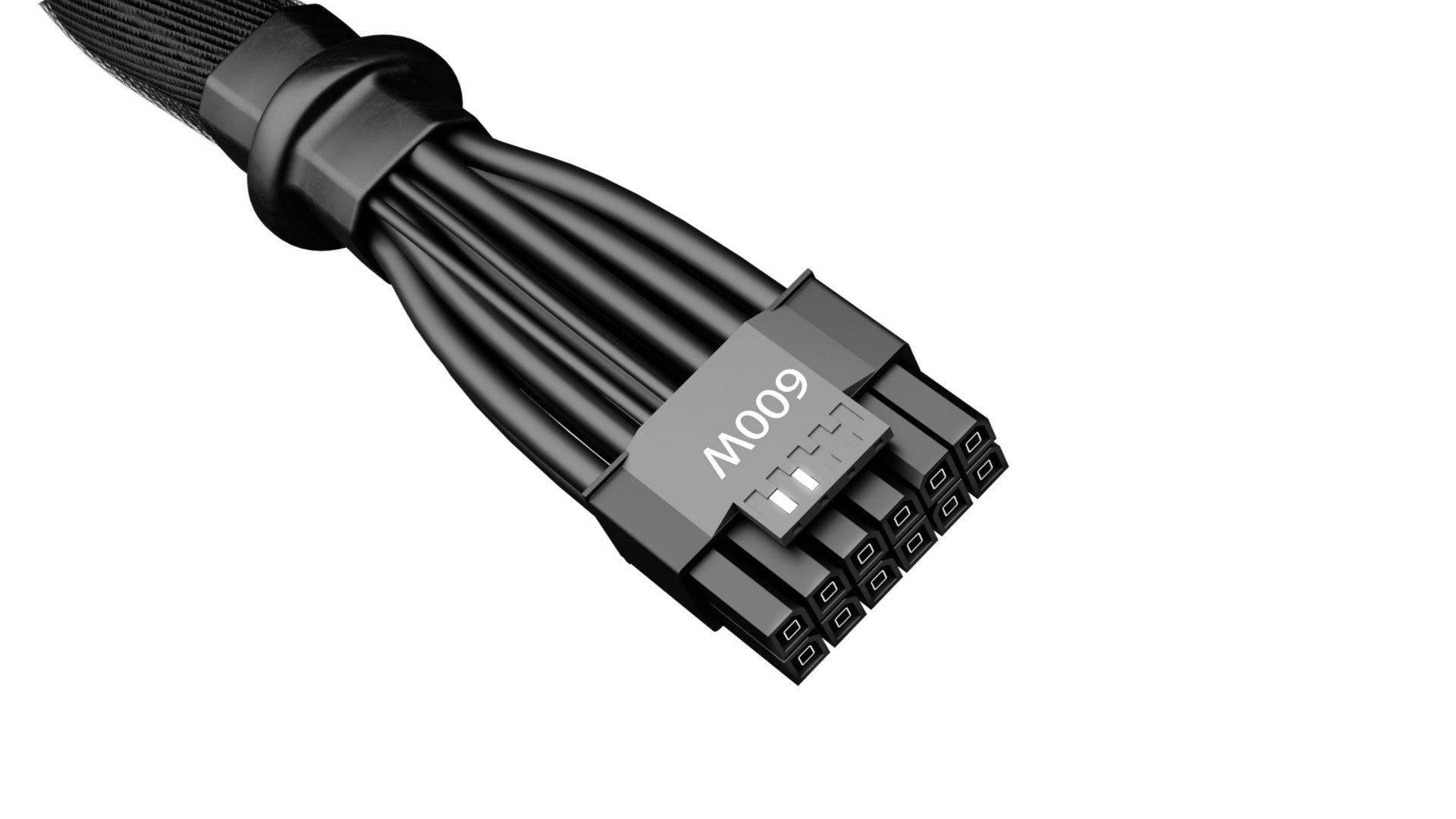

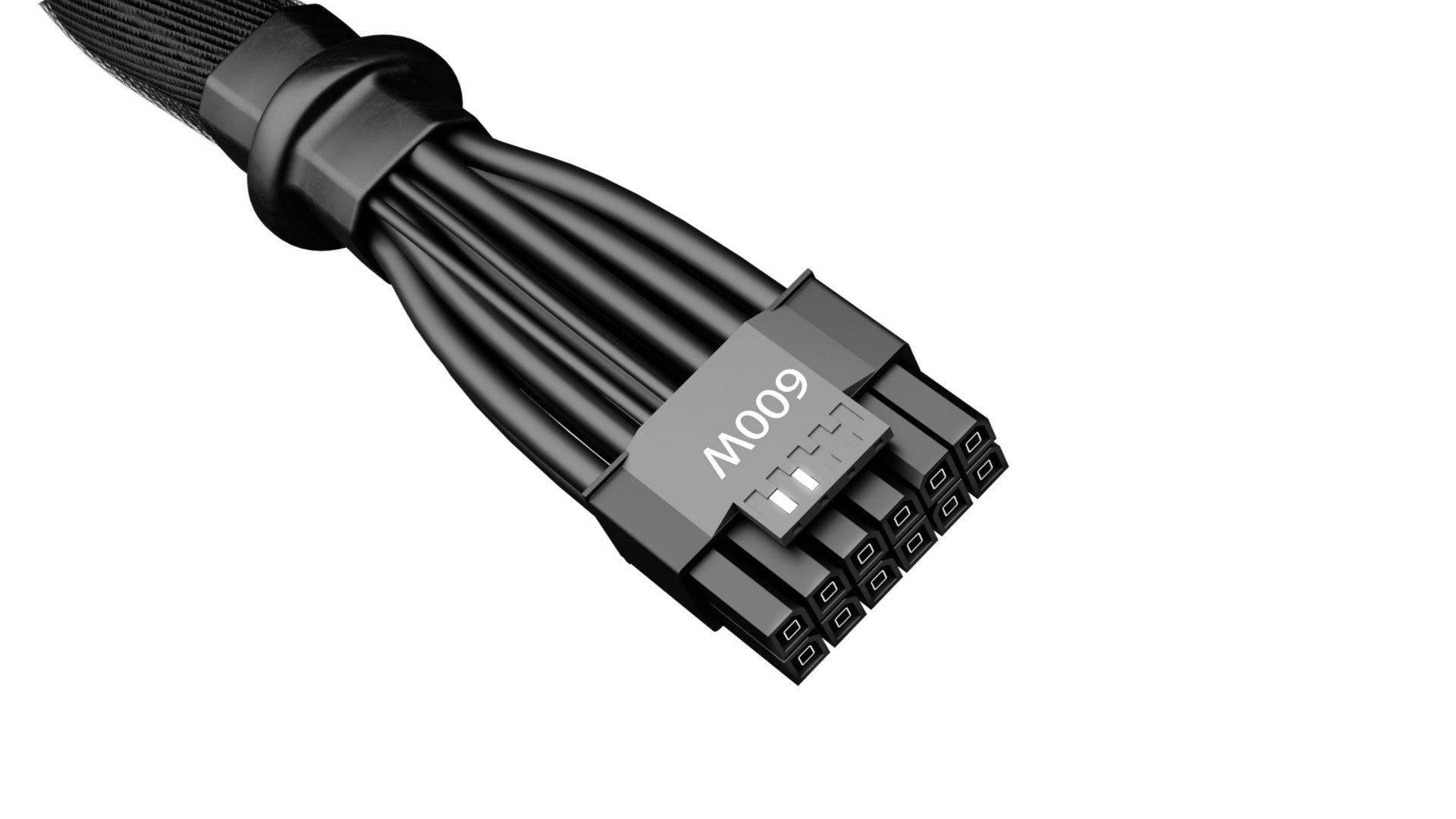

Rest in Peace 12VHPWR Connector – Willkommen 12V-2×6 Connector, wichtige Modifikationen und PCIe Base 6 | Exklusiv (igor'sLAB)

Für die nicht Videofreunde (oder die bei Youtube "schwarz" sehen wegen AD Blocker).

Das der Herr gerne gegen andere austeilt ist ja nicht neu, macht ihn für mich ziemlich unsympatisch.

Für die nicht Videofreunde (oder die bei Youtube "schwarz" sehen wegen AD Blocker).

Das der Herr gerne gegen andere austeilt ist ja nicht neu, macht ihn für mich ziemlich unsympatisch.

Mente

Grand Admiral Special

- Mitglied seit

- 23.05.2009

- Beiträge

- 3.671

- Renomée

- 135

- Aktuelle Projekte

- constalation astroids yoyo

- Lieblingsprojekt

- yoyo doking

- Meine Systeme

- Ryzen 3950x

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD 5800X3D

- Mainboard

- Asus ROG Crosshair VIII Dark Hero

- Kühlung

- Headkiller IV

- Speicher

- 3800CL14 G.Skill Trident Z silber/rot DIMM Kit 32GB, DDR4-3600, CL15-15-15-35 (F4-3600C15D-16GTZ)

- Grafikprozessor

- AMD Radeon RX 6900 XT Ref. @Alphacool

- Display

- MSI Optix MAG27CQ

- SSD

- SN8502TB,MX5001TB,Vector150 480gb,Vector 180 256gb,Sandisk extreme 240gb,RD400 512gb

- HDD

- n/a

- Optisches Laufwerk

- n/a

- Soundkarte

- Soundblaster X4

- Gehäuse

- Phanteks Enthoo Pro 2 Tempered Glass

- Netzteil

- Seasonic Prime GX-850 850W

- Tastatur

- Logitech G19

- Maus

- Logitech G703

- Betriebssystem

- Win 10 pro

- Webbrowser

- IE 11 Mozilla Opera

- Verschiedenes

- Logitech PRO RENNLENKRAD DD

Hi,

ich sage mal so gut das sie es endlich ändern den in dem Punkt das der Stecker nicht gut war sind wir uns wohl einig.

Nachdem ich mit dem Anschluss einige Systeme gebaut haben, kann ich das auch sehr gut verstehen das es einfach Quark war

und man sich echt Fragt warum das Konsortium um PCIE das so überhaupt rausgegeben hatte ...

lg

ich sage mal so gut das sie es endlich ändern den in dem Punkt das der Stecker nicht gut war sind wir uns wohl einig.

Nachdem ich mit dem Anschluss einige Systeme gebaut haben, kann ich das auch sehr gut verstehen das es einfach Quark war

und man sich echt Fragt warum das Konsortium um PCIE das so überhaupt rausgegeben hatte ...

lg

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Nicht das erste mal bei einem der Mitglieder - vermutlich wollte die PCI-Sig eine Situation vermeiden, wie es der VESA passiert ist mit GSync. So passiert das dann typischerweise.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.387

- Renomée

- 1.983

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

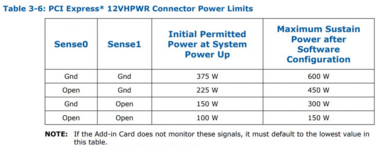

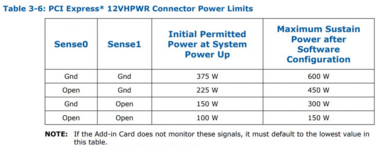

Irgendwie habe ich den Einwand mit der Pinbelegung des Sense Steckers nicht verstanden.

Von den vorhandenen 4 Pins werden bisher nur 2 genutzt und selbst mit denen sollen beim 12VHPWR Stecker

die Ausgangsleistungen von 600W, 450W, 300W und 150W abgedeckt sein. Für die Geforce Karten wurde halt nur die 600W und die 450W Einstellung verwendet und will man bei der neuen Ausführung kompatibel sein müßte das auch beibehalten werden.

www.allround-pc.com

www.allround-pc.com

Von den vorhandenen 4 Pins werden bisher nur 2 genutzt und selbst mit denen sollen beim 12VHPWR Stecker

die Ausgangsleistungen von 600W, 450W, 300W und 150W abgedeckt sein. Für die Geforce Karten wurde halt nur die 600W und die 450W Einstellung verwendet und will man bei der neuen Ausführung kompatibel sein müßte das auch beibehalten werden.

Intel ATX 3.1: Tschüss 12VHPWR, Hallo 12V-2x6-Stecker

Für Grafikkarten steht eine neue Form der Stromversorgung an, denn mit PCI-Express 5.0 soll auch der 12VHPWR-Stecker kommen.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Heimlicher Wechsel an den Sense-Pins schon ab der GeForce RTX 4070 FE und niemand hat es bemerkt (igor'sLAB)

ZOTAC GAMING GeForce RTX 4060 Twin Edge OC White Edition Review (TweakTown)

Doppelposting wurde automatisch zusammengeführt:

ZOTAC GAMING GeForce RTX 4060 Twin Edge OC White Edition Review (TweakTown)

Zuletzt bearbeitet:

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

hier fällt das produkt-upsampling der aktuellen generation halt am deutlichsten auf und nvidia am härtesten auf die füße.

wenn gn und andere bereits die 4060 ti eigentlich als 4050 eingestuft haben, was wäre dann dieses modell geworden? als 4050 oder ti wären beide karten zum richtigen preis durchaus interessant. aber so wird nur die abgehobenheit und der größenwahn von nvidia zur schau gestellt.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Mal schauen was sich nvidia noch so alles einfallen lässt bis 2025 - in Kürze dann die 4060 Ti 16GB für 100 € Aufpreis.

wenn jensen vor ein paar wochen noch betonen musste, dass gamer nvidia immer noch wichtig sind, dann weiß man, dass das angesichts der aktuellen entwicklung längst nicht mehr stimmt ... sinnlose lippenbekenntnisse.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.387

- Renomée

- 1.983

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Man muss die Fans eben an der Stange halten um sie weiter melken zu können und Worte sind billig. ^^

GeForce RTX 4060 Ti 16 GB: Nvidia hat keine Lust auf Tests des VRAM-Knüppels

Am 18. Juli soll die GeForce RTX 4060 Ti 16 GB erscheinen. Und zwar sang- und klanglos, wie allmählich deutlich wird.

Beeskeeper-40

Lieutnant

- Mitglied seit

- 22.06.2023

- Beiträge

- 62

- Renomée

- 29

die liegt wie Blei in den Regalen, 128Bit Interface dafür brauch ich keine 16GB

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.387

- Renomée

- 1.983

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Die Breite vom Interface ist dafür erstmal egal denn der VRAM ist so oder so erheblich schneller als als der Zugriff auf den Bereich der in den RAM ausgelagert wird.

Nvidia hat das Ding u.A. mit der Preisgestaltung offenbar künstlich uninteressant gemacht um später sagen zu können das es keine Nachfrage dafür gab und weiterhin mit der VRAM Krüppel Taktik zum möglichst zeitigen Austausch fortfahren zu können.

Nvidia hat das Ding u.A. mit der Preisgestaltung offenbar künstlich uninteressant gemacht um später sagen zu können das es keine Nachfrage dafür gab und weiterhin mit der VRAM Krüppel Taktik zum möglichst zeitigen Austausch fortfahren zu können.

Beeskeeper-40

Lieutnant

- Mitglied seit

- 22.06.2023

- Beiträge

- 62

- Renomée

- 29

1. eh viel zu teuer die Karten,

2.16GB brauchte keine dermaßen kastrierte GPU

3. ich spiele lieber mit meiner 3080TI

2.16GB brauchte keine dermaßen kastrierte GPU

3. ich spiele lieber mit meiner 3080TI

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.387

- Renomée

- 1.983

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das ist leider ein Mythos der immer wieder gern am Leben erhalten wird.2.16GB brauchte keine dermaßen kastrierte GPU

Texturen fressen z.B. viel Platz im VRAM aber so gut wie keine GPU Leistung. Das merkt man allerdings erst wenn genug davon da ist. ^^

Sollte also bei einem Spiel die Framerate bei der bloßen Erhöhung der Texturendetails merklich einbrechen dann tut es das für gewöhnlich nur weil zu wenig VRAM vorhanden ist und die GPU durch die Auslagerung in den erheblich langsameren RAM entsprechend lange auf die Daten warten muss.

Das perfide daran ist also das man den großen VRAM nicht bemerkt, die Auswirkungen des zu kleinen VRAM hingegen sehr wohl.

alles kein problem, nur einzelfälle. und laut gn ist der vor allem der user selbst schuld. na denn brauchts ja keine neuen stecker.

www.pcgameshardware.de

www.pcgameshardware.de

nach der 4070 und ti, die die modifikationen wohl schon von haus aus hatten, scheint nvidia nun auch bei anderen modellen den stecker zu ersetzen.

Geforce RTX 4090 Founders Edition mit neuem Stecker

Im Internet ist ein Bild der Geforce RTX 4090 Founders Edition mit neuem Stecker aufgetaucht.

nach der 4070 und ti, die die modifikationen wohl schon von haus aus hatten, scheint nvidia nun auch bei anderen modellen den stecker zu ersetzen.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Zotac GeForce RTX 4070 AMP Airo Review (TechPowerUp)

Zu dem hat er ja die Änderungen schon vor 7 Monaten gefordert :

:

Doppelposting wurde automatisch zusammengeführt:

Nun da Tech Jesus macht er niemals Fehler und muss daher auch nicht zugeben das er mal falsch lag.und laut gn ist der vor allem der user selbst schuld

Zu dem hat er ja die Änderungen schon vor 7 Monaten gefordert

:

:

Zuletzt bearbeitet:

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.877

- Renomée

- 2.822

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

Galax Geforce RTX 4060 8GB EX White review (guru3d)

Colorful iGame GeForce RTX 4060 Ti Ultra W Duo OC Review (TechPowerUp)

NVIDIA GeForce RTX 4060 Ti 16GB Review—Not (TechPowerUp)

Das Gehabe dieser Firma kotzt nur noch an.

Nvidia GeForce RTX 4060 vs. GeForce RTX 4060 Ti, 40 Game Benchmark: 1080p & 1440p (Hardware Unboxed)

Doppelposting wurde automatisch zusammengeführt:

Colorful iGame GeForce RTX 4060 Ti Ultra W Duo OC Review (TechPowerUp)

NVIDIA GeForce RTX 4060 Ti 16GB Review—Not (TechPowerUp)

Das Gehabe dieser Firma kotzt nur noch an.

Doppelposting wurde automatisch zusammengeführt:

Nvidia GeForce RTX 4060 vs. GeForce RTX 4060 Ti, 40 Game Benchmark: 1080p & 1440p (Hardware Unboxed)

Zuletzt bearbeitet:

Thunderbird 1400

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 17.976

- Renomée

- 316

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7800X3D

- Mainboard

- Gigabyte X670E Aorus Pro X

- Kühlung

- Corsair H115i Pro AiO Wakü

- Speicher

- 32GB G.Skill Trident Z5 DDR5-7200 CL34

- Grafikprozessor

- RTX4080 Super (Gigabyte Aero OC)

- Display

- 55" TV & Leinwand

- SSD

- 2TB Samsung 980 Pro (M.2), 2x 2TB Transcent (M.2), 1TB Crucial MX500 (SATA)

- HDD

- 2TB

- Soundkarte

- Realtek Onboard

- Gehäuse

- Fractal Design North XL (white)

- Netzteil

- 850W be quiet! Pure Power 12M ATX3.0

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Firefox

- Verschiedenes

- Meta Quest 3

Soll ihr Dreck doch in den Lagern verstauben.

Das Gehabe dieser Firma kotzt nur noch an.

es will ja niemand etwas unterstellen ... aber die (zurückhaltende) gereiztheit diverser redaktionen bei diesem thema zeigt imho, dass trotz aller beteuerungen von unabhängigkeit und objektivität viele eben doch stark von der nvidia-bemusterung abhängig sind. da hält man sich dann doch lieber bewusst oder unbewusst mit kritik zurück.

aber so wie sich nvidia teilweise aufführt, sollten die herrschaften sich vielleicht drauf einstellen, dass nvidia das zukünftig immer häufiger so macht. so wie nvidia eigentlich keinen bock mehr auf die eigenen board-partner hat, so wenig bock haben sie auf unabhängige berichterstattung. die wollen lieber eine eigene hofberichterstattung. ein bißchen wie apple halt, nur noch unsympathischer.

da ist es bei aller kritik dann doch ganz gut, wenn bestimmte influencer ihre hardware selbst kaufen, auch wenn es dann evtl. keine reviews direkt zum launch gibt.

Ähnliche Themen

- Antworten

- 1K

- Aufrufe

- 72K

- Antworten

- 227

- Aufrufe

- 24K

- Antworten

- 2K

- Aufrufe

- 113K

- Antworten

- 51

- Aufrufe

- 7K

- Antworten

- 54

- Aufrufe

- 6K