App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

NVIDIA - Kepler

- Ersteller Desti

- Erstellt am

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

Schau dir die Werte doch an, der prozentuale Leistungsverlust ist im integrierten Benchmark identisch - was für Nvidia spricht, denn bei Direct Compute und Open CL ist idR die HD 7970 GE deutlich schneller.Tomb Raider zeigt schonungslos die GPGPU-Schwächen der GTX680.

Zuletzt bearbeitet:

ONH

Grand Admiral Special

Schiele ich oder was, die gtx680 hat ganz ander resultate und prozentuale einbusse. Was man auch erahnen könnte wenn man sieht das nur die Titan und 670 verglichen werden und die ggtx680 nur in der umfangreicheren Tabelle vorkommt wo man mit und ohne Tresfx nicht ohne weiteres vergleichbar sind.

Zuletzt bearbeitet:

Markus Everson

Grand Admiral Special

Könnte ein Mod bescheid geben wenn die üblichen Verdächtigen ihren Genitalienvergleich beendet und die Hosen wieder zugeknüpft haben?

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

Beim internen Bench ist nur die GTX 670 dabei, ja. Aber warum sollte eine schnellere GTX 680 stärker einbrechen als eine GTX 670? Tut sie nicht, d.h. der Einbruch ist genauso hoch wie bei der HD 7970 GE.Schiele ich oder was, die gtx680 hat ganz ander resultate und prozentuale einbusse. Was man auch erahnen könnte wenn man sieht das nur die Titan und 670 verglichen werden und die ggtx680 nur in der umfangreicheren Tabelle vorkommt wo man mit und ohne Tresfx nicht ohne weiteres vergleichbar sind.

Guck dir aber zudem mal die Ingame-Benches weiter unten an, da bricht eine GTX 680/670 stärker ein als eine HD 7970 GE (allerdings nur um rund sechs Prozent, was sicherlich keine "Schwäche" ist) - im internen Benchmark wie gesagt nicht.

HD 7970 GE ohne/mit Tress FX (Avg-Fps) = 80,6 vs 59,0 (73,2 %)

GTX 680 ohne/mit Tress FX (Avg-Fps) = 80,3 vs 54,1 (67,4 %)

GTX 670 ohne/mit Tress FX (Avg-Fps) = 76,0 vs 50,7 (66,7 %)

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Es sind immer die selben die den selben Nagel in jeden Thread hämmern.Könnte ein Mod bescheid geben wenn die üblichen Verdächtigen ihren Genitalienvergleich beendet und die Hosen wieder zugeknüpft haben?

Markus Everson

Grand Admiral Special

Ja, das ist mir auch schon aufgefallen.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

So kurz nach dem Verkausstart sind doch solche Bugs nicht ungewöhnlich!Wenn das so weiter geht wird nVidia bald Schwierigkeiten haben seine Aufpreise zu rechtfertigen.

Tomb Raider zeigt schonungslos die GPGPU-Schwächen der GTX680.

http://www.pcgameshardware.de/AMD-R...mb-Raider-PC-Grafikkarten-Benchmarks-1058878/

Nicht die Performance begeistert nicht gerade, auch die Treiberfehler sind nicht gerade Premium.

Jetzt lass nvidia mal ordentlich den Treiber anpassen, oder meinetwegen auch ein Patch fürs Spiel, so ganz Perfekt ist es noch nicht, auch nicht mit AMD only Hardware.

Aber, die angesprochene GPGPU Schwäche gibt es, aber nicht bei TressFX.

Da muss man schon ein wenig in de Profi Bereich gehen, z.B. beim Rendern:

http://www.hardwareluxx.de/index.ph...-geforce-gtx-titan-im-3-way-sli.html?start=16

mariahellwig

Grand Admiral Special

So kurz nach dem Verkausstart sind doch solche Bugs nicht ungewöhnlich!

Laut nVidia soll es dafür keine schnelle Lösung geben. Das Problem ließe sich nicht allein über den Treiber lösen, hier wären Anpassungen am Code notwendig.

Mit nVidias Anspruch auf Premiumprodukte lässt sich das nicht vereinbaren. Bei der Konkurrenz gibt es funktionierende Produkte.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

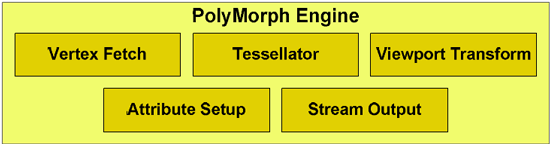

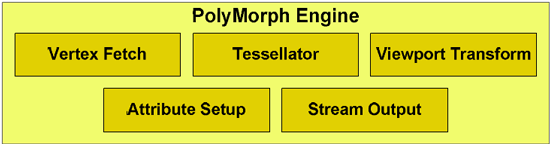

Hmm damit stellt sich das ganze schon anders dar. Da die probleme sich umgehen lassen mit dem deaktivieren von Tesselation, könnte ich mir vorstellen dass dies mit der Hardware-Implementierung zu tun haben könnte. Ich kann mich noch gut daran erinnern wie es die Diskussion gab ob Nvidia überhaupt Tesselation richtig umgesetzt hat und "echte" DX11 Hardware anbietet, als sie sich entschlossen keine seperate Tesselation Unit zu verwenden, sondern mehrere Tesselatoren in den Polymporphen Engines:

http://www.anandtech.com/show/2977/...tx-470-6-months-late-was-it-worth-the-wait-/5

Dies könnte sich nun rächen, wegen einer vielleicht unsauberen Hardware-Implementierung.

Edit:

Es scheint hier auch nur wenig Veränderung gegeben haben gegenüber Fermi in Version 2.0 auf Kepler:

http://www.anandtech.com/show/5699/nvidia-geforce-gtx-680-review/2

http://www.anandtech.com/show/2977/...tx-470-6-months-late-was-it-worth-the-wait-/5

As we covered in our GF100 Recap, NVIDIA seeks to separate themselves from AMD in spite of the rigid feature set imposed by DirectX 11. Tessellation is one of the ways they intend to do that, as the DirectX 11 standard leaves them plenty of freedom with respect to tessellation performance. To accomplish this goal, NVIDIA needs significantly better tessellation performance, which has lead to them having 14/15/16 tesselators through having that many PolyMorph Engines. With

Dies könnte sich nun rächen, wegen einer vielleicht unsauberen Hardware-Implementierung.

Edit:

Es scheint hier auch nur wenig Veränderung gegeben haben gegenüber Fermi in Version 2.0 auf Kepler:

http://www.anandtech.com/show/5699/nvidia-geforce-gtx-680-review/2

Because NVIDIA still only has a single Polymorph Engine per SMX, the number of Polymorph Engines hasn’t been doubled like most of the other hardware in an SMX. Instead the capabilities of the Polymorph Engine itself have been doubled, making each Polymorph Engine 2.0 twice as powerful as a GF114 Polymorph Engine. In absolute terms, this means each Polymorph Engine can now spit out a polygon in 2 cycles, versus 4 cycles on GF114, for a total of 4 polygons/clock across GK104.

Zuletzt bearbeitet:

MusicIsMyLife

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.02.2002

- Beiträge

- 15.580

- Renomée

- 2.569

- Standort

- in der Nähe von Cottbus

- Lieblingsprojekt

- Asteroids@Home

- Meine Systeme

- Alltags-PC, Test-PC (wechselnde Hardware)

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Desktopsystem

- Alltags-PC

- Mein Laptop

- HP DV7-2225sg

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X

- Mainboard

- ASRock B650M PG Riptide

- Kühlung

- Watercool Heatkiller IV Pro Copper

- Speicher

- 2x 32 GB G.Skill TridentZ 5 TGB (F5-6000J3040G32X2-TZ5RS)

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- ASUS ROG PG42UQ (3840x2160), Philips BDM4065UC (3840x2160), Samsung C27HG70 (2560x1440)

- SSD

- Micron 9300 Pro 7,68 TB (U.2), Samsung 850 Evo 4 TB (SATA)

- HDD

- keine, SSD only...

- Optisches Laufwerk

- LG CH08LS10 Blu-ray Disc-Player

- Soundkarte

- Creative SoundBlasterX AE-5 Plus

- Gehäuse

- Dimastech BenchTable EasyXL (vorübergehend)

- Netzteil

- Corsair RM850i

- Tastatur

- ASUS ROG Strix Flare

- Maus

- Steelseries Sensei 310

- Betriebssystem

- Windows 10 Professional

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

- Internetanbindung

- ▼250 MBit ▲45 MBit

Hmm damit stellt sich das ganze schon anders dar. Da die probleme sich umgehen lassen mit dem deaktivieren von Tesselation, könnte ich mir vorstellen dass dies mit der Hardware-Implementierung zu tun haben könnte.

Im 3DCenter berichten User, dass sich die Probleme umgehen lassen.

Einer hat einen älteren Treiber installiert und das Tomb Raider-Profil des aktuellen Treibers importiert und es läuft mit Tesselation und imho auch TressFX. Zwar etwas langsamer, aber statil.

Ein weiterer User hat das Problem gelöst, indem er das Profil für Tomb Raider gelöscht hat und dei EXE von TR dem Profil von Hitman Absolution hinzugefügt hat. Auch dort soll es mit Tesselation und Co. keine Probleme mehr geben.

Sollte das flächendeckend stimmen, dann liegt es "lediglich" am Treiber.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Na dann hat sich Nvidia aber keinen Gefallen gemacht mit der Aussage es würde nicht am Treiber liegen, sondern der Code müsse geändert werden.

eratte

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 11.11.2001

- Beiträge

- 21.861

- Renomée

- 2.815

- Standort

- Rheinberg / NRW

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- YoYo, Collatz

- Lieblingsprojekt

- YoYo

- Meine Systeme

- Wegen der aktuellen Lage alles aus.

- BOINC-Statistiken

- Mein Laptop

- Lenovo ThinkPad E15 Gen4 Intel / HP PAVILION 14-dk0002ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 7950X

- Mainboard

- ASUS ROG Crosshair X670E Hero

- Kühlung

- Noctua NH-D15

- Speicher

- 2 x 32 GB G.Skill Trident Z DDR5 6000 CL30-40-40-96

- Grafikprozessor

- Sapphire Radeon RX7900XTX Gaming OC Nitro+

- Display

- 2 x ASUS XG27AQ (2560x1440@144 Hz)

- SSD

- Samsung 980 Pro 1 TB & Lexar NM790 4 TB

- Optisches Laufwerk

- USB Blu-Ray Brenner

- Soundkarte

- Onboard

- Gehäuse

- NEXT H7 Flow Schwarz

- Netzteil

- Corsair HX1000 (80+ Platinum)

- Tastatur

- ASUS ROG Strix Scope RX TKL Wireless / 2. Rechner&Server Cherry G80-3000N RGB TKL

- Maus

- ROG Gladius III Wireless / 2. Rechner&Server Sharkoon Light2 180

- Betriebssystem

- Windows 11 Pro 64

- Webbrowser

- Firefox

- Verschiedenes

- 4 x BQ Light Wings 14. 1 x NF-A14 Noctua Lüfter. Corsair HS80 Headset .

- Internetanbindung

- ▼VDSL 100 ▲VDSL 100

MusicIsMyLife

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.02.2002

- Beiträge

- 15.580

- Renomée

- 2.569

- Standort

- in der Nähe von Cottbus

- Lieblingsprojekt

- Asteroids@Home

- Meine Systeme

- Alltags-PC, Test-PC (wechselnde Hardware)

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Desktopsystem

- Alltags-PC

- Mein Laptop

- HP DV7-2225sg

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X

- Mainboard

- ASRock B650M PG Riptide

- Kühlung

- Watercool Heatkiller IV Pro Copper

- Speicher

- 2x 32 GB G.Skill TridentZ 5 TGB (F5-6000J3040G32X2-TZ5RS)

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- ASUS ROG PG42UQ (3840x2160), Philips BDM4065UC (3840x2160), Samsung C27HG70 (2560x1440)

- SSD

- Micron 9300 Pro 7,68 TB (U.2), Samsung 850 Evo 4 TB (SATA)

- HDD

- keine, SSD only...

- Optisches Laufwerk

- LG CH08LS10 Blu-ray Disc-Player

- Soundkarte

- Creative SoundBlasterX AE-5 Plus

- Gehäuse

- Dimastech BenchTable EasyXL (vorübergehend)

- Netzteil

- Corsair RM850i

- Tastatur

- ASUS ROG Strix Flare

- Maus

- Steelseries Sensei 310

- Betriebssystem

- Windows 10 Professional

- Webbrowser

- Firefox

- Schau Dir das System auf sysprofile.de an

- Internetanbindung

- ▼250 MBit ▲45 MBit

Na dann hat sich Nvidia aber keinen Gefallen gemacht mit der Aussage es würde nicht am Treiber liegen, sondern der Code müsse geändert werden.

Ich habe gerade nochmal den Thread auf 3DC gelesen. Es scheint so, als seien mit den Workarounds nicht alle Probleme zu beheben, da einige weiterhin bzw. von neuen Problemen berichten.

Insofern muss ich meine Vermutung wohl etwas revidieren. Scheint doch mehr als eine reine Treibergeschichte zu sein.

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

dann ist es bestimmt taktik, dass AMD mir meinen key für tombraider noch immer nicht geschickt hat.. auch wenn mir nicht ganz aufgeht, was die davon hätten.. *gg*

naja.. spaß beiseite.. schade um das spiel - hatte mich drauf gefreut.. aber vllt. gibts ja einen patch + ein treiber-update, bis ich endlich den hochlegalen key für das spiel erhalte.. falls das noch geschieht..

AMD habe ich am 5.3. angemailt, wo mein code bleibt (never settle bundle) - gestern kam eine automatische antwort, dass meine anfrage innerhalb von 24-48 std beantwortet wird. dehne ich das zeitfenster etwas aus, dann fallen die 48std ins wochenende und wahrscheinlich wird das dann vor montag wieder nix.

(..)

mfg

tobi

naja.. spaß beiseite.. schade um das spiel - hatte mich drauf gefreut.. aber vllt. gibts ja einen patch + ein treiber-update, bis ich endlich den hochlegalen key für das spiel erhalte.. falls das noch geschieht..

AMD habe ich am 5.3. angemailt, wo mein code bleibt (never settle bundle) - gestern kam eine automatische antwort, dass meine anfrage innerhalb von 24-48 std beantwortet wird. dehne ich das zeitfenster etwas aus, dann fallen die 48std ins wochenende und wahrscheinlich wird das dann vor montag wieder nix.

(..)

mfg

tobi

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

@Tobi

Die Codes sollten doch vom Händler beim Verkauf übergeben werden ? Scheint aber einige Probleme zu geben.

http://www.fudzilla.com/home/item/30700-not-all-rosy-with-amd-never-settle-reloaded

Ich drück mal die Daumen, dass es klappt.

Zu NVIDIA und PhysX auf PS4 hat Fudzilla auch einen Artikel.

http://www.fudzilla.com/home/item/30702-nvidia-hops-on-playstation-4-train

Die Codes sollten doch vom Händler beim Verkauf übergeben werden ? Scheint aber einige Probleme zu geben.

http://www.fudzilla.com/home/item/30700-not-all-rosy-with-amd-never-settle-reloaded

Ich drück mal die Daumen, dass es klappt.

Zu NVIDIA und PhysX auf PS4 hat Fudzilla auch einen Artikel.

http://www.fudzilla.com/home/item/30702-nvidia-hops-on-playstation-4-train

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

ja, die liegen im karton.. aber nicht "die" (plural) sondern halt nur einer (singular) und damit registriert man sich bei AMD für das never-settle-bundle.

dann bekommt man eine bestätigungsmail und wartet sich den wolf..

(..)

mfg

tobi

dann bekommt man eine bestätigungsmail und wartet sich den wolf..

(..)

mfg

tobi

TobiWahnKenobi

Grand Admiral Special

- Mitglied seit

- 11.08.2004

- Beiträge

- 7.014

- Renomée

- 153

- Standort

- Hannover

- Mein Laptop

- Macbook Pro 13" Retina BTO /i7

- Details zu meinem Desktop

- Prozessor

- Intel Core i9 14900K

- Mainboard

- Z790 (Asrock)

- Kühlung

- H2O

- Speicher

- 48GB DDR5 7000 (40-52-52-52-114)

- Grafikprozessor

- 24GiB NVidia Geforce RTX 4090 OC

- Display

- 55" LG OLED C9 | 140" Acer DLP-3D

- SSD

- 8TB NVMe RAID + 3TB NVMe + 4TB SATA SSD

- HDD

- 36TB

- Optisches Laufwerk

- Bluray RW

- Soundkarte

- HDMI (Dolby Atmos @Yamaha AVR 5.2.2) / ALC / Hercules DJ Instinct Mixer

- Gehäuse

- Thermal Take X71

- Netzteil

- 1200W Corsair

- Tastatur

- Corsair K68 und originale von Cherry

- Maus

- Logitech G502

- Betriebssystem

- Windows 11

- Webbrowser

- Firefox

- Verschiedenes

- DVB-C, x10 Remote, XBox-Elite-Pad, Grafiktablet, Hercules DJ Instinct, iP2500, Fritzbox, Drucker, Oculus Rift VR

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Ja das schon, aber wenn nvidia den Code erst letztes Wochenende bekommen hat, zaubern können die auch nicht.Laut nVidia soll es dafür keine schnelle Lösung geben. Das Problem ließe sich nicht allein über den Treiber lösen, hier wären Anpassungen am Code notwendig.

Mit nVidias Anspruch auf Premiumprodukte lässt sich das nicht vereinbaren. Bei der Konkurrenz gibt es funktionierende Produkte.

PhysX ist doch schon lange bestandteil mancher Spiele, also bei mir ist PhysX installiert. (z.B: wegen Metro2033)Zu NVIDIA und PhysX auf PS4 hat Fudzilla auch einen Artikel.

http://www.fudzilla.com/home/item/30702-nvidia-hops-on-playstation-4-train

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Meine Recherche ergibt, dass TressFX wohl in erster Linie auf Order Independent Transperancy basiert (OIT)

http://blogs.amd.com/play/tressfx/

Das hat AMD mit der HD5000 eingeführt es findet auch schon im Mecha Demo Anwendung:

http://developer.amd.com/resources/...deon-hd-5000-series-graphics-real-time-demos/

Die mit Direct Compute anschließend berechnenden Feinabstimmungen kommen auch bei DoF zum Einsatz und werden hier beim Lady Bug Demo auch schon genutzt.

Und Nvidia hat ebenfalls seit 2007 OIT im Programm (Präsentation aus 2008: http://www.slideshare.net/acbess/order-independent-transparency-presentation). Das Problem hierbei scheint allerdings zu sein, dass dies kein DX11 Feature ist, sondern jeder Hersteller eigene Implementierungen genutzt hat bisher. Bis dato war es auch nicht sinnvoll nutzbar ohne zu grosse Performance einbussen, was AMD scheinbar gelöst hat.

Dass Tesselation Auswirkungen hat mag mit der Reihenfolge der Pipeline zu tun haben und somit bei Nvidia Probleme verursachen. Siehe dazu: http://scalibq.wordpress.com/2012/0...tion-is-not-i-repeat-not-different-from-amds/

http://blogs.amd.com/play/tressfx/

Das hat AMD mit der HD5000 eingeführt es findet auch schon im Mecha Demo Anwendung:

http://developer.amd.com/resources/...deon-hd-5000-series-graphics-real-time-demos/

Die mit Direct Compute anschließend berechnenden Feinabstimmungen kommen auch bei DoF zum Einsatz und werden hier beim Lady Bug Demo auch schon genutzt.

Und Nvidia hat ebenfalls seit 2007 OIT im Programm (Präsentation aus 2008: http://www.slideshare.net/acbess/order-independent-transparency-presentation). Das Problem hierbei scheint allerdings zu sein, dass dies kein DX11 Feature ist, sondern jeder Hersteller eigene Implementierungen genutzt hat bisher. Bis dato war es auch nicht sinnvoll nutzbar ohne zu grosse Performance einbussen, was AMD scheinbar gelöst hat.

Dass Tesselation Auswirkungen hat mag mit der Reihenfolge der Pipeline zu tun haben und somit bei Nvidia Probleme verursachen. Siehe dazu: http://scalibq.wordpress.com/2012/0...tion-is-not-i-repeat-not-different-from-amds/

Diese Reihenfolge ist universell bei alle GPUs so. Doch die Nvidia Tesselatoren sind auf den SMX von Kepler verbaut und AMDs OIT fügt vor der Tesselation stage zusätzliche Details hinzu. AMDs Tesselator ist nicht verteilt und kann wahrscheinlich somit damit besser umgehen, während Nvidias Pipeline die zusätzlichen Informationen ja auf alle 14/15/16 Tesselatoren verteilen muss-und dafür wird es vermutlich keine Steuerbefehle geben im Code.yVertex shader -> Hull shader -> Tessellator -> Domain Shader -> Geometry Shader -> Pixel shader

Oi!Olli

Grand Admiral Special

- Mitglied seit

- 24.12.2006

- Beiträge

- 16.413

- Renomée

- 782

- Mein Laptop

- HP Elitebook 8760W

- Details zu meinem Desktop

- Prozessor

- Ryzen R7 5800X3D

- Mainboard

- Asus B 550 Strix F Wifi

- Kühlung

- Noctua NH-U12A

- Speicher

- 2x 32 GB Kingston FURY DIMM DDR4 3600

- Grafikprozessor

- XFX Speedster MERC 310 Radeon RX 7900 XT Black Edition

- Display

- Acer Predator XB253QGP

- SSD

- Samsung 980 Pro 2 TB, Samsung 970 Evo Plus 2 TB

- HDD

- Samsung TB, 2x2 TB 1x3 TB 1x8 TB

- Optisches Laufwerk

- GH-22NS50

- Soundkarte

- Soundblaster Recon 3d

- Gehäuse

- Raijintek Zofos Evo Silent

- Netzteil

- BeQuiet Straight Power 750 Platinum

- Betriebssystem

- Windows 10 Pro

- Webbrowser

- Opera 101 (der Browser aktualisiert sich natürlich immer)

- Verschiedenes

- X-Box One Gamepad, MS Sidewinder Joystick

mariahellwig

Grand Admiral Special

@Complicated

Dank für die Aufklärung.

Dank für die Aufklärung.

MP05

Lieutnant

- Mitglied seit

- 29.12.2008

- Beiträge

- 65

- Renomée

- 8

- Mein Laptop

- Acer Aspire TimelineX 3820TG

- Details zu meinem Desktop

- Prozessor

- AMD Phenom II 955 @ 3,8 GHz, Stock VCore

- Mainboard

- Gigabyte GA-MA770T-UD3

- Kühlung

- Alpenföhn Groß Clockner

- Speicher

- 2x 2 GB G Skill DDR3-1600 CL9

- Grafikprozessor

- Gainward Radeon HD4850 GS 512 MB

- Display

- Samsung 2333HD 1920x1080

- HDD

- 2 TB Samsung + 500GB WD + 1 TB WD eSATA

- Optisches Laufwerk

- LG GH-22L2P0 DVD-Brenner

- Soundkarte

- Onboard Realtek ALC888

- Gehäuse

- Sharkoon Rebel 9 Economy

- Netzteil

- Chieftec GPS-450AA

- Betriebssystem

- Windows XP SP3 + Windows 7 Professional

- Webbrowser

- Firefox 5

Hallo,

Ich muss deiner Theorie leider widersprechen. Zunächst einmal ist Order-Independent-Transparency viel mehr die Bezeichnung für eine Reihe von Algorithmen für ein Problem in der Computergrafik als für einen konkreten Algorithmus. Das Problem ist, dass Alpha-Blending eine nicht kommuntative Operation ist(die Reihenfolge in der die Farbwerte kombiniert werden ist entscheidend). Wenn man also z.B. 3 verschiedene transparente Objekte hat, ensteht je nach Render-Reihenfolge eine andere Farbe. Ein Lösungsansatz ist also die 3 Objekte einfach nach der Entfernung zur Kamera zu sortieren. Das ist aber zum einen sehr rechenaufwändig und zum anderen keine Lösung Falls die Objekte sich gegenseitig schneiden und so keine eindeutige Sortierung möglich ist.

Order-Indepent-Transparancy soll eben genau dafür sorgen, dass die transparenten Objekte in beliebiger Reihenfolge gerendent werden können und die Alpha-Blending-Operation dennoch in korrekter Reihenfolge ausgeführt werden.

Ein Lösungsansatz dazu ist Depth-Peeling(die von die verlinkte NVidia-Präsi zeigt eine verbesserte Version dieses Algorithmus). Dabei wird die gesamte Geometrie mehrfach gezeichnet. Bei jedem Schritt wird immer der Farbwert sowie die Entfernung des Pixels, der der Kamera am nächsten ist, gespeichert. Bei jedem weiteren Schritt werden immer die Entfernungen des vorherigen Schritts verwendet um alle Pixel zu verwerfen, die bereits erfasst wurden(die Entfernung ist kleiner/gleich der Entfernung aus dem vorherigen Schritt).

Man erhält am Ende eine Reihe von Farbbildern die sozusagen die Tiefenschichten der Szene darstellen. Im ersten Bild sind also alle Pixel die der Kamera am nächsten sind, dann die, die am zweitnächsten sind usw. Am Ende muss man nur diese Bilder nacheinander mit Alpha-Blending verrechnen um das endgültige Bild zu erhalten.

Die Technik von AMD geht einen völlig anderen Weg, da es ein neues Feature von DirectX 11 nutzt, die sogenannten Append-/Consume-Buffer(sozusagen Bilder mit Listen pro Pixel, also ein Pixel kann beliebig viele Farbwerte speichern). Dabei muss die Geometrie nur ein einziges mal gerendert werden und anstatt nur einen Farbwert pro Pixel, pro Renderingpass speicher zu können, ist es nun möglich eine Liste von Farbwerten zu speichern. Man rendert also im wesentlichen die Geometrie merkt sich dabei die Farbe mit zugehörigen Tiefenwert in einer Liste für jeden Bildschirm-Pixel. In einem zweiten Schritt muss man nur jede Pixel-Liste der Tiefe nach sortieren und die Farben entsprechend mit Alpha-Blending verrechnen. Vorteil dieser Technik ist es, dass die Geometrie nur einmal gerendert werden muss und lediglich der Pixel-Shader etwas aufwendiger ist.

Die Technik funktioniert aber auf absolut jeder Hardware die DirectX 11(bzw. auch mit OpenGL 4.2) unterstützt und ist nicht AMD-exklusiv. Außerdem läuft die Technik vollständig im Pixel-Shader ab, weswegen sie auch keinen Einfluss auf die Tesselierung hat. Das Problem muss also an einer anderen Stelle entstehen.

Grüße

Marcel

Meine Recherche ergibt, dass TressFX wohl in erster Linie auf Order Independent Transperancy basiert (OIT)

http://blogs.amd.com/play/tressfx/

Das hat AMD mit der HD5000 eingeführt es findet auch schon im Mecha Demo Anwendung:

http://developer.amd.com/resources/...deon-hd-5000-series-graphics-real-time-demos/

Die mit Direct Compute anschließend berechnenden Feinabstimmungen kommen auch bei DoF zum Einsatz und werden hier beim Lady Bug Demo auch schon genutzt.

Und Nvidia hat ebenfalls seit 2007 OIT im Programm (Präsentation aus 2008: http://www.slideshare.net/acbess/order-independent-transparency-presentation). Das Problem hierbei scheint allerdings zu sein, dass dies kein DX11 Feature ist, sondern jeder Hersteller eigene Implementierungen genutzt hat bisher. Bis dato war es auch nicht sinnvoll nutzbar ohne zu grosse Performance einbussen, was AMD scheinbar gelöst hat.

Dass Tesselation Auswirkungen hat mag mit der Reihenfolge der Pipeline zu tun haben und somit bei Nvidia Probleme verursachen. Siehe dazu: http://scalibq.wordpress.com/2012/0...tion-is-not-i-repeat-not-different-from-amds/

Diese Reihenfolge ist universell bei alle GPUs so. Doch die Nvidia Tesselatoren sind auf den SMX von Kepler verbaut und AMDs OIT fügt vor der Tesselation stage zusätzliche Details hinzu. AMDs Tesselator ist nicht verteilt und kann wahrscheinlich somit damit besser umgehen, während Nvidias Pipeline die zusätzlichen Informationen ja auf alle 14/15/16 Tesselatoren verteilen muss-und dafür wird es vermutlich keine Steuerbefehle geben im Code.

Ich muss deiner Theorie leider widersprechen. Zunächst einmal ist Order-Independent-Transparency viel mehr die Bezeichnung für eine Reihe von Algorithmen für ein Problem in der Computergrafik als für einen konkreten Algorithmus. Das Problem ist, dass Alpha-Blending eine nicht kommuntative Operation ist(die Reihenfolge in der die Farbwerte kombiniert werden ist entscheidend). Wenn man also z.B. 3 verschiedene transparente Objekte hat, ensteht je nach Render-Reihenfolge eine andere Farbe. Ein Lösungsansatz ist also die 3 Objekte einfach nach der Entfernung zur Kamera zu sortieren. Das ist aber zum einen sehr rechenaufwändig und zum anderen keine Lösung Falls die Objekte sich gegenseitig schneiden und so keine eindeutige Sortierung möglich ist.

Order-Indepent-Transparancy soll eben genau dafür sorgen, dass die transparenten Objekte in beliebiger Reihenfolge gerendent werden können und die Alpha-Blending-Operation dennoch in korrekter Reihenfolge ausgeführt werden.

Ein Lösungsansatz dazu ist Depth-Peeling(die von die verlinkte NVidia-Präsi zeigt eine verbesserte Version dieses Algorithmus). Dabei wird die gesamte Geometrie mehrfach gezeichnet. Bei jedem Schritt wird immer der Farbwert sowie die Entfernung des Pixels, der der Kamera am nächsten ist, gespeichert. Bei jedem weiteren Schritt werden immer die Entfernungen des vorherigen Schritts verwendet um alle Pixel zu verwerfen, die bereits erfasst wurden(die Entfernung ist kleiner/gleich der Entfernung aus dem vorherigen Schritt).

Man erhält am Ende eine Reihe von Farbbildern die sozusagen die Tiefenschichten der Szene darstellen. Im ersten Bild sind also alle Pixel die der Kamera am nächsten sind, dann die, die am zweitnächsten sind usw. Am Ende muss man nur diese Bilder nacheinander mit Alpha-Blending verrechnen um das endgültige Bild zu erhalten.

Die Technik von AMD geht einen völlig anderen Weg, da es ein neues Feature von DirectX 11 nutzt, die sogenannten Append-/Consume-Buffer(sozusagen Bilder mit Listen pro Pixel, also ein Pixel kann beliebig viele Farbwerte speichern). Dabei muss die Geometrie nur ein einziges mal gerendert werden und anstatt nur einen Farbwert pro Pixel, pro Renderingpass speicher zu können, ist es nun möglich eine Liste von Farbwerten zu speichern. Man rendert also im wesentlichen die Geometrie merkt sich dabei die Farbe mit zugehörigen Tiefenwert in einer Liste für jeden Bildschirm-Pixel. In einem zweiten Schritt muss man nur jede Pixel-Liste der Tiefe nach sortieren und die Farben entsprechend mit Alpha-Blending verrechnen. Vorteil dieser Technik ist es, dass die Geometrie nur einmal gerendert werden muss und lediglich der Pixel-Shader etwas aufwendiger ist.

Die Technik funktioniert aber auf absolut jeder Hardware die DirectX 11(bzw. auch mit OpenGL 4.2) unterstützt und ist nicht AMD-exklusiv. Außerdem läuft die Technik vollständig im Pixel-Shader ab, weswegen sie auch keinen Einfluss auf die Tesselierung hat. Das Problem muss also an einer anderen Stelle entstehen.

Grüße

Marcel

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.371

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Gibt es die gleichen Probleme bei der Fermi Architektur?

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 407

- Antworten

- 1

- Aufrufe

- 446