App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD Kabini APU / Jaguar CPU + Graphics Core Next GPU, 2-4 Kerne, 28nm TSMC, 2013

- Ersteller Duplex

- Erstellt am

Markus Everson

Grand Admiral Special

Wenn es was zu tun gibt ist der entscheidende Faktor. Das ist beim Browsen und Texteditor eben nicht der Fall.

Aber selbstverständlich gibt es dabei was zu tun. Sonst würde kein Tastendruck ausgewertet, keine Mausbewegung überwacht, kein Bild gescrollt, kein Byte übertragen.

Dazu kommt noch das weder Dein Browser noch Dein Texteditor unter DOS laufen. Alle danach folgenden OS laufen im Multitasking und verbraten zu jedem Zeitpunkt eine unglaubliche Menge an CPU-Zyklen ohne das Du oder ich etwas davon bemerken oder das auch nur gut finden.

Idle ist ein Mythos aus vergangenen Zeiten, als Männer noch richtige Männer waren!

mariahellwig

Grand Admiral Special

Seht euch doch einfach mal die Verteilung der Rechenzeit an. Da kommt erst der Leerlaufprozess, dann lange Zeit nichts und dann vielleicht etwas anderes

Aber selbst die Verteilung der Rechenzeit muss berechnet werden  . Das ist minimal im Verhältnis aber vorhanden, die CT hat mal die Akkuzeiten im Leerlauf zwischen Win und Linux verglichen, müssten ja gleich sein wenn absolut nichts passiert, ist aber natürlich nicht so ( OSX und Win geht natürlich auch ).

. Das ist minimal im Verhältnis aber vorhanden, die CT hat mal die Akkuzeiten im Leerlauf zwischen Win und Linux verglichen, müssten ja gleich sein wenn absolut nichts passiert, ist aber natürlich nicht so ( OSX und Win geht natürlich auch ).

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Jup. Deshalb ist es nicht unbedingt zutreffend, wenn jemand pauschal behauptet, Teillast oder Volllast wäre wichtiger als Idle. Dennoch sollte man sich darüber im Klaren sein, dass der Prozessor mit Last mehr Energie braucht als im Wartezustand. Egal welcher Takt anliegt, also auch mit Idle-Takt. Der Grund dafür wurde weiter vorne genannt, CMOS.Seht euch doch einfach mal die Verteilung der Rechenzeit an. Da kommt erst der Leerlaufprozess, dann lange Zeit nichts und dann vielleicht etwas anderes

Zuletzt bearbeitet:

Opteron

Redaktion

☆☆☆☆☆☆

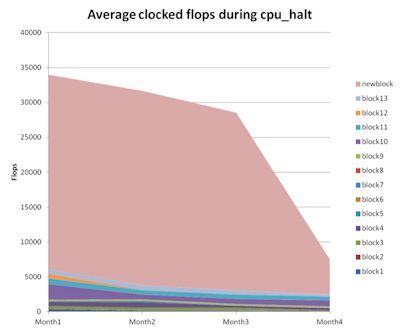

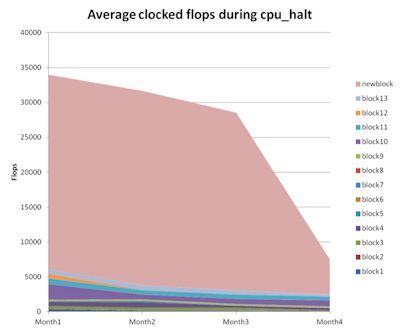

Interessanter Artikel auf eetimes vom AMD Entwickler wie bei jaguar der Stromverbrauch durch Simulationen gesenkt werden konnte:

http://www.eetimes.com/design/eda-d...rocessor-core-with-RTL-clock-gating-analysis-

http://www.eetimes.com/design/eda-d...rocessor-core-with-RTL-clock-gating-analysis-

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Einige Übersichten sind recht interessant.

So wenig scheint der Cache (hier L2 Controller) unter Idle doch nicht auszumachen, wie einige immer behaupten.

Sieht in der Theorie nach ~85% weniger Energie unter Idle für den Jaguar Kern aus. 15% mehr IPC und 25% weniger Energie für typische Anwendungen schaut nach ~50% besserer Effizienz aus. Nicht schlecht! Auch wenn es sich bezogen aufs gesamte Design wieder etwas relativieren wird, hier scheint AMD ein super Wurf gelungen zu sein. Ich nehme mal an, dass das wirklich nur die architektonischen Verbesserungen sind und Verbesserungen durch die 28 nm Fertigung noch hinzukommen.

So wenig scheint der Cache (hier L2 Controller) unter Idle doch nicht auszumachen, wie einige immer behaupten.

Sieht in der Theorie nach ~85% weniger Energie unter Idle für den Jaguar Kern aus. 15% mehr IPC und 25% weniger Energie für typische Anwendungen schaut nach ~50% besserer Effizienz aus. Nicht schlecht! Auch wenn es sich bezogen aufs gesamte Design wieder etwas relativieren wird, hier scheint AMD ein super Wurf gelungen zu sein. Ich nehme mal an, dass das wirklich nur die architektonischen Verbesserungen sind und Verbesserungen durch die 28 nm Fertigung noch hinzukommen.

BavarianRealist

Grand Admiral Special

- Mitglied seit

- 06.02.2010

- Beiträge

- 3.358

- Renomée

- 80

...Sieht in der Theorie nach ~85% weniger Energie unter Idle für den Jaguar Kern aus. 15% mehr IPC und 25% weniger Energie für typische Anwendungen schaut nach ~50% besserer Effizienz aus. Nicht schlecht! Auch wenn es sich bezogen aufs gesamte Design wieder etwas relativieren wird, hier scheint AMD ein super Wurf gelungen zu sein...

Insbesondere, wenn man berücksichtigt, wie gut Brazos diesbezüglich schon ist. Ein solcher Fortschritt wäre schon gewaltig. Die Performance/Watt wird vor allem für bestimmte Server immer interessanter. Mit dem Jaguar-Core könnte AMD womöglich endlich mal wieder ein richtig gutes Produkt besitzen; hoffentlich!

tomturbo

Technische Administration, Dinosaurier

- Mitglied seit

- 30.11.2005

- Beiträge

- 9.455

- Renomée

- 665

- Standort

- Österreich

- Aktuelle Projekte

- Universe@HOME, Asteroids@HOME

- Lieblingsprojekt

- SETI@HOME

- Meine Systeme

- Xeon E3-1245V6; Raspberry Pi 4; Ryzen 1700X; EPIC 7351

- BOINC-Statistiken

- Mein Laptop

- Microsoft Surface Pro 4

- Details zu meinem Desktop

- Prozessor

- R7 5800X

- Mainboard

- Asus ROG STRIX B550-A GAMING

- Kühlung

- Alpenfön Ben Nevis Rev B

- Speicher

- 2x32GB Mushkin, D464GB 3200-22 Essentials

- Grafikprozessor

- Sapphire Radeon RX 460 2GB

- Display

- BenQ PD3220U, 31.5" 4K

- SSD

- 1x HP SSD EX950 1TB, 1x SAMSUNG SSD 830 Series 256 GB, 1x Crucial_CT256MX100SSD1

- HDD

- Toshiba X300 5TB

- Optisches Laufwerk

- Samsung Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Define R4

- Netzteil

- XFX 550W

- Tastatur

- Trust ASTA mechanical

- Maus

- irgend eine silent Maus

- Betriebssystem

- Arch Linux, Windows VM

- Webbrowser

- Firefox + Chromium + Konqueror

- Internetanbindung

-

▼300

▲50

Für welche Server?Die Performance/Watt wird vor allem für bestimmte Server immer interessanter.

Für die die langsam sein sollen? Hm, wer braucht die?

Ich sah noch niemanden auf langsame Server umstellen, Du etwa?

hoschi_tux

Grand Admiral Special

- Mitglied seit

- 08.03.2007

- Beiträge

- 4.763

- Renomée

- 287

- Standort

- Ilmenau

- Aktuelle Projekte

- Einstein@Home, Predictor@Home, QMC@Home, Rectilinear Crossing No., Seti@Home, Simap, Spinhenge, POEM

- Lieblingsprojekt

- Seti/Spinhenge

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 5900X

- Mainboard

- ASUS TUF B450m Pro-Gaming

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x 16GB Crucial Ballistix Sport LT DDR4-3200, CL16-18-18

- Grafikprozessor

- AMD Radeon RX 6900XT (Ref)

- Display

- LG W2600HP, 26", 1920x1200

- HDD

- Crucial M550 128GB, Crucial M550 512GB, Crucial MX500 2TB, WD7500BPKT

- Soundkarte

- onboard

- Gehäuse

- Cooler Master Silencio 352M

- Netzteil

- Antec TruePower Classic 550W

- Betriebssystem

- Gentoo 64Bit, Win 7 64Bit

- Webbrowser

- Firefox

Wozu dann ARM Server?

Wird zudem schon einen Grund haben, wenn Jaguar in Konsolen Verwendung findet/finden sollte.

Wird zudem schon einen Grund haben, wenn Jaguar in Konsolen Verwendung findet/finden sollte.

tomturbo

Technische Administration, Dinosaurier

- Mitglied seit

- 30.11.2005

- Beiträge

- 9.455

- Renomée

- 665

- Standort

- Österreich

- Aktuelle Projekte

- Universe@HOME, Asteroids@HOME

- Lieblingsprojekt

- SETI@HOME

- Meine Systeme

- Xeon E3-1245V6; Raspberry Pi 4; Ryzen 1700X; EPIC 7351

- BOINC-Statistiken

- Mein Laptop

- Microsoft Surface Pro 4

- Details zu meinem Desktop

- Prozessor

- R7 5800X

- Mainboard

- Asus ROG STRIX B550-A GAMING

- Kühlung

- Alpenfön Ben Nevis Rev B

- Speicher

- 2x32GB Mushkin, D464GB 3200-22 Essentials

- Grafikprozessor

- Sapphire Radeon RX 460 2GB

- Display

- BenQ PD3220U, 31.5" 4K

- SSD

- 1x HP SSD EX950 1TB, 1x SAMSUNG SSD 830 Series 256 GB, 1x Crucial_CT256MX100SSD1

- HDD

- Toshiba X300 5TB

- Optisches Laufwerk

- Samsung Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Define R4

- Netzteil

- XFX 550W

- Tastatur

- Trust ASTA mechanical

- Maus

- irgend eine silent Maus

- Betriebssystem

- Arch Linux, Windows VM

- Webbrowser

- Firefox + Chromium + Konqueror

- Internetanbindung

-

▼300

▲50

Das frage ich mich auch, und habe auch noch keinen in der freien Wildbahn erspähen können.Wozu dann ARM Server?

Konsole <> ServerWird zudem schon einen Grund haben, wenn Jaguar in Konsolen Verwendung findet/finden sollte.

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

gibt ja auch verschiedene servertypen

Opteron

Redaktion

☆☆☆☆☆☆

Ich auch nicht, aber auf stromsparendere Server vielleicht?Für welche Server?

Für die die langsam sein sollen? Hm, wer braucht die?

Ich sah noch niemanden auf langsame Server umstellen, Du etwa?

Im Webcast sagte der AMDler gerade, dass 2014 ein ARM64+Seamicrochip von AMD kommt. x86 wird nicht eingestellt, aber wenn ich den Iren richtig verstanden hab, dann wäre ARM 1. Priorität ... aber ich warte da mal besser auf die Aufzeichnung und hör nochmal hin.

Bin schon froh, dass er gesagt hat, dass x86 für Server bleibt

(Ich hoffe nur, dass er sich nicht nur auf nen Kabini-Opteron bezieht

)

)amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

High Tech Konzern und eine Tonübertragung wie über Langwelle vor 100 Jahren

tomturbo

Technische Administration, Dinosaurier

- Mitglied seit

- 30.11.2005

- Beiträge

- 9.455

- Renomée

- 665

- Standort

- Österreich

- Aktuelle Projekte

- Universe@HOME, Asteroids@HOME

- Lieblingsprojekt

- SETI@HOME

- Meine Systeme

- Xeon E3-1245V6; Raspberry Pi 4; Ryzen 1700X; EPIC 7351

- BOINC-Statistiken

- Mein Laptop

- Microsoft Surface Pro 4

- Details zu meinem Desktop

- Prozessor

- R7 5800X

- Mainboard

- Asus ROG STRIX B550-A GAMING

- Kühlung

- Alpenfön Ben Nevis Rev B

- Speicher

- 2x32GB Mushkin, D464GB 3200-22 Essentials

- Grafikprozessor

- Sapphire Radeon RX 460 2GB

- Display

- BenQ PD3220U, 31.5" 4K

- SSD

- 1x HP SSD EX950 1TB, 1x SAMSUNG SSD 830 Series 256 GB, 1x Crucial_CT256MX100SSD1

- HDD

- Toshiba X300 5TB

- Optisches Laufwerk

- Samsung Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Define R4

- Netzteil

- XFX 550W

- Tastatur

- Trust ASTA mechanical

- Maus

- irgend eine silent Maus

- Betriebssystem

- Arch Linux, Windows VM

- Webbrowser

- Firefox + Chromium + Konqueror

- Internetanbindung

-

▼300

▲50

Was nutzt das Stromsparende wenn es arschlahm ist?Ich auch nicht, aber auf stromsparendere Server vielleicht

Server sind Kisten die was leisten sollen und nicht stromsparen.

Zeit ist Geld und Geld verdient man mit Leistung und nicht mit stromsparen.

Wenn der Server nur idelt dann ist er fehl am Platz und kann gleich als ganzes eingespart werden, das bringt mehr.

Als nächstes bauen wir Elektrorasenmähermotoren in die F1 ein damit wir spritsparen

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

klar und ein F1 Triebwerk ins Auto, damit wir mal die Schallmauer auf der Autobahn knakken.

.

EDIT :

.

Bei Facebook und google braucht es halt keine High Performance Computer. Die brauchen massig Speicherplatz und Datendurchsatz. Da wird außer Adressen nichts berechnet.

.

EDIT :

.

Bei Facebook und google braucht es halt keine High Performance Computer. Die brauchen massig Speicherplatz und Datendurchsatz. Da wird außer Adressen nichts berechnet.

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

Für nen kleinen Datenserver daheim reicht ja auch ein Atom oder steckste da nen i7 rein?

.

EDIT :

.

Wo bitte sind die Daten bei FB, Google, Amazoon etc gespeichert?

.

EDIT :

.

Wo bitte sind die Daten bei FB, Google, Amazoon etc gespeichert?

Opteron

Redaktion

☆☆☆☆☆☆

Hast Du den Part mit den x86 Server verstanden? Irgendwas mit "priority" war da.High Tech Konzern und eine Tonübertragung wie über Langwelle vor 100 Jahren

@tomturbo:

HAst auch wieder recht, aber es gibt halt unterschiedliche Server.

tomturbo

Technische Administration, Dinosaurier

- Mitglied seit

- 30.11.2005

- Beiträge

- 9.455

- Renomée

- 665

- Standort

- Österreich

- Aktuelle Projekte

- Universe@HOME, Asteroids@HOME

- Lieblingsprojekt

- SETI@HOME

- Meine Systeme

- Xeon E3-1245V6; Raspberry Pi 4; Ryzen 1700X; EPIC 7351

- BOINC-Statistiken

- Mein Laptop

- Microsoft Surface Pro 4

- Details zu meinem Desktop

- Prozessor

- R7 5800X

- Mainboard

- Asus ROG STRIX B550-A GAMING

- Kühlung

- Alpenfön Ben Nevis Rev B

- Speicher

- 2x32GB Mushkin, D464GB 3200-22 Essentials

- Grafikprozessor

- Sapphire Radeon RX 460 2GB

- Display

- BenQ PD3220U, 31.5" 4K

- SSD

- 1x HP SSD EX950 1TB, 1x SAMSUNG SSD 830 Series 256 GB, 1x Crucial_CT256MX100SSD1

- HDD

- Toshiba X300 5TB

- Optisches Laufwerk

- Samsung Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Define R4

- Netzteil

- XFX 550W

- Tastatur

- Trust ASTA mechanical

- Maus

- irgend eine silent Maus

- Betriebssystem

- Arch Linux, Windows VM

- Webbrowser

- Firefox + Chromium + Konqueror

- Internetanbindung

-

▼300

▲50

Nein es reicht der Atom nicht und nein den tun ich nicht in meinem Server rein.Für nen kleinen Datenserver daheim reicht ja auch ein Atom oder steckste da nen i7 rein?

Da steckt ein Dualcore K8 drinnen der bei Raid5 von 10 Laufwerken durchaus auch mal auf 100% geht.

Das möchte ich nicht mit einem Atom durchmachen.

amdfanuwe

Grand Admiral Special

- Mitglied seit

- 24.06.2010

- Beiträge

- 2.372

- Renomée

- 34

- Details zu meinem Desktop

- Prozessor

- 4200+

- Mainboard

- M3A-H/HDMI

- Kühlung

- ein ziemlich dicker

- Speicher

- 2GB

- Grafikprozessor

- onboard

- Display

- Samsung 20"

- HDD

- WD 1,5TB

- Netzteil

- Extern 100W

- Betriebssystem

- XP, AndLinux

- Webbrowser

- Firefox

- Verschiedenes

- Kaum hörbar

Da herrscht doch der größte Serverbedarf. Doch nicht die paar HPC Kisten in den Forschungscentern oder bei der Armi für Simulationsspiele.

.

EDIT :

.

@Opteron hab leider kaum was verstanden, mein English reicht da auch nicht weit.

.

EDIT :

.

@Opteron hab leider kaum was verstanden, mein English reicht da auch nicht weit.

y33H@

Admiral Special

- Mitglied seit

- 16.05.2011

- Beiträge

- 1.768

- Renomée

- 10

Je nachdem was für ein K8 erledigt das ein 4C-Atom gleichflott oder schneller bei einen Bruchteil der Leistungsaufnahme.Da steckt ein Dualcore K8 drinnen der bei Raid5 von 10 Laufwerken durchaus auch mal auf 100% geht. Das möchte ich nicht mit einem Atom durchmachen.

tomturbo

Technische Administration, Dinosaurier

- Mitglied seit

- 30.11.2005

- Beiträge

- 9.455

- Renomée

- 665

- Standort

- Österreich

- Aktuelle Projekte

- Universe@HOME, Asteroids@HOME

- Lieblingsprojekt

- SETI@HOME

- Meine Systeme

- Xeon E3-1245V6; Raspberry Pi 4; Ryzen 1700X; EPIC 7351

- BOINC-Statistiken

- Mein Laptop

- Microsoft Surface Pro 4

- Details zu meinem Desktop

- Prozessor

- R7 5800X

- Mainboard

- Asus ROG STRIX B550-A GAMING

- Kühlung

- Alpenfön Ben Nevis Rev B

- Speicher

- 2x32GB Mushkin, D464GB 3200-22 Essentials

- Grafikprozessor

- Sapphire Radeon RX 460 2GB

- Display

- BenQ PD3220U, 31.5" 4K

- SSD

- 1x HP SSD EX950 1TB, 1x SAMSUNG SSD 830 Series 256 GB, 1x Crucial_CT256MX100SSD1

- HDD

- Toshiba X300 5TB

- Optisches Laufwerk

- Samsung Brenner

- Soundkarte

- onboard

- Gehäuse

- Fractal Design Define R4

- Netzteil

- XFX 550W

- Tastatur

- Trust ASTA mechanical

- Maus

- irgend eine silent Maus

- Betriebssystem

- Arch Linux, Windows VM

- Webbrowser

- Firefox + Chromium + Konqueror

- Internetanbindung

-

▼300

▲50

never ever, hab selber 2 atom nettops es gibt nichts lahmeres der schafft nichtmal gigabit ordentlich auszulasten.Je nachdem was für ein K8 erledigt das ein 4C-Atom gleichflott oder schneller bei einen Bruchteil der Leistungsaufnahme.

Der Verbrauch der CPU ist im Vergleich zum Rest des Systems aber sowieso ein Geringfaktor der hier keine Rolle spielt,

und wird, wie immer total übertrieben.

Aber so genug OT von meiner Seite aus es geht hier um Jaguar, sorry

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Naja, übertreib mal nicht. Jaguar ist kein Atom oder ARM. Je nach Workload rechne ich mit K10 Level pro Takt. Wird natürlich auch Szenarien geben, wo das SI limitiert.Was nutzt das Stromsparende wenn es arschlahm ist?

Kommt immer auf den Einsatzzweck an. Von diversen Leuten in der Branche hört man immer öfter, dass mittlerweile Sparsamkeit mehr Priorität als maximale Performance hat. Kann es sein, dass du Server mit HPC verwechselst? Nicht jeder Server ist automatisch HPC.Server sind Kisten die was leisten sollen und nicht stromsparen.

Eben. Die meisten Server sind heutzutage doch Datenhuren mit massig RAM und HDDs/SSDs und weniger Rechenknechte. Mal davon abgesehen ist bei vielen Servern das Ansprechverhalten entscheidender als Rohleistung.Bei Facebook und google braucht es halt keine High Performance Computer. Die brauchen massig Speicherplatz und Datendurchsatz. Da wird außer Adressen nichts berechnet.

FredD

Gesperrt

- Mitglied seit

- 25.01.2011

- Beiträge

- 2.472

- Renomée

- 43

Da ihr schon beim Thema Server seid:

Ideen/Speku wie mögliche Server-Chips auf Jaguar-Basis aussehen würden?

Ein Ringbus wie bei Intel ist bei AMD vermutlich nicht geplant (?).

Wie interessant (Fläche/Performance) wäre denn ein 4x4 Core Jaguar Chip, mit sagen wir 4x2 MB L2 und 8 MB L3?

Ideen/Speku wie mögliche Server-Chips auf Jaguar-Basis aussehen würden?

Ein Ringbus wie bei Intel ist bei AMD vermutlich nicht geplant (?).

Wie interessant (Fläche/Performance) wäre denn ein 4x4 Core Jaguar Chip, mit sagen wir 4x2 MB L2 und 8 MB L3?

Opteron

Redaktion

☆☆☆☆☆☆

Braucht es vermutlich nicht einmal. Wenn, dann rechne ich damit, dass das Teil "nur" in den Seamicroserver kommt und da ist sowieso nur alles mit PCIe angebunden. Von den Dual-Core Atoms waren 8 Stück mit je 8,5W TDP auf einer Karte, da reicht dann auch für 4 Kabinis mit je ~17W.

Man könnte sich jetzt noch 4 Kabini Quad-Module mit Quad-Channel für den G34-Nachfolger vorstellen, wäre sicherlich auch ne interessante Sache, aber wirds wohl eher nicht geben. Davon hätte man schon hören müssen.

Man könnte sich jetzt noch 4 Kabini Quad-Module mit Quad-Channel für den G34-Nachfolger vorstellen, wäre sicherlich auch ne interessante Sache, aber wirds wohl eher nicht geben. Davon hätte man schon hören müssen.

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 969

- Antworten

- 0

- Aufrufe

- 2K

- Antworten

- 49

- Aufrufe

- 12K

- Antworten

- 413

- Aufrufe

- 82K

- Antworten

- 26

- Aufrufe

- 7K