App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD RX 6500 XT langsamer als gforce 1030 (beide 3.0 x4) . kann man runtertakten des VRAM der AMD verhindern ?

- Ersteller ballererian

- Erstellt am

- Status

- Für weitere Antworten geschlossen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Du kannst es dir ja mal beim Superposition Benchmark ansehen.

Der ist zwar alt, ist aber dennoch mit der richtigen Einstellung ziemlich fordernd.

Im "8k Optimized" Preset verlangt er bereist nach über 6 GB VRAM und kratzt bei der IGP meines 5700G und zugewiesenen 8 GB Grafikspeicher diesen lt. Taskmanager auch recht gut aus. Die Framerate ist mit der IGP natürlich ein Witz

Der ist zwar alt, ist aber dennoch mit der richtigen Einstellung ziemlich fordernd.

Im "8k Optimized" Preset verlangt er bereist nach über 6 GB VRAM und kratzt bei der IGP meines 5700G und zugewiesenen 8 GB Grafikspeicher diesen lt. Taskmanager auch recht gut aus. Die Framerate ist mit der IGP natürlich ein Witz

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

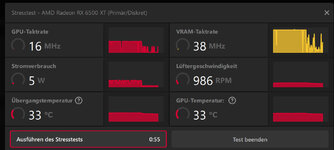

Zieh die spalten mal etwas weiter auf.

GPU-Speicher-Junction müßte die VRAM Temperatur sein und die scheint dort voll im grünen Bereich zu sein. Was man aber nicht sieht ist die Temperatur des Spannungswandlers.

Was allerdings sofort ins Auge sticht ist die GPU-Speicher-Nutzung mit fast 5,7 GB. Bei dir werden bereits fast 2,6 GB in den RAM ausgelagert.

das VRAM funktioniert wie ein Cache. wenn das knapp wird, dann sollen texturen aus dem vram geworfen die selten benutzt werden. also wenn man in einem game auf den boden schaut dann werden kaum texturen benötigt. dann wird also auch vom PC zur graka kaum was übertragen. ich habe frisch rebootet damit alle speicherleichen weg waren, dann den bench wieder 3 mal hintereinander ausgeführt. bei der 3. ausführung war das vram mit 4.020 MB viel weniger als bei der schnellen ausführung meines vorigen posts. ich denke habe nun alle werte. nichts was ans limit kommt. selbst wenn far cry cry vergisst textur speicher freizugeben müsste es ein normal programmierter treiber merken nach einiger zeit, dass auf manche texturen nicht mehr zugegriffen wird und kann die dann durch welche ersetzen die oft von PC zu Vram geladen werden. bei dem nvidia treiber geht das korrekt, daher ist mir das bei dem AMD gleich aufgefallen. den nvidia treiber hab ich allerdings nicht entfernt denke das geht, denn es ist im taskmanager nichts von nvidia tasks zu sehen. es gibt viele die vergleiche von nvidia zu amd machen, glaube kaum dass die es nicht gemerkt hätten, wenn der nvidia treiber stören würde.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

jein

Damit es performant läuft sollten alle benötigten Daten im VRAM liegen. Das schließt natürlich nicht aus das weitere vorgeladen werden können um nachladezeiten zu minimieren. Wird der VRAM knapp fällt letzteres zuerst zum Opfer wodurch öfter nachgeladen werden muss und muss für gerade benötigte Daten auf den ausgelagerten Speicher zugegriffen werden bricht die Framerate endgültig ein, Bildelemente wie Texturen werden deutlich sichtbar nachgeladen oder fehlen ganz. Wie sich das genau äußert hängt erheblich von der Spiele Engine ab. Bugs wie Speicher Lecks sind wieder ein Thema für sich.

Damit es performant läuft sollten alle benötigten Daten im VRAM liegen. Das schließt natürlich nicht aus das weitere vorgeladen werden können um nachladezeiten zu minimieren. Wird der VRAM knapp fällt letzteres zuerst zum Opfer wodurch öfter nachgeladen werden muss und muss für gerade benötigte Daten auf den ausgelagerten Speicher zugegriffen werden bricht die Framerate endgültig ein, Bildelemente wie Texturen werden deutlich sichtbar nachgeladen oder fehlen ganz. Wie sich das genau äußert hängt erheblich von der Spiele Engine ab. Bugs wie Speicher Lecks sind wieder ein Thema für sich.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.853

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

GutWie steht es hier eigentlich um die Windows-App?

Anders als noch hier, konnte ich mehrere erfolgreich abliefern.

Doppelposting wurde automatisch zusammengeführt:

Im GPUGrid Forum hat jemand eine nette Info gefunden: Wenn eine WU bei 100% steht und keine Restzeit mehr anzeigt, kann man sich anhand dieser zwei Dateien in etwa ausmalen, wie viel da noch kommt.

Anhang anzeigen 52745

Weil Asus die Karte herstellt. AMD liefert nur die GPU.wieso sollte asus so einen sensor einbauen.

Nein, wenn die üblichen Temperatur-Überwachungschips erkannt werden, dann kann das Tool da auch Werte auslesen. Allenfalls die Zuordnung ist dann erschwert, das wird Asus wohl nicht veröffentlichen.hwinfo kann nur das auslesen was die hardware hersteller veröffentlichen.

Jein. Erstens ist es GDDR6, also kein DDR6 und auch kein DDR5. Und zweitens bedeutet es noch lange nicht, dass jeder Speicher plötzlich Temperatursensoren drin hat. Im Zweifel sind das einzelne DDR5-Modul-Hersteller, die Sensoren zusätzlich drauf haben.die graka hat doch DDR6. und wenn es in DDR 5 temperatursensoren gibt, wird es das mit DDR 6 logischerweise auch geben auch wenn es keiner erwähnt.

Dann würde ich einfach mal nach der Ursache suchen - auf Software-Ebene.mmer wenn die karte langsam wird ist zwar der GPU takt voll hoch aber der ram takt ganz niedrig.

Irgendwelche geheime Sensoren herbeiwünschen, führt sowieso nicht zum Ziel. Entweder weil es sie gar nicht gibt oder weil Du da mangels infos auch nicht weiterkommst.

Bei meinen Karten wird der RAM dann runtergetaktet, wenn er gerade wenig zu tun bekommt.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Dann würde ich einfach mal nach der Ursache suchen - auf Software-Ebene.mmer wenn die karte langsam wird ist zwar der GPU takt voll hoch aber der ram takt ganz niedrig.

Irgendwelche geheime Sensoren herbeiwünschen, führt sowieso nicht zum Ziel. Entweder weil es sie gar nicht gibt oder weil Du da mangels infos auch nicht weiterkommst.

Bei meinen Karten wird der RAM dann runtergetaktet, wenn er gerade wenig zu tun bekommt.

Wenn die Karte wenig zu tun hat taktet das RAM und die GPU runter. In dem Falle wenn meine RX lahm ist taktet die GPU volle leistung nur RAM taktet runter. vielleicht ist es auch gar kein geheimer Sensor sondern geheimer Anti Mining code, oder geheimer kauf dir eine Karte mit mehr VRAM Hinweis

vielleicht lassen die meisten beim spielen den fps counter links oben der bei steam oder ubi launcher einschaltbar ist nicht mitlaufen und merken nicht, dass ihre Karte je länger sie spielen immer langsamer wird. da ist es dann von Vorteil wenn die karte im benchmark bei dem spiel 120 fps schafft so dass man bei 2 std spielen dann noch wenigstens 40 fps hat.

warum testet hier keiner mit ner AMD 4 GB karte mal das far cry kostenlos demo mit dem benchmark. dann würde man sehen ob es bei anderen AMD karten auch so ist.

Doppelposting wurde automatisch zusammengeführt:

jein

Damit es performant läuft sollten alle benötigten Daten im VRAM liegen. Das schließt natürlich nicht aus das weitere vorgeladen werden können um nachladezeiten zu minimieren. Wird der VRAM knapp fällt letzteres zuerst zum Opfer wodurch öfter nachgeladen werden muss und muss für gerade benötigte Daten auf den ausgelagerten Speicher zugegriffen werden bricht die Framerate endgültig ein, Bildelemente wie Texturen werden deutlich sichtbar nachgeladen oder fehlen ganz. Wie sich das genau äußert hängt erheblich von der Spiele Engine ab. Bugs wie Speicher Lecks sind wieder ein Thema für sich.

das endgültig einbrechen bei vram mangel war als es noch AGP steckplatz mit 150 megabyte pro sekunde gab und keine dualcore CPU. Nur miitlerweile liegt die transferrate bei über 2.000 MB/sec heute kann man den backpuffer rendern und währen dieser zeit mit einem anderen thread neue texturen die evtl für das rendern benötigt werden schon übertragen. da nimmt man meist 1024x1024 tiles für hires texturen. so ein tile hat dann nur 0.5 megabyte. Selbst wenn da nichts threaded ginge, bei den 2 fps die ich mit der karte hinbekomme wenn sie lahm ist können paar hundert tiles bei jedem frame übertragen werden.

Du kannst es dir ja mal beim Superposition Benchmark ansehen.

Der ist zwar alt, ist aber dennoch mit der richtigen Einstellung ziemlich fordernd.

Im "8k Optimized" Preset verlangt er bereist nach über 6 GB VRAM und kratzt bei der IGP meines 5700G und zugewiesenen 8 GB Grafikspeicher diesen lt. Taskmanager auch recht gut aus. Die Framerate ist mit der IGP natürlich ein Witz

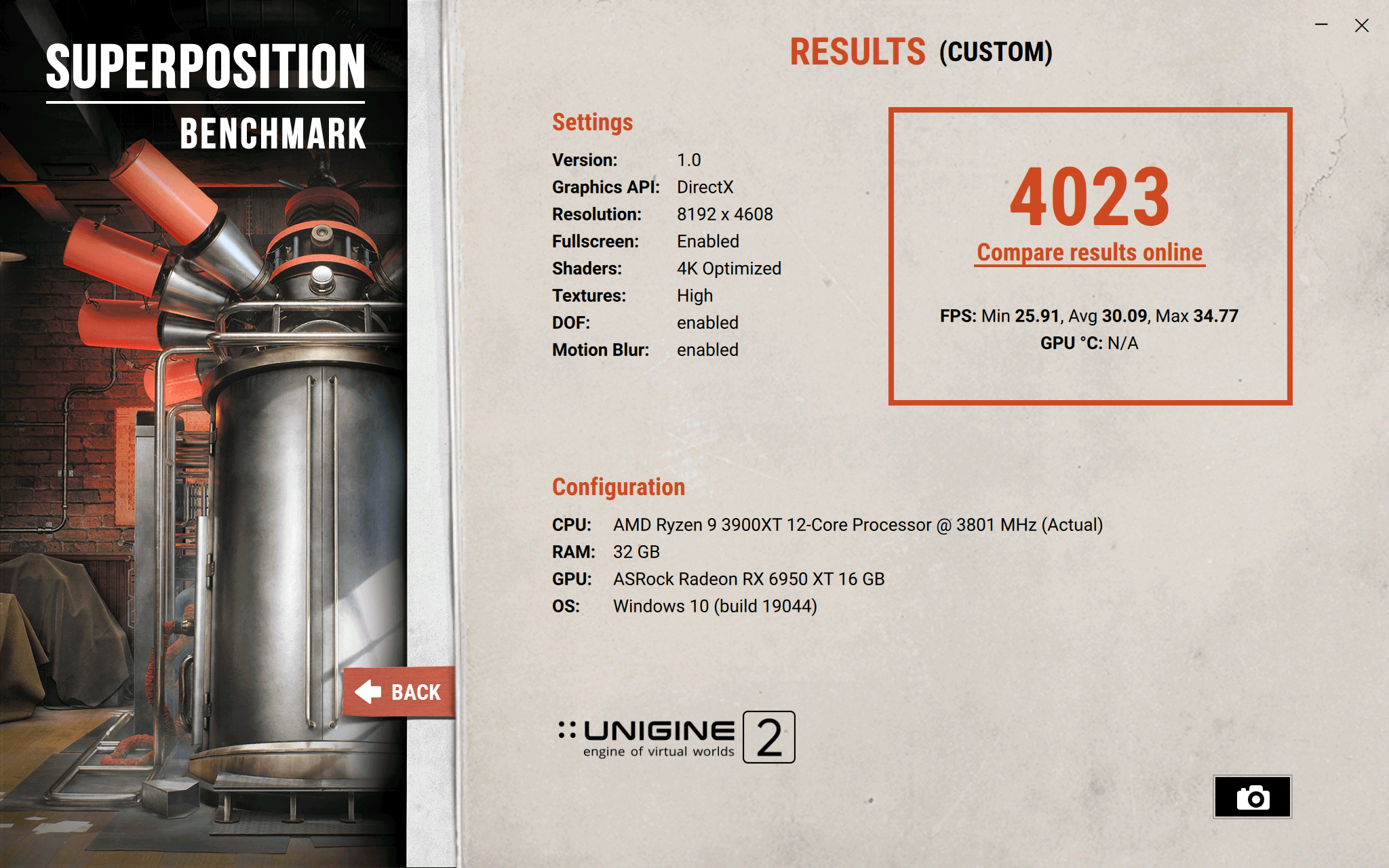

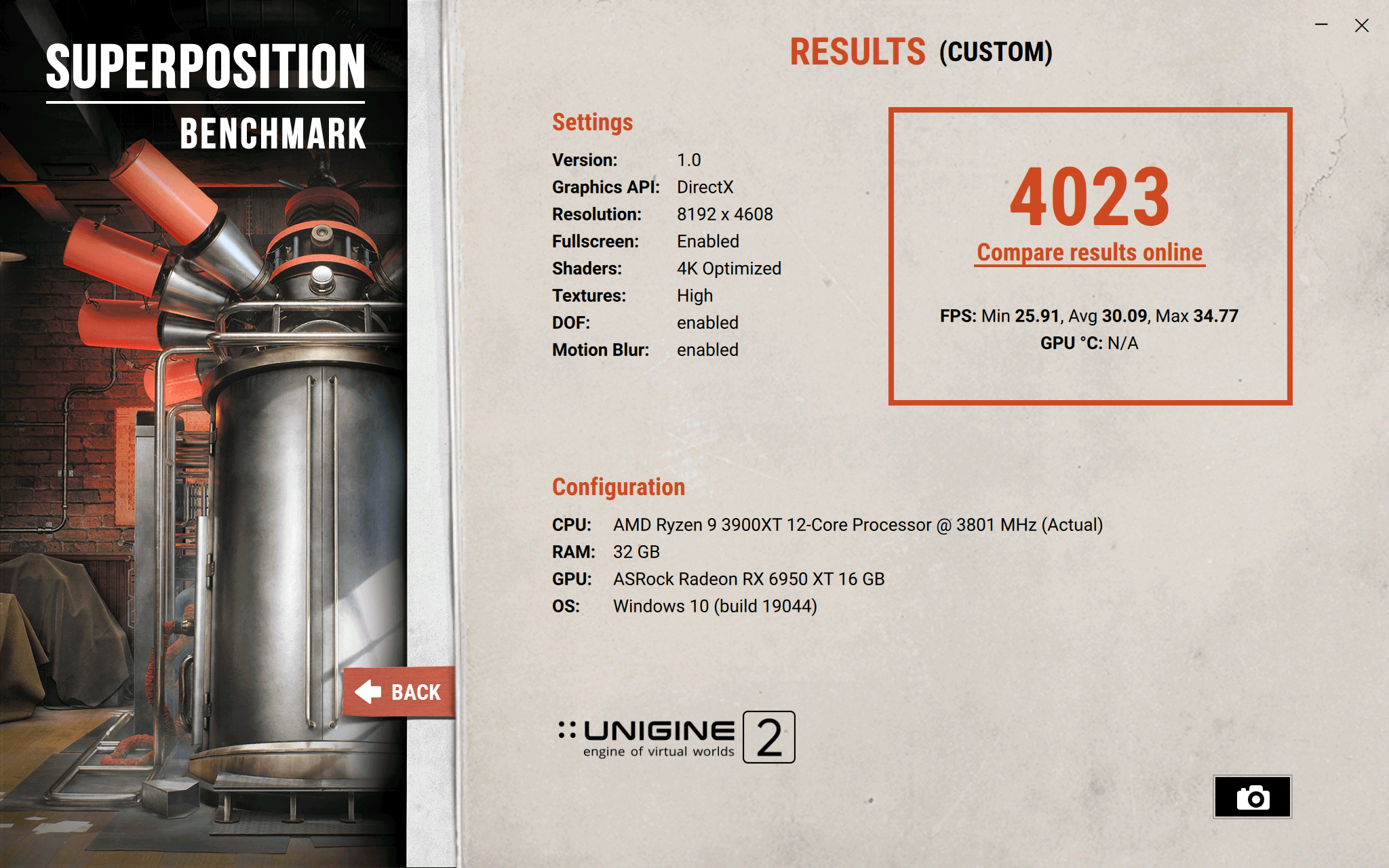

Anhang anzeigen 52846

der benchmark scheint sehr gut zum testen, zumindest zeigt der dass meine Hardware ok zu sein scheint. komme in 5k resolution auf average wert 18 fps obwohl vram 4300 MB benutzt wird. Lüfter dreht nur mit 800 u/min. Ram clock taktet nicht runter nur GPU clock. Watt zahl braucht die Karte 80 Watt. Was macht denn deine Karte bei den Settings ?.

Ich habe auch fullhd probiert und mittlere texturen da brauchen die texturen nur 1300 MB. auch da war als leichtes hängen festzustellen wie bei half life 2. da werd ich die rx6400 später wieder ausbauen und meine gforce 1030 mit dem Test testen ob die das ohne ruckler abspielt

Ein Schwachpunkt der RX6500 scheinen die shader zu sein. denn bei hoher einstellung verbrauchen die viel vram und bremsen extrem. da kann ich dann mit der gforce 1030 vergleichen was die für vram Bedarf hat.

kennst noch ein paar benchmarks die die karte fordern und bei dem sich auch einstellungen ändern lassen. am besten wäre ein freies spiel Demo, evtl mit shadern und so damit ich vergleichen kann ob nvidia oder AMD bessere performance bei vram mangel und mikroruckeln hat ?.

Ich frag mich wie die bei youtube die videos aufnehmen. schneiden die das raus wenn es kurz ruckelt. denn ich schaffe es mit der RX nicht obwohl textur speicher reicht und 1920x1080 ohne die kurzen hänger. Aber wenn ich die shader auf lowest quality stelle wirds auf jedenfall weniger. far cry 6 hat über 7000 shader, sieht man da beim 1 start die berechnung der shader von 7300 abwärts zählte. passierte auch als ich dann zu der RX 6500 gewechselt hab

Doppelposting wurde automatisch zusammengeführt:

da kann man sehen auch wenn ein paar hundert Megabyte VRAM fehlen, macht es nur 12% aus bei der minimum framerate. bei average FPS dann 4%. Also nicht so dass total die performance einbricht wegen etwas fehlendem Texturram. ist mit texturen mittel und 5k auflösung. es sieht so aus als ob die 6500 oder generell alle AMD karten Probleme haben wenn viele shader wie bei far cry 6 verwendet werden. vielleicht wenn die shader viel rechnen wird der RAM takt runtergesetzt und braucht zu lange um wieder hochzugehen.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Fast, das der VRAM je nach Bandbreitenbedarf getaktet wird konnte man z.B. in meinem damaligen Test bei den Primegrid Werten sehen. Vielleicht ein Tribut an die ursprüngliche Entwicklung für den mobilen Markt?Wenn die Karte wenig zu tun hat taktet das RAM und die GPU runter. In dem Falle wenn meine RX lahm ist taktet die GPU volle leistung nur RAM taktet runter.

PrimeGrid (PPS Sieve)

RX 6500XT

1 WU: ca. 850s, GPU Takt 0-2824 MHz, GPU Auslastung 0-99%, VRAM Controller 0%, VRAM Takt 6-1340 MHz (idR. unter 100 MHz), ca. 45-50W

2 WUs: ca. 1165s, GPU Takt 949-2831 MHz, GPU Auslastung 18-99%, VRAM Controller max. 1%, VRAM Takt 6-1340 MHz (idR. unter 140 MHz), ca. 64-75W

4 WUs: ca. 2040s, GPU Takt 217-2832 MHz, GPU Auslastung 7-99%, VRAM Controller max. 1%, VRAM Takt 10-1076 MHz (idR. unter 140 MHz), ca. 72-77W

Das ist eher nvidias Taktik.vielleicht ist es auch gar kein geheimer Sensor sondern geheimer Anti Mining code, oder geheimer kauf dir eine Karte mit mehr VRAM Hinweis

Ich habe den halben Tag versucht die Karte auf meiner Testplattform zum laufen zu bekommen aber bei der Treiberinstallation wurde jedes mal der Bildschirm schwarz und das war es dann bis er wieder im abgesicherten Modus deinstalliert wurde.Was macht denn deine Karte bei den Settings ?.

Irgendwas wurde vermutlich an Windows geändert denn den Effekt hatte ich auch mit dem bei meinem damaligen Test genutzten Treiber.

Hier aber nochmal die Testergebnisse von damals:

Superposition Benchmark

RX 6500XT

1080p Medium 8531

min. 41.05, Avg. 63.81, Max 85.86

1080p High 6485

min. 38.73, Avg. 48.51, Max 58.41

1080p Extreme 2749

min. 16.84, Avg. 20.57, Max 23.92

4K Optimized 3655

min. 21.15, Avg. 27.34, Max 33.36

8K Optimized 260

Min. 1.47, Avg 1.95, Max 2.69

Das Problem hast du damals wie heute denn an der Ursache hat sich nichts geändert. Der Zugriff auf die in den RAM ausgelagerten Daten ist erheblich langsamer und in der Zwischenzeit darf die GPU darauf warten.das endgültig einbrechen bei vram mangel war als es noch AGP steckplatz mit 150 megabyte pro sekunde gab und keine dualcore CPU

Die GPUs haben sich ja schließlich auch weiterentwickelt und damit deren Bedarf an Speicherbandbreite.

Zuletzt bearbeitet:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Ich habe den halben Tag versucht die Karte auf meiner Testplattform zum laufen zu bekommen aber bei der Treiberinstallation wurde jedes mal der Bildschirm schwarz und das war es dann bis er wieder im abgesicherten Modus deinstalliert wurde.Was macht denn deine Karte bei den Settings ?.

Irgendwas wurde vermutlich an Windows geändert denn den Effekt hatte ich auch mit dem bei meinem damaligen Test genutzten Treiber.

was für einen Monitor hast du ?. HDMI Kabel oder DVI ?. Wenn du den auf freesync stehen hast und der treiber erkennt es nicht, dann bleibt das Bild schwarz und es dauert 20 sec oder mehr bis der Monitor merkt gibt kein freesync. Ich habe meine RX 6500 installiert mit dem HDMI kabel und ohne freesync. Aber wenn ich freesync anstelle im Monitor wechselt der AMD treiber automatisch. was bei DVI passiert weis ich nicht hab kein DVI Kabel kauf ich mir auch keins, denn HDMI tut es auch und soweit ich weis funktioniert die Auflösungen der karte übermittel über HDMI besser. auch HDR anstellen in windows erkennt der Monitor automatisch.

Ich habe LG 32uk550/le500

Hier aber nochmal die Testergebnisse von damals:

Superposition Benchmark

RX 6500XT

1080p Medium 8531

min. 41.05, Avg. 63.81, Max 85.86

1080p High 6485

min. 38.73, Avg. 48.51, Max 58.41

1080p Extreme 2749

min. 16.84, Avg. 20.57, Max 23.92

4K Optimized 3655

min. 21.15, Avg. 27.34, Max 33.36

8K Optimized 260

Min. 1.47, Avg 1.95, Max 2.69

hast du auch eine 4 GB rx 6400 ?. denn der zusammenbruch bei 8k ist bei mir genauso. problem ist auch man kann AA nicht abstellen im Radeon treiber, oder gibt es da eine Lösung ?. wenn man 8k in 4k monitor sieht hat man ja schon noch mehr AA Reduktion.

wenn ich DOF abstelle und shader low stelle geht die FPS trotz 6000 MB VRAM Belegung nicht so extrem stark runter. warum es mit DOF so stark runtergeht obwohl nicht mehr VRAM gebraucht wird, weis nicht.

egal. aber wieder ein Indiz, dass der Schwachpunkt bei AMD die shader sind. die rx 7000 serie soll überarbeitete bekommen. die 8k Werte

Das Problem hast du damals wie heute denn an der Ursache hat sich nichts geändert. Der Zugriff auf die in den RAM ausgelagerten Daten ist erheblich langsamer und in der Zwischenzeit darf die GPU darauf warten.das endgültig einbrechen bei vram mangel war als es noch AGP steckplatz mit 150 megabyte pro sekunde gab und keine dualcore CPU

Die GPUs haben sich ja schließlich auch weiterentwickelt und damit deren Bedarf an Speicherbandbreite.

ja gut aber es fällt den augen viel weniger auf. In meinem test war der speedverlust auch sehr wenig in 8k wenn 2 gb mehr texturen benutzt wurden. also kein zusammenbruch. so wie ich das sehe wirft die radeon als pixelshader aus dem VRAM wenn es voll ist.

hier mit low texturen

Doppelposting wurde automatisch zusammengeführt:

PixelIch habe den halben Tag versucht die Karte auf meiner Testplattform zum laufen zu bekommen aber bei der Treiberinstallation wurde jedes mal der Bildschirm schwarz und das war es dann bis er wieder im abgesicherten Modus deinstalliert wurde.Was macht denn deine Karte bei den Settings ?.

Irgendwas wurde vermutlich an Windows geändert denn den Effekt hatte ich auch mit dem bei meinem damaligen Test genutzten Treiber.

was für einen Monitor hast du ?. HDMI Kabel oder DVI ?. Wenn du den auf freesync stehen hast und der treiber erkennt es nicht, dann bleibt das Bild schwarz und es dauert 20 sec oder mehr bis der Monitor merkt gibt kein freesync. Ich habe meine RX 6500 installiert mit dem HDMI kabel und ohne freesync. Aber wenn ich freesync anstelle im Monitor wechselt der AMD treiber automatisch. was bei DVI passiert weis ich nicht hab kein DVI Kabel kauf ich mir auch keins, denn HDMI tut es auch und soweit ich weis funktioniert die Auflösungen der karte übermittel über HDMI besser. auch HDR anstellen in windows erkennt der Monitor automatisch.

Ich habe LG 32uk550/le500

Hier aber nochmal die Testergebnisse von damals:

Superposition Benchmark

RX 6500XT

1080p Medium 8531

min. 41.05, Avg. 63.81, Max 85.86

1080p High 6485

min. 38.73, Avg. 48.51, Max 58.41

1080p Extreme 2749

min. 16.84, Avg. 20.57, Max 23.92

4K Optimized 3655

min. 21.15, Avg. 27.34, Max 33.36

8K Optimized 260

Min. 1.47, Avg 1.95, Max 2.69

hast du auch eine 4 GB rx 6400 ?. denn der zusammenbruch bei 8k ist bei mir genauso. problem ist auch man kann AA nicht abstellen im Radeon treiber, oder gibt es da eine Lösung ?. wenn man 8k in 4k monitor sieht hat man ja schon noch mehr AA Reduktion.

wenn ich DOF abstelle und shader low stelle geht die FPS trotz 6000 MB VRAM Belegung nicht so extrem stark runter. warum es mit DOF so stark runtergeht obwohl nicht mehr VRAM gebraucht wird, weis nicht.

egal. aber wieder ein Indiz, dass der Schwachpunkt bei AMD die shader sind. die rx 7000 serie soll überarbeitete bekommen. die 8k Werte

Das Problem hast du damals wie heute denn an der Ursache hat sich nichts geändert. Der Zugriff auf die in den RAM ausgelagerten Daten ist erheblich langsamer und in der Zwischenzeit darf die GPU darauf warten.das endgültig einbrechen bei vram mangel war als es noch AGP steckplatz mit 150 megabyte pro sekunde gab und keine dualcore CPU

Die GPUs haben sich ja schließlich auch weiterentwickelt und damit deren Bedarf an Speicherbandbreite.

ja gut aber es fällt den augen viel weniger auf. In meinem test war der speedverlust auch sehr wenig in 8k wenn 2 gb mehr texturen benutzt wurden. also kein zusammenbruch. so wie ich das sehe wirft die radeon als pixelshader aus dem VRAM wenn es voll ist.

hier mit low texturen

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich habe 2 verschiedene genutzt, ein UHD TV per HDMI und einen alten Dell 24" Monitor mit aktiven DisplayPort - DVI Converter. Es ist ja nicht nru das der Bildschirm schwarz bleibt, das ganze System bleibt stehen (keine Festplattenaktivität mehr, keine Reaktion auf den Aus Button)was für einen Monitor hast du ?. HDMI Kabel oder DVI ?.

nein, nur die R9 Nano bei der der Treiber allergisch auf den Speicherüberlauf reagiert.hast du auch eine 4 GB rx 6400 ?

Es benötigt enen nicht jede Funktion gleich viel Bandbreite.wenn ich DOF abstelle und shader low stelle geht die FPS trotz 6000 MB VRAM Belegung nicht so extrem stark runter.

Hoch auflösende Texturen belegen vor allem Speicherplatz, sind aber sehr genügsam bei der Bandbreite. Das nutzte AMD z.B. beim HBCC aus. Auf die Shader dürfte erheblich mehr zugegriffen werden.

Bei dem test sehe ich leider bereits den Unterschied zwischen den Shader Einstellungen High und Extreme und wie man ebenfalls sieht haben sie einen erheblichen Einfluss auf die Performance.ja gut aber es fällt den augen viel weniger auf.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Super Position in 8k ?

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

@WindHund

ich frage mich nur, wozu man so eine low end karte, die noch dazu beworben wird als 1080p karte, mit 4k als auflösung nutzen möchte. ich brauch im normalfall auch eher weniger fps, aber bevor ich auf massive details verzichte, würde ich dann doch eher die auflösung runterschrauben.

mit "the last of us" hab ich erstmals eins dieser "neuen" spiele, bei denen vram ungeheuer wichtig ist und niedrige fps nicht smooth sondern immer rucklig aussehen. (wobei ich es nicht von dem mausstottern was viele bemängeln unterscheiden kann)

man müsste ausprobieren, wieviel gb vram in den einstellungen des spiels angezeigt werden, um zumindest in full hd nicht über 4 gb vram zu kommen, wenn man es mit so einer karte spielen wöllte. ich glaub aber in 4k wäre das wahrscheinlich nie möglich.

am besten wäre wohl zumindest von der 6500 auf die 6600 zu wechseln um wenigstens 8 gb vram zu haben. da könnte man als fps genügsamer spieler wohl noch am ehesten hinkommen.

ich frage mich nur, wozu man so eine low end karte, die noch dazu beworben wird als 1080p karte, mit 4k als auflösung nutzen möchte. ich brauch im normalfall auch eher weniger fps, aber bevor ich auf massive details verzichte, würde ich dann doch eher die auflösung runterschrauben.

mit "the last of us" hab ich erstmals eins dieser "neuen" spiele, bei denen vram ungeheuer wichtig ist und niedrige fps nicht smooth sondern immer rucklig aussehen. (wobei ich es nicht von dem mausstottern was viele bemängeln unterscheiden kann)

man müsste ausprobieren, wieviel gb vram in den einstellungen des spiels angezeigt werden, um zumindest in full hd nicht über 4 gb vram zu kommen, wenn man es mit so einer karte spielen wöllte. ich glaub aber in 4k wäre das wahrscheinlich nie möglich.

am besten wäre wohl zumindest von der 6500 auf die 6600 zu wechseln um wenigstens 8 gb vram zu haben. da könnte man als fps genügsamer spieler wohl noch am ehesten hinkommen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Wie gesagt, alte Spiele wie HL2 gehen durchaus in UHD allerdings muss man dann aufpassen weil oftmals das Menü nicht mit skaliert und verdammt klein wird.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

@WindHund

ich frage mich nur, wozu man so eine low end karte, die noch dazu beworben wird als 1080p karte, mit 4k als auflösung nutzen möchte. ich brauch im normalfall auch eher weniger fps, aber bevor ich auf massive details verzichte, würde ich dann doch eher die auflösung runterschrauben.

hatte ich weiter oben schon geschrieben . aber mache es noch ausführlicher. Es geht darum jedem klar zu zeigen, dass die AMD ein grosses Problem hat, dass es mit der nvidia nicht gibt und dass ich es dann mit den klaren Beweisen auch im AMD forum(dort schreibt auch AMD support) klar rüberkommt und die den treiber verbessern oder sagen geht nicht besser. kann ja nicht sein, dass ein game das viele pixelshader nutzt wie far cry so langsam wird bei der AMD und bei der gforce 1030 6 mal schneller ist obwohl der nur 2 GB Textur RAM hat. vermutlich würde eine AMD karte mit 2 GB ram nichtmal in 1080 über 10 fps kommen.

Fakt ist jedenfalls selbst mit einer 1030 lässt sich viel in 4k spielen wenn man wie ich auf AA verzichten kann. Ich finde 4k ohne AA sieht viel besser und detailreicher aus als 1080p mit AA. wobei Super sampling AA die beste qualität hat aber auch nichts anderes ist als 4k auflösung auf 1080 P runtergerechnet. warum dann nicht gleich 4k auflösung ohne runterrechnen anschauen

1080p ohne AA das sieht auch nicht gut aus.oder nutzt du 1080 ohne AA ?. ihr solltet nicht alles glauben was euch das marketing weis machen möchte..

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.853

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Es ist ein Problem, was nur in der Theorie existiert. Also nicht mal ein kleines Problem, sondern noch weniger.Es geht darum jedem klar zu zeigen, dass die AMD ein grosses Problem hat, dass es mit der nvidia nicht gibt

Aber Du kannst gern berichten, was Dir AMD in seinem Forum (das kenne ich noch gar nicht) darauf antwortet.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Es ist ein Problem, was nur in der Theorie existiert. Also nicht mal ein kleines Problem, sondern noch weniger.Es geht darum jedem klar zu zeigen, dass die AMD ein grosses Problem hat, dass es mit der nvidia nicht gibt

Aber Du kannst gern berichten, was Dir AMD in seinem Forum (das kenne ich noch gar nicht) darauf antwortet.

das problem reduziert sicherlich bei jedem game mit vielen pixelshadern die leistung. dass kann auch passieren mit 8 GB ram. weil wie in meinem screenshots gesehen schon wenn man denselben bench öfter laufen lässt geht die geschwindigkeit stark runter. Wer nicht mit einer nvidia Karte vergleichen kann, woher soll der auch merken, dass es besser geht mit nvidia und far cry z,b. der freut sich oh der 8 gb texturspeicher ist voll weil er 2-3 mal zu windows desktop gewechselt hat e-mails geladen und 2 stunden das spiel spielt und kauft sich dann eine 16 gb karte.

wenn der AMD support auch mit so sprüchen kommt für 4k gamen ist die karte nicht geeignet, dann schick ich die Karte eben wieder zurück und kauf mir ne nvidia oder mal einen intel probieren was die so kann .

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Der Knackpunkt ist doch das es im einstelligen FPS Bereich vollkommen egal ist wer schneller ist denn beide haben eine unspielbare Dia Show. Ob die eine oder andere Karte mit dem Speicherüberlauf besser klar kommt spielt dann ganz einfach keine Rolle mehr.kann ja nicht sein, dass ein game das viele pixelshader nutzt wie far cry so langsam wird bei der AMD und bei der gforce 1030 6 mal schneller ist obwohl der nur 2 GB Textur RAM hat. vermutlich würde eine AMD karte mit 2 GB ram nichtmal in 1080 über 10 fps kommen.

Für Far Cry 6 sind sogar 4 GB VRAM als Mindestvoraussetzung angegeben, wer weiß ob bei den 2 GB der GT1030 nicht bereits Effekte wegen Speichermangel entfallen und sie deshalb "schneller" ist. Zu allem Überfluss gibt es letztere auch noch mit GDDR5 oder erheblich langsameren DDR4 Speicher.

Im übrigen ist das Fixen von Bugs des Spiels nicht Aufgabe des Treibers und dort mit Sicherheit auch nur sehr eingeschränkt möglich.

Zuletzt bearbeitet:

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.853

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Das ist kein Spruch, sondern die Realität. Die hätte Dir vor dem Kauf klar sein müssen.wenn der AMD support auch mit so sprüchen kommt für 4k gamen ist die karte nicht geeignet,

Auch eine Geforce 1050ti, die im gleichen Preisbereich liegt, ist nicht für 4K gedacht.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

ok mir ist jetzt erstmal klar geworden, weswegen die 4k auflösung überhaupt gewünscht wird. wenn man einen 4k monitor besitzt, dann dürfte da drauf fullhd doch sicher bescheiden aussehen oder ?

ich nutze es ja eher umgedreht mit 4k und dsr lediglich auf nem fullhd monitor . da wirkt dann fullhd auch nicht gänzlich hässlich, aber in 4k sieht es natürlich ohne aa auch immer besser aus. (und nein ich würde fullhd nicht ohne spielen).

. da wirkt dann fullhd auch nicht gänzlich hässlich, aber in 4k sieht es natürlich ohne aa auch immer besser aus. (und nein ich würde fullhd nicht ohne spielen).

ich hatte immer nachgeschaut wegen monitor und dann wegen der frage ob 4k oder lieber nur wqhd und würde wahrscheinlich zweitere option vorziehen, weil man dann ja immer noch auf nativ gehen kann wenn die grafikkarte die 4k auflösung nicht schafft.

bei einer 4gb grafikkarte hätte ich mir allerdings gar keinen 4k monitor erst geholt wenns ums spielen geht, da ist man ja sonst immer auf interpolation angewiesen.

ob nvidia nun mit weniger vram auskommt, kann ich nicht einschätzen ... mein schritt war von amd agp mit 1 gb ram ^^ zu pcie 3.0 nvidia mit 11 gb ram ...ich kenne keine zwischenschritte mit derart beschnittenen grafikkarten und die mittlerweile ebenso alternde apu zählt ja eh nicht, wobei eratte dahingehend ja schon einen test gemacht hat mit super position in 8k. ich bemerke nur, das trotz das ich mit wenig fps auskomme, neue spiele mich nun doch langsam zwingen von alles auf max in 4k abzugehen.

wenn far cry 6 mit der gt1030 besser läuft warum nicht die nehmen ? oder ist die bereits verkauft zugunsten der 6500 ? ansonsten beide verkaufen und etwas mit 8 gb vram kaufen. für viele jahre reicht es aber auch nicht, wenn man neuere sachen spielen will..... in 4k sowieso nicht.

ich nutze es ja eher umgedreht mit 4k und dsr lediglich auf nem fullhd monitor

. da wirkt dann fullhd auch nicht gänzlich hässlich, aber in 4k sieht es natürlich ohne aa auch immer besser aus. (und nein ich würde fullhd nicht ohne spielen).

. da wirkt dann fullhd auch nicht gänzlich hässlich, aber in 4k sieht es natürlich ohne aa auch immer besser aus. (und nein ich würde fullhd nicht ohne spielen).ich hatte immer nachgeschaut wegen monitor und dann wegen der frage ob 4k oder lieber nur wqhd und würde wahrscheinlich zweitere option vorziehen, weil man dann ja immer noch auf nativ gehen kann wenn die grafikkarte die 4k auflösung nicht schafft.

bei einer 4gb grafikkarte hätte ich mir allerdings gar keinen 4k monitor erst geholt wenns ums spielen geht, da ist man ja sonst immer auf interpolation angewiesen.

ob nvidia nun mit weniger vram auskommt, kann ich nicht einschätzen ... mein schritt war von amd agp mit 1 gb ram ^^ zu pcie 3.0 nvidia mit 11 gb ram ...ich kenne keine zwischenschritte mit derart beschnittenen grafikkarten und die mittlerweile ebenso alternde apu zählt ja eh nicht, wobei eratte dahingehend ja schon einen test gemacht hat mit super position in 8k. ich bemerke nur, das trotz das ich mit wenig fps auskomme, neue spiele mich nun doch langsam zwingen von alles auf max in 4k abzugehen.

wenn far cry 6 mit der gt1030 besser läuft warum nicht die nehmen ? oder ist die bereits verkauft zugunsten der 6500 ? ansonsten beide verkaufen und etwas mit 8 gb vram kaufen. für viele jahre reicht es aber auch nicht, wenn man neuere sachen spielen will..... in 4k sowieso nicht.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Es kommt darauf an wen man skalieren läßt.wenn man einen 4k monitor besitzt, dann dürfte da drauf fullhd doch sicher bescheiden aussehen oder ?

Läßt man den Monitor skalieren und dessen Skaler taugt nix dann kommt eben auch ein entsprechendes Ergebnis dabei raus. Man kann allerdings auch die GPU skalieren lassen, zumindest kenne ich das von den Anzeige Einstellungen AMD Adrenalin Edition. Damit schaut 1080p auf dem UHD Display für mich recht normal aus denn die Bildausgabe erfolgt in der Auflösung des Monitors.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

ok wieder was gelernt. müsste es aber wahrscheinlich live sehen. ist dann so ein unterschied zwischen gehts so und sieht furchtbar aus ?

ich kanns mir einfach nicht vorstellen, dass egal auf welche weise das bild skaliert wurde, ein bild mit weniger information als wie für die auflösung erforderlich gut ausschaut.

ich kanns mir einfach nicht vorstellen, dass egal auf welche weise das bild skaliert wurde, ein bild mit weniger information als wie für die auflösung erforderlich gut ausschaut.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Das ist kein Spruch, sondern die Realität. Die hätte Dir vor dem Kauf klar sein müssen.wenn der AMD support auch mit so sprüchen kommt für 4k gamen ist die karte nicht geeignet,

Auch eine Geforce 1050ti, die im gleichen Preisbereich liegt, ist nicht für 4K gedacht

die pauschalaussage dass die karte nicht für 4k games geignet sind ist schlicht falsch. Ich erkläre dass mal ganz genau warum

Die realität ist bisher immer die schnellste Karte ist nicht schnell genug. es finden sich sicherlich genug games die auf der schnellsten Karte nicht mit 50 fps minimum laufen mit high details. es finden sich aber auch viele gute Games die auf der 1030 in 4k mit über 50 fps laufen bei vollen Details. counerstrike , fortnite half life 1 2 , gta 5 , war thunder wären aktuelle beispiele da gibt es meist über 100 fps . und von games die vor 2015 releast wurden da laufen sicherlich über 95% schnelll in 4k. es gibt doch genug videos die die performance einer 1030 mit aktuellen games in 4k zeigen. Ältere versionen von GTA inklusive. schau sie dir doch an.

Hätt ich mir vor 5 Jahren statt der 1030 für 600 eur damals war 4 GB für den preis drin eine high end AMD gekauft, wäre die heute auch total veraltet. die 1030 kostete damals glaub ich 100 eur. was ist denn deine mindest FPS ?. ich finde noch gut genug wenn es 15 fps macht als minimum. aber auch 12 fps gehen gerade noch. darunter hab ich keine Lust. und wenn ich 180 eur investiere für eine neue Karte dann sollte die auf jedenfall immer mindestens 3 mal so schnell sein wie meine alte. ist die RX 6500 aber nicht und das schlimme ist länger man spielt desto langsamer wird die AMD. siehe den benchmark 2 mal gestartet wie extrem beim 2. lauf die perforamance einbricht. und ruckeln tut die selbst bei half life 2 in 4k was die 1030 nicht macht.

Ich hab es nicht eilig. wart ich eben ab bis die 8gb karten auch so um die 150 eur kosten und gute games die auf der 1030 imn 4k gut laufen gibt es weil die älter sind sehr billig.

Cappuandy

Grand Admiral Special

- Mitglied seit

- 30.01.2013

- Beiträge

- 3.636

- Renomée

- 168

- Standort

- Lübeck

- Mein Desktopsystem

- ROGi

- Mein Laptop

- MacBook Pro

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 7600X

- Mainboard

- Asus ROG X670E-I Gaming WiFi

- Kühlung

- BeQuiet DarkRockPro 4

- Speicher

- Gskill Trident-Z5 RGB Black 32Gb 6000CL30

- Grafikprozessor

- iGP

- Display

- LG 27" UHD60 HDR

- SSD

- 980 Pro & T500

- HDD

- - none -

- Optisches Laufwerk

- - none -

- Soundkarte

- ROG Hive - ALC4050

- Gehäuse

- Fractal Design Torrent Nano

- Netzteil

- BeQuiet SP12 1kW Platinum

- Tastatur

- Razer Cynosa

- Maus

- Razer Mamba

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox | Safari@iPhone

- Internetanbindung

- ▼schneller ▲schnell

ich versteh nur Bahnhof.. muss ich da mitkommen oder nicht

ich versteh nur Bahnhof.. muss ich da mitkommen oder nicht

Edit: Farcry ist echt ein super Game was sich in der Zeit sehr gut entwickelt hat ggü. dem anderen ähnlichen Spiel.. „komm grad nicht auf den Namen“ -> Just Cause Serie.

Zuletzt bearbeitet:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

ok wieder was gelernt. müsste es aber wahrscheinlich live sehen. ist dann so ein unterschied zwischen gehts so und sieht furchtbar aus ?

ich kanns mir einfach nicht vorstellen, dass egal auf welche weise das bild skaliert wurde, ein bild mit weniger information als wie für die auflösung erforderlich gut ausschaut.

in youtube gibt es dazu videos. suche nach dlss vs fsr 2 . da siehst dann die videos nebeneinander. das hochskalieren sieht tatsächlich schärfer aus und läuft dann etwas schneller. im falle far cry 6 wäre das dann sogar schneller als gforce 1030. Wenn in 1-2 jahren spiele kommen bin ich mir sicher ist es für die 4 gb variante aber auch das ende. und ne 8 gb karte von amd wird genauso am ende sein wenn ich high res texturen runterlade. da empfehlen die vram 12 gb

nvidia hat viel weniger fps verlust wenn der VRAM knapp ist. Bei AMD wird es dann mit 2 fps unspielbar wenn viele pixel schader verwendet werden.

Wenn die bei AMD den treiber verbessern hilft es bei allen zukünftigen auch. bei alten AMD treiber ging nichtmal der AMD stresstrest ohne dass VRAM runtertaktete. ob die den stresstest geändert haben oder den treiber verbessert weis ich natürlich nicht. vielleicht kennen die amd programmierer das problem und denen fehlt nur ein test der klar zeigt warum der slowdown kommt. das ist far cry 6 oder der superposition benchmark der den fehler zeigt

- Mitglied seit

- 11.11.2001

- Beiträge

- 9.608

- Renomée

- 422

- Standort

- Bayern, am Rande des Wahnsinns

- Aktuelle Projekte

- Dieses und jenes

- BOINC-Statistiken

- Mein Laptop

- HP EliteBook 840 G2, Elitebook 850 G3

- Details zu meinem Desktop

- Prozessor

- Ryzen7 5800X3D

- Mainboard

- Asus TUF B550 Plus

- Kühlung

- BeQuiet DarkRock4

- Speicher

- 4x16GB DDR4-3200 Crucial

- Grafikprozessor

- XFX RX6700XT 12GB

- Display

- 2x HP X27i

- SSD

- NVMe: 970EVO 1TB, SATA: WD Blue 1TB, 870QVO 4TB, Acer RE100 4TB, 870QVO 8TB

- Optisches Laufwerk

- LG BluRay-Brenner

- Soundkarte

- Realtek ALC1200

- Gehäuse

- Fractal Define R5

- Netzteil

- Seasonic Focus 650W

- Tastatur

- Keychron K4

- Maus

- Logitech MX518

- Betriebssystem

- Win10 Pro/64, Linux 64bit (wechselnd)

- Webbrowser

- Primär: Firefox, sekundär: Wechselnd

- Internetanbindung

- ▼100 MBit ▲32 MBit

OP kauft eine Low-End karte, die vom Herstellers als 1080p Karte beworben wird, jammert über Probleme bei 4K.

Ich bin echt geneigt den Thread wegen trollerei zu schließen.![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Ich bin echt geneigt den Thread wegen trollerei zu schließen.

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

ach lass mal .... er ist eben voll in seinem element ^^ und wenn das geld nicht für eine bessere karte reicht.... dann kann jemand mit der veranlagung sowas auseinanderzupflücken, eben auf sowas kommen  . ist doch sonst schon ziemlich tote hose.

. ist doch sonst schon ziemlich tote hose.

. ist doch sonst schon ziemlich tote hose.

. ist doch sonst schon ziemlich tote hose.ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

ach lass mal .... er ist eben voll in seinem element ^^ und wenn das geld nicht für eine bessere karte reicht.... dann kann jemand mit der veranlagung sowas auseinanderzupflücken, eben auf sowas kommen. ist doch sonst schon ziemlich tote hose.

das hat nichts mit Geld zu tun. Ich habe genug Gerld weil ich nur gutes kaufe und warten kann. nur durch Kritik wird etwas besser. Ist schon komisch, dass das Problem keiner bemerkt. Ich habe es mal mit full HD in far cry 6 probiert. das erste mal den benchmark laufen lassen kommt es auf 55 fps durchschnitt. das 2. mal den benchmark laufen lassen dann nur noch auf 8 fps. genauso das ruckeln mit den pixelshadern auf hoch bei dem superposition benchmark passiert auch bei full HD. Hier ist ein video mit far cry 6 in full hd.

bei 2:00 ist dann der viel langsamere 2. durchlauf

das video ist in mpeg 1 recordet und halber auflösung in X und Y damit der video codec keinen speedverlust erzeugt. das problem passiert natürlich auch wenn ich nicht das recorde. auch wenn ich auf den boden schaue gibt es speedverlust nach einiger zeit. nchdem die AMD speedverlust hatte ist meine gforce 1030 schneller also nenn mir einen Grund wieso ich die AMD behalten solle wenn es da nicht besser wird ?. ich kann auch noch mehr videos machen mit low textures da ist mehr VRAM frei. speedverlust ist aber trotzdem. hat man 8GB tritt es halt nur später auf. in dem channel sind auch noch superposition benches mit low shader und high shader quality auch in FullHD und viel VRAM frei

- Status

- Für weitere Antworten geschlossen.

Ähnliche Themen

- Gesperrt

- Antworten

- 4

- Aufrufe

- 506

- Antworten

- 0

- Aufrufe

- 624

- Antworten

- 2K

- Aufrufe

- 133K

- Antworten

- 504

- Aufrufe

- 74K