App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

RX 6500XT vs. R9 Nano

- Ersteller sompe

- Erstellt am

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Nachdem meine kleine PowerColor Fighter RX 6500XT diese Woche eingetrudelt war hatte ich mir die Zeit genommen ihr im Vergleich zu meiner alten Sapphire R9 Nano mit Fiji GPU und 4 GB HBM Speicher eine etwas umfangreichere Testreihe zu starten und dabei auch noch ausgerechnet meine meine Testplattform mit dem FX-8350, 16 GB 1866er DDR3 RAM und der 500GB Crucial P1 genommen, was letztendlich bedeutet das dort nur PCIe 2.0 zur Verfügung stand.

Zusätzlich wollte ich zu einem späteren Zeitpunkt noch zusätzliche 3D Tests mit dem Ryzen 9 3950X nachreichen um den Einfluss des FX und der PCIe Geschwindigkeit zu überprüfen.

Der Schwerpunkt lag dabei vor allem auf dem Distributed Computing Bereich bei dem die Singlethread Schwäche des FX nicht allso sehr ins Gewicht fallen dürfte.

Zusätzlich habe ich aber auch den 3D Bereich angerissen und erstmal eine Reihe synthetischer Benchmarks durchgejagt, wobei mir hier ausgerechnet die R9 Nano die meisten Probleme bereitete da der provozierte VRAM Überlauf zumindest bei DX11 jedes mal in einem Blackscreen endete. Die RX 6500XT machte diesen hingegen abgesehen vom erwarteten Leistungseinbruch klaglos mit.

Werte zum Takt, der Auslastung und dem Strombedarf wurden per hwinfo64 7.20 ausgelesen. Leider war dort bei der R9 Nano der Wert für die Auslastung des Speichercontrollers nutzlos weil er bei dieser Karte immer bei 0% blieb, selbst bei dem DC Projekt "Einstein" das sehr Speicherlastig ist.

Da beide Karten nicht mit dem gleichen Treiber laufen weil der Treiber Support der R9 Nano mit dem Adrenalin 21.5.2 in den Legacy Support gefallen war, die RX 6500XT aber erst mit späteren Versionen unterstützt wurde hatte ich bei dieser auf den Adrenalin 22.3.1 gesetzt. Leider kann ich dadurch nicht wirklich sagen woran es nun genau liegt.

Nun aber erstmal die gesammelten Ergebnisse von den Tests mit einigen DC Projekten:

Einstein

RX 6500XT

1 WU : ca. 740 Sekunden, GPU ca. 90%, VRAM Controller ca. 33%, max. 2843 MHz und 59W

2 WUs: ca. 1170 Sekunden, GPU ca. 98%, VRAM Controller ca. 39%, max. 2846 MHz und 64W

R9 Nano

1 WU : ca. 380 Sekunden, GPU max. 100%, 874 - 1000 MHz und 145W

2 WUs: ca. 610 Sekunden, GPU max. 100%, 874 - 1000 MHz und 150W

Milkyway

RX 6500XT

1 WU : ca. 120 Sekunden, GPU ca. 97%, VRAM Controller ca. 7%, max. 2842 MHz und 54W

2 WUs: ca. 220 Sekunden, GPU ca. 99%, VRAM Controller ca. 9%, max. 2843 MHz und 62W

VRAM wird bei Berechnung nur auf ca. 190 MHz bzw. 1076 MHz hochgetaktet.

R9 Nano

1 WU : ca. 85 Sekunden, GPU 80 - 99%, 944 - 1000 MHz und max. 150W

2 WUs: ca. 140 Sekunden, GPU 100%, 944 MHz und 150W

PrimeGrid (PPS Sieve)

RX 6500XT

1 WU: ca. 850s, GPU Takt 0-2824 MHz, GPU Auslastung 0-99%, VRAM Controller 0%, VRAM Takt 6-1340 MHz (idR. unter 100 MHz), ca. 45-50W

2 WUs: ca. 1165s, GPU Takt 949-2831 MHz, GPU Auslastung 18-99%, VRAM Controller max. 1%, VRAM Takt 6-1340 MHz (idR. unter 140 MHz), ca. 64-75W

4 WUs: ca. 2040s, GPU Takt 217-2832 MHz, GPU Auslastung 7-99%, VRAM Controller max. 1%, VRAM Takt 10-1076 MHz (idR. unter 140 MHz), ca. 72-77W

R9 Nano

1 WU: ca. 635s, GPU Takt 847-1000 MHz, GPU Auslastung 0-100%, 105-125W

2 WUs: ca. 885s, GPU Takt 911- 974 MHz, GPU Auslastung 100%, 150W

4 WUs: ca. 1740s, GPU Takt 911- 974 MHz, GPU Auslastung 100%, 150W

Moo! Wrapper

RX 6500XT

1 WU: ca. 790s, GPU Takt 0-2728 MHz, GPU Auslastung 0-98%, VRAM Controller 0%, VRAM Takt 2- 24 MHz, 45-85W

2 WUs: ca. 1440s, GPU Takt 2019-2781 MHz, GPU Auslastung 61-99%, VRAM Controller max. 4%, VRAM Takt 10-2234 MHz (idR. unter 20 MHz), 85W

R9 Nano

1 WU: ca. 795s, GPU Takt 717-1000 MHz, GPU Auslastung 74-100%, 150W

2 WUs: ca. 1320s, GPU Takt 717-1000 MHz, GPU Auslastung 100%, 150W

Collatz

RX 6500XT

1 WU: ca. 1260s, GPU Takt 2804 MHz, GPU Auslastung 99%, VRAM Controller 9%, VRAM Takt 2250 MHz, 70W

2 WUs: ca. 2205s, GPU Takt 2823 MHz, GPU Auslastung 99%, VRAM Controller 10%, VRAM Takt 2242 MHz, 79W

R9 Nano

1 WU: ca. 1175s, GPU Takt 874-1000 MHz, GPU Auslastung 100%, 150W

2 WUs: ca. 2340s, GPU Takt 874-1000 MHz, GPU Auslastung 100%, 150W

SRBase

RX 6500XT

1 WU: ca. 985s, GPU Takt ca. 2700 MHz, GPU Auslastung 62-99%, VRAM Controller 0%, VRAM Takt 1076 MHz, 85W

2 WUs: ca. 1965s, GPU Takt ca. 2700 MHz, GPU Auslastung 99%, VRAM Controller 1%, VRAM Takt 1076 MHz, 85W

R9 Nano

1 WU: ca. 770s, GPU Takt 717- 911 MHz, GPU Auslastung 100%, 150W

2 WUs: ca. 1950s, GPU Takt 874-1000 MHz, GPU Auslastung 100%, 150W

[automerge]1648313568[/automerge]

So, gleich folgen die ersten 3D Tests...

3D Mark

RX 6500XT

Time Spy 4445

Time Spy Extreme 1919

Fire Strike 9775

Fire Strike Extreme 5894

Fire Strike Ultra 3383

R9 Nano

Time Spy 4329

Time Spy Extreme 1907

Fire Strike 9957

Fire Strike Extreme *Blackscreen*

Fire Strike Ultra *Blackscreen*

Valley Benchmark

RX 6500XT

Extreme HD - Score: 2191

avg. 52.4 FPS, min. 21.6, max. 100.4

R9 Nano

Extreme HD - Score: 2790

avg. 66.7 FPS, min. 24.8, max. 125.0

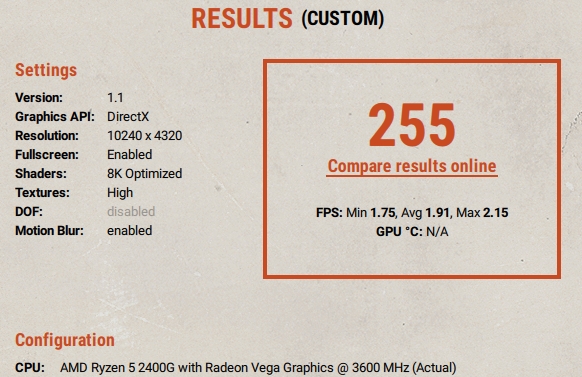

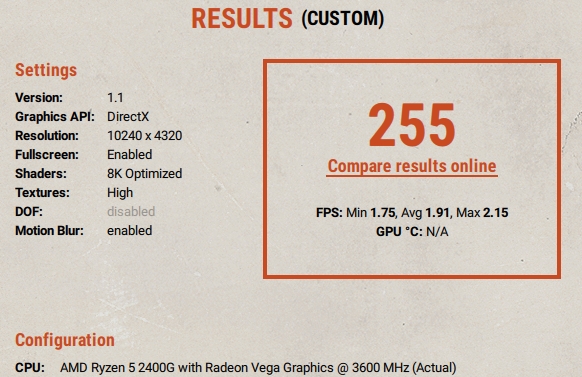

Superposition Benchmark

RX 6500XT

1080p Medium 8531

min. 41.05, Avg. 63.81, Max 85.86

1080p High 6485

min. 38.73, Avg. 48.51, Max 58.41

1080p Extreme 2749

min. 16.84, Avg. 20.57, Max 23.92

4K Optimized 3655

min. 21.15, Avg. 27.34, Max 33.36

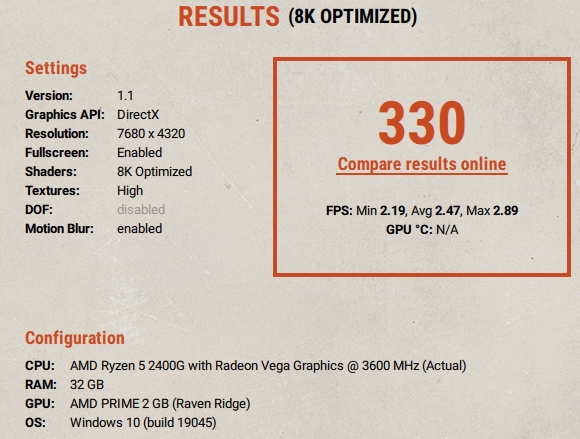

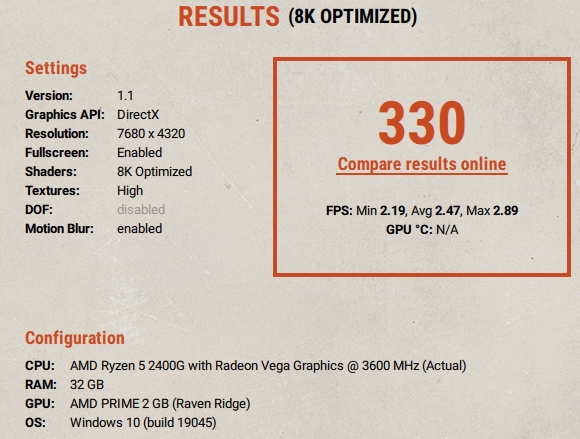

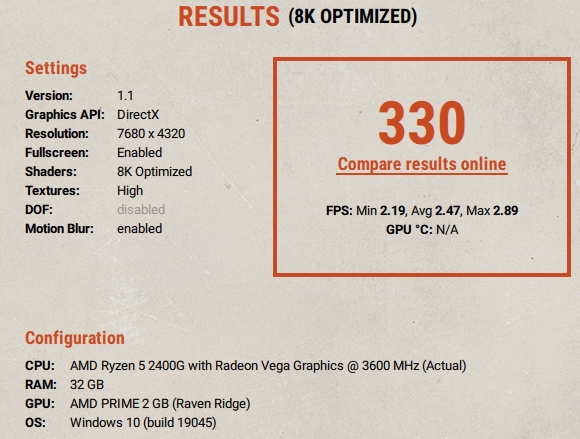

8K Optimized 260

Min. 1.47, Avg 1.95, Max 2.69

R9 Nano

1080p Medium 9107

min. 50.11, Avg. 68.12, Max 85.26

1080p High 6661

min. 40.21, Avg. 49.82, Max 58.43

1080p Extreme 2910

min. 17.40, Avg. 21.77, Max 25.31

4K Optimized *Blackscreen*

8K Optimized *Blackscreen*

[automerge]1648330842[/automerge]

An dieser Stelle setze ich wegen der Blackscreen Probleme beim VRAM Überlauf bei der R9 Nano die Spiele Tests nur noch mit der RX6500XT fort aber auch das spuckt schon mehr als genug Werte aus.

Für heute schließe ich meine kleine Testreihe mit 2 Tomb Raider Titeln auf der FX-8350 Plattform ab um genug Vergleichswerte für den Ryzen Vergleich zu sammeln und selbst da zeigen sich schon einige interessante Gegebenheiten was das Verhalten von Spielen beim VRAM Überlauf betrifft.

Rise of the Tomb Raider

Das Speichermanagement des Spiels scheint deutlich schlechter mit dem VRAM Überlauf klar zu kommen als bei dessen Nachfolger allerdings macht sich mit dem FX-8350 durchaus das verbesserte Multithreading von DX12 bemerkbar.

1920 x 1080, DX11, Preset @ Sehr hoch

Texturenqualität @ hoch

Berggipfel: 59.68 FPS (min: 27.84, max: 81.06)

Syrien: 54.52 FPS (min: 9.70, max: 81.60)

Geothermales Tal: 42.65 FPS (min: 7.92, max: 74.78)

GPU D3D Speicher dediziert: max. 3531 MB

GPU D3D Speicher dynamisch: max. 96MB

Gesammte CPU-Auslastung: max. 81.3%

Texturenqualität @ Sehr hoch

Berggipfel: 59.00 FPS (min: 19.80, max: 99.50)

Syrien: 49.61 FPS (min: 8.03, max: 81.19)

Geothermales Tal: 42.12 FPS (min: 5.19, max: 62.30)

GPU D3D Speicher dediziert: max. 4032 MB

GPU D3D Speicher dynamisch: max. 115 MB

Gesammte CPU-Auslastung: max. 84.4%

DX12, Preset @ Sehr hoch

Texturenqualität @ hoch

Berggipfel: 59.95 FPS (min: 39.07, max: 96.72)

Syrien: 59.14 FPS (min: 29.80, max: 87.83)

Geothermales Tal: 51.02 FPS (min: 25.14, max: 69.67)

GPU D3D Speicher dediziert: max. 4020 MB

GPU D3D Speicher dynamisch: max. 345 MB

Gesammte CPU-Auslastung: max. 89.5%

Texturenqualität @ Sehr hoch

Berggipfel: 59.54 FPS (min: 10.34, max: 89.77)

Syrien: 55.93 FPS (min: 4.46, max: 93.76)

Geothermales Tal: 49.00 FPS (min: 2.84, max: 71.21)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 623 MB

Gesammte CPU-Auslastung: max. 93.5%

Shadow of the Tomb Raider

Wie man sieht geht die Framerate mit zunehmenden Texturendetails deutlich nach unten, wohl nicht zuletzt aufgrund des PCIe 2.0 Standards der Testplattform. Deutlich negativer wirkt sich allerdings DX11 auf die min. FPS aus, hier fallen dem Spiel wohl einfach die Unzulänglichkeiten der API beim Multithreading auf die Füße. Was allerdings auch auffällt ist dass die Nutzung des dynamischen Speichers bei DX11 deutlich gedeckelt zu sein scheint.

1920 x 1080, DX11, Preset @ Ultrahoch

Texturenqualität @ normal

GPU FPS: avg. 48, min. 23, max. 101, 95% 26

CPU Spiel: avg. 93, min. 59, max. 116, 95% 71

CPU Render: avg. 44, min. 23, max. 83, 95% 26

GPU D3D Speicher dediziert: max. 3479 MB

GPU D3D Speicher dynamisch: max. 598 MB

Gesammte CPU-Auslastung: max. 67.4%

Texturenqualität @ hoch

GPU FPS: avg. 47, min. 22, max. 100, 95% 26

CPU Spiel: avg. 94, min. 49, max. 118, 95% 72

CPU Render: avg. 43, min. 15, max. 82, 95% 26

GPU D3D Speicher dediziert: max. 4043 MB

GPU D3D Speicher dynamisch: max. 575 MB

Gesammte CPU-Auslastung: max. 68.2%

Texturenqualität @ Ultra

GPU FPS: avg. 47, min. 23, max. 95, 95% 26

CPU Spiel: avg. 93, min. 55, max. 117, 95% 70

CPU Render: avg. 42, min. 23, max. 82, 95% 26

GPU D3D Speicher dediziert: max. 4042 MB

GPU D3D Speicher dynamisch: max. 609 MB

Gesammte CPU-Auslastung: max. 65.7%

DX12, Preset @ Ultrahoch

Texturenqualität @ normal

GPU FPS: avg. 54, min. 39, max. 94, 95% 42

CPU Spiel: avg. 81, min. 55, max. 114, 95% 63

CPU Render: avg. 105, min. 60, max. 242, 95% 59

GPU D3D Speicher dediziert: max. 3642 MB

GPU D3D Speicher dynamisch: max. 1165 MB

Gesammte CPU-Auslastung: max. 82.3%

Texturenqualität @ hoch

GPU FPS: avg. 41, min. 27, max. 77, 95% 28

CPU Spiel: avg. 82, min. 39, max. 118, 95% 60

CPU Render: avg. 104, min. 60, max. 241, 95% 63

GPU D3D Speicher dediziert: max. 3528 MB

GPU D3D Speicher dynamisch: max. 3111 MB

Gesammte CPU-Auslastung: max. 77.5%

Texturenqualität @ Ultra

GPU FPS: avg. 38, min. 27, max. 70, 95% 28

CPU Spiel: avg. 80, min. 41, max. 114, 95% 58

CPU Render: avg. 104, min. 60, max. 240, 95% 63

GPU D3D Speicher dediziert: max. 3769 MB

GPU D3D Speicher dynamisch: max. 4133 MB

Gesammte CPU-Auslastung: max. 73.7%

So, nun aber genug für heute.

Zusätzlich wollte ich zu einem späteren Zeitpunkt noch zusätzliche 3D Tests mit dem Ryzen 9 3950X nachreichen um den Einfluss des FX und der PCIe Geschwindigkeit zu überprüfen.

Der Schwerpunkt lag dabei vor allem auf dem Distributed Computing Bereich bei dem die Singlethread Schwäche des FX nicht allso sehr ins Gewicht fallen dürfte.

Zusätzlich habe ich aber auch den 3D Bereich angerissen und erstmal eine Reihe synthetischer Benchmarks durchgejagt, wobei mir hier ausgerechnet die R9 Nano die meisten Probleme bereitete da der provozierte VRAM Überlauf zumindest bei DX11 jedes mal in einem Blackscreen endete. Die RX 6500XT machte diesen hingegen abgesehen vom erwarteten Leistungseinbruch klaglos mit.

Werte zum Takt, der Auslastung und dem Strombedarf wurden per hwinfo64 7.20 ausgelesen. Leider war dort bei der R9 Nano der Wert für die Auslastung des Speichercontrollers nutzlos weil er bei dieser Karte immer bei 0% blieb, selbst bei dem DC Projekt "Einstein" das sehr Speicherlastig ist.

Da beide Karten nicht mit dem gleichen Treiber laufen weil der Treiber Support der R9 Nano mit dem Adrenalin 21.5.2 in den Legacy Support gefallen war, die RX 6500XT aber erst mit späteren Versionen unterstützt wurde hatte ich bei dieser auf den Adrenalin 22.3.1 gesetzt. Leider kann ich dadurch nicht wirklich sagen woran es nun genau liegt.

Nun aber erstmal die gesammelten Ergebnisse von den Tests mit einigen DC Projekten:

Einstein

RX 6500XT

1 WU : ca. 740 Sekunden, GPU ca. 90%, VRAM Controller ca. 33%, max. 2843 MHz und 59W

2 WUs: ca. 1170 Sekunden, GPU ca. 98%, VRAM Controller ca. 39%, max. 2846 MHz und 64W

R9 Nano

1 WU : ca. 380 Sekunden, GPU max. 100%, 874 - 1000 MHz und 145W

2 WUs: ca. 610 Sekunden, GPU max. 100%, 874 - 1000 MHz und 150W

Milkyway

RX 6500XT

1 WU : ca. 120 Sekunden, GPU ca. 97%, VRAM Controller ca. 7%, max. 2842 MHz und 54W

2 WUs: ca. 220 Sekunden, GPU ca. 99%, VRAM Controller ca. 9%, max. 2843 MHz und 62W

VRAM wird bei Berechnung nur auf ca. 190 MHz bzw. 1076 MHz hochgetaktet.

R9 Nano

1 WU : ca. 85 Sekunden, GPU 80 - 99%, 944 - 1000 MHz und max. 150W

2 WUs: ca. 140 Sekunden, GPU 100%, 944 MHz und 150W

PrimeGrid (PPS Sieve)

RX 6500XT

1 WU: ca. 850s, GPU Takt 0-2824 MHz, GPU Auslastung 0-99%, VRAM Controller 0%, VRAM Takt 6-1340 MHz (idR. unter 100 MHz), ca. 45-50W

2 WUs: ca. 1165s, GPU Takt 949-2831 MHz, GPU Auslastung 18-99%, VRAM Controller max. 1%, VRAM Takt 6-1340 MHz (idR. unter 140 MHz), ca. 64-75W

4 WUs: ca. 2040s, GPU Takt 217-2832 MHz, GPU Auslastung 7-99%, VRAM Controller max. 1%, VRAM Takt 10-1076 MHz (idR. unter 140 MHz), ca. 72-77W

R9 Nano

1 WU: ca. 635s, GPU Takt 847-1000 MHz, GPU Auslastung 0-100%, 105-125W

2 WUs: ca. 885s, GPU Takt 911- 974 MHz, GPU Auslastung 100%, 150W

4 WUs: ca. 1740s, GPU Takt 911- 974 MHz, GPU Auslastung 100%, 150W

Moo! Wrapper

RX 6500XT

1 WU: ca. 790s, GPU Takt 0-2728 MHz, GPU Auslastung 0-98%, VRAM Controller 0%, VRAM Takt 2- 24 MHz, 45-85W

2 WUs: ca. 1440s, GPU Takt 2019-2781 MHz, GPU Auslastung 61-99%, VRAM Controller max. 4%, VRAM Takt 10-2234 MHz (idR. unter 20 MHz), 85W

R9 Nano

1 WU: ca. 795s, GPU Takt 717-1000 MHz, GPU Auslastung 74-100%, 150W

2 WUs: ca. 1320s, GPU Takt 717-1000 MHz, GPU Auslastung 100%, 150W

Collatz

RX 6500XT

1 WU: ca. 1260s, GPU Takt 2804 MHz, GPU Auslastung 99%, VRAM Controller 9%, VRAM Takt 2250 MHz, 70W

2 WUs: ca. 2205s, GPU Takt 2823 MHz, GPU Auslastung 99%, VRAM Controller 10%, VRAM Takt 2242 MHz, 79W

R9 Nano

1 WU: ca. 1175s, GPU Takt 874-1000 MHz, GPU Auslastung 100%, 150W

2 WUs: ca. 2340s, GPU Takt 874-1000 MHz, GPU Auslastung 100%, 150W

SRBase

RX 6500XT

1 WU: ca. 985s, GPU Takt ca. 2700 MHz, GPU Auslastung 62-99%, VRAM Controller 0%, VRAM Takt 1076 MHz, 85W

2 WUs: ca. 1965s, GPU Takt ca. 2700 MHz, GPU Auslastung 99%, VRAM Controller 1%, VRAM Takt 1076 MHz, 85W

R9 Nano

1 WU: ca. 770s, GPU Takt 717- 911 MHz, GPU Auslastung 100%, 150W

2 WUs: ca. 1950s, GPU Takt 874-1000 MHz, GPU Auslastung 100%, 150W

[automerge]1648313568[/automerge]

So, gleich folgen die ersten 3D Tests...

3D Mark

RX 6500XT

Time Spy 4445

Time Spy Extreme 1919

Fire Strike 9775

Fire Strike Extreme 5894

Fire Strike Ultra 3383

R9 Nano

Time Spy 4329

Time Spy Extreme 1907

Fire Strike 9957

Fire Strike Extreme *Blackscreen*

Fire Strike Ultra *Blackscreen*

Valley Benchmark

RX 6500XT

Extreme HD - Score: 2191

avg. 52.4 FPS, min. 21.6, max. 100.4

R9 Nano

Extreme HD - Score: 2790

avg. 66.7 FPS, min. 24.8, max. 125.0

Superposition Benchmark

RX 6500XT

1080p Medium 8531

min. 41.05, Avg. 63.81, Max 85.86

1080p High 6485

min. 38.73, Avg. 48.51, Max 58.41

1080p Extreme 2749

min. 16.84, Avg. 20.57, Max 23.92

4K Optimized 3655

min. 21.15, Avg. 27.34, Max 33.36

8K Optimized 260

Min. 1.47, Avg 1.95, Max 2.69

R9 Nano

1080p Medium 9107

min. 50.11, Avg. 68.12, Max 85.26

1080p High 6661

min. 40.21, Avg. 49.82, Max 58.43

1080p Extreme 2910

min. 17.40, Avg. 21.77, Max 25.31

4K Optimized *Blackscreen*

8K Optimized *Blackscreen*

[automerge]1648330842[/automerge]

An dieser Stelle setze ich wegen der Blackscreen Probleme beim VRAM Überlauf bei der R9 Nano die Spiele Tests nur noch mit der RX6500XT fort aber auch das spuckt schon mehr als genug Werte aus.

Für heute schließe ich meine kleine Testreihe mit 2 Tomb Raider Titeln auf der FX-8350 Plattform ab um genug Vergleichswerte für den Ryzen Vergleich zu sammeln und selbst da zeigen sich schon einige interessante Gegebenheiten was das Verhalten von Spielen beim VRAM Überlauf betrifft.

Rise of the Tomb Raider

Das Speichermanagement des Spiels scheint deutlich schlechter mit dem VRAM Überlauf klar zu kommen als bei dessen Nachfolger allerdings macht sich mit dem FX-8350 durchaus das verbesserte Multithreading von DX12 bemerkbar.

1920 x 1080, DX11, Preset @ Sehr hoch

Texturenqualität @ hoch

Berggipfel: 59.68 FPS (min: 27.84, max: 81.06)

Syrien: 54.52 FPS (min: 9.70, max: 81.60)

Geothermales Tal: 42.65 FPS (min: 7.92, max: 74.78)

GPU D3D Speicher dediziert: max. 3531 MB

GPU D3D Speicher dynamisch: max. 96MB

Gesammte CPU-Auslastung: max. 81.3%

Texturenqualität @ Sehr hoch

Berggipfel: 59.00 FPS (min: 19.80, max: 99.50)

Syrien: 49.61 FPS (min: 8.03, max: 81.19)

Geothermales Tal: 42.12 FPS (min: 5.19, max: 62.30)

GPU D3D Speicher dediziert: max. 4032 MB

GPU D3D Speicher dynamisch: max. 115 MB

Gesammte CPU-Auslastung: max. 84.4%

DX12, Preset @ Sehr hoch

Texturenqualität @ hoch

Berggipfel: 59.95 FPS (min: 39.07, max: 96.72)

Syrien: 59.14 FPS (min: 29.80, max: 87.83)

Geothermales Tal: 51.02 FPS (min: 25.14, max: 69.67)

GPU D3D Speicher dediziert: max. 4020 MB

GPU D3D Speicher dynamisch: max. 345 MB

Gesammte CPU-Auslastung: max. 89.5%

Texturenqualität @ Sehr hoch

Berggipfel: 59.54 FPS (min: 10.34, max: 89.77)

Syrien: 55.93 FPS (min: 4.46, max: 93.76)

Geothermales Tal: 49.00 FPS (min: 2.84, max: 71.21)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 623 MB

Gesammte CPU-Auslastung: max. 93.5%

Shadow of the Tomb Raider

Wie man sieht geht die Framerate mit zunehmenden Texturendetails deutlich nach unten, wohl nicht zuletzt aufgrund des PCIe 2.0 Standards der Testplattform. Deutlich negativer wirkt sich allerdings DX11 auf die min. FPS aus, hier fallen dem Spiel wohl einfach die Unzulänglichkeiten der API beim Multithreading auf die Füße. Was allerdings auch auffällt ist dass die Nutzung des dynamischen Speichers bei DX11 deutlich gedeckelt zu sein scheint.

1920 x 1080, DX11, Preset @ Ultrahoch

Texturenqualität @ normal

GPU FPS: avg. 48, min. 23, max. 101, 95% 26

CPU Spiel: avg. 93, min. 59, max. 116, 95% 71

CPU Render: avg. 44, min. 23, max. 83, 95% 26

GPU D3D Speicher dediziert: max. 3479 MB

GPU D3D Speicher dynamisch: max. 598 MB

Gesammte CPU-Auslastung: max. 67.4%

Texturenqualität @ hoch

GPU FPS: avg. 47, min. 22, max. 100, 95% 26

CPU Spiel: avg. 94, min. 49, max. 118, 95% 72

CPU Render: avg. 43, min. 15, max. 82, 95% 26

GPU D3D Speicher dediziert: max. 4043 MB

GPU D3D Speicher dynamisch: max. 575 MB

Gesammte CPU-Auslastung: max. 68.2%

Texturenqualität @ Ultra

GPU FPS: avg. 47, min. 23, max. 95, 95% 26

CPU Spiel: avg. 93, min. 55, max. 117, 95% 70

CPU Render: avg. 42, min. 23, max. 82, 95% 26

GPU D3D Speicher dediziert: max. 4042 MB

GPU D3D Speicher dynamisch: max. 609 MB

Gesammte CPU-Auslastung: max. 65.7%

DX12, Preset @ Ultrahoch

Texturenqualität @ normal

GPU FPS: avg. 54, min. 39, max. 94, 95% 42

CPU Spiel: avg. 81, min. 55, max. 114, 95% 63

CPU Render: avg. 105, min. 60, max. 242, 95% 59

GPU D3D Speicher dediziert: max. 3642 MB

GPU D3D Speicher dynamisch: max. 1165 MB

Gesammte CPU-Auslastung: max. 82.3%

Texturenqualität @ hoch

GPU FPS: avg. 41, min. 27, max. 77, 95% 28

CPU Spiel: avg. 82, min. 39, max. 118, 95% 60

CPU Render: avg. 104, min. 60, max. 241, 95% 63

GPU D3D Speicher dediziert: max. 3528 MB

GPU D3D Speicher dynamisch: max. 3111 MB

Gesammte CPU-Auslastung: max. 77.5%

Texturenqualität @ Ultra

GPU FPS: avg. 38, min. 27, max. 70, 95% 28

CPU Spiel: avg. 80, min. 41, max. 114, 95% 58

CPU Render: avg. 104, min. 60, max. 240, 95% 63

GPU D3D Speicher dediziert: max. 3769 MB

GPU D3D Speicher dynamisch: max. 4133 MB

Gesammte CPU-Auslastung: max. 73.7%

So, nun aber genug für heute.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ein neuer Tag und neues Glück, die PCIe Tests der RX 6500XT sind da.

Getestet wurde mit einem Ryzen 9 3950x dem 64 GB 3200er CL14 Speicher zur Seite standen. Um euch nicht mit Werten sinnlos zu überschwemmen hatte ich mich auf die DirectX12 Versionen beschränkt und die Werte vom CPU Test und der Speicherbelegung nur bei PCIe 4.0 Test dazu geschrieben denn an den Ergebnissen ändert sich eh kaum etwas.

1920 x 1080, SAM aktiv

Rise of the Tomb Raider

DX12, Preset @ Sehr hoch

Texturenqualität @ hoch

PCIe 4.0

Berggipfel: 82.97 FPS (min: 62.93, max: 149.32)

Syrien: 75.24 FPS (min: 59.33, max: 84.67)

Geothermales Tal: 68.22 FPS (min: 55.30, max: 84.71)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 492 MB

Gesammte CPU-Auslastung: max. 17.4%

PCIe 3.0

Berggipfel: 100.36 FPS (min: 62.77, max: 141.78)

Syrien: 70.47 FPS (min: 56.48, max: 76.83)

Geothermales Tal: 62.47 FPS (min: 52.40, max: 78.88)

PCIe 2.0

Berggipfel: 93.60 FPS (min: 56.51, max: 129.35)

Syrien: 64.95 FPS (min: 42.23, max: 74.87)

Geothermales Tal: 55.38 FPS (min: 38.53, max: 73.13)

Texturenqualität @ Sehr hoch

PCIe 4.0

Berggipfel: 100.74 FPS (min: 41.34, max: 165.17)

Syrien: 75.12 FPS (min: 50.38, max: 93.98)

Geothermales Tal: 66.98 FPS (min: 42.45, max: 85.02)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 647 MB

Gesammte CPU-Auslastung: max. 20.8%

PCIe 3.0

Berggipfel: 97.33 FPS (min: 26.99, max: 129.93)

Syrien: 69.61 FPS (min: 42.51, max: 77.96)

Geothermales Tal: 61.53 FPS (min: 37.65, max: 77.28)

PCIe 2.0

Berggipfel: 91.09 FPS (min: 26.27, max: 123.13)

Syrien: 61.16 FPS (min: 9.93, max: 84.04)

Geothermales Tal: 46.63 FPS (min: 17.05, max: 59.81)

Shadow of the Tomb Raider

DX12, Preset @ Ultrahoch

Texturenqualität @ normal

PCIe 4.0

GPU FPS: avg. 69, min. 56, max. 107, 95% 60

CPU Spiel: avg. 170, min. 125, max. 229, 95% 128

CPU Render: avg. 274, min. 183, max. 486, 95% 194

GPU D3D Speicher dediziert: max. 3934 MB

GPU D3D Speicher dynamisch: max. 1026 MB

Gesammte CPU-Auslastung: max. 27.1%

PCIe 3.0

GPU FPS: avg. 61, min. 49, max. 100, 95% 50

PCIe 2.0

GPU FPS: avg. 52, min. 39, max. 95, 95% 41

Texturenqualität @ hoch

PCIe 4.0

GPU FPS: avg. 65, min. 53, max. 104, 95% 54

GPU D3D Speicher dediziert: max. 3607 MB

GPU D3D Speicher dynamisch: max. 2268 MB

Gesammte CPU-Auslastung: max. 20.9%

PCIe 3.0

GPU FPS: avg. 50, min. 34, max. 92, 95% 35

PCIe 2.0

GPU FPS: avg. 38, min. 22, max. 82, 95% 27

Texturenqualität @ Ultra

PCIe 4.0

GPU FPS: avg. 57, min. 42, max. 100, 95% 45

GPU D3D Speicher dediziert: max. 3840 MB

GPU D3D Speicher dynamisch: max. 4176 MB

Gesammte CPU-Auslastung: max. 19.0%

PCIe 3.0

GPU FPS: avg. 43, min. 28, max. 90, 95% 31

PCIe 2.0

GPU FPS: avg. 29, min. 17, max. 76, 95% 18

Wie man sieht halten sich de Unterschiede zwischen PCIe 4.0 und 3.0 durchaus in Grenzen, wolange man es nicht mit den Textureneinstellungen übertreibt.

PCIe 2.0 ist aber definitiv zu wenig denn bei "Shadow of the Tomb Raider" rutscht selbst der Ryzen auf das Niveau des FX. Das Spiel "Rise of the Tomb Raider" kommt zwar durch sein Speichermanagement auf den ersten Blick besser mit dem knappen VRAM klar, neigt dafür aber deutlich stärker zu FPS Einbrüchen die die min. FPS in den Keller ziehen.

In beiden Fällen kann man aber durchaus erkennen das selbst mit PCIe 3.0 Systemen und angepassten Textureneinstellungen das schmale PCIe Interface kaum zum zum Flaschenhals wurde aber je mehr man es mit den Texturen übertreibt desto mehr zieht das Auslagern bz. ständige Nachladen der Texturen die Performance in den Keller.

Jetzt brauche ich aber erstmal eine kurze Pause um das System wieder auf die 6900XT umzubauen damit ich mit dieser nochmal untersuchen kann wie groß der Leistungsunterschied zwischen den Textureneinstellungen überhaupt ausfällt wenn der VRAM groß genug ist.

Da es dabei nicht um die FPS selbst geht sondern lediglich um die Abweichung zwischen den Texturenstufen sollte der gravierende Leistungsunterschied kein allso großes Problem sein.

[automerge]1648403204[/automerge]

Da das Spiel "Shadow of the Tomb Raider" recht gleichmäßig mit dem Speicherüberlauf einbrach habe ich mir gleich mal dieses genommen um den Einfluss der Textureneinstellungen bei ausreichend VRAM auszutesten. Da die RX 6900XT mit FullHD ein gutes Stück unterfordert ist und das Spiel im CPU Limit rumrennt habe ich auch gleich noch mit UHD Einstellung mit getesten um auch das GPU Limit mitzunehmen. Die max. Belegung des VRAM der Grafikkarte habe ich gleich noch dazu geschrieben.

Tja, was soll ich sagen? Wie man sieht haben die Textureneinstellungen praktisch keine Auswirkungen auf die Leistung der Grafikkarte, jedenfalls wenn der VRAM reicht.

Shadow of the Tomb Raider

RX 6900XT, DX12, Preset @ Ultrahoch

1920 x 1080 (GPU Auslastung ca. 75 - 90%)

Texturenqualität @ normal (5426 MB)

GPU FPS: avg. 217, min. 156, max. 290, 95% 156

Texturenqualität @ hoch (7416 MB)

GPU FPS: avg. 217, min. 149, max. 292, 95% 159

Texturenqualität @ Ultra (8495 MB)

GPU FPS: avg. 217, min. 153, max. 292, 95% 159

3840 x 2160 (GPU Auslastung 100%)

Texturenqualität @ normal (6866 MB)

GPU FPS: avg. 93, min. 77, max. 131, 95% 81

Texturenqualität @ hoch (8823 MB)

GPU FPS: avg. 91, min. 76, max. 130, 95% 80

Texturenqualität @ Ultra (9947 MB)

GPU FPS: avg. 91, min. 75, max. 130, 95% 79

Da sich das Spiel "Rise of the Tomb Raider" beim Speichermanagement deutlich anders verhalten hat und beim Speicherüberlauf nur wenig auslagerte wollte ich noch mal die FullHD Einstellungen durchgehen um zu schauen wieviel VRAM das Spiel belegt wenn genug davon da ist.

Die Werte kommen gleich nach.

[automerge]1648405082[/automerge]

So, die Werte für den Speicherbedarf sind da und wenn ichs ehe wieviel sich das Spiel unter den Nagel reißen kann wenn es darf dann wundern einen die erheblichen Nachladeruckler bei der höchsten Textureneinstellung nicht wirklich. Weil ich gerade dabei war habe ich gleich noch die max. Speicherbelegung mit UHD mitgetestet.

FullHD

hoch = 5291 MB

sehr hoch = 9484 MB

UHD

hoch = 6398 MB

sehr hoch = 10564 MB

So, das sollte erstmal alles von mir sein aber wenn jemand noch einen besonderen Wunsch zum Nachtesten hat dann kann ich mal schauen ob ich entsprechend nachtesten kann.

Getestet wurde mit einem Ryzen 9 3950x dem 64 GB 3200er CL14 Speicher zur Seite standen. Um euch nicht mit Werten sinnlos zu überschwemmen hatte ich mich auf die DirectX12 Versionen beschränkt und die Werte vom CPU Test und der Speicherbelegung nur bei PCIe 4.0 Test dazu geschrieben denn an den Ergebnissen ändert sich eh kaum etwas.

1920 x 1080, SAM aktiv

Rise of the Tomb Raider

DX12, Preset @ Sehr hoch

Texturenqualität @ hoch

PCIe 4.0

Berggipfel: 82.97 FPS (min: 62.93, max: 149.32)

Syrien: 75.24 FPS (min: 59.33, max: 84.67)

Geothermales Tal: 68.22 FPS (min: 55.30, max: 84.71)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 492 MB

Gesammte CPU-Auslastung: max. 17.4%

PCIe 3.0

Berggipfel: 100.36 FPS (min: 62.77, max: 141.78)

Syrien: 70.47 FPS (min: 56.48, max: 76.83)

Geothermales Tal: 62.47 FPS (min: 52.40, max: 78.88)

PCIe 2.0

Berggipfel: 93.60 FPS (min: 56.51, max: 129.35)

Syrien: 64.95 FPS (min: 42.23, max: 74.87)

Geothermales Tal: 55.38 FPS (min: 38.53, max: 73.13)

Texturenqualität @ Sehr hoch

PCIe 4.0

Berggipfel: 100.74 FPS (min: 41.34, max: 165.17)

Syrien: 75.12 FPS (min: 50.38, max: 93.98)

Geothermales Tal: 66.98 FPS (min: 42.45, max: 85.02)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 647 MB

Gesammte CPU-Auslastung: max. 20.8%

PCIe 3.0

Berggipfel: 97.33 FPS (min: 26.99, max: 129.93)

Syrien: 69.61 FPS (min: 42.51, max: 77.96)

Geothermales Tal: 61.53 FPS (min: 37.65, max: 77.28)

PCIe 2.0

Berggipfel: 91.09 FPS (min: 26.27, max: 123.13)

Syrien: 61.16 FPS (min: 9.93, max: 84.04)

Geothermales Tal: 46.63 FPS (min: 17.05, max: 59.81)

Shadow of the Tomb Raider

DX12, Preset @ Ultrahoch

Texturenqualität @ normal

PCIe 4.0

GPU FPS: avg. 69, min. 56, max. 107, 95% 60

CPU Spiel: avg. 170, min. 125, max. 229, 95% 128

CPU Render: avg. 274, min. 183, max. 486, 95% 194

GPU D3D Speicher dediziert: max. 3934 MB

GPU D3D Speicher dynamisch: max. 1026 MB

Gesammte CPU-Auslastung: max. 27.1%

PCIe 3.0

GPU FPS: avg. 61, min. 49, max. 100, 95% 50

PCIe 2.0

GPU FPS: avg. 52, min. 39, max. 95, 95% 41

Texturenqualität @ hoch

PCIe 4.0

GPU FPS: avg. 65, min. 53, max. 104, 95% 54

GPU D3D Speicher dediziert: max. 3607 MB

GPU D3D Speicher dynamisch: max. 2268 MB

Gesammte CPU-Auslastung: max. 20.9%

PCIe 3.0

GPU FPS: avg. 50, min. 34, max. 92, 95% 35

PCIe 2.0

GPU FPS: avg. 38, min. 22, max. 82, 95% 27

Texturenqualität @ Ultra

PCIe 4.0

GPU FPS: avg. 57, min. 42, max. 100, 95% 45

GPU D3D Speicher dediziert: max. 3840 MB

GPU D3D Speicher dynamisch: max. 4176 MB

Gesammte CPU-Auslastung: max. 19.0%

PCIe 3.0

GPU FPS: avg. 43, min. 28, max. 90, 95% 31

PCIe 2.0

GPU FPS: avg. 29, min. 17, max. 76, 95% 18

Wie man sieht halten sich de Unterschiede zwischen PCIe 4.0 und 3.0 durchaus in Grenzen, wolange man es nicht mit den Textureneinstellungen übertreibt.

PCIe 2.0 ist aber definitiv zu wenig denn bei "Shadow of the Tomb Raider" rutscht selbst der Ryzen auf das Niveau des FX. Das Spiel "Rise of the Tomb Raider" kommt zwar durch sein Speichermanagement auf den ersten Blick besser mit dem knappen VRAM klar, neigt dafür aber deutlich stärker zu FPS Einbrüchen die die min. FPS in den Keller ziehen.

In beiden Fällen kann man aber durchaus erkennen das selbst mit PCIe 3.0 Systemen und angepassten Textureneinstellungen das schmale PCIe Interface kaum zum zum Flaschenhals wurde aber je mehr man es mit den Texturen übertreibt desto mehr zieht das Auslagern bz. ständige Nachladen der Texturen die Performance in den Keller.

Jetzt brauche ich aber erstmal eine kurze Pause um das System wieder auf die 6900XT umzubauen damit ich mit dieser nochmal untersuchen kann wie groß der Leistungsunterschied zwischen den Textureneinstellungen überhaupt ausfällt wenn der VRAM groß genug ist.

Da es dabei nicht um die FPS selbst geht sondern lediglich um die Abweichung zwischen den Texturenstufen sollte der gravierende Leistungsunterschied kein allso großes Problem sein.

[automerge]1648403204[/automerge]

Da das Spiel "Shadow of the Tomb Raider" recht gleichmäßig mit dem Speicherüberlauf einbrach habe ich mir gleich mal dieses genommen um den Einfluss der Textureneinstellungen bei ausreichend VRAM auszutesten. Da die RX 6900XT mit FullHD ein gutes Stück unterfordert ist und das Spiel im CPU Limit rumrennt habe ich auch gleich noch mit UHD Einstellung mit getesten um auch das GPU Limit mitzunehmen. Die max. Belegung des VRAM der Grafikkarte habe ich gleich noch dazu geschrieben.

Tja, was soll ich sagen? Wie man sieht haben die Textureneinstellungen praktisch keine Auswirkungen auf die Leistung der Grafikkarte, jedenfalls wenn der VRAM reicht.

Shadow of the Tomb Raider

RX 6900XT, DX12, Preset @ Ultrahoch

1920 x 1080 (GPU Auslastung ca. 75 - 90%)

Texturenqualität @ normal (5426 MB)

GPU FPS: avg. 217, min. 156, max. 290, 95% 156

Texturenqualität @ hoch (7416 MB)

GPU FPS: avg. 217, min. 149, max. 292, 95% 159

Texturenqualität @ Ultra (8495 MB)

GPU FPS: avg. 217, min. 153, max. 292, 95% 159

3840 x 2160 (GPU Auslastung 100%)

Texturenqualität @ normal (6866 MB)

GPU FPS: avg. 93, min. 77, max. 131, 95% 81

Texturenqualität @ hoch (8823 MB)

GPU FPS: avg. 91, min. 76, max. 130, 95% 80

Texturenqualität @ Ultra (9947 MB)

GPU FPS: avg. 91, min. 75, max. 130, 95% 79

Da sich das Spiel "Rise of the Tomb Raider" beim Speichermanagement deutlich anders verhalten hat und beim Speicherüberlauf nur wenig auslagerte wollte ich noch mal die FullHD Einstellungen durchgehen um zu schauen wieviel VRAM das Spiel belegt wenn genug davon da ist.

Die Werte kommen gleich nach.

[automerge]1648405082[/automerge]

So, die Werte für den Speicherbedarf sind da und wenn ichs ehe wieviel sich das Spiel unter den Nagel reißen kann wenn es darf dann wundern einen die erheblichen Nachladeruckler bei der höchsten Textureneinstellung nicht wirklich. Weil ich gerade dabei war habe ich gleich noch die max. Speicherbelegung mit UHD mitgetestet.

FullHD

hoch = 5291 MB

sehr hoch = 9484 MB

UHD

hoch = 6398 MB

sehr hoch = 10564 MB

So, das sollte erstmal alles von mir sein aber wenn jemand noch einen besonderen Wunsch zum Nachtesten hat dann kann ich mal schauen ob ich entsprechend nachtesten kann.

Zuletzt bearbeitet:

TAL9000

Grand Admiral Special

- Mitglied seit

- 20.03.2007

- Beiträge

- 5.946

- Renomée

- 665

- Standort

- nähe Giessen

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- was halt so geht, bervozuge aber Bio/Physik/Astronomie Projekte

- Lieblingsprojekt

- SIMAP, danach kam mMn nichts mehr direkt produktives

- Meine Systeme

- Ryzen 3700X; 4650G; Radeon RX6950XT; RX6500XT

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Fujitsu LifeBook E546 FJNB291

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X // Ryzen 5 4650G // Intel Core i7-3770 + i5-3570K

- Mainboard

- MSI B350 PC Mate // ASRock A300-STX // 2x Intel DH77EB

- Kühlung

- Arctic Liquid Freezer 240 + 2x SilverStone FW121 // Noctua NH-L9a // AC Freezer 7 // Intel E41759

- Speicher

- 2x16GB DDR4-3200 // 2x8GB DDR4-3200 // 2x8GB DDR3-1600 // 4x4GB DDR3-1600

- Grafikprozessor

- PowerColor Radeon RX 6950 XT Red Devil 16G // AMD IGP // Sapphire Pulse RX 6500 XT 4G // Intel IGP

- Display

- 24" Lenovo ThinkVision LT2452p 1920x1200

- SSD

- WD_BLACK SN750 500GB // Transcend MTE110S 256GB // Canvas SL308 250GB // Crucial MX500 250GB

- HDD

- MG06ACA800E 8TB // Z5K1000 1TB // HDWA120EZSTA 2TB // HD153UI 1,5TB

- Optisches Laufwerk

- - // - // LiteOn iHAS120 DVD-RW // LG DVD-RW

- Soundkarte

- OnBoard

- Gehäuse

- Enermax iVektor schwarz // AsRock DeskMini // Chenbro PC31031 // TFX Desktop

- Netzteil

- be quiet! Dark Power Pro 11 650W // ex 19V // FSP Hexa 85+ Pro 450W // Seasonic SS-300TFX

- Tastatur

- Qpad 3202-MK85 Cherry MX-Brown

- Maus

- VERTI WM25

- Betriebssystem

- Win10pro x64 // Ubuntu Xfce (Mint) // Win10pro x64 // Ubuntu Xfce (Mint)

- Webbrowser

- Firefox

- Verschiedenes

- Danke thorsam & JagDoc, KVM ATEN CS1764 4-fach Desktop , USV 2xAPC BR900GI, NAS QNAP TS-431P2-8G + TS-462-16G je 4x4TB

- Internetanbindung

-

▼50 MBit

▲10 MBit

Um mal Werte für Amicable Numbers bei zusteuern, jedoch nur im Vergleich zu meiner alten RX580:

GPU Sapphire Pulse Radeon RX 6500 XT 4GB GDDR6 HDMI DP (11314-01-20G) PCIex16/4 1x6pol Power 130W TDP Flop SP-5790 DP-362

Microsoft Windows 10 Professional x64 Edition, (10.00.19044.00)

~1722 sec bei einer WU ~70W

GPU Gigabyte Aorus Radeon RX 580 8G GDDR5 DVI HDMI 3xDP (GV-RX580AORUS-8GD) PCIex16 1x8pol Power 185W TDP Flop SP-6359 DP-397

Linux Ubuntu 20.04.4 LTS [5.4.0-100-generic|libc 2.31 (Ubuntu GLIBC 2.31-0ubuntu9.7)]

~2834 sec bei einer WU ~140W

Damit hat die RX 6500 XT ~164% Leistung der RX580, bei ~50% des Stromverbrauchs...

Nach dem Penta schreibe ich noch was dazu und ggf. komme ich auch mal wieder zu zocken.

GPU Sapphire Pulse Radeon RX 6500 XT 4GB GDDR6 HDMI DP (11314-01-20G) PCIex16/4 1x6pol Power 130W TDP Flop SP-5790 DP-362

Microsoft Windows 10 Professional x64 Edition, (10.00.19044.00)

~1722 sec bei einer WU ~70W

GPU Gigabyte Aorus Radeon RX 580 8G GDDR5 DVI HDMI 3xDP (GV-RX580AORUS-8GD) PCIex16 1x8pol Power 185W TDP Flop SP-6359 DP-397

Linux Ubuntu 20.04.4 LTS [5.4.0-100-generic|libc 2.31 (Ubuntu GLIBC 2.31-0ubuntu9.7)]

~2834 sec bei einer WU ~140W

Damit hat die RX 6500 XT ~164% Leistung der RX580, bei ~50% des Stromverbrauchs...

Nach dem Penta schreibe ich noch was dazu und ggf. komme ich auch mal wieder zu zocken.

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 3.586

- Renomée

- 2.241

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 3x Ryzen 7950X, 9950X, 4800H, 7945HX, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090, Radeon Pro VII

- BOINC-Statistiken

- Mein Desktopsystem

- mehrere

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 9950X, 7945HX

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 11 x64/Pro, Linux Mint 21.x

In dem Vergleich echt gute Werte!

Das Projekt ist wie so viele nvidia-lastig. Meine 1650 Ti Mobile braucht ~950 Sek bei 50W (Win 10).

Das Projekt ist wie so viele nvidia-lastig. Meine 1650 Ti Mobile braucht ~950 Sek bei 50W (Win 10).

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Ein neuer Tag und neues Glück, die PCIe Tests der RX 6500XT sind da.

Getestet wurde mit einem Ryzen 9 3950x dem 64 GB 3200er CL14 Speicher zur Seite standen. Um euch nicht mit Werten sinnlos zu überschwemmen hatte ich mich auf die DirectX12 Versionen beschränkt und die Werte vom CPU Test und der Speicherbelegung nur bei PCIe 4.0 Test dazu geschrieben denn an den Ergebnissen ändert sich eh kaum etwas.

1920 x 1080, SAM aktiv

Rise of the Tomb Raider

DX12, Preset @ Sehr hoch

Texturenqualität @ hoch

PCIe 4.0

Berggipfel: 82.97 FPS (min: 62.93, max: 149.32)

Syrien: 75.24 FPS (min: 59.33, max: 84.67)

Geothermales Tal: 68.22 FPS (min: 55.30, max: 84.71)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 492 MB

Gesammte CPU-Auslastung: max. 17.4%

PCIe 3.0

Berggipfel: 100.36 FPS (min: 62.77, max: 141.78)

Syrien: 70.47 FPS (min: 56.48, max: 76.83)

Geothermales Tal: 62.47 FPS (min: 52.40, max: 78.88)

PCIe 2.0

Berggipfel: 93.60 FPS (min: 56.51, max: 129.35)

Syrien: 64.95 FPS (min: 42.23, max: 74.87)

Geothermales Tal: 55.38 FPS (min: 38.53, max: 73.13)

Texturenqualität @ Sehr hoch

PCIe 4.0

Berggipfel: 100.74 FPS (min: 41.34, max: 165.17)

Syrien: 75.12 FPS (min: 50.38, max: 93.98)

Geothermales Tal: 66.98 FPS (min: 42.45, max: 85.02)

GPU D3D Speicher dediziert: max. 4048 MB

GPU D3D Speicher dynamisch: max. 647 MB

Gesammte CPU-Auslastung: max. 20.8%

PCIe 3.0

Berggipfel: 97.33 FPS (min: 26.99, max: 129.93)

Syrien: 69.61 FPS (min: 42.51, max: 77.96)

Geothermales Tal: 61.53 FPS (min: 37.65, max: 77.28)

PCIe 2.0

Berggipfel: 91.09 FPS (min: 26.27, max: 123.13)

Syrien: 61.16 FPS (min: 9.93, max: 84.04)

Geothermales Tal: 46.63 FPS (min: 17.05, max: 59.81)

Shadow of the Tomb Raider

DX12, Preset @ Ultrahoch

Texturenqualität @ normal

PCIe 4.0

GPU FPS: avg. 69, min. 56, max. 107, 95% 60

CPU Spiel: avg. 170, min. 125, max. 229, 95% 128

CPU Render: avg. 274, min. 183, max. 486, 95% 194

GPU D3D Speicher dediziert: max. 3934 MB

GPU D3D Speicher dynamisch: max. 1026 MB

Gesammte CPU-Auslastung: max. 27.1%

PCIe 3.0

GPU FPS: avg. 61, min. 49, max. 100, 95% 50

PCIe 2.0

GPU FPS: avg. 52, min. 39, max. 95, 95% 41

Texturenqualität @ hoch

PCIe 4.0

GPU FPS: avg. 65, min. 53, max. 104, 95% 54

GPU D3D Speicher dediziert: max. 3607 MB

GPU D3D Speicher dynamisch: max. 2268 MB

Gesammte CPU-Auslastung: max. 20.9%

PCIe 3.0

GPU FPS: avg. 50, min. 34, max. 92, 95% 35

PCIe 2.0

GPU FPS: avg. 38, min. 22, max. 82, 95% 27

Texturenqualität @ Ultra

PCIe 4.0

GPU FPS: avg. 57, min. 42, max. 100, 95% 45

GPU D3D Speicher dediziert: max. 3840 MB

GPU D3D Speicher dynamisch: max. 4176 MB

Gesammte CPU-Auslastung: max. 19.0%

PCIe 3.0

GPU FPS: avg. 43, min. 28, max. 90, 95% 31

PCIe 2.0

GPU FPS: avg. 29, min. 17, max. 76, 95% 18

Wie man sieht halten sich de Unterschiede zwischen PCIe 4.0 und 3.0 durchaus in Grenzen, wolange man es nicht mit den Textureneinstellungen übertreibt.

PCIe 2.0 ist aber definitiv zu wenig denn bei "Shadow of the Tomb Raider" rutscht selbst der Ryzen auf das Niveau des FX. Das Spiel "Rise of the Tomb Raider" kommt zwar durch sein Speichermanagement auf den ersten Blick besser mit dem knappen VRAM klar, neigt dafür aber deutlich stärker zu FPS Einbrüchen die die min. FPS in den Keller ziehen.

In beiden Fällen kann man aber durchaus erkennen das selbst mit PCIe 3.0 Systemen und angepassten Textureneinstellungen das schmale PCIe Interface kaum zum zum Flaschenhals wurde aber je mehr man es mit den Texturen übertreibt desto mehr zieht das Auslagern bz. ständige Nachladen der Texturen die Performance in den Keller.

Jetzt brauche ich aber erstmal eine kurze Pause um das System wieder auf die 6900XT umzubauen damit ich mit dieser nochmal untersuchen kann wie groß der Leistungsunterschied zwischen den Textureneinstellungen überhaupt ausfällt wenn der VRAM groß genug ist.

Da es dabei nicht um die FPS selbst geht sondern lediglich um die Abweichung zwischen den Texturenstufen sollte der gravierende Leistungsunterschied kein allso großes Problem sein.

[automerge]1648403204[/automerge]

Da das Spiel "Shadow of the Tomb Raider" recht gleichmäßig mit dem Speicherüberlauf einbrach habe ich mir gleich mal dieses genommen um den Einfluss der Textureneinstellungen bei ausreichend VRAM auszutesten. Da die RX 6900XT mit FullHD ein gutes Stück unterfordert ist und das Spiel im CPU Limit rumrennt habe ich auch gleich noch mit UHD Einstellung mit getesten um auch das GPU Limit mitzunehmen. Die max. Belegung des VRAM der Grafikkarte habe ich gleich noch dazu geschrieben.

Tja, was soll ich sagen? Wie man sieht haben die Textureneinstellungen praktisch keine Auswirkungen auf die Leistung der Grafikkarte, jedenfalls wenn der VRAM reicht.

Shadow of the Tomb Raider

RX 6900XT, DX12, Preset @ Ultrahoch

1920 x 1080 (GPU Auslastung ca. 75 - 90%)

Texturenqualität @ normal (5426 MB)

GPU FPS: avg. 217, min. 156, max. 290, 95% 156

Texturenqualität @ hoch (7416 MB)

GPU FPS: avg. 217, min. 149, max. 292, 95% 159

Texturenqualität @ Ultra (8495 MB)

GPU FPS: avg. 217, min. 153, max. 292, 95% 159

3840 x 2160 (GPU Auslastung 100%)

Texturenqualität @ normal (6866 MB)

GPU FPS: avg. 93, min. 77, max. 131, 95% 81

Texturenqualität @ hoch (8823 MB)

GPU FPS: avg. 91, min. 76, max. 130, 95% 80

Texturenqualität @ Ultra (9947 MB)

GPU FPS: avg. 91, min. 75, max. 130, 95% 79

Da sich das Spiel "Rise of the Tomb Raider" beim Speichermanagement deutlich anders verhalten hat und beim Speicherüberlauf nur wenig auslagerte wollte ich noch mal die FullHD Einstellungen durchgehen um zu schauen wieviel VRAM das Spiel belegt wenn genug davon da ist.

Die Werte kommen gleich nach.

[automerge]1648405082[/automerge]

So, die Werte für den Speicherbedarf sind da und wenn ichs ehe wieviel sich das Spiel unter den Nagel reißen kann wenn es darf dann wundern einen die erheblichen Nachladeruckler bei der höchsten Textureneinstellung nicht wirklich. Weil ich gerade dabei war habe ich gleich noch die max. Speicherbelegung mit UHD mitgetestet.

FullHD

hoch = 5291 MB

sehr hoch = 9484 MB

UHD

hoch = 6398 MB

sehr hoch = 10564 MB

So, das sollte erstmal alles von mir sein aber wenn jemand noch einen besonderen Wunsch zum Nachtesten hat dann kann ich mal schauen ob ich entsprechend nachtesten kann.

sehr interessant auch mit dem pcie vergleich. vorallem wieso amd graka so viel mehr VRAM speicher nutzen nur weil die auflösung höher wird. bei meiner alten nvidia 1030 ändert sich da an vram belegung durch erhöhung der Auflösung kaum etwas. ein full hd bild hat 4.1 megabyte. zum double buffern braucht man 2 und 1 für den Z Buffer in 32 bit . also etwa 13 megabyte. ein UHD Bild braucht das 4 fache also 52 megabyte für die 3 bilder . somit wäre theoretisch 52 mb -13 mb = 39 MB mehr vram nötig. in deinem Fall wird aber 1100 megabyte mehr gebraucht. selbst wenn man die 39 mb * 4 nimmt für 2 fach antialiasing wäre es immer noch erst 156 megabyte mehr. wozu die AMD karte die restlichen 944 MB mehr braucht ist ein gigantisches Rätsel. obwohl ich gar kein AA nutze braucht meine RX 6500XT auch viel mehr bei höherer auflösung.

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das liegt vermutlich daran das wegen LOD nicht nur der Framebuffer selbst eine Rolle spielt.

Hintergrundobjekte bestehen dadurch aus mehr Pixeln die wiederum höher aufgelöste Texturen vertragen und diese belegen wiederum mehr Platz im VRAM.

Hintergrundobjekte bestehen dadurch aus mehr Pixeln die wiederum höher aufgelöste Texturen vertragen und diese belegen wiederum mehr Platz im VRAM.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

die R9 Nano die meisten Probleme bereitete da der provozierte VRAM Überlauf zumindest bei DX11 jedes mal in einem Blackscreen endete.

Was zeigt windows an GPU speicher an im task manager ?

Ich habe laut Windows und info tools 20 GB GPU speicher. Das GPU speicher sollte so wie das restliche memory system auch funktionieren. windows oder treiber sollte sich darum kümmern, dass oft benötigtes im pysikalischen RAM bleibt. das pysikalische RAM nennen die dedzierter GPU Speicher. Im falle meines Screenshots haben programme 1.2 gigabyte GPU speicher angefordert. davon sind dann 0.9 gigabyte im pysikalischen RAM der GPU. was haben leute an GPU speicher die 8 gb oder 16 gb GFX karten haben und mehr als 32 GB RAM ?

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das sind bei dir 4 GB lokalen Grafikspeicher und 16 GB die in den RAM ausgelagert werden könnten, also zusammen 20 GB theoretischen Grafikspeicher.

Für den gemeinsamen GPU-Speicher wird idR. von Windows pauschal die Hälfte des verbauten RAM veranschlagt. Bei meiner Testplattform mit dem FX und der eingebauten R9 Nano (4 GB) sind das bei verbauten 16 GB RAM 8 GB gemeinsamer GPU Speicher, zusammen also 12 GB (virtueller) GPU-Speicher und bei meinem Spiele System mit den 64 GB RAM wurden 32 GB veranschlagt, was bei der verbauten Rx 6900XT (16 GB) 48 GB (virtuellen) GPU-Speicher entspricht.

Da dieser aber nicht für diesen Zweck fest zugeordnet wird ist er nur entsprechend des Füllstandes des RAMs nutzbar.

[automerge]1681286935[/automerge]

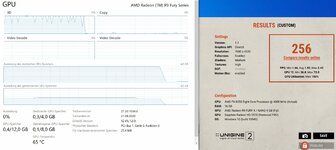

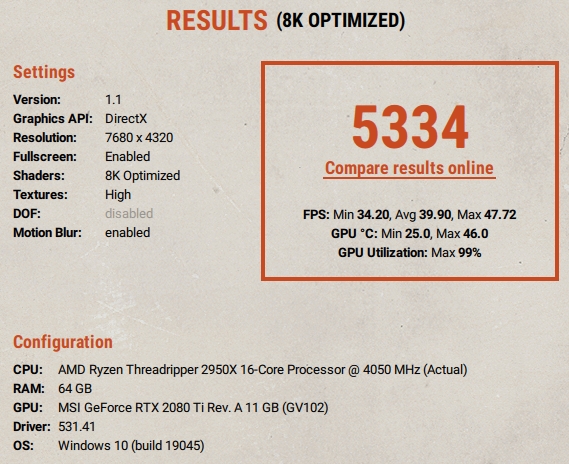

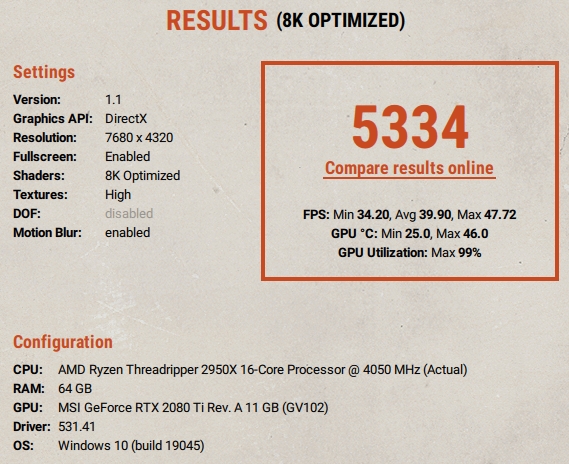

Wo ich gerade nochmal den Superposition Test auf der R9 Nano angeworfen habe, der Speicherüberlauf scheint inzwischen kein Problem mehr zu sein. Der Treiber den Windows anbot ist von 2020 und der 4K Optimized Test läuft gerade einwandfrei durch. Beim ursprünglichen Test gab es ja mit der Karte Blackscreen Abschtürze.

Ich wiederhole gleich mal diesen Test....

[automerge]1681288505[/automerge]

R9 Nano

1080p Medium 8867

min. 50.89, Avg. 66.32, Max 82.88

1080p High 6472

min. 39.16, Avg. 48.41, Max 57.43

1080p Extreme 2846

min. 16.94, Avg. 21.29, Max 24.80

4K Optimized 3876

min. 16.67, Avg. 28.99, Max 35.04

8K Optimized 397

min. 2.62, Avg. 2.97, Max 4.00

Für den gemeinsamen GPU-Speicher wird idR. von Windows pauschal die Hälfte des verbauten RAM veranschlagt. Bei meiner Testplattform mit dem FX und der eingebauten R9 Nano (4 GB) sind das bei verbauten 16 GB RAM 8 GB gemeinsamer GPU Speicher, zusammen also 12 GB (virtueller) GPU-Speicher und bei meinem Spiele System mit den 64 GB RAM wurden 32 GB veranschlagt, was bei der verbauten Rx 6900XT (16 GB) 48 GB (virtuellen) GPU-Speicher entspricht.

Da dieser aber nicht für diesen Zweck fest zugeordnet wird ist er nur entsprechend des Füllstandes des RAMs nutzbar.

[automerge]1681286935[/automerge]

Wo ich gerade nochmal den Superposition Test auf der R9 Nano angeworfen habe, der Speicherüberlauf scheint inzwischen kein Problem mehr zu sein. Der Treiber den Windows anbot ist von 2020 und der 4K Optimized Test läuft gerade einwandfrei durch. Beim ursprünglichen Test gab es ja mit der Karte Blackscreen Abschtürze.

Ich wiederhole gleich mal diesen Test....

[automerge]1681288505[/automerge]

R9 Nano

1080p Medium 8867

min. 50.89, Avg. 66.32, Max 82.88

1080p High 6472

min. 39.16, Avg. 48.41, Max 57.43

1080p Extreme 2846

min. 16.94, Avg. 21.29, Max 24.80

4K Optimized 3876

min. 16.67, Avg. 28.99, Max 35.04

8K Optimized 397

min. 2.62, Avg. 2.97, Max 4.00

Zuletzt bearbeitet:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Das sind bei dir 4 GB lokalen Grafikspeicher und 16 GB die in den RAM ausgelagert werden könnten, also zusammen 20 GB theoretischen Grafikspeicher.

Für den gemeinsamen GPU-Speicher wird idR. von Windows pauschal die Hälfte des verbauten RAM veranschlagt. Bei meiner Testplattform mit dem FX und der eingebauten R9 Nano (4 GB) sind das bei verbauten 16 GB RAM 8 GB gemeinsamer GPU Speicher, zusammen also 12 GB (virtueller) GPU-Speicher und bei meinem Spiele System mit den 64 GB RAM wurden 32 GB veranschlagt, was bei der verbauten Rx 6900XT (16 GB) 48 GB (virtuellen) GPU-Speicher entspricht.

Da dieser aber nicht für diesen Zweck fest zugeordnet wird ist er nur entsprechend des Füllstandes des RAMs nutzbar.

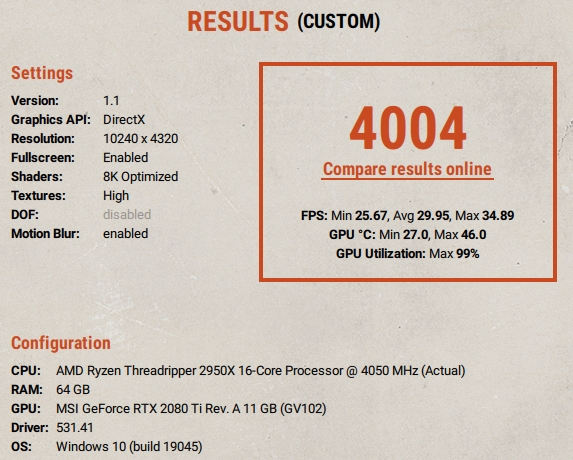

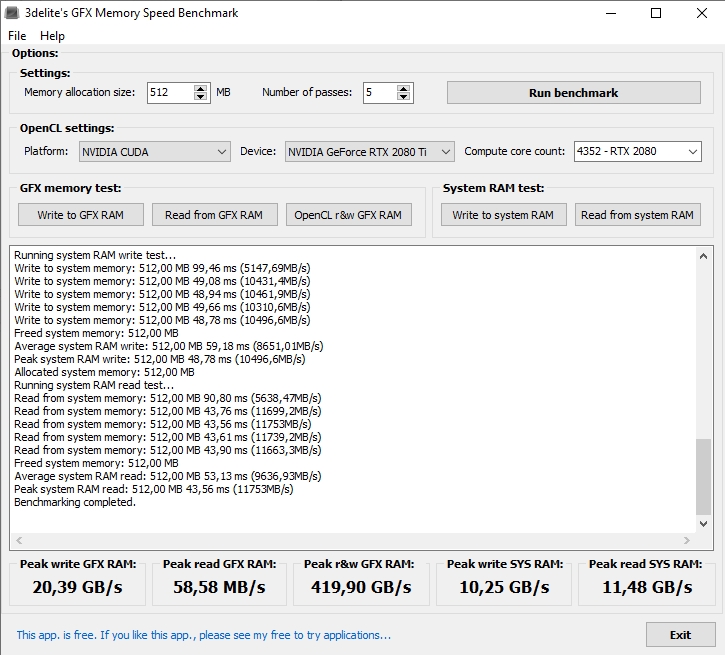

Anhang anzeigen 52877Anhang anzeigen 52875

[automerge]1681286935[/automerge]

Wo ich gerade nochmal den Superposition Test auf der R9 Nano angeworfen habe, der Speicherüberlauf scheint inzwischen kein Problem mehr zu sein. Der Treiber den Windows anbot ist von 2020 und der 4K Optimized Test läuft gerade einwandfrei durch. Beim ursprünglichen Test gab es ja mit der Karte Blackscreen Abschtürze.

Ich wiederhole gleich mal diesen Test....

[automerge]1681288505[/automerge]

R9 Nano

1080p Medium 8867

min. 50.89, Avg. 66.32, Max 82.88

1080p High 6472

min. 39.16, Avg. 48.41, Max 57.43

1080p Extreme 2846

min. 16.94, Avg. 21.29, Max 24.80

4K Optimized 3876

min. 16.67, Avg. 28.99, Max 35.04

8K Optimized 397

min. 2.62, Avg. 2.97, Max 4.00

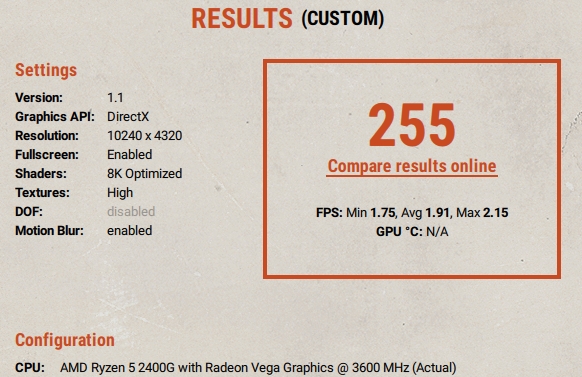

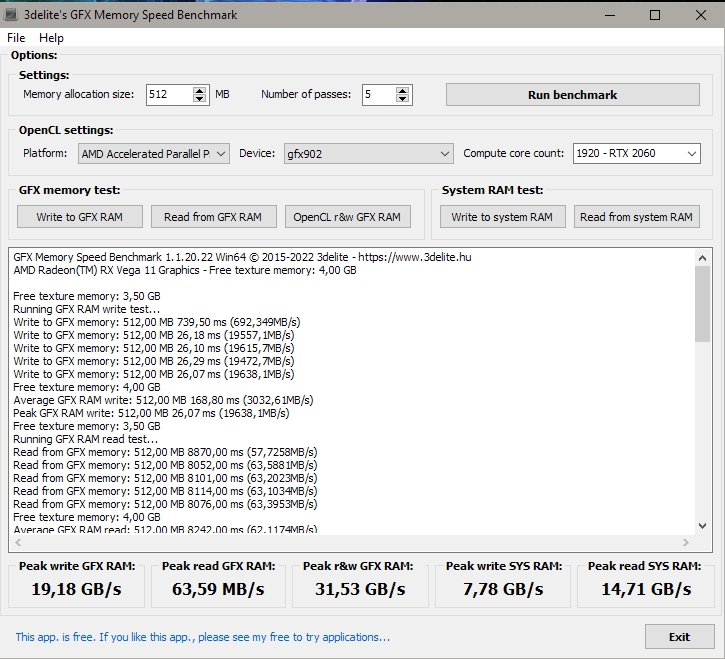

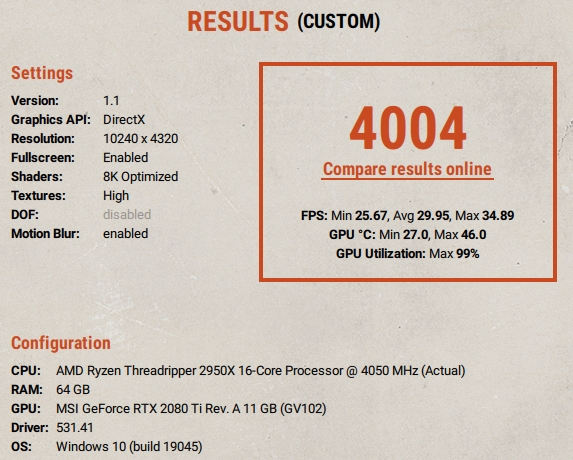

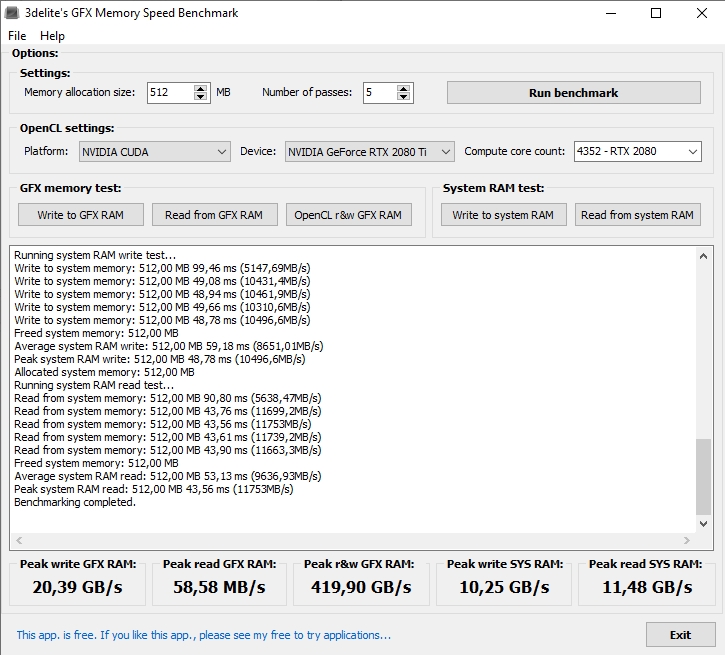

kannst du bitte einmal die pixelshader bei dem 8k test auf low oder mid stellen und den text in 8k machen ? . bei mir gibt es dann 3-4 fach mehr performance. werte ändern kannst in dem benchmark auch in kostenloser version wenn du custom anwählst. wäre auch gut wenn du einmal den GFX memory benchmark machst was da rauskommt bei schnellen karten .

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Bei der R9 Nano:

8K Optimized + Shader @ low, Texturen @ High - 1937

min. 11.56, Avg. 14.49, Max 18.01

8K Optimized + Shader @ medium, Texturen @ High - 281

min. 1.84, Avg. 2.11, Max 2.95

8K Optimized @ FHD + Shader @ low, Texturen @ High - 13159

min. 58.29, Avg. 98.42, Max 135.74

8K Optimized @ FHD + Shader @ medium, Texturen @ High - 9917

min. 54.07, Avg. 74.18, Max 95.57

Die höhere Shader Einstellung frißt also ca. 25% Leistung und der Rest säuft aufgrund des Speicherüberlaufs ab.

[automerge]1681294239[/automerge]

Um nochmal den tatsächlichen VRAM Bedarf beim größten Einbruch zu verdeutlichen:

8K Optimized + Shader @ low, Texturen @ High - 1937

min. 11.56, Avg. 14.49, Max 18.01

8K Optimized + Shader @ medium, Texturen @ High - 281

min. 1.84, Avg. 2.11, Max 2.95

8K Optimized @ FHD + Shader @ low, Texturen @ High - 13159

min. 58.29, Avg. 98.42, Max 135.74

8K Optimized @ FHD + Shader @ medium, Texturen @ High - 9917

min. 54.07, Avg. 74.18, Max 95.57

Die höhere Shader Einstellung frißt also ca. 25% Leistung und der Rest säuft aufgrund des Speicherüberlaufs ab.

[automerge]1681294239[/automerge]

Um nochmal den tatsächlichen VRAM Bedarf beim größten Einbruch zu verdeutlichen:

Zuletzt bearbeitet:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

8K Optimized + Shader @ low, Texturen @ High - 1937

min. 11.56, Avg. 14.49, Max 18.01

8K Optimized + Shader @ medium, Texturen @ High - 281

min. 1.84, Avg. 2.11, Max 2.95

alleine durch die shader von medium auf low gestellt wird es über 600% also über 6 fach schneller. (1937 / 281) die dedizierte GPU auslastung ist vermutlich auch bei vollen 4 gb bei shader low oder ?. denn shader brauchen sehr wenug VRAM . die graka ist eine Highend graka von 2015 mit 4 GB richtig ?. https://www.notebookcheck.com/AMD-Radeon-R9-Fury-Benchmarks.154390.0.html

im timespy benchmark kommt die r9 auf 4720 punkte wie da steht. RX6500XT schaffft auch so viel.

danke für den test da passiert genau dasselbe wie bei der RX 6500 XT. die shader machen die karte extrem lahm sobald mehr vram gefordert wird. dürfte nicht sein shader müssten priorität vor texturen haben. habe ich schon bei AMD reportet mit neuem Beispielvideo in fullhd https://community.amd.com/t5/driver...wn-after-18-sec-bad-memory/m-p/599851#M173267

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Auch mit low war die Karte so oder so im Speicherüberlauf.

Der Superposition Benchmark prognostizierte für den 8K Preset mit "Medium" 7160 MB VRAM Bedarf, welche lt. Taskmanager auch ganz gut hin kommen und mit "Low" sollen es immerhin noch 6012 MB sein. Vermutlich reicht dieses eine GB bereits das so viele bandbreitenkritische Daten ausgelagert werden das es die Performance in den Keller zieht. Kurzum, die Karte hat für die Einstellung eindeutig zu wenig VRAM.

Der Superposition Benchmark prognostizierte für den 8K Preset mit "Medium" 7160 MB VRAM Bedarf, welche lt. Taskmanager auch ganz gut hin kommen und mit "Low" sollen es immerhin noch 6012 MB sein. Vermutlich reicht dieses eine GB bereits das so viele bandbreitenkritische Daten ausgelagert werden das es die Performance in den Keller zieht. Kurzum, die Karte hat für die Einstellung eindeutig zu wenig VRAM.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.262

- Renomée

- 548

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PrimeGrid@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 5950X @ ASRock Taichi X570 & Sapphire RX 7900 XTX Nitro+

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.50

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 8l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3200 CL22 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x Sapphire Radeon RX 7900XTX OC 24GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Hi, danke für die Mühe für die vielen Werte.Auch mit low war die Karte so oder so im Speicherüberlauf.

Der Superposition Benchmark prognostizierte für den 8K Preset mit "Medium" 7160 MB VRAM Bedarf, welche lt. Taskmanager auch ganz gut hin kommen und mit "Low" sollen es immerhin noch 6012 MB sein. Vermutlich reicht dieses eine GB bereits das so viele bandbreitenkritische Daten ausgelagert werden das es die Performance in den Keller zieht. Kurzum, die Karte hat für die Einstellung eindeutig zu wenig VRAM.

Wenn ich bei mir Shader & Texturen auf Low einstelle (Custom Settings) dann läuft auch 10K mit über 25FPS.

Bei MilkyWay kommt die RX 6950 XT auf ~ 32 Sekunden (gedrosselt Power Limit -10% = 311W).

MfG

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Auch mit low war die Karte so oder so im Speicherüberlauf.

Der Superposition Benchmark prognostizierte für den 8K Preset mit "Medium" 7160 MB VRAM Bedarf, welche lt. Taskmanager auch ganz gut hin kommen und mit "Low" sollen es immerhin noch 6012 MB sein. Vermutlich reicht dieses eine GB bereits das so viele bandbreitenkritische Daten ausgelagert werden das es die Performance in den Keller zieht. Kurzum, die Karte hat für die Einstellung eindeutig zu wenig VRAM.

bei mir geht das graka schreiben mit 22 GB . aus sys ram lesen mit 14 GB. beim kopieren würde dann mein System 14 GB ins Vram kopieren können pro sekunde weil der schreib und lesespeicher getrennt ist in dem falle. wenn 1 GB pro frame immer mehr übertragen muss, dann müsste es zumindest mal noch mehr als 10 frames schaffen. bei dir und mir bricht es viel mehr ein. genauer kann man es nur sehen wenn du mal den gfx mem benchmark machst. hab DDR 4 3200 . mir nutzt also mehr als pce3x4 eh nichts, weil sowieso schon schneller ins graka ram geschrieben wird als aus meinen system ram gelesen werden kann. andere benches die speichergeschwindigkeit beim lesen und schreiben auf GFX mem messen kenn ich keine. liegt vermutlich daran dass dann alle sehen würden, dass mehr als pciee3x4 eh nichts bringt weil ddr 4 das nichtmal schafft.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.262

- Renomée

- 548

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PrimeGrid@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 5950X @ ASRock Taichi X570 & Sapphire RX 7900 XTX Nitro+

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.50

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 8l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3200 CL22 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x Sapphire Radeon RX 7900XTX OC 24GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

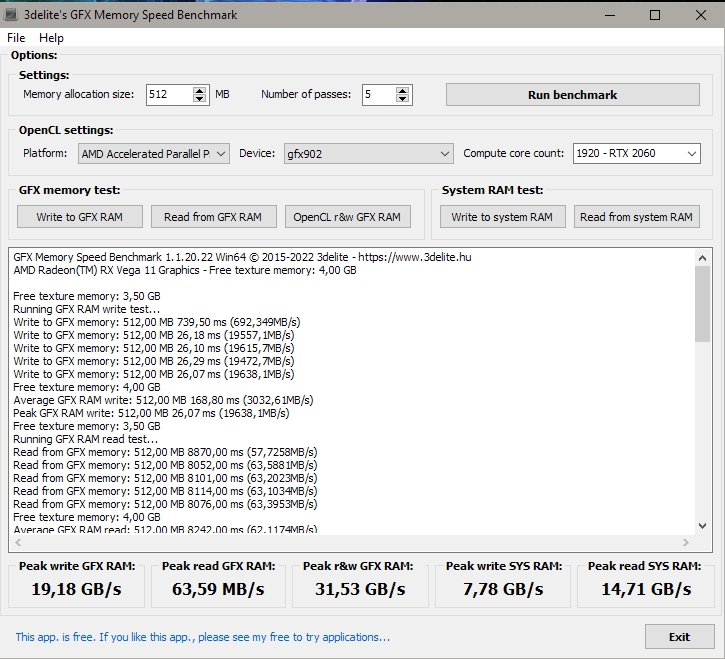

Es gibt eine neue Version von GFX Memory Speed Benchmark: https://www.3delite.hu/Object Pascal Developer Resources/download.html#gfxbenchmark

Maximal 127W Chip Power Draw laut GPUz.

Maximal 127W Chip Power Draw laut GPUz.

sompe

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.733

- Renomée

- 2.492

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

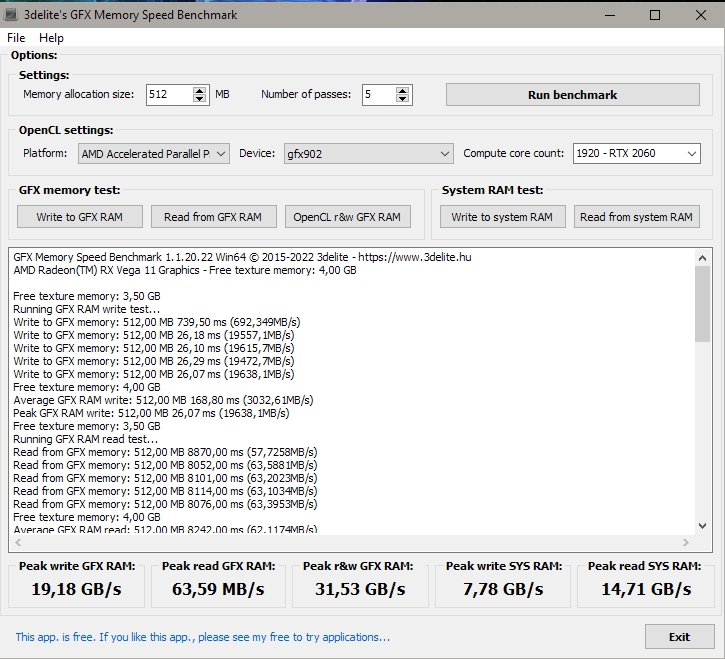

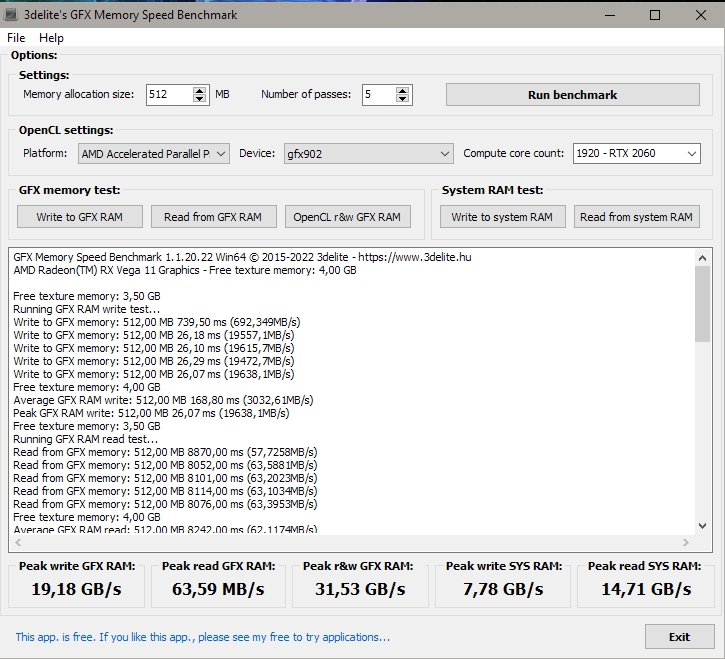

Ehrlich gesagt würde ich nicht allso viel auf die Aussagekraft der Messwerte geben.

Ich hatte mit einer etwas neueren Version die R9 Nano getestet und die Messergebnisse widersprechen sich teils erheblich mit denen vom AIDA GPGPU Test. Leider sieht man bei dem wegen der Trial Hinweise nicht alle Werte.

Bei dem in der Version deines Testprogramms offenbar hinzu gekommenen OpenCL Test wird es dann erst recht kurios denn das Ergebnis ist in den 5 Durchläufen einfach instabil und ändert sich bereits mit der Angabe zum Compute Core Count deutlich, wobei in der Modellauswahl nur Geforce Karten stehen.

Eventuell ist der Test auch nur für Karten dieses Herstellers brauchbar.

Ich hatte mit einer etwas neueren Version die R9 Nano getestet und die Messergebnisse widersprechen sich teils erheblich mit denen vom AIDA GPGPU Test. Leider sieht man bei dem wegen der Trial Hinweise nicht alle Werte.

Bei dem in der Version deines Testprogramms offenbar hinzu gekommenen OpenCL Test wird es dann erst recht kurios denn das Ergebnis ist in den 5 Durchläufen einfach instabil und ändert sich bereits mit der Angabe zum Compute Core Count deutlich, wobei in der Modellauswahl nur Geforce Karten stehen.

Eventuell ist der Test auch nur für Karten dieses Herstellers brauchbar.

Zuletzt bearbeitet:

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.262

- Renomée

- 548

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PrimeGrid@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 5950X @ ASRock Taichi X570 & Sapphire RX 7900 XTX Nitro+

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.50

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 8l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3200 CL22 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x Sapphire Radeon RX 7900XTX OC 24GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Mir fällt gerade auf, die Peak r&w GFX RAM sind bei dem ersten Lauf etwas Buffer Overflowed.

So sieht es mit normal aus:

Und so mit 16384 Compute Cores, wobei meine 6950 nur 5120 hat:

Ich nehme mal an, dass ist eine CUDA Translation via AMD APP.

So sieht es mit normal aus:

Und so mit 16384 Compute Cores, wobei meine 6950 nur 5120 hat:

Ich nehme mal an, dass ist eine CUDA Translation via AMD APP.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

aber heutzutage muss man ja aufpassen wo man programe sich lädt. ungarn gilt als trojanisches pferd russlands. die rx 6950 schreibt auch nur 22,9 GB /sec peak write gfx mem. nun glaube ich der bench zeigt müll . Ich habe mir mal die pcie specs durchgelesen . bei pcie3x4 werden ja nur 4 gigabyte/sec übertragen theoretisch. https://www.elektronik-kompendium.de/sites/com/0904051.htm der bench nutzt blöcke von 512 MB. passt also garnicht in den cache der CPU. wie kann man so einen falschen bench programmieren.

gibts noch andere benchmarks die GPU ram transfer speed messen ?

gibts noch andere benchmarks die GPU ram transfer speed messen ?

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.262

- Renomée

- 548

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PrimeGrid@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 5950X @ ASRock Taichi X570 & Sapphire RX 7900 XTX Nitro+

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.50

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 8l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3200 CL22 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x Sapphire Radeon RX 7900XTX OC 24GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Ich hatte jetzt kein Problem mit dem GFX Benchmark, es ist immerhin ein Installer für Windows.aber heutzutage muss man ja aufpassen wo man programe sich lädt. ungarn gilt als trojanisches pferd russlands. die rx 6950 schreibt auch nur 22,9 GB /sec peak write gfx mem. nun glaube ich der bench zeigt müll . Ich habe mir mal die pcie specs durchgelesen . bei pcie3x4 werden ja nur 4 gigabyte/sec übertragen theoretisch. https://www.elektronik-kompendium.de/sites/com/0904051.htm der bench nutzt blöcke von 512 MB. passt also garnicht in den cache der CPU. wie kann man so einen falschen bench programmieren.

gibts noch andere benchmarks die GPU ram transfer speed messen ?

Also es muss Irgendwie & wo getestet worden sein.