App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

RX 6500XT vs. R9 Nano

- Ersteller sompe

- Erstellt am

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

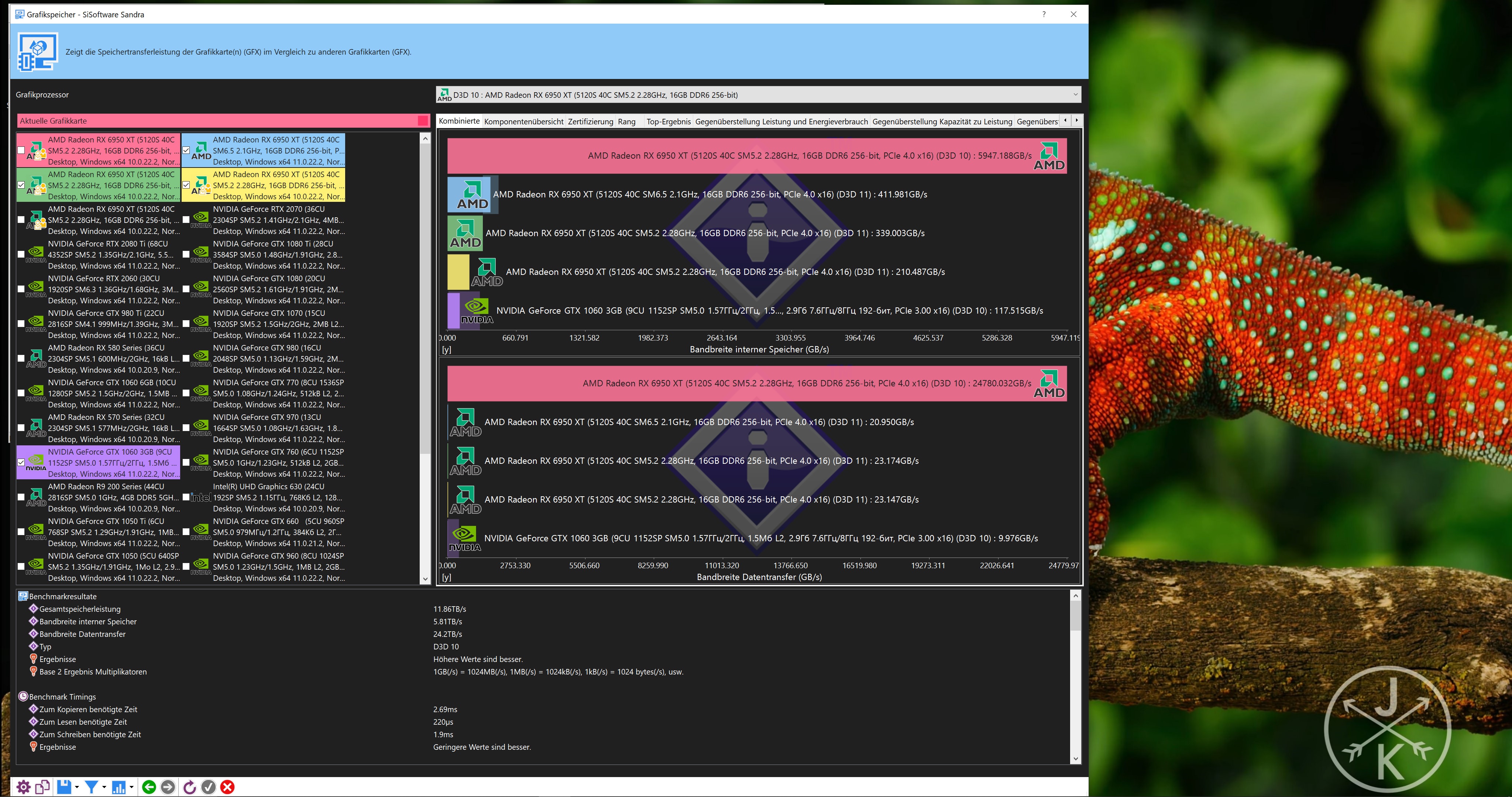

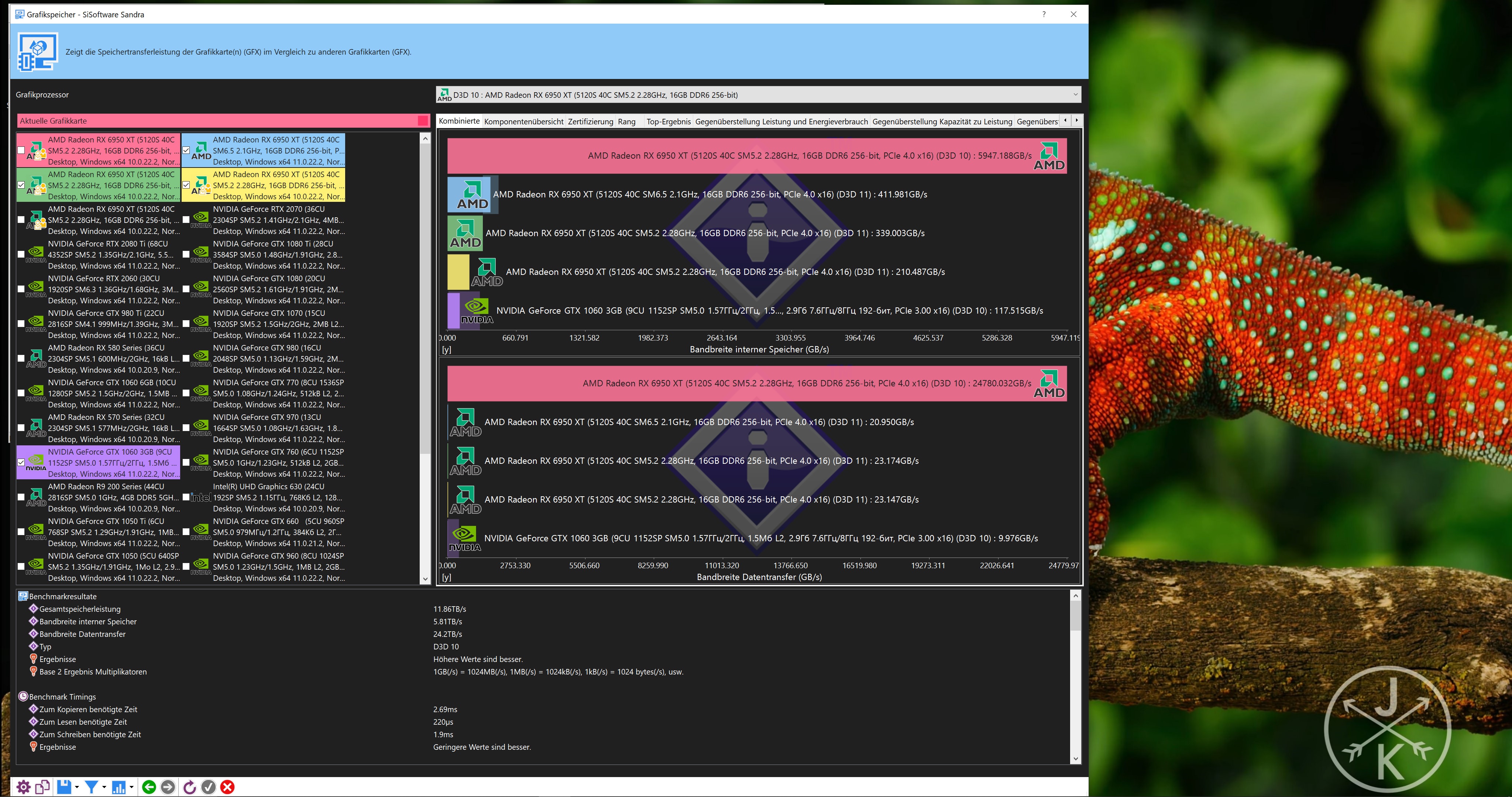

Eigentlich sind es bei PCI-Express 4.0: 16 GT/s ~ 31,5 GByte/s mit 16 Lanes: https://www.elektronik-kompendium.de/sites/com/0904051.htmIn deinem Fall ist das mehr als PCIe 4 x8 oder PCIe 3 x 16. bei meiner gforce 1030 und radeon 6500 XT ist es aber auch so 22 GB . siehe mein screenshot oben. aber pcie3 x16 soll nur 16 gb machen. in dem bench kommen meine karten aber auf 22 GB. aber eh egal mein DDR 4 schafft auch nur 16 GB

pro Lane

(Balast in %)8b10b / 20% 8b10b / 20% 128b/130b / <2% 128b/130b / <2% 128b/130b / <2% PAM-4 PAM-4

Aber das nur als Info, sofern der Mainboard Steckplatz PCI-Express 4.0 x16 kann sollten es um die 20 GByte/s sein.

Edit:

Gerade nochmal den 3DMark PCI-Express Test gemacht: https://www.3dmark.com/pcie/373928

27 GByte/s

Ich meinte bei dir kann es möglich sein, nur bei mir nicht, ich habe nur PCIe3 und da gibt es nicht mehr als 15.5 gb bei x16 wie du zitiert hast. test zeigt aber bei mir 22 gb an https://forum.planet3dnow.de/index.php?threads/rx-6500xt-vs-r9-nano.457714/#post-5436036 hab auch far cry 6 im hintegrund laufen gehabt damit buss nicht runtertaktet

hwinfo und gpu-z zeigen bei meiner 6500xt pcie3x4. dass wären dann theoretisch nicht mehr als 5 Gb. macht die gforce 1030 aber auch und ist aber viel schneller.

Doppelposting wurde automatisch zusammengeführt:

tja die grosse frage ist wo gibt es einen funktionierenden Mem benchmark oder stimmen die werte von hwinfo und gpu-z nicht bei der 6500XT . die geben die werte für die karte evtl per Hand ein. aida hatt ich früher mal mit der gfroce 1030 getestet, war auch so ähnlich im wert wie memory benchmark

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich würde eher sagen das der Zugriff von außen auf den VRAM in der Form nicht vorgesehen ist und man deshalb über diesen Weg keine sinnvollen Werte für die Übertragungsraten vom VRAM bekommen kann. Das wird man wohl eher anhand der internen Kopiervorgängen abschätzen können.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Ok, jetzt habe ich dich verstanden.Eigentlich sind es bei PCI-Express 4.0: 16 GT/s ~ 31,5 GByte/s mit 16 Lanes: https://www.elektronik-kompendium.de/sites/com/0904051.htmIn deinem Fall ist das mehr als PCIe 4 x8 oder PCIe 3 x 16. bei meiner gforce 1030 und radeon 6500 XT ist es aber auch so 22 GB . siehe mein screenshot oben. aber pcie3 x16 soll nur 16 gb machen. in dem bench kommen meine karten aber auf 22 GB. aber eh egal mein DDR 4 schafft auch nur 16 GB

pro Lane

(Balast in %)8b10b / 20% 8b10b / 20% 128b/130b / <2% 128b/130b / <2% 128b/130b / <2% PAM-4 PAM-4

Aber das nur als Info, sofern der Mainboard Steckplatz PCI-Express 4.0 x16 kann sollten es um die 20 GByte/s sein.

Edit:

Gerade nochmal den 3DMark PCI-Express Test gemacht: https://www.3dmark.com/pcie/373928

27 GByte/s

Ich meinte bei dir kann es möglich sein, nur bei mir nicht, ich habe nur PCIe3 und da gibt es nicht mehr als 15.5 gb bei x16 wie du zitiert hast. test zeigt aber bei mir 22 gb an https://forum.planet3dnow.de/index.php?threads/rx-6500xt-vs-r9-nano.457714/#post-5436036 hab auch far cry 6 im hintegrund laufen gehabt damit buss nicht runtertaktet

hwinfo und gpu-z zeigen bei meiner 6500xt pcie3x4. dass wären dann theoretisch nicht mehr als 5 Gb. macht die gforce 1030 aber auch und ist aber viel schneller.

Doppelposting wurde automatisch zusammengeführt:

tja die grosse frage ist wo gibt es einen funktionierenden Mem benchmark oder stimmen die werte von hwinfo und gpu-z nicht bei der 6500XT . die geben die werte für die karte evtl per Hand ein. aida hatt ich früher mal mit der gfroce 1030 getestet, war auch so ähnlich im wert wie memory benchmark

Auch wenn deine GPU nur 15GByte/s kann, es werden ja keine Roh Daten übertragen sondern Komprimierte Datenströme.

Das würde auch erklären warum die Lese Geschwindigkeit so gering ist, weil die CPU die Daten Entpacken muss die Eigentlich die GPU entpacken muss.

Der nächste Schritt ist DirectStorage, da kann dann die GPU direkt Daten von der SSD in den VRAM laden ohne Umweg der CPU oder den RAM.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Ich würde eher sagen das der Zugriff von außen auf den VRAM in der Form nicht vorgesehen ist und man deshalb über diesen Weg keine sinnvollen Werte für die Übertragungsraten vom VRAM bekommen kann. Das wird man wohl eher anhand der internen Kopiervorgängen abschätzen können.

muss er ja wie sonst sollen die daten ins vram kommen. treiber müssen auch die windows befehle benutzten damit die programme nicht gleichzeitig auf den speicher zugreifen können. wenn er das so programmiert, muss es auch gehen https://learn.microsoft.com/en-us/windows/win32/direct3d9/accessing-surface-memory-directly dass ist die unterste low level stufe in direct x. das da 9 drinsteht soll zeigen, dass dieser befehl ab direct x 9 geht. direct x 9 kam 2002.also er muss sich den lock holen und dann kann er mit der cpu voll auf den speicher zugreifen und de zeit messen. sinnvollerweise wäre aber ein bench richtig der aus dem system ram liest und mit memcpy auf das vram schreibt. aber auch bei den surfaces kann windows die selber aus dem vram nehmen und es wird dann nur im system ram rumgeschoben.

windows muss dann solange warten bis man den lock wieder freigibt. die locks gibt es auch für texturen. windows benennung ist halt etwas eigenartig. die nennen es surfaces aber üblich ist das ne bitmap die auch direkt angezeigt werden kann. ich habe damit schon programmiert, wenn innerhalb eines locks windows abstürzt hilft nur der reset knopf. da gibt es weder bluescreen und den task manager kann man auch nicht mehr aufrufen

direct x12 haben sie zwar massiv umgebaut, aber dennoch ist das grundprinzip dasselbe. die 20 GB virtuelles VRAM bleibt.

von furmark gibt es auch einen benchmark, aber der nutzt nicht viele polygone. zumindest sieht man in dem test, dass man durch abstellen von AA viel performance gewinnt. auf custom clicken um zu starten

Eigentlich sind es bei PCI-Express 4.0: 16 GT/s ~ 31,5 GByte/s mit 16 Lanes: https://www.elektronik-kompendium.de/sites/com/0904051.htmIn deinem Fall ist das mehr als PCIe 4 x8 oder PCIe 3 x 16. bei meiner gforce 1030 und radeon 6500 XT ist es aber auch so 22 GB . siehe mein screenshot oben. aber pcie3 x16 soll nur 16 gb machen. in dem bench kommen meine karten aber auf 22 GB. aber eh egal mein DDR 4 schafft auch nur 16 GB

pro Lane

(Balast in %)8b10b / 20% 8b10b / 20% 128b/130b / <2% 128b/130b / <2% 128b/130b / <2% PAM-4 PAM-4

Aber das nur als Info, sofern der Mainboard Steckplatz PCI-Express 4.0 x16 kann sollten es um die 20 GByte/s sein.

Edit:

Gerade nochmal den 3DMark PCI-Express Test gemacht: https://www.3dmark.com/pcie/373928

27 GByte/s

Ich meinte bei dir kann es möglich sein, nur bei mir nicht, ich habe nur PCIe3 und da gibt es nicht mehr als 15.5 gb bei x16 wie du zitiert hast. test zeigt aber bei mir 22 gb an https://forum.planet3dnow.de/index.php?threads/rx-6500xt-vs-r9-nano.457714/#post-5436036 hab auch far cry 6 im hintegrund laufen gehabt damit buss nicht runtertaktet

hwinfo und gpu-z zeigen bei meiner 6500xt pcie3x4. dass wären dann theoretisch nicht mehr als 5 Gb. macht die gforce 1030 aber auch und ist aber viel schneller.

Doppelposting wurde automatisch zusammengeführt:

tja die grosse frage ist wo gibt es einen funktionierenden Mem benchmark oder stimmen die werte von hwinfo und gpu-z nicht bei der 6500XT . die geben die werte für die karte evtl per Hand ein. aida hatt ich früher mal mit der gfroce 1030 getestet, war auch so ähnlich im wert wie memory benchmark

Ok, jetzt habe ich dich verstanden.

Auch wenn deine GPU nur 15GByte/s kann, es werden ja keine Roh Daten übertragen sondern Komprimierte Datenströme.

Das würde auch erklären warum die Lese Geschwindigkeit so gering ist, weil die CPU die Daten Entpacken muss die Eigentlich die GPU entpacken muss.

Der nächste Schritt ist DirectStorage, da kann dann die GPU direkt Daten von der SSD in den VRAM laden ohne Umweg der CPU oder den RAM.

das habe ich nicht geschrieben gepackt wird da eigentlich nichts. wenn es gepackt wäre müsste lesen schneller als schreiben gehen. dass lesen langsam ist liegt daran weil die karte halt nicht so gemacht sind dass viel gelesen wird und dafür mehr bandbreite zum schreiben da ist.

fehlen halt mehr benchmarks die das vram testen. habve aber gesehen die alten benchmarks wie 3d mark 11 kann man nun kostenlos von der 3d mark seite laden. mal sehen was sich da einstellen lässt und testen

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Das wird allgemein so gemacht inzwischen, es gibt keine Roh Daten Übertragungen mehr.Ok, jetzt habe ich dich verstanden.

Auch wenn deine GPU nur 15GByte/s kann, es werden ja keine Roh Daten übertragen sondern Komprimierte Datenströme.

Das würde auch erklären warum die Lese Geschwindigkeit so gering ist, weil die CPU die Daten Entpacken muss die Eigentlich die GPU entpacken muss.

Der nächste Schritt ist DirectStorage, da kann dann die GPU direkt Daten von der SSD in den VRAM laden ohne Umweg der CPU oder den RAM.

das habe ich nicht geschrieben gepackt wird da eigentlich nichts. wenn es gepackt wäre müsste lesen schneller als schreiben gehen. dass lesen langsam ist liegt daran weil die karte halt nicht so gemacht sind dass viel gelesen wird und dafür mehr bandbreite zum schreiben da ist.

fehlen halt mehr benchmarks die das vram testen. habve aber gesehen die alten benchmarks wie 3d mark 11 kann man nun kostenlos von der 3d mark seite laden. mal sehen was sich da einstellen lässt und testen

Der Grafik Treiber komprimiert die Daten die an die GPU gehen, bzw. der Spiele Entwickler.

Daher lässt sich über die Bandbreite nicht viel sagen, da es auf den Entwickler ankommt ob er Moderne Feature nutzt oder eben nicht.

GPUz gibt die Roh Daten Leistung an, die sind vom Takt abhängig also berechnet.

Edit: Hier mal noch AIDA64 [Trail] GPGPU Benchmark: https://abload.de/img/aida64_extreme_gpgpu2sdl9.jpg

Zuletzt bearbeitet:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Das wird allgemein so gemacht inzwischen, es gibt keine Roh Daten Übertragungen mehr.was sich da einstellen lässt und testen

Der Grafik Treiber komprimiert die Daten die an die GPU gehen, bzw. der Spiele Entwickler.

Daher lässt sich über die Bandbreite nicht viel sagen, da es auf den Entwickler ankommt ob er Moderne Feature nutzt oder eben nicht.

GPUz gibt die Roh Daten Leistung an, die sind vom Takt abhängig also berechnet.

solange ich keine beweise in source codes sehe glaub ich das nicht. lassen wirs

Ich habe hier mal eine benchmark für pixdelshader gefunden . der zeigt für die 6500 XT an 20 GB Vram und benutzt 16 gb vram. ist aber kein DX12 sondern opengl. läuft in full HD mit 37 fps und in 4k mit11 fps . vielleicht kennt den jemand ?

RhodiumLC: Pixel Shader GPU Benchmark (OpenGL) | Geeks3D

RhodiumLC: Pixel Shader GPU Benchmark (OpenGL)

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Kennen tu ich das nicht, aber sieht echt cool aus.

1081p 147FPS

2160p 37FPS

Aber im Fenster Mode, Fullscreen sollte nochmal etwas mehr sein.

1081p 147FPS

2160p 37FPS

Aber im Fenster Mode, Fullscreen sollte nochmal etwas mehr sein.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Warum diskutierst du dann nicht mit entsprechenden Programmierern und Entwicklern sondern in einem User Forum?solange ich keine beweise in source codes sehe glaub ich das nicht. lassen wirs

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Warum diskutierst du dann nicht mit entsprechenden Programmierern und Entwicklern sondern in einem User Forum?solange ich keine beweise in source codes sehe glaub ich das nicht. lassen wirs

wieso user forum. in jedem forum können welche sein die programmieren oder eine game engine nutzen. unreal 5 engine ist kostenlos für freie projekte. früher gab es mal s3tc Texturkompression. es wurde nie weiterentwickelt, dabei wäre es gerade für hochauflösende texturen nützlich. Lohnt sich für die Hardware industrie halt mehr, wenn man um ein 16 megabyte bild zu berechnen 9000 megabyte im pysikalischen VRAM haben muss wegen schlechtem speichermanagement vermutlich nur bei DX 12. https://de.wikipedia.org/wiki/S3_Texture_Compression

kennt wer eigentliche spiele demos die DX 11 DX 12 version umschaltbar haben die viel VRAM brauchen ?. dann könnt ich mal testen was dx11 auf der amd version macht wenn der physikalische speicher voll ist. ob das besser erkennt was nicht gebraucht wird derzeit.

Doppelposting wurde automatisch zusammengeführt:

s3tc texturen gab es so wie das aussieht maximal bis für das alte unreal https://www.oldunreal.com/phpBB3/viewtopic.php?t=400

Zuletzt bearbeitet:

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

der benchmark sieht in der tat sehr hübsch aus

1080p .... avg fps 116 / max fps 120

2160p .... avg fps 29 / max fps 31

umschaltbar ... äh ... the witcher 3 kann man in dx11 oder dx12 spielen.

1080p .... avg fps 116 / max fps 120

2160p .... avg fps 29 / max fps 31

umschaltbar ... äh ... the witcher 3 kann man in dx11 oder dx12 spielen.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Immer noch im Fenster Modus, aber nur noch 20°C im Raum, als vorher 23°C: https://abload.de/img/shadertoy_2100pn1clo.jpg

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Du stellst Forderungen die nur entsprechende Entwickler erfüllen könne und bist hier damit ganz einfach an der falschen Stelle. Was vielleicht, womöglich, eventuell sein könnte spielt dafür keine Rolle.wieso user forum. in jedem forum können welche sein die programmieren oder eine game engine nutzen.

Morkhero

Grand Admiral Special

- Mitglied seit

- 03.02.2002

- Beiträge

- 8.771

- Renomée

- 752

- Standort

- Bill Gates' Klo

- Details zu meinem Desktop

- Prozessor

- AMD Athlon 64 X2 4600+

- Mainboard

- MSI K8N Neo2-54G Platinum

- Kühlung

- Zalman CNPS9500 LED

- Speicher

- 4 GB G.Skill PC3200

- Grafikprozessor

- HIS ATI Radeon HD4670 IceQ AGP

- Display

- Dell U2212HM

- HDD

- 74GB WD Raptor, einer 200er und eine 1 TB (Caviar Black) WD

- Optisches Laufwerk

- Toshiba SH-S138L ; Pioneer DVD-105

- Soundkarte

- Audigy Player

- Gehäuse

- Chieftec Big Tower

- Netzteil

- Coolermaster SilentPro 500

- Betriebssystem

- Windows XP

- Webbrowser

- Firefox

- Verschiedenes

- lahme Kiste ^^

@WindHund

mit der ollen 2080ti kann ich nix mehr reissen gegen eine 6950xt^^ ...nur was die temperatur angeht ist das system noch für rekorde gut ... die temperatur der karte geht hier nicht über 45 grad unter last.

... die temperatur der karte geht hier nicht über 45 grad unter last.

und das mit dx11 und dx12 bei the witcher fiel mir nur wegen dem next gen update ein. der unterschied ist deutlich und für ballerian ist das spiel sicher auch günstiger zu bekommen als the last of us. wobei ich mit seiner karte maximal frustiert wäre ^^.

mit der ollen 2080ti kann ich nix mehr reissen gegen eine 6950xt^^ ...nur was die temperatur angeht ist das system noch für rekorde gut

... die temperatur der karte geht hier nicht über 45 grad unter last.

... die temperatur der karte geht hier nicht über 45 grad unter last.und das mit dx11 und dx12 bei the witcher fiel mir nur wegen dem next gen update ein. der unterschied ist deutlich und für ballerian ist das spiel sicher auch günstiger zu bekommen als the last of us. wobei ich mit seiner karte maximal frustiert wäre ^^.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

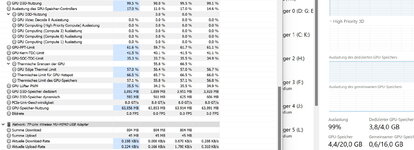

So richtig viel VRAM und RAM braucht bei mir Forspoken.

Nicht nur das es über 12GByte VRAM + RAM sind, es wird auch extreme schnell geladen.

Mein System bootet vom UEFI Bild bis zum Eingeben des Windows Passwort: 8 Sekunden ohne Fast Boot...

Hab schon wieder ein Buffer Overflow erwischt (DirectX 10) :

Nicht nur das es über 12GByte VRAM + RAM sind, es wird auch extreme schnell geladen.

Mein System bootet vom UEFI Bild bis zum Eingeben des Windows Passwort: 8 Sekunden ohne Fast Boot...

Hab schon wieder ein Buffer Overflow erwischt (DirectX 10) :

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Immer noch im Fenster Modus, aber nur noch 20°C im Raum, als vorher 23°C: https://abload.de/img/shadertoy_2100pn1clo.jpg

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

alle spiele die halt älter sind. hier hab ich ein Video gefunden von the witcher DX 12 im vergleich DX 11. unterschied sieht man zwar keinen auch nicht in speed , aber dafür braucht die DX 12 Version mehr VRAM. DX12 3.6 GB DX 11 2.8 GB .

speicherleck in far cry 6 seh ich keines, denn der vram bedarf des kompletten VRAM Bedarf im task manager liegt immer so um die 5.1 GB und bleibt so. passiert sogar dass nur 3.7 GB physikalisches VRAM genutzt wird. trotzdem läuft es mal schnell dann wird es irgendwann extrem langsam

das problem hab ich in der gforce 1030 nicht.

Du stellst Forderungen die nur entsprechende Entwickler erfüllen könne und bist hier damit ganz einfach an der falschen Stelle. Was vielleicht, womöglich, eventuell sein könnte spielt dafür keine Rolle.wieso user forum. in jedem forum können welche sein die programmieren oder eine game engine nutzen.

was für forderungen denn ?. das kostenlose far cry 6 trail auf einer 4g AMD karte installieren und probieren ob es da genau so passiert, dazu muss man kein programmierer sein. Wenn es mehr gibt die das Problem betätigen dann machen die eher etwas. der Kunde ist der König. Wenn König Kunde sagt , man muss eben immer eine grake haben die mehr VRAM hat als das GESAMTE Game belegt freut es die entwickler, die grakahersteller usw. Haben sie weniger arbeit und verdienen mehr geld.

Oder sind in dem Forum alle vielschreiber arbeiter bei AMD oder im computerhardware bereich beschäftigt ? . ehrliche antwort wäre gut, dann wüsst ich dass ich mir die mühe sparen hier zu schreiben. denn wenn das DX 12 memory management verbessert würde, dann befürchten die HW verkäufer weniger umsatz

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Deine ständige Forderung nach entsprechenden Code Zeilen, was letztendlich den Großteil der Ressourcen Verwaltung der Spiele Engine bedeuten würde.

Genau das wirst du hier aus mehreren Gründen mit Sicherheit nicht bekommen.

Begib dich mit einer Antwort auf User Niveau zufrieden oder stelle solche Forderungen da wo du sie auch bekommen kannst denn sonst ist es einfach nur Spam.

Selbst die Diskussion die du hier vom Zaun brichst ist mal wieder vollkommen fehl am Platz da es dir erneut nur um Programmierung geht und inzwischen aus dem bereits geschlossenen Topic wissen müßtest das du diese Antworten ohnehin nicht ebkommen kannst. Also geht es offenbar nur ums trollen....

Genau das wirst du hier aus mehreren Gründen mit Sicherheit nicht bekommen.

Begib dich mit einer Antwort auf User Niveau zufrieden oder stelle solche Forderungen da wo du sie auch bekommen kannst denn sonst ist es einfach nur Spam.

Selbst die Diskussion die du hier vom Zaun brichst ist mal wieder vollkommen fehl am Platz da es dir erneut nur um Programmierung geht und inzwischen aus dem bereits geschlossenen Topic wissen müßtest das du diese Antworten ohnehin nicht ebkommen kannst. Also geht es offenbar nur ums trollen....

vinacis_vivids

Vice Admiral Special

- Mitglied seit

- 12.01.2004

- Beiträge

- 848

- Renomée

- 87

@ballererian

Wie wäre es wenn du mal was vorlegst? Vllt. ein Benchmark mit RT optimiert auf RDNA2/3 ?

Wissen bekommst du bei www.gpuopen.com

Eventuell noch FSR 2.2 implementieren in der UE4.

Hast du überhaupt Kenntnisse was das angeht?

Wenn ich mal länger Zeit habe, würde ich auch mal ne Benchmark-Demo inkl. RT und FSR2.2, optimiert für RDNA2 / 3 hinlegen wollen.

Das RDNA3 e-Buch hat bspw. ca. 600 Seiten, wo man die shader-intrinsics sich anschauen kann.

Wie wäre es wenn du mal was vorlegst? Vllt. ein Benchmark mit RT optimiert auf RDNA2/3 ?

Wissen bekommst du bei www.gpuopen.com

Eventuell noch FSR 2.2 implementieren in der UE4.

Hast du überhaupt Kenntnisse was das angeht?

Wenn ich mal länger Zeit habe, würde ich auch mal ne Benchmark-Demo inkl. RT und FSR2.2, optimiert für RDNA2 / 3 hinlegen wollen.

Das RDNA3 e-Buch hat bspw. ca. 600 Seiten, wo man die shader-intrinsics sich anschauen kann.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Es geht hier um die RX 6500 und es gäbe die Diskussiion übehaupt nicht wenn sompe nicht der Meinung wäre, dass es kein Fehler in Speicherverwaltung ist, wenn die RX 65000 sobald das 4 GB limit der karte überschritten wird extrem langsam wird und die gfor4ce 1030 obwohl die nur 2 GB VRAM hat nicht

wenn du kein Programmierer bist woher willst du dann wissen, dass die RX 6500XT keine schlechtere Speicherverwaltung als die gforce 1030 hat

such einfach GPU nicht sichtbare polygone dann findest text von der uni karlsruhe. da solte auch nicht programmierern klar sein, dass nur wenige polygone und damit auch nur wenig texturen im physikalischen vram sein müssen.

Begib dich mit einer Antwort auf User Niveau zufrieden

wenn du kein Programmierer bist woher willst du dann wissen, dass die RX 6500XT keine schlechtere Speicherverwaltung als die gforce 1030 hat

such einfach GPU nicht sichtbare polygone dann findest text von der uni karlsruhe. da solte auch nicht programmierern klar sein, dass nur wenige polygone und damit auch nur wenig texturen im physikalischen vram sein müssen.

Moderne Grafikkarten können problemlos 2 Millionen Dreiecke bei hohen Frameraten rendern. Selbst wenn jedes Dreieck auf dem Bildschirm nur einen Pixel groß wäre, reichte es damit für HD-Auflösungen bei 60 FPS und mehr. Warum sollten wir uns also (Gedanken machen) Polygone (zu) sparen? Weil die meisten Polygone überhaupt nicht sichtbar sind!

Ein Grund kann Verdeckung durch andere Polygone sein. Culling-Verfahren versuchen, solche Polygone im Vorfeld heraus zu filtern. Ein anderes Problem kann allerdings die hohe Distanz zu Dreiecken sein: Weit entfernte Dreiecke können auf dem Bildschirm deutlich weniger als einen Pixel groß sein. In vielen Fällen wollen wir uns den Aufwand durch solche Dreiecke sparen, in dem wir weit entfernte Polygone zu einem einzelnen zusammenfassen (der Unterschied ist auf dem Ergebnisbild nicht mehr wahrzunehmen). Verfahren, die uns dies erlauben nennen wir “Level of Detail”-Techniken.

Ein Sonderfall für solche Techniken ist Terrain: Eine realitätsnahe Abbildung eines ganzen Kontinents kann Terabyte an Daten verursachen, mit einer entsprechend hohen Anzahl an Polygonen. Wir müssen hier viele entfernte Polygone einsparen, aber auch darauf achten, dass der Betrachter den Unterschied und den Übergang zwischen Detailstufen nicht bemerkt. Wir betrachten deshalb zunächst die Möglichkeiten, wie wir Terrain repräsentieren können, und was wir bei der Darstellung von Terrain im Allgemeinen beachten müssen

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich habe spaßenshalber mal versucht die Superpositionstests aus #10 bei der GT1030 eines meiner CPU Cruncher durchlaufen lassen.

8K Optimized @ FHD + Shader @ low, Texturen @ High - 4125

min. 20.24, Avg. 30.86, max. 46.04

8K Optimized @ FHD + Shader @ medium, Texturen @ High - 2653

min. 15.86, Avg. 19.84, max. 26.56

8K Optimized + Shader @ low, Texturen @ High - 133 aber in 5 von 6 Startversuchen Crash Benchmark

min. 1, Avg. 1, max. 1 (scheint die kleinste Einheit zu sein)

8K Optimized + Shader @ medium, Texturen @ High - Crash Benchmark

Interessant ist allerdings wie sehr die Werte zum belegten VRAM bei hwinfo64 (6.22) und dem Taskmanager auseinander gehen. (im Fenstermodus beobachtet)

Vor allem der Wert für den insgesammt belegten VRAM war sinnlos (z.B. 1,9 GB + 3,7 GB = 2 GB beim 8k Test)

8K Optimized @ FHD + Shader @ low, Texturen @ High - 4125

min. 20.24, Avg. 30.86, max. 46.04

8K Optimized @ FHD + Shader @ medium, Texturen @ High - 2653

min. 15.86, Avg. 19.84, max. 26.56

8K Optimized + Shader @ low, Texturen @ High - 133 aber in 5 von 6 Startversuchen Crash Benchmark

min. 1, Avg. 1, max. 1 (scheint die kleinste Einheit zu sein)

8K Optimized + Shader @ medium, Texturen @ High - Crash Benchmark

Interessant ist allerdings wie sehr die Werte zum belegten VRAM bei hwinfo64 (6.22) und dem Taskmanager auseinander gehen. (im Fenstermodus beobachtet)

Vor allem der Wert für den insgesammt belegten VRAM war sinnlos (z.B. 1,9 GB + 3,7 GB = 2 GB beim 8k Test)

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Ich habe spaßenshalber mal versucht die Superpositionstests aus #10 bei der GT1030 eines meiner CPU Cruncher durchlaufen lassen.

hast GT 1030 geschrieben. welche graka meinst du und was ist "eines meiner CPU Cruncher" das du geschrieben hast ?

Ich lasse die rx 6500 derzeit noch drin, damit ich nicht öfters umstecken muss, aber später mach ich dann auch alle tests die ich mit der 1030 nicht früher machte in neuem vergleichs thread.

die einzeige bei hw info stimmt bei mir. bei hwinfo heist es GPU speicher dynamisch was bei windows gemeinsamer GPU speicher heist. und gpu speicher dediziert ist das pysikalische vram. gesamt VRam zeigt hwinfo nicht an zumindest seh ich das nicht auf die schnelle. musst gpu speicher dynamisch + gpu speicher dediziert selber ausrechnen

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Wiederhole die Tests mal mit deiner GT1030.

Besonders interessant, der prognostizierte VRAM Speicherbedarf wird zum Anfang beim Laden des Tests belegt und schnurrt dann ein Stück zusammen, wobei die GPU bereits beim Ladevorgang auf Vollast fährt.

Besonders interessant, der prognostizierte VRAM Speicherbedarf wird zum Anfang beim Laden des Tests belegt und schnurrt dann ein Stück zusammen, wobei die GPU bereits beim Ladevorgang auf Vollast fährt.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Hab es mal mit Shadows of the Tomb Raider getestet DX11 vs. DX12.Immer noch im Fenster Modus, aber nur noch 20°C im Raum, als vorher 23°C: https://abload.de/img/shadertoy_2100pn1clo.jpg

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

alle spiele die halt älter sind. hier hab ich ein Video gefunden von the witcher DX 12 im vergleich DX 11. unterschied sieht man zwar keinen auch nicht in speed , aber dafür braucht die DX 12 Version mehr VRAM. DX12 3.6 GB DX 11 2.8 GB .

Wie du schon geschrieben hast, bei den reinen Durchschnittlichen FPS Zahlen sieht das nicht nach viel aus.

Aber, das Bild hakt mehrmals während des Benchmark richtig heftig ~ 500-600ms mit DirectX 11 (so könnte ich nicht spielen) : https://abload.de/img/shadowofthetombraidercvdyl.png

Mit DirectX 12 läufts wie am Schnürchen durch : https://abload.de/img/shadowofthetombraiderqai9k.png

Der VRAM ist unter 8GByte belegt mit UHD (ohne RT und HDR) und der RAM bei knapp 10GByte.

Ok, der Vergleich ist nicht ganz fair, das Spiel wurde ja mit DirectX12 Entwickelt, nun Rückwirkend im DirectX 11 Mode ist natürlich Murks, weil DX11 vieles nicht kann im Vergleich zu DX12.

Ich glaube nicht, dass wir uns da groß Gedanken machen müssen, wir können ja die Grafikeinstellungen vom Spiel anpassen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.225

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@sompe

Das habe ich jetzt nicht explizit Nachgeschaut, ob die Texturen Einstellung ein Einfluss auf das VRAM Volumen hat.

Aber, bevor das Spiel geladen wird, also im Spiel Menü sind es knapp 6GByte VRAM mit D3D12. (bei meinem Test oben)

Je nach dem wie lange man dann aktiv spielt, wird es natürlich mehr VRAM gerade bei open World Spiele.

Hier links oben sind die AB RTTS Stats zu sehen: https://abload.de/img/sottr_2023_04_14_17_40dcvl.jpg

Nicht von der CPU Auslastung im Bild blenden lassen (idle), im Spiel werden je nach Nachlade Menge alle 24 Threads befeuert.

.

Das habe ich jetzt nicht explizit Nachgeschaut, ob die Texturen Einstellung ein Einfluss auf das VRAM Volumen hat.

Aber, bevor das Spiel geladen wird, also im Spiel Menü sind es knapp 6GByte VRAM mit D3D12. (bei meinem Test oben)

Je nach dem wie lange man dann aktiv spielt, wird es natürlich mehr VRAM gerade bei open World Spiele.

Hier links oben sind die AB RTTS Stats zu sehen: https://abload.de/img/sottr_2023_04_14_17_40dcvl.jpg

Nicht von der CPU Auslastung im Bild blenden lassen (idle), im Spiel werden je nach Nachlade Menge alle 24 Threads befeuert.

.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Einfach nur den Benchmark mit den jeweiligen Textureneinstellungen durchlaufen lassen.

Höher aufgelöste Texturen sollten normalerweise auch mehr VRAM fressen. Damals war das offenbar bei DX11 nicht der Fall. ^^

Höher aufgelöste Texturen sollten normalerweise auch mehr VRAM fressen. Damals war das offenbar bei DX11 nicht der Fall. ^^

Ähnliche Themen

- Gesperrt

- Antworten

- 81

- Aufrufe

- 4K

- Antworten

- 15

- Aufrufe

- 687

- Antworten

- 0

- Aufrufe

- 1K