App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

RX 6500XT vs. R9 Nano

- Ersteller sompe

- Erstellt am

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

ok, ich habe gerade gesehen auch am Ende vom inGame Bench werden alle Threads belastet, nicht zu 100% aber alles wird genutzt: https://abload.de/img/sottr_4k_inbenchpidjq.pngEinfach nur den Benchmark mit den jeweiligen Textureneinstellungen durchlaufen lassen.

Höher aufgelöste Texturen sollten normalerweise auch mehr VRAM fressen. Damals war das offenbar bei DX11 nicht der Fall. ^^

Das Bild ist etwas Größer als die Bilder vom Spiele Menü.

Edit:

Die selbe Stelle (etwa) mit Texturen auf niedrigster Stufe: https://abload.de/img/sottr_2023_04_14_20_29ge63.jpg

Und das Ergebnis noch: https://abload.de/img/sottr_2023_04_14_20_2rzf62.jpg

Es macht schon ein Unterschied, ich sehe auch deutlich ein Unterschied im Bild, da fehlt was.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Fair ist es schon denn die Textureneinstellungen sollten dann dennoch einen Einfluss darauf haben. Es geht ja nicht um Sachen wie den Multicore Support sondern lediglich die VRAM Belegung. Sind sie dennoch deutlich besser wird wohl bei DX11 deutlich öfter nachgeladen.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Ja, inzwischen ändert sich das VRAM Volumen wenn die Texturen angepasst werden mit D3D11.

Von "niedrigste" 6,3GByte über "normal" 6,4GByte weiter zu "Hoch" 6,9GByte und zurück zu "Ultra" 7,6GByte. (im Menü)

InBench sind dann 10 GByte VRAM (Ultra): https://abload.de/img/sottr_2023_04_14_21_5xaf42.jpg

Ich habe mehr IDLE zum Bilder Hochladen als Benchmarks zum laden benötigen!

Von "niedrigste" 6,3GByte über "normal" 6,4GByte weiter zu "Hoch" 6,9GByte und zurück zu "Ultra" 7,6GByte. (im Menü)

InBench sind dann 10 GByte VRAM (Ultra): https://abload.de/img/sottr_2023_04_14_21_5xaf42.jpg

Ich habe mehr IDLE zum Bilder Hochladen als Benchmarks zum laden benötigen!

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Hab es mal mit Shadows of the Tomb Raider getestet DX11 vs. DX12.Immer noch im Fenster Modus, aber nur noch 20°C im Raum, als vorher 23°C: https://abload.de/img/shadertoy_2100pn1clo.jpg

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

alle spiele die halt älter sind. hier hab ich ein Video gefunden von the witcher DX 12 im vergleich DX 11. unterschied sieht man zwar keinen auch nicht in speed , aber dafür braucht die DX 12 Version mehr VRAM. DX12 3.6 GB DX 11 2.8 GB .

Wie du schon geschrieben hast, bei den reinen Durchschnittlichen FPS Zahlen sieht das nicht nach viel aus.

Aber, das Bild hakt mehrmals während des Benchmark richtig heftig ~ 500-600ms mit DirectX 11 (so könnte ich nicht spielen) : https://abload.de/img/shadowofthetombraidercvdyl.png

es ist nur für den benchmark. wenn du vsync anstellst und freesync am monitor an ist müsste es auch gehen. denn am besten ist immer mit vsync nur für benchmark ist es natürlich ungeeignet . Du hast hohe fps. man sieht unterschiede in der bildrate stark wenn sie sich ändert. Du hast 120 hz eingestellt dass wären 8.3 ms Pro Bild. das diagram zeigt von 0- 20 ms das du hast. Wenn du dir deine kurve anschaust ist deine frame zeit mal unter mal über 8 ms . da ist klar dass es dann sichtbar ruckelig wirkt durch das tearing weil du vsync aus hast. 20 ms wären 50 hz. normalerweise müsste das der freesync monitor aber ausgleichen. müssten doch alle 120 hz monitore freesync haben. wenn der monitor fest 120 hz macht, und ein Bild dauert länger als 8.3 ms in der berechnung dann siehst du das vorige Bild 16,6 ms lang(ist frame time für 60 hz. . wenn er dann schneller rechnet dann wieder in 8.3 ms.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Die harten Ruckler sind mit den "niedrigsten" Texturen weg, dennoch sind es 33% weniger FPS und die Framtime Linie Zittert immer wieder (D3D11).Hab es mal mit Shadows of the Tomb Raider getestet DX11 vs. DX12.Immer noch im Fenster Modus, aber nur noch 20°C im Raum, als vorher 23°C: https://abload.de/img/shadertoy_2100pn1clo.jpg

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

alle spiele die halt älter sind. hier hab ich ein Video gefunden von the witcher DX 12 im vergleich DX 11. unterschied sieht man zwar keinen auch nicht in speed , aber dafür braucht die DX 12 Version mehr VRAM. DX12 3.6 GB DX 11 2.8 GB .

Wie du schon geschrieben hast, bei den reinen Durchschnittlichen FPS Zahlen sieht das nicht nach viel aus.

Aber, das Bild hakt mehrmals während des Benchmark richtig heftig ~ 500-600ms mit DirectX 11 (so könnte ich nicht spielen) : https://abload.de/img/shadowofthetombraidercvdyl.png

es ist nur für den benchmark. wenn du vsync anstellst und freesync am monitor an ist müsste es auch gehen. denn am besten ist immer mit vsync nur für benchmark ist es natürlich ungeeignet . Du hast hohe fps. man sieht unterschiede in der bildrate stark wenn sie sich ändert. Du hast 120 hz eingestellt dass wären 8.3 ms Pro Bild. das diagram zeigt von 0- 20 ms das du hast. Wenn du dir deine kurve anschaust ist deine frame zeit mal unter mal über 8 ms . da ist klar dass es dann sichtbar ruckelig wirkt durch das tearing weil du vsync aus hast. 20 ms wären 50 hz. normalerweise müsste das der freesync monitor aber ausgleichen. müssten doch alle 120 hz monitore freesync haben. wenn der monitor fest 120 hz macht, und ein Bild dauert länger als 8.3 ms in der berechnung dann siehst du das nächste Bild 16,6 ms lang(ist frame time für 60 hz. . wenn er dann schneller rechnet dann wieder in 8.3 ms.

Also für solche Visuelle Blockbuster ist D3D11 schon lange nichts mehr.

Zumal Raytracing Schatten ohne D3D12 auch nicht vorhanden sind und kein HDR Rendering, was ich Persönlich als Feature für mich entdeckt habe.

Ich nutze kein VSync im Spiel, nur FreeSync Premium Pro + Enhanced Sync in den Adrenalin Einstellungen.

Ich habe noch nichts Vergleichbares gesehen.

Quelle: https://www.amd.com/de/technologies/free-sync-faqWie unterscheidet sich das HDR bei FreeSync™ Premium Pro von herkömmlichem HDR?

Die Implementierung von HDR in FreeSync™ Premium Pro unterscheidet sich von einer herkömmlichen HDR-Pipeline. Bei FreeSync Premium Pro gibt der Monitor Spezifikationen und Daten direkt an den PC weiter. Somit ist ein direktes Tonemapping auf das Display möglich und unnötige Zwischenschritte werden vermieden, was die Eingabelatenz verringert. Außerdem übersteigen die HDR-Grundvoraussetzungen bei FreeSync Premium Pro die von HDR 400, um im Vergleich zu SDR (sRGB) mindestens das doppelte wahrgenommene Farbvolumen zu bieten.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Die harten Ruckler sind mit den "niedrigsten" Texturen weg, dennoch sind es 33% weniger FPS und die Framtime Linie Zittert immer wieder (D3D11).Hab es mal mit Shadows of the Tomb Raider getestet DX11 vs. DX12.Immer noch im Fenster Modus, aber nur noch 20°C im Raum, als vorher 23°C: https://abload.de/img/shadertoy_2100pn1clo.jpg

@Morkhero

The Last of us (Part 1)...

Ich müsste erst mal schauen was kein DirectX 12 hat.

alle spiele die halt älter sind. hier hab ich ein Video gefunden von the witcher DX 12 im vergleich DX 11. unterschied sieht man zwar keinen auch nicht in speed , aber dafür braucht die DX 12 Version mehr VRAM. DX12 3.6 GB DX 11 2.8 GB .

Wie du schon geschrieben hast, bei den reinen Durchschnittlichen FPS Zahlen sieht das nicht nach viel aus.

Aber, das Bild hakt mehrmals während des Benchmark richtig heftig ~ 500-600ms mit DirectX 11 (so könnte ich nicht spielen) : https://abload.de/img/shadowofthetombraidercvdyl.png

es ist nur für den benchmark. wenn du vsync anstellst und freesync am monitor an ist müsste es auch gehen. denn am besten ist immer mit vsync nur für benchmark ist es natürlich ungeeignet . Du hast hohe fps. man sieht unterschiede in der bildrate stark wenn sie sich ändert. Du hast 120 hz eingestellt dass wären 8.3 ms Pro Bild. das diagram zeigt von 0- 20 ms das du hast. Wenn du dir deine kurve anschaust ist deine frame zeit mal unter mal über 8 ms . da ist klar dass es dann sichtbar ruckelig wirkt durch das tearing weil du vsync aus hast. 20 ms wären 50 hz. normalerweise müsste das der freesync monitor aber ausgleichen. müssten doch alle 120 hz monitore freesync haben. wenn der monitor fest 120 hz macht, und ein Bild dauert länger als 8.3 ms in der berechnung dann siehst du das nächste Bild 16,6 ms lang(ist frame time für 60 hz. . wenn er dann schneller rechnet dann wieder in 8.3 ms.

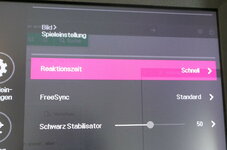

schau mal im monitor einstell menu ob bei dir freesync an ist. so ruckler kann bei etwas komplexeren szenen als im benchmark auch mit DX 12 passieren ohne freesync. HDR hat technisch nur indirekt mit freesync zu tun. weil hdr mehr daten überträgt kann sein dass dann nicht so hohe monitor refresh rate geht wegen kabel. dank free sync braucht man keine so hohe monitor refreshrate und ruckt nicht. da tun es dann 75 hz auch. Muss man im Monitor setting overlay sehen wenn freesync aktiv ist. oder dort anstellen. so sieht es bei mir aus

ohne freesync wenn z.b das Bild rendern 8.31 ms braucht und der Monitor bei 120 hz erreichen alle 8.3 ms ein Bild benötigt ruckt es ohne freesync schon stark obwohl das bild 0.01 ms später am monitor ankam. Ist das Bild nicht da nach 8.3 ms wird wegen den 0.01 ms später das Bild dann 8.3 ms weiter angezeigt. also 16.6 ms lang angezeigt. allerdings stimmt das Bild dann nicht in der position weil es ja für 8,3 ms Zeit früher berechnet wurde. das wirkt sehr stark weil alles relativ ist und der fehler in dem falle 100% ist. dass es bei direct x 12 und tombraider gerade nicht auftritt ist halt weil die szene nicht so komplex ist, dass sie um die 8.3 ms stärker schwankt. aber bei einem freesync monitor ist sowas kein Problem, der zeigt dann das Bild eben nach 8.31 ms an was man nicht merkt weil der fehler nur wenige % hat

wenn man kein freesync hat dann hat ein 500 hz monitor auch vorteil weil der fehler geringer ist. ein 500 hz monitor kann alle 2 ms ein Bild anzeigen. kommt das Bild nicht innerhalb 8 ms, dann kommt es 2 ms später also nach 10 ms.

aber um teure hardware kosten zu sparen ist freesync optimal.

Doppelposting wurde automatisch zusammengeführt:

Im übrigen kommt es auch darauf an womit man spielt. mit einem gamepad sieht die bewegung am flüssigsten aus beim drehen und so. Aber zielen kann ich damit viel schlechter als mit Trackball. Ich spiel öfters mit dem trackball . hab mehrere am besten find ich Elecom EX G. die kugel dreht man nie so gleichmässig als wenn man den stick drückt und es rotiert mit gleicher geschwindigleit. aber zielen kann ich damit schlechter obwoh ich einen gulikit habe mit optischen sensoren. mit dem trackball geht zwar das zielen am besten und man muss nicht schieben wie mit Maus und man kann sich schneller drehen wenn man die kugel stark anschubst. Aber die drehung wirkt nie so flüssig wie mit dem gamepad. daher find ich es auch nicht schlimm selbst wenn das game nur 13 fps macht da wirkt sogar das game schärfer weil die bewegungsunschärfe durch das IPS wegfällt.

und im real life wenn man sich schnell dreht und was sehen will dann dreht man die augen so, dass das bild mal kurz stillsteht. hat alles seine Vor und nachteile. ich nehme game pad nur wenn man nicht so genau zielen muss.

hier ist mal gaming mit trackball zu sehen.

Zuletzt bearbeitet:

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

@ballerian

DAnke für die Ausführlich Erklärung, die harten Ruckler gibt es nur wenn man Versucht ein DX12 Blockbuster mit der DX11 API zu Spielen.

Das ist an sich schon Quatsch, man nutzt die Software die besser läuft und nicht freiwillig die schlechtere.

Ja bei mir is FreeSync Premium Pro an da meine Spiele auch in HDR Rendern (Eingestellt im Spiele Menü)

Hier ein Bild vom Samsung Overlay unten das Blau/Violette: https://abload.de/img/20230302_185803kycmt.jpg

Ich habe keine Problem, läuft alles zu meiner Zufriedenheit.

DAnke für die Ausführlich Erklärung, die harten Ruckler gibt es nur wenn man Versucht ein DX12 Blockbuster mit der DX11 API zu Spielen.

Das ist an sich schon Quatsch, man nutzt die Software die besser läuft und nicht freiwillig die schlechtere.

Ja bei mir is FreeSync Premium Pro an da meine Spiele auch in HDR Rendern (Eingestellt im Spiele Menü)

Hier ein Bild vom Samsung Overlay unten das Blau/Violette: https://abload.de/img/20230302_185803kycmt.jpg

Ich habe keine Problem, läuft alles zu meiner Zufriedenheit.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

@WindHund

Ich hab mal far cry 6 mit HDR probiert wie ich in deinem screenshot sehe kann man einfach mit win+alt+b umschalten. finde auch Bild sieht besser aus in HDR vorallem wenn man Full HD ohne AA nutzt damit das Bild scharf ist reduziert sich das flimmern. ich mag kein AA weil mir dann das Bild zu unscharf wird. Ich habe in far cry 6 nun einmal raytracing bei schatten und spiegelungen angestellt bei FUll HD. wenn ich das game neu starte und da wo ich gespeichert hatte rumlaufe komm ich auf 47 fps wenn HDR aktiv. schalte ich mit win +alt +b HDR ab geht es runter auf 19 fps. schalte ich wieder zurück auf HDR an mit wieder win+alt+b drücken dann macht es nur noch 4 fps . wenn ich das game dann wieder neu starte hab ich wieder 47 fps. VRA; belegung ist immer ziemlich gleich gibt also kein memory leck. wenn es den Bug nicht gäbe, wäre ich zufrieden mit der peformance der RX6500xt .muss irgendwas mit den pxixelshadern zu tun haben.

shadow of the tombraider hab ich mir gekauft und benchmarks laufen lassen. auch unter DX 11 wird es beim länger spielen dann benchmark wieder machen fast 2 * langsamer bei den min fps. ist aber nicht so extrem wie bei far cry 6. obwohl vom shadow of tombraider auch VRAM 5 GB angefordert war

hänger hab ich bei DX 11 und DX 12 keine . raytracing geht da in mittel in full hd fast ohne speedverlust

wie heist denn die CPU GPU anzeige die bei dem witcher demo die frame time in diagram zeigt ?.

forum.planet3dnow.de

forum.planet3dnow.de

denke die zeigt genauer an. ab und an nach auflösungen ändern hatt ich bei shadows of tomb raider mal 0.2 sec hänger aber in dem diagram von shadow of tombraider sieht man das nicht.

Ich hab mal far cry 6 mit HDR probiert wie ich in deinem screenshot sehe kann man einfach mit win+alt+b umschalten. finde auch Bild sieht besser aus in HDR vorallem wenn man Full HD ohne AA nutzt damit das Bild scharf ist reduziert sich das flimmern. ich mag kein AA weil mir dann das Bild zu unscharf wird. Ich habe in far cry 6 nun einmal raytracing bei schatten und spiegelungen angestellt bei FUll HD. wenn ich das game neu starte und da wo ich gespeichert hatte rumlaufe komm ich auf 47 fps wenn HDR aktiv. schalte ich mit win +alt +b HDR ab geht es runter auf 19 fps. schalte ich wieder zurück auf HDR an mit wieder win+alt+b drücken dann macht es nur noch 4 fps . wenn ich das game dann wieder neu starte hab ich wieder 47 fps. VRA; belegung ist immer ziemlich gleich gibt also kein memory leck. wenn es den Bug nicht gäbe, wäre ich zufrieden mit der peformance der RX6500xt .muss irgendwas mit den pxixelshadern zu tun haben.

shadow of the tombraider hab ich mir gekauft und benchmarks laufen lassen. auch unter DX 11 wird es beim länger spielen dann benchmark wieder machen fast 2 * langsamer bei den min fps. ist aber nicht so extrem wie bei far cry 6. obwohl vom shadow of tombraider auch VRAM 5 GB angefordert war

hänger hab ich bei DX 11 und DX 12 keine . raytracing geht da in mittel in full hd fast ohne speedverlust

wie heist denn die CPU GPU anzeige die bei dem witcher demo die frame time in diagram zeigt ?.

RX 6500XT vs. R9 Nano

In deinem Fall ist das mehr als PCIe 4 x8 oder PCIe 3 x 16. bei meiner gforce 1030 und radeon 6500 XT ist es aber auch so 22 GB . siehe mein screenshot oben. aber pcie3 x16 soll nur 16 gb machen. in dem bench kommen meine karten aber auf 22 GB. aber eh egal mein DDR 4 schafft auch nur 16 GB...

forum.planet3dnow.de

forum.planet3dnow.de

denke die zeigt genauer an. ab und an nach auflösungen ändern hatt ich bei shadows of tomb raider mal 0.2 sec hänger aber in dem diagram von shadow of tombraider sieht man das nicht.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Es gibt auch ein Datenträger Frame Buffer, der wird erst gefüllt wenn sich die Berechnungen Wiederholen.@WindHund

denke die zeigt genauer an. ab und an nach auflösungen ändern hatt ich bei shadows of tomb raider mal 0.2 sec hänger aber in dem diagram von shadow of tombraider sieht man das nicht.

Shader Cache wird es im GPU Treiber genannt, denn kann man dort auch zurücksetzen. (löschen)

Daher nutze ich ja den After Burner um mir auch die Frame Time Linie anzeigen zu lassen, weil ich Neugierig bin.

Es gibt genug Stellen, wo DX11 die Linie nicht Flach hält, sondern sie steigt an, die Latenz.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Na ja, bei 0% GPU gebundenen FPS ist es auch nicht wirklich verwunderlich das die Zuschaltung von RT zu keinem großartigen Geschwindigkeitsverlußt führt. Das Spiel hängt voll im CPU Limit.hänger hab ich bei DX 11 und DX 12 keine . raytracing geht da in mittel in full hd fast ohne speedverlust

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Na ja, bei 0% GPU gebundenen FPS ist es auch nicht wirklich verwunderlich das die Zuschaltung von RT zu keinem großartigen Geschwindigkeitsverlußt führt. Das Spiel hängt voll im CPU Limit.hänger hab ich bei DX 11 und DX 12 keine . raytracing geht da in mittel in full hd fast ohne speedverlust

dass sind doch screenshots mit DX11 sieht man das nicht ?. bei DX 11 gibt es doch gar kein Raytracing und ich hatte die preset einstellung in grafik von hoch um es mit anderen systemen besser zu vergleichen.. wäre raytracing an(durch anschalten bei preset hoch) müsste DX 12 an sichtbar sein und unter grafik steht benutzerdefiniert. Die Werte die shadow of the tomb raider ausgibt bei CPU render find ich falsch. Oder kann man das ohne 3d grafikkarte spielen ?. denn dass meine CPU nicht bremst seh ich einfach wenn ich eine sehr kleine screenaufläsung wähle. ist die CPU zu langsam wird es bei kleinerer auflösung kaum schneller. wird aber bei mir viel schneller.

3072x1728 grafikpreset hoch und raytracing an auf mittel. cpu render wert ist mit raytracing viel schneller

800x600 preset hoch raytracing an auf mittel

800x600 grafikpreset hoch

also sieht man klar ne schnellere CPU nutzt kaum was. wenn es mal eine APU von AMD gibt mit der performace der 6500 wäre am besten. da hat man dann mit 32 gb kein 16 GB ram limit und die zeit daten zur graka übertragen werden auch gespart. Für diejenigen die noch mehr power wollen, sollte dann eine graka per sli sich zusammen schalten lassen so hat jeder was von der APU . nur so wie das aussieht scheint die built in grafik in der neuen ryzen generation langsamer als in der vorigen generation

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Nichts für ungut aber du wirfst hier alles so fröhlich durcheinander das die Screenshots wertlos werden und gehst kein Stück auf angesprochene Probleme ein.

Die ersten beiden sind aufgrund der hohen Auflösung wertlos weil es schon deshalb bei der 6500XT wenig verwunderlich ist das die Framerate GPU gebunden ist denn dafür ist die ganz einfach zu langsam, was man ja auch an den durchschnittlichen 18 FPS erkennen kann. Mit der Einstellung spielt aufgrund der Framerate wohl ohnehin niemand, womit es für die Praxis nutzlos ist.

Bei den anderen beiden hast du zwar in 800 x 600 mit RT rumgespielt aber den bereits angesprochenen Punkt ignoriert. Den Prozentsatz der GPU gebundenen Frames.

Mit der Zuschaltung von RT stiegt der Satz lediglich von 35% auf 54%. Der Großteil der GPU Leistung hängt also dennoch in der Luft weil die GPU auf die Daten der CPU warten muss und entsprechend gering fällt dadurch der Unterschied in Benchmark Ergebnis aus weil die GPU dennoch entsprechend große Reserven hat da letztendlich lediglich der GPU gebundenen Teil Einfluss auf das Ergebniss hat.

Du scheinst dir ohnehin gezielt nutzlose Einstellungen rauszusuchen die für die Praxis keine Rolle zu spielen scheinen um irgendeine Aussage zu unterstreichen.

Unterm Strich haben die Daten nur 2 Sachen gezeigt. Für die hohe Auflösung ist die Karte zu lahm und RT ist aus dem gleichen Grund Ressourcenverschwendung weil die Rechenleistung bei den klassischen Einstellungsmöglichkeiten besser angelegt wäre um ein möglichst gutes Spielerlebnis mit der Hardware zu erhalten.

Die ersten beiden sind aufgrund der hohen Auflösung wertlos weil es schon deshalb bei der 6500XT wenig verwunderlich ist das die Framerate GPU gebunden ist denn dafür ist die ganz einfach zu langsam, was man ja auch an den durchschnittlichen 18 FPS erkennen kann. Mit der Einstellung spielt aufgrund der Framerate wohl ohnehin niemand, womit es für die Praxis nutzlos ist.

Bei den anderen beiden hast du zwar in 800 x 600 mit RT rumgespielt aber den bereits angesprochenen Punkt ignoriert. Den Prozentsatz der GPU gebundenen Frames.

Mit der Zuschaltung von RT stiegt der Satz lediglich von 35% auf 54%. Der Großteil der GPU Leistung hängt also dennoch in der Luft weil die GPU auf die Daten der CPU warten muss und entsprechend gering fällt dadurch der Unterschied in Benchmark Ergebnis aus weil die GPU dennoch entsprechend große Reserven hat da letztendlich lediglich der GPU gebundenen Teil Einfluss auf das Ergebniss hat.

Du scheinst dir ohnehin gezielt nutzlose Einstellungen rauszusuchen die für die Praxis keine Rolle zu spielen scheinen um irgendeine Aussage zu unterstreichen.

Unterm Strich haben die Daten nur 2 Sachen gezeigt. Für die hohe Auflösung ist die Karte zu lahm und RT ist aus dem gleichen Grund Ressourcenverschwendung weil die Rechenleistung bei den klassischen Einstellungsmöglichkeiten besser angelegt wäre um ein möglichst gutes Spielerlebnis mit der Hardware zu erhalten.

vinacis_vivids

Vice Admiral Special

- Mitglied seit

- 12.01.2004

- Beiträge

- 850

- Renomée

- 87

Ich warte immer noch auf die 8K Ultra RT Ergebnisse mit der GF1030...

Maverick-F1

Grand Admiral Special

Das könnte wohl länger dauern, weil die GF1030 kein RT kann...Ich warte immer noch auf die 8K Ultra RT Ergebnisse mit der GF1030...

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Nichts für ungut aber du wirfst hier alles so fröhlich durcheinander das die Screenshots wertlos werden und gehst kein Stück auf angesprochene Probleme ein.

bei dem 3072 mit raytracing steht aber GPU gebunden 100%. du hattest vorher auf die DX 11 werte von mir ohne raytracing das gepostet

Na ja, bei 0% GPU gebundenen FPS ist es auch nicht wirklich verwunderlich das die Zuschaltung von RT zu keinem großartigen Geschwindigkeitsverlußt führt. Das Spiel hängt voll im CPU Limit.hänger hab ich bei DX 11 und DX 12 keine . raytracing geht da in mittel in full hd fast ohne speedverlust

vielleicht berechnet das spiel unter DX 11 viele effekt per CPU . und dass soll der CPU Render wert aussagen.

die CPU ist nicht zu lahm sieht man dx 11, zumal es bei 800x600 viel schneller wird.

Ich habe heute nochmal 3072x bench gemacht in DX 11 und es ist sogar noch schneller. statt min 19 bei der schnellen version kommt min 30 raus. das stimmt auch denn links sieht man bps während game läuft. der geht nie auf unter 30. bei CPU render steht aber 19. soll ich ein video hochladen ?

ich habe die 3000 auflösung deswegen genommen weil ich schon die direct x11 werte gepostet hatte in der auflösung. es ist ein benchmark und benchmarks sind immer sehr komplex. kommt im spiel selten vor. nur am anfang die stadt. willst du sagen 25 fps sind nicht spielbar ?.wieviele fps soll es denn mindestens haben ?.

wenn man frisch startet oder am besten bootet und gleich den benchmark macht ist die karte in 3072x schnell. sie wird nur mit der zeit einiges langsamer. aber immerhin nicht so schlimm wie in far cry 6

Doppelposting wurde automatisch zusammengeführt:

hier noch das direct x 11 in 800x600. da gibt es GPU gebunden immerhin 34% aus. bei so kleiner auflösung kann schon eher sein, dass CPU zu langsam ist.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Wie der ein wenig hilfreiches Posting von dir...

Warum es bei der Umschaltung auf DX11 schneller läuft?

Ganz einfach, weil DX11 kein Raytracing unterstützt und es deshalb keine GPU Leistung frißt.

Des weiteren kippte der Wert der GPU gebundenen Frames mit der Abschaltung von DX12 von 100% auf 0%.

Der lausige Multicore Support von DX11 läßt grüßen.

Warum es bei der Umschaltung auf DX11 schneller läuft?

Ganz einfach, weil DX11 kein Raytracing unterstützt und es deshalb keine GPU Leistung frißt.

Des weiteren kippte der Wert der GPU gebundenen Frames mit der Abschaltung von DX12 von 100% auf 0%.

Der lausige Multicore Support von DX11 läßt grüßen.

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Warum es bei der Umschaltung auf DX11 schneller läuft?

Es geht nicht darum, es geht darum dir zu beweisen dass die GPU bound anzeige in tomb raider nicht richtig funktioniert bei DX 11. das gpu overlay vom amd treiber zeigt immer 80-99% gpu auslastung an. also cpu ist schnell genug

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Und jetzt rate mal warum die GPU Auslastung auf 80% runter rutscht.

Weil sie auf die Daten der CPU warten muss und wie nennt man das? CPU Limitierung.

Und was fehlt noch in deiner Aufführung?

Der GPU Takt und wie weit der Verbrauch der GPU vom Powerlimit entfernt ist da bei Unterforderung der GPU gern mal der Takt gesenkt wird um Strom zu sparen.

Weil sie auf die Daten der CPU warten muss und wie nennt man das? CPU Limitierung.

Und was fehlt noch in deiner Aufführung?

Der GPU Takt und wie weit der Verbrauch der GPU vom Powerlimit entfernt ist da bei Unterforderung der GPU gern mal der Takt gesenkt wird um Strom zu sparen.

WindHund

Grand Admiral Special

- Mitglied seit

- 30.01.2008

- Beiträge

- 12.228

- Renomée

- 536

- Standort

- Im wilden Süden (0711)

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- NumberFields@home

- Lieblingsprojekt

- none, try all

- Meine Systeme

- RYZEN R9 3900XT @ ASRock Taichi X570 & ASUS RX Vega64

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5950X

- Mainboard

- ASRock 570X Taichi P5.05 Certified

- Kühlung

- AlphaCool Eisblock XPX, 366x40mm Radiator 6l Brutto m³

- Speicher

- 2x 16 GiB DDR4-3600 CL26 Kingston (Dual Rank, unbuffered ECC)

- Grafikprozessor

- 1x ASRock Radeon RX 6950XT Formula OC 16GByte GDDR6 VRAM

- Display

- SAMSUNG Neo QLED QN92BA 43" up to 4K@144Hz FreeSync PP HDR10+

- SSD

- WD_Black SN850 PCI-Express 4.0 NVME

- HDD

- 3 Stück

- Optisches Laufwerk

- 1x HL-DT-ST BD-RE BH10LS30 SATA2

- Soundkarte

- HD Audio (onboard)

- Gehäuse

- SF-2000 Big Tower

- Netzteil

- Corsair RM1000X (80+ Gold)

- Tastatur

- Habe ich

- Maus

- Han I

- Betriebssystem

- Windows 10 x64 Professional (up to date!)

- Webbrowser

- @Chrome.Google & Edge Chrome

Nicht nur in HDR Rendern, sondern auch mit HDR10+ Wiedergeben auf dem Bildschirm:

www.inside-digital.de

www.inside-digital.de

Dank LFC sind bei mir 30 gerenderte Frames wie 60Hz, gefühlt.

Edit:

Von HDR1000 bis HDR10+: Was wirklich hinter diesen Kennzeichnungen steckt

Damit in dem Begriffschaos die Übersicht nicht abhandenkommt, haben wir für dich die wichtigsten Erklärungen zu HDR zusammengestellt.

Im Gegensatz zu HDR10 ist HDR10+ dynamisch, sodass HDR10+ für jedes einzelne Bild lebensechte Farben und ausgeprägte Details berechnet. Dieses HDR-Format entwickelten Amazon Video und Samsung als Alternative zu Dolby Vision. Es ist lizenzfrei und daher stärker auf dem Markt vertreten. Durch die dynamischen Einstellungen sind HDR10+-Inhalte abwärtskompatibel zu SDR-TV-Geräten, die jedoch nicht die volle Detailfülle des Inhalts wiedergeben können.

Dank LFC sind bei mir 30 gerenderte Frames wie 60Hz, gefühlt.

Edit:

FreeSync™

- Zertifiziert

- Verzerrungsfrei

- Niedrige Latenz

FreeSync™ Premium

- Zertifiziert

- Mindestens 120 Hz bei FHD-Auflösung oder höher

- Kompensation für niedrige Bildraten

- Niedrige Latenz

FreeSync™ Premium Pro

(bisher bekannt als FreeSync 2 HDR)

Siehe aktuelle Liste unterstützter Spiele.

- Umfangreiche Farb- und Luminanzzertifizierung

- HDR-Fähigkeiten und Spielunterstützung

- Mindestens 120 Hz bei FHD-Auflösung oder höher

- Kompensation für niedrige Bildraten

- Niedrige Latenz mit SDR oder HDR

Zuletzt bearbeitet:

Gozu

Vice Admiral Special

- Mitglied seit

- 19.02.2017

- Beiträge

- 521

- Renomée

- 70

- Mein Laptop

- Asus ROG Zephyrus G14 2022 (GA402RJ-L8116W) / HP 15s-eq1158ng

- Details zu meinem Desktop

- Prozessor

- Ryzen R9 5900

- Mainboard

- AsRock B550 Phantom Gaming Velocita

- Kühlung

- Coolermaster MASTERLIQUID 120

- Speicher

- 2x 16GB HyperX KHX3733C19D4/16GX 3733-19

- Grafikprozessor

- AsRock RX 6800 Phantom Gaming D 16G

- Display

- 27 " iiyama G-Master GB2760QSU WQHD

- HDD

- 2x WDC WD10EADS-11P8B1

- Optisches Laufwerk

- TSSTcorp CDDVDW SH-2

- Gehäuse

- CoolerMaster HAF XB

- Netzteil

- Enermax EDT1250EWT

- Maus

- Rocat Kova

- Betriebssystem

- Windows 10 Professional x64, Manjaro

- Webbrowser

- Iron

- Internetanbindung

- ▼1000 MBit ▲50 MBit

Viele Hardcoregamer nutzen auch unter Windows DXVK für Spiele mit DX9 - DX11, weil diese damit bessere Frametimes haben. Gibt meistens einen Boost bei AMD, NVIDIA und Intel Karten. DXVK ist Bestandteil von Valves Proton womit die Windows Spiele unter Linux laufen. Einfach runterladen und die DLLs ins Spiele Verzeichniss kopieren. Ab Version 2.0 muss die Grafikkarte Vulkan 1.3 beherschen, bei älteren Karten also besser Version 1.10.3 nehmen.

github.com

github.com

Test mit 4 Spielen:

Releases · doitsujin/dxvk

Vulkan-based implementation of D3D9, D3D10 and D3D11 for Linux / Wine - doitsujin/dxvk

Test mit 4 Spielen:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

siehst du nun im VideoUnd jetzt rate mal warum die GPU Auslastung auf 80% runter rutscht.

Weil sie auf die Daten der CPU warten muss und wie nennt man das? CPU Limitierung.

ich habe nun Video gemacht da siehst es ganz genau. klar minimales CPU limit gibt es immer. Obwohl ich mit demselben PC und bandicam das video aufnehme bleibt die auslastung während des benchmarks wenn grafik zu sehen ist über 95%. Obwohl ich das video aufnehme zeigt tomb raider sogar ne höhere GPU auslastung als 0 %. Auch während dem abspielen kein runtertakten. video kompression macht alles die CPU. das ruckeln liegt daran weil ich nur mit 30 fps aufnehme damit es nicht so viel CPU leistung braucht bei der aufnahme. irgendwie lässt bandicam unregelmässig frames weg. denn auf dem bildschirm während ich aufgenommen habe lief es auch flüssig und es war tearing zu sehen weil kein vysnc an.

Und was fehlt noch in deiner Aufführung?

Muss ich jetzt noch mit video kamera aufnehmen damit es nicht ruckelt bevor du endlich merkst die tomb raider gpu auslastung stimmt nicht und CPU ist schnell genug ?

Der GPU Takt und wie weit der Verbrauch der GPU vom Powerlimit entfernt ist da bei Unterforderung der GPU gern mal der Takt gesenkt wird um Strom zu sparen.

siehst du alles in dem AMD GPU overlay im video. GPU Takt und VRAM Takt bleibt hoch. oder willst noch sagen die AMD overlay anzeige stimmt nicht und tombraider ist richtig ?

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.409

- Renomée

- 1.989

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Glückwunsch das du mit dem Video genau das bestätigt hast was ich bereits schrieb.

Mit deaktivierten DX12 Support sind die RT Schatten aus (ausgegraut) und genau daher kommt die Steigerung der Framerate weil die GPU un der hohen Auflösung schon auch ohne RT gut ausgelastet ist, ganz im Gegenteil zu deinen 800 x 600 Tests.

Wie erwartet warst du in deiner Ausführung genau darauf nicht eingegangen und versuchst weiterhin nach dem bekannten Schema etwas zu konstruieren, was erneut die Vermutung nahe legt das du nur trollen willst.

Und jetzt nochmal 2 Bilder mit einem anderen System dessen Vega64 (Referenzdesign, HBCC off) gleich 2 Fehlerquellen weitestgehend ausräumt. Sie besitzt keinen RT Support und die 8 GB VRAM (wurden vor allem im ersten Test ausgiebig genutzt) sind für das Preset "Hoch" selbst in UHD ausreichend, wobei die Framerate dennoch etwas mager ist.

Wie man sieht sind die Unterschiede zwischen DX12 on und off im Endergebnis nur noch gering und der CPU-Renderer (wofür der Wert auch immer stehen mag) hat bei DX12 wie erwartet einen recht deutlichen Vorteil.

Erneut kann man nur sagen das die 6500XT für solch eine Bildeinstellung einfach die falsche Karte ist, erst recht wenn man auch noch mit RT rumspielen will.

Mit deaktivierten DX12 Support sind die RT Schatten aus (ausgegraut) und genau daher kommt die Steigerung der Framerate weil die GPU un der hohen Auflösung schon auch ohne RT gut ausgelastet ist, ganz im Gegenteil zu deinen 800 x 600 Tests.

Wie erwartet warst du in deiner Ausführung genau darauf nicht eingegangen und versuchst weiterhin nach dem bekannten Schema etwas zu konstruieren, was erneut die Vermutung nahe legt das du nur trollen willst.

Doppelposting wurde automatisch zusammengeführt:

Und jetzt nochmal 2 Bilder mit einem anderen System dessen Vega64 (Referenzdesign, HBCC off) gleich 2 Fehlerquellen weitestgehend ausräumt. Sie besitzt keinen RT Support und die 8 GB VRAM (wurden vor allem im ersten Test ausgiebig genutzt) sind für das Preset "Hoch" selbst in UHD ausreichend, wobei die Framerate dennoch etwas mager ist.

Wie man sieht sind die Unterschiede zwischen DX12 on und off im Endergebnis nur noch gering und der CPU-Renderer (wofür der Wert auch immer stehen mag) hat bei DX12 wie erwartet einen recht deutlichen Vorteil.

Erneut kann man nur sagen das die 6500XT für solch eine Bildeinstellung einfach die falsche Karte ist, erst recht wenn man auch noch mit RT rumspielen will.

Zuletzt bearbeitet:

ballererian

Lieutnant

- Mitglied seit

- 07.04.2023

- Beiträge

- 59

- Renomée

- 0

- Details zu meinem Desktop

- Prozessor

- i5 8600

- Mainboard

- asus H310

- Speicher

- 32 GB

- Grafikprozessor

- asus dual RX 6500 XT 4 GB

- Display

- LG 4k display freesync aktiv

- SSD

- 4 TB , 1TB , 512 GB

- HDD

- keine

- Optisches Laufwerk

- keine

- Soundkarte

- focusrite 8i6o

- Netzteil

- 430 watt

- Betriebssystem

- win 10 und win 11 beides auf selben rechner aber auf anderer SSD

Glückwunsch das du mit dem Video genau das bestätigt hast was ich bereits schrieb.

Mit deaktivierten DX12 Support sind die RT Schatten aus (ausgegraut) und genau daher kommt die Steigerung der Framerate weil die GPU un der hohen Auflösung schon auch ohne RT gut ausgelastet ist, ganz im Gegenteil zu deinen 800 x 600 Test

es geht nicht um DX 11 oder DX 12 speedunterschied. Es geht nur um deinen post https://forum.planet3dnow.de/index.php?threads/rx-6500xt-vs-r9-nano.457714/page-3#post-5436642

Na ja, bei 0% GPU gebundenen FPS ist es auch nicht wirklich verwunderlich das die Zuschaltung von RT zu keinem großartigen Geschwindigkeitsverlußt führt. Das Spiel hängt voll im CPU Limit.

und zu dem neuen text

Mit deaktivierten DX12 Support sind die RT Schatten aus (ausgegraut) und genau daher kommt die Steigerung der Framerate weil die GPU un der hohen Auflösung schon auch ohne RT gut ausgelastet ist, ganz im Gegenteil zu deinen 800 x 600 Tests.

tombraider zeigt aber bei DX 11 geringe auslastung der GPU an.

sollte klar sein , dass die tomb raider GPU auslastung falsch anzeigt zumindest für DX11. Dass in DX 11 kein RT geht hab ich schon gleich auf deinen obigen post geschrieben. dass das Spiel nicht im CPU limit hängt sollte nun ausreichend belegt sein.

noch die fakten zu DX 11 zu DX 12 speedunterschied auf RX 6500 XT 4GB. DX 11 einiges schneller (beides ohne RT natürlich) und selbes preset hoch. dass liegt daran, weil DX 11 weniger vram braucht und daher das schlechte vram management weniger ausmacht. ruckeln tut es bei mir nicht. soll ich video mit video kamera hochladen ?. obwohl dx 12 einiges langsamer als DX 11 zeigt DX12 sogar 100% GPU gebunden an. DX 11 0%. wenn du den tomb raider werten glaubst müsste dann DX 11 für dich ein vielfaches schneller sein. ich habe bei beiden tests tombraider neu gestartet und gleich den bench gemacht

Die DX 11 Werte

Ähnliche Themen

- Gesperrt

- Antworten

- 81

- Aufrufe

- 4K

- Antworten

- 15

- Aufrufe

- 707

- Antworten

- 0

- Aufrufe

- 1K