App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

- Foren

- Planet 3DNow! Community

- Planet 3DNow! Distributed Computing

- Team Planet 3DNow!

- Café Planet 3DNow!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

10. Pentathlon 2019 - Einstein@home (Querfeldein)

- Ersteller LordNord

- Erstellt am

LordNord

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 07.09.2005

- Beiträge

- 5.871

- Renomée

- 532

- Standort

- S-H

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3900X

- Mainboard

- ASUS TUF Gaming B550-Plus

- Kühlung

- be quiet! Dark Rock 4

- Speicher

- 2x16GB Crucial DDR4 3200

- Grafikprozessor

- ASUS ROG STRIX Vega 64 GAMING OC

- Display

- AOC Q3279VWFD8

- SSD

- Kingston A2000 1TB + WD Blue SN550 1TB Crucial BX500 2TB + Mega Fastro MS200 2TB Extern

- HDD

- 8TB extern

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 Compact Lite

- Netzteil

- Be quiet! Pure Power 9 600W

- Tastatur

- Corsair K70 MK.2 Low Profile

- Betriebssystem

- Win 10 64Bit

- Webbrowser

- Firefox

- Internetanbindung

-

▼200

▲200

Ja hat sich geklärt, bin jetzt auf unter 20min.

Ich denk mal da soll die iGPU nicht benutzt werden?

in die cc_config:

<ignore_ati_dev>X</ignore_ati_dev>

für nivida anpassen und das X durch die GeräteID (wird von Boinc vergeben) ersetzen.

Ich denk mal da soll die iGPU nicht benutzt werden?

in die cc_config:

<ignore_ati_dev>X</ignore_ati_dev>

für nivida anpassen und das X durch die GeräteID (wird von Boinc vergeben) ersetzen.

Zuletzt bearbeitet:

Onkel_Dithmeyer

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.04.2008

- Beiträge

- 12.947

- Renomée

- 4.022

- Standort

- Zlavti

- Aktuelle Projekte

- Universe@home

- Lieblingsprojekt

- Universe@home

- Meine Systeme

- cd0726792825f6f563c8fc4afd8a10b9

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X @4000 MHz//1,15V

- Mainboard

- MSI X370 XPOWER GAMING TITANIUM

- Kühlung

- Custom Wasserkühlung vom So. G34

- Speicher

- 4x8 GB @ 3000 MHz

- Grafikprozessor

- Radeon R9 Nano

- Display

- HP ZR30W & HP LP3065

- SSD

- 2 TB ADATA

- Optisches Laufwerk

- LG

- Soundkarte

- Im Headset

- Gehäuse

- Xigmatek

- Netzteil

- BeQuiet Dark Pro 9

- Tastatur

- GSkill KM570

- Maus

- GSkill MX780

- Betriebssystem

- Ubuntu 20.04

- Webbrowser

- Firefox Version 94715469

- Internetanbindung

- ▼100 Mbit ▲5 Mbit

Ne, ich hab noch den 18.12 drauf

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.975

- Renomée

- 1.568

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Es werden auf jeden Fall auf der Nano, als auch auf der RX580 jetzt Berechnungen ausgeführt. Ich fass da erstmal nix an

Wenn es dich beruhigt, bei mir sehen RX 580 und 7970 im BM so aus:

Code:

07.05.2019 21:21:42 | | OpenCL: AMD/ATI GPU 0: AMD Radeon R9 200 / HD 7900 Series (driver version 2766.5, device version OpenCL 1.2 AMD-APP (2766.5), 3072MB, 3072MB available, 4096 GFLOPS peak)

07.05.2019 21:21:42 | | OpenCL: AMD/ATI GPU 1: AMD Radeon R9 200 / HD 7900 Series (driver version 2766.5, device version OpenCL 2.0 AMD-APP (2766.5), 4096MB, 4096MB available, 6290 GFLOPS peak)Wobei GPU 1 die 580 ist. Wechsel ich die Karten auf dem Board, habe ich zwei 580 im BM. Passiert mit den Treibern 18.x und 19.x Mit 17.x werden sie zwar korrekt angezeigt, sie behindern sich dann aber gegenseitig. So funktioniert es jedenfalls und das genügt mir

Das Problem hab ich aufm Huawei Matebook auch.

Welcher Treiber? 19.4.1?

Schau mal in den BM Meldungen, ob die gleichen GraKas mehrfach mit verschiedenen Treiberversionen erkannt werden. Hatte ich vor einiger Zeit gehabt. Es waren zwei Treiber gleichzeitig aktiv (allerdings fiel das nur im BM auf). Da half eine Deinstallation und saubere Neuinstallation der Treiber. Oder etwas aufwändiger mit exclude_gpu in der cc_config.

Zuletzt bearbeitet:

cyrusNGC_224

Grand Admiral Special

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Oh ja, dann nur noch mir Fernwartung drauf zugreifenEs werden auf jeden Fall auf der Nano, als auch auf der RX580 jetzt Berechnungen ausgeführt. Ich fass da erstmal nix an

Onkel_Dithmeyer

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.04.2008

- Beiträge

- 12.947

- Renomée

- 4.022

- Standort

- Zlavti

- Aktuelle Projekte

- Universe@home

- Lieblingsprojekt

- Universe@home

- Meine Systeme

- cd0726792825f6f563c8fc4afd8a10b9

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X @4000 MHz//1,15V

- Mainboard

- MSI X370 XPOWER GAMING TITANIUM

- Kühlung

- Custom Wasserkühlung vom So. G34

- Speicher

- 4x8 GB @ 3000 MHz

- Grafikprozessor

- Radeon R9 Nano

- Display

- HP ZR30W & HP LP3065

- SSD

- 2 TB ADATA

- Optisches Laufwerk

- LG

- Soundkarte

- Im Headset

- Gehäuse

- Xigmatek

- Netzteil

- BeQuiet Dark Pro 9

- Tastatur

- GSkill KM570

- Maus

- GSkill MX780

- Betriebssystem

- Ubuntu 20.04

- Webbrowser

- Firefox Version 94715469

- Internetanbindung

- ▼100 Mbit ▲5 Mbit

Wenn es dich beruhigt, bei mir sehen RX 580 und 7970 im BM so aus:

Code:07.05.2019 21:21:42 | | OpenCL: AMD/ATI GPU 0: AMD Radeon R9 200 / HD 7900 Series (driver version 2766.5, device version OpenCL 1.2 AMD-APP (2766.5), 3072MB, 3072MB available, 4096 GFLOPS peak) 07.05.2019 21:21:42 | | OpenCL: AMD/ATI GPU 1: AMD Radeon R9 200 / HD 7900 Series (driver version 2766.5, device version OpenCL 2.0 AMD-APP (2766.5), 4096MB, 4096MB available, 6290 GFLOPS peak)

Wobei GPU 1 die 580 ist. Wechsel ich die Karten auf dem Board, habe ich zwei 580 im BM. Passiert mit den Treibern 18.x und 19.x Mit 17.x werden sie zwar korrekt angezeigt, sie behindern sich dann aber gegenseitig. So funktioniert es jedenfalls und das genügt mir

Code:

07.05.2019 22:45:50 | | OpenCL: AMD/ATI GPU 0: Radeon RX 580 Series (driver version 2766.5, device version OpenCL 2.0 AMD-APP (2766.5), 4096MB, 4096MB available, 8192 GFLOPS peak)

07.05.2019 22:45:50 | | OpenCL: AMD/ATI GPU 1: Radeon RX 580 Series (driver version 2766.5, device version OpenCL 2.0 AMD-APP (2766.5), 4096MB, 4096MB available, 6267 GFLOPS peak)

07.05.2019 22:45:50 | | OpenCL: AMD/ATI GPU 2: Radeon RX 580 Series (driver version 2766.5, device version OpenCL 2.0 AMD-APP (2766.5), 4096MB, 4096MB available, 8192 GFLOPS peak)

07.05.2019 22:45:50 | | OpenCL: AMD/ATI GPU 3: Radeon RX 580 Series (driver version 2766.5, device version OpenCL 2.0 AMD-APP (2766.5), 4096MB, 4096MB available, 6267 GFLOPS peak)Bei mir haben sie sich eben noch verdoppelt ansonsten das gleiche ^^

Die Nano macht 2 WUs in ~15 Minuten, die 580 braucht ~25 Minuten. Laufen aber beide mit -50% weil es sonst auf 5 m² mit Dachschräge hier mit 36 Kernen und drei GPUs doch zu warm wird

denjo

Grand Admiral Special

- Mitglied seit

- 28.12.2005

- Beiträge

- 3.748

- Renomée

- 117

- Standort

- Kellinghusen

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PDM <--- sowas gabs mal :(

- Lieblingsprojekt

- all

- Meine Systeme

- Ryzen 7 1700, 3.60GHz

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X, 4,1Ghz All Core VID 1.13

- Mainboard

- ASUS ROG Strix B550-E Gaming

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- Gskill F4-3600C16-8GTZNC -> 4*8 GB 3733Mhz (16-19-19-19-35)

- Grafikprozessor

- 5700XT Nitro+

- Display

- LG UltraGear 27GL850-B

- SSD

- Samsung 970 NVMe 1 TB

- HDD

- Western Digital Blue 4TB + 500 Samsung

- Optisches Laufwerk

- gehören der Vergangenheit an.

- Soundkarte

- Onboard

- Gehäuse

- bequite! PURE BASE 500

- Netzteil

- Enermax Revolution87+ 550 W GOLD -> Thx p3d

- Betriebssystem

- Windows X

- Webbrowser

- Chrome, Firefox

- Verschiedenes

- MEHR POWER ^^

- Internetanbindung

- ▼600 ▲50

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.760

- Renomée

- 732

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Wenn wir das mal eben 3 Tage zurückhalten könnten, wären das gut 18 Mio.

Aber vermutlich ist es ja nicht nur eine Hand voll Rechner, sondern mehrere kleine Grüppchen von Rechnern bei zig Leuten ?

Effektiv doch nur eine Hand plus ein Finger:

https://einsteinathome.org/account/52796/computers

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.975

- Renomée

- 1.568

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Komischen Kram

Lustig, dass die Nano exakt die doppelten GFLOPS wie die 7970 haben soll. Dafür hat meine 580 stolze 23 mehr als Deine 8)

Lustig, dass die Nano exakt die doppelten GFLOPS wie die 7970 haben soll. Dafür hat meine 580 stolze 23 mehr als Deine 8)

bnoob

Vice Admiral Special

- Mitglied seit

- 02.05.2015

- Beiträge

- 518

- Renomée

- 86

- Standort

- Heidelberg

- Aktuelle Projekte

- Pentathlon 2024

- Lieblingsprojekt

- SETI@Home (rest in peace)

- Meine Systeme

- Ryzen 9 5950X, Radeon 7900XTX

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Lenovo ThinkPad X1 Nano, Intel Core i5-1130G7, 16 GB RAM, 512 GB SSD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X @ Watercool Heatkiller IV

- Mainboard

- ASRock X570M Pro4 @ AnfiTec WaKü

- Kühlung

- Full-Loop-WaKü

- Speicher

- Corsair Vengeance RGB 4x16GB, DDR4-3000, CL16-20-20-38

- Grafikprozessor

- MSI Radeon 6900XT @ WaKü

- Display

- Hisense H43MEC3050, 43"@3840x2160

- SSD

- verschiedene SSDs

- Soundkarte

- Denon AVR-1513 @ HDMI

- Gehäuse

- Fractal Design Define C Mini TG

- Netzteil

- NZXT C850

- Tastatur

- Raptor Gaming K1

- Maus

- Roccat Kone Pure Ultra

- Betriebssystem

- Windows 10 Pro 64-Bit

- Webbrowser

- Mozilla Firefox

- Schau Dir das System auf sysprofile.de an

Bekommt ihr gerade WUs?

LordNord

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 07.09.2005

- Beiträge

- 5.871

- Renomée

- 532

- Standort

- S-H

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3900X

- Mainboard

- ASUS TUF Gaming B550-Plus

- Kühlung

- be quiet! Dark Rock 4

- Speicher

- 2x16GB Crucial DDR4 3200

- Grafikprozessor

- ASUS ROG STRIX Vega 64 GAMING OC

- Display

- AOC Q3279VWFD8

- SSD

- Kingston A2000 1TB + WD Blue SN550 1TB Crucial BX500 2TB + Mega Fastro MS200 2TB Extern

- HDD

- 8TB extern

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 Compact Lite

- Netzteil

- Be quiet! Pure Power 9 600W

- Tastatur

- Corsair K70 MK.2 Low Profile

- Betriebssystem

- Win 10 64Bit

- Webbrowser

- Firefox

- Internetanbindung

-

▼200

▲200

Schotten sind zu...

Schotten sind zu...koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.760

- Renomée

- 732

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Ruhe bewahren, ich ziehe gerade neue WUs (mein Wettbunker ist durch, jetzt kommen frische, die müssen gleich auch für die Vega reichen dann), du bist gleich dran, bitte Nummer ziehen

--- Update ---

521 Einheiten zusätzlich eingelagert (in paralleler BOINC Instanz unter Ubuntu), der Nächste bitte!

--- Update ---

521 Einheiten zusätzlich eingelagert (in paralleler BOINC Instanz unter Ubuntu), der Nächste bitte!

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.975

- Renomée

- 1.568

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Schotten sind zu...

Mit dem Klischee müssen sie schon lange leben

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.760

- Renomée

- 732

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Damit habe ich jetzt 1510 Einsteine (= 5232150 Credit) auf Platte die frühestens am 12.05. (5 CPU Taks), Rest ab 14.05. ablaufen. Ich nehme mir mal fest vor die alle durchzurechnen und dann geschlossen hochzuladen.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.311

- Renomée

- 1.900

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Ich hab angeblich 2800 Stück jetzt. Hoffentlich finde ich die alle wieder, wenn sie fertig sind.

bnoob

Vice Admiral Special

- Mitglied seit

- 02.05.2015

- Beiträge

- 518

- Renomée

- 86

- Standort

- Heidelberg

- Aktuelle Projekte

- Pentathlon 2024

- Lieblingsprojekt

- SETI@Home (rest in peace)

- Meine Systeme

- Ryzen 9 5950X, Radeon 7900XTX

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Lenovo ThinkPad X1 Nano, Intel Core i5-1130G7, 16 GB RAM, 512 GB SSD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X @ Watercool Heatkiller IV

- Mainboard

- ASRock X570M Pro4 @ AnfiTec WaKü

- Kühlung

- Full-Loop-WaKü

- Speicher

- Corsair Vengeance RGB 4x16GB, DDR4-3000, CL16-20-20-38

- Grafikprozessor

- MSI Radeon 6900XT @ WaKü

- Display

- Hisense H43MEC3050, 43"@3840x2160

- SSD

- verschiedene SSDs

- Soundkarte

- Denon AVR-1513 @ HDMI

- Gehäuse

- Fractal Design Define C Mini TG

- Netzteil

- NZXT C850

- Tastatur

- Raptor Gaming K1

- Maus

- Roccat Kone Pure Ultra

- Betriebssystem

- Windows 10 Pro 64-Bit

- Webbrowser

- Mozilla Firefox

- Schau Dir das System auf sysprofile.de an

Ich bekomme keine neuen WUs, gibt es eine Zahl in der Config die ich ändern muss?

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.760

- Renomée

- 732

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Ich habe nur den Cache auf 10 Tage gesetzt, sonst nichts geändert.

In der neu angelegten BOINC Instanz waren die vorraussichtlichen Laufzeiten auch 2-3x zu lang, trotzdem hat er mir reichlich WUs gegeben.

In der neu angelegten BOINC Instanz waren die vorraussichtlichen Laufzeiten auch 2-3x zu lang, trotzdem hat er mir reichlich WUs gegeben.

bnoob

Vice Admiral Special

- Mitglied seit

- 02.05.2015

- Beiträge

- 518

- Renomée

- 86

- Standort

- Heidelberg

- Aktuelle Projekte

- Pentathlon 2024

- Lieblingsprojekt

- SETI@Home (rest in peace)

- Meine Systeme

- Ryzen 9 5950X, Radeon 7900XTX

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Lenovo ThinkPad X1 Nano, Intel Core i5-1130G7, 16 GB RAM, 512 GB SSD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X @ Watercool Heatkiller IV

- Mainboard

- ASRock X570M Pro4 @ AnfiTec WaKü

- Kühlung

- Full-Loop-WaKü

- Speicher

- Corsair Vengeance RGB 4x16GB, DDR4-3000, CL16-20-20-38

- Grafikprozessor

- MSI Radeon 6900XT @ WaKü

- Display

- Hisense H43MEC3050, 43"@3840x2160

- SSD

- verschiedene SSDs

- Soundkarte

- Denon AVR-1513 @ HDMI

- Gehäuse

- Fractal Design Define C Mini TG

- Netzteil

- NZXT C850

- Tastatur

- Raptor Gaming K1

- Maus

- Roccat Kone Pure Ultra

- Betriebssystem

- Windows 10 Pro 64-Bit

- Webbrowser

- Mozilla Firefox

- Schau Dir das System auf sysprofile.de an

Log sagt

Hab in der cc mal die max_xfers hochgeschraubt, hilft nichts

--- Update ---

Upload ist auf 0.01 wegen der militärischen Befestigungsanlagen

08-May-2019 00:46:43 [Einstein@Home] Sending scheduler request: Requested by user.

08-May-2019 00:46:43 [Einstein@Home] Not requesting tasks: too many uploads in progress

08-May-2019 00:46:44 [Einstein@Home] Scheduler request completed

Hab in der cc mal die max_xfers hochgeschraubt, hilft nichts

--- Update ---

Upload ist auf 0.01 wegen der militärischen Befestigungsanlagen

Mit dem Klischee müssen sie schon lange leben

BTT: das mit der zweiten (und dritten, und vierten) BOINC-Instanz funktioniert wirklich gut

Gerade für GPU-Projekte, wo man nicht mit VMs hantieren kann, ist das sehr praktisch. Man darf nur nicht durcheinander kommen

Gerade für GPU-Projekte, wo man nicht mit VMs hantieren kann, ist das sehr praktisch. Man darf nur nicht durcheinander kommen

Ich bekomme keine neuen WUs, gibt es eine Zahl in der Config die ich ändern muss?

Vielleicht ist Dir das gleiche passiert wie mir mit der neuen Instanz unter Einstein?

https://www.planet3dnow.de/vbulleti...-Querfeldein?p=5238340&viewfull=1#post5238340

Schau mal auf der Projektseite, ob die neue Instanz im gleichen Profil (Work, Home, Generic, etc.) gelandet ist wie die bisherige!

Edit: ah, jüngeren Post nicht gesehen

Dann ist das Problem ja erkannt. Aber ganz Themaverfehlung war mein Beitrag auch nicht, denn hier könntest Du mit einer zweiten Instanz bunkern. Aber VOOOORSICHT, nix kaputtmachen am bestehenden Bunker

Dann ist das Problem ja erkannt. Aber ganz Themaverfehlung war mein Beitrag auch nicht, denn hier könntest Du mit einer zweiten Instanz bunkern. Aber VOOOORSICHT, nix kaputtmachen am bestehenden Bunker

Zuletzt bearbeitet:

ICEMAN

Grand Admiral Special

- Mitglied seit

- 17.10.2000

- Beiträge

- 9.643

- Renomée

- 241

- Mitglied der Planet 3DNow! Kavallerie!

- Meine Systeme

- AMD Ryzen 3 2200G

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- HP 255 G8

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 5600G

- Mainboard

- MSI B450 Gaming Plus

- Kühlung

- Noctua NH-U9F

- Speicher

- Corsair Vengeance LPX 16GB DDR4 3000MHz C16

- Grafikprozessor

- AMD Radeon Vega 8

- Display

- 27" BenQ EW277HDR, 24" Samsung S24F350

- SSD

- Samsung 860 250GB, 2x 256GB Micron 1100

- HDD

- 1TB Samsung HD103SJ

- Optisches Laufwerk

- DVD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- FRACTAL DESIGN DEFINE XL Titanium

- Netzteil

- Enermax PRO82+ II 425W 80PLUS® Bronze

- Betriebssystem

- Windows 10 64bit Prof.

- Webbrowser

- Chrome

- Internetanbindung

-

▼250

▲50

Ich habe meine Intel GPU alle schon durch und mein GT730 läßt das System ganz schön ruckeln. Gibt es eine Einstellung das vielleicht nicht die ganze Leistung für Boinc drauf geht und er einfach länger braucht?

erde-m

Grand Admiral Special

- Mitglied seit

- 23.03.2002

- Beiträge

- 3.275

- Renomée

- 454

- Standort

- TF

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- LHC

- Meine Systeme

- AMD Ryzen9 5950X+64 GB DDR3600+RX6900XT, AMD Epyc 7V12+256 GB ECC DDR3200+R VII, AMD Ryzen 5 2500U

- BOINC-Statistiken

- Mein Laptop

- HP Envy x360 15-bq102ng Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen9 5950X

- Mainboard

- Asus Prime X470-Pro

- Kühlung

- be quiet Silent Loop 280mm

- Speicher

- 64GB (4x16GB) G.Skill TridentZ Neo F4-3600C16-64GTZNC Quad Kit

- Grafikprozessor

- AMD Radeon RX 6900XT

- Display

- Acer Pro Designer PE320QK

- SSD

- M2:Samsung 990Pro 2TB + 970Evo Plus 1TB

- HDD

- WDC WD100EFAX

- Soundkarte

- Onboard

- Gehäuse

- Fractal Define 7 Clear Tempered Glass White

- Netzteil

- bequiet Dark Power 12 1000W

- Tastatur

- Logitech G815

- Maus

- Logitech G402

- Betriebssystem

- Linux Mint 21.2; Win11Pro-64Bit

- Webbrowser

- Firefox

- Verschiedenes

- Qnap Single-port Aquantia AQC107 10GbE

- Internetanbindung

- ▼225 MBit ▲45 MBit

Mmhh, meine Vega56 hatte im Standard immer 4 WU in Arbeit. Musste sie per Appconfig zu 2 WU zwingen, weil bei 4 WU schnell mal eine hängen blieb, sobald etwas Grafiklast parallel kam.

<app_config>

<app>

<name>hsgamma_FGRPB1G</name>

<gpu_versions>

<gpu_usage>1</gpu_usage>

<cpu_usage>1</cpu_usage>

</gpu_versions>

</app>

</app_config>

<app_config>

<app>

<name>hsgamma_FGRPB1G</name>

<gpu_versions>

<gpu_usage>1</gpu_usage>

<cpu_usage>1</cpu_usage>

</gpu_versions>

</app>

</app_config>

Mist, bei einem System mit Radeon RX 580 hab ich mich per RDP eingeloggt. Nu rechnete die GPU nicht mehr  Muss heute Nacht mal versuchen, das System neu zu starten und mich mit einem anderen Fernwartungstool einzuloggen. Windows-Maschine aus der Ferne neu starten *brrrrrr* Hoffentlich geht da nichts schief.

Muss heute Nacht mal versuchen, das System neu zu starten und mich mit einem anderen Fernwartungstool einzuloggen. Windows-Maschine aus der Ferne neu starten *brrrrrr* Hoffentlich geht da nichts schief.

Muss heute Nacht mal versuchen, das System neu zu starten und mich mit einem anderen Fernwartungstool einzuloggen. Windows-Maschine aus der Ferne neu starten *brrrrrr* Hoffentlich geht da nichts schief.

Muss heute Nacht mal versuchen, das System neu zu starten und mich mit einem anderen Fernwartungstool einzuloggen. Windows-Maschine aus der Ferne neu starten *brrrrrr* Hoffentlich geht da nichts schief.

ICEMAN

Grand Admiral Special

- Mitglied seit

- 17.10.2000

- Beiträge

- 9.643

- Renomée

- 241

- Mitglied der Planet 3DNow! Kavallerie!

- Meine Systeme

- AMD Ryzen 3 2200G

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- HP 255 G8

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 5600G

- Mainboard

- MSI B450 Gaming Plus

- Kühlung

- Noctua NH-U9F

- Speicher

- Corsair Vengeance LPX 16GB DDR4 3000MHz C16

- Grafikprozessor

- AMD Radeon Vega 8

- Display

- 27" BenQ EW277HDR, 24" Samsung S24F350

- SSD

- Samsung 860 250GB, 2x 256GB Micron 1100

- HDD

- 1TB Samsung HD103SJ

- Optisches Laufwerk

- DVD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- FRACTAL DESIGN DEFINE XL Titanium

- Netzteil

- Enermax PRO82+ II 425W 80PLUS® Bronze

- Betriebssystem

- Windows 10 64bit Prof.

- Webbrowser

- Chrome

- Internetanbindung

-

▼250

▲50

Mit Teamviewer geht das eigentlich sehr gut.

LordNord

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 07.09.2005

- Beiträge

- 5.871

- Renomée

- 532

- Standort

- S-H

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3900X

- Mainboard

- ASUS TUF Gaming B550-Plus

- Kühlung

- be quiet! Dark Rock 4

- Speicher

- 2x16GB Crucial DDR4 3200

- Grafikprozessor

- ASUS ROG STRIX Vega 64 GAMING OC

- Display

- AOC Q3279VWFD8

- SSD

- Kingston A2000 1TB + WD Blue SN550 1TB Crucial BX500 2TB + Mega Fastro MS200 2TB Extern

- HDD

- 8TB extern

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 Compact Lite

- Netzteil

- Be quiet! Pure Power 9 600W

- Tastatur

- Corsair K70 MK.2 Low Profile

- Betriebssystem

- Win 10 64Bit

- Webbrowser

- Firefox

- Internetanbindung

-

▼200

▲200

Hat auch seine Aussetzer... nichts ist perfekt.

denjo

Grand Admiral Special

- Mitglied seit

- 28.12.2005

- Beiträge

- 3.748

- Renomée

- 117

- Standort

- Kellinghusen

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- PDM <--- sowas gabs mal :(

- Lieblingsprojekt

- all

- Meine Systeme

- Ryzen 7 1700, 3.60GHz

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X, 4,1Ghz All Core VID 1.13

- Mainboard

- ASUS ROG Strix B550-E Gaming

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- Gskill F4-3600C16-8GTZNC -> 4*8 GB 3733Mhz (16-19-19-19-35)

- Grafikprozessor

- 5700XT Nitro+

- Display

- LG UltraGear 27GL850-B

- SSD

- Samsung 970 NVMe 1 TB

- HDD

- Western Digital Blue 4TB + 500 Samsung

- Optisches Laufwerk

- gehören der Vergangenheit an.

- Soundkarte

- Onboard

- Gehäuse

- bequite! PURE BASE 500

- Netzteil

- Enermax Revolution87+ 550 W GOLD -> Thx p3d

- Betriebssystem

- Windows X

- Webbrowser

- Chrome, Firefox

- Verschiedenes

- MEHR POWER ^^

- Internetanbindung

- ▼600 ▲50

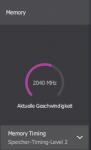

Oo ich glaub das mit dem level 2 vram timings im treiber hat tatsächlich performance gebracht oO 10-20 sec pro wu

Ähnliche Themen

- Antworten

- 73

- Aufrufe

- 4K

- Antworten

- 308

- Aufrufe

- 17K

- Antworten

- 49

- Aufrufe

- 3K

- Antworten

- 342

- Aufrufe

- 19K