App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

AMD GCN4 (Polaris, Radeon 400/500) & GCN5 (Vega)

- Ersteller BoMbY

- Erstellt am

Unbekannter Krieger

Grand Admiral Special

- Mitglied seit

- 04.10.2013

- Beiträge

- 4.455

- Renomée

- 66

- Mein Laptop

- HP 15-bq102ng (sackteuer u. ab Werk instabil)

- Details zu meinem Desktop

- Prozessor

- FX-8320E@4,2 GHz & 2,6 GHz Northbridge (jeweils mit UV)

- Mainboard

- Asus M5A99X Evo R2.0 (eher enttäuschend ggü. ASRock E3)

- Kühlung

- Raijintek Nemesis (Lüfter mittig im sowie hinter dem Kühler; erstklassig)

- Speicher

- 4x4 GiB Hynix DDR3-1866 ECC

- Grafikprozessor

- XFX RX 570 8G (P8DFD6)@1180 & 2150 MHz@starkem, fortdauerndem UV | ASRock RX 570 8G@das Gleiche

- Display

- BenQ XL2411T ~ nach 3 RMAs und 6 Monaten wieder brauchbar

- SSD

- Crucial MX100 256 GB (ein Glückskauf) | SanDisk Ultra Plus 256 GB (ein Glückskauf)

- HDD

- WD20EZRZ u. a. (Seagate, Hitachi, WD)

- Optisches Laufwerk

- TSST SH-222AL

- Gehäuse

- Corsair Carbide 300R (ein Fehlkauf)

- Netzteil

- CoolerMaster V450S (ein Glückskauf)

- Betriebssystem

- Win8.x x64, Win7 x64

- Webbrowser

- welche mit minimalem Marktanteil & sinnvollen Konzepten (nicht Chrome-Seuche und Sieche-Fuchs)

- Verschiedenes

- frühere GPUs: , Asus RX 480 O8G@580 O8G, VTX3D 7850 1G

bschicht86 schrieb:Wenn da was dran ist, dann war Lisa's damalige Bemerkung "Overclockers Dream" zur Fury wohl ein wenig fehlplatziert.

Mich interessiert immer noch, ob konkret über Fury X oder Fury oder allgemein über Fiji als Chip gesprochen wurde.IT-Extremist schrieb:Diese Aussage ist nicht von ihr gekommen!

cyrusNGC_224

Grand Admiral Special

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Also wenn die zu den Preisen kommen und die Erwartungen erfüllen, dann gibt es doch überhaupt keinen Grund mehr, zur Konkurrenz zu greifen!?!Falls das dann die endgültigen Preise sind, können die sich durchaus sehen lassen.

Das wäre ja so der Hammer.

Ob die sich damit zukünftige Generationen versperren?

mariahellwig

Grand Admiral Special

Wenn Apple wirklich bald beim iMac auf 8K gehen will, dann reicht da eine Intel-APU ohne dGPU nicht mehr aus.

Apple integriert auch eine GPU in die Cinema-Displays, dafür wäre P11 auch ideal.

Apple ist für AMD gut für das Prestige, wahrscheinlich auch finanziell attraktiv, aber strategisch ein unbedeutender Markt. Apple ist keine Spieleplattform, und auch keine VR-Plattform.

Man kann dort keinerlei Kompetenzen aufbauen und damit anderen Kunden nachziehen.

bei dem verlinkten händler handelt es sich um die aufpreise gegenüber einer basiskonfiguration mit geforce gt 730.79 Euro für 'ne RX 460? Hammer wenn das so kommt. Mehr brauche ich gar nicht. Wobei 'ne Version mit 4 GB nett wäre. Die RX 470 schaut aber auch ziemlich verlockend aus.

Marodeur3D

Cadet

- Mitglied seit

- 15.11.2012

- Beiträge

- 8

- Renomée

- 1

Was man von diesen Preisen zu halten hat, sieht man sehr gut bei den beiden EVGA 1080 Karten, die eine (EVGA GeForce GTX 1080 Gaming ACX 3.0 mit 719€ zu 729€) ist unter dem bei Geizhals geführten Preis, die zweite (EVGA GeForce GTX 1080 FTW Gaming ACX 3.0 mit 845€ zu 769€) deutlich darüber. Ich würde sagen, die dort angegebenen Preise geben eine grobe Richtung vor, mehr nicht. Und wenn ich mir die übrigen Preise so anschaue, habe ich den Verdacht, die rechnen die GT 730 nicht aus dem Endpreis raus

LehmannSaW

Vice Admiral Special

- Mitglied seit

- 21.09.2007

- Beiträge

- 597

- Renomée

- 36

- Standort

- poloidal cell 5 im 3. grid block

- Mein Laptop

- HP ENVY x360 15 Dark Ash Silver mit Ryzen 5 2500U

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 1800X

- Mainboard

- ASRock X370 Taichi

- Kühlung

- NZXT Kraken X61

- Speicher

- 16GB G.Skill Trident Z DDR4-3200 @ 3200Mhz

- Grafikprozessor

- Sapphire Radeon R9 Nano

- Display

- Acer Predator XR341CK 34-Zoll mit FreeSync

- SSD

- 250GB Samsung SSD 960 EVO M.2 + 256GB Samsung SSD 840 Pro SSD + 525GB Crucial MX300

- HDD

- 4TB Seagate Desktop SSHD

- Optisches Laufwerk

- keines

- Soundkarte

- on-Board

- Gehäuse

- NZXT S340 ELITE weiß

- Netzteil

- be quiet Straight Power 10 CM 800W

- Betriebssystem

- Windows 10 Pro 64

- Webbrowser

- Mozilla Firefox / IE

"Sap Radeon Rx 480 8gb - Ddr5 Hdmi/Triple Dp (Uefi) 21260-00-20G" = $286.00 + Free Shipping

Weiß leider nur nicht, ob das ein Großhändler ist oder nicht.

Könnte also mit um die 250 € für die 8GB Version klappen

Gruß Lehmann

Weiß leider nur nicht, ob das ein Großhändler ist oder nicht.

Könnte also mit um die 250 € für die 8GB Version klappen

Gruß Lehmann

OBrian

Moderation MBDB, ,

- Mitglied seit

- 16.10.2000

- Beiträge

- 17.032

- Renomée

- 267

- Standort

- NRW

- Details zu meinem Desktop

- Prozessor

- Phenom II X4 940 BE, C2-Stepping (undervolted)

- Mainboard

- Gigabyte GA-MA69G-S3H (BIOS F7)

- Kühlung

- Noctua NH-U12F

- Speicher

- 4 GB DDR2-800 ADATA/OCZ

- Grafikprozessor

- Radeon HD 5850

- Display

- NEC MultiSync 24WMGX³

- SSD

- Samsung 840 Evo 256 GB

- HDD

- WD Caviar Green 2 TB (WD20EARX)

- Optisches Laufwerk

- Samsung SH-S183L

- Soundkarte

- Creative X-Fi EM mit YouP-PAX-Treibern, Headset: Sennheiser PC350

- Gehäuse

- Coolermaster Stacker, 120mm-Lüfter ersetzt durch Scythe S-Flex, zusätzliche Staubfilter

- Netzteil

- BeQuiet 500W PCGH-Edition

- Betriebssystem

- Windows 7 x64

- Webbrowser

- Firefox

- Verschiedenes

- Tastatur: Zowie Celeritas Caseking-Mod (weiße Tasten)

Naja warum nicht, man kann ja schon mal überlegen, wieviel man aus dem Sparschwein abzweigen muß

Die Preise werden von der Lieferbarkeit abhängen. Attraktiv werden die Karten sicherlich, aber wenn die Liefersituation ziemlich eng ist, dann werden auch Händler mit höheren Preisen ihre Karten los (und sind dann die einzigen mit ner grünen Lampe bei Geizhals). Das sind dann schnell mal 30€ mehr. Aber da dann die ganze Strategie von AMD nicht aufginge (also das Gewinnen von Marktanteilen, indem man den ganzen Markt mit unterpreisigen Karten flutet, bevor Nvidia mit dem GP106 kommt), denke ich schon, daß die Produktion auf Hochtouren läuft und sie so viele Waferstarts gemacht haben wie nur irgend möglich. Angst vor Überproduktion gibt es sicher nicht, denn die Chips werden ja mehrere Jahre lang angeboten werden.

Wenn sie jedenfalls die Listenpreise so in den Handel übertragen können wie gewünscht, dann käme die 8-GB-Version wahrscheinlich bei so 270 € raus (starke OC-Versionen mit aufwendigem Kühler usw. wohl Richtung 300 oder drüber), die 4GB mit 220-230 € und dann wahrscheinlich die 470 mit so 180 €.

Die Preise werden von der Lieferbarkeit abhängen. Attraktiv werden die Karten sicherlich, aber wenn die Liefersituation ziemlich eng ist, dann werden auch Händler mit höheren Preisen ihre Karten los (und sind dann die einzigen mit ner grünen Lampe bei Geizhals). Das sind dann schnell mal 30€ mehr. Aber da dann die ganze Strategie von AMD nicht aufginge (also das Gewinnen von Marktanteilen, indem man den ganzen Markt mit unterpreisigen Karten flutet, bevor Nvidia mit dem GP106 kommt), denke ich schon, daß die Produktion auf Hochtouren läuft und sie so viele Waferstarts gemacht haben wie nur irgend möglich. Angst vor Überproduktion gibt es sicher nicht, denn die Chips werden ja mehrere Jahre lang angeboten werden.

Wenn sie jedenfalls die Listenpreise so in den Handel übertragen können wie gewünscht, dann käme die 8-GB-Version wahrscheinlich bei so 270 € raus (starke OC-Versionen mit aufwendigem Kühler usw. wohl Richtung 300 oder drüber), die 4GB mit 220-230 € und dann wahrscheinlich die 470 mit so 180 €.

gruffi

Grand Admiral Special

- Mitglied seit

- 08.03.2008

- Beiträge

- 5.393

- Renomée

- 65

- Standort

- vorhanden

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 5 1600

- Mainboard

- MSI B350M PRO-VDH

- Kühlung

- Wraith Spire

- Speicher

- 2x 8 GB DDR4-2400 CL16

- Grafikprozessor

- XFX Radeon R7 260X

- Display

- LG W2361

- SSD

- Crucial CT250BX100SSD1

- HDD

- Toshiba DT01ACA200

- Optisches Laufwerk

- LG Blu-Ray-Brenner BH16NS40

- Soundkarte

- Realtek HD Audio

- Gehäuse

- Sharkoon MA-I1000

- Netzteil

- be quiet! Pure Power 9 350W

- Betriebssystem

- Windows 10 Professional 64-bit

- Webbrowser

- Mozilla Firefox

- Verschiedenes

- https://valid.x86.fr/mb4f0j

Du meinst es könnte noch preiswerter werden?bei dem verlinkten händler handelt es sich um die aufpreise gegenüber einer basiskonfiguration mit geforce gt 730.

Atombossler

Admiral Special

- Mitglied seit

- 28.04.2013

- Beiträge

- 1.425

- Renomée

- 65

- Standort

- Andere Sphären

- Mein Laptop

- Thinkpad 8

- Details zu meinem Desktop

- Prozessor

- A8-7600@3.25Ghz

- Mainboard

- Asus A88X-PRO

- Kühlung

- NoFan CR80 EH

- Speicher

- 16Gb G-Skill Trident-X DDR3 2400

- Grafikprozessor

- APU

- Display

- Acer UHD 4K2K

- SSD

- Samsung 850 PRO

- HDD

- 2xSamsung 1TB HDD (2,5")

- Optisches Laufwerk

- Plexi BD-RW

- Soundkarte

- OnBoard Geraffel

- Gehäuse

- Define R2

- Netzteil

- BeQuiet

- Betriebssystem

- Win7x64-PRO

- Webbrowser

- Chrome

Stefan Payne

Grand Admiral Special

Was man von diesen Preisen zu halten hat, sieht man sehr gut bei den beiden EVGA 1080 Karten, die eine (EVGA GeForce GTX 1080 Gaming ACX 3.0 mit 719€ zu 729€) ist unter dem bei Geizhals geführten Preis, die zweite (EVGA GeForce GTX 1080 FTW Gaming ACX 3.0 mit 845€ zu 769€) deutlich darüber. Ich würde sagen, die dort angegebenen Preise geben eine grobe Richtung vor, mehr nicht.

Noch einmal:

DAS ist nicht vergleichbar, da die von dir genannte Karte gar nicht lieferbar ist!

Daher gönnen sich die Händler einen Verfügbarkeits-Bonus!

Das können sie sich aber eben nur deswegen leisten, weil sie von den Herstellern keine Karten bekommen.

Das wird, nach unseren bisherigen Informationen nach, nicht mit den AMD Karten passieren, da die breit verfügbar und kaufbar sein werden.

nVidia ist also deutlich hintendran, versucht(e) das ganze aber mit einer Pro Forma Vorstellung, ohne absehbare Lieferbarkeit (bzw mit Mondpreisen) zu überdecken, um auch ja als erster zu gelten, auch wenn das eben NICHT der Fall ist...

SPINA

Grand Admiral Special

- Mitglied seit

- 07.12.2003

- Beiträge

- 18.122

- Renomée

- 985

- Mein Laptop

- Lenovo IdeaPad Gaming 3 (15ARH05-82EY003NGE)

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- ASUS PRIME X370-PRO

- Kühlung

- AMD Wraith Prism

- Speicher

- 2x Micron 32GB PC4-25600E (MTA18ASF4G72AZ-3G2R)

- Grafikprozessor

- Sapphire Pulse Radeon RX 7600 8GB

- Display

- LG Electronics 27UD58P-B

- SSD

- Samsung 980 PRO (MZ-V8P1T0CW)

- HDD

- 2x Samsung 870 QVO (MZ-77Q2T0BW)

- Optisches Laufwerk

- HL Data Storage BH16NS55

- Gehäuse

- Lian Li PC-7NB

- Netzteil

- Seasonic PRIME Gold 650W

- Betriebssystem

- Debian 12.x (x86-64)

- Verschiedenes

- ASUS TPM-M R2.0

nVidia scheint die Referenzkarten lieber selbst und unter eigenem Namen verkaufen zu wollen.[3DC]Payne;5099268 schrieb:Das können sie sich aber eben nur deswegen leisten, weil sie von den Herstellern keine Karten bekommen.

Im hauseigenen Onlineshop haben die GeForce GTX 1080 und 1070 eine ununterbrochene Verfügbarkeit seit Anbeginn: Link

bschicht86

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 14.12.2006

- Beiträge

- 4.249

- Renomée

- 228

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- 2950X

- Mainboard

- X399 Taichi

- Kühlung

- Heatkiller IV Pure Chopper

- Speicher

- 64GB 3466 CL16

- Grafikprozessor

- 2x Vega 64 @Heatkiller

- Display

- Asus VG248QE

- SSD

- PM981, SM951, ein paar MX500 (~5,3TB)

- HDD

- -

- Optisches Laufwerk

- 1x BH16NS55 mit UHD-BD-Mod

- Soundkarte

- Audigy X-Fi Titanium Fatal1ty Pro

- Gehäuse

- Chieftec

- Netzteil

- Antec HCP-850 Platinum

- Betriebssystem

- Win7 x64, Win10 x64

- Webbrowser

- Firefox

- Verschiedenes

- LS120 mit umgebastelten USB -> IDE (Format wie die gängigen SATA -> IDE)

Scheinen ja immer mehr ihr Eigen Ding zu machen. Erst Software nun auch Hardware. Mittlerweile sind ja die Softwareschmieden nicht mehr ganz so begeistert. Ob die OEM's auch bald auf die Barrikaden gehen?

BavarianRealist

Grand Admiral Special

- Mitglied seit

- 06.02.2010

- Beiträge

- 3.358

- Renomée

- 80

Aus wccftech:

Die Strategie von AMD mit Polaris gefällt mir immer besser; damit werden quasi 3 Fliegen mit einer Klappe geschlagen:

1) man hat eine neue Architektur und einen neunen Prozess auf einmal => statt alles von Anfang an perfekt zu machen und dadurch Zeit zu verlieren, reizt man weder das neue Design noch den Prozess aus und geht mit sehr vorsichtigem Binning in den Markt um von Anfang an reichlich Produkte zu haben. UND wenn AMD anfangs erst mal auf viel Takt verzichtet, dann haben die womöglich auch auf einige CUs verzichtet, weil das genau den gleichen Effekt hat => maximales Yield, möglichst jedes Die verwendbar machen (die Größe des Dies deutet drauf hin, dass da weit mehr als 36CU drin sind.).

2) Mit dem großebn Overclocking-Potenzial + den neuen Overclocking-Tool spricht AMD die Freaks aktiv an. Und diese Freaks dürften aktuell vor allem Nvidia-Kunden sein. Wenn jetzt AMD hier deutlich mehr ermöglicht als Nvidia, dann könnte so mancher von denen erst mal vom Kauf einer teuren 1070/1080 abgehalten werden, zumal ja Vega noch aussteht und in Polaris-10 am Ende gar noch geheime CUs schlummern könnten, die am Ende auch noch frei geschaltet werden könnten...

3) AMD mit Polaris sehr aggressive in den Markt geht, soldass es für Nvidia hier im Mainstream keine Traum-Margen mehr geben wird, und zwar von Anfang an mit den GP106. Damit macht AMD womöglich eines Nvidia ganz klar: wenn Nvidia den Mainstream-Markt ebenfalls mit Kampfpreisen verteidigen will, könnte AMD den kommenden Vega ebenfalls so pricen, dass die Preise der 1070/80 in den Keller fallen. Am Ende würde keiner von beiden mit den GPUs mehr Geld machen. Aber nur AMD hat auch CPUs/APUs bzw. das Konsolen-Geschäft. Für Nvidia wäre ein Preiskampf im GPU-Geschäft ungleich schädlicher. => Ziel: man teilt sich die Märkte: AMD hält den Vega so lange aus dem Markt, solange AMD im Mainstrem Geld abschöpfen kann.

--- Update ---

Und hier noch eine Überlegung:

- sollten im Polaris-10 später (nach einer kleinen Optimierung des Dies) +15% Takt von Anfang an drin sein und

- sollten dann auch noch 40 CUs laufen

=> wären das mehr als +25% an Performance und vermutlich GTX1070-Leistung.

===> und dann bräuchte Vega nicht so viel mehr, um auch GTX1080 zu überholen und gar in GP102-Region vorzustoßen.

AMD dürfte den Vega mindestens bis nach Prästentation von Nvidias GP102-Designs geheim halten.

"AMD RX 480 Can Hit 1.5Ghz+, New Overclocking Tool With Voltage Control Coming...

Die Strategie von AMD mit Polaris gefällt mir immer besser; damit werden quasi 3 Fliegen mit einer Klappe geschlagen:

1) man hat eine neue Architektur und einen neunen Prozess auf einmal => statt alles von Anfang an perfekt zu machen und dadurch Zeit zu verlieren, reizt man weder das neue Design noch den Prozess aus und geht mit sehr vorsichtigem Binning in den Markt um von Anfang an reichlich Produkte zu haben. UND wenn AMD anfangs erst mal auf viel Takt verzichtet, dann haben die womöglich auch auf einige CUs verzichtet, weil das genau den gleichen Effekt hat => maximales Yield, möglichst jedes Die verwendbar machen (die Größe des Dies deutet drauf hin, dass da weit mehr als 36CU drin sind.).

2) Mit dem großebn Overclocking-Potenzial + den neuen Overclocking-Tool spricht AMD die Freaks aktiv an. Und diese Freaks dürften aktuell vor allem Nvidia-Kunden sein. Wenn jetzt AMD hier deutlich mehr ermöglicht als Nvidia, dann könnte so mancher von denen erst mal vom Kauf einer teuren 1070/1080 abgehalten werden, zumal ja Vega noch aussteht und in Polaris-10 am Ende gar noch geheime CUs schlummern könnten, die am Ende auch noch frei geschaltet werden könnten...

3) AMD mit Polaris sehr aggressive in den Markt geht, soldass es für Nvidia hier im Mainstream keine Traum-Margen mehr geben wird, und zwar von Anfang an mit den GP106. Damit macht AMD womöglich eines Nvidia ganz klar: wenn Nvidia den Mainstream-Markt ebenfalls mit Kampfpreisen verteidigen will, könnte AMD den kommenden Vega ebenfalls so pricen, dass die Preise der 1070/80 in den Keller fallen. Am Ende würde keiner von beiden mit den GPUs mehr Geld machen. Aber nur AMD hat auch CPUs/APUs bzw. das Konsolen-Geschäft. Für Nvidia wäre ein Preiskampf im GPU-Geschäft ungleich schädlicher. => Ziel: man teilt sich die Märkte: AMD hält den Vega so lange aus dem Markt, solange AMD im Mainstrem Geld abschöpfen kann.

--- Update ---

Und hier noch eine Überlegung:

- sollten im Polaris-10 später (nach einer kleinen Optimierung des Dies) +15% Takt von Anfang an drin sein und

- sollten dann auch noch 40 CUs laufen

=> wären das mehr als +25% an Performance und vermutlich GTX1070-Leistung.

===> und dann bräuchte Vega nicht so viel mehr, um auch GTX1080 zu überholen und gar in GP102-Region vorzustoßen.

AMD dürfte den Vega mindestens bis nach Prästentation von Nvidias GP102-Designs geheim halten.

Solidus

Lt. Commander

- Mitglied seit

- 04.05.2014

- Beiträge

- 130

- Renomée

- 2

Aus wccftech: http://wccftech.com/amd-rx-480-1500mhz-overclocking-tool-voltage-control/

Für Nvidia wäre ein Preiskampf im GPU-Geschäft ungleich schädlicher. => Ziel: man teilt sich die Märkte: AMD hält den Vega so lange aus dem Markt, solange AMD im Mainstrem Geld abschöpfen kann.

Ähem...

Nvidia dürfte in die Entwicklung von GPUs doppelt so viel investieren wie AMD. Dass Nvidia jetzt plözlich nackt da steht, kann ich mir nur sehr schwer vorstellen.

hoschi_tux

Grand Admiral Special

- Mitglied seit

- 08.03.2007

- Beiträge

- 4.761

- Renomée

- 286

- Standort

- Ilmenau

- Aktuelle Projekte

- Einstein@Home, Predictor@Home, QMC@Home, Rectilinear Crossing No., Seti@Home, Simap, Spinhenge, POEM

- Lieblingsprojekt

- Seti/Spinhenge

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen R9 5900X

- Mainboard

- ASUS TUF B450m Pro-Gaming

- Kühlung

- Noctua NH-U12P

- Speicher

- 2x 16GB Crucial Ballistix Sport LT DDR4-3200, CL16-18-18

- Grafikprozessor

- AMD Radeon RX 6900XT (Ref)

- Display

- LG W2600HP, 26", 1920x1200

- HDD

- Crucial M550 128GB, Crucial M550 512GB, Crucial MX500 2TB, WD7500BPKT

- Soundkarte

- onboard

- Gehäuse

- Cooler Master Silencio 352M

- Netzteil

- Antec TruePower Classic 550W

- Betriebssystem

- Gentoo 64Bit, Win 7 64Bit

- Webbrowser

- Firefox

Ich frage mich wo nVidia doppelt so viel investiert. In Pascal sicher nicht (Cache vergrößern und Takt bis ans Limit treiben ins kein Aufwand)..

AMD hingegen entwickelt GCN systematisch weiter und ist dabei wegweisend.

AMD hingegen entwickelt GCN systematisch weiter und ist dabei wegweisend.

Ähem...

Nvidia dürfte in die Entwicklung von GPUs doppelt so viel investieren wie AMD. Dass Nvidia jetzt plözlich nackt da steht, kann ich mir nur sehr schwer vorstellen.

Dann muß NV auch doppelt so viel verdienen. Und sowas können bestimmt auch andere bauen.

Stefan Payne

Grand Admiral Special

Wo hast du die Infos hierüber her?Ähem...

Nvidia dürfte in die Entwicklung von GPUs doppelt so viel investieren wie AMD. Dass Nvidia jetzt plözlich nackt da steht, kann ich mir nur sehr schwer vorstellen.

Ganz ab davon ist die Aussage aber mehr als korrekt!

NVidia hat in den letzten Jahren bzw mit der letzten Generation und Gameworks einiges an Vertrauen verspielt. Auch die Sache mit dem optimiertem Pressetreiber, der einige Details bei AOTS nicht (korrekt) rendert, kommt noch dazu...

Und jetzt kommt AMD und nimmt nVidia einfach so mal den kompletten Mainstream Markt, zeigt den Leuten ganz deutlich, dass das, was nVidia hier verlangt, Wucherpreise sind...

Und wenn der Midrange Markt wegfällt und nVidia einiges an Marktanteilen verliert, schaut es für sie ganz doof aus, da sie eben KEIN zweites Standbein haben.

Tegra ist ein ziemlicher FLOP und keiner will das wirklich. Auch schauts so aus, als ob nVidia einiges an Vertrauen mit den Herstellern und ev. auch OEMs verspielt hat, so dass es durchaus möglich ist, dass eigentlich niemand mehr wirklich Lust auf den Verein hat...

Ergo habens 2 Möglichkeiten:

a) Jenssen absägen und Unternehmenspolitik drastisch ändern

b) gnadenlos untergehen...

Dank der Pressearbeit von AMD ist Gameworks ja glücklicherweise gescheitert, auch verweigert sich nVidia den offenen Standards und trägt sogar offene Standards aus den Standardisierungsgremien, um das zu verdongeln -> G-Sync...

Auf jeden Fall kannst du dich im nächsten Jahr auf deutlich sinkende Zahlen bei nVidia freuen...

Denn nVidia ist momentan etwas mit 3DFX zu vergleichen. Die haben auch viel zu lange an ihrer Architektur festgehalten und viel zu spät erst was neues gebracht...

Und hier ist nVidia gerade die Bremse, die weiterhin an ihrer bestehenden Architektur festhalten und nix neues bringen...

nvidia investiert ca. 50% mehr in r&d als amd. bei nvidia haben sich r&d ausgaben in den rund 10 letzten jahren in etwa verdreifacht. bei amd haben sie sich ausgehend von dem rekordquartal q4 2007 mit rund 510 millionen us-dollar in etwa halbiert auf aktuell rund 240 millionen us-dollar. gemessen am umsatz geben beide in etwa ähnlich viel aus (amd 28%, nvidia 26%).

Woerns

Grand Admiral Special

- Mitglied seit

- 05.02.2003

- Beiträge

- 2.983

- Renomée

- 232

Klingt wie ein Abgesang. Nvida würde ich jetzt nicht totschreiben. (Ok, hast Du nicht wirklich gemacht...)

Aber zunächst mal schaut Nvidia ein Quartal in die Röhre, wenn AMD sein 28nm Portfolio durch 14nm ersetzt. Nvidia hat im Mainstream Bereich nur 28nm zu bieten. Es kann die Preise reduzieren, wird es wohl auch müssen. Aber technologisch sind die Polaris Karten einfach einen Schritt weiter (z.B. in Sachen Verlustleistung), und Nvidia muss irgendwie durchhalten, bis sein 16nm-Portfolio auch im Mainstream angekommen ist.

Darüber hinaus stelle ich aber (auch mit etws Enttäuschung) fest, dass die Nvidia Käufer sich als sehr resistent gegenüber allen Unverschämtheiten der Firma erwiesen haben. Insofern kann man aus Anlegersicht deren Führung eigentlich keinen Vorwurf machen. Die Kundschaft bleibt komischerweise treu. Nvidia hat eine stabile CUDA-Gemeinde. Nvidia hat einen Fuß im HPC-Bereich. Da muss AMD noch gehörig aufholen, und dass AMD das auch schafft, glaube ich erst, wenn ich es erlebe.

MfG

--- Update ---

Ich kann mir vorstellen, dass AMD mit seinen Custom-Designs, speziell für die Konsolen, ein bisschen R&D quersubventionieren kann, ohne dass das so in den Bilanzen sichtbar wird. Die Custom-Designs sind ja nicht nur Fertigungs- sondern auch Entwicklungsaufträge.

MfG

Aber zunächst mal schaut Nvidia ein Quartal in die Röhre, wenn AMD sein 28nm Portfolio durch 14nm ersetzt. Nvidia hat im Mainstream Bereich nur 28nm zu bieten. Es kann die Preise reduzieren, wird es wohl auch müssen. Aber technologisch sind die Polaris Karten einfach einen Schritt weiter (z.B. in Sachen Verlustleistung), und Nvidia muss irgendwie durchhalten, bis sein 16nm-Portfolio auch im Mainstream angekommen ist.

Darüber hinaus stelle ich aber (auch mit etws Enttäuschung) fest, dass die Nvidia Käufer sich als sehr resistent gegenüber allen Unverschämtheiten der Firma erwiesen haben. Insofern kann man aus Anlegersicht deren Führung eigentlich keinen Vorwurf machen. Die Kundschaft bleibt komischerweise treu. Nvidia hat eine stabile CUDA-Gemeinde. Nvidia hat einen Fuß im HPC-Bereich. Da muss AMD noch gehörig aufholen, und dass AMD das auch schafft, glaube ich erst, wenn ich es erlebe.

MfG

--- Update ---

Ich kann mir vorstellen, dass AMD mit seinen Custom-Designs, speziell für die Konsolen, ein bisschen R&D quersubventionieren kann, ohne dass das so in den Bilanzen sichtbar wird. Die Custom-Designs sind ja nicht nur Fertigungs- sondern auch Entwicklungsaufträge.

MfG

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Die Frage ist allerdings eher ob aus den Investitionen in Forschung auch profitable Produkte entstehen. GSync war sicherlich keine billige Aktion und kann auch als gescheitert angesehen werden. Die Ausgaben in CPU Forschung bringen kaum was ein, Tegra ist seit Genrationen stagnierend und rückläufig seit dem ersten Marketing-Hype.

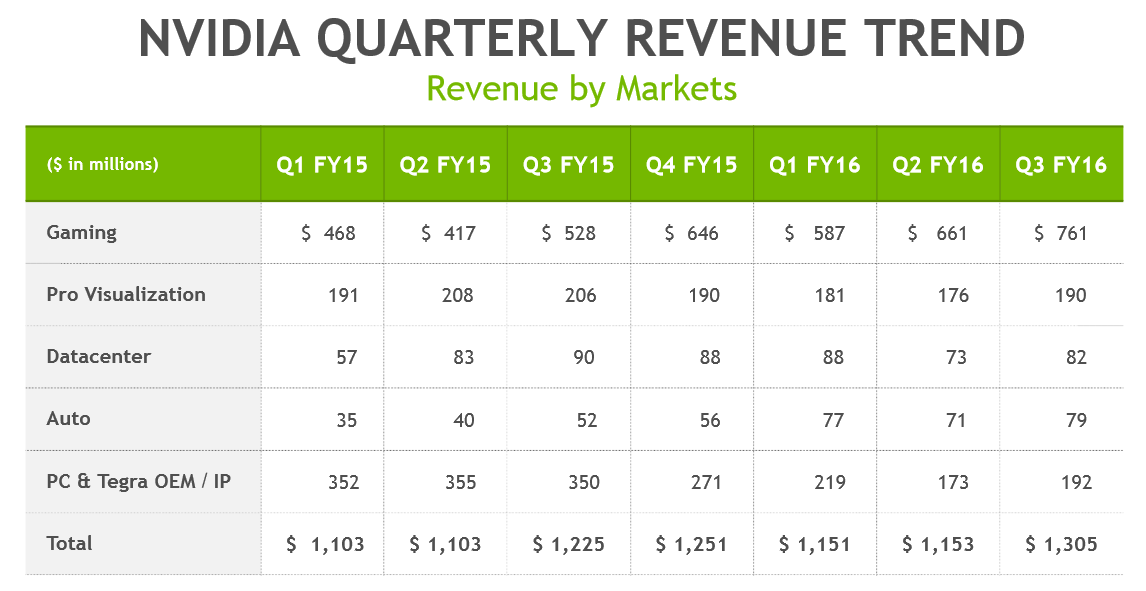

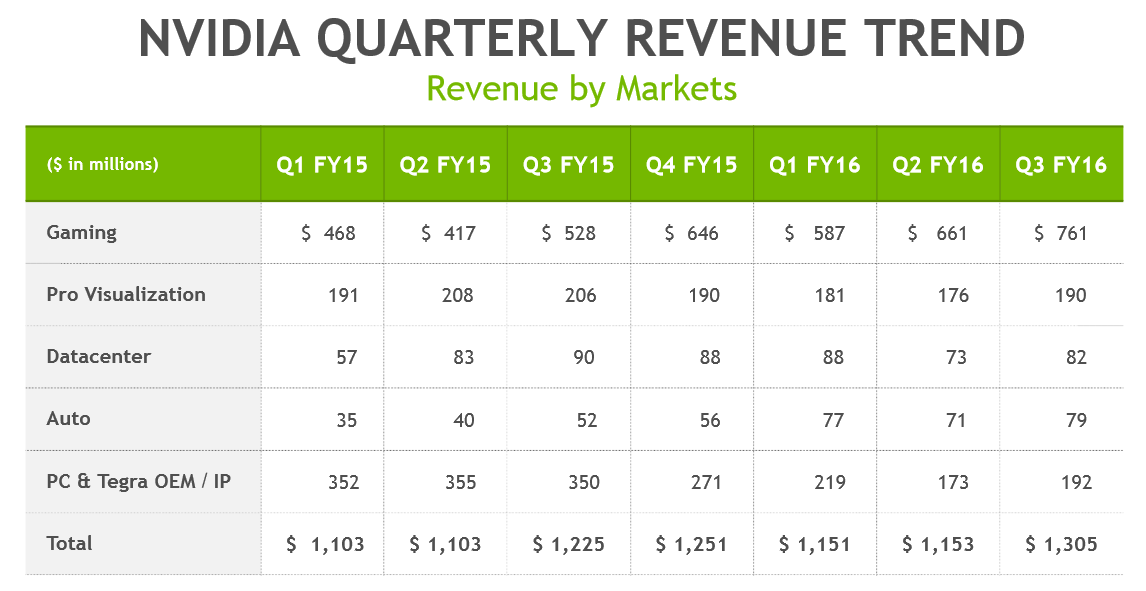

Nicht zu vergessen, dass in diese Tabelle Tegra mit den IP-Zahlungen zusammengefasst ist. Davon kommen von Intel alleine 66 Mio. im Quartal

http://www.computerbase.de/2016-03/patente-intel-amd-lizenzgespraechen/

Nicht zu vergessen, dass in diese Tabelle Tegra mit den IP-Zahlungen zusammengefasst ist. Davon kommen von Intel alleine 66 Mio. im Quartal

http://www.computerbase.de/2016-03/patente-intel-amd-lizenzgespraechen/

Damit scheint 2017 auch Schluss zu sein, da Intel Gespräche mit AMD aufgenommen hat. An den Zahlen ist zu erkennen, dass Nvidia außer dem Wachstum im Gaming mit Maxwell2 keine weiteren Märkte profitabler machen konnte. Deshalb setzt AMD auch hier an um Nvidia da Gewinne abzunehmen wo sie am meisten zu verlieren haben.Im letzten Jahr des laufenden Lizenzabkommens zwischen Intel und Nvidia sieht sich Intel angeblich nach einer Alternative um. Seit 2011 zahlte der Chipriese 66 Millionen US-Dollar pro Quartal an Nvidia für die Nutzung bestimmter technischer Errungenschaften, insgesamt sollen am Ende 1,5 Milliarden US-Dollar geflossen sein.

Das im Jahr 2011 geschlossene Abkommen beendete seinerzeit einen Rechtsstreit zwischen den beiden Firmen. Das Abkommen wurde auf sechs Jahre ausgelegt und sicherte Nvidia Zugang zu Intels Technologie, ausgenommen Intels „proprietäre Prozessoren, Flashspeicher sowie bestimmte Chipsätze für die Intel-Plattform“. Intel erhielt im Gegenzug Zugang zu allen Patenten von Nvidia, Intel war dies zusätzliche 1,5 Milliarden US-Dollar wert.

Solidus

Lt. Commander

- Mitglied seit

- 04.05.2014

- Beiträge

- 130

- Renomée

- 2

Aus den Jahresabschlüssen.[3DC]Payne;5099396 schrieb:Wo hast du die Infos hierüber her?

Forschungsaufwand 2015

Nvidia: 1,3 Milliarden USD

AMD: 950 Millionen USD

Nachdem AMD mit diesem Budget noch weitere Geschäftsfelder beackern muss, schätze ich, dass die tatsächen Investitionen in GPUs höchstens 500 Millionen USD betragen.

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Allerdings sollte man auch beachten wie hoch die Know-How Differenz ist. Nvidia muss einiges aufholen. Z.B. erst jetzt mit dem NVlink haben sie einen Interconnect den AMD und Intel seit Jahren haben. Die Weiterentwicklung auf hohem Niveau ist günstiger als das aufholen oder etwas völlig neues bahnbrechendes zu entwickeln. AMD hat da zuletzt starke Synergien bei CPU und GPU Entwicklung einbringen können und mit der APU eine neue Produktklasse etabliert, welche für Konsolen fast zum Standard geworden ist.

Stefan Payne

Grand Admiral Special

Das ist aber völliger Bullshit, was du hier machst, denn, wie schon erwähnt, kannst du das eben NICHT so wirklich gut trennen. ZUmal du auch nicht so wirklich weißt, was denn nun genau wo hin geflossen ist.Aus den Jahresabschlüssen.

Forschungsaufwand 2015

Nvidia: 1,3 Milliarden USD

AMD: 950 Millionen USD

Nachdem AMD mit diesem Budget noch weitere Geschäftsfelder beackern muss, schätze ich, dass die tatsächen Investitionen in GPUs höchstens 500 Millionen USD betragen.

Richtig, nur eine Ermahnung, dass, wenn sich nVidia nicht bald sehr schnell ändert, für die der Ofen aus ist und sie arge Probleme haben.Klingt wie ein Abgesang. Nvida würde ich jetzt nicht totschreiben. (Ok, hast Du nicht wirklich gemacht...)

Sei es, weil ihnen niemand mehr traut und/oder niemand mehr Bock auf deren Verhalten hat. Und das ist jetzt schon z.T. sehr fragwürdig...

Und, wenn wir funktionierende Kartellbehörden hätten, sie wohl schon einen aufn Deckel bekommen hätten...

Aber das ganze ändert auch nichts am Zustand, dass so einigen gerade ein Licht aufgeht und sich abzeichnet, dass sie gar nicht soo viel Lust auf nV haben. Einige können sichs leisten (Apple), andere trauen sich ev. nicht so richtig.

Die Entwickler von The Witcher haben ja, im Rahmen ihrer Möglichkeiten, nVidia ja richtig angekackt, was Gameworks betrifft.

Das siehst du viel zu positiv...Aber zunächst mal schaut Nvidia ein Quartal in die Röhre, wenn AMD sein 28nm Portfolio durch 14nm ersetzt. Nvidia hat im Mainstream Bereich nur 28nm zu bieten. Es kann die Preise reduzieren, wird es wohl auch müssen. Aber technologisch sind die Polaris Karten einfach einen Schritt weiter (z.B. in Sachen Verlustleistung), und Nvidia muss irgendwie durchhalten, bis sein 16nm-Portfolio auch im Mainstream angekommen ist.

Du vergisst da aber einige Dinge:

a) technologisch ist Pascal kaum mehr als ein geshrinkter Maxwell

b) sind die AMD Chips bei vergleichbarer Leistung 'nen Stück kleiner, damit billiger

c) hat AMD das ganze anscheinend auf Preis und Effizienz optimiert, nVidia weniger.

Siehe hier z.B. GP104 vs. Polaris big. Der GP104 ist fast 50% größer als der AMD Chip...

Und das eine Quartal ist schlicht Quatsch!

Gerade im Mainstream brauchst du ja große Mengen - und die hat AMD ja schon vorproduziert.

Während es noch kein Lebenszeichen von GP106 gibt, nur einen vermuteten Termin...

Dazu kommt noch das Weihnachtsgeschäft und noch einige Dinge...

Das ist also unterm Strich eher ein halbes Jahr als ein Viertel...

Und Grafikchip Upgrades kommen bei Notebooks ja auch nicht sooo oft vor, da hast dann entweder was oder eben nicht, hast nix, bist erst mal 'ne Runde oder zwei raus...

das liegt aber nur zu einem geringen Teil an den Käufern selbst. Zu einem recht großem Teil aber auch an der Presse, die z.B. die GTX 970 nicht total verrissen haben, als die Speicherarchitektur bekannt wurde. Hier ist von Seiten der Presse eher auf Kuschelkurs mit nVidia gegangen worden, um sie wohl nicht zu verärgern. Aber hier hätte man mehr machen können und auch müssen...Darüber hinaus stelle ich aber (auch mit etws Enttäuschung) fest, dass die Nvidia Käufer sich als sehr resistent gegenüber allen Unverschämtheiten der Firma erwiesen haben. Insofern kann man aus Anlegersicht deren Führung eigentlich keinen Vorwurf machen. Die Kundschaft bleibt komischerweise treu. Nvidia hat eine stabile CUDA-Gemeinde. Nvidia hat einen Fuß im HPC-Bereich. Da muss AMD noch gehörig aufholen, und dass AMD das auch schafft, glaube ich erst, wenn ich es erlebe.

MfG

Die meisten sind schlicht einfach nur unglaublich uninformiert. Dazu kommen noch die ganzen NVidia Fans, die gewaltsam, mit aller Macht, die Gebarden des Unternehmen schön reden.

Dazu kommt, dass AMD keine allzu guten OEM Deals bekommen hatte, letzte Generation.

Aber jetzt schauts so aus, als ob etwas mehr passieren könnte.

Und AMD einige OEMs von ihren Karten überzeugen konnte.

Dazu kommt eben auch noch Apple, die wohl auch keine Lust mehr auf nVidia haben, nachdem die OpenCL Support gedroppt haben, nachdem GCN etwas besser als das eigene Zeugs war...

Und zu der CUDA Gemeinde:

AMD hat die mit Hawaii zuletzt ordentlich ins wanken gebracht, als sie einen deutlich schnelleren Chip hatten, im HPC Bereich kommen sie von Intel unter Beschuss und beim Rest hat AMD ja gewaltig aufgeholt...

Und die ganzen CUDA Leute waren weiter auf die deutlich schwächeren nVidia Chips festgelegt...

Möglich, aber ändert erst einmal wenig am grundsätzlichen...Ich kann mir vorstellen, dass AMD mit seinen Custom-Designs, speziell für die Konsolen, ein bisschen R&D quersubventionieren kann, ohne dass das so in den Bilanzen sichtbar wird. Die Custom-Designs sind ja nicht nur Fertigungs- sondern auch Entwicklungsaufträge.

MfG

Nämlich, dass NVidia in einigen Bereichen gar nicht in der Lage ist, mit AMD zu konkurieren, da eben einige wesentliche Bestandteile fehlen, die AMD eben schon hat...

nVidia ist aktuell auch einiges Zurück, was die Technologie betrifft.

Einerseits weil AMD ihre grundsätzliche Architektur gerade erst erneuert hat (GCN), während nVidia noch auf dem G80 aufbaut, der immer wieder mal erweitert wurde...

Dazu kommt eben noch das ganze Zeugs, was AMD für die CPUs eh benötigt oder in besseren Zeiten entwickelt hat. Dazu gehört eben auch der Interconnect von den ganzen Dingen...

Da hat AMD momentan einen gewaltigen Vorsprung, auch was Multi GPU Technologie betrifft, ist AMD hier deutlich weiter, da die aktuellen Chips gar keine Brücke mehr benötigen und alles über den PCIe läuft, während nVidia immer noch Brücken braucht...

Und hier vermuten einige sogar, dass AMD den PCIe auf 'was anderes' umschalten könnte, wenn eine AMD CPU mit einer AMD GPU kombiniert wird...

nVidia scheint zum Beispiel das Lizenzabkommen mit Intel zu verlieren, das scheint jetzt AMD zu bekommen.

Wobei die Frage auch sein kann, was AMD alles an Intel lizensieren könnte...

Insgesamt schaut es für NV momentan nicht so besonders toll aus, was aber noch durch die 'Hardcore nVidia Fans' überspielt werden kann, aber eben nicht mehr lange, da einige unschöne Dinge ans Tageslicht kommen...

Und spätestens, wenn mehr und mehr Spiele anfangen auf der GTX 970 zu ruckeln und darauf dann auch die Antwort kommt, dass das an der Speicherarchitektur liegt, kann sich das auch noch langfristig zu einem wirklich üblen Bumerang entwickeln, spätestens wenn nVidia die GTX 970 Optimierungen sein lässt...

Ähnliche Themen

- Antworten

- 1

- Aufrufe

- 292

- Antworten

- 1

- Aufrufe

- 659

- Antworten

- 0

- Aufrufe

- 575

- Antworten

- 0

- Aufrufe

- 560

- Antworten

- 0

- Aufrufe

- 547