App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Universe@Home

- Ersteller cyrusNGC_224

- Erstellt am

JagDoc

Grand Admiral Special

- Mitglied seit

- 18.08.2002

- Beiträge

- 3.354

- Renomée

- 725

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- RNA, Pogs, Enigma, Asteroids

- Lieblingsprojekt

- RNA

- Meine Systeme

- i7-3820, i7-3930, ODROID-X2/U2

- BOINC-Statistiken

- Folding@Home-Statistiken

Hab gerade mal den Netzwerkzugriff abgeschaltet.

Sind ca 500KB upload.

Sind ca 500KB upload.

joe carnivore

Admiral Special

- Mitglied seit

- 04.01.2008

- Beiträge

- 1.650

- Renomée

- 96

- Standort

- Goslar

- Meine Systeme

- AMD Ryzen 5950x , 5600, 5700G , 3600 ,2x Opteron 3280, FX 8350, Athlon 5350 ,Xeon 1230 v3, Intel Celeron G3900T, Raspberry 5, 5x Raspberry 4 , 3 x Raspberry 3 , 3 Bannana pi M2 , 4 Odroid U3, 2 x Tablet Fire TV von Amazon

- BOINC-Statistiken

Hab gerade mal den Netzwerkzugriff abgeschaltet.

Sind ca 500KB upload.

Hört sich gut an. Dann kann man einsteigen mit kleiner Leitung.

Zuletzt bearbeitet:

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.919

- Renomée

- 2.214

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Bei mir gibt der BM die realen 3:17 als Schätzung an. Fast schon unheimlich genau.

Oh, da haben sie's wohl geändert.

Tja, seit ein paar Tagen klappt die Zeitberechnung nicht mehr.

Ich bekomme für die V2 1:14h angezeigt, real laufen die aber nach wie vor ihre 3:20h

Das hat zur Folge, dass Universe immer 3x so viele WUs schickt, wie verarbeitet werden können.

Die laufen dann immer 1-2 Tage im Panik-Modus durch, dann macht das Projekt erstmal eine Weile Pause, weil ja WCG auch noch was rechnen soll, um auf die eingestellte Projektverteilung zu kommen. Dies wiederum führt zu WUs, deren Haltbarkeit bald überschritten ist. Und das hat natürlich wieder den Panik-Modus zur Folge.

Die 4 Tage Deadline finde ich nach wie vor zu kurz. Ich hab das Projekt jetzt erstmal auf No Work gestellt. Vielleicht hol ich ab und zu mal einen Schwung WUs und mach die Tür dann wieder zu.

Ich hab Universe nur auf dem einen Rechner, es kann also nicht daran lieben, dass ein anderer Rechner die Zeiten beeinflusst.

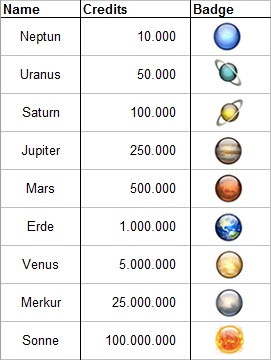

Edit: Oh wie nett, es gibt sogar Badges bei dem Projekt

Zuletzt bearbeitet:

Sabroe SMC

Grand Admiral Special

- Mitglied seit

- 14.05.2008

- Beiträge

- 4.770

- Renomée

- 532

- Standort

- Castrop-Rauxel

- Mein Laptop

- Gigabyte P37, i7 4720HQ, 16 Gb, 128 Gb SSD, 1Tb HD, 17" FHD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asus TUF Gaming X670E Plus

- Kühlung

- Noctua NH-D15 chromax.black

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 64GB DDR5-6400 CL32-39-39-102 on-die ECC

- Grafikprozessor

- Palit GeForce RTX 4090 GameRock

- Display

- Samsung U32H850, 31.5" (3840x2160)

- SSD

- Kingston KC3000 PCIe 4.0 NVMe SSD 2TB

- Optisches Laufwerk

- irgendeins

- Soundkarte

- Onboard

- Gehäuse

- SilverStone Seta D1, schwarz

- Netzteil

- ASUS ROG Strix, ROG-STRIX-850G Gold Aura Edition, 850W ATX 3.0

- Tastatur

- Razer BlackWidow Ultimate

- Maus

- Zowie Gaming Mouse FK1

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox in aktuellster Version

- Verschiedenes

- Teufel Concept C (Schwarz) bestehend aus - 2 Satelliten-Lautsprecher CS 25 FCR Mk3 (Schwarz) 1 Aktiv-Subwoofer CC 2013 SW (Schwarz)

- Internetanbindung

-

▼500 Mbit/s

▲25 Mbit/s

Dazu noch richtig schöne, im Vergleich zu anderen Projekten.

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Mit der neuen "Universe X-ray sources v2 v0.03" Anwendung wurden die Linuxlaufzeiten im Schnitt um den Faktor 2,5 verkürzt! So ist die Leistung unter Linux nun der unter Win ebenbürtig und sogar stellenweise etwas besser. Z.B. auf einem Athlon 5350 Win 8.1 ca. 17000 s, unter Linux sind es ca. 10000 s (zuvor ~26000 s).

Checkpoints funktionieren nun auch.

Die extrem hohen Uploads sind übrigens schon lange Geschichte. Nun sind Up,- und Download nur wenige kB groß.

Checkpoints funktionieren nun auch.

Die extrem hohen Uploads sind übrigens schon lange Geschichte. Nun sind Up,- und Download nur wenige kB groß.

Wenn ich mir die x6 1090 anschaue, dann ist Linux jetzt beinahe doppelt so schnell als Win !cyrusNGC_224 schrieb:So ist die Leistung unter Linux nun der unter Win ebenbürtig und sogar stellenweise etwas besser.

Das ist nicht sehr nett.

Wann zieht Windows nach ??

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Weiß nicht ob die das überhaupt so schnell vorhaben.

Hab jetzt auf dem Win 8.1. Athlon extra eine Linux VM angelegt, weil das wie gesagt fast der doppelt Durchsatz ist.

Hab jetzt auf dem Win 8.1. Athlon extra eine Linux VM angelegt, weil das wie gesagt fast der doppelt Durchsatz ist.

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.595

- Renomée

- 1.345

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Mal ne blöde Frage: was wird hier gerechnet? Iwie konnte ich hierzu nix sachdienliches finden

Gruß,

Ritschie

Gruß,

Ritschie

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Für so ein jungen Projekt haben die schon sehr viel und sehr detaillierte Beschreibungen parat [1], [2].

Also eine Datenbank wird erstellt, in der sämtliche Objekte im bekannten Universum abgebildet werden.

Neutronensterne, schwarze Löcher, Doppelsternsystem usw. Im Grunde wird das simuliert, anhand von Daten von Gravitationswellen und Röntgenstrahlung.

Und noch vieles mehr.

[1] http://iopscience.iop.org/0067-0049/174/1/223/pdf/0067-0049_174_1_223.pdf

[2] http://universeathome.pl/universe/universe.pdf

This proposal aims to create the first database of the simulated stellar content of the Universe,

from the earliest stars to the most exotic black hole binaries. This comprehensive stellar library will

be a world-wide scientific resource for astronomers, and an educational asset for the public. With

a state-of-the-art suite of computational tools, we can calculate the physical properties of individual

stars, evolve them in time, and track how they interact with each other as they age. With this library

of stellar populations that spans the known range of star formation histories and initial elemental

abundances, it is possible to tackle fundamental science questions that have been out of reach in

general relativity, astronomy, and cosmology. As a group wewill use this database to characterize the

population of supernova progenitor stars that have been used to discover the mysterious dark energy

that accelerates the expansion of the Universe; we can calculate how (if at all) binary evolution

facilitates the formation of ultra-luminous X-ray sources, and we can model the number and physical

properties of neutron stars and black holes that strongly emit gravitational waves that are at the

heart of research into gamma-ray bursts – the most energetic explosions known-to-date. The data

that we create can be mined not only to match current observations, but to predict how the sky

will appear to future astronomical observatories as new windows to the Universe open. Altogether,

this proposal will allow us to consolidate a strong and highly visible research group; an independent

computational center that trains a new cohort of highly educated students, and communicates with

the public via innovative science venues, and offer a fresh look at the Universe.

Also eine Datenbank wird erstellt, in der sämtliche Objekte im bekannten Universum abgebildet werden.

Neutronensterne, schwarze Löcher, Doppelsternsystem usw. Im Grunde wird das simuliert, anhand von Daten von Gravitationswellen und Röntgenstrahlung.

Und noch vieles mehr.

[1] http://iopscience.iop.org/0067-0049/174/1/223/pdf/0067-0049_174_1_223.pdf

[2] http://universeathome.pl/universe/universe.pdf

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.595

- Renomée

- 1.345

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Hallo cyrus,Also eine Datenbank wird erstellt, in der sämtliche Objekte im bekannten Universum abgebildet werden.

Neutronensterne, schwarze Löcher, Doppelsternsystem usw. Im Grunde wird das simuliert, anhand von Daten von Gravitationswellen und Röntgenstrahlung.

Und noch vieles mehr.

leider ist mein Englisch zu eingestaubt. Aber deine kurze Erklärung genügt mir. Vielen Dank dafür.

Gruß,

Ritschie

Das Projekt hat sich zum Ziel gemacht, eine erste Datenbank für den simulierten stellaren Inhalt des Universums zu erstellen, von den frühesten Sternen bis zu den exotischsten schwarzen Löchern. Als stellare Bibliothek soll sie eine weltweite wissenschaftliche Quelle für Astronomen und ein Lernvorteil für die Öffentlichkeit werden.

Mit neuesten Berechnungswerkzeugen können wir die physikalischen Eigenschaften von Sternen berechnen und wie sie sich zueinander verhalten, wenn sie altern. Fundamentale wissenschaftliche Fragen der Relativität, Astronomie und Kosmologie können anhand dieser Bibliothek der Sternenpopulation angepackt werden. Als Gruppe werden wir die Datenbank zur Charakterisierung der Population von Supernova-Vorgängern nutzen, die zur Entdeckung der mysteriösen Dunklen Energie führten, die die Expansion des Universums beschleunigt. Wir können berechnen wie (und ob) die binäre Evolution die Formation von ultraleuchtenden Röntgen-Quellen erleichtert, und wir können die Anzahl der physikalischen Eigenschaften von Neutronensternen und schwarzen Löchern modellieren, die starke Gravitationswellen emittieren. Gravitationswellen sind das Herz zur Erforschung von Gammablitzen - der größten energetischen Explosion, die bis heute bekannt ist.

Weiterführende ausführlichere Projektbeschreibungen (in Englisch) kann man in dieser

PDF-Datei erfahren.

Badges-System:

Quelle: http://wiki.bc-team.org/index.php?title=Universe@Home

Universe@home http://universeathome.pl/universe/index.php

Anwendungen: http://universeathome.pl/universe/apps.php

Die Linuxanwendung ist auf einem Phenom2 x6 1090 zur Zeit beinahe doppelt so fix als die Winversion.cyrusNGC_224 schrieb:Die extrem hohen Uploads sind übrigens schon lange Geschichte. Nun sind Up,- und Download nur wenige kB groß.

Linux: ca. 6600 sec

Win: ca. 12200 sec

Ram unter Win : ca. 4,5 MB

Credits je Wu: 222,22

Universe@Home test project http://universeathometest.info/universe/

Zuletzt bearbeitet:

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.595

- Renomée

- 1.345

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

@ Pollux: vielen Dank für den Link!

Gruß,

Ritschie

Gruß,

Ritschie

Sabroe SMC

Grand Admiral Special

- Mitglied seit

- 14.05.2008

- Beiträge

- 4.770

- Renomée

- 532

- Standort

- Castrop-Rauxel

- Mein Laptop

- Gigabyte P37, i7 4720HQ, 16 Gb, 128 Gb SSD, 1Tb HD, 17" FHD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asus TUF Gaming X670E Plus

- Kühlung

- Noctua NH-D15 chromax.black

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 64GB DDR5-6400 CL32-39-39-102 on-die ECC

- Grafikprozessor

- Palit GeForce RTX 4090 GameRock

- Display

- Samsung U32H850, 31.5" (3840x2160)

- SSD

- Kingston KC3000 PCIe 4.0 NVMe SSD 2TB

- Optisches Laufwerk

- irgendeins

- Soundkarte

- Onboard

- Gehäuse

- SilverStone Seta D1, schwarz

- Netzteil

- ASUS ROG Strix, ROG-STRIX-850G Gold Aura Edition, 850W ATX 3.0

- Tastatur

- Razer BlackWidow Ultimate

- Maus

- Zowie Gaming Mouse FK1

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox in aktuellster Version

- Verschiedenes

- Teufel Concept C (Schwarz) bestehend aus - 2 Satelliten-Lautsprecher CS 25 FCR Mk3 (Schwarz) 1 Aktiv-Subwoofer CC 2013 SW (Schwarz)

- Internetanbindung

-

▼500 Mbit/s

▲25 Mbit/s

Kann mir mal jemand erklären warum ein Opteron 6380 (16Kerne, 2,5 Ghz Takt) ca 25% pro WU schneller ist als ein Opteron 6344 (12Kerne, 2,6 Ghz Takt).

6380: http://universeathome.pl/universe/result.php?resultid=1726723 5,916.06 sec

6344: http://universeathome.pl/universe/result.php?resultid=1879587 7,919.05 sec

Sind die WU's so unterschiedlich, was ich bisher bei ca 1500 WUs auf meinem Opteron nicht feststellen konnte, oder gibt es etwa eine "schnellere" App? Oder kann man eventuell die Opteronen übertakten? Die Gleitkommazahlenwerte der Rechner des Herrn Brobecki sind alle ca 12% höher als die von meinem Rechner. 2200 zu 2500

6380: http://universeathome.pl/universe/result.php?resultid=1726723 5,916.06 sec

6344: http://universeathome.pl/universe/result.php?resultid=1879587 7,919.05 sec

Sind die WU's so unterschiedlich, was ich bisher bei ca 1500 WUs auf meinem Opteron nicht feststellen konnte, oder gibt es etwa eine "schnellere" App? Oder kann man eventuell die Opteronen übertakten? Die Gleitkommazahlenwerte der Rechner des Herrn Brobecki sind alle ca 12% höher als die von meinem Rechner. 2200 zu 2500

Zuletzt bearbeitet:

Raspo

Admiral Special

- Mitglied seit

- 12.02.2008

- Beiträge

- 1.983

- Renomée

- 36

- Standort

- Hamburg

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Oneplus 6 64GB

- Details zu meinem Desktop

- Prozessor

- Ryzen 3900X@65W

- Mainboard

- Asus Crosshair VI Hero

- Kühlung

- be quiet silent loop 280

- Speicher

- 4x 8 GB G.Skill Trident Z RGB @3600CL16

- Grafikprozessor

- Sapphire Pulse Vega 56

- Display

- Philips 436M6

- SSD

- Samsung 960 Evo

- HDD

- Intel SSD 80GB, WD Scorpio 620GB HDD für Boinc

- Soundkarte

- onboard @ Dali Zensor 1

- Gehäuse

- Phanteks Evolv ATX TG

- Netzteil

- Seasonic Prime 660W Platinum

- Betriebssystem

- Win 10 64bit Pro

- Webbrowser

- Firefox

Vielleicht hat er schnelleren Speicher verbaut.

Sabroe SMC

Grand Admiral Special

- Mitglied seit

- 14.05.2008

- Beiträge

- 4.770

- Renomée

- 532

- Standort

- Castrop-Rauxel

- Mein Laptop

- Gigabyte P37, i7 4720HQ, 16 Gb, 128 Gb SSD, 1Tb HD, 17" FHD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asus TUF Gaming X670E Plus

- Kühlung

- Noctua NH-D15 chromax.black

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 64GB DDR5-6400 CL32-39-39-102 on-die ECC

- Grafikprozessor

- Palit GeForce RTX 4090 GameRock

- Display

- Samsung U32H850, 31.5" (3840x2160)

- SSD

- Kingston KC3000 PCIe 4.0 NVMe SSD 2TB

- Optisches Laufwerk

- irgendeins

- Soundkarte

- Onboard

- Gehäuse

- SilverStone Seta D1, schwarz

- Netzteil

- ASUS ROG Strix, ROG-STRIX-850G Gold Aura Edition, 850W ATX 3.0

- Tastatur

- Razer BlackWidow Ultimate

- Maus

- Zowie Gaming Mouse FK1

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox in aktuellster Version

- Verschiedenes

- Teufel Concept C (Schwarz) bestehend aus - 2 Satelliten-Lautsprecher CS 25 FCR Mk3 (Schwarz) 1 Aktiv-Subwoofer CC 2013 SW (Schwarz)

- Internetanbindung

-

▼500 Mbit/s

▲25 Mbit/s

Ich habe 2x 32 GB Kingston ValueRAM DIMM, 8x8GB Module mit ECC, DDR3-1600 CL11 verbaut. Kann der Chipsatz/Prozessor aus der zeit mit schnelleren Rams umgehen? Wenn ja, wieviel Einfluss hat die Geschwindigkeit des Rams auf die Rechenzeit der WUs?

Zuletzt bearbeitet:

Onkel_Dithmeyer

Redaktion

☆☆☆☆☆☆

- Mitglied seit

- 22.04.2008

- Beiträge

- 12.951

- Renomée

- 4.068

- Standort

- Zlavti

- Aktuelle Projekte

- Universe@home

- Lieblingsprojekt

- Universe@home

- Meine Systeme

- cd0726792825f6f563c8fc4afd8a10b9

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 3900X @4000 MHz//1,15V

- Mainboard

- MSI X370 XPOWER GAMING TITANIUM

- Kühlung

- Custom Wasserkühlung vom So. G34

- Speicher

- 4x8 GB @ 3000 MHz

- Grafikprozessor

- Radeon R9 Nano

- Display

- HP ZR30W & HP LP3065

- SSD

- 2 TB ADATA

- Optisches Laufwerk

- LG

- Soundkarte

- Im Headset

- Gehäuse

- Xigmatek

- Netzteil

- BeQuiet Dark Pro 9

- Tastatur

- GSkill KM570

- Maus

- GSkill MX780

- Betriebssystem

- Ubuntu 20.04

- Webbrowser

- Firefox Version 94715469

- Internetanbindung

- ▼100 Mbit ▲5 Mbit

Bei Universe nicht sonderlich viel.

Sabroe SMC

Grand Admiral Special

- Mitglied seit

- 14.05.2008

- Beiträge

- 4.770

- Renomée

- 532

- Standort

- Castrop-Rauxel

- Mein Laptop

- Gigabyte P37, i7 4720HQ, 16 Gb, 128 Gb SSD, 1Tb HD, 17" FHD

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 7950X3D

- Mainboard

- Asus TUF Gaming X670E Plus

- Kühlung

- Noctua NH-D15 chromax.black

- Speicher

- G.Skill Trident Z5 RGB silber DIMM Kit 64GB DDR5-6400 CL32-39-39-102 on-die ECC

- Grafikprozessor

- Palit GeForce RTX 4090 GameRock

- Display

- Samsung U32H850, 31.5" (3840x2160)

- SSD

- Kingston KC3000 PCIe 4.0 NVMe SSD 2TB

- Optisches Laufwerk

- irgendeins

- Soundkarte

- Onboard

- Gehäuse

- SilverStone Seta D1, schwarz

- Netzteil

- ASUS ROG Strix, ROG-STRIX-850G Gold Aura Edition, 850W ATX 3.0

- Tastatur

- Razer BlackWidow Ultimate

- Maus

- Zowie Gaming Mouse FK1

- Betriebssystem

- Windows 11 Pro

- Webbrowser

- Firefox in aktuellster Version

- Verschiedenes

- Teufel Concept C (Schwarz) bestehend aus - 2 Satelliten-Lautsprecher CS 25 FCR Mk3 (Schwarz) 1 Aktiv-Subwoofer CC 2013 SW (Schwarz)

- Internetanbindung

-

▼500 Mbit/s

▲25 Mbit/s

Sehe ich genauso

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Der Brobecki hat sowieso unglaubliche Kisten im Park. Und ja, es gibt Boards, mit denen man die Opteron übertakten kann.

Anhand der höheren Benchwerte muss das auch der Fall sein.

--- Update ---

Ach, was mir noch auffällt, er hat da überall Gentoo Linux drauf laufen. Da wird bekanntlich jedes Paket im Quellcode geliefert und muss noch kompiliert werden, was mit den optimalen Kompilerflags für eine spezifische Arch tatsächlich einige % Vorteil bringen könnte.

Dagegen spricht, dass die eigentlich Universe App eben nicht neu kompiliert werden kann (außer er hat den Quellcode bekommen).

Anhand der höheren Benchwerte muss das auch der Fall sein.

--- Update ---

Ach, was mir noch auffällt, er hat da überall Gentoo Linux drauf laufen. Da wird bekanntlich jedes Paket im Quellcode geliefert und muss noch kompiliert werden, was mit den optimalen Kompilerflags für eine spezifische Arch tatsächlich einige % Vorteil bringen könnte.

Dagegen spricht, dass die eigentlich Universe App eben nicht neu kompiliert werden kann (außer er hat den Quellcode bekommen).

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Universe sendet neuerdings WUs nur an vier verschiedene OS Klassen, was die Homogeneous Redundancy Funktionen von Boinc verwendet: Windwos, Linux, Mac-PPC, Mac-Intel

http://universeathome.pl/universe/forum_thread.php?id=62&postid=555

Außerdem teilt man die Berechnung in verschiedene Reihen auf. Das hat geringere Uploadgrößen und unterschiedliche Laufzeiten zur Folge.

http://universeathome.pl/universe/forum_thread.php?id=64#557

http://universeathome.pl/universe/forum_thread.php?id=62&postid=555

Außerdem teilt man die Berechnung in verschiedene Reihen auf. Das hat geringere Uploadgrößen und unterschiedliche Laufzeiten zur Folge.

http://universeathome.pl/universe/forum_thread.php?id=64#557

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

http://universeathome.pl/universe/forum_thread.php?id=71&postid=588From new batch we start to send about 4 times longer work units...

Longer WU's allow us to check some models more deeply and also this change will unload server by giving us same data in less files...

Ab jetzt also 4 mal so lange Laufzeiten. Wobei diese zuvor stetig kürzer wurden.

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

In Kürze wird es eine App für Android Geräte geben. Vorerst nur, wenn man Testanwendungen im Profil zulässt.Thanks to the user matszpk we can start Today testing Android version of our application.

Application will be available soon but only for users who mark "Test application" in their options.

http://universeathome.pl/universe/forum_thread.php?id=84#652

JagDoc

Grand Admiral Special

- Mitglied seit

- 18.08.2002

- Beiträge

- 3.354

- Renomée

- 725

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- RNA, Pogs, Enigma, Asteroids

- Lieblingsprojekt

- RNA

- Meine Systeme

- i7-3820, i7-3930, ODROID-X2/U2

- BOINC-Statistiken

- Folding@Home-Statistiken

Es gibt jetzt auch eine App für Linux-ARM:

http://universeathome.pl/universe/forum_thread.php?id=116

http://universeathome.pl/universe/forum_thread.php?id=116

Sightus

Grand Admiral Special

- Mitglied seit

- 01.12.2006

- Beiträge

- 3.113

- Renomée

- 299

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- Einige

- Meine Systeme

- Neumodische Taschenrechner mit grafischer Oberfläche

- BOINC-Statistiken

Weiß zufällig jemand, ob die Windows-App auch irgendwann optimiert wird?

NEO83

Grand Admiral Special

- Mitglied seit

- 19.01.2016

- Beiträge

- 5.593

- Renomée

- 997

- Standort

- Wilhelmshaven

- Meine Systeme

- R9 7950X & RTX5080 | R5 9600X & RX9070XT | 7940HS & RTX4070

- BOINC-Statistiken

- Mein Desktopsystem

- Kraftzwerg | MiniMe

- Mein Laptop

- ASUS TUF A17 @R9 7940HS @RTX4070

- Details zu meinem Desktop

- Prozessor

- R9 7950X | R5 9600X

- Mainboard

- MSI MAG X870 Tomahawk WIFI | ASUS B850M-Plus WiFi

- Kühlung

- Corsair iCUE LINK H115i RGB | Noctua NH-D12L

- Speicher

- Corsair Vengeance 64GB, DDR5-6000 | TeamGroup 32GB, DDR5 7200

- Grafikprozessor

- PNY GeForce RTX 5080 OC | RX9070XT RedDevil

- Display

- MSI MAG 274UPFDE @UHD @144Hz | MSI MPG ARTYMIS 273CQRDE @WQHD

- SSD

- WD_BLACK SN850X 1TB, WD_BLACK SN850X 2TB | WD Blue 1TB, FIKWOT 2TB

- Optisches Laufwerk

- USB BD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- Corsair Frame 4000D | Jonsbo D31 MESH

- Netzteil

- be quiet! Power Zone 2 1000W | ASUS ROG Loki 1000W Platinum SFX-L

- Tastatur

- Logitech G815

- Maus

- Logitech G502 SE Lightspeed

- Betriebssystem

- Windows 11 | Dualboot Windows 11 & CachyOS

- Webbrowser

- FireFox | FireFox

- Internetanbindung

-

▼600MBit

▲300MBit

Wäre eine schöne Sache aber naja man kann nicht alles haben

cyrusNGC_224

Grand Admiral Special

★ Themenstarter ★

- Mitglied seit

- 01.05.2014

- Beiträge

- 5.924

- Renomée

- 117

- Aktuelle Projekte

- POGS, Asteroids, Milkyway, SETI, Einstein, Enigma, Constellation, Cosmology

- Lieblingsprojekt

- POGS, Asteroids, Milkyway

- Meine Systeme

- X6 PII 1090T, A10-7850K, 6x Athlon 5350, i7-3632QM, C2D 6400, AMD X4 PII 810, 6x Odroid U3

- BOINC-Statistiken

Ja, das wurde seitens der Entwickler schon in Angriff genommen. Aber aus irgend einem Grund bekommen die die Win App nicht an die Laufzeiten der Linux und Mac Apps angeglichen. Und das ist bei wirklich jedem Unterprojekt der Fall, bisher.Weiß zufällig jemand, ob die Windows-App auch irgendwann optimiert wird?

Oft liegen die Faktor 2 auseinander.

(Athlon 5350 Linux 3:46h; Win 8.1 6:11h)

http://universeathome.pl/universe/forum_thread.php?id=10#80

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 201

- Antworten

- 0

- Aufrufe

- 103

- Antworten

- 2

- Aufrufe

- 525

- Antworten

- 0

- Aufrufe

- 357

- Antworten

- 85

- Aufrufe

- 3K

Aktuelle Aktionen

Pentathlon 2025

Forumsthread

Webseite SG Pentathlon

Marathon 26.05 22:00 - 29.05. 21:59

Projekt: World Community Grid

Forumsthread

Forumsthread

Webseite SG Pentathlon

Marathon 26.05 22:00 - 29.05. 21:59

Projekt: World Community Grid

Forumsthread