App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

- Foren

- Planet 3DNow! Community

- Planet 3DNow! Distributed Computing

- Team Planet 3DNow!

- Café Planet 3DNow!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Formula Boinc 2021

- Ersteller pipin

- Erstellt am

- Status

- Für weitere Antworten geschlossen.

Maverick-F1

Grand Admiral Special

Meine beiden Rechenknechte kriegen aber keine Sixtracks - jeder gerade mal eine WU, dann: "This computer has reached a limit of tasks in progress" ![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

![Augen rollen (sarkastisch) :] :]](https://www.planet3dnow.de/vbulletin/images/smilies/rolleyes.gif)

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Egal was ich mache, es laufen max. 11 ATLAS WUs parallel, 16 könnten. 40 Threads müßte ich also mit etwas anderen füllen um das Ding auszulasten.

Das bedeutet aber auch dass die Kiste ca. alle 3 Stunden fast 8 GB an WUs runterladen müßte, das wären dann um die 60 GB pro Tag.

Das bedeutet aber auch dass die Kiste ca. alle 3 Stunden fast 8 GB an WUs runterladen müßte, das wären dann um die 60 GB pro Tag.

Maverick-F1

Grand Admiral Special

Und wo ist jetzt das Problem?Das bedeutet aber auch dass die Kiste ca. alle 3 Stunden fast 8 GB an WUs runterladen müßte, das wären dann um die 60 GB pro Tag.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

@Maverick-F1

Ich könnte mit allen Threads an der 90GB Grenze kratzen.

Ah ich habe den 1,6 GB Download gefunden, könnte der CMS Client sein.

Ich könnte mit allen Threads an der 90GB Grenze kratzen.

Doppelposting wurde automatisch zusammengeführt:

Ah ich habe den 1,6 GB Download gefunden, könnte der CMS Client sein.

Maverick-F1

Grand Admiral Special

Ich will hier eigentlich "nur" SixTrack rechnen - aber jeder Rechner kriegt nur genau eine WU (hab' zum Test noch den R9 mitreingenommen). Mach' ich was falsch?

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.904

- Renomée

- 1.435

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Möglicherweise

Schau mal in den Projekteinstellungen, ob die max. Anzahl von WUs auf 1 steht.

Schau mal in den Projekteinstellungen, ob die max. Anzahl von WUs auf 1 steht.

Maverick-F1

Grand Admiral Special

Da hatte ich das letzte Mal noch mit den (nativen) ATLAS-WUs rumgespielt und tatsächlich die Limits übersehen - da hab' ich wohl 'nen Elch verdient!

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Sagt mal, kann es sein das vBox bei der Anzahl der Kerne/Threads limitiert ist?

Mehr als 92 bekomme ich nicht zum laufen.

Mehr als 92 bekomme ich nicht zum laufen.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.853

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Waren die Atlas nicht welche, die gleich mehrere Kerne pro WU nutzen?

Bei mir war das auf 4 CPUs gestellt.

Bei mir war das auf 4 CPUs gestellt.

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.718

- Renomée

- 711

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Ja ATLAS mit mehreren Threads laufen lassen, mit nur einem gibt es massiven Overhead durch vBox und auch nativ durch cvmfs und Singularity. 4-6 Threads ist das Optimum.

Die CMS und Theory sind single threaded.

Auf den 7v12 ließen sich aber auch nicht genug WUs starten um alle Kerne auszulasten, zuvor ging vBox in die Knie und die Berechnung der schon laufenden WUs kam dann kaum noch voran.

Nativ eliminiert man den vBox Spielkram, sollte sich aber einen Squidproxy aufsetzen der den Traffic der ATLAS dann massiv reduziert. Beschreibung dazu findet sich in unserem Wiki.

Die CMS und Theory sind single threaded.

Auf den 7v12 ließen sich aber auch nicht genug WUs starten um alle Kerne auszulasten, zuvor ging vBox in die Knie und die Berechnung der schon laufenden WUs kam dann kaum noch voran.

Nativ eliminiert man den vBox Spielkram, sollte sich aber einen Squidproxy aufsetzen der den Traffic der ATLAS dann massiv reduziert. Beschreibung dazu findet sich in unserem Wiki.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

So richtig weiss ich noch nicht was ich machen soll.

Mit vBox werden nicht alle Threads genutzt und auf den Konfigurationszirkus um die native WUs habe ich keine lust.

Vermutlich schalte ich entweder SMT ab oder setze BOINC auf 50% der Kerne um den gleichen Effekt zu haben. Dann rauschen halb so viele WUs halt schneller durch.

Mit vBox werden nicht alle Threads genutzt und auf den Konfigurationszirkus um die native WUs habe ich keine lust.

Vermutlich schalte ich entweder SMT ab oder setze BOINC auf 50% der Kerne um den gleichen Effekt zu haben. Dann rauschen halb so viele WUs halt schneller durch.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.853

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

So richtig viel hatten meine Rechner nicht eingelagert und liefen alle leer. Die haben jeweils nur 88 WUs bekommen. Und da waren wohl zu viele WUs drin, die nach wenigen Sekunden schon wieder als beendet gelten.

Egal, auf gehts!

Egal, auf gehts!

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Die CMS WUs kann ich getrost knicken, da kam bisher zu 100% nur Schrott raus.

enigmation

Admiral Special

Kannst du mal einmal das Fehlerlog posten von der Task?Die CMS WUs kann ich getrost knicken, da kam bisher zu 100% nur Schrott raus.

Bei mir funktionieren die Theory native grad zu 100% ...

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

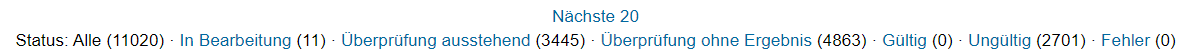

Ich verlinke einfach mal den besagten Rechner: https://lhcathome.cern.ch/lhcathome/results.php?hostid=10644354

Beim Ablauf kann ich keinen Fehler erkennen aber beim Arbeitspaket sagt er bei 1 von 1 WUs als Fehler zu "viele Ergebnisse"

Seit alle anderen WUs durch sind scheinen 10 WUs seit 4-7 Stunden noch zu laufen, 6 wurden verdrängt und die einzigen anderen WUs die noch laufen sind 3 WCG Regenwolken.......bei 64 Kernen/128 Threads, 128GB RAM die zu 95% von BOINC genutzt werden dürfen und einer 500GB SSD bei der BOINC 10 GB frei lassen soll.

Beim Ablauf kann ich keinen Fehler erkennen aber beim Arbeitspaket sagt er bei 1 von 1 WUs als Fehler zu "viele Ergebnisse"

Seit alle anderen WUs durch sind scheinen 10 WUs seit 4-7 Stunden noch zu laufen, 6 wurden verdrängt und die einzigen anderen WUs die noch laufen sind 3 WCG Regenwolken.......bei 64 Kernen/128 Threads, 128GB RAM die zu 95% von BOINC genutzt werden dürfen und einer 500GB SSD bei der BOINC 10 GB frei lassen soll.

enigmation

Admiral Special

Dieses VM Heartbeat file scheint zu fehlen.

Laut diesem Post im LHC-Forum kann es problematisch sein, zu vieleTheory CMS auf einmal zu starten. Bei deinem 64-Kerner kann ich mir das gut vorstellen.

Laut diesem Post im LHC-Forum kann es problematisch sein, zu viele

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Es ging ja um die CMS und nicht um die Theorie WUs. Letztere neigen eher dazu sich festzufressen.

Zudem nutze ich nur noch die vBox WUs weil ich keine Lust mehr auf den Zirkus um die native WUs habe. Sollten die mal ohne Zusatzarbeiten vernünfig laufen würde ich sie gern wieder aktivieren.

Das Projekt scheint verdammt schlecht auf heutige Prozessoren vorbereitet zu sein......

Zudem nutze ich nur noch die vBox WUs weil ich keine Lust mehr auf den Zirkus um die native WUs habe. Sollten die mal ohne Zusatzarbeiten vernünfig laufen würde ich sie gern wieder aktivieren.

Das Projekt scheint verdammt schlecht auf heutige Prozessoren vorbereitet zu sein......

enigmation

Admiral Special

Ich glaub, das Posting im LHC-Forum bezog sich auch auf CMS. Hab meinen Beitrag daher editiert.

Ich geb dir Recht, das ist nix, was man dann einfach so laufen lassen kann bei dieser hohen Fehlerquote einfach nur durch zu viele Kerne.

Ich geb dir Recht, das ist nix, was man dann einfach so laufen lassen kann bei dieser hohen Fehlerquote einfach nur durch zu viele Kerne.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

So langsam habe ich auch den Durchblick warum die Anzahl der laufenden WUs begrenzt wurde.

Die ATLAS vBox WU scheint 10GB RAM zugeteilt zu bekommen, Theorie vBox war mit 2,3 GB dabei und die bisherigen fehlerhaften CMS vBox WUs bekamen 1,9 GB.

Die ATLAS vBox WU scheint 10GB RAM zugeteilt zu bekommen, Theorie vBox war mit 2,3 GB dabei und die bisherigen fehlerhaften CMS vBox WUs bekamen 1,9 GB.

Cashran

Admiral Special

- Mitglied seit

- 28.01.2005

- Beiträge

- 1.519

- Renomée

- 223

- Standort

- Vortex Rikers

- Aktuelle Projekte

- MilkyWay, LHC, yoyo, Universe, Primegrid,

- Meine Systeme

- R9 3900X/R7790 R7 3800X/R480

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD R7 1700X

- Mainboard

- Biostar X470NH

- Kühlung

- boxed

- Speicher

- 2x 16 GB GSkill 3200@XMP

- Grafikprozessor

- HD 7790

- Display

- 21,5" Benq GL2240 1080

- HDD

- 1TB 2,5"

- Soundkarte

- Onboard Sound

- Netzteil

- bequiet 400W

- Betriebssystem

- Windows 10, VM LMDE

- Webbrowser

- Firefox, Opera, IE

Und einfach mehrere VMs laufen lassen ist keine Option?

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ausgehend von der Speicherbelegung bräuchte ich ca. 320GB RAM nur für BOINC wenn ich alle 128 Threads uneingeschränkt nutzen wollte, allerdings scheint die gleichzeitig laufenen CMS WUs durch irgendetwas auf 10 limitiert zu sein. Mit 2 GB RAM pro Thread sollte man also rechnen.

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.659

- Renomée

- 1.061

- Aktuelle Projekte

- MW@H; TN Grid, Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.718

- Renomée

- 711

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Sixtrack sollte durch mehrere VMs oder einfach auch nur mehrere Instanzen kein Problem sein.

Der BOINC vmwrapper und vBox sind einfach nicht fit genug um eine hohe Anzahl von VMs zu verwalten.

Auf Thorsams Systemen mit CMS WUS fraß irgendwann vBox selbst die meisten CPUs und es blieb für die Jobs kaum mehr was über bzw. brachen die auch ab. Das taugt höchsten für Systeme bis 32 Threads würde ich meinen und dann würde ich auch Sixtrack unter mischen, einfach um die RAM Anforderungen niedrig zu halten.

Der BOINC vmwrapper und vBox sind einfach nicht fit genug um eine hohe Anzahl von VMs zu verwalten.

Auf Thorsams Systemen mit CMS WUS fraß irgendwann vBox selbst die meisten CPUs und es blieb für die Jobs kaum mehr was über bzw. brachen die auch ab. Das taugt höchsten für Systeme bis 32 Threads würde ich meinen und dann würde ich auch Sixtrack unter mischen, einfach um die RAM Anforderungen niedrig zu halten.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.979

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich starte noch eine Runde mit dem kleinen Matze Cruncher.

Dessen 3850x hat 64 GB RAM und käme damit auf die besagten 2 GB pro Thread.

Soooo....

4x ATLAS vBox WUs (je 8 Core) laufen schonmal parallel, die RAM Auslastung liegt bei ca. 49%.

Edit: Zwischenzeitlich ist die Speicherauslastung auf 53% geklettert.

Dessen 3850x hat 64 GB RAM und käme damit auf die besagten 2 GB pro Thread.

Doppelposting wurde automatisch zusammengeführt:

Soooo....

4x ATLAS vBox WUs (je 8 Core) laufen schonmal parallel, die RAM Auslastung liegt bei ca. 49%.

Edit: Zwischenzeitlich ist die Speicherauslastung auf 53% geklettert.

Zuletzt bearbeitet:

Ereignishorizont

Lieutnant

- Mitglied seit

- 20.07.2021

- Beiträge

- 72

- Renomée

- 44

Ich bin jetzt erst mal auf Sixtrack umgestiegen. Da werden wenigstens alle Threads genutzt und die Kisten sind nicht ununterbrochen am Runterladen. CMS und ATLAS rechne ich natürlich was runtergeladen wurde.

Den 3900X habe ich dann doch angeworfen. Bei den Sixtrack-WUs geht das - die brauchen nur sehr wenig Arbeitsspeicher.

Den 3900X habe ich dann doch angeworfen. Bei den Sixtrack-WUs geht das - die brauchen nur sehr wenig Arbeitsspeicher.

- Status

- Für weitere Antworten geschlossen.

Ähnliche Themen

- Antworten

- 308

- Aufrufe

- 16K

- Antworten

- 128

- Aufrufe

- 7K

- Antworten

- 0

- Aufrufe

- 274