App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Prognose-Board: Wie geht es bei AMD weiter? Entwicklungen / Strategien / Maßnahmen, die AMD betreffen bzw. die AMD treffen könnte

- Ersteller BavarianRealist

- Erstellt am

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Dann gehst du bei einer solchen Intel Seite die zur Messung ein nvidia Tool verwendet hat davon aus das sie eine AMD freundliche Berichterstattung machen?

Bei Golem steht halt nichst vom zeitlichen Anteil drin des hohen idle Verbrauchs wohingegen Computerbase mit dem nvidia Toll sogar einen zeitlichen Verlauf liefert.

Dort scheiben sie von 16W Grundverbrauch der XTX der durch die Peaks auf einen Durchschnittsverbrauch von 19W hochgeschraubt wurde.

War es nicht so das es auch bei der Vorstellung der 6000er Serie sehr unterschiedliche Angaben zum Idle Verbrauch gab weil es Probleme mit dem Erreichen des idle Taktes gab?

Bei Golem steht halt nichst vom zeitlichen Anteil drin des hohen idle Verbrauchs wohingegen Computerbase mit dem nvidia Toll sogar einen zeitlichen Verlauf liefert.

Dort scheiben sie von 16W Grundverbrauch der XTX der durch die Peaks auf einen Durchschnittsverbrauch von 19W hochgeschraubt wurde.

War es nicht so das es auch bei der Vorstellung der 6000er Serie sehr unterschiedliche Angaben zum Idle Verbrauch gab weil es Probleme mit dem Erreichen des idle Taktes gab?

Leider nein. RDNA2 war im idle besser.Beim Strombedarf bewegt man sich abgesehen von der Video Wiedergabe im Rahmen der Konkurrenz,

Aber wenn es nur Peaks sind - kann und muss AMD hier nachbessern (einige berichten von Treibercrashes und BlackScreen issues).

Die Frage ist nur, warum AMD dies nicht bislang nicht treiberseitg/hardwareseitig(?) korrigieren konnte.

Es ist ja nicht so, dass AMD den Launch spontan vorgezogen haette.

Idle und Desktop ist keine exotische Anwendung. Es ist kein Beinbruch - aber so was sollte nicht passieren IMHO.

Jeder Tester wird das finden und im Inet erst mal im Review verewigen.

Gruss,

TNT

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.371

- Renomée

- 9.696

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Aber doch nicht abwechselnd über 60 und unter 20 W. Da macht der Treiber noch Probleme beim Strom sparen. Lies mal den Golem-Test.

Golem.de: IT-News für Profis

Eigentlich haetten die Treiberprobleme bei Golem auch mit ins Fazit gehört.

Wenn man die Tests so liest, offenbart sich allerdings in der Beurteilung ein sehr inhomogenes Bild. Bei manchen kommt die Karte gerade im Hinblick auf die Effizienzprobleme für mich überraschend gut weg. Aber ich gehöre halt auch nicht zur Zielgruppe.

Frage ist halt, was über Treiber noch zu regeln ist. Hier muss AMD definitiv zum Launch einfach besser aufgestellt sein. Wenn man bedenkt, dass FSR 3.0 allerdings auch noch kommt, kann es sein, dass man die Karten in einem halben Jahr ganz anders bewerten muss.

Letztendlich muss man aber auch noch immer in Betracht ziehen, dass AMD mit der Personalstärke von Nvidia (bzw jetzt wohl eher etwas darüber) nicht nur GPU, sondern auch CPU stemmt.

Es bleibt einfach dabei, was in Zukunft für AMD wichtig ist:

Software, Software und Software.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ähm nein, die RDNA2 Modelle stehen nicht in Konkurrenz zu der aktuellen Generation, dafür liegen sie einfach vom Preis und der Leistung her zu weit aus einander.Leider nein. RDNA2 war im idle besser.

Konkurrenz zur 7900XTX ist aktuell die 4080 die in idle (1 Monitor) ebenfalls mit 19W Durchschnittsverbrauch dabei war.

Die 7900XT ist hingegen fast konkurrenzlos weil sie von der Rasterleistung her ca. auf der Höhe der 3090Ti liegt, welche aber wiederum 25W in idle schluckte.

und entsprechende Kommunikation dazu in den Markt... bzw. ich wuerde mir bei AMD mehr Realismus/Auswahl im aktuellen Angebotsportfolio wuenschen (es geht gerade eben nicht immer nur alles besser und hoeher im Markt - AMD wurde verwoehnt in den letzten Jahren).Software, Software und Software.

Flagschiffe allein bringen es nicht fuer AMD - wenn diese der absoluten Leistungsspitze doch deutlich hinterherlaufen - dann vielleicht schneller in die Breite gehen!?

Was mir persoenlich immer noch schwerfaellt einer Grafikkarte fuer das Gamining fuer >1k ein gutes Preisleistungsverhaeltnis zu bescheinigen oder zu sagen, dass sie guenstig sei. Das Preisgefuege ist einfach irre IMHO - egal welches Lager.

Wird das schon als Normalitaet empfunden?

Auch in Anbetracht des Preises sollte AMD doch so etwas wie die Verbrauchsprobleme erst gar nicht aufkommen lassen (da jeder Test das finden wird...sind das sehr aussenwirksame Probleme IMHO). Aber nun ist es so und es wird (oder vielleicht wurde schon!?) nachgebessert.

Dass einige wenige Spiele mal crashen etc. halte ich nun fuer nicht so tragisch.

Gruss,

TNT

Doppelposting wurde automatisch zusammengeführt:

Das ist es wieder ... AMD hat sich in der Praese selbst zu seiner nun alten Generation in den Vergleich gesetzt.Ähm nein, die RDNA2 Modelle stehen nicht in Konkurrenz zu der aktuellen Generation

Und natuerlich stehen die neuen Modelle mit den alten solange noch angeboten in der Konkurrenz im Markt, in den Benchmarks usw. - ob man das nun mag oder nicht.

Herje,

TNT

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.724

- Renomée

- 433

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Es geht nicht um Tools, sondern um den Text. Bei neuer Hardware stellt man die Neuerungen vor. Wenn man dafür angeblich keine Zeit hat (Häh?) und darüber hinaus alles aufzählt, was NICHT verbessert wurde (Wozu??), und der Text insgesamt so negativ klingt, wie meistens bei AMD auf dieser "völlig neutralen" Seite, dann weiß man halt Bescheid.ein nvidia Tool

Zeit und Personal-Ressourcen, siehst du an FSR 3.0. Das sollte bestimmt zum Launch fertig sein.Die Frage ist nur, warum AMD dies nicht bislang nicht treiberseitg korrigieren konnte.

Verbrauchsoptimierung ist ein typisches Ding, was man hinten anstellt. Gerade auch im Multimonitor-Setup kamen schon öfter Fixes mit den nächsten Treibern. Zum Launch sind Performance und Stabilität wichtiger.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Worauf sollen sie sich sonst beziehen wenn es um das Aufzeigen von Verbesserungen geht?Das ist es wieder ... AMD hat sich in der Praese selbst zu seiner nun alten Generation in den Vergleich gesetzt.

Und natuerlich stehen die neuen Modelle mit den alten solange noch angeboten in der Konkurrenz im Markt, in den Benchmarks usw. - ob man das nun mag oder nicht.

Was hat das aber mit einer Konkurrenzsituation von Produkten zu tuen?

2 unterschiedliche Baustellen.

Doppelposting wurde automatisch zusammengeführt:

Eben, und im Text von Golem stand nur das der Verbrauch auf diesen Wert kommt aber nicht für wie lange. War vielleicht genau das mit "häufig" gemeint?Es geht nicht um Tools, sondern um den Text. Bei neuer Hardware stellt man die Neuerungen vor. Wenn man dafür angeblich keine Zeit hat (Häh?) und darüber hinaus alles aufzählt, was NICHT verbessert wurde (Wozu??), und der Text insgesamt negativ klingt, wie meistens bei AMD auf dieser "völlig neutralen" Seite, dann weiß man halt Bescheid.

Genau das schließt aber der Abschnitt bei Computerbase mit ein und da sich der Wert des Strombedarfs am Ende immer auf einen Durchschnittswert in einem bestimmten Zeitraum bezieht sind solche Peak Angaben sür sich erstmal wertlos wenn die Stromversorgung sie liefern kann und davon kann man getrost ausgehen.

Zuletzt bearbeitet:

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.724

- Renomée

- 433

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Wenn die Grafikkarte nichts zu tun hat, sollte sie eigentlich permanent im Stromsparmodus verbleiben. Wird der öfter unterbrochen, gibt's da noch ein Treiberproblem. Verbesserungsbedarf bei den Treibern wird auch bei anderen Reviews erwähnt.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Das ist die Frage, wenn der Framebuffer mit dem vorgehaltenen aktuellen Bild im VRAM liegt müßte vermutlich der gesammte Rattenschwanz bis dort hin aktiviert werden um es dort zu aktualisieren.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.724

- Renomée

- 433

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Für so ne kleine Teilaufgabe? Nee.... Auch PCGH schreibt "Technisch spricht wenig gegen Nachbesserungen".

Zitat:

Zitat:

"Bei den Linux-Benchmarks von Phoronix ist der Idle-Verbrauch anscheinend konstant niedrig, das weist definitiv auf ein Treiberproblem o. ä. hin, das nur den Windows-Treiber betrifft.

Und der Linux-Support scheint insgesamt gut zu sein - im Test lief mit aktuellen Releases vom Kernel und Mesa das meiste Zeug out of the box.

Zuletzt bearbeitet:

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

Ein Freesync Monitor macht einen solchen Refresh in der Regel eigenständig. Hat da mal jemand den Monitor im Testsetup genauer angeschaut? Leider unterwegs, sonst hätte ich das selber nachgeschaut.

- Mitglied seit

- 16.10.2000

- Beiträge

- 24.371

- Renomée

- 9.696

- Standort

- East Fishkill, Minga, Xanten

- Aktuelle Projekte

- Je nach Gusto

- Meine Systeme

- Ryzen 9 5900X, Ryzen 7 3700X

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Samsung P35 (16 Jahre alt ;) )

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 5900X

- Mainboard

- ASRock B550

- Speicher

- 2x 16 GB DDR4 3200

- Grafikprozessor

- GeForce GTX 1650

- Display

- 27 Zoll Acer + 24 Zoll DELL

- SSD

- Samsung 980 Pro 256 GB

- HDD

- diverse

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design R5

- Netzteil

- be quiet! Straight Power 10 CM 500W

- Tastatur

- Logitech Cordless Desktop

- Maus

- Logitech G502

- Betriebssystem

- Windows 10

- Webbrowser

- Firefox, Vivaldi

- Internetanbindung

- ▼250 MBit ▲40 MBit

Samsung puts processing-in-memory chip onto AMD MI100 GPU

Korean tech giant claims big performance, energy efficiency gains with memory tech

Samsung has built a claimed first-of-its-kind supercomputer containing AMD datacenter GPUs affixed with its processing-in-memory chips, which the company said can significantly improve the performance and energy efficiency of training large AI models.

Interessant, dass Samsung da AMD Instinct MI100 für gewählt hat.

PIM | Technology | Samsung Semiconductor Global

Samsung is accelerating the capabilities of AI by becoming the first company to integrate Processing-in-Memory(PIM) in High Bandwidth Memory(HBM).

Complicated

Grand Admiral Special

- Mitglied seit

- 08.10.2010

- Beiträge

- 4.949

- Renomée

- 441

- Mein Laptop

- Lenovo T15, Lenovo S540

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 3700X

- Mainboard

- MSI X570-A PRO

- Kühlung

- Scythe Kama Angle - passiv

- Speicher

- 32 GB (4x 8 GB) G.Skill TridentZ Neo DDR4-3600 CL16-19-19-39

- Grafikprozessor

- Sapphire Radeon RX 5700 Pulse 8GB PCIe 4.0

- Display

- 27", Lenovo, 2560x1440

- SSD

- 1 TB Gigabyte AORUS M.2 PCIe 4.0 x4 NVMe 1.3

- HDD

- 2 TB WD Caviar Green EADS, NAS QNAP

- Optisches Laufwerk

- Samsung SH-223L

- Gehäuse

- Lian Li PC-B25BF

- Netzteil

- Corsair RM550X ATX Modular (80+Gold) 550 Watt

- Betriebssystem

- Win 10 Pro.

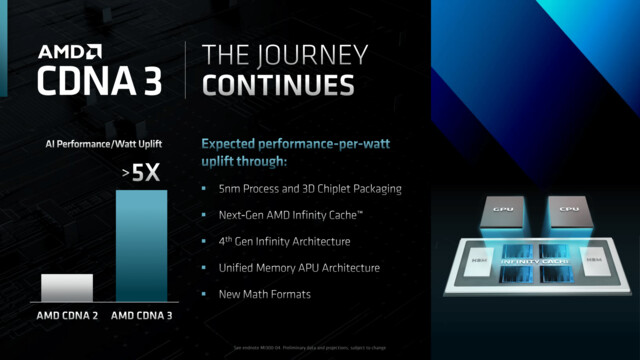

Wäre doch genau der richtige Speicher für die CDNA3-APU MI300:

Pinnacle Ridge

Vice Admiral Special

- Mitglied seit

- 04.03.2017

- Beiträge

- 528

- Renomée

- 7

Kann es sein, daß dieser Speicher von den NVIDIA GPUs nicht unterstützt wird?

Hier bleibt AMD nicht ganz kritiklos.

Klingt als ob da jemand enttaeuscht waere - aber ganz unrecht ha der Artikel nicht IMHO.

www.heise.de

www.heise.de

Ob die Branche - vorweg Nvidia und AMD sowie Intel zusammen eine Kehrtwende hin bekommen oder geht die Entwicklung so weiter!?

Gruss und Danke,

TNT

Klingt als ob da jemand enttaeuscht waere - aber ganz unrecht ha der Artikel nicht IMHO.

Das stromschluckende Hardware-Jahr 2022: Haben die alle Lack gesoffen?

Bitte weiterscrollen, hier gibt es nichts zu lesen – außer einer Tirade über die Hardware-Vorstellungen aus dem Jahr 2022.

Ob die Branche - vorweg Nvidia und AMD sowie Intel zusammen eine Kehrtwende hin bekommen oder geht die Entwicklung so weiter!?

Gruss und Danke,

TNT

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.724

- Renomée

- 433

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Heise ist bei dem Thema irgendwie "geschädigt" (Noch nie ein BIOS von innen gesehen?)

"ALLE Mainboards MÜSSEN den schnellsten 16-Kerner bei höchster TDP unterstützen?"

- Klingt doof, ist aber auch falsch. An die Gegenbeispiele können wir uns noch gut erinnern. Warum kein Mainboard-Hersteller mehr davon Gebrauch macht, ist mir auch nicht klar, das wurde im Laufe der AM4-Evoluation wieder abgeschafft.

Und was hätte wohl in den Reviews gestanden, wenn sie es NICHT gemacht hätten?

"ALLE Mainboards MÜSSEN den schnellsten 16-Kerner bei höchster TDP unterstützen?"

- Klingt doof, ist aber auch falsch. An die Gegenbeispiele können wir uns noch gut erinnern. Warum kein Mainboard-Hersteller mehr davon Gebrauch macht, ist mir auch nicht klar, das wurde im Laufe der AM4-Evoluation wieder abgeschafft.

Und was hätte wohl in den Reviews gestanden, wenn sie es NICHT gemacht hätten?

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Es ist durchaus klar denn damals war so mancher Spannungswandler solcher Mainboards verreckt wenn ein Prozessor mit zu hoher TDP draufgeschnallt wurde udn wer weiß mit wievielen Support Anfragen die sonst noch überschwemmt wurde weil deshalb kein Post erfolgte oder der überlastete und deshalb überhitzte Spannungswandler die Taktfrequenz der Prozessoren ins Bodenlose drosselte.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.724

- Renomée

- 433

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

So klar finde ich das nicht, es stand groß und breit auf den Webseiten, den Spezifikationen, im Handbuch, auf der Verpackung. Außerdem waren solche Kombinationen (16-Kerner mit dem billigsten A320-Board) schon an sich so bescheuert, dass das niemand gemacht hätte.

Weiß nicht, wie die das gehandhabt haben, aber technisch ist es mit Sicherheit möglich, die CPU beim Post als "nicht unterstützt" erkennen und einfach beim Basistakt zu bleiben. Dann überhitzt auch nichts. Autoteile passen ja auch nicht überall, bei beidem muss man halt gucken, was man bestellt.

Auf der anderen Seite locken klare Argumente in Form von Kostenersparnissen.

Weiß nicht, wie die das gehandhabt haben, aber technisch ist es mit Sicherheit möglich, die CPU beim Post als "nicht unterstützt" erkennen und einfach beim Basistakt zu bleiben. Dann überhitzt auch nichts. Autoteile passen ja auch nicht überall, bei beidem muss man halt gucken, was man bestellt.

Auf der anderen Seite locken klare Argumente in Form von Kostenersparnissen.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Was würdest du machen wenn du mit den billigsten Produkten die zudem die geringste Gewinnspanne haben den meisten Ärger/Support Aufwand im Endkunden Markt hättest?

Ich für meinen Teil würde genau diese einstellen und mich damit auf den OEM Markt beschränken weil an den Dingern bis zum Ablauf der Garantie normalerweise eh nichts verändert wird und danach wäre es nicht mehr mein Problem.

Im übrigen gab es bei AM4 nicht nur die 16 Kerner mit der max. TDP aber schon immer Pfennigfuchser mit unzureichenden technischen Verständnis und fehlender Selbstkritik/Eigenverantwortung.

Basistakt ist übrigens genau das was bei den sonstigen Specs garantiert wird und dazu gehört auch die TDP. Die Boards müßten die CPUs also von Anfang an entsprechend drosseln um in die max. unterstützte TDP zu passen. Schon sind wir bei Support Anfragen wegen zu geringen Takt/Performance.

Selbst bei den AM4 Boards die dafür freigegeben waren gab es Modelle bei denen der Spannungswandler bei Dauervollast überhitzte wenn der nicht genug Airflow abbekam und die CPU darauf hin gedrosselt wurde um ihn zu entlasten/abkühlen zu lassen. Gerade im DC Bereich "durfte" ich damit schon mehr als genug Erfahrungen sammeln.

Ich für meinen Teil würde genau diese einstellen und mich damit auf den OEM Markt beschränken weil an den Dingern bis zum Ablauf der Garantie normalerweise eh nichts verändert wird und danach wäre es nicht mehr mein Problem.

Im übrigen gab es bei AM4 nicht nur die 16 Kerner mit der max. TDP aber schon immer Pfennigfuchser mit unzureichenden technischen Verständnis und fehlender Selbstkritik/Eigenverantwortung.

Basistakt ist übrigens genau das was bei den sonstigen Specs garantiert wird und dazu gehört auch die TDP. Die Boards müßten die CPUs also von Anfang an entsprechend drosseln um in die max. unterstützte TDP zu passen. Schon sind wir bei Support Anfragen wegen zu geringen Takt/Performance.

Selbst bei den AM4 Boards die dafür freigegeben waren gab es Modelle bei denen der Spannungswandler bei Dauervollast überhitzte wenn der nicht genug Airflow abbekam und die CPU darauf hin gedrosselt wurde um ihn zu entlasten/abkühlen zu lassen. Gerade im DC Bereich "durfte" ich damit schon mehr als genug Erfahrungen sammeln.

derDruide

Grand Admiral Special

- Mitglied seit

- 09.08.2004

- Beiträge

- 2.724

- Renomée

- 433

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 3900X

- Mainboard

- Asus Strix B450-F Gaming

- Kühlung

- Noctua NH-C14

- Speicher

- 32 GB DDR4-3200 CL14 FlareX

- Grafikprozessor

- Radeon RX 590

- Display

- 31.5" Eizo FlexScan EV3285

- SSD

- Corsair MP510 2 TB, Samsung 970 Evo 512 GB

- HDD

- Seagate Ironwulf 6 TB

- Optisches Laufwerk

- Plextor PX-880SA

- Soundkarte

- Creative SoundblasterX AE-7

- Gehäuse

- Antec P280

- Netzteil

- be quiet! Straight Power E9 400W

- Maus

- Logitech Trackman Marble (Trackball)

- Betriebssystem

- openSUSE 15.2

- Webbrowser

- Firefox

- Internetanbindung

- ▼50 MBit ▲10 MBit

Ist die Frage, ob die Gesamtrechnung wirklich so schlecht aussieht. Die Hersteller sparen bei jedem Mainboard Geld für die Stromversorgung, Leiterbahnen und Kühlung. Das steht schon mal auf der Haben-Seite, auch für alle Boards, die korrekt bestückt werden. Dazu kommen zusätzliche Kunden, die genau solche Platinen wollen (wegen geringerem Preis und höherer Effizienz). Sie profitieren ja auch davon.

Nur wenige Honks werden vorhaben, eine Hochleistungs-CPU darauf einzusetzen. Davon werden viele die zig Hinweise sehen. Andere fragen in Foren nach, und bekommen ein "WHAT?". Die nächsten fallen weg, wenn das Board funktioniert, nur nicht ganz so schnell, weil sie das gar nicht merken. Wir sind wie gesagt im Bereich "Bastler ohne Ahnung, der sich trotzdem selbst einen Rechner baut."

Weitere fallen weg, weil sie ihren eigenen Fehler bemerken, wissen, dass sie selbst Schuld sind, und ihnen der erneute Umbau / Einschicken / auf den PC verzichten zu aufwändig wäre. Sowas wird wegen eigenem Verschulden sowieso nicht akzeptiert, wenn man nicht innerhalb von zwei Wochen nach dem Kauf schon Zeit hatte, alles zusammen zu bauen und das Problem korrekt zu diagnostizieren.

Um die paar, die dann noch übrig bleiben, kümmert sich soweit ich weiß der Händler. Den Fehler "Board passt nicht zur CPU" sieht der Händler, sowas geht IMHO gar nicht erst zum Hersteller. Erst wenn die Händler so ein Board auslisten würden, weil zu viele Honks durchs Raster fallen, hätte der Hersteller ein Problem.

Man kann es ja in den Modellnamen aufnehmen, z. B. "ASRock A620 Extreme Green Edition 65 W" . Deutlicher geht's dann wirklich nicht mehr, und für Office-PCs würde ich das bevorzugt kaufen.

. Deutlicher geht's dann wirklich nicht mehr, und für Office-PCs würde ich das bevorzugt kaufen.

PS: DC ist schon so speziell, dass es zahlenmäßig nicht ins Gewicht fällt. Mit Basistakt meinte ich "irgendwas, was funktioniert, ohne zu überhitzen", auch generell drosseln.

Nur wenige Honks werden vorhaben, eine Hochleistungs-CPU darauf einzusetzen. Davon werden viele die zig Hinweise sehen. Andere fragen in Foren nach, und bekommen ein "WHAT?". Die nächsten fallen weg, wenn das Board funktioniert, nur nicht ganz so schnell, weil sie das gar nicht merken. Wir sind wie gesagt im Bereich "Bastler ohne Ahnung, der sich trotzdem selbst einen Rechner baut."

Weitere fallen weg, weil sie ihren eigenen Fehler bemerken, wissen, dass sie selbst Schuld sind, und ihnen der erneute Umbau / Einschicken / auf den PC verzichten zu aufwändig wäre. Sowas wird wegen eigenem Verschulden sowieso nicht akzeptiert, wenn man nicht innerhalb von zwei Wochen nach dem Kauf schon Zeit hatte, alles zusammen zu bauen und das Problem korrekt zu diagnostizieren.

Um die paar, die dann noch übrig bleiben, kümmert sich soweit ich weiß der Händler. Den Fehler "Board passt nicht zur CPU" sieht der Händler, sowas geht IMHO gar nicht erst zum Hersteller. Erst wenn die Händler so ein Board auslisten würden, weil zu viele Honks durchs Raster fallen, hätte der Hersteller ein Problem.

Man kann es ja in den Modellnamen aufnehmen, z. B. "ASRock A620 Extreme Green Edition 65 W"

PS: DC ist schon so speziell, dass es zahlenmäßig nicht ins Gewicht fällt. Mit Basistakt meinte ich "irgendwas, was funktioniert, ohne zu überhitzen", auch generell drosseln.

Zuletzt bearbeitet:

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Der Endkundenmarkt ist auch nur relativ klein, in der Preisklasse sind die Gewinne pro Stück für gewöhnlich noch viel kleiner denn da kommt der Gewinn über die Masse und die Masse setzen eher die OEMs ab.

Warum sollten sich die Board Hersteller also die Gewinne durch unnötige Support Anfragen aus dem Endkunden Markt auffressen lassen? Der Support bei Endkunden Produkten kostet dem Hersteller nunmal Geld. Was sich nicht rentiert wird eben in absehbarer Zeit eingestellt.

Den Basistakt von Prozessor XY gibt dessen Spec wieder, was du meinst ist Drosselung und da sind wir wieder ganz schnell bei Support Anfragen an den Hersteller.

Des weiteren solltest du nicht vergessen das es um AMD geht wo schnell mal aus jeder Mücke ein Elefant gemacht wird. Oder glaubt jemand ernsthaft das bei Intel die billigen B660 mit ihren schwachbrüstigen Spannungswandlern bis zu +250W des Turbos liefern können? Entsprechend dürfte dann auch der Einfluss auf die Performance der Prozessoren ausfallen.

Hindert dennoch niemanden die Dinger für AM5 Preis Diskussionen anzuschleppen weil man ja auch die großen Prozessoren draufschnallen darf.

Warum sollten sich die Board Hersteller also die Gewinne durch unnötige Support Anfragen aus dem Endkunden Markt auffressen lassen? Der Support bei Endkunden Produkten kostet dem Hersteller nunmal Geld. Was sich nicht rentiert wird eben in absehbarer Zeit eingestellt.

Den Basistakt von Prozessor XY gibt dessen Spec wieder, was du meinst ist Drosselung und da sind wir wieder ganz schnell bei Support Anfragen an den Hersteller.

Des weiteren solltest du nicht vergessen das es um AMD geht wo schnell mal aus jeder Mücke ein Elefant gemacht wird. Oder glaubt jemand ernsthaft das bei Intel die billigen B660 mit ihren schwachbrüstigen Spannungswandlern bis zu +250W des Turbos liefern können? Entsprechend dürfte dann auch der Einfluss auf die Performance der Prozessoren ausfallen.

Hindert dennoch niemanden die Dinger für AM5 Preis Diskussionen anzuschleppen weil man ja auch die großen Prozessoren draufschnallen darf.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Was es liefern können muss um alle Modelle abzudecken gibt AMD vor denn das ist Teil der CPU Specs.

Wie es letztendlich dimensioniert wird obliegt natürlich den Board Herstellern die letztendlich auch den Support dafür tragen müssen.

Wenn es wiederum so dimensioniert wird das nicht alle TDP Klassen abgedeckt werden können müßten diese dann die nicht unterstützten Modelle sperren damit der Spannungswandler keine Probleme bekommt oder das Board selbst beim Einsetzen eines zu stromhunrigen Modells beschädigt wird, was aber wiederum ein Mehraufwand beim BIOS Support und vermutlich auch beim Testaufwand wäre. Mehr Aufwand = mehr Kosten.

Wie es letztendlich dimensioniert wird obliegt natürlich den Board Herstellern die letztendlich auch den Support dafür tragen müssen.

Wenn es wiederum so dimensioniert wird das nicht alle TDP Klassen abgedeckt werden können müßten diese dann die nicht unterstützten Modelle sperren damit der Spannungswandler keine Probleme bekommt oder das Board selbst beim Einsetzen eines zu stromhunrigen Modells beschädigt wird, was aber wiederum ein Mehraufwand beim BIOS Support und vermutlich auch beim Testaufwand wäre. Mehr Aufwand = mehr Kosten.

Pinnacle Ridge

Vice Admiral Special

- Mitglied seit

- 04.03.2017

- Beiträge

- 528

- Renomée

- 7

Früher bei AM2/AM3 gab es doch Bretter, die bei der TDP limitiert waren?

Oder bilde ich mir das nur ein?

Oder bilde ich mir das nur ein?

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.374

- Renomée

- 1.978

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Gab es....und sorgten im Endkundenmarkt gern mal für Probleme weil kaum jemand die technischen Daten gelesen sondern das Board nur nach dem Preis gekauft hatte und dann kam eben die böse Überraschung und das Geschrei war groß.

Bei OEM Systemen interessiert das nicht weil die für gewöhnlich nicht aufgerüstet sondern ausgetauscht werden.

Bei OEM Systemen interessiert das nicht weil die für gewöhnlich nicht aufgerüstet sondern ausgetauscht werden.

Ähnliche Themen

- Antworten

- 731

- Aufrufe

- 50K

- Antworten

- 0

- Aufrufe

- 2K

- Antworten

- 0

- Aufrufe

- 1K

- Antworten

- 763

- Aufrufe

- 100K