App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

- Foren

- Planet 3DNow! Community

- Planet 3DNow! Distributed Computing

- Team Planet 3DNow!

- Café Planet 3DNow!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

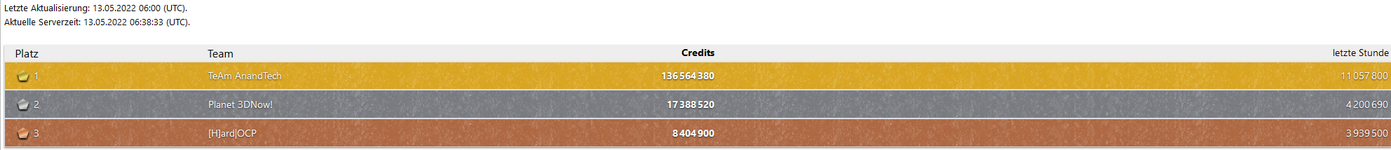

13. Pentathlon 2022: Stadtlauf (Einstein@home)

- Ersteller Nero24

- Erstellt am

Olle Kalesche

Admiral Special

- Mitglied seit

- 02.04.2015

- Beiträge

- 1.126

- Renomée

- 72

- Standort

- Hessen

- Aktuelle Projekte

- Seti , Einstein , und andere

- Meine Systeme

- AMD Athlon 5350 , (AMD Athlon II X4 610e)

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Athlon(tm) 5350 APU with Radeon(tm) R3 @2100

- Mainboard

- ASRock AM1B-ITX

- Kühlung

- standard

- Speicher

- 1x Crucial Technology 8GB, BLT8G3D1608ET3LX0 800.0 MHz (DDR3-1600 / PC3-12800) @8,8,8,1T

- Grafikprozessor

- GTX 750Ti

- Display

- 27", SAMSUNG , T27C370, 1920 x 1080

- HDD

- Seagate ST2000DM001-9YN1

- Optisches Laufwerk

- Liteon, ATAPI iHAS624 B

- Soundkarte

- intern

- Gehäuse

- Sharkoon T28

- Netzteil

- Cooler Master V450S (450W,gold)

@koschi

Eine WU habe ich losgelassen. Status in den 3-4 Minuten knapp 10%. Der Lüfter der GPU ist gerade angelaufen.

Wenn das möglicherweise plausibel weitergeht , dann lass ich die paar heute Nacht berechnen. Morgen steht dann Material zur Verfügung , welches man überprüfen kann. Ansonsten , wie gesagt wird die Kiste degradiert zum Marathon.

Auf 11 Kernen rechnet das NB Universe.

Eine WU habe ich losgelassen. Status in den 3-4 Minuten knapp 10%. Der Lüfter der GPU ist gerade angelaufen.

Wenn das möglicherweise plausibel weitergeht , dann lass ich die paar heute Nacht berechnen. Morgen steht dann Material zur Verfügung , welches man überprüfen kann. Ansonsten , wie gesagt wird die Kiste degradiert zum Marathon.

Auf 11 Kernen rechnet das NB Universe.

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.857

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Kannst Du irgendwo die GPU-Temperatur anzeigen lassen? nvidia-smi müsste als Befehl reichen.

Vielleicht wirds der ja einfach zu warm. Dann wäre ggf. eine Drosselung sinnvoll.

Vielleicht wirds der ja einfach zu warm. Dann wäre ggf. eine Drosselung sinnvoll.

Meisterfragger

Vice Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 515

- Renomée

- 63

- Standort

- mittlerweile Berlin

- Aktuelle Projekte

- Folding@home

- Meine Systeme

- Sys1, s. Sig

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- i5 3570K @ 4,2 GHz @ 1,085V

- Mainboard

- Gigabyte Z77 D3H Rev 1.0

- Kühlung

- Thermalright

- Speicher

- 2x4096 MB Crucial XMS 1600 MHz

- Grafikprozessor

- EVGA GTX 970 SC @1392 MHz

- Display

- Dell U2412

- SSD

- Crucial MX 100 512 GB

- HDD

- WD 500 GB und 3TB Red

- Optisches Laufwerk

- Plextor PX-716A; LG BH16NS40

- Soundkarte

- SB X-Fi Audio

- Gehäuse

- Antec Sonata 3

- Netzteil

- FSP Aurum 500 Watt

- Betriebssystem

- Win 7 Pro 64 Bit/ Win98SE, Win XP Pro;

- Webbrowser

- Firefox 33

- Verschiedenes

- leise und schnell :)

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.719

- Renomée

- 711

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Ist die WU fertig geworden?@koschi

Eine WU habe ich losgelassen. Status in den 3-4 Minuten knapp 10%. Der Lüfter der GPU ist gerade angelaufen.

Wenn das möglicherweise plausibel weitergeht , dann lass ich die paar heute Nacht berechnen. Morgen steht dann Material zur Verfügung , welches man überprüfen kann. Ansonsten , wie gesagt wird die Kiste degradiert zum Marathon.

Auf 11 Kernen rechnet das NB Universe.

Wenn die wieder hängt (sollte max. ne halbe Stunde laufen), geh lieber zu Srbase, das mag Nvidia.

Verdammte Axt, was sich schon mit dem Tahiti-System abgezeichnet hat, zeigt sich nun auch auf den Vega-Systemen. Die WUs dauern in diesem Jahr fast eine ganze Minute länger als noch letztes Jahr  Beim Tahiti-System hatte ich es noch auf die CPU geschoben, einen K10, der ewig beschäftigt war mit der Fertigstellung der letzten paar Prozent. Aber auch hier auf den Ryzens dauert das ewig.

Beim Tahiti-System hatte ich es noch auf die CPU geschoben, einen K10, der ewig beschäftigt war mit der Fertigstellung der letzten paar Prozent. Aber auch hier auf den Ryzens dauert das ewig.

Kurzum: so geht meine Kalkulation nicht auf, ich hab mir zu viele WUs gezogen. Entweder ich brech die zeitnah ab, damit der Server sie nochmal verschicken kann, was aber schade wäre, weil sie schon gut abgehangen sind, oder vielleicht kann mir jemand mit Windows und Radeon-GPU ein paar Instanzen abnehmen?

Beim Tahiti-System hatte ich es noch auf die CPU geschoben, einen K10, der ewig beschäftigt war mit der Fertigstellung der letzten paar Prozent. Aber auch hier auf den Ryzens dauert das ewig.

Beim Tahiti-System hatte ich es noch auf die CPU geschoben, einen K10, der ewig beschäftigt war mit der Fertigstellung der letzten paar Prozent. Aber auch hier auf den Ryzens dauert das ewig.Kurzum: so geht meine Kalkulation nicht auf, ich hab mir zu viele WUs gezogen. Entweder ich brech die zeitnah ab, damit der Server sie nochmal verschicken kann, was aber schade wäre, weil sie schon gut abgehangen sind, oder vielleicht kann mir jemand mit Windows und Radeon-GPU ein paar Instanzen abnehmen?

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.271

- Renomée

- 1.857

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Es gibt immer mal wieder batches, die kürzer oder länger dauern. Da muss man schon vor dem Bunkern ein paar WUs durchrechnen lassen.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.980

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

NEO83

Grand Admiral Special

- Mitglied seit

- 19.01.2016

- Beiträge

- 3.946

- Renomée

- 445

- Standort

- Wilhelmshaven

- BOINC-Statistiken

- Mein Desktopsystem

- Kraftprotz

- Mein Laptop

- ASUS TUF A17 @R9 7940HS @RTX4070

- Details zu meinem Desktop

- Prozessor

- AMD R7 7800X3D

- Mainboard

- GIGABYTE B650E AORUS Master

- Kühlung

- Noctua NH-D12L

- Speicher

- Corsair Vengeance RGB Kit 32GB, DDR5-6000, CL30-36-36-76

- Grafikprozessor

- PNY GeForce RTX 4080 XLR8 Gaming Verto Epic-X

- Display

- MSI MPG Artymis 273CQRDE @WQHD @165Hz

- SSD

- WD_BLACK SN850X 1TB, WD_BLACK SN850X 2TB

- Optisches Laufwerk

- USB BD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 XL

- Netzteil

- ASUS ROG Loki 1000W Platinum SFX-L

- Tastatur

- Logitech G815

- Maus

- Logitech G502 SE Lightspeed

- Betriebssystem

- Windows 11 64Bit

- Webbrowser

- FireFox

- Internetanbindung

- ▼1,15GBit ▲56MBit

skelletor

Grand Admiral Special

- Mitglied seit

- 14.06.2002

- Beiträge

- 5.316

- Renomée

- 289

- Standort

- Dresden

- Aktuelle Projekte

- Simap, Spinhenge, Poem, QMC, RNA World

- Lieblingsprojekt

- einheimische Projekte

- Meine Systeme

- AMD Ryzen 7 5800X3D + AMD Radeon RX 6900XT

- BOINC-Statistiken

- Mein Laptop

- Acer Aspire E3 112, Lenovo ThinkPad L570

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- MSI X570-A Pro

- Kühlung

- beQuiet DarkRock TF

- Speicher

- 2x 16GB GSkill 1800MHz CL14 @ 1T

- Grafikprozessor

- AMD Radeon 6900XT

- Display

- Samsung C27HG70 @2560*1440 144Hz; EIZO S2411W @1920x1200 60Hz; 52 Zoll Sony KDL-52HX905 @1920*1080

- SSD

- 1TB WD Black SN850 M2 NVME, 512 GB Samsung 850 Pro

- HDD

- 1x 4TB WesternDigital Red

- Optisches Laufwerk

- Pioneer BluRay Brenner

- Soundkarte

- Realtek HD Audio OnBoard (ALC 1220)

- Gehäuse

- noname

- Netzteil

- Seasonic X650 (80+ Gold)

- Tastatur

- Logitech G815 Tactile (brown)

- Maus

- Swiftpoint Z

- Betriebssystem

- Windows 10 Home 64bit

- Webbrowser

- Firefox

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.719

- Renomée

- 711

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

passt

NEO83

Grand Admiral Special

- Mitglied seit

- 19.01.2016

- Beiträge

- 3.946

- Renomée

- 445

- Standort

- Wilhelmshaven

- BOINC-Statistiken

- Mein Desktopsystem

- Kraftprotz

- Mein Laptop

- ASUS TUF A17 @R9 7940HS @RTX4070

- Details zu meinem Desktop

- Prozessor

- AMD R7 7800X3D

- Mainboard

- GIGABYTE B650E AORUS Master

- Kühlung

- Noctua NH-D12L

- Speicher

- Corsair Vengeance RGB Kit 32GB, DDR5-6000, CL30-36-36-76

- Grafikprozessor

- PNY GeForce RTX 4080 XLR8 Gaming Verto Epic-X

- Display

- MSI MPG Artymis 273CQRDE @WQHD @165Hz

- SSD

- WD_BLACK SN850X 1TB, WD_BLACK SN850X 2TB

- Optisches Laufwerk

- USB BD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 XL

- Netzteil

- ASUS ROG Loki 1000W Platinum SFX-L

- Tastatur

- Logitech G815

- Maus

- Logitech G502 SE Lightspeed

- Betriebssystem

- Windows 11 64Bit

- Webbrowser

- FireFox

- Internetanbindung

- ▼1,15GBit ▲56MBit

@skelletor Optimierungspotential sehe ich in 1-2 weiteren 6900XT sonst ist das sicherlich ok

Das wäre cool!@Nero24 sobald ich hier alle CPU WUs in Linux durch habe könnte ich dir eine Instanz abnehmen ... sind das opencl2 oder opencl1?

Ich frage weil ich sonst die iGPU ausschalten muss, die kann die 2er nicht berechnen

Alles opencl1. Ist aber Windows, gell. Denke nicht, dass Du die Instanz unter Linux ans Laufen kriegst oder hast Du Dual-Boot eingerichtet?

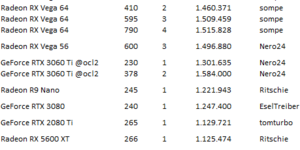

Alles opencl1. Ist aber Windows, gell. Denke nicht, dass Du die Instanz unter Linux ans Laufen kriegst oder hast Du Dual-Boot eingerichtet?Wenn das die Werte für 2 WUs gleichzeitig ist, dann passt das für eine 6900XT. Wenn das eine WU ist, dann stimmt was nicht.Meine vorbereiteten sind alle so 4:30 - 4:40

NEO83

Grand Admiral Special

- Mitglied seit

- 19.01.2016

- Beiträge

- 3.946

- Renomée

- 445

- Standort

- Wilhelmshaven

- BOINC-Statistiken

- Mein Desktopsystem

- Kraftprotz

- Mein Laptop

- ASUS TUF A17 @R9 7940HS @RTX4070

- Details zu meinem Desktop

- Prozessor

- AMD R7 7800X3D

- Mainboard

- GIGABYTE B650E AORUS Master

- Kühlung

- Noctua NH-D12L

- Speicher

- Corsair Vengeance RGB Kit 32GB, DDR5-6000, CL30-36-36-76

- Grafikprozessor

- PNY GeForce RTX 4080 XLR8 Gaming Verto Epic-X

- Display

- MSI MPG Artymis 273CQRDE @WQHD @165Hz

- SSD

- WD_BLACK SN850X 1TB, WD_BLACK SN850X 2TB

- Optisches Laufwerk

- USB BD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 XL

- Netzteil

- ASUS ROG Loki 1000W Platinum SFX-L

- Tastatur

- Logitech G815

- Maus

- Logitech G502 SE Lightspeed

- Betriebssystem

- Windows 11 64Bit

- Webbrowser

- FireFox

- Internetanbindung

- ▼1,15GBit ▲56MBit

Das wäre cool!Alles opencl1. Ist aber Windows, gell. Denke nicht, dass Du die Instanz unter Linux ans Laufen kriegst oder hast Du Dual-Boot eingerichtet?

Dual-Boot

Ich kann halt nicht komplett auf Windows verzichten daher hab ich beides ^^

Dauert aber sicher noch bis morgen ... über 300 Speere und über 300 Universen und die Speere dauern unter linux halt länger ...

Vllt warte ich auch nur bis ich die PG und Einsteine fertig hab und Wechsel dann eben ... den Rest kann ich auch später noch berechnen

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 14.375

- Renomée

- 1.980

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 9 3950X

- Mainboard

- MSI MPG X570 GAMING PRO CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 4x 16 GB G.Skill Trident Z RGB, DDR4-3200, CL14

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Intel 600p 1TB

- HDD

- Western Digital WD Red 2 & 3TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Querfeldein (Primegrid) läuft ja eh diese Nacht aus.

seTTam

Vice Admiral Special

- Mitglied seit

- 16.08.2009

- Beiträge

- 888

- Renomée

- 81

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Folding@Home-Statistiken

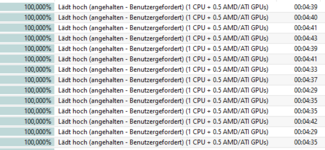

Auch hier wieder mit GTX1650 getestet: 709.83 Sekunden

Mit der OpenCL-2-App liegt eine GeForce RTX 3060 Ti nun in etwa auf Augenhöhe mit einer Vega 56 unter OpenCL 1 und ist schneller als eine RTX 3080.  Der AMD-Vorsprung ist also dahin

Der AMD-Vorsprung ist also dahin

Wer eine aktuelle NVIDIA Turing oder Ampere hier einsetzen möchte, tut also gut daran, die Projektsettings entsprechend zu setzen:

Der AMD-Vorsprung ist also dahin

Der AMD-Vorsprung ist also dahin

Wer eine aktuelle NVIDIA Turing oder Ampere hier einsetzen möchte, tut also gut daran, die Projektsettings entsprechend zu setzen:

NEO83

Grand Admiral Special

- Mitglied seit

- 19.01.2016

- Beiträge

- 3.946

- Renomée

- 445

- Standort

- Wilhelmshaven

- BOINC-Statistiken

- Mein Desktopsystem

- Kraftprotz

- Mein Laptop

- ASUS TUF A17 @R9 7940HS @RTX4070

- Details zu meinem Desktop

- Prozessor

- AMD R7 7800X3D

- Mainboard

- GIGABYTE B650E AORUS Master

- Kühlung

- Noctua NH-D12L

- Speicher

- Corsair Vengeance RGB Kit 32GB, DDR5-6000, CL30-36-36-76

- Grafikprozessor

- PNY GeForce RTX 4080 XLR8 Gaming Verto Epic-X

- Display

- MSI MPG Artymis 273CQRDE @WQHD @165Hz

- SSD

- WD_BLACK SN850X 1TB, WD_BLACK SN850X 2TB

- Optisches Laufwerk

- USB BD-Brenner

- Soundkarte

- Onboard

- Gehäuse

- Fractal Design Meshify 2 XL

- Netzteil

- ASUS ROG Loki 1000W Platinum SFX-L

- Tastatur

- Logitech G815

- Maus

- Logitech G502 SE Lightspeed

- Betriebssystem

- Windows 11 64Bit

- Webbrowser

- FireFox

- Internetanbindung

- ▼1,15GBit ▲56MBit

RX6600M @OCL2 --> Linux --> 2WUs --> 647s

Hier scheint aber etwas nicht ganz grün zu sein Oo

Sollte eine 5600XT nicht eigentlich langsamer sein ? ^^

Ich werd das unter windows nochmal nachtesten, und sobald möglich auch noch OCL1 unter Linux ... OCL2 scheint bei AMD nicht unbedingt schneller zu sein, warum auch immer ...

Hier scheint aber etwas nicht ganz grün zu sein Oo

Sollte eine 5600XT nicht eigentlich langsamer sein ? ^^

Ich werd das unter windows nochmal nachtesten, und sobald möglich auch noch OCL1 unter Linux ... OCL2 scheint bei AMD nicht unbedingt schneller zu sein, warum auch immer ...

Olle Kalesche

Admiral Special

- Mitglied seit

- 02.04.2015

- Beiträge

- 1.126

- Renomée

- 72

- Standort

- Hessen

- Aktuelle Projekte

- Seti , Einstein , und andere

- Meine Systeme

- AMD Athlon 5350 , (AMD Athlon II X4 610e)

- BOINC-Statistiken

- Details zu meinem Desktop

- Prozessor

- AMD Athlon(tm) 5350 APU with Radeon(tm) R3 @2100

- Mainboard

- ASRock AM1B-ITX

- Kühlung

- standard

- Speicher

- 1x Crucial Technology 8GB, BLT8G3D1608ET3LX0 800.0 MHz (DDR3-1600 / PC3-12800) @8,8,8,1T

- Grafikprozessor

- GTX 750Ti

- Display

- 27", SAMSUNG , T27C370, 1920 x 1080

- HDD

- Seagate ST2000DM001-9YN1

- Optisches Laufwerk

- Liteon, ATAPI iHAS624 B

- Soundkarte

- intern

- Gehäuse

- Sharkoon T28

- Netzteil

- Cooler Master V450S (450W,gold)

@MagicEye04 @koschi

Sorry , bin gestern abend auf der Couch eingeschlafen.

Die Temp der GPU liegt bei 52°C , 20W bei der aktuellen WU soweit ich das verstehe und die berechnete WU von heute Nacht ist wieder Schrott.

So bin kurz im Bad und beim Essen , dann geht's weiter.

Sorry , bin gestern abend auf der Couch eingeschlafen.

Die Temp der GPU liegt bei 52°C , 20W bei der aktuellen WU soweit ich das verstehe und die berechnete WU von heute Nacht ist wieder Schrott.

So bin kurz im Bad und beim Essen , dann geht's weiter.

skelletor

Grand Admiral Special

- Mitglied seit

- 14.06.2002

- Beiträge

- 5.316

- Renomée

- 289

- Standort

- Dresden

- Aktuelle Projekte

- Simap, Spinhenge, Poem, QMC, RNA World

- Lieblingsprojekt

- einheimische Projekte

- Meine Systeme

- AMD Ryzen 7 5800X3D + AMD Radeon RX 6900XT

- BOINC-Statistiken

- Mein Laptop

- Acer Aspire E3 112, Lenovo ThinkPad L570

- Details zu meinem Desktop

- Prozessor

- Ryzen 7 5800X3D

- Mainboard

- MSI X570-A Pro

- Kühlung

- beQuiet DarkRock TF

- Speicher

- 2x 16GB GSkill 1800MHz CL14 @ 1T

- Grafikprozessor

- AMD Radeon 6900XT

- Display

- Samsung C27HG70 @2560*1440 144Hz; EIZO S2411W @1920x1200 60Hz; 52 Zoll Sony KDL-52HX905 @1920*1080

- SSD

- 1TB WD Black SN850 M2 NVME, 512 GB Samsung 850 Pro

- HDD

- 1x 4TB WesternDigital Red

- Optisches Laufwerk

- Pioneer BluRay Brenner

- Soundkarte

- Realtek HD Audio OnBoard (ALC 1220)

- Gehäuse

- noname

- Netzteil

- Seasonic X650 (80+ Gold)

- Tastatur

- Logitech G815 Tactile (brown)

- Maus

- Swiftpoint Z

- Betriebssystem

- Windows 10 Home 64bit

- Webbrowser

- Firefox

Die anderen beiden (Arecibo u. gravitational) GPU Projekte aus lassen?

Hab die alle 3 drin, aber nur Gamma Ray bekommen.

Wenn die anderen was lahm legen oder 20x weniger Punkte bringen, schalt ich die noch aus.

Hab die alle 3 drin, aber nur Gamma Ray bekommen.

Wenn die anderen was lahm legen oder 20x weniger Punkte bringen, schalt ich die noch aus.

koschi

Grand Admiral Special

- Mitglied seit

- 11.11.2001

- Beiträge

- 5.719

- Renomée

- 711

- Standort

- 0511

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- sieher Banner

- Lieblingsprojekt

- WCG, Einstein, Universe

- Meine Systeme

- R7 3900X @ 85W + 2 x Vega 56, 8 x Odroid C2, 8 x Odroid XU4, 4 x Odroid N2, 3 x Nvidia Jetson TK1

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- R9 3900X

- Mainboard

- Asus PRIME X370 PRO

- Kühlung

- Thermalright Le Grand Macho RT

- Speicher

- 2x32 GB DDR4 Corsair Vengeance LPX 3200@3200

- Grafikprozessor

- 2 x Sapphire Pulse Vega 56

- Display

- LG UltraFine 32UN880-B

- SSD

- Samsung EVO Plus 870 1TB & 850 500GB, Crucial MX500 1TB

- Optisches Laufwerk

- PIONEER BDR-209DBK

- Soundkarte

- Nubert nuPro A-20 (USB), Pioneer SE-MS7BT(K) (BT)

- Gehäuse

- Fractal Design Define R5 PCGH

- Netzteil

- BeQuiet! StraightPower 11 850W

- Betriebssystem

- Ubuntu LTS

- Internetanbindung

- ▼220 ▲40

Die Gravitational Wave bringen weniger Punkte, für Binary Radio Pulsar Search (Arecibo, large) (BRP4G) bekommst du nur mit Intel iGPU oder CPU überhaupt WUs.

Bleib bei den FGRP1G.

Bleib bei den FGRP1G.

Doppelposting wurde automatisch zusammengeführt:

Schwierig das remote zu untersuchen, ich würde aber sagen mach erstmal Srbase...@MagicEye04 @koschi

Sorry , bin gestern abend auf der Couch eingeschlafen.

Die Temp der GPU liegt bei 52°C , 20W bei der aktuellen WU soweit ich das verstehe und die berechnete WU von heute Nacht ist wieder Schrott.

So bin kurz im Bad und beim Essen , dann geht's weiter.

FritzB

Grand Admiral Special

- Mitglied seit

- 25.12.2002

- Beiträge

- 2.904

- Renomée

- 1.435

- Standort

- Märkisch Kongo

- Aktuelle Projekte

- WCG, GPUGrid

- Lieblingsprojekt

- gute Frage

- Meine Systeme

- 4x Ryzen 7950X, 4800H, 5600G, RTX 4070 Ti, RTX 4070 Ti Super, GTX 1650 Ti, RTX 4090

- BOINC-Statistiken

- Mein Laptop

- Lenovo ideapad 3, Ryzen 7 4800H, 1650 Ti

- Details zu meinem Desktop

- Prozessor

- 7950X, 5600G

- Mainboard

- jeweils eins

- Kühlung

- BQ Silent Loop 2 280, Arctic Liquid Freezer II 240, Scythe Fuma 3

- Speicher

- ganz viel DDR4 und DDR5

- Grafikprozessor

- GeForce 4090, 4070 Ti Super, 4070 Ti

- Display

- LG UltraGear 27GP850-B

- SSD

- diverse

- Optisches Laufwerk

- hatter

- Gehäuse

- Nanoxia Deep Silence 5, BQ Silent Base 500/600 u.a.

- Netzteil

- Corsair, Seasonic, BQ...

- Betriebssystem

- Windows 10 x64/Pro, Linux Mint 21.x

Mit der OpenCL-2-App liegt eine GeForce RTX 3060 Ti nun in etwa auf Augenhöhe mit einer Vega 56 unter OpenCL 1 und ist schneller als eine RTX 3080.

Mit der neuen App kann die 3080 auch was

Schlechte Neuigkeiten:

RTX 3080@300W, 2 WUs: 246 Sek

davon 30 Sek Nachlaufzeit auf 3900X@100W und 21x Numberfield

Ritschie

Moderator (DC)

☆☆☆☆☆☆

- Mitglied seit

- 30.12.2010

- Beiträge

- 4.598

- Renomée

- 1.339

- Standort

- /home

- Mitglied der Planet 3DNow! Kavallerie!

- Lieblingsprojekt

- SIMAP; LHC@SixTrack; Einstein@home

- Meine Systeme

- Threadripper 3970X, Threadripper 1950X, Ryzen9 3950X, Ryzen7 1700X, Ryzen3 4300GE

- Mein Laptop

- lenovo ThinkPad E595; AMD Ryzen 5 3500U

- Details zu meinem Desktop

- Prozessor

- AMD Threadripper 3970X

- Mainboard

- MSI Creator TRX40

- Kühlung

- Watercool Heatkiller IV, i-PCPS, i-KOM, Watercool HTF4 LT

- Speicher

- 4 x 16 GB G.Skill TridentZ DDR4-3200 CL14

- Grafikprozessor

- AMD Radeon RX 6700 XT

- Display

- 27" Lenovo Legion Y27q-20 WQHD FreeSync

- SSD

- Samsung SSD 970 PRO 512GB, M.2

- Gehäuse

- Cooler Master Cosmos 1000

- Netzteil

- be quiet! DARK POWER PRO P11 550W

- Tastatur

- Ducky Shine 3

- Betriebssystem

- openSUSE Leap

- Webbrowser

- Firefox

Wo war noch gleich die Einstellung, 2 WUs parallel berechnen zu lassen?

Gruß

Ritschie

Gruß

Ritschie

Ähnliche Themen

- Antworten

- 73

- Aufrufe

- 4K

- Antworten

- 188

- Aufrufe

- 9K

- Antworten

- 128

- Aufrufe

- 7K

- Antworten

- 49

- Aufrufe

- 3K

- Antworten

- 308

- Aufrufe

- 16K