App installieren

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Anmerkung: This feature may not be available in some browsers.

- Foren

- Planet 3DNow! Community

- Planet 3DNow! Distributed Computing

- Team Planet 3DNow!

- Café Planet 3DNow!

Du verwendest einen veralteten Browser. Es ist möglich, dass diese oder andere Websites nicht korrekt angezeigt werden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Du solltest ein Upgrade durchführen oder ein alternativer Browser verwenden.

Formula Boinc 2022

- Ersteller Ritschie

- Erstellt am

enigmation

Admiral Special

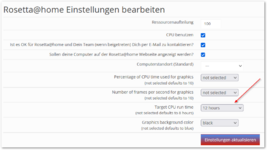

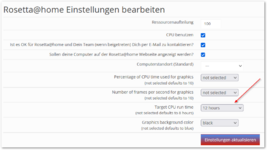

Hier rechnen nun 40/40 Threads native Rosettas. Mit update.bat genügend native WUs eingesammelt und dann in den Rosetta-Einstellungen die WU-Dauer auf 12h gestellt.

Dann könnt ihr auf wenigen WUs rumkauen lassen. Bei dem Projekt wird die Dauer der Berechnung gewertet, nicht die Anzahl der berechneten WUs.

Oder stellt es auf eine noch längere Dauer und verkürzt diese, wenn das Sprintende näher rückt. Die Einstellung der Dauer dürfte sofort wirken bei den aktuell berechneten WUs, wenn ich mich richtig erinnere.

Noch was zu den Zahlen bei nativen Rosetta-WUs: 350MB RAM/WU, Projektordner ist 1,6GB groß bei 24 Threads.

DRAM-Bandbreite ist auch normal:

Dann könnt ihr auf wenigen WUs rumkauen lassen. Bei dem Projekt wird die Dauer der Berechnung gewertet, nicht die Anzahl der berechneten WUs.

Oder stellt es auf eine noch längere Dauer und verkürzt diese, wenn das Sprintende näher rückt. Die Einstellung der Dauer dürfte sofort wirken bei den aktuell berechneten WUs, wenn ich mich richtig erinnere.

Noch was zu den Zahlen bei nativen Rosetta-WUs: 350MB RAM/WU, Projektordner ist 1,6GB groß bei 24 Threads.

DRAM-Bandbreite ist auch normal:

seTTam

Vice Admiral Special

- Mitglied seit

- 16.08.2009

- Beiträge

- 945

- Renomée

- 101

- Mitglied der Planet 3DNow! Kavallerie!

- BOINC-Statistiken

- Folding@Home-Statistiken

Ich bin jetzt wirklich kurz davor dieses Projekt zu entfernen.

Jetzt habe ich ein Diskspace Problem bei 800G freien Diskspace. Und Ich bekomme nicht gesagt, wo es denn fehlen sollte.

Do 07 Apr 2022 21:21:13 CEST | Rosetta@home | Nachricht vom Server: rosetta python projects needs 19073.49MB more disk space. You currently have 0.00 MB available and it needs 19073.49 MB.

Sowas habe ich bei mir auch, da hört aber der Spaß auf. Ich lasse das rechnen, was geht, versuche aber nix zu verdrehen, damit es läuft.

Na gut, auf die ubuntuP3DN-VM musste ich noch virtual-box installieren, aber das reicht auch

MagicEye04

Grand Admiral Special

- Mitglied seit

- 20.03.2006

- Beiträge

- 23.919

- Renomée

- 2.214

- Standort

- oops,wrong.planet..

- Aktuelle Projekte

- Seti,WCG,Einstein + was gerade Hilfe braucht

- Lieblingsprojekt

- Seti

- Meine Systeme

- R7-1700+GTX1070ti,R7-1700+RadeonVII, FX-8350+GTX1050ti, X4-5350+GT1030, X2-240e+RX460

- BOINC-Statistiken

- Folding@Home-Statistiken

- Mein Laptop

- Dell Latitude E7240

- Details zu meinem Desktop

- Prozessor

- R9-3950X (@65W)

- Mainboard

- Asus Prime B550plus

- Kühlung

- TR Macho

- Speicher

- 2x16GiB Corsair LPX2666C16

- Grafikprozessor

- Radeon VII

- Display

- LG 32UD99-W 81,3cm

- SSD

- Crucial MX500-250GB, Samsung EVO280 256GB

- HDD

- Seagate 7200.14 2TB (per eSATAp)

- Optisches Laufwerk

- LG DVDRAM GH24NS90

- Soundkarte

- onboard

- Gehäuse

- Nanoxia Deep Silence1

- Netzteil

- BeQuiet StraightPower 11 550W

- Tastatur

- Cherry RS6000

- Maus

- Logitech RX600

- Betriebssystem

- Ubuntu

- Webbrowser

- Feuerfuchs

- Verschiedenes

- 4x Nanoxia Lüfter (120/140mm) , Festplatte in Bitumenbox

Ich habe jetzt einige von den vbox tasks als zombies im Status "unmanageable, restarting later" herumliegen.

Aber die restarten nicht, wenn ich alle anderen anhalte. Mal sehen, ob es noch was wird.

Der andere Rechner hat genug normale tasks bekommen über Nacht, also werde ich das nun auch auf dem 3950X so machen. Das vbox-Zeug kann mich mal.

Aber die restarten nicht, wenn ich alle anderen anhalte. Mal sehen, ob es noch was wird.

Der andere Rechner hat genug normale tasks bekommen über Nacht, also werde ich das nun auch auf dem 3950X so machen. Das vbox-Zeug kann mich mal.

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.728

- Renomée

- 1.144

- Aktuelle Projekte

- Rosetta@Home, Milkyway@Home; Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

Man sollte das vbox Zeug auf jeden Fall mengenmäßig per app_config beschränken. Dem 3990X waren 32 WUs gleichzeitig wohl zuviel. Der BM hat heute Nacht die Verbindung zum Boinc Client verloren. Nach Neustart des Rechners und vom BM hat er 5 Minuten gebraucht, um den Client zu verbinden.

Engpass ist wohl die Festplatte, die ist nämlich auf einmal zu 90 % gefüllt (genau die 90 % Obergrenze, die ich vorgegeben hatte).

Engpass ist wohl die Festplatte, die ist nämlich auf einmal zu 90 % gefüllt (genau die 90 % Obergrenze, die ich vorgegeben hatte).

eiernacken1983

Admiral Special

- Mitglied seit

- 18.06.2020

- Beiträge

- 1.728

- Renomée

- 1.144

- Aktuelle Projekte

- Rosetta@Home, Milkyway@Home; Einstein@Home

- Lieblingsprojekt

- MW@H

- Meine Systeme

- 3990X+2 x Radeon VII; 3950X + Radeon VII; 5950X + 5700XT; 3950X + Vega 64

- BOINC-Statistiken

- Folding@Home-Statistiken

- Details zu meinem Desktop

- Prozessor

- Ryzen 9 5950X

- Mainboard

- Gigabyte X570 Aorus Pro

- Kühlung

- Noctua NH-D15

- Speicher

- 4 x 8 GB G.Skill @ 3600 Cl16

- Grafikprozessor

- RX 5700XT Anniversary Edition

- Betriebssystem

- Windows 10

Bei Cosmology bekommen diese WUs einen automatischen Timeout von 24 h. Das wird hier dann bestimmt genauso sein. Sie warten also auf den Ablauf der 24 h und nicht darauf, dass Du Ressourcen freigibstIch habe jetzt einige von den vbox tasks als zombies im Status "unmanageable, restarting later" herumliegen.

...

Solange es WUs mit diesem Status gibt, werden mglw. keine neuen WUs gezogen (zumindest bei Cosmology ist das so).

JagDoc

Grand Admiral Special

- Mitglied seit

- 18.08.2002

- Beiträge

- 3.354

- Renomée

- 725

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- RNA, Pogs, Enigma, Asteroids

- Lieblingsprojekt

- RNA

- Meine Systeme

- i7-3820, i7-3930, ODROID-X2/U2

- BOINC-Statistiken

- Folding@Home-Statistiken

Hier auf P 66 Gesamt:Kann mir mal einer verraten wo sich "The Scottish Boinc Team" versteckt hat? Auf der Rosetta Projektseite finde ich die nicht mehr oder ich bin blind.

Link

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.753

- Renomée

- 2.500

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich habe jetzt einige von den vbox tasks als zombies im Status "unmanageable, restarting later" herumliegen.

Aber die restarten nicht, wenn ich alle anderen anhalte. Mal sehen, ob es noch was wird.

Bei Cosmology bekommen diese WUs einen automatischen Timeout von 24 h. Das wird hier dann bestimmt genauso sein. Sie warten also auf den Ablauf der 24 h und nicht darauf, dass Du Ressourcen freigibst

Von Cosmo kenne ich das problem auch aber ich bin mir gerade nicht ganz sicher woran das lag, vermutlich an zu wenig RAM oder freigegebenen Plattenspeicher für alle VMs.

Auf meinem Carrizo Schleppi ist es übrigens ein Dauerproblem, da darf ich nur die Hälfte der Kerne freigeben damit es nicht auftritt.

Bei den VM WUs habe ich für mich festgestellt das man mit 8-10GB Plattenspeicher und 3-4 GB RAM pro WU rechnen sollte.

[automerge]1649405697[/automerge]

Wo ich schon dabei bin, mein letzter Berechnungsversuch bei meinem großen Ripper hat die SSD offenbar so zugemüllt dass die Linux Installation nicht mehr starten will.

Mal schauen was passiert wenn ich die 512GB Platte gegen ein 2 TB Modell tausche.

Angesichts der enormen Schreiblast die offenbar vor allem nach dem Runterladen/beim Start der WU und beim Beenden entsteht und der vielen parallel laufenden WUs bin ich aber am überlegen ob bei der Kiste ein PCIe 4.0 Modell (Samsung 980 PRO) sinnvoll wäre oder ob ich im zuge dessen auf eine 2,5" SATA SSD (Crucial MX500) für den Wechselrahmen wechsel. Beide könnte ich kurzfristig im Laden bekommen, wobei die TBW sehr deutlich für das PCIe 4.0 Modell sprechen würde.

Zuletzt bearbeitet:

JagDoc

Grand Admiral Special

- Mitglied seit

- 18.08.2002

- Beiträge

- 3.354

- Renomée

- 725

- Mitglied der Planet 3DNow! Kavallerie!

- Aktuelle Projekte

- RNA, Pogs, Enigma, Asteroids

- Lieblingsprojekt

- RNA

- Meine Systeme

- i7-3820, i7-3930, ODROID-X2/U2

- BOINC-Statistiken

- Folding@Home-Statistiken

Jetzt sind sie auf P14 Punktedurchschnitt.@JagDoc , danke, Wenn ich aber nach Punktedurchschnitt sortiere, sollten die dann ~ P15 sein, da fehlen die aber. Da stimmt dort was nicht und meine Stats dann auch nicht.

Stony666

Vice Admiral Special

- Mitglied seit

- 29.03.2007

- Beiträge

- 801

- Renomée

- 631

- Standort

- Appelwoigefilde

- Aktuelle Projekte

- WCG, PG, SRBase... eigentlich alle im Laufe des Jahres

- BOINC-Statistiken

Sehr schade, ich habe mein Dickschiff einige Stunden laufen lassen.

Resultat: 1 WU in 4 Stunden bekommen und die ist nach 10Min mit Berechnungsfehler gestorben.

Was für ein besch*** Projekt! Das sieht mich in diesem Jahr nicht wieder

Resultat: 1 WU in 4 Stunden bekommen und die ist nach 10Min mit Berechnungsfehler gestorben.

Was für ein besch*** Projekt! Das sieht mich in diesem Jahr nicht wieder

enigmation

Admiral Special

Ja, da sind immer wieder Batches dabei, die früher oder später abbrechen. Meist bekommt man anteilig dennoch Punkte gutgeschrieben. Und das Problem haben ja alle im Sprint.

Maverick-F1

Grand Admiral Special

Ich hab' den Pinguin auf dem Cezanne eine 1-2h nach WUs betteln lassen (kein vBox - den Krampf tu ich mir nicht mehr an!) und nix gekriegt - dann halt ohne mich...

Oder muss man da am Linux was basteln, wie bei LHC?

Oder muss man da am Linux was basteln, wie bei LHC?

enigmation

Admiral Special

nein, nix basteln. Bei mir läuft es ohne weiteres zu tun. Nur die Hürde der raren WUs muss man nehmen.while true; do boinccmd --host 127.0.0.1 --passwd p3d --project https://boinc.bakerlab.org/rosetta update; sleep 80; done

Maverick-F1

Grand Admiral Special

Hm - die Kiste nur deswegen ideln zu lassen widerstrebt mir - und andere Projekte zum "Auffüllen" mag ich mir aktuell gerade auch nicht antun (wird Zeit, dass WCG endlich wieder online kommt!)...

Stony666

Vice Admiral Special

- Mitglied seit

- 29.03.2007

- Beiträge

- 801

- Renomée

- 631

- Standort

- Appelwoigefilde

- Aktuelle Projekte

- WCG, PG, SRBase... eigentlich alle im Laufe des Jahres

- BOINC-Statistiken

Ja, aber es geht mir nicht um den Sprint.Ja, da sind immer wieder Batches dabei, die früher oder später abbrechen. Meist bekommt man anteilig dennoch Punkte gutgeschrieben. Und das Problem haben ja alle im Sprint.

Ich lasse keinen Rechner stundenlang nur so laufen, weil keine WUs kommen. Diese Projektwahl verstehe ich nicht.

Das macht für mich einfach keinen Sinn. Bin gespannt, ob yafu auch noch gewählt wird. Da kommt dann erst richtig Freude auf.

enigmation

Admiral Special

Bis die Probleme wieder behoben sind und die Verantwortlichen sich wieder mehr um die Pflege ihres Projektes kümmern, bin ich da ja auch raus. Nur für den Sprint wieder angeworfen, da ja alle damit zu kämpfen haben.Ja, aber es geht mir nicht um den Sprint.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.753

- Renomée

- 2.500

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Ich bin erstmal dabei die Linux Installation auf die MX500 zu clonen, mal schauen wie es dann mit genügend Speicherplatz ausschaut und wieviel Platz BOINC belegt wenn so viele WUs wie möglich parallel laufen können.

olsen_gg

Grand Admiral Special

- Mitglied seit

- 02.03.2012

- Beiträge

- 10.878

- Renomée

- 870

- Standort

- Stralsund

- Aktuelle Projekte

- WCG SCC1, HSTB, wechselnde..

- Lieblingsprojekt

- alle medizinisch / pharmazeutischen Projekte

- Meine Systeme

- Ryzen 9 3900X, 2x Ryzen 7 3700X, ( noch vorhanden: i7-4770S, Lappy i7-3630QM, 13x ARM...)

- BOINC-Statistiken

- Details zu meinem Desktop

- Verschiedenes

- Zuviel Details, das muss nicht veröffentlicht werden.

Das wird das Marathon-Projekt im Penta.Ja, da sind immer wieder Batches dabei, die früher oder später abbrechen. Meist bekommt man anteilig dennoch Punkte gutgeschrieben. Und das Problem haben ja alle im Sprint.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.753

- Renomée

- 2.500

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

SSD ist getauscht und die Neue füllt sich.......

Die 5 VM WUs 5700G haben seit ca. 5 Stunden für ca. 190GB Schreiblast gesorgt und die 2TB MX500 gibbet derzeit im MM für 178€. ^^

[automerge]1649431259[/automerge]

Die Platte ist groß genug (Rosetta belegt ca. 700 GB) aber nun spackt er mit demVM Hypervisor rum.

Die 5 VM WUs 5700G haben seit ca. 5 Stunden für ca. 190GB Schreiblast gesorgt und die 2TB MX500 gibbet derzeit im MM für 178€. ^^

[automerge]1649431259[/automerge]

Die Platte ist groß genug (Rosetta belegt ca. 700 GB) aber nun spackt er mit demVM Hypervisor rum.

Zuletzt bearbeitet:

olsen_gg

Grand Admiral Special

- Mitglied seit

- 02.03.2012

- Beiträge

- 10.878

- Renomée

- 870

- Standort

- Stralsund

- Aktuelle Projekte

- WCG SCC1, HSTB, wechselnde..

- Lieblingsprojekt

- alle medizinisch / pharmazeutischen Projekte

- Meine Systeme

- Ryzen 9 3900X, 2x Ryzen 7 3700X, ( noch vorhanden: i7-4770S, Lappy i7-3630QM, 13x ARM...)

- BOINC-Statistiken

- Details zu meinem Desktop

- Verschiedenes

- Zuviel Details, das muss nicht veröffentlicht werden.

SSD-Killer also. Danke, ohne mich.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.753

- Renomée

- 2.500

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Cosmo steigt mit dem gleiche vbox Fehler aus aber eine neue VM läßt sich in vbox erstellen.

Also scheint irgendwie die Verbindung zwischen BOINC und vbox gestört zu sein.

Also scheint irgendwie die Verbindung zwischen BOINC und vbox gestört zu sein.

Stony666

Vice Admiral Special

- Mitglied seit

- 29.03.2007

- Beiträge

- 801

- Renomée

- 631

- Standort

- Appelwoigefilde

- Aktuelle Projekte

- WCG, PG, SRBase... eigentlich alle im Laufe des Jahres

- BOINC-Statistiken

Hast du eine von den vorab Versionen von boinc am start? 7.18...Cosmo steigt mit dem gleiche vbox Fehler aus aber eine neue VM läßt sich in vbox erstellen.

Also scheint irgendwie die Verbindung zwischen BOINC und vbox gestört zu sein.

Ich habe mal im Forum von LHC gelesen, das da die Verbindung gerne nicht klappt!

sowas mal unter Linux included?

sudo add-apt-repository ppa:costamagnagianfranco/boinc

Dann hast du solch eine Version.

Rückgängig geht (unter Mint) mit:

sudo apt-get install ppa-purge

sudo ppa-purge ppa:costamagnagianfranco/boinc

sudo apt remove boinc-client

sudo apt update

sudo apt install boinc-client oder boinc (jenachdem ob du das GUI hast oder nicht)

Konfig und alle WUs bleiben erhalten.

[automerge]1649442156[/automerge]

Nur die Python WUs sind so disklastigSSD-Killer also. Danke, ohne mich.

sompe

Grand Admiral Special

- Mitglied seit

- 09.02.2009

- Beiträge

- 15.753

- Renomée

- 2.500

- Mein Laptop

- Dell G5 15 SE 5505 Eclipse Black

- Details zu meinem Desktop

- Prozessor

- AMD Ryzen 7 7800X3D

- Mainboard

- MSI MPG X670E CARBON WIFI

- Kühlung

- Wasserkühlung

- Speicher

- 32GB DDR5-6000 CL36

- Grafikprozessor

- AMD Radeon RX 6900 XT

- Display

- 1x 32" LG 32UD89-W + 1x 24" Dell Ultrasharp 2405FPW

- SSD

- Samsung SSD 980 PRO 1TB, Crucial MX500 500GB, Intel 600p 512GB, Crucial T705 4TB

- HDD

- Western Digital WD Red 2TB, 3TB, 8TB

- Optisches Laufwerk

- LG GGC-H20L

- Soundkarte

- onboard

- Gehäuse

- Thermaltake Armor

- Netzteil

- be quiet! Dark Power Pro 11 1000W

- Betriebssystem

- Windows 10 Professional, Windows 7 Professional 64 Bit, Ubuntu 20.04 LTS

- Webbrowser

- Firefox

Nö ist die ganz normale Version, ich glaube 7.16.6.

Ich habe jetzt nochmal VBox neu installiert und zwischendurch neu gestartet um zu schauen ob der BM das mitbekommt (hat er), hat leider nicht geholfen.

Vielleicht doch ein Problem vom BM selbst?

Ich habe jetzt nochmal VBox neu installiert und zwischendurch neu gestartet um zu schauen ob der BM das mitbekommt (hat er), hat leider nicht geholfen.

Vielleicht doch ein Problem vom BM selbst?

Ähnliche Themen

- Antworten

- 0

- Aufrufe

- 39

- Antworten

- 85

- Aufrufe

- 3K

- Antworten

- 0

- Aufrufe

- 34

- Antworten

- 112

- Aufrufe

- 3K

- Antworten

- 276

- Aufrufe

- 7K

Aktuelle Aktionen

Pentathlon 2025

Forumsthread

Webseite SG Pentathlon

Marathon 26.05 22:00 - 29.05. 21:59

Projekt: World Community Grid

Forumsthread

Forumsthread

Webseite SG Pentathlon

Marathon 26.05 22:00 - 29.05. 21:59

Projekt: World Community Grid

Forumsthread